论文题目:Fusing binocular vision and deep learning to detect dynamic wheel-rail displacement of high-speed trains(融合双目视觉和深度学习的高速列车轮轨动态位移检测)

期刊:Mechanical Systems and Signal Processing

摘要:轮轨之间的巨大位移会导致轨道损坏甚至列车脱轨。轮轨动态位移检测为判别轨道车辆的运行健康状态和制定主动控制策略提供了技术手段。本文提出了一种融合双目视觉(BV)和深度学习(DL)的DWRD在线检测方法,该方法简称为BV-DL。首先,利用双目摄像机在线捕捉轮轨接触动态视频,同时配置两台激光器对轮轨接触区域进行聚焦,定位轮轨接触图像中的关键点;然后,提出了自动识别轮轨接触区域的感兴趣区域(ROI)检测网络和自动检测轮轨像素位移(WRPD)的关键点检测网络。最后,建立三维坐标变换(3DCT)模型,实时计算轮轨世界位移,即关键点之间的DWRD。为了验证该方法的性能,采用基于激光位移传感器的方法验证了3DCT模型的可靠性。同时,介绍了传统的图像处理方法、基于MobileNet v3的方法和基于yolox的方法来预测WRPD。实验结果表明,与四种方法相比,所提出的BV-DL方法在像素坐标计算和三维坐标计算方面均能获得最优的结果。

融合双目视觉与深度学习检测高速列车动态轮轨位移

一、研究背景与问题

1.1 为什么要检测轮轨位移?

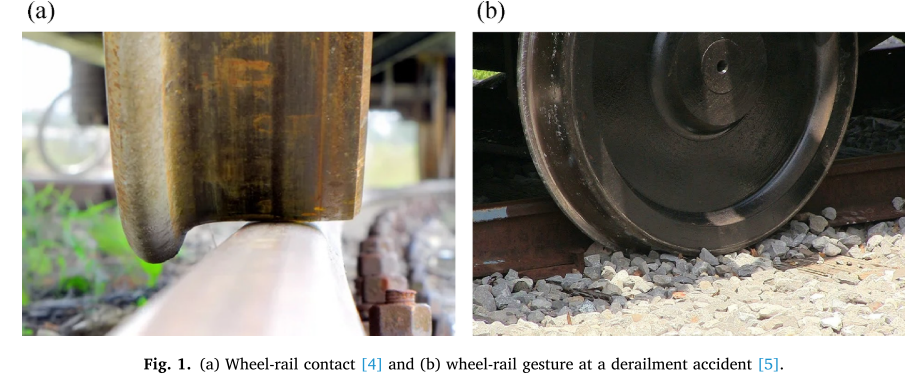

在高速铁路运行中,安全始终是首要考量 。列车运行时,由于车轮踏面具有一定的锥度,轮对在前进过程中会产生蛇行运动,从而产生动态轮轨位移(Dynamic Wheel-Rail Displacement, DWRD)。

当列车运行速度不断提升(实验中最高可达320 km/h),如果轮轨位移过大,轮对容易与轨道发生碰撞,严重时可能导致脱轨事故。因此,实时检测DWRD对于保障高速列车运行安全具有重要意义。

1.2 现有方法的局限性

论文系统梳理了现有的轮轨位移检测方法,并指出了各自的不足:

| 方法类型 | 工作原理 | 主要缺陷 |

|---|---|---|

| 传感器检测法 | 激光传感器、加速度传感器等 | 需要在轨道旁安装多个传感器,成本高,只适合局部检测 |

| 应变片检测法 | 通过应变片变形计算应力 | 需要特殊的测力轮对,成本高昂,难以推广 |

| 热成像检测法 | 利用红外热成像定位接触点 | 受环境温度影响大,复杂环境下不适用 |

| 传统图像处理法 | 像素分析提取图像特征 | 过度依赖阈值参数设置,需根据环境调整 |

| 现有深度学习方法 | 目标检测、关键点检测等 | 缺乏从像素位移到空间位移的转换方法 |

1.3 核心问题

现有深度学习算法虽然能够检测图像中的关键点,但无法将像素坐标转换为真实的物理位移。这意味着即使检测到关键点位置变化,也无法得知实际的轮轨位移是多少毫米------这正是本文要解决的关键问题。

二、创新方法:BV-DL

论文提出了一种融合双目视觉(Binocular Vision, BV)和 深度学习(Deep Learning, DL)的新方法,简称BV-DL方法。

2.1 整体框架

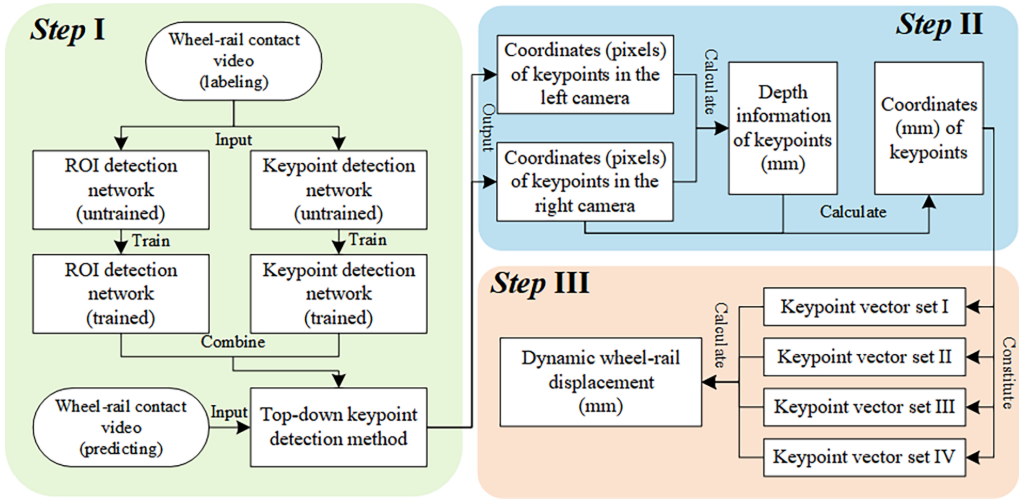

BV-DL方法的检测流程分为三个步骤:

- Step I:自顶向下的关键点识别 ------ 使用深度学习网络检测像素坐标

- Step II:世界坐标系中的3D坐标变换 ------ 将像素坐标转换为空间坐标

- Step III:DWRD计算 ------ 根据关键点的空间坐标计算真实位移

2.2 硬件配置

实验采用以下设备:

- ZED 2i 双目摄像机:分辨率 3840×1080,采样率 30 fps

- 两个蓝紫色单线激光器:照射轮轨接触区域,提供关键点定位参考

设备安装在列车转向架下方,摄像机捕捉轮对与轨道轮的中心接触区域。

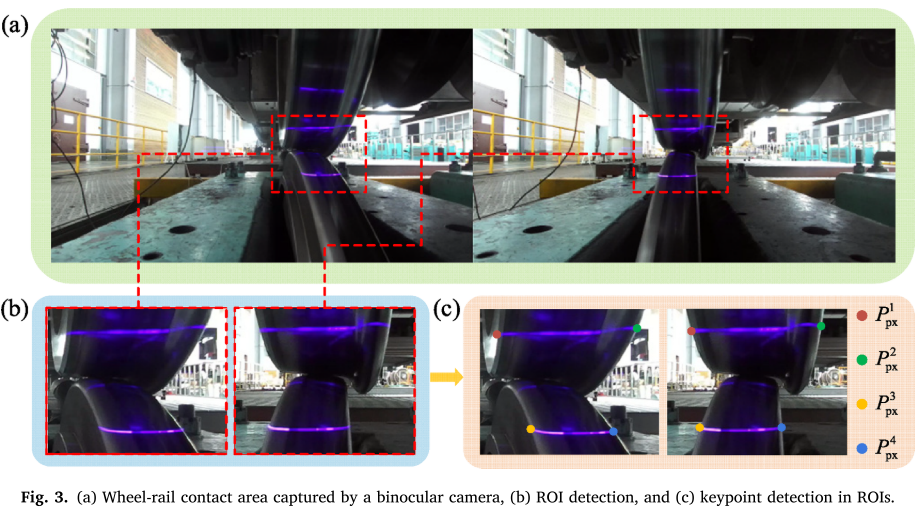

2.3 关键点定义

论文定义了4个关键点:

- P¹ₚₓ:激光与车轮的左交点

- P²ₚₓ:激光与车轮的右交点

- P³ₚₓ:激光与轨道的左交点

- P⁴ₚₓ:激光与轨道的右交点

通过激光作为参考,可以更准确地定位关键点,避免传统方法中关键点位置不明确导致的误检。

三、技术创新点详解

3.1 创新一:自顶向下的关键点检测方法

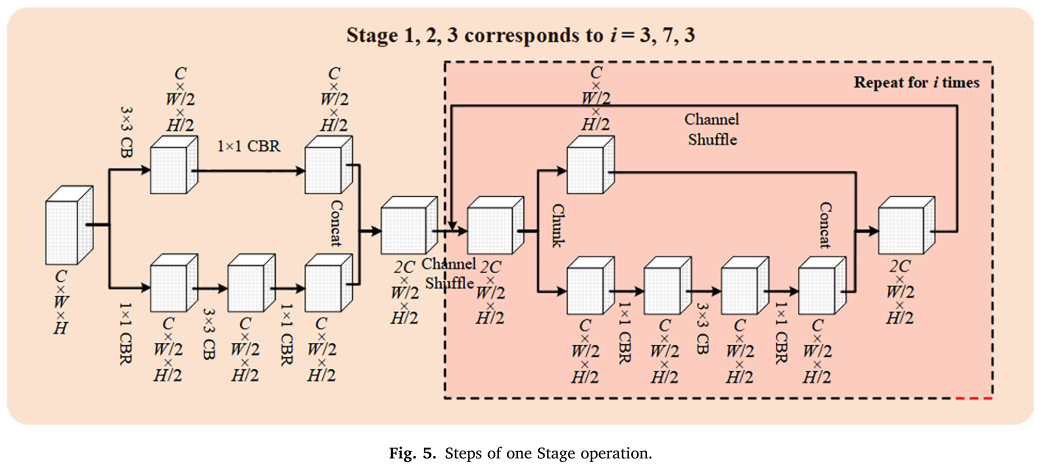

3.1.1 ROI检测网络

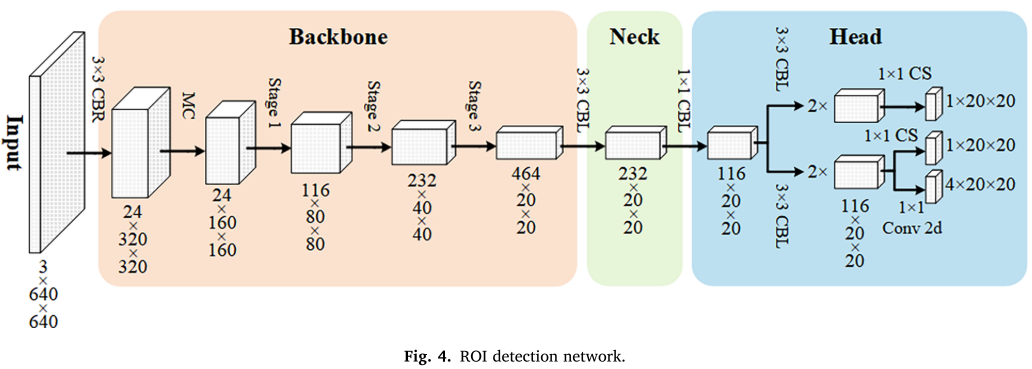

第一阶段使用ROI检测网络识别轮轨接触区域,过滤掉无用的环境背景。

网络架构特点:

- 输入:3×640×640 的特征图

- Backbone:采用 ShuffleNet v2 的 Stage 模块

- Neck:使用 3×3 CBL(Conv + BatchNorm + LeakyReLU)减少通道数

- Head:特征解耦,分别输出分类、边界框IoU和目标置信度

关键操作:

- Channel Shuffle:打乱特征图通道,增强特征信息流动

- LeakyReLU:减少梯度消失问题

- Sigmoid:将输出映射到0-1之间,判断是否为轮轨ROI

3.1.2 关键点检测网络

第二阶段使用关键点检测网络在ROI内精确定位4个关键点。

网络架构特点:

- 输入:3×256×256 的特征图(ROI裁剪后resize)

- Backbone:与ROI检测网络类似的处理方式

- Neck:7×7 Conv 2d 减少通道数

- Head:Flatten + FC + Linear,输出 4×512 的特征图

输出设计:

- 分为两个分支,分别预测关键点的横向和纵向坐标

- 以热力图形式进行分类预测

3.1.3 数据增强策略

为模拟真实线路的复杂环境,论文采用了丰富的数据增强:

ROI检测网络:

- 随机图像拼接、裁剪、翻转、填充、融合

- HSV增强

关键点检测网络:

- 随机图像裁剪、翻转

- 添加黑色像素块

- HSV增强

3.2 创新二:3D坐标变换模型

这是论文的核心创新,解决了从像素位移到空间位移的转换问题。

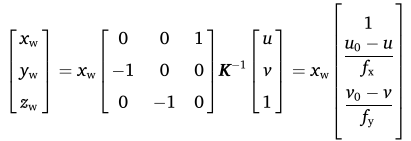

3.2.1 单目相机的局限

使用单目相机时,根据针孔成像原理可以建立像素坐标与世界坐标的关系:

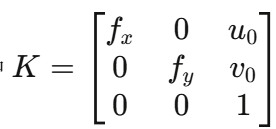

其中 是相机内参矩阵。

是相机内参矩阵。

问题:要计算世界坐标,必须知道 x_w(深度信息),但单目相机无法获取深度。

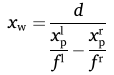

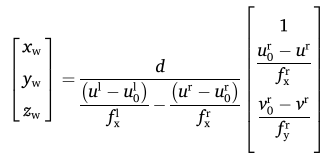

3.2.2 双目视觉获取深度

双目相机通过视差原理计算深度:

其中:

- d:两个相机光心之间的距离(基线距离)

- (u^l, v^l):左相机中的像素坐标

- (u^r, v^r):右相机中的像素坐标

最终转换公式:

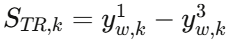

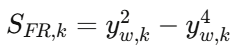

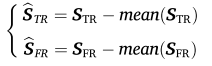

3.2.3 DWRD计算

对于每一帧图像,计算:

- 踏面-轨道相对横向距离 :

- 轮缘-轨道相对横向距离 :

将各帧的距离按时间顺序排列,去均值后得到真实位移向量:

3.3 创新三:完整的实时检测系统

论文建立了一套完整的在线检测系统:

- 双目相机实时采集轮轨接触视频

- ROI检测网络自动识别轮轨接触区域

- 关键点检测网络检测4个关键点的像素坐标

- 3DCT模型将像素坐标转换为世界坐标

- 实时计算DWRD

检测速度:36 FPS,满足实时检测需求

四、实验验证

4.1 实验环境

实验于2023年11月15日在西南交通大学轨道交通车辆系统国家重点实验室的全尺寸滚动试验台上进行。

实验条件:

- 列车速度从 0 km/h 加速到约 320 km/h,再减速到 0 km/h

- 在减速过程中,约 275 km/h 后轮对出现明显的横向位移

- 完整记录30分钟视频数据

4.2 训练策略

- 训练数据:从视频中随机选取500张图像

- ROI检测网络:batch size=8,80个epoch

- 关键点检测网络:batch size=16,250个epoch

- 学习率策略:LinearLR + CosineAnnealingLR

- 优化器:AdamW

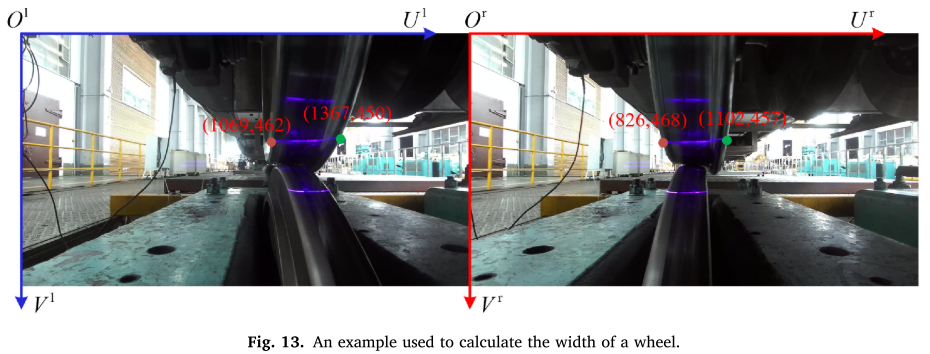

4.3 3DCT模型验证

为验证3DCT模型的可靠性,论文计算了一帧图像中车轮宽度:

| 项目 | 左相机 | 右相机 |

|---|---|---|

| 激光与车轮左交点U坐标 | 1069 | 826 |

| 激光与车轮右交点U坐标 | 1367 | 1102 |

通过公式计算得到车轮宽度为 135.40 mm ,与设计值 135 mm 非常接近,证明了3DCT模型的可靠性。

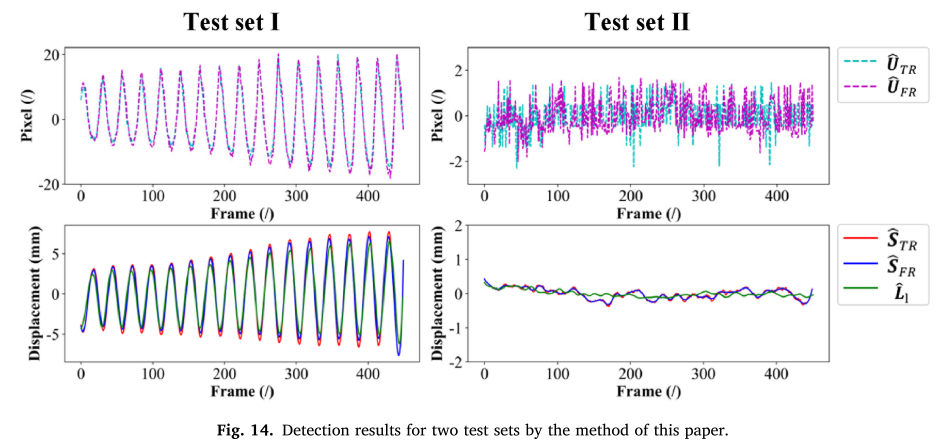

4.4 与激光位移传感器对比

论文使用安装在车轮侧面的激光位移传感器作为基准:

- Test Set I:存在明显轮轨位移的工况

- Test Set II:无明显轮轨位移的工况

结果显示,BV-DL方法计算的位移分量与激光位移传感器采集的数据吻合良好。

4.5 对比实验

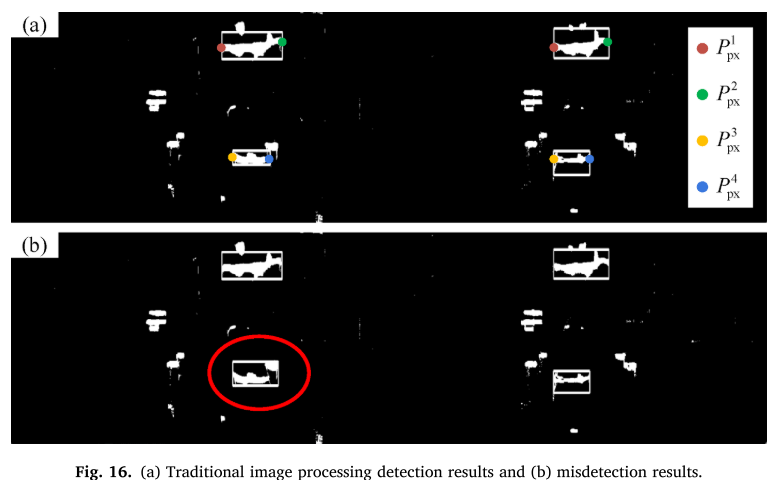

对比实验一:传统图像处理方法

使用HSV阈值分割和连通域分析检测关键点:

问题发现:

- 由于环境颜色和亮度变化,容易产生误检

- 踏面侧和轮缘侧的像素位移差异明显

- 过度依赖阈值参数设置

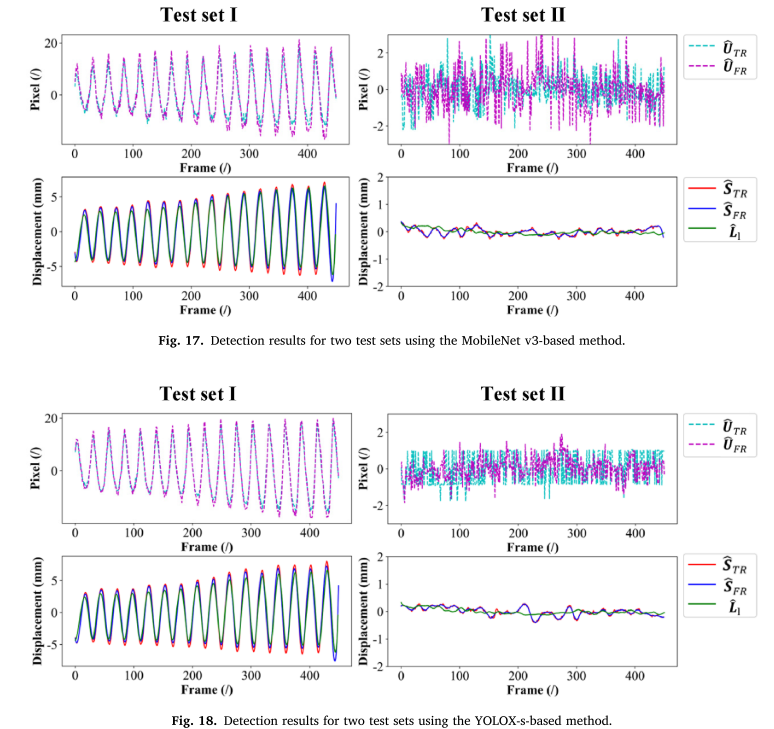

对比实验二:不同Backbone的深度学习方法

将关键点检测网络的Backbone替换为:

- MobileNet V3

- YOLOX-s

结果分析:

- 两种方法检测的关键点在无明显位移时波动显著

- 受外部干扰影响更大

4.6 定量评估

使用MAE (平均绝对误差)和RMSE(均方根误差)评估各方法:

| 测试集 | 评估指标 | 曲线 | BV-DL方法 | 传统图像处理 | MobileNet V3 | YOLOX-s |

|---|---|---|---|---|---|---|

| Test I | MAE | Û_TR | 1.127 | 1.271 | 1.683 | 1.336 |

| Test I | MAE | Û_FR | 1.051 | 1.343 | 1.602 | 1.323 |

| Test II | MAE | Û_TR | 0.787 | 1.405 | 0.903 | 0.852 |

| Test II | MAE | Û_FR | 0.770 | 4.283 | 1.047 | 0.798 |

结论:BV-DL方法在大多数指标上取得最优结果。

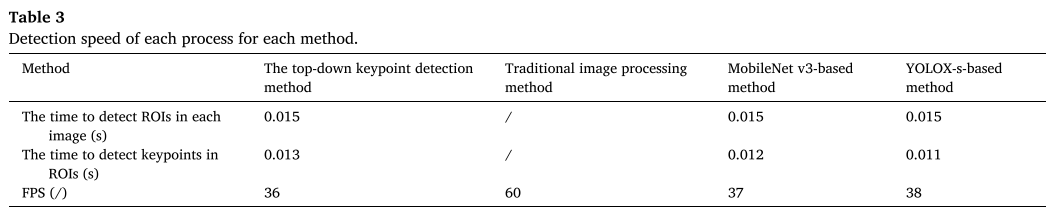

4.7 检测速度

| 方法 | ROI检测(s) | 关键点检测(s) | FPS |

|---|---|---|---|

| BV-DL | 0.015 | 0.013 | 36 |

| 传统图像处理 | / | / | 60 |

| MobileNet V3 | 0.015 | 0.012 | 37 |

| YOLOX-s | 0.015 | 0.011 | 38 |

BV-DL方法具有足够的检测速度和良好的精度。

五、方法优势与局限

5.1 优势

-

实时检测能力:使用高分辨率摄像机记录轮轨接触视频,可从每帧图像的关键点像素坐标计算真实DWRD

-

深度信息获取:采用双目相机弥补单目相机无法获取深度的缺陷,通过3DCT方法将像素坐标转换为空间坐标

-

高精度识别:能够准确识别像素坐标系中的轮轨像素位移和世界坐标系中的动态轮轨位移

5.2 局限与未来工作

-

用于对比的关键点像素坐标是人工标注的,可能存在一定的偶然误差

-

目前缺乏真实线路的实测数据,未来将进行实际线路测试

-

由于列车实际运行环境复杂,相机内参需要在列车定期维护时手动标定

六、总结

本文针对高速列车动态轮轨位移检测问题,提出了融合双目视觉和深度学习的BV-DL方法。该方法的核心贡献包括:

- 自顶向下的关键点检测:ROI检测 + 关键点检测的两阶段方法

- 3D坐标变换模型:实现从像素位移到真实空间位移的转换

- 完整的检测系统:双目相机 + 激光 + 深度学习网络

实验结果表明,BV-DL方法在像素坐标计算和3D坐标计算方面均优于传统图像处理方法和其他深度学习方法,为高速列车运行安全监测提供了新的技术手段。