1. 神经元与大脑

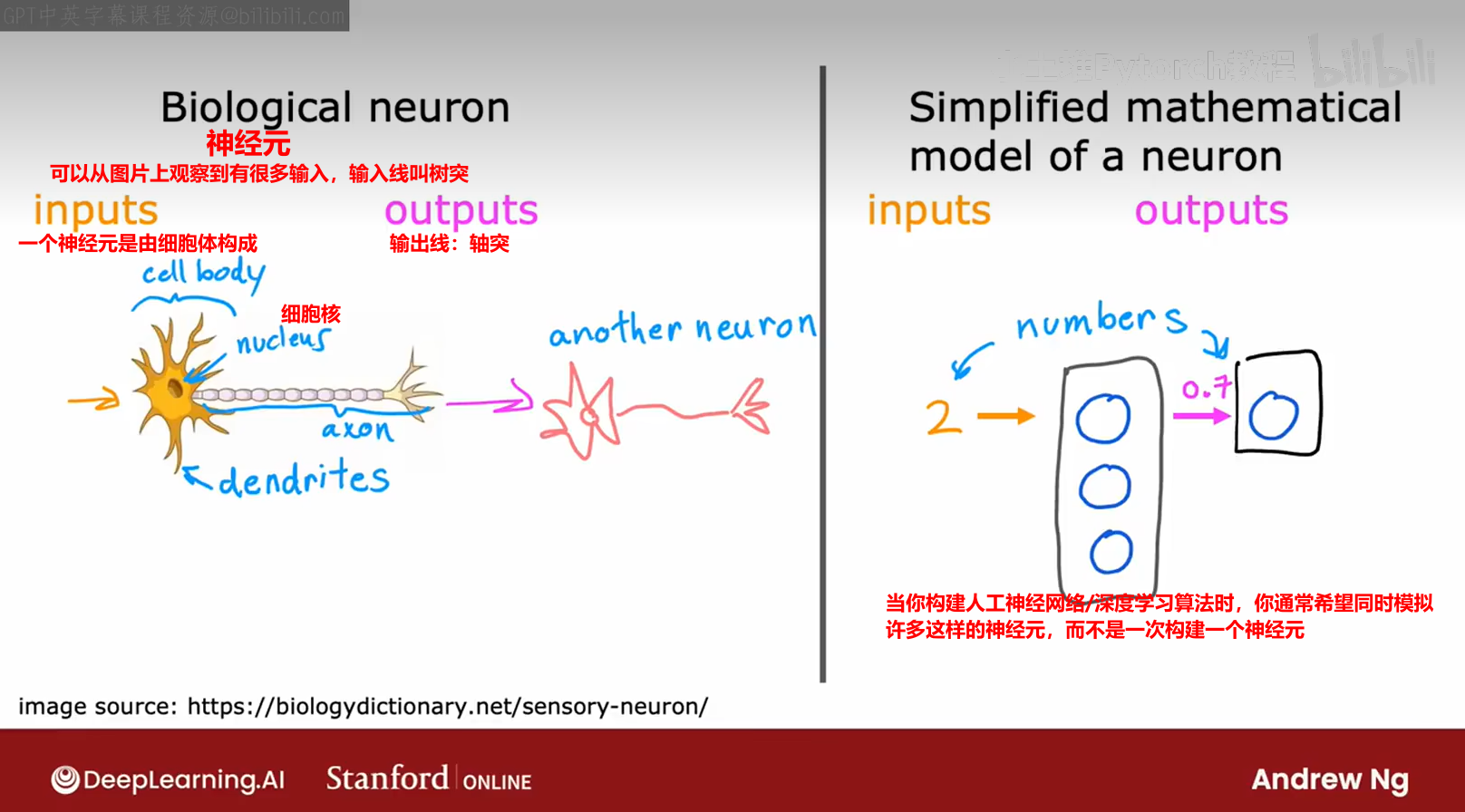

【1】神经网络,有时也称为人工神经网络,已经变得与我们所认为的大脑实际工作和学习方式大不相同

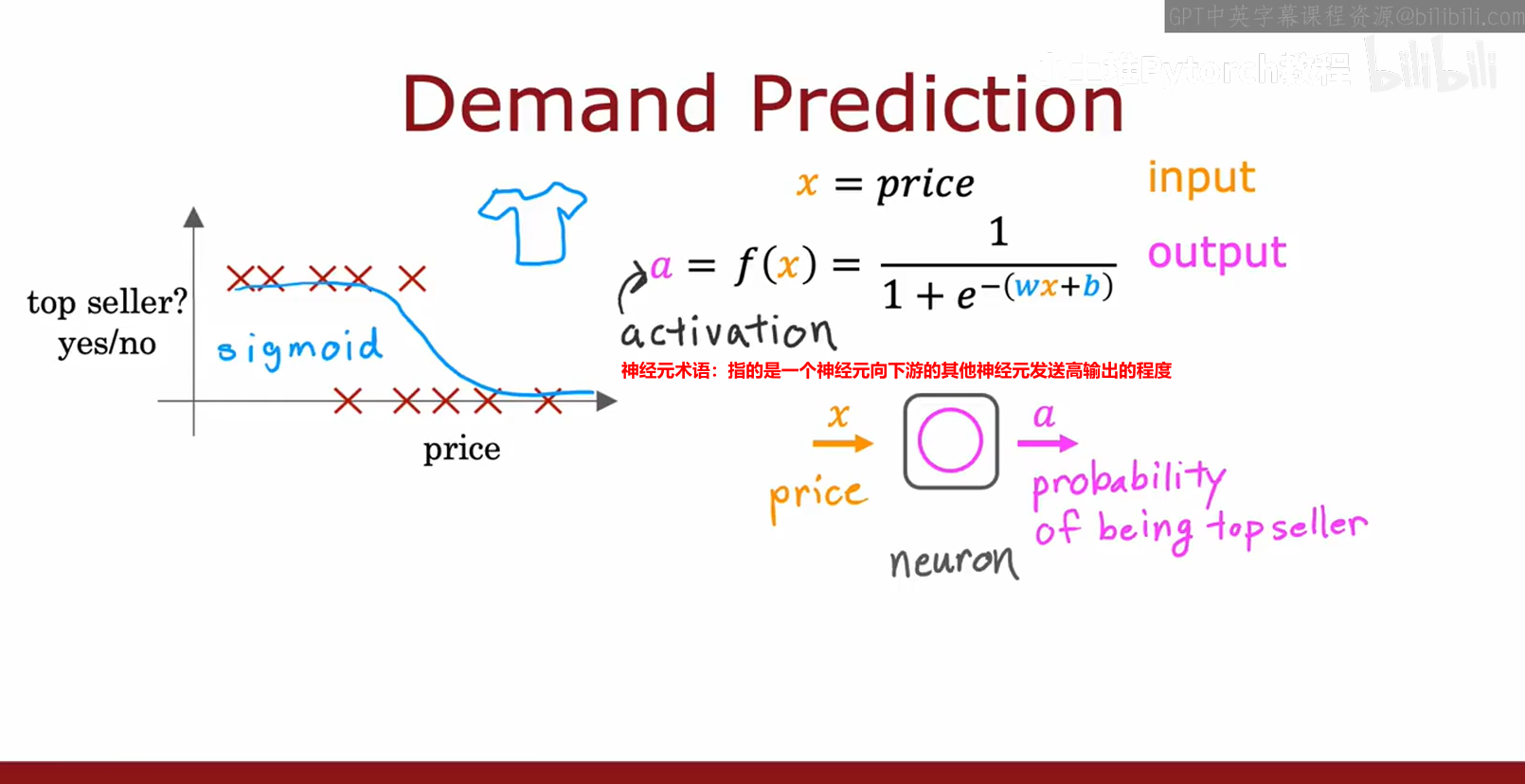

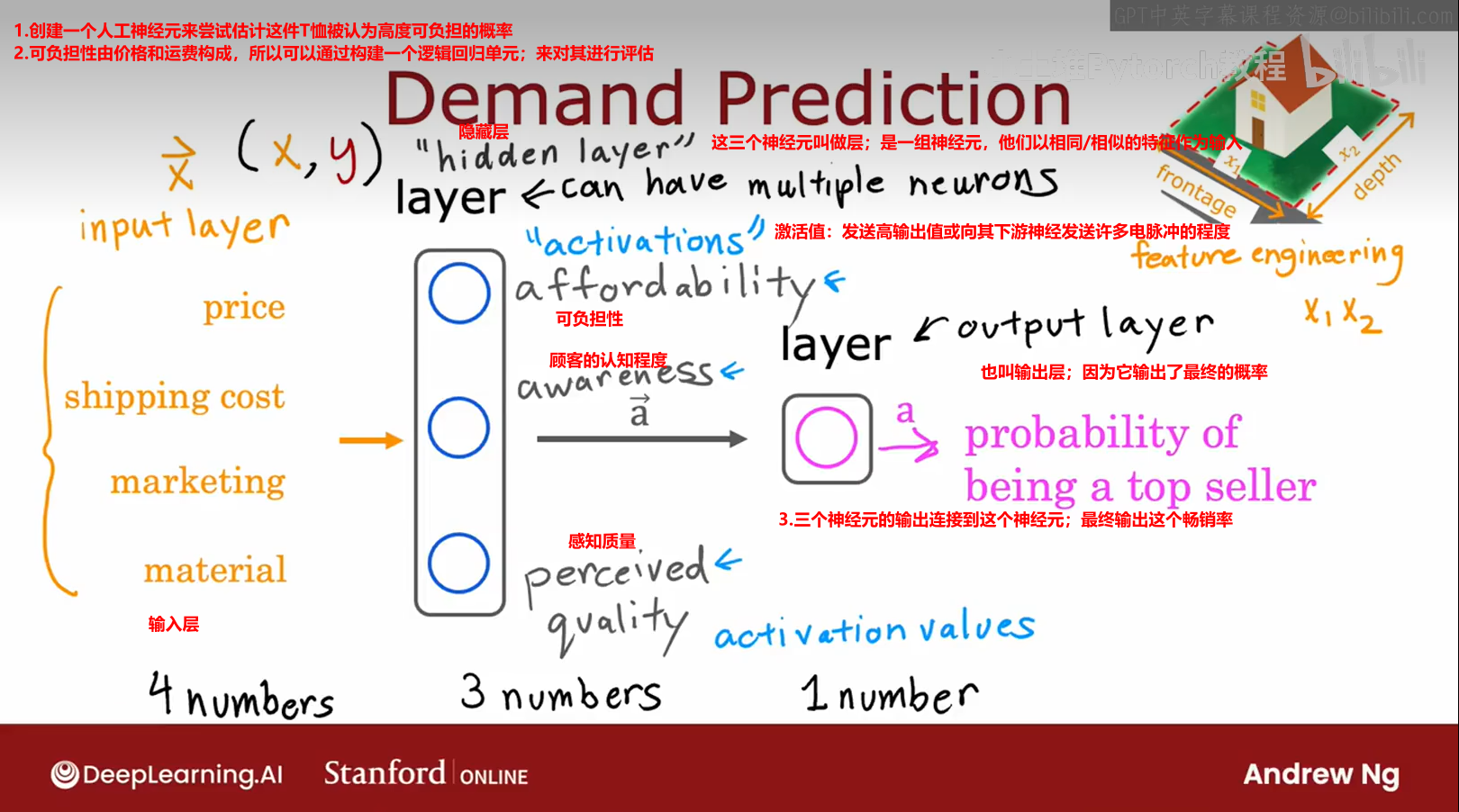

说明神经网络的工作原理,从一个例子开始

神经网络的大致工作:输入层有一个特征向量【这个例子中有四个数字】,他被输入到隐藏层【隐藏层输出三个数字】,再用一个变量来表示隐藏层输出的激活向量,然后输出层将这三个数字作为输入,并输出一个数字,这将是神经网络的最终激活值或最终预测。

尽管之前将这个神经网络描述为一个计算本例子的可负担性、意识、感知质量,但神经网路的一个很好的特性是,当你从数据中训练它,你不需要明确决定什么是特征,如可负担性等,神经网络应该计算,相反,它会自己找出在隐藏层中要使用的特征。

神经元的显著特点是,它能够自行学习隐藏层的特征检测器,神经网络能够从数据中自行找出这些数据。

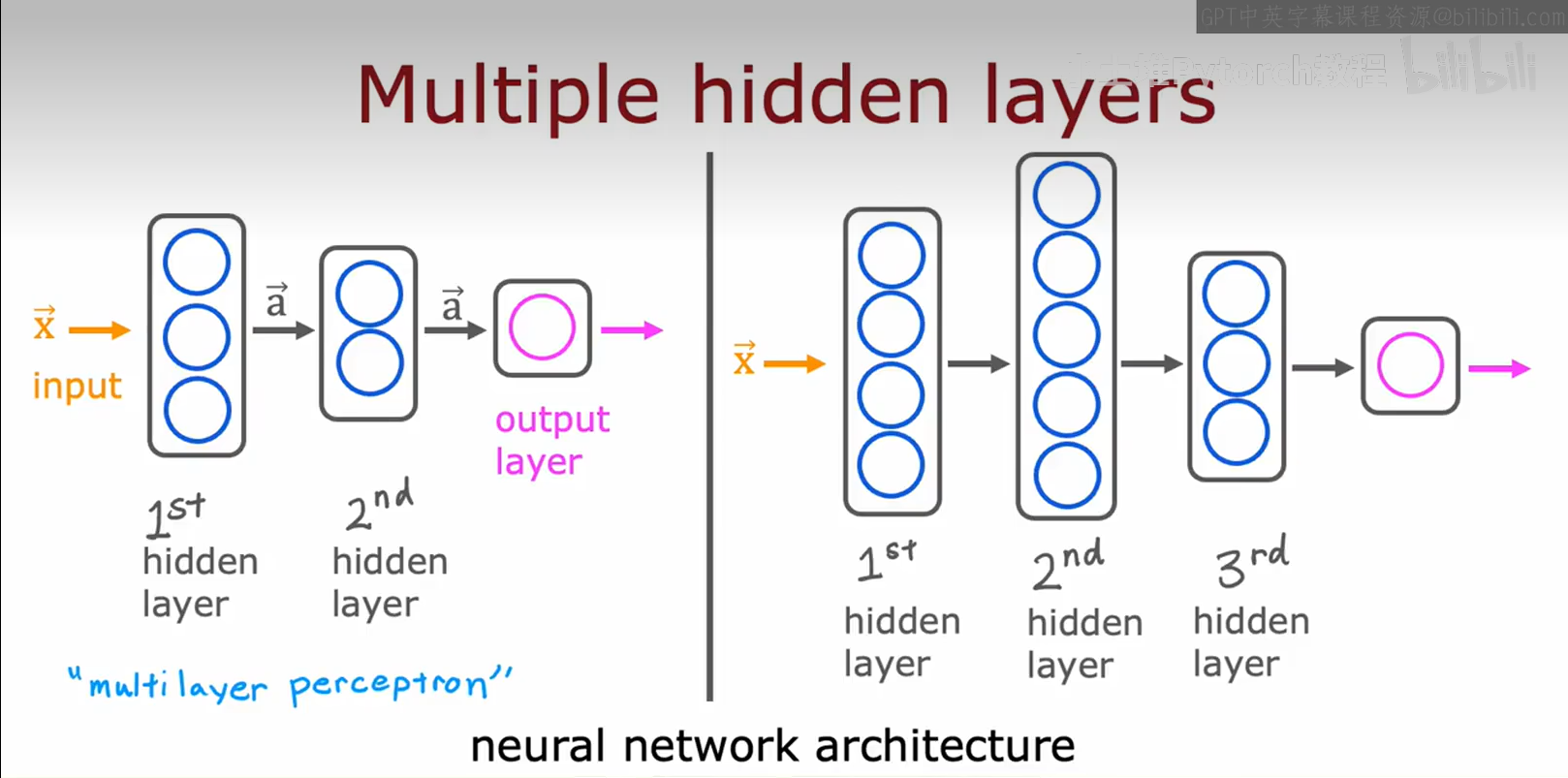

有更多隐藏层的神经网络的例子;当你构建自己的神经网络时,你需要决定的一件事是你想要多少个隐藏层,以及每个隐藏层有多少个神经元。

关于有多少个隐藏层,以及每个隐藏层有多少个神经元的问题神经网络架构的问题 netural network architecture

有时文献中会将这种具有多层的神经网络称为多层感知器multilayer perception

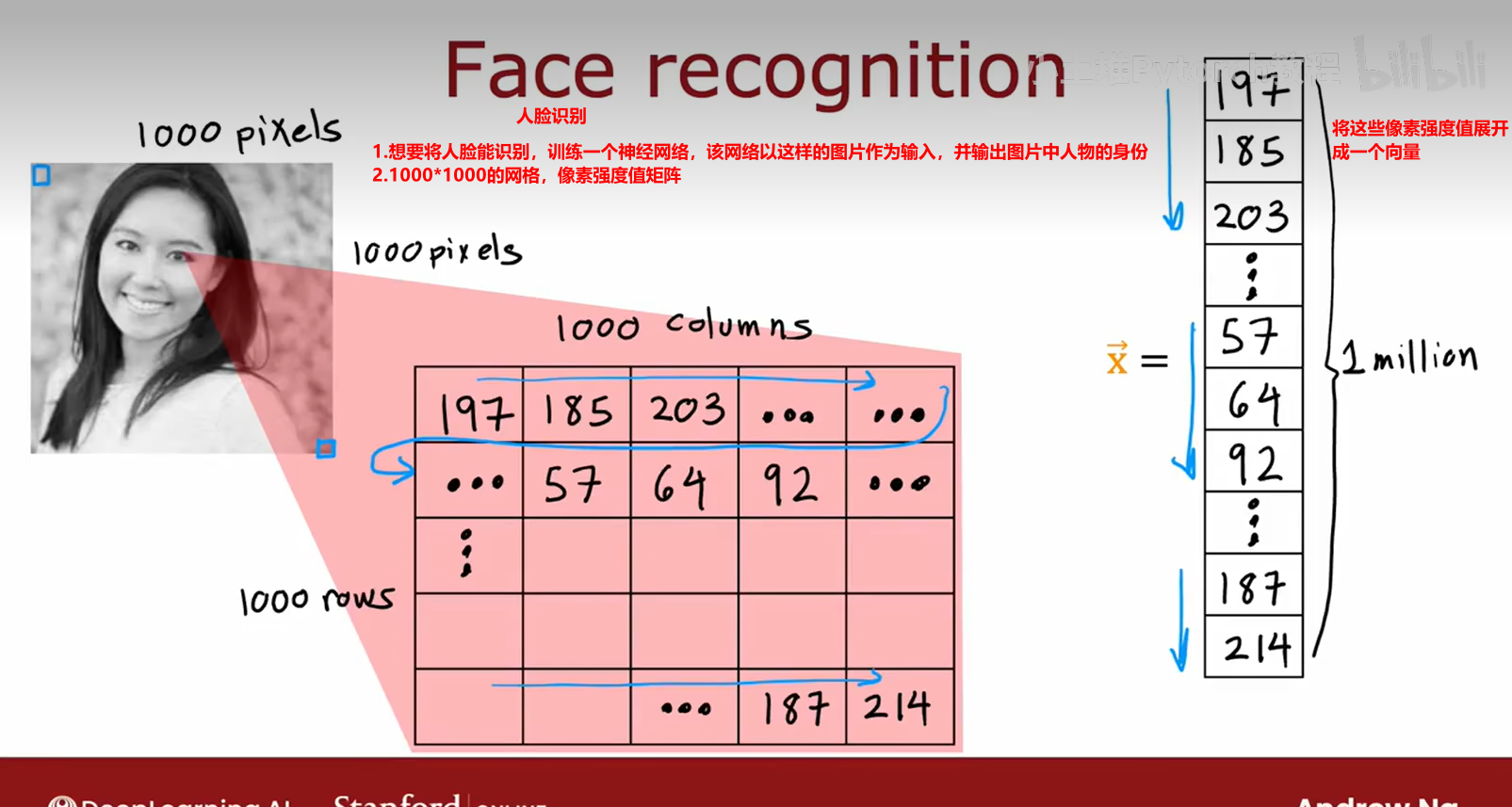

以上是神经网络如何在需求预测示例,我们看看将类似的想法应用于计算机视觉应用

人脸识别的例子

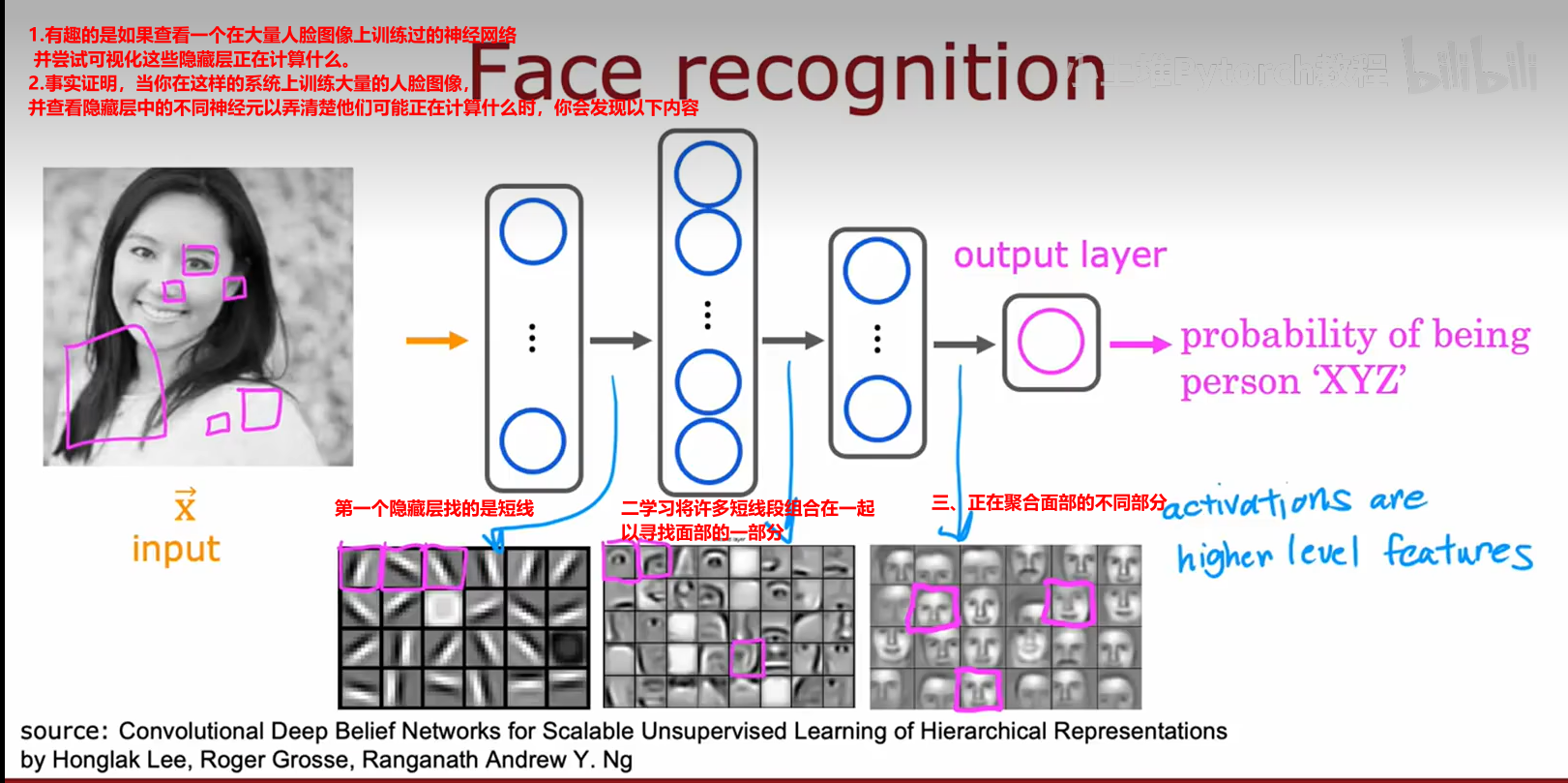

在这个可视化中,第一个隐藏层的神经元被显示为查看相对较小的窗口以寻找这些边缘;然后第二个隐藏层查看更大的窗口,第三个隐藏层查看更大的。

因此这些小神经元的可视化实际上对应于图像中不同大小的区域

因此,只要输入不同的数据,神经网络就会自动学习检测非常不同的特征,以便尝试进行汽车检测、任人物识别或任何特定的训练任务。

以上是对神经网络的直觉描述以及其工作原理