softmax

讲参数指数化,讲指数化的结果归一化。

指数化,将所有的输入参数变为非负,同时加大数据之间的差异。

最后归一化,是为了满足概率分布的基本性质,也就是输出值的和为1。

Softmax(zi)=ezi∑j=1nezj \text{Softmax}(z_i) = \frac{e^{z_i }}{\sum_{j=1}^{n} e^{z_j }} Softmax(zi)=∑j=1nezjezi

所以softmax的作用就是放大并归一化参数。不改变参数的大小次序。

而涉及到非线性变换的时候,就要考虑激活函数

激活函数

sigmoid和ReLU就是两种非线性激活函数,其中ReLU修正线性单元(Rectified linear unit,ReLU)。

ReLU,当输入参数小于0,输出0,当大于0,就输出参数x本身。因为比较简单,所以比较常用。

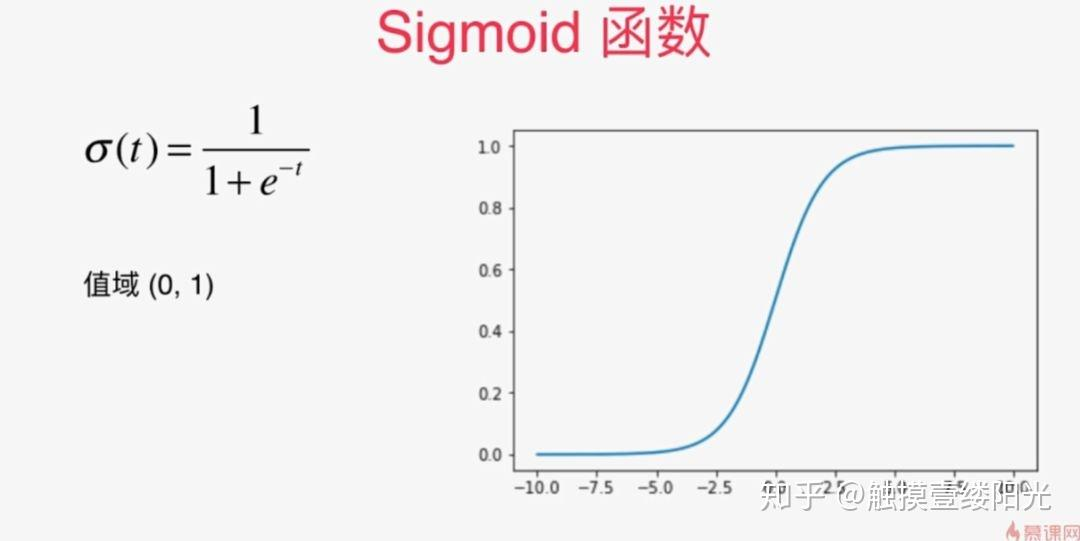

另一种就是sigmoid激活函数,他是讲输出的函数值映射在(0,1)区间

以及tanh函数