目录

[I2I 推荐技术概述](#I2I 推荐技术概述)

一、摘要

人们乐于在在线社区中分享包含个人体验的"笔记",因此推荐符合用户兴趣的笔记已成为一项关键任务。现有在线方法仅将笔记输入基于BERT的模型生成嵌入以评估相似性,但可能未充分利用某些重要线索,例如代表笔记核心概念的标签(hashtags)或分类。实际上,学习生成标签/分类可增强笔记嵌入,两者均将关键信息压缩为有限内容。此外,大型语言模型(LLMs)在自然语言理解上显著优于BERT,引入LLMs至笔记推荐具有广阔前景。

本文提出一种名为NoteLLM的新型统一框架,利用LLMs解决笔记间(I2I)推荐问题。具体而言,通过"笔记压缩提示"将笔记压缩为单个特殊标记,并采用对比学习方法学习潜在相关笔记的嵌入。此外,NoteLLM通过指令微调自动生成笔记摘要及标签/分类。真实场景的广泛验证表明,相比在线基线方法,该方案显著有效,并在小红书推荐系统中实现重大改进。

二、介绍

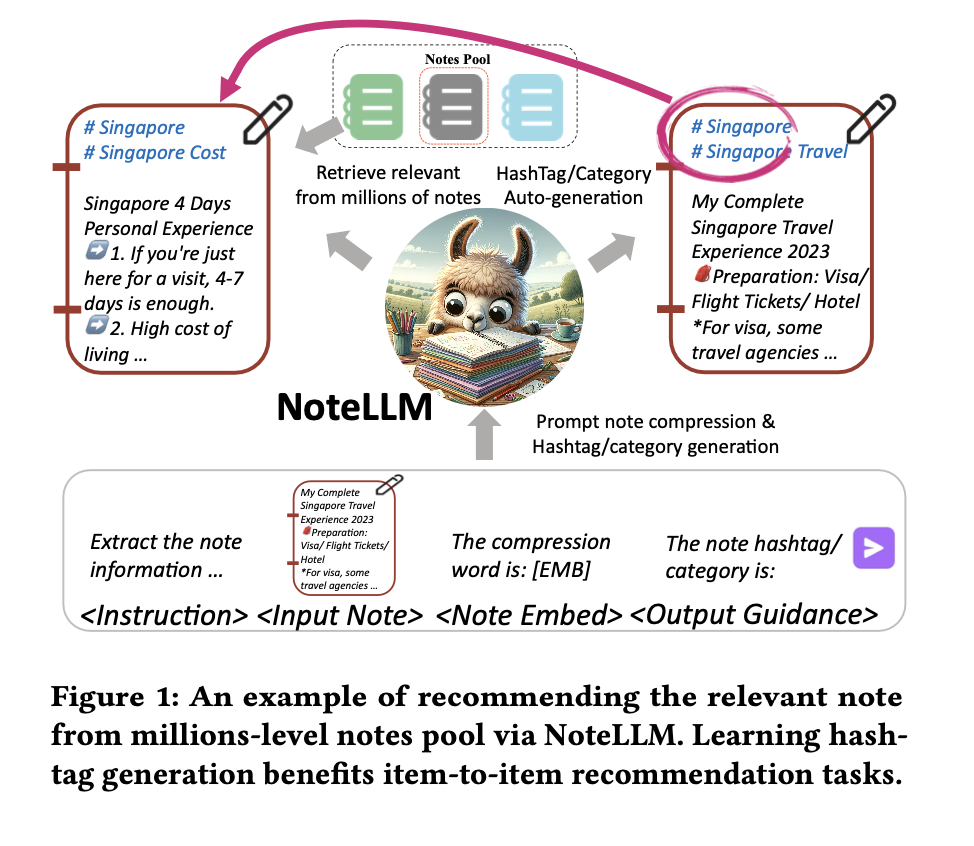

以用户生成内容(UGC)为核心,致力于提供更真实、个性化的用户体验,小红书(Xi-aohongshu)和Lemon8等社交媒体在用户中广受欢迎。这些平台鼓励用户分享产品评价、旅行博客和生活经历等内容,这些内容也被称为"笔记"。通过根据用户偏好提供更个性化的笔记,笔记推荐在提升用户参与度方面发挥着至关重要的作用[16, 34, 48, 64]。物到物(Item-to-item,I2I)笔记推荐是一种从数百万级的笔记库中检索用户可能感兴趣的笔记的经典方法[19, 65]。给定一条目标笔记,I2I方法会根据内容[65]或协同信号[19]选择相关笔记。现有的在线I2I笔记推荐方法通常将整篇笔记内容输入基于BERT的模型[3]以生成笔记嵌入,并根据嵌入相似度推荐相关笔记[11, 36]。然而,这些方法仅将话题标签/类别视为笔记内容的一个组成部分,未能充分利用其潜力。如图1所示,话题标签/类别(例如#新加坡)代表了笔记的核心思想,对于判断两条笔记是否包含相关内容至关重要。实际上,我们发现生成话题标签/类别与生成笔记嵌入类似。两者都将笔记的关键信息压缩到有限的内容中。因此,学习生成话题标签/类别有可能提高嵌入的质量。此外,大型语言模型(Large Language Models,LLMs)最近在自然语言处理[10, 24, 42, 54]和推荐系统[1, 2, 34, 59]方面展现出了强大的能力。然而,目前很少有研究探讨LLMs在I2I推荐中的应用。利用LLMs改进I2I笔记推荐具有相当大的潜力。

受上述见解启发,本文提出了一种名为NoteLLM的统一多任务方法。NoteLLM基于LLMs,从I2I笔记推荐和话题标签/类别生成任务中学习,旨在通过学习提取浓缩概念来增强I2I笔记推荐能力。具体而言,我们首先为每个笔记样本构建一个统一的笔记压缩提示,然后通过预训练的LLMs(例如LLaMA 2 [42])进行解码,这些模型利用特殊标记来压缩笔记内容并同时生成话题标签/类别。为了构建相关笔记对,我们根据用户行为统计所有笔记对的共现分数,并为每个笔记形成共现分数集。我们选择共现分数最高的笔记作为给定笔记的相关笔记。此外,为了为每个样本推荐相关笔记,生成-对比学习(Generative-Contrastive Learning,GCL)利用压缩标记作为每个笔记的嵌入,然后训练LLMs从批量负样本中识别出相关笔记。同时,我们采用协同监督微调(Collaborative Supervised Fine-tuning,CSFT)方法来训练模型为每个笔记生成话题标签/类别。由于I2I笔记推荐任务和话题标签/类别生成任务所学习的压缩标记都旨在提取笔记内容的核心概念,因此CSFT可以有效增强笔记嵌入。

本文的贡献如下:

- 据我们所知,我们的NoteLLM框架是首个利用LLMs解决I2I推荐任务的框架。它揭示了引入LLMs是增强I2I推荐系统的一种实用且具有前景的策略。

- 我们提出了一个多任务框架,通过学习I2I推荐任务和话题标签/类别生成任务来增强笔记嵌入。我们证明了学习生成压缩概念对I2I推荐任务是有益的。

- 在小红书的离线实验和在线工业场景中进行的广泛验证表明,我们提出的技术框架在笔记推荐方面是有效的。

三、相关工作

I2I 推荐技术概述

I2I(Item-to-Item)推荐是一种基于目标物品从大规模物品池中推荐排序列表的关键技术。其实现方式包括预构建I2I索引或在线通过近似k近邻方法检索相关物品。传统I2I推荐通常仅依赖用户行为的协同信号,但这类方法因缺乏用户-物品交互数据而无法处理冷启动物品问题。

内容驱动的I2I推荐

为解决冷启动问题,大量研究转向基于内容的I2I推荐。文本驱动的I2I推荐系统通过物品的文本内容衡量相似性。早期方法采用基于词项的稀疏向量匹配机制,而深度学习技术则通过神经网络更高效地表征文本信息。后续研究将文本转化为同一潜在空间的嵌入向量,通过嵌入相似度衡量关系。

大语言模型(LLMs)的应用潜力

近期,大语言模型因其卓越能力受到广泛关注,但在I2I推荐领域的应用尚未充分探索。现有研究多将LLMs仅视为生成嵌入向量的编码器,未能发挥其生成能力的全部潜力。NoteLLM创新性地利用LLMs生成标签/类别,以增强物品嵌入表征。

大语言模型在推荐系统中的应用

近年来,大语言模型(LLMs)取得了显著进展,许多研究将其引入推荐任务。LLMs与推荐系统的结合主要有三种方法。

数据增强方法

通过LLMs丰富世界知识的特性生成更突出且多样化的数据,优于原始数据。但这类方法需持续预处理测试数据以匹配增强后的训练数据,且高度依赖LLM生成的质量。

直接推荐方法

设计特殊提示词或通过监督微调引导LLMs回答推荐问题。由于上下文长度限制,这类方法通常仅用于重排序阶段,处理数十个候选项目。

嵌入编码方法

将LLMs作为编码器生成项目表征嵌入。虽然能有效提取信息,但放弃了LLMs的生成能力。NoteLLM创新地在召回阶段使用LLMs,并通过学习标签生成优化嵌入生成能力。

从文本生成话题标签/分类

话题标签和分类作为社交媒体上的标注机制,能够简化特定主题内容的识别,并帮助用户查找相关主题内容。从文本生成这些标签可为未标注的笔记创建标识符,或根据用户偏好推荐选项。该领域主要存在三种方法:抽取式、分类式和生成式方法。

抽取式方法从文本中识别关键短语作为话题标签或分类,但无法获取原文中未出现的标签。分类式方法将任务视为文本分类问题,但由于人工生成标签的多样性和自由形式特性,可能导致结果欠佳。

生成式方法直接根据输入文本生成话题标签/分类,但这些方法仅局限于解决标签生成任务。在NoteLLM中,大语言模型(LLM)通过多任务学习,同时执行I2I推荐和标签/分类生成。由于这两项任务的相似性,学习生成标签/分类也能提升I2I推荐的效果。

四、问题定义

问题定义

本节介绍问题定义。假设笔记池为 N = {𝑛₁, 𝑛₂, ..., 𝑛ₘ} ,其中 𝑚 表示笔记数量。每条笔记包含标题、标签、类别和内容,第 𝑖 条笔记记为 𝑛𝑖 = (𝑡𝑖, 𝑡𝑝𝑖, 𝑐𝑖, 𝑐𝑡𝑖) ,其中 𝑡𝑖 、𝑡𝑝𝑖 、𝑐𝑖 、𝑐𝑡𝑖 分别代表标题、标签、类别和内容。

任务描述

笔记间推荐任务(I2I)

给定目标笔记 𝑛𝑖 ,基于大语言模型(LLM)的检索器需从笔记池 N {𝑛𝑖} 中筛选出与目标笔记最相似的 𝑘 条笔记并进行排序。

标签生成任务

利用 LLM 根据标题 𝑡𝑖 和内容 𝑐𝑡𝑖 生成对应的标签 𝑡𝑝𝑖。

类别生成任务

利用 LLM 根据标题 𝑡𝑖 、标签 𝑡𝑝𝑖 和内容 𝑐𝑡𝑖 生成对应的类别 𝑐𝑖。

本篇内容就到这里,下篇会详细讲解方法论。

下篇文章:推荐大模型系列-NoteLLM: A Retrievable Large Language Model for Note Recommendation(二)