虚拟机性能优化实战:从基础调优到深度压榨性能

在云计算、企业级应用部署场景中,虚拟机(VM)是资源隔离与弹性扩展的核心载体。但很多时候,虚拟机默认配置无法充分发挥硬件潜力,甚至会因资源争抢、配置不当导致性能瓶颈。本文结合实战经验,从"优化前准备→分层调优实施→效果验证→避坑指南"全流程,拆解虚拟机性能优化的核心方法,帮你快速提升VM运行效率。

一、优化前必做:明确目标与定位瓶颈

优化不是"盲目调参",先明确核心目标与瓶颈点,才能精准发力。

1. 明确优化目标

不同场景目标差异较大,常见目标包括:

-

计算密集型(如大数据分析、AI训练):提升CPU利用率、减少任务执行耗时;

-

IO密集型(如数据库、文件服务器):降低磁盘IO延迟、提升吞吐量;

-

内存密集型(如缓存服务、中间件):减少内存交换、提升内存命中率;

-

通用场景:平衡CPU、内存、IO资源,降低虚拟机卡顿、提升稳定性。

2. 瓶颈定位工具与方法

通过工具采集指标,避免"凭感觉调优":

-

基础监控工具:

top/htop(CPU/内存占用)、iostat(磁盘IO)、vmstat(系统整体状态)、netstat/ss(网络连接); -

虚拟机专属工具:VMware ESXi Host Client、Hyper-V管理器、QEMU Monitor(KVM)、VirtualBox性能监控;

-

进阶工具:Prometheus+Grafana(长期指标采集与可视化)、perf(CPU性能分析)、blktrace(磁盘IO追踪)。

核心指标参考(需结合业务场景调整):

| 指标类型 | 关键指标 | 预警阈值(参考) |

|---|---|---|

| CPU | 平均负载(load average)、CPU使用率 | load average > CPU核心数*1.5;CPU使用率持续>85% |

| 内存 | 内存使用率、交换分区(Swap)使用率、页交换次数(si/so) | 内存使用率持续>90%;Swap使用率>20%;si/so频繁非0 |

| 磁盘IO | IOPS、吞吐量(MB/s)、平均延迟(await) | await持续>50ms;IOPS接近存储设备上限 |

| 网络 | 带宽利用率、网络延迟(ping)、丢包率 | 带宽利用率>80%;延迟>100ms;丢包率>1% |

二、分层优化实战:从硬件到虚拟机的全链路调优

虚拟机性能受"硬件底层→宿主机系统→虚拟机配置→应用"多层影响,按从下到上的顺序优化,效果更显著。

1. 硬件层优化:夯实性能基础

硬件是性能的上限,重点优化CPU、内存、存储、网络四大核心硬件:

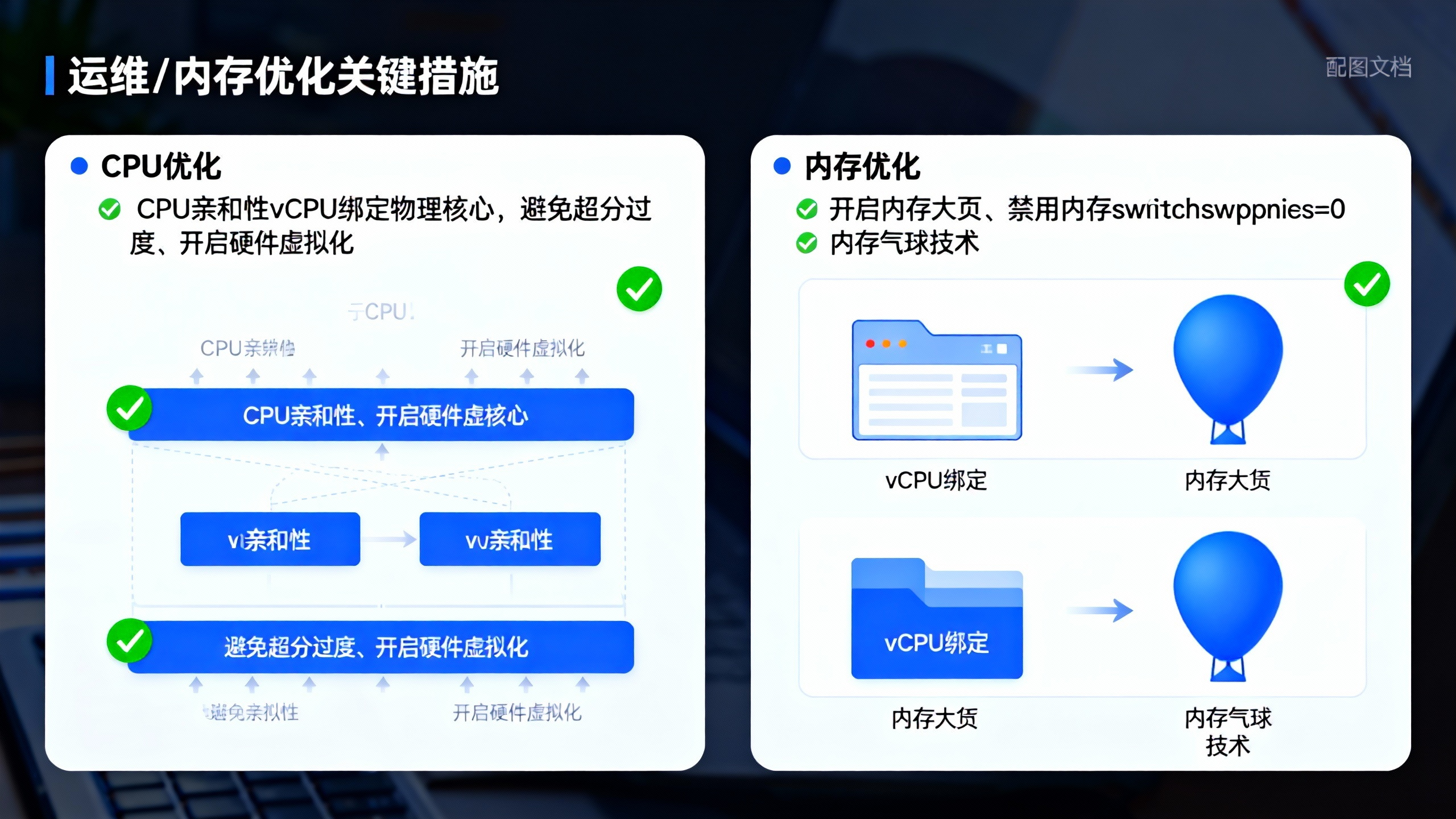

(1)CPU优化

-

选择高性能CPU:优先选多核、高主频、支持硬件虚拟化(Intel VT-x/AMD-V)的CPU,开启超线程(HT)提升并发处理能力;

-

CPU亲和性(CPU Pinning):将虚拟机的vCPU绑定到物理CPU核心,避免vCPU在不同物理核心间切换,减少缓存失效(如KVM通过virsh edit配置cpuset,VMware在虚拟机设置中开启"CPU亲和性");

-

避免CPU超分过度:vCPU总数不建议超过物理CPU核心数的1.5倍(计算密集型场景建议1:1),超分过高会导致CPU争抢,出现"上下文切换风暴"。

(2)内存优化

-

配置合适的内存大小:根据业务需求分配内存,避免"内存不足导致Swap频繁"或"内存过剩浪费资源",建议预留物理内存的10%-20%给宿主机;

-

开启内存气球(Ballooning):在VMware、KVM等虚拟化平台中启用气球驱动,实现内存动态调度,当宿主机内存紧张时,可从空闲虚拟机中"借调"内存,提升整体内存利用率;

-

禁用不必要的内存交换:对于内存密集型应用,可通过修改

/etc/sysctl.conf设置vm.swappiness=0(Linux系统),减少内存交换(需确保内存充足,避免OOM); -

开启内存大页(HugePages):将内存页大小从默认的4KB提升到2MB或1GB,减少页表项数量,降低CPU对页表的查询开销,尤其适合内存量大的虚拟机(如数据库、大数据节点)。

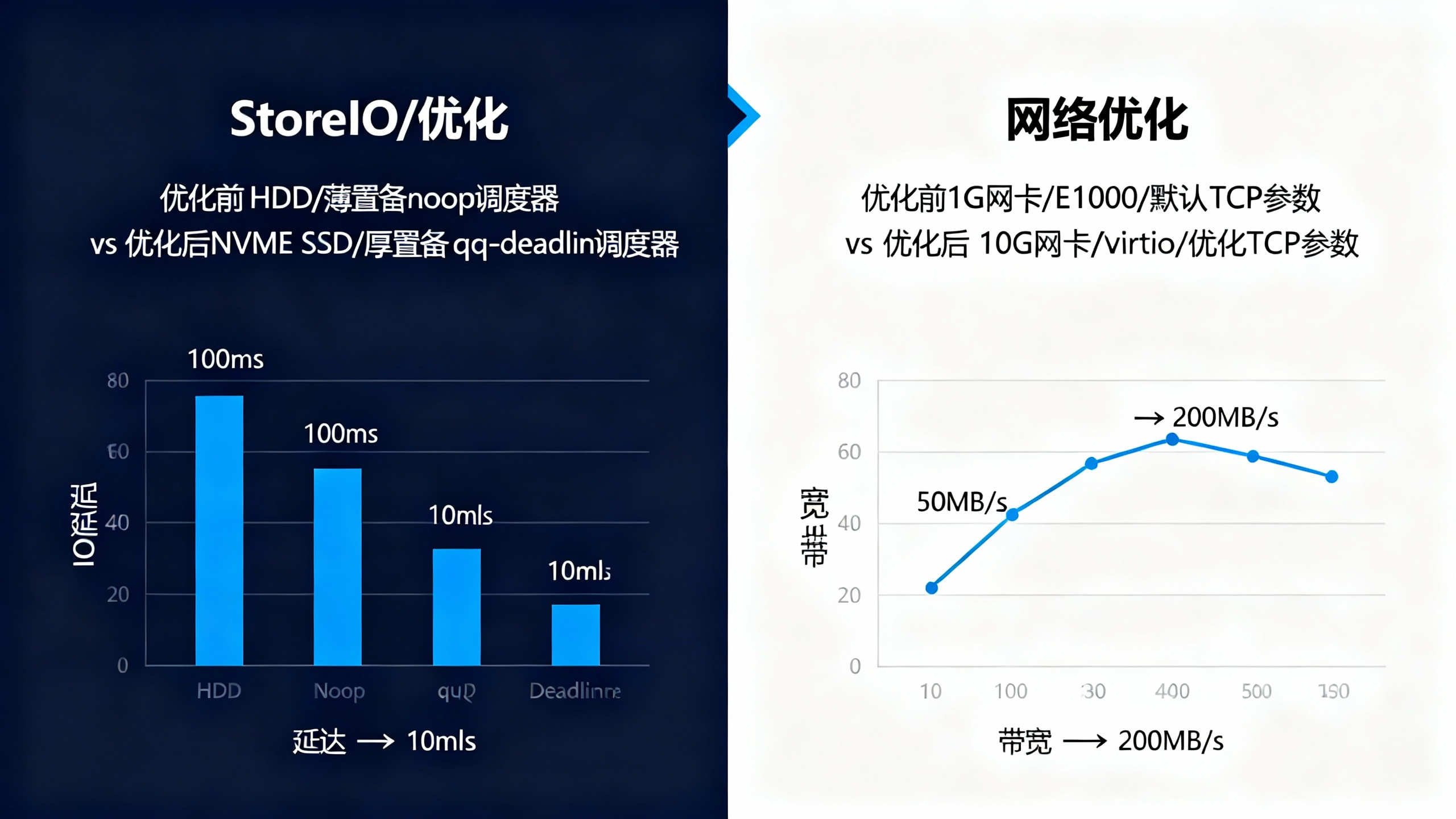

(3)存储IO优化

存储IO是很多虚拟机的性能瓶颈,重点从"存储介质→IO调度→虚拟机配置"优化:

-

升级存储介质:将机械硬盘(HDD)替换为固态硬盘(SSD)或NVMe SSD,IO延迟可降低一个数量级;对于分布式存储,确保存储节点性能均衡;

-

选择合适的IO调度器:Linux系统中,SSD/NVMe建议使用

mq-deadline或none(noop)调度器,HDD建议使用mq-deadline(通过echo mq-deadline > /sys/block/sda/queue/scheduler临时生效,修改/etc/udev/rules.d/60-io-scheduler.rules永久生效); -

虚拟机磁盘配置:使用"厚置备延迟置零"(VMware)或"raw格式"(KVM),避免薄置备的空间分配开销;开启磁盘缓存(如VMware的"写入缓存"),但需注意数据安全(建议搭配UPS);

-

分散IO压力:将不同IO负载的虚拟机分散到不同存储卷,避免单个存储设备成为瓶颈;对于数据库等高频IO应用,可使用多磁盘阵列(RAID 0/10)提升吞吐量。

(4)网络优化

-

提升网络带宽:将虚拟机网卡从1G网卡升级为10G网卡,避免带宽不足导致网络阻塞;

-

开启网卡多队列(RSS):在支持多队列的网卡中,为虚拟机配置多个vCPU队列,实现网络中断负载均衡,提升网络并发处理能力;

-

优化网络参数:调整TCP参数(如

net.core.somaxconn提升最大监听队列数、net.ipv4.tcp_tw_reuse复用TIME_WAIT连接),减少网络延迟与连接开销; -

避免网络广播风暴:在虚拟化网络中,合理划分VLAN,隔离不同业务的网络流量,减少广播包对虚拟机性能的影响。

2. 宿主机系统层优化

宿主机是虚拟机的运行基础,优化宿主机可提升整体虚拟化效率:

-

精简宿主机服务:关闭不必要的系统服务(如邮件服务、打印服务),减少资源占用;

-

升级虚拟化软件:使用最新版本的VMware ESXi、KVM(QEMU/Libvirt)、Hyper-V,修复旧版本的性能bug,获取新的性能优化特性;

-

配置宿主机CPU调度:VMware开启"高性能"电源管理模式,KVM通过

virsh schedulerinfo调整CPU调度策略(如使用"credit2"调度器),避免CPU频率波动导致性能下降; -

限制宿主机资源占用:为宿主机预留足够的CPU、内存资源,避免宿主机系统与虚拟机争抢资源(如VMware建议预留2个CPU核心、4GB内存给ESXi)。

3. 虚拟机层面优化

针对单个虚拟机的配置调优,精准匹配业务需求:

(1)CPU配置

-

合理分配vCPU数量:避免"vCPU过多"(导致上下文切换频繁)或"vCPU过少"(CPU瓶颈),一般遵循"vCPU数量 ≤ 物理CPU核心数",计算密集型场景建议vCPU与物理核心1:1映射;

-

开启CPU硬件辅助虚拟化:确保虚拟机开启Intel VT-x/AMD-V、Intel VT-d/AMD-Vi(IOMMU),提升CPU虚拟化效率,支持设备直通;

-

避免vCPU超分:计算密集型场景严格禁止vCPU超分,通用场景超分比例不建议超过1.2:1。

(2)内存配置

-

精准分配内存:根据业务实际内存占用分配,如数据库虚拟机内存建议为物理内存的50%-70%,缓存服务可分配更高比例;

-

开启内存压缩(VMware):当内存紧张时,通过内存压缩减少Swap使用,提升性能;

-

避免内存过度共享:KVM的内存共享(KSM)适合相同镜像的虚拟机,但会增加CPU开销,内存充足时可关闭。

(3)磁盘配置

-

选择合适的磁盘格式:VMware优先使用VMDK厚置备,KVM优先使用raw或qcow2(开启qcow2的写缓存);

-

启用磁盘IO限制(按需):对于多租户场景,为虚拟机设置磁盘IO上限,避免单个虚拟机占用过多IO资源;

-

定期整理磁盘碎片:Windows虚拟机定期执行磁盘碎片整理,Linux虚拟机使用

fstrim释放未使用的空间(SSD适用)。

(4)网络配置

-

配置合适的网卡类型:VMware使用VMXNET3网卡(性能优于E1000),KVM使用virtio网卡,提升网络吞吐量;

-

合理分配网络带宽:为虚拟机设置网络带宽上限(如VMware的"流量 shaping"),避免网络拥堵;

-

关闭不必要的网络服务:虚拟机内关闭IPv6(未使用时)、网络文件共享等不必要的服务,减少网络开销。

(5)Guest OS优化

-

安装虚拟化工具:VMware安装VMware Tools,KVM安装virtio驱动,Hyper-V安装Integration Services,提升硬件兼容性与性能;

-

精简Guest OS:关闭不必要的服务、进程,禁用自动更新、防火墙(内网环境)等非核心功能;

-

优化系统参数:根据业务场景调整系统参数(如数据库虚拟机调整文件描述符限制、TCP连接超时时间)。

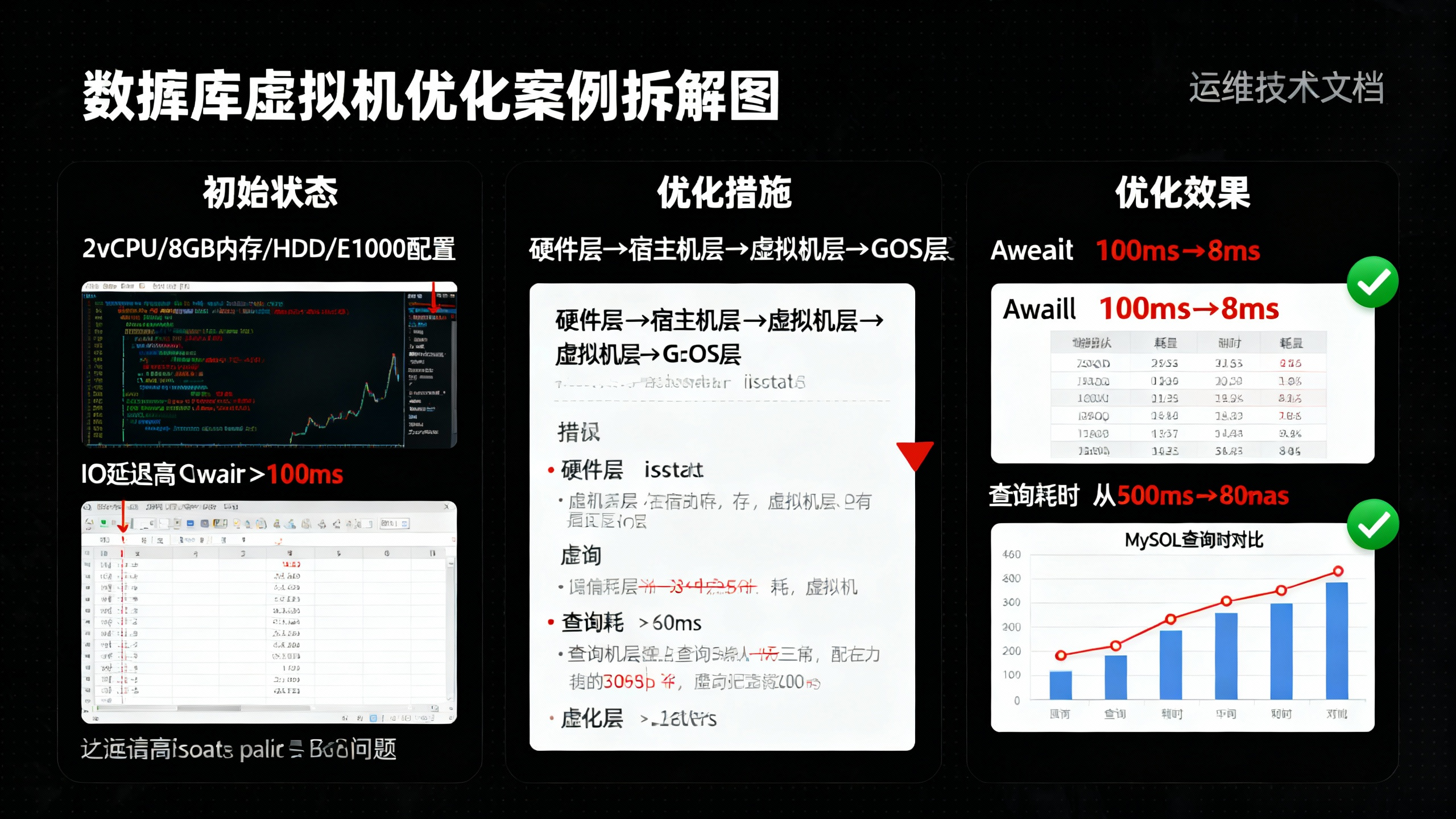

三、实战案例:数据库虚拟机性能优化

以"MySQL数据库虚拟机(KVM环境,IO密集型)"为例,展示优化全流程:

1. 初始状态与瓶颈

配置:2vCPU、8GB内存、1块HDD磁盘(薄置备)、E1000网卡;

问题:MySQL查询延迟高,iostat显示磁盘await持续>100ms,CPU使用率低(20%),内存使用率60%。

2. 优化措施

-

硬件层:将HDD替换为NVMe SSD,网卡升级为virtio;

-

宿主机层:设置IO调度器为mq-deadline,开启CPU亲和性(将虚拟机vCPU绑定到物理核心2-3);

-

虚拟机层:vCPU提升到4核,内存保持8GB,磁盘改为raw格式(厚置备),开启内存大页(2MB);

-

Guest OS层:安装virtio驱动,关闭防火墙,调整TCP参数(

net.core.somaxconn=1024),MySQL配置调整(innodb_buffer_pool_size=4GB,开启innodb_flush_log_at_trx_commit=2)。

3. 优化效果

-

磁盘IO延迟:await从100ms+降至10ms以内;

-

MySQL查询延迟:复杂查询耗时从500ms降至80ms;

-

CPU使用率:提升至50%-60%(资源充分利用),无明显上下文切换风暴。

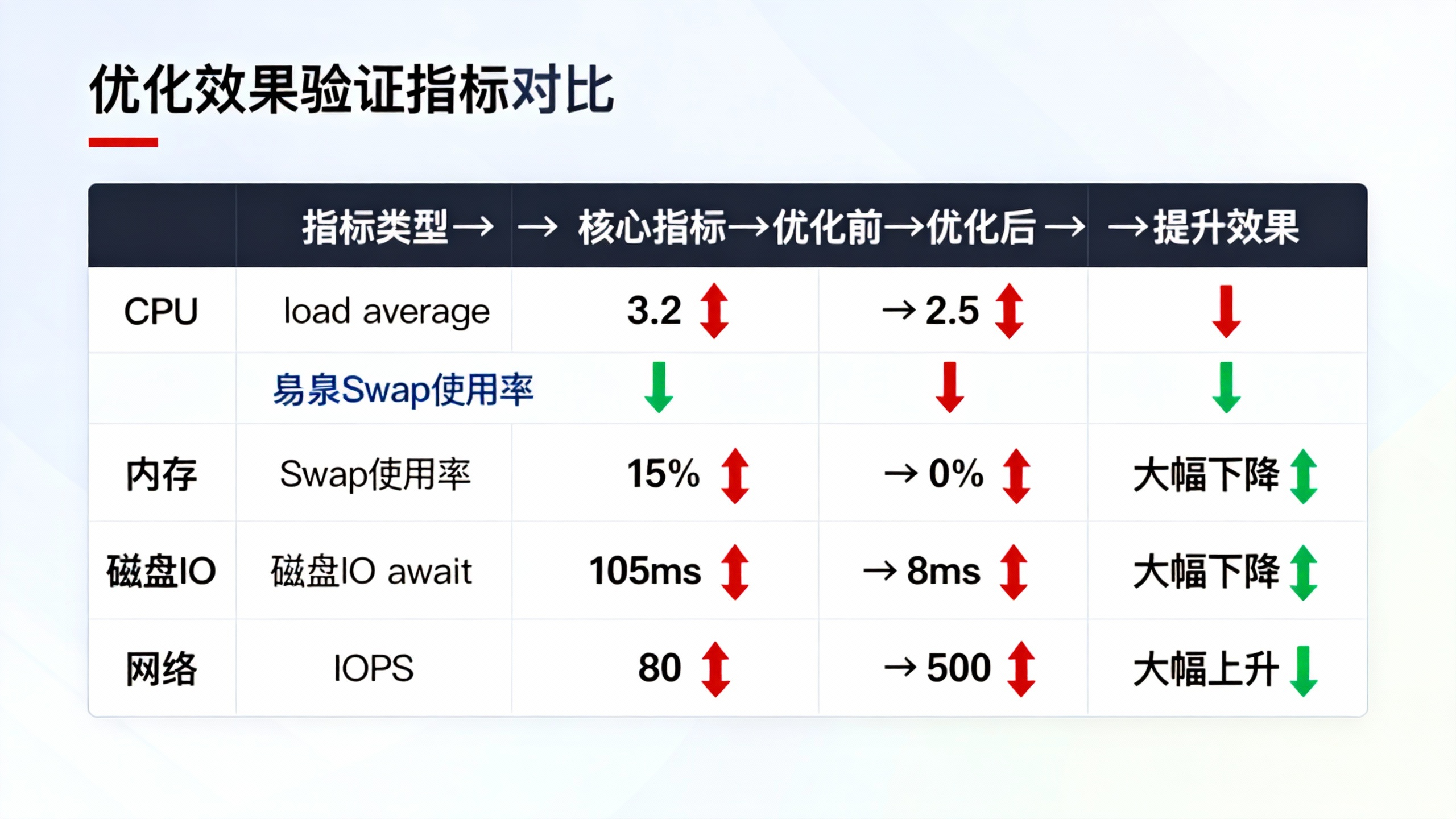

四、优化效果验证:量化指标+业务验证

优化后需通过"指标对比+业务验证"确认效果,避免"调优后性能反而下降":

1. 指标对比

采集优化前后的核心指标,形成对比表:

| 指标类型 | 核心指标 | 优化前 | 优化后 | 提升效果 |

|---|---|---|---|---|

| CPU | 平均负载、CPU使用率 | load average=3.2,使用率20% | load average=2.5,使用率60% | CPU资源充分利用 |

| 内存 | 内存使用率、Swap使用率 | 60%,Swap使用率15% | 65%,Swap使用率0% | 消除内存交换 |

| 磁盘IO | await、IOPS、吞吐量 | await=105ms,IOPS=80,吞吐量=50MB/s | await=8ms,IOPS=500,吞吐量=200MB/s | IO延迟降低92%,吞吐量提升300% |

| 网络 | 带宽利用率、延迟 | 利用率70%,延迟50ms | 利用率65%,延迟15ms | 网络延迟降低70% |

2. 业务验证

从业务角度验证优化效果:

-

数据库场景:统计SQL查询平均耗时、TPS/QPS变化;

-

应用服务场景:统计接口响应时间、并发用户数上限;

-

批处理场景:统计任务执行总耗时。

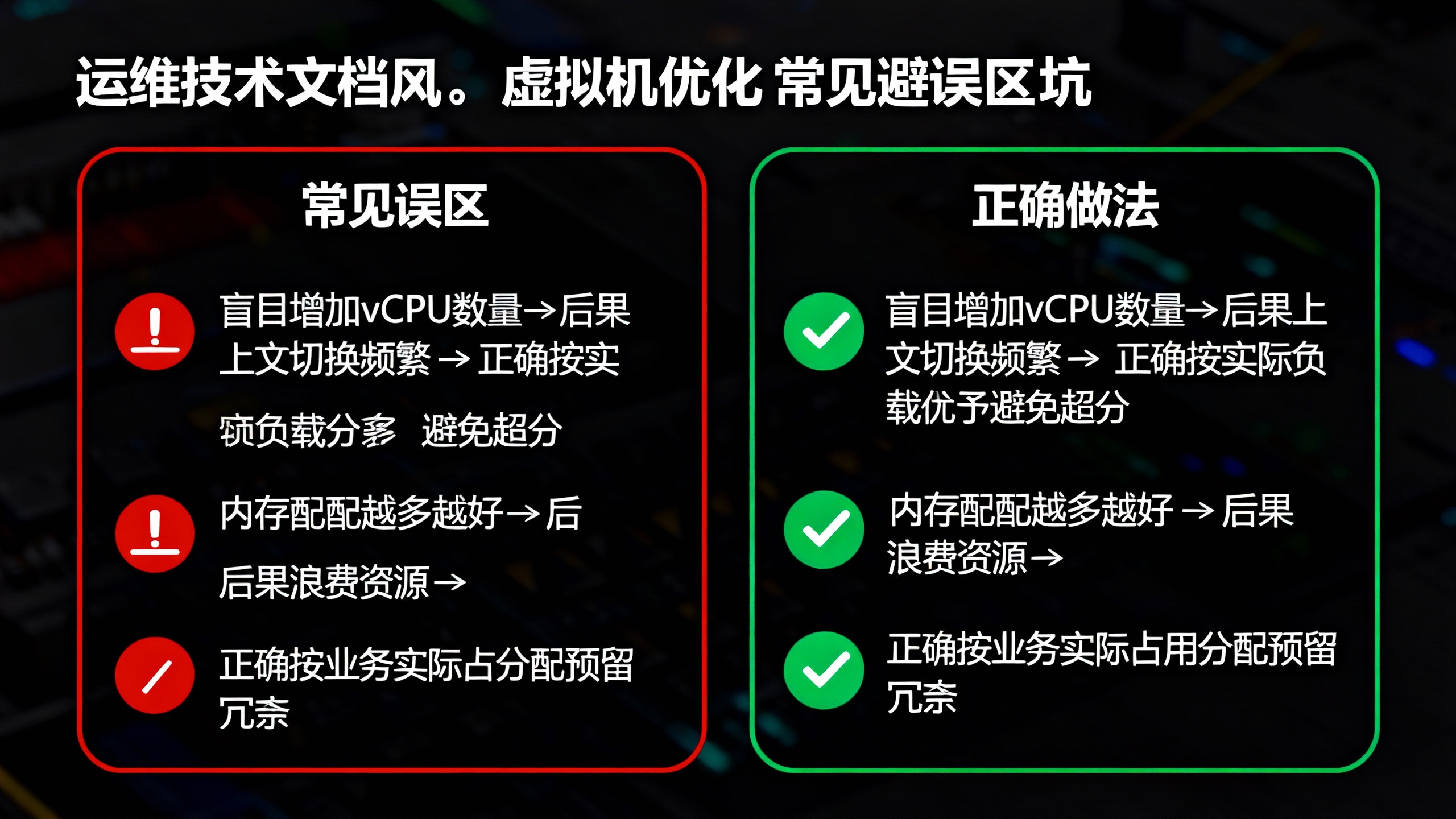

五、避坑指南:虚拟机优化常见误区

-

误区1:盲目增加vCPU数量 → 后果:vCPU过多导致上下文切换频繁,CPU利用率反而下降;正确做法:根据实际CPU负载分配,避免超分过度。

-

误区2:内存分配越多越好 → 后果:浪费内存资源,增加内存管理开销;正确做法:根据业务实际占用分配,预留10%-20%冗余。

-

误区3:开启所有优化特性 → 后果:部分特性(如KSM、磁盘缓存)会增加CPU开销,适得其反;正确做法:根据场景选择性开启,优先保障核心瓶颈指标。

-

误区4:忽略宿主机资源预留 → 后果:宿主机资源不足,导致虚拟机卡顿、崩溃;正确做法:为宿主机预留足够的CPU、内存、IO资源。

-

误区5:优化后不验证效果 → 后果:无法确认优化价值,可能引入新的性能问题;正确做法:优化前后采集指标对比,结合业务场景验证。

六、总结:虚拟机优化的核心逻辑

虚拟机性能优化的核心是"先定位瓶颈,再分层调优":从硬件层夯实基础,到宿主机层优化资源调度,再到虚拟机层精准匹配业务需求,最后通过量化指标验证效果。优化不是"一次性操作",需结合业务变化、硬件升级持续迭代。

建议优先解决"最明显的瓶颈"(如IO延迟过高、内存交换频繁),这类问题解决后,性能往往会有质的提升。对于复杂场景,可借助自动化监控工具(如Prometheus)长期跟踪指标,实现"动态调优"。

你在虚拟机优化过程中遇到过哪些棘手问题?欢迎在评论区交流分享!