###################################################################

论文标题:From Generated Human Videos to Physically Plausible Robot Trajectories

论文地址:https://arxiv.org/abs/2512.05094v1

项目地址:https://genmimic.github.io/

###################################################################

从生成的人体视频到物理可行的机器人轨迹

詹姆斯·倪* ¹ 泽楷·王* ¹ 伟·林* ³ 阿米尔·巴尔* ¹

杨立昆† ² 特雷弗·达雷尔† ¹ 吉腾德拉·马利克† ¹ 罗伊·赫齐格† ¹

¹ 加州大学伯克利分校 ² 纽约大学 ³ 约翰内斯·开普勒大学

摘要

视频生成模型在合成新颖情境下人体动作方面的能力正在迅速提升,使其具备成为情境化机器人控制高级规划器的潜力。为实现这一潜力,一个关键的研究问题仍然悬而未决:人形机器人如何能够以零样本的方式执行生成视频中的人体动作? 这一挑战的出现是因为生成视频通常带有噪声并表现出形态畸变,与真实视频相比,使得直接模仿变得困难。为解决这个问题,我们引入了一个两阶段流程。首先,我们将视频像素提升为4D人体表征,然后重定向到人形机器人的形态。其次,我们提出了GenMimic ------一个以3D关键点为条件的、具有物理意识的强化学习策略,该策略通过对称正则化和关键点加权跟踪奖励进行训练。因此,GenMimic能够模仿来自有噪声生成视频的人体动作。我们构建了GenMimicBench,这是一个使用两个视频生成模型在一系列动作和情境下生成的合成人体运动数据集,为评估零样本泛化能力和策略鲁棒性建立了一个基准。大量实验证明了其在模拟中对强基线的改进,并确认了在Unitree G1人形机器人上无需微调即可实现连贯、物理稳定的运动跟踪。这项工作为实现视频生成模型作为机器人控制高级策略的潜力提供了一条有希望的途径。

1 引言

人形机器人控制[4, 8, 12, 16, 17, 33, 37, 38]的最新进展正在推动能够执行人类任务的通用智能体向前发展。此类智能体尚未实现的一个要求是规划并适应未见过的任务和情境的能力 。与此同时,视频生成模型已经成为在新情境下合成行为的强大工具[27, 43, 60]。随着这些模型质量的不断提高,它们为生成式的、基于视觉的规划与控制提供了一条有希望的途径。实现这一潜力引出了一个核心研究问题:我们如何能够使人形机器人忠实地复现生成视频中描绘的动作?

生成视频的一个关键挑战在于其固有的噪声和形态上的不准确性过于严重,无法直接用作训练数据。我们的目标不是在生成视频上训练,而是构建一个能够进行零样本模仿的鲁棒策略。为实现此目标,我们的解决方案遵循两阶段流程。首先,我们采用现有的4D人体重建模型,例如[13, 61],将像素提升为中间的人体运动轨迹。为了最小化第一阶段带来的形态差距,我们将人体运动轨迹重定向到机器人形态。其次,我们在AMASS[39]上训练,这是一个在IsaacGym[32]中使用强化学习(RL)训练的、具有物理意识的策略,以重定向后的表征为条件,来预测模仿人体动作所需的关节角度。概述请见图1。

我们引入GenMimic作为该流程所需的鲁棒跟踪策略。核心洞见是某些关键点更为重要,并且可以对称相关。因此,GenMimic采用了两个核心特性。首先,我们调整了传统的跟踪奖励,使用输入运动3D关键点的加权组合,使策略能够有选择性地关注最重要的特征。其次,我们添加了一个辅助对称损失,以强制学习对称关键点之间的联系。这个损失引入了一种用于鲁棒性的归纳偏置,提供了一种隐式的纠错机制:当运动的一侧有噪声或包含错误时,策略可以利用其镜像反射的信息。

为了系统地评估这种能力,我们构建了一个合成人体运动数据集GenMimicBench ,该数据集使用最先进的视频生成模型生成:Wan2.1-VACE-14B [60] 和 Cosmos-Predict2-14B-Sample-GROOT-Dreams-GR1[43]。GenMimicBench包含428个视频,涵盖受控室内场景和野外场景。Wan2.1子集包含从NTU RGB+D[55]帧生成的217个干净、多视角视频,覆盖了五位不同受试者的结构化动作组合和相机视角。Cosmos-Predict2子集则补充了从PennAction[67]帧生成的211个视频,展示了八位受试者在真实环境中执行简单动作和物体交互动作。这些部分共同构成了一个多样化的基准,旨在探究人形机器人策略在视觉、形态和运动分布偏移下的鲁棒性和零样本泛化能力。

我们将主要贡献总结如下:(i)我们提出了首个使人形机器人能够执行视频生成模型生成动作的通用框架。(ii)我们提出了GenMimic ,一种新颖的强化学习策略,通过对称正则化和3D关键点奖励的选择性加权组合进行训练,尽管仅基于现有运动捕捉数据训练,却能泛化到有噪声的合成视频。(iii)我们使用Wan2.1和Cosmos-Predict2构建了合成人体运动数据集GenMimicBench,为评估零样本泛化能力和策略鲁棒性建立了一个可扩展的基准。(iv)我们在模拟和真实世界实验中广泛验证了我们的方法。在模拟中,我们提供了详细的消融研究,并展示了相比强基线的显著改进。我们进一步在物理的Unitree G1机器人上确认了方法的可行性,展示了连贯且物理稳定的运动。

2 相关工作

人形策略学习。

基于奖励的人形机器人控制方法已使人形机器人能够学习广泛的移动技能[7, 15, 29, 49, 50, 51, 63]、基于接触的技能[20, 23, 66],甚至跑酷[73]。然而,这些针对特定任务的控制器依赖于手工设计的任务目标,且不易泛化。

近年来,随着基于物理模拟的进展,一种补充性的、使用人体运动捕捉数据的数据驱动学习范式已经出现。早期工作[45, 46]开创了为物理模拟角色从动作中学习的方法。该领域的强劲进展已导致能够学习在各种环境中泛化的技能[37, 58, 59, 68]。H2O[17]、OmniH2O[16]和HumanPlus[12]通过为人形遥操作学习全身控制器,成功地将运动跟踪扩展到了机器人学。

基于这一强劲进展,包括HOVER[18]、GMT[8]、Any2Track[69]、BeyondMimic[33]和TWIST[65]在内的近期工作已经展示了高保真地复现多样化人体运动的能力。VideoMimic[4]和ResMimic[70]通过引入场景感知和物体感知的交互与控制,进一步扩展了这些能力,使机器人能够响应环境情境。这些方法正在推动能够执行多样化人类任务的通用人形智能体向前发展。作为这些工作的补充,我们引入了一种以4D人体重建数据为条件的鲁棒策略,该策略能够进行零样本模仿,并泛化到视频生成模型生成的新颖人体动作。这一能力为基于视觉的生成式规划与控制开辟了一条途径。

机器人学的零样本泛化。

零样本泛化最初作为大规模语言和视觉语言模型(VLMs)的标志出现。CLIP[48]展示了无需微调即可对未见过的类别进行识别和检索,启发了开放词汇检测和分割[11, 14, 30, 71]。现代多模态大语言模型[1, 3, 5, 9, 21, 28, 36, 44, 57, 72]通过上下文提示进一步扩展了这一能力,实现了跨语义和视觉领域的广泛零样本迁移。基于此,机器人学研究将零样本泛化从感知扩展到了动作。视觉-语言-动作框架,如RT-2[74]、SayCan[2]、CLIPort[56]、LLARVA[41]、ARM4R[42]和OpenVLA[26],将机器人控制建立在多模态表征之上,以执行未见过的任务而无需重新训练。同时,通用人形策略[8, 33, 65]将零样本行为扩展到全身模仿和移动,但仍然依赖于高质量的运动捕捉数据作为输入。相比之下,我们的工作探索了从有噪声生成视频重建的运动进行零样本模仿。GenMimic使人形策略能够直接从此类视频生成相应的人体动作,而无需微调。

用于人体运动生成的视频生成模型。

视频生成模型的最新进展使得可控的人体运动合成成为可能,并改进了时间连贯性和语义一致性。扩散-变换器方法如Wan[60]、Hunyuan-Video[27]和MovieGen[47]从文本或视觉提示中捕获结构化的、动作驱动的动态。身份保持方法[10, 19, 22, 34, 64]确保了一致的受试者外观,而多模态和多概念扩展[6, 24, 31, 62]整合了文本、图像和音频以实现细粒度的运动控制。动作感知模型如Cosmos-Predict2[43]和DreamGen[25]进一步将生成式视频合成与预测建模联系起来,产生对具身学习有用的物理可信的运动。基于这一趋势,GenMimic研究人形机器人如何以零样本方式执行生成视频中描绘的人体动作。我们利用Cosmos-Predict2和Wan2.1来生成涵盖不同受试者、视角和动作组合的多样化合成运动,将视频生成模型重新定位为机器人控制的潜在动作规划器。

3 GenMimicBench

为了评估人形控制策略在多样化视觉和运动分布下的零样本泛化能力,我们引入了GenMimicBench ,一个包含428个生成视频的合成人体运动数据集。该数据集使用两个最先进的视频生成模型创建:Wan2.1-VACE-14B [60] 和 Cosmos-Predict2-14B-Sample-GROOT-Dreams-GR1[43]。如图2所示,每个序列都是从一个初始帧和一个描述预期动作的文本提示生成的,从而实现受试者身份、视角和动作的系统性变化。总体而言,GenMimicBench涵盖了广泛的受试者、环境和动作类型,从简单手势到多步组合以及物体交互行为。

Wan2.1视频:受控室内场景。

GenMimicBench的大部分内容使用Wan2.1从NTU RGB+D[55]帧生成。这些片段提供了干净、结构化的室内环境,并配有同步的前、左、右相机视角。我们包含了五位具有不同人口统计学特征、身体比例和服装风格的受试者,确保了外观的多样性,同时保持了场景几何的一致性。这些动作涵盖了四个结构化类别:(a)简单上半身动作 (3个动作:摸头、竖起大拇指、挥手);(b)简单上半身动作 + 行走 (4个动作:无上半身动作、摸头、竖起大拇指、挥手 + 行走);(c)复合上半身动作 (4个序列:摸头 → 竖起大拇指 → 挥手;摸头 → 抱臂;举起右手并指向前方 → 抱臂;交叉手臂 → 打开交叉 → 挥右手);(d)复合上半身动作 + 行走(4个序列,将上述复合动作与行走结合)。这产生了217个多视角室内视频,捕捉了形态、视角和动作组合的细粒度变化。

Cosmos-Predict2视频:网络风格场景。

为了用更大的多样性补充这些受控场景,我们还使用Cosmos-Predict2基于PennAction[67]帧生成了视频。这些片段反映了野外YouTube视频的特征:杂乱的场景、变化的相机运动、不均匀的照明和真实的物体布局。该子集包含217个视频,展示了八位不同的受试者执行简单手势(例如,摸头、竖起大拇指)以及一系列物体交互行为,如开门、举起书本或哑铃、操作日常家居用品。这个部分让策略暴露于受控数据集中不存在的现实复杂性,为评估在自然环境中的鲁棒性提供了一个具有挑战性的测试平台。

总之,GenMimicBench提供了一个统一的、包含428个高方差合成运动序列的集合,涵盖了结构化室内场景和多样化的现实世界视频情境。通过整合受控动作与多样化的野外人体运动,GenMimicBench为评估在视觉、形态和运动分布偏移下的零样本人形策略性能建立了一个全面的基准。该数据集被特意设计用于压力测试鲁棒性,使其非常适合评估依赖于生成视频中噪声或不完美运动重建的策略。

4 从生成视频到人形机器人动作

为了解决从生成视频执行人形动作的挑战,我们在第4.1节介绍了一个基于4D重建的两阶段流程。然后,我们在第4.2节详细描述了我们新颖、鲁棒的GenMimic跟踪策略。方法概述请见图3。

4.1 两阶段流程

阶段1:从像素到4D人形重建。

给定一个生成的输入RGB视频,我们使用最先进的人体重建模型来检测并提取每帧的全局姿态((\theta_{t}\in\mathbb{R}^{7}))和SMPL[35]参数(形状 (\beta_{t}\in\mathbb{R}^{16}) 和每关节角度轴 (J_{t}\in\mathbb{R}^{J\times 3}))。由于形态不匹配,得到的SMPL轨迹不能直接用于人形机器人。因此,我们将SMPL轨迹重定向到机器人的关节空间((q{\text{goal}}_{t})),这结合(\theta_{t})在机器人空间中恢复了全局3D关键点((p{\text{goal}}_{t}))。

阶段2:从4D人形到动作。

为了恰当地泛化到未见过的的人体动作,我们的策略必须对输入中的变化和噪声具有鲁棒性。为实现这一点,我们特意选择3D关键点(p{\text{goal}}_{t})而非关节角度(q{\text{goal}}_{t}),因为关键点对变化更鲁棒,且噪声在此表征中更直接可观测。

给定这些关键点(p{\text{goal}}_{t})和本体感觉信息((o{\text{proprio}}{t})),我们的跟踪策略输出物理上可实现的期望关节角度((q^{\text{des}}{t}))。这些期望关节角度被比例-微分控制器使用,该控制器向机器人输出可执行的扭矩。

接下来,我们详细描述我们的鲁棒跟踪策略。

4.2 GenMimic 策略

4.2.1 预备知识

我们将人形运动跟踪表述为一个由部分可观测马尔可夫决策过程建模的决策问题,定义为状态 (s_{t}\in\mathcal{S}),观测 (o_{t}\in\Omega),动作 (a_{t}\in\mathcal{A}) 和奖励 (\mathcal{R}{t}\in\mathbb{R})。由于 (s{t}) 在真实机器人上难以估计,我们在模拟中使用近端策略优化(PPO)[53]训练了一个特权教师策略((\pi_{s}:\mathcal{S}\rightarrow\mathcal{A}))。然后,我们使用DAgger[52]将学习到的行为提炼成一个学生策略((\pi_{o}:\Omega\rightarrow\mathcal{A}))。

在时间 (t),我们假设可以获取机器人的当前本体感觉状态,包括关节位置((q_{t}))、关节速度((\dot{q}{t}))、根节点角速度((\omega{\text{root}}_{t}))、投影重力向量((g_{t}))和紧接的前一个动作((a_{t-1}))。我们还使用机器人在局部空间(相对于骨盆)中的3D刚体位置((p{\text{local}} {t})),该位置通过正向运动学计算。对于学生策略,我们将过去 (\ell^{\text{proprio}}) 步的本体感觉信息((o{\text{proprio}}_{t}=[q_{t},\dot{q}_{t},\omega{\text{root}}{t},p^{\text{ local}}{t},g_{t},a_{t-1}]))与未来 (\ell^{\text{goal}}) 步的目标3D关键点连接起来。

特权教师策略可以访问模拟器的完整状态信息。这些信息包含机器人的刚体状态信息,包括全局3D位置((p_{t}))、四元数((r_{t}))、线速度((\dot{p}{t}))和角速度((\omega {t})),以及模拟参数((\theta{\text{sim}}))。教师策略不使用本体感觉信息的历史记录((s_{t}=[o{\text{proprio}}{t},p {t},r_{t},\dot{p}{t},\omega {t},\theta^{ \text{sim}}]))或目标未来,但也可以访问目标与机器人位置之间的差值((p^{\text{goal}}{t}-p{t}))。观测空间的完整表格见附录B.2。

4.2.2 鲁棒跟踪策略

跟踪策略如图3所示。从视频生成的的人体动作包含噪声和形态不匹配,这使得它们偏离了训练数据的分布。我们表明,添加加权关键点跟踪奖励和对称增强提供了足够的鲁棒性来解决这些挑战。

加权跟踪。

某些关键点,例如对应于末端执行器的那些,本质上对于任务执行和物理稳定性比躯干或非接触关键点更为关键。因此,我们设计了一个跟踪奖励,使用每个关键点误差的加权组合:

\\mathcal{R}*{t}^{\\text{weighted}}=\\exp\\left(-\\sum_{j=1}^{n}w* {j}\|p_{t,j}-p_{t ,j}^{\\text{goal}}\|_{2}^{2}/\\sigma\^{2}\\right) \\tag{1}

其中每个权重 (w_{j}\geq 0) 且 (\sum_{j=1}^{n}w_{j}=1)。这种表述能够有选择地关注目标中最可靠和与任务相关的方面。对于生成视频,偏向末端执行器而远离不准确的下半身会产生稳定的模仿。

对称损失。

人体表现出固有的双边对称性,其中左右两侧是近似的镜像。我们假设,因为这种对称性作为一种强大的物理归纳偏置,一个明确学习并利用左右关键点之间对称相关性的策略,可以对生成视频中每个关键点的噪声实现更大的鲁棒性。

为了实现这一点,我们在标准的PPO训练目标中加入了一个辅助对称损失 (\mathcal{L}{\text{SYM}}(\pi)),由一个权重系数 (\lambda{\text{SYM}}) 控制:

\\mathcal{L}*{\\text{PPO},\\text{SYM}}(\\pi)=\\mathcal{L}* {\\text{PPO}}(\\pi)+\\lambda *{\\text{SYM}}\\mathcal{L}*{\\text{SYM}}(\\pi) \\tag{2}

对称损失((\mathcal{L}{\text{SYM}}))类似于标准的PPO损失,只是它使用了一个修正的概率比。这个修正比 (\beta{t}^{\text{sym}}) 是基于对称状态和动作计算的:

\\beta_{t}\^{\\text{sym}}=\\frac{\\pi(T_{a}(a_{t})\|T_{s}(s_{t}))}{\\pi_{\\text{old}}(a_ {t}\|s_{t})} \\tag{3}

其中 (T_{s}:S\to S),(T_{a}:A\to A) 是状态和动作的双边对称函数。这个损失有效地增加了在对称状态 (T_{s}(s_{t})) 下选择对称动作 (T_{a}(a_{t})) 的可能性,如果在状态 (s_{t}) 下的原始动作 (a_{t}) 产生了高的优势。

4.2.3 策略学习

在本节中,我们描述了策略学习的细节,包括训练数据、奖励和领域随机化。

数据。

我们在AMASS[39]上训练GenMimic,这是一个大规模的运动捕捉数据集,涵盖了346名受试者和11,451个动作,涉及步行、跑步、跳舞和手势等多种活动。我们应用第一阶段(第4.1节)描述的重定向过程,将所有人体运动轨迹重定向到机器人形态。为确保物理可行性,我们过滤掉涉及物体交互或重定向误差足够高的轨迹,保留了8,123个动作。

奖励。

利用我们专门的跟踪奖励和对称损失(第4.2.2节),我们发现少量的奖励函数项足以用于策略学习。我们使用四个基于机器人关节角度、关节速度、身体位置和身体旋转与目标之间差异的加权跟踪奖励。我们使用三个基于加速度、速度和动作速率的能量正则化项。我们使用两个模拟器特定的惩罚项来抑制不期望的脚部滑动和违反关节限制的行为。我们使用一个方向惩罚项来鼓励稳定性。

除了这些核心项,我们还包括基本的终止惩罚和存活奖励。我们还包括四个脚步惩罚项,以在现实世界中实现更安全的踏步行为。我们注意到所有非加权的跟踪项都是RL中学习人形策略的标准奖励项。更多细节请参见附录B.3节。

领域随机化。

为了增加鲁棒性,我们对跟踪策略的状态和观测施加输入噪声。为了确保策略对外部扰动、环境因素和模拟到真实的差异具有鲁棒性,我们还对关键模拟参数进行了随机化。具体来说,我们对摩擦、质量、PD控制器增益、电机强度和控制延迟进行随机化,并在模拟期间对机器人施加外部脉冲。详细概述请参见附录B.4节。

5 实验

我们在第5.3节中使用在AMASS上训练的策略评估GenMimic模仿人体动作的性能。该评估在模拟中,在GenMimicBench数据集上将我们的方法与强基线进行比较。我们还在第5.4节中使用23自由度的Unitree G1人形机器人在真实环境中评估了我们的方法。最后,我们在第5.5节进行了严格的消融研究,展示了我们的设计选择。

5.1 实现细节

流程的第一阶段利用TRAM[61]从视频进行4D人体重建,然后使用PHC[37]将4D人体运动重定向到机器人形态。对于第二阶段,我们在PyTorch中将GenMimic实现为一个隐藏层维度为([512,256,128])的多层感知机。我们实现了类似于[40]的对称损失。跟踪策略以50 Hz 运行,而PD控制器通过同步的4倍子步进以200 Hz运行。学生策略使用本体感觉历史长度 (\ell^{\text{proprio}}=10) 和目标未来长度 (\ell^{\text{goal}}=10)。训练在IsaacGym[32]中进行,使用了超过 (1.5B) 个样本,利用了四块NVIDIA RTX 4090 GPU。部署使用单块NVIDIA 4060 Mobile GPU。更多细节见附录B节。

5.2 基线

我们在模拟中将GenMimic与几个现有的最先进的跟踪策略基线进行比较。GMT[8]使用混合专家教师和自适应采样实现通用运动跟踪,并以自由度(DoF)为条件。TWIST[65]通过整合真实世界运动捕捉训练数据实现高质量性能。BeyondMimic[33]提出了一种替代的自适应采样策略和一组可泛化的超参数,但依赖于实时状态估计。对于特权比较,我们重新实现了BeyondMimic并在AMASS上训练,以及在其公开数据集上训练TWIST教师策略。对于非特权比较,我们使用了GMT和TWIST学生策略的公开预训练检查点。更多细节见附录B.5节。

5.3 模拟实验

我们在GenMimicBench数据集的模拟中将我们的方法与强基线进行了比较。结果见表1。

为了有效比较策略,我们报告了一系列指标,这些指标是GenMimicBench中每个动作256次运行的平均值。我们将**成功率(SR)**定义为机器人没有摔倒且其全局位置与目标偏差不超过0.5米的运行次数百分比。策略的运动跟踪保真度通过全局(MPKPE)和局部(LMPKPE)坐标中的平均每关键点位置误差(厘米)来量化。具体来说,MPKPE衡量整体跟踪性能,而LMPKPE评估策略匹配目标姿态的能力。

然而,标准的MPKPE和LMPKPE指标偏向于成功,因为它们仅在终止前的运行段上计算。因此,比较具有不同成功率的方法会产生误导:一个早期失败的策略只从其短暂的成功段贡献误差,而一个鲁棒的策略则在跨越更广、更具挑战性动作的更长轨迹上累积误差。为了在同一输入分布下进行无偏比较,我们还报告了无条件指标MPKPE-NT和LMPKPE-NT(无终止),这些指标在整个运动运行过程中计算,没有任何终止条件。我们注意到所有指标都提供了有用的信号,但SR仍然是最关键的,因为其他指标对作为生成视频真值的噪声运动更为敏感。

如表1所示,GenMimic在特权和非特权设置下均优于现有基线。GenMimic学生在SR和MPKPE-NT上都高于GMT和TWIST,而GenMimic教师在SR、MPKPE和MPKPE-NT上都高于BeyondMimic和TWIST。所有非特权策略都表现出较高的全局误差,突显了从生成视频进行零样本模仿的挑战。

我们将GMT强大的局部姿态跟踪但较差的全局跟踪归因于其对自由度(DoF)条件的依赖。因此,在面对有噪声运动时,它无法泛化到分布外的数据。TWIST学生和教师在所有指标上都表现出高方差和较差性能,大概是因为它们被设计为使用高质量运动捕捉作为输入。最后,我们注意到BeyondMimic在利用全局位置信息和观测空间构成方面与3DP消融实验最为相似(但它们的奖励非常不同)。虽然GenMimic教师也使用全局信息,但我们将其在有噪声运动上的卓越鲁棒性归因于加权关键点奖励和对称损失的引入。

5.4 真实世界实验

我们成功地将我们的策略部署在23自由度的G1人形机器人上,展示了从生成视频中物理复现人体动作的能力。我们总共执行了43个动作,并在表2中报告了视觉成功率(VSR)。与仅衡量与真值偏差的定量模拟指标不同,VSR评估执行的运动是否在物理上类似于生成的视频。我们认为任何过度蹒跚或无法视觉上跟随关键关键点(如手或脚)的情况均为失败。

我们的策略成功地复现了广泛的上半身动作,包括挥手、指向、伸手及其组合。将这些动作与下半身运动组合会显著增加难度。对于踏步组合,策略可靠地跟随上半身动作,但无法始终如一地踏步或抬腿。对于转身组合,策略可靠地达到期望的方向,但经常蹒跚。我们假设这些挑战源于不准确或物理上不可行的运动线索,这个问题可能可以通过向3D目标关键点引入加权噪声来解决。

5.5 消融实验

我们在模拟中进行消融实验,在AMASS上训练,以评估我们三个关键设计选择的重要性:目标观测的选择、加权关键点奖励的使用以及对称损失。每个消融实验都使用约1.5B样本进行训练,并在GenMimicBench和AMASS的10%测试集上进行评估。我们在AMASS评估中省略了NT指标。结果详见表3。更多结果见附录A.1节。

目标观测消融。

我们首先使用一个排除加权关键点奖励和对称损失的基线策略,对目标观测空间进行消融。我们比较了第4.1节详述的_3D Points_(3DP)和使用目标关节角度的DoF。我们的实验表明,使用3D关键点提高了在有噪声输入上的性能。

加权关键点奖励消融。

在选择了_3DP_作为最优观测空间之后,我们接下来对加权关键点奖励进行消融。在_3DP+Weights_中,我们定义了一个固定的加权方案,以优先考虑末端执行器,同时降低下半身的优先级。我们的实验证实了这些权重的重要性。

我们还考虑了一种数据驱动的、自监督的方法来学习这些权重。在_3DP+Self-supervised_配置中,策略在每一步(t)输出一个额外的(n)维向量(\alpha_{t}),并带有一个关于(\alpha_{t})变化的正则化奖励。然后通过Softmax函数计算归一化的权重,(w_{t}=\text{Softmax}(\alpha_{t}))。我们的实验表明,学习到的权重在有噪声输入上达到了与手动微调权重相当的性能,但在干净或困难输入上表现更差。

对称损失消融。

我们通过将对称损失添加到_3DP+Weights_配置中来结束消融实验。请注意,得到的_3DP+Weights+Symmetry_等同于GenMimic教师策略。基于SR和NT指标,我们的实验证实对称损失提高了对噪声的鲁棒性。

6 结论

我们提出了GenMimic ,一个具有物理意识的人形控制框架,使机器人能够以零样本的方式执行生成视频中描绘的人体运动。我们引入了一个两阶段流程。首先,我们将视频像素提升为4D人体表征,然后重定向到人形形态。其次,我们提出了GenMimic ,一个以3D关键点为条件的、具有物理意识的强化学习策略,通过对称正则化和关键点加权跟踪奖励进行训练。我们构建了GenMimicBench,一个使用Wan2.1和Cosmos-Predict2生成的可扩展合成人体运动视频基准。然后,我们在这个基准上评估我们的方法,以评估其零样本泛化能力和策略鲁棒性。在模拟中和Unitree G1人形机器人上的实验证明了物理稳定的模仿能力,以及与强基线相比的卓越泛化性能。

7 局限性与未来工作

虽然我们的结果证明了人形机器人模仿人体运动以复现生成视频的可行性,但仍然存在一些局限性。首先,运动轨迹的质量受到生成视频质量和下游4D重建质量的限制。未来的工作可以关注对齐生成视频与真实视频之间的领域差距,以便重建能够使策略更鲁棒并利用更丰富的场景信息。其次,我们的策略仅在AMASS上训练。我们相信通用策略能够利用的运动数据越多样化,其在分布外运动上的性能就越好。第三,我们当前的评估主要关注简单的人体动作而非动态运动。一个前景广阔的方向不是直接以3D关键点为条件,而是学习一个潜在的、能够桥接简单、复杂、真实和生成运动的运动表征。最终,我们相信通用智能体需要具备规划并适应未见过的任务和情境的能力。这项工作朝着这个方向迈出了第一步,为人形机器人实现基于视觉的生成式规划与控制奠定了基石。

致谢

我们衷心感谢贾斯汀·科尔(Justin Kerr)富有启发性的讨论和反馈。作为加州大学伯克利分校的附属研究人员,作者团队部分获得了美国国家科学基金会、美国国防部、伯克利人工智能研究院(BAIR)产业联盟计划以及人形智能中心项目的支持。本文所表述的观点、见解及研究发现均属作者个人立场,不应被解读为代表任何资助机构、国防部或美国政府的官方观点或政策。

从生成的人体视频到物理可行的机器人轨迹

补充材料

在此,我们提供了关于实验和消融研究(附录A)、训练过程(附录B)、GenMimicBench分析(附录C)以及实验硬件设置(附录D)的额外细节。

附录A:额外的实验结果

A.1 额外的消融研究

我们进行了额外的消融研究以评估我们设计选择之间的相互作用。具体来说,我们研究了目标观测的选择如何影响权重和对称增强的有效性。与第5.5节类似,我们比较了在大约1.5B样本上训练的教师策略,并在AMASS(测试集)和GenMimicBench上进行了评估。我们报告了相同的指标,并再次强调SR是最重要的指标。

结果如表4所示。首先,我们发现与以DoF为条件相比,以3D关键点为条件提高了在有噪声输入上的性能。其次,无论条件输入是什么,使用加权关键点奖励都能持续提高跟踪保真度。然而,我们注意到,与以DoF为条件相比,在以3D关键点为条件时,鲁棒性的提高(尤其对有噪声输入)更为显著。最后,虽然对称损失也提高了鲁棒性,但这种好处主要在以3D关键点为条件时才能实现。这支持了我们的假设,即对称损失鼓励策略学习左右两侧之间的空间关系,而这种关系在DoF表征中更难学习。

表4:GenMimic的额外消融研究。我们注意到所有策略都是教师策略。SR是机器人没有摔倒且保持在目标0.5米以内的运行次数百分比。MPKPE和LMPKPE分别代表终止前全局和局部坐标中的平均每关键点位置误差。我们还报告了无偏指标MPKPE-NT和LMPKPE-NT,这些指标是在整个运动持续时间内、无终止条件下计算的。

| 方法 | AMASS SR↑ | AMASS MPKPE↓ | AMASS LMPKPE↓ | GenMimicBench SR↑ | GenMimicBench MPKPE↓ | GenMimicBench LMPKPE↓ | GenMimicBench MPKPE-NT↓ | GenMimicBench LMPKPE-NT↓ |

|---|---|---|---|---|---|---|---|---|

| 目标观测消融 | ||||||||

| DoFs | 45.8% | 13.38±0.31 | 6.65±0.09 | 23.8% | 25.64±1.56 | 7.76±0.35 | 53.84±6.67 | 7.90±0.44 |

| 3D Points (3DP) | 50.0% | 14.08±0.42 | 7.19±0.15 | 40.0% | 23.23±1.69 | 7.07±0.55 | 39.51±8.55 | 7.22±0.70 |

| 权重和对称性消融 | ||||||||

| 3DP+Weights | 97.7% | 7.89±0.36 | 6.09±0.14 | 77.4% | 16.59±1.39 | 7.03±0.50 | 28.45±12.64 | 7.77±1.30 |

| 3DP+Self-supervised | 67.6% | 9.00±0.54 | 6.10±0.17 | 62.0% | 18.63±1.32 | 6.49±0.50 | 40.63±10.48 | 7.75±0.99 |

| 3DP+Weights+Symmetry | 99.3% | 7.49±0.36 | 5.62±0.09 | 86.8% | 16.63±1.06 | 6.68±0.33 | 20.46±5.73 | 6.75±0.47 |

附录B:额外的训练细节

接下来,我们提供关于实现细节、观测与状态空间、奖励、领域随机化和基线的更多细节。

B.1 实现细节

我们使用RSL-RL[54]实现的PPO算法训练教师策略。策略以50 Hz运行,我们每步模拟物理4次,使用PD控制器和IsaacGym,频率为200 Hz。PPO超参数详见表5。

对于学生策略,我们不采用修改的损失函数,而是对训练批次应用对称增强,并直接最小化学生和教师动作之间的ℓ₂损失。

为确保动作的期望分布,我们对行动者策略输出的动作(a_{t})进行裁剪,并根据以下公式将其映射到期望关节角度(q^{\text{des}}_{t}):

q^{\\text{des}}_{t}=q^{\\text{default}}+c\\cdot\\text{clip}(a_{t},-a^{\\text{clip}},a^{\\text{clip}})

其中(q{\text{default}})是默认关节位置,(c=0.25)是一个动作缩放参数,(a{\text{clip}}=10)弧度定义了裁剪幅度。这些期望关节角度随后被传递给PD控制器,PD控制器输出扭矩:

T_{t}=K_{p}(q\^{\\text{des}}*{t}-q* {t})-K_{d}q_{t}

在训练过程中,如果机器人的平均关键点位置偏离目标关键点超过0.5米,或者投影重力向量的(x)或(y)分量超过0.7 m/s²,我们将终止该片段。如果策略到达一个运动的末尾,我们会在不重置环境的情况下重新采样运动,以便策略可以学习不同运动之间的过渡行为。

表5:PPO和DAgger的超参数

| 参数 | 值 |

|---|---|

| PPO | |

| GPU数量 | 4 块 RTX 4090 |

| 环境数量 | 4096 |

| 学习轮数 | 5 |

| 每环境步数 | 24 |

| 小批量大小 | 24576 |

| 折扣因子 ((\gamma)) | 0.99 |

| GAE ((\lambda)) | 0.95 |

| PPO 裁剪参数 | 0.2 |

| 熵损失系数 | 0.005 |

| 优化器 | Adam |

| 学习率 | 1e-3 |

| 学习率调度 | adaptive |

| 期望KL散度 | 0.01 |

| 归一化输入 | True |

| 归一化值 | False |

| DAgger | |

| GPU数量 | 1 块 RTX 4090 |

| 环境数量 | 2048 |

| 学习轮数 | 5 |

| 优化器 | Adam |

| 学习率 | 1e-3 |

B.2 观测与状态空间

表6详细说明了策略的本体感觉历史和运动未来,以及特权教师策略和评论家使用的状态空间。为了提高跟踪质量,我们扩展了机器人运动学结构,将头部和手部的刚体信息包括在内。这些在物理机器人上是存在的,并且是最相关的关键点,但并未包含在标准运动链中。

表6:观测

| 输入 | 维度 | 行动者 ((π_s)) | 行动者 ((π_o)) | 评论家 |

|---|---|---|---|---|

| 本体感觉历史 | ||||

| 关节位置 | 23 | ✓ | ✓ | ✓ |

| 关节速度 | 23 | ✓ | ✓ | ✓ |

| 根节点角速度 | 3 | ✓ | ✓ | ✓ |

| 投影重力 | 3 | ✓ | ✓ | ✓ |

| 前一动作 | 23 | ✓ | ✓ | ✓ |

| 局部刚体位置 | (3×27) | ✓ | ✓ | ✓ |

| 全局刚体位置 | (3×27) | ✓ | ✗ | ✓ |

| 全局刚体四元数 | (4×27) | ✓ | ✗ | ✓ |

| 全局刚体线速度 | (3×27) | ✓ | ✗ | ✓ |

| 全局刚体角速度 | (3×27) | ✓ | ✗ | ✓ |

| 历史长度 | 1 | 10 | 1 | |

| 本体感觉总计 | 507 | 1560 | 507 | |

| 目标未来 | ||||

| 目标3D关键点位置 | (3×27) | ✓ | ✓ | ✓ |

| 全局位置差异 | (3×27) | ✓ | ✗ | ✓ |

| 未来长度 | 1 | 10 | 1 | |

| 目标总计 | 162 | 810 | 162 | |

| 特权信息 | ||||

| 基座质心偏置 | 3 | ✓ | ✗ | ✓ |

| 脚部摩擦系数 | 2 | ✓ | ✗ | ✓ |

| 随机化质量 | 8 | ✓ | ✗ | ✓ |

| KD缩放因子 | 23 | ✓ | ✗ | ✓ |

| KP缩放因子 | 23 | ✓ | ✗ | ✓ |

| 扭矩缩放因子 | 23 | ✓ | ✗ | ✓ |

| 脚部接触力 | (2×3) | ✓ | ✗ | ✓ |

| 特权信息总计 | 88 | 0 | 88 | |

| 总观测空间 | 676 | 2370 | 676 |

B.3 奖励

奖励项及其权重的完整分解见表7。我们强调了十个对于使策略能够模仿输入运动至关重要的奖励项,这些项基于第4.2.2节详述的加权奖励公式。

我们使用了四个基于第4.2.2节详述公式的加权奖励。除了关键点位置,我们将公式推广到跟踪关节位置、关节速度和关键点方向。对于加权关节奖励,我们使用权重 (w^{\text{upper}}=2) 和 (w^{\text{lower}}=1)。对于加权关键点奖励,我们将手部和头部的关键点视为末端执行器,权重为 (w{\text{end-eff}}=4),(w{\text{upper}}=2) 和 (w^{\text{lower}}=1)。

我们还利用了三个基于物理和生物学原理(如能量最小化)的正则化项来鼓励期望的策略行为。由于模拟器的不准确性,我们包括了对于超出关节限制和脚部滑动行为的惩罚项。为了进一步保证稳定性,我们加入了一个方向奖励。

除了这些核心项,我们还加入了终止惩罚和存活奖励。最后,我们还加入了四个额外的脚部惩罚项,以在现实中创建更安全的踏步行为并防止硬件损坏。我们注意到,所有非加权的跟踪项都是RL中学习人形策略的标准奖励项。

表7:奖励 。上半部分表示GenMimic中突出显示且至关重要的奖励项。下半部分表示用于在现实世界安全部署的片段奖励和脚部惩罚项。(d_{\text{quat}}(r_{1},r_{2}))是四元数之间的距离函数。(q^{ul}) 和 (q^{il}) 表示机器人关节的下限和上限。(F^{\text{foot}}{t}) 表示脚部刚体的3D接触力。(g^{\text{foot}} {t}) 表示基于脚部刚体四元数的3D投影重力向量。(h_{\text{air}}) 和 (h^{\text{des}}{\text{air}}=0.1)m 表示单步过程中脚部的当前最大高度和期望最大高度。(t{\text{air}}) 和 (t^{\text{des}}_{\text{air}}=0.25)s 表示单步过程中脚部当前在空中的时间和期望在空中的时间。

| 奖励项 | 细节 | 权重 | 原理说明 |

|---|---|---|---|

| 跟踪奖励 | |||

| 跟踪关节位置 | (\exp\left(\sum_{j}w_{j}(q_{t,j}-q{\text{goal}}_{t,j}){2}\right)/\sigma^{2}_{p}) | 32 | 虽然物理上不一定可行,但重定向后的目标关节角度是正确行为的良好信号 |

| 跟踪关节速度 | (\exp\left(\sum_{j}w_{j}(\dot{q}{t,j}-\dot{q}{\text{goal}}_{t,j}){2}\right)/\sigma^{2}{p}) | 16 | |

| 跟踪身体位置 | (\exp\left(\sum_{j}w_{j}|p_{t,j}-p{\text{goal}}_{t,j}|{2}\right)/\sigma^{2}_{p}) | 50 | 通过优先跟踪3D关键点,鼓励正确模仿目标运动 |

| 跟踪身体旋转 | (\exp\left(\sum_{j}w_{j}d_{\text{quat}}(r_{t,j},r{\text{goal}}_{t,j}){2}\right)/\sigma^{2}_{br}) | 20 | |

| 惩罚项 / 正则化 | |||

| 动作速率 | (|a_{t-1}-a_{t}|^{2}) | -1 | 较慢的行为减少了模拟到现实的差距 |

| 能量消耗 | (|T_{t}\odot\dot{q}_{t}|^{2}) | -1e-6 | 最小化施加的努力 |

| DoF加速度 | (|\ddot{q}_{t}|^{2}) | -3e-6 | 避免抖动运动 |

| DoF限制 | (\sum[((q_{t}>q{ul})\vee(q_{t}<q{ll}))]) | -100 | 惩罚超过硬限制的关节 |

| 脚部滑动 | (p{\text{foot}}_{t-1}\cdot\mathbbm{1}[|F{\text{foot}}_{t}|>1]) | -5 | 防止脚部滑动(模拟器行为) |

| 方向 | (|g{\text{xy}}_{t}|{2}) | -50 | 鼓励稳定的方向 |

| 脚部惩罚项 | |||

| 脚部接触力 | (\frac{\sum|F^{\text{foot}}_{t}|}{\text{...}}) | -0.03 | 鼓励较轻的踏步 |

| 脚部方向 | (\sum\min(h_{\text{air}}-h^{\text{des}}_{\text{air}},0)\cdot\mathbbm{1}[\text{feet in air}]) | -62.5 | 鼓励脚部保持平直 |

| 脚部最大高度 | (\sum(t_{\text{air}}-t^{\text{des}}_{\text{air}})\cdot\mathbbm{1}[\text{first step}]) | -2500 | 避免踏步过高 |

| 脚部腾空时间 | 详见原文 | 1000 | 鼓励较长的步伐 |

| 片段奖励 | |||

| 终止惩罚 | 提前终止时 | -200 | |

| 存活奖励 | 环境步进时 | 20 |

B.4 领域随机化

我们在模拟中进行了广泛的领域随机化,以提高策略的鲁棒性并促进模拟到真实的迁移。我们每5秒对机器人施加随机脉冲,以提高对外部扰动的鲁棒性。在环境重置时,我们对环境、机器人、关节和PD控制器的基本属性进行随机化,确保策略能够在各种表面和物理条件下进行模仿。最后,我们仅为行动者注入观测噪声,以确保对现实世界传感器噪声以及生成视频噪声的鲁棒性。详细分解见表8。

表8:领域随机化。(L)表示均匀分布,(\mathcal{N})表示正态分布。

| 参数 | 类型 | 范围 | 原理说明 |

|---|---|---|---|

| 扰动 | |||

| 随机推力强度 (xy) | 设定值 | (L[-1,1]) m/s | 对脉冲的鲁棒性 |

| 重置 | |||

| 地面摩擦系数 | 设定值 | (L[0.4,1.25]) | 对不同表面类型的鲁棒性 |

| 基座质心偏置 | 加性 | (L[-100,100]) g | 对重量不平衡的鲁棒性 |

| 连杆质量 | 乘性 | (L[0.7,1.3]) | 对重量不平衡的鲁棒性 |

| P增益 ((K_p)) | 乘性 | (L[0.75,1.25]) | 对控制器误差的鲁棒性 |

| D增益 ((K_d)) | 乘性 | (L[0.75,1.25]) | 对控制器误差的鲁棒性 |

| 电机强度 | 乘性 | (L[0.5,1.5]) | 对电池电量、电机磨损的鲁棒性 |

| 控制延迟 | 设定值 | ({0,1,2,3}) 步 | 对现实世界输入延迟的鲁棒性 |

| 目标3D关键点偏移 | 加性 | (L[-0.02,0.02]) m | 对目标输入漂移的鲁棒性 |

| 噪声 | |||

| 关节位置 | (\mathcal{N}(0,0.01)) rad | ||

| 关节速度 | (\mathcal{N}(0,0.1)) rad/s | ||

| 根节点角速度 | (\mathcal{N}(0,0.5)) rad/s | ||

| 投影重力 | (\mathcal{N}(0,0.1)) m/s² | ||

| 局部刚体位置 | 加性 | (\mathcal{N}(0,0.01)) m | 对现实世界传感器噪声的鲁棒性 |

| 全局刚体位置 | (\mathcal{N}(0,0.01)) m | ||

| 全局刚体四元数 | (\mathcal{N}(0,0.01)) | ||

| 全局刚体线速度 | (\mathcal{N}(0,0.2)) m/s | ||

| 全局刚体角速度 | (\mathcal{N}(0,0.5)) rad/s | ||

| 目标3D关键点位置 | (\mathcal{N}(0,0.05)) m | 对目标输入噪声的鲁棒性 |

B.5 基线

GMT。 GMT使用标准的学生-教师框架实现通用运动跟踪,但采用了混合专家教师和自适应采样。与我们的方法不同,GMT以DoF和目标线速度为条件,并且不使用任何位置信息。我们使用GMT的预训练检查点,在并行化的IsaacGym环境中实现,以便快速评估。

TWIST。 TWIST同样采用学生-教师框架,但不使用DAgger,而是使用RL训练学生策略,并增加了学生和教师之间的KL散度损失。这种蒸馏过程产生了一个比教师性能更好的学生策略。对于非特权学生策略,我们使用TWIST的预训练检查点,并类似地在并行化的IsaacGym环境中实现以进行快速评估。对于特权教师策略,我们重新实现了TWIST的训练过程,并在注入了真实世界运动捕捉数据的其数据集上进行训练。我们在单块NVIDIA RTX 4090上训练了1.5B个环境步,并在运行评估前验证了收敛性。

BeyondMimic。 BeyondMimic使用自适应采样策略和一组固定的超参数,在单个运动片段上进行训练。我们在我们的代码库中重新实现了BeyondMimic的训练过程。我们调整了它们的跟踪奖励公式,并在我们的AMASS数据集上进行训练。在训练过程中,我们发现自适应采样在大规模上难以收敛,因此我们使用了均匀采样器。我们在单块NVIDIA RTX 4090上训练了1.5B个环境步,并在运行评估前验证了收敛性。

附录C:数据集细节

C.1 AMASS

AMASS 是一个大规模的运动捕捉数据集,将来自15个不同来源的数据统一到单一表征下。数据包括SMPL姿态,涵盖346名受试者和11,451个动作,涉及多种活动,包括移动、运动、舞蹈、武术和日常动作。我们首先过滤掉涉及物体(或环境,如楼梯)交互的不可行动作。然后,我们使用PHC将人体表征重定向到机器人形态,并进一步过滤重定向误差足够高的动作。我们保留了8,123个机器人形态下的动作,使用90/10%的比例进行训练和评估。

C.2 GenMimicBench 细节

本节扩展了关于GenMimicBench的构建和特性的描述,这是我们的合成人体运动数据集,用于评估对生成视频中人形动作的零样本控制。

C.2.1 动作分类

如图5所示,GenMimicBench涵盖了多样化的人体运动,根据复杂性分类如下:

简单上半身动作。

这些动作涉及最少的全局身体位移和简单手势:摸头、竖起大拇指、挥手。

简单上半身动作+移动。

这些动作将周期性行走与上半身动作结合:无手势 + 行走、摸头 + 行走、竖起大拇指 + 行走、挥手 + 行走。

复合上半身动作。

这些动作涉及将简单动作链接在一起或同时组合简单动作的多步动作序列:摸头 → 竖起大拇指 → 挥手;摸头 → 抱臂;举起右手并指向前方 → 抱臂;交叉手臂 → 打开交叉 → 挥右手。

复合动作 + 移动。

这些动作将上述多步动作序列与移动(如行走或踏步)结合。

野外行为。

对于野外行为,我们以PennAction数据集中的8个帧和8个受试者为条件,使用Cosmos-Predict2生成了广泛的视频。我们包括:(a)有/无移动的简单手势,(b)物体交互任务,如开门、捡书、举重物,以及(c)动作序列,如走向并抓取架子上的物品。

这些动作类别共同提供了从稳定、受控的手势到在不同视角和情境下的多步行为的广泛运动复杂性谱系。

C.2.2 视频生成设置

文本提示设计。

每个视频都是从文本提示生成的,该提示(1)明确描述目标动作或复合序列,(2)避免风格化或情感描述以保持一致性,(3)在有益时限制环境(例如,在室内房间,向前行走 ),以及(4)鼓励真实的人体运动学(自然人体运动,平滑过渡)。

视觉条件帧。

对于两种生成模型,每个片段都以单个参考帧为条件,该帧决定了(1)受试者身份,包括外观、身体比例和服装,(2)周围背景和场景情境,以及(3)相机视角。对于Wan2.1,条件帧来自NTU RGB+D视频中的同步帧(前、左、右视图),使得同一受试者能够有多视角设置。对于Cosmos-Predict2,条件帧来自PennAction视频帧,这些帧代表了具有自然杂乱和变化场景布局的YouTube风格场景。我们选择受试者直立、处于中性站姿、完全可见且无重大遮挡的帧,以确保后续视频生成的稳定初始化。

视频特征。

Wan2.1视频的帧分辨率为832×480,帧率为16 fps,持续时间为5.0秒。Cosmos-Predict2视频的帧分辨率为768×432,帧率为16 fps,持续时间为5.8秒。

C.2.3 GenMimicBench 中的挑战

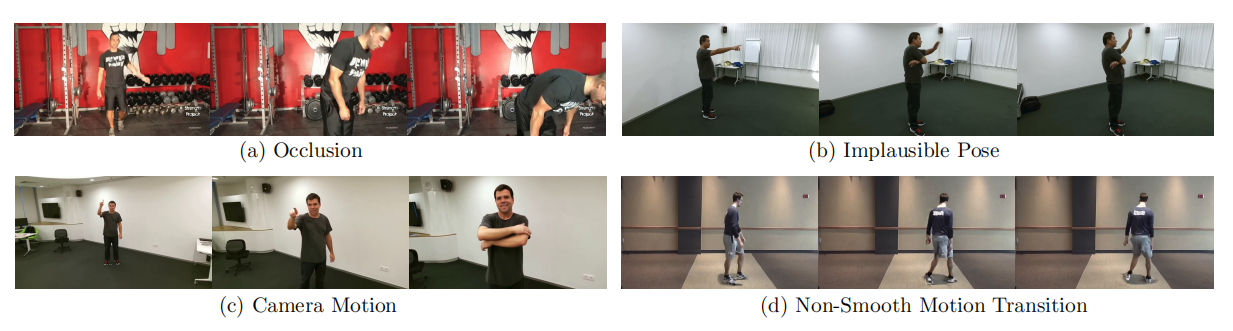

GenMimicBench对人形控制提出了一系列挑战。这些挑战源于当前视频生成模型中固有的不完美,这些不完美在4D重建和重定向过程中被放大。图6展示了这些生成伪影的几种代表性失败模式,包括部分身体遮挡、物理上不可能的姿势、剧烈的相机运动以及不平滑的时间过渡。我们在下面总结了关键难点来源。

外观和照明漂移。

生成的序列可能表现出受试者外观(例如,纹理细节、受试者面部、肢体比例)的细微变化,以及照明和背景的波动。这些不一致性在4D提升过程中传播为有噪声或漂移的关键点,要求策略跟踪不稳定的运动参考。

不平滑或不自然的运动。

模型可能会产生动作之间的突然转换、不真实的加速度或时间上不一致的运动风格。此类伪影表现为不连续的轨迹,可能导致人形控制器稳定性问题。

物理上不可能的姿势。

偶尔会出现违反人体运动学的情况,包括过度伸展、脚部滑动或短暂的自相交。策略必须学会容忍这些运动学上不可行的跟踪目标。

遮挡和相机效应。

一些视频序列引入了部分身体遮挡,并且很大一部分视频包含非静态或漂移的相机运动。当这些因素与细微的场景伪影结合时,会降低4D重建质量并产生模糊的轨迹,特别是在与移动结合时。

图6:GenMimicBench中有噪声视频的示例。(a)遮挡:部分身体可见性和物体干扰阻碍了可靠的4D重建。(b)物理上不可能的姿势:不可能的关节配置(例如,不正确抱臂)产生了运动学无效的参考轨迹。(c)相机运动:强烈的视点漂移和场景抖动降低了时间一致性并降低了重建保真度。(d)不平滑的运动过渡:不一致的时间变化(例如,左/右腿交换)在目标运动中产生不连续性。这些伪影说明了人形策略在零样本跟踪生成视频时必须容忍的噪声、不稳定且有时不可行的运动参考。

附录D:实验硬件设置

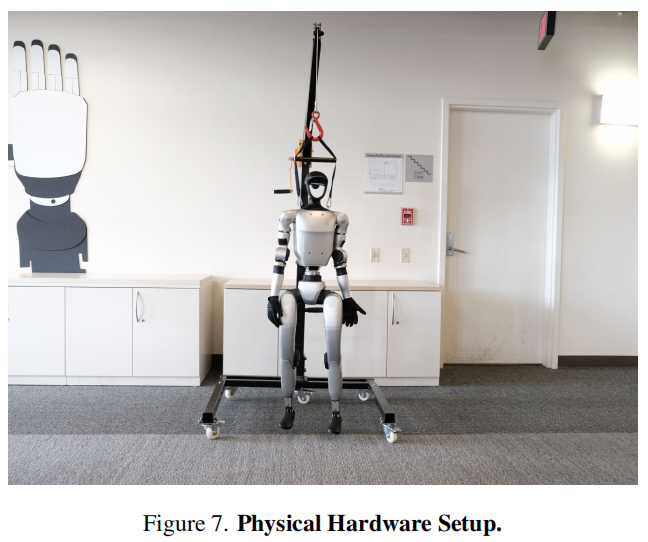

图7:物理硬件设置。

动作之间的突兀转换、不真实的加速度变化,或时间上不一致的运动风格。这类伪影表现为不连贯的运动轨迹,可能导致人形控制器的稳定性问题。

物理上不合理的姿势:偶尔会出现违反人体运动学的情况,包括关节过度伸展、脚部滑动或短暂的自相交。控制策略必须学会适应这些在运动学上不可行的跟踪目标。

遮挡与摄像机效应:部分视频序列存在身体局部遮挡,且有相当比例的视频包含非静态或漂移的摄像机运动。当这些因素与细微的场景伪影相结合时,会降低四维重建质量并产生模糊的运动轨迹,在涉及移动时尤为明显。

D. 真实世界 G1 实验

我们在真实世界实验中使用了配备 12 个下半身关节、1 个躯干关节和 10 个上半身关节的 23 自由度 Unitree G1 人形机器人。我们使用 Unitree SDK 2 在 Python 中实现了部署代码,该代码在笔记本电脑上以 50 Hz 的频率运行控制策略,并向以 500 Hz 驱动电机的机载 PD 控制器发送命令。我们使用 Unitree 提供的默认 PD 增益参数:髋部使用 Kp = 200,Kd = 5;膝部使用 Kp = 300,Kd = 6;踝部使用 Kp = 40,Kd = 2;整个上半身使用 Kp = 100,Kd = 2。出于安全考虑,特别是在输入存在噪声的情况下,我们在部署期间将机器人通过龙门架固定。在实际部署前,我们会在仿真中验证所有动作。物理设置的照片参见图 7。