前言

阅读论文,最直接的获取创新改进的内容。但其架构条理性相对偏弱,有空了再阅读源码,完整的梳理下与YOLOV8的区别。

论文链接: https://arxiv.org/pdf/2405.14458v1

Abstract

【已有YOLO的缺陷 】

在过去几年中,YOLOs因其在计算成本和检测性能之间取得的有效平衡,已成为实时目标检测领域的主流范式。研究人员探索了YOLOs的架构设计、优化目标、数据增强策略等,取得了显著进展。然而,

- NMS的延迟:依赖于后处理中的非极大值抑制(NMS)阻碍了YOLOs的端到端部署,并对推理延迟产生了不利影响。

- 模型组件的计算冗余:YOLOs中各种组件的设计缺乏全面彻底的检查,导致明显的计算冗余,限制了模型的能力。这使得其效率次优,同时存在巨大的性能提升潜力。

【YOLOV10的改进 】

在本工作中,我们旨在从后处理和模型架构两个方面进一步推进YOLOs的性能-效率边界。为此提出

- 无 NMS 训练的一致性双重分配方法,实现具有竞争力的性能和低推理延迟。

- 引入了YOLOs的 整体效率-准确度驱动 模型设计策略。本工作从效率和准确性的角度全面优化了YOLOs的各个组件,大幅降低了计算开销并增强了能力。

【YOLOV10的效果 】

新一代实时端到端目标检测的YOLO系列,称为YOLOv10。大量实验表明,YOLOv10在不同模型规模下均能实现最先进的性能与效率。例如:

- YOLOv10-S在COCO数据集上以相似的平均精度比RT-DETR-R18快1.8倍,同时参数量和浮点运算次数减少2.8倍。

- 与YOLOv9-C相比,YOLOv10-B在保持相同性能的情况下,延迟降低46%,参数量减少25%。

代码和模型可在 https://github.com/THU-MIG/yolov10 获取。1 Introduction

【YOLO的流行 】

实时物体检测一直是计算机视觉领域研究的焦点,旨在低延迟下准确预测图像中物体的类别和位置。它被广泛应用于各种实际场景,包括自动驾驶、机器人导航和物体跟踪等。近年来,研究人员专注于开发基于CNN的物体检测器以实现实时检测。其中,YOLO因其在性能和效率之间巧妙的平衡而越来越受欢迎。【NMS的不足 】

YOLO的检测流程由两部分组成:模型前向过程和 NMS 后处理。然而,这两部分仍存在不足,导致精度-延迟边界不理想。

- 具体来说,YOLOs在训练过程中通常采用一对多的标签分配策略,即一个真实对象对应多个正样本。尽管这种方法能带来更优的性能,但需要 NMS 在推理阶段选择最佳的正样本预测。这会减慢推理速度,并使性能对 NMS 的超参数敏感,从而阻碍YOLOs实现最优的端到端部署。

【NMS的尝试改进】

- 解决这一问题的一个思路是采用最近提出的端到端DETR架构。例如,RT-DETR 提出了一种高效的混合编码器和不确定性最小化查询选择机制,将DETRs带入了实时应用领域。然而,仅从模型部署过程的前向效率来看,DETRs相比YOLOs仍有提升空间。

- 另一个思路是探索基于CNN的检测器的端到端检测,这类检测器通常采用一对一的分配策略来抑制冗余预测。但它们通常会引入额外的推理开销,或在YOLOs上实现次优性能。

【YOLO模型组件的改进 】

此外,模型架构设计仍是YOLOs面临的核心挑战,这对模型的准确性和速度具有重要影响。为构建更高效、更优的模型架构,研究者们探索了多种设计策略。

- 在骨干网络中,为提升特征提取能力,提出了多种基础计算单元,包括DarkNet、CSPNet、EfficientRep 和ELAN 等。

- 在颈部网络中,为增强多尺度特征融合能力,研究者们尝试了PAN、BiC、GD 和RepGFPN 等方案。同时,模型缩放策略和重参数化技术也得到深入研究。尽管这些努力取得了显著进展,但从效率和准确性的双重角度对YOLOs各组件进行全面评估仍显不足。这导致YOLOs内部仍存在大量计算冗余,造成参数利用率低下和效率欠佳的问题。此外,受限模型能力也导致性能表现欠佳,为提升准确度留有较大空间。

【YOLOV10 的改进 】

在本研究中,我们致力于解决这些问题并进一步提升YOLOs的精度-速度边界。我们从后处理和模型架构两个维度着手,贯穿整个检测流程。

- 首先通过提出一种无 NMS 的YOLOs 一致性双重分配策略 及 双重标签分配与一致性匹配度量,解决了后处理中的冗余预测问题。该策略使模型在训练期间获得丰富且协调的监督信息,同时在推理阶段无需依赖 NMS ,从而以高效的方式实现与高精度模型相媲美的性能。

- 其次,我们通过全面检查YOLOs各组件,提出了整体效率-精度驱动的模型架构设计策略。

- 为提升效率,我们采用轻量级分类头、空间通道解耦降采样及排名引导模块设计,减少显式计算冗余,实现更高效的架构。

- 为提高精度,我们探索大内核卷积并提出有效的部分自注意力模块,增强模型能力,在低成本下挖掘性能提升潜力。

【YOLOV10 的效果 】

基于这些方法,我们成功开发出一系列不同模型规模的实时端到端检测器,即YOLOv10-N/S/M/B/X系列。在物体检测标准基准测试集COCO上的大量实验表明,我们的YOLOv10在不同模型规模下,其计算精度与性能的平衡表现显著优于现有最先进模型。

- 如图1所示,在性能相当的情况下,YOLOv10-S/X 分别比 RT-DETRR18/R101快1.8倍和1.3倍。

- 与YOLOv9-C相比,YOLOv10-B在保持相同性能的前提下,将延迟降低了46%。

- 此外,YOLOv10展现出高效的参数利用率。

YOLOv10-L/X 在平均精度(AP)上分别比YOLOv8-L/X高出0.3和0.5,参数量分别减少1.8倍和2.3倍。

YOLOv10-M 在参数量减少23%和31%的情况下,与YOLOv9-M/YOLO-MS相比达到相近的AP值。2 Related Work

【实时目标检测器 】

实时目标检测旨在低延迟下对目标进行分类和定位,这对于实际应用至关重要。

- YOLOv1、YOLOv2 和 YOLOv3 采用了典型的三部分检测架构,即骨干网、颈部和头部。

YOLOv4 和 YOLOv5 引入了CSPNet 设计以替代DarkNet,结合数据增强策略、增强的PAN以及更多模型尺度等。

YOLOv6 分别提出了用于颈部和骨干网的BiC和SimCSPSPPF,采用锚点辅助训练和自蒸馏策略。

YOLOv7 引入了E-ELAN以丰富梯度流路径,并探索了多种可训练的免费资源包方法。

YOLOv8 提出了C2f构建块以有效提取和融合特征。

Gold-YOLO 提供了先进的GD机制以增强多尺度特征融合能力。

YOLOv9 提出了 GELAN 以改进架构,并提出 PGI 以增强训练过程。【端到端目标检测器 】

端到端目标检测已成为传统流水线的范式转变,提供了更精简的架构。

- DETR引入了Transformer架构并采用匈牙利损失函数以实现一对一匹配预测,从而消除了手工设计的组件和后处理步骤。此后,各种DETR变体被提出以提升其性能和效率。

可变形DETR利用多尺度可变形注意力模块加速收敛速度。

DINO将对比降噪、混合查询选择和前向两次方案整合到DETR中。

RT-DETR进一步设计了高效的混合编码器,并提出了不确定性最小查询选择以同时提高准确性和延迟。- 另一条实现端到端目标检测的路径是基于CNN检测器。

可学习 NMS 和关系网络提出了另一种网络以消除检测器的重复预测。

OneNet和DeFCN提出了一对一匹配策略,使全卷积网络能够实现端到端目标检测。

FCOSpss引入了正样本选择器以选择最优样本进行预测。3 Methodology

3.1 无 NMS 训练的一致双重分配

NMS 的弊端,使得需要探索更加的无NMS的端到端的预测方式。则有

【双标签分配的操作】

双标签分配

- 【一对一匹配的问题】一对一匹配仅将单个预测分配给每个真实标签,避免了 NMS 后处理。然而,这会导致弱监督,从而造成准确率和收敛速度不理想。

- 【一对一匹配缺陷的优化 】这一缺陷可以通过一对多分配来弥补。为YOLOs引入了双标签分配,以结合两种策略的优势。

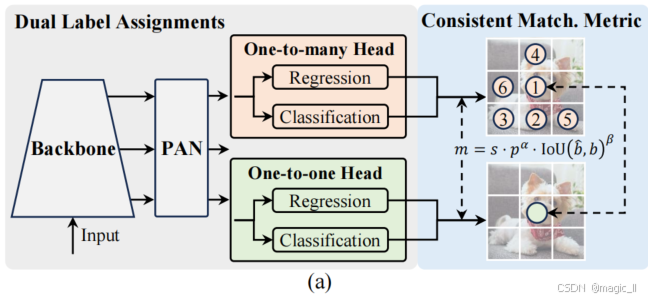

- 【结构】如图2.(a)所示,在原有的一对多的头部基础上,yolov10 新引入了一个一对一头部。该结构保持与原始一对多分支完全一致,并采用相同的优化目标,但利用一对一匹配来获取标签分配。

- 【训练时】模型同时优化两个头部,使骨干网络和颈部网络能够充分利用一对多分配提供的丰富监督信息。

- 【推理时 】丢弃一对多头部,仅使用一对一头部进行预测。这使得YOLOs能够在端到端部署中实现,而无需承担额外的推理成本。此外,在一对一匹配中,采用顶部匹配策略,该策略在训练时间更少的情况下,达到了与匈牙利匹配相同的性能。

一致性匹配度量标准

在一对一 和一对多的任务头上 进行任务分配时,为实现两个分支的预测感知匹配,采用统一的匹配度量标准,即 m ( α , β ) = s ⋅ p α ⋅ IoU ( b ^ , b ) β m(\alpha,\beta)=s\cdot p^\alpha\cdot\text{IoU}(\hat{b},b)^\beta m(α,β)=s⋅pα⋅IoU(b^,b)β【 p p p 】是分类得分

【 b ^ \hat{b} b^】 和 【 b b b】 分别表示预测框和实例框。

【 s s s】表示空间先验,指示预测的锚点是否位于实例内。

【 α α α】和【 β β β】是两个重要的超参数,用于平衡语义预测任务和位置回归任务的影响。【度量】

将一对多和一对一的度量分别表示为 m o 2 m = m ( α o 2 m , β o 2 m ) m_{o2m}=m(α_{o2m},β_{o2m}) mo2m=m(αo2m,βo2m) 和 m o 2 o = m ( α o 2 o , β o 2 o ) m_{o2o}=m(α_{o2o},β_{o2o}) mo2o=m(αo2o,βo2o)。这些度量影响两个头的标签分配和监督信息。【双标签分配的优势】

- 在双标签分配中,一对多分支提供的监督信号比一对一分支丰富得多。

也就是,如果能协调一对一头部与一对多头部的监督,就可以将一对一头部优化到与一对多头部优化方向一致。这样一来,一对一头部在推理时能提供更高质量的样本,从而提升性能。【双标签分配的依据 】

分析两个头部之间的监督差距。

- 【操作:将两个头初始化相同的参数】由于训练过程中的随机性,我们从一开始就让两个头部初始化为相同值并生成相同预测,即一对一头部和一对多头部为每个预测-实例对生成相同的 p p p 和 I o U IoU IoU。值得注意的是,两个分支的回归目标不会产生冲突,因为匹配的预测结果共享相同目标,而未匹配的预测结果则被忽略。

- 监督差距在于不同的分类目标。给定一个实例,我们用 u ∗ u^∗ u∗ 表示其与预测的最大IoU,用 m o 2 m ∗ m^{∗}{o2m} mo2m∗ 和 m o 2 o ∗ m^{∗}{o2o} mo2o∗ 分别表示最大的一对多匹配分数和一对一匹配分数。假设一对多分支产生正样本 Ω,一对一分支选择第 i i i 个预测,其度量未 m o 2 o , i = m o 2 o ∗ m_{o2o},i=m^{∗}{o2o} mo2o,i=mo2o∗,那么我们可以推导出分类目标 t o 2 m , j = u ∗ m o 2 m , j m o 2 m ∗ ≤ u ∗ for i ∈ Ω t{o2m,j} = u^* \frac{m_{o2m,j}}{m^{*}{o2m}}\leq u^*\quad\text{for }i\in\Omega to2m,j=u∗mo2m∗mo2m,j≤u∗for i∈Ω、 t o 2 o , i = u ∗ m o 2 m , i m o 2 o ∗ = u ∗ t{o2o,i}=u^*\frac{m_{o2m,i}}{m^{*}{o2o}}=u^* to2o,i=u∗mo2o∗mo2m,i=u∗,的任务对齐损失。因此,可通过不同分类目标的1-Wasserstein距离[46]推导出两个分支之间的监督差距,即 A = t o 2 o , i − I ( i ∈ Ω ) τ o 2 m , i + ∑ k ∈ Ω \ { i } t o 2 m , k A=t{o2o,i}-\mathbb{I}(i\in\Omega)\tau_{o2m,i}+\sum_{k\in\Omega\backslash\{i\}}t_{o2m,k} A=to2o,i−I(i∈Ω)τo2m,i+k∈Ω\{i}∑to2m,k可以观察到,随着 t o 2 m , i t_{o2m,i} to2m,i 的增加,差距逐渐减小,即 i i i 在 Ω中的排名更高。当 t o 2 m , i = u ∗ t_{o2m,i}=u^* to2m,i=u∗时,差距达到最小值,即 i i i 是Ω中最佳的正样本,如图2(a)所示。为了实现这一点,我们提出了一个一致的匹配度量,即 α o 2 o = r ⋅ α o 2 m α_{o2o} =r· α_{o2m} αo2o=r⋅αo2m 和 β o 2 o = r ⋅ β o 2 m β_{o2o} =r· β_{o2m} βo2o=r⋅βo2m ,这意味着 m o 2 o = m o 2 m r m_{o2o}=m^{r}_{o2m} mo2o=mo2mr。因此,对于一对多头,最佳正样本也是对一对一头的最佳样本。因此,两个头部均可实现一致且协调的优化。

【双标签分配的实验】

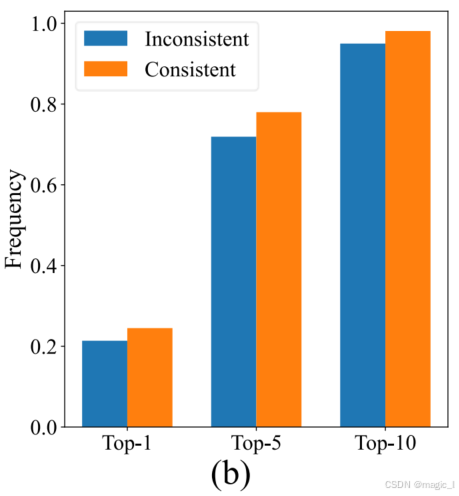

在YOLOv8-S中,默认采用 α o 2 m = 0.5 α_{o2m}=0.5 αo2m=0.5 和 β o 2 m = 6 β_{o2m}=6 βo2m=6时,Top-1/5/10的一对多结果中一对一分配的频率。为保持一致性, α o 2 o = 0.5 α_{o2o} =0.5 αo2o=0.5、 β o 2 o = 6 β_{o2o}=6 βo2o=6。为不一致性, αo2o =0.5; βo2o =2。

为了简化,我们默认取 r = 1 r=1 r=1,即 α o 2 o = α o 2 m α_{o2o}=α_{o2m} αo2o=αo2m 和 β o 2 o = β o 2 m β_{o2o} = β_{o2m} βo2o=βo2m 。为了验证改进后的监督对齐效果,我们在训练后统计了前 1/5/10 个一对多结果中的一对一匹配对的数量。如图 2(b) 所示,在一致匹配度量下,对齐效果有所改善。如需更全面的数学证明,请参阅附录。

一对多结果中的一对一匹配对的数量

举个例子:

- 假设有一个目标,一对多分支给出了10个正样本预测,按质量排序为:[pred_A, pred_B, pred_C, ..., pred_J],而一对一分支只选了一个预测,比如 pred_C。

那么:

- Top1 对齐:pred_C 在一对多分支中是第1名吗?不是 → 对齐失败

Top5 对齐:pred_C 在一对多分支中前5吗?是 → 对齐成功

Top10 对齐:pred_C 在一对多分支中前10吗?是 → 对齐成功【与其他方法的对比讨论 】

先前的研究通过探索 不同标签分配方式 来加速训练收敛并提升网络性能。

- H-DETR、Group-DETR 和 MS-DETR 在原有的一对一匹配基础上,通过混合或多重组标签分配引入了一对多匹配机制,从而改进了DETR算法。与DETR不同的是,这些方法为实现一对多匹配,通常会引入额外查询或重复二分匹配的基准数据,或从匹配分数中筛选出排名靠前的查询。

我们则采用融合空间先验的预测感知分配方法。- LRANet在训练中使用密集分配和稀疏分配分支,这些都属于一对多分配,

而我们则采用了单一对多和一对一分配分支。- DEYO 研究了在第一阶段使用一对多匹配进行卷积编码器的逐步训练,以及在第二阶段使用一对一匹配进行Transformer解码器的训练,

而我们在端到端推理中避免了Transformer解码器。- 与结合双重分配的CNN检测器研究相比,我们进一步分析了两个头部之间的监督差距,并为YOLOs提出了一致匹配度量,以缩小理论监督差距。这通过更好的监督对齐提高了性能,并消除了超参数调优的需要。

3.2 整体效率---精度驱动模型设计

除了后处理环节,YOLO模型架构本身也给效率与精度的平衡带来了巨大挑战。模型架构存在不可忽视的计算冗余和能力局限,制约了其在实现高效性能方面的潜力。本文旨在从效率与精度双重视角,对YOLO模型架构进行整体性优化设计。

【效率驱动模型设计 】

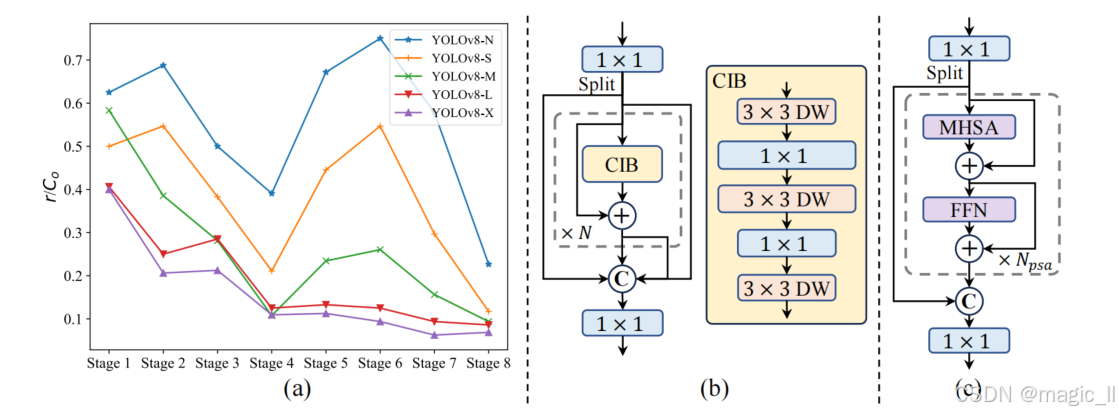

YOLO的组件包括主干、下采样层、具有基本构建块的阶段以及头部。主干的计算成本较低,因此我们对其他三个部分进行了效率驱动的模型设计。

(1) 轻量级分类头

在YOLO中,分类头和回归头通常共享相同的架构。然而,它们在计算开销上表现出显著差异。例如,在YOLOv8-S中,分类头(5.95G/1.51M)的FLOPs和参数数量分别是回归头(2.34G/0.64M)的2.5倍和2.4倍。我们 发现回归头对YOLO性能的影响更为重要 。因此,可以在不大幅影响性能的情况下减少分类头的开销。为此,我们采用了一个轻量级的分类头架构,该架构由两个3×3核的深度可分离卷积和一个1×1卷积组成。(2) 空间通道解耦式降采样

YOLO模型通常采用步长为2的3×3标准卷积层,同时实现空间降采样(从H×W到H²×W²)和通道变换(从C到2C)。这种设计带来了不可忽视的计算成本O(9²HW C²)和参数量O(18C²)。为此,我们提出解耦空间降采样与通道扩展操作,从而实现更高效的降采样。具体而言,我们首先通过逐点卷积调节通道维度,再利用深度卷积进行空间降采样。这种设计将计算成本降至O(2HW C² + 9²HW C),参数量减少至O(2C² + 18C),同时在降采样过程中最大限度保留信息,最终在降低延迟的同时保持了与现有方法相当的性能表现。

维度 原来 YOLO 的做法 YOLOv10 的做法 核心操作 一个 3×3 stride=2 标准卷积,同时 完成: ① 空间下采样(H×W → H/2×W/2) ② 通道翻倍(C → 2C) 拆成两步: ① 1×1 卷积升维(C→2C) ② 3×3 depth-wise stride=2 下采样 计算复杂度 O(9×2×H×W×C×2C)=O(18 HW C²) O(2 HW C²) + O(9 HW C) 参数量 18 C² 2 C² + 18 C 效果 延迟高、计算重 延迟降、精度持平 (3) 基于秩的模块化设计 。

【模块的参数冗余】

YOLO模型通常在所有阶段采用相同的基础模块,例如YOLOv8中的瓶颈模块。为深入分析YOLO的这种同质化设计,我们利用内在秩来评估各阶段的冗余度。

【验证方法】

计算每个阶段最后一个基础模块中最后一个卷积层的数值秩,该数值表示大于阈值的奇异值数量。图3(a)展示了YOLOv8的结果,表明深层stage和大的模型尺寸容易表现出更多的冗余。这一观察结果表明,简单地为所有阶段应用相同的块设计对于最佳容量效率权衡并非最优。

【冗余的解决】

为解决这一问题,提出了一种秩引导块设计方案,旨在通过紧凑的架构设计减少已被证明冗余的阶段的复杂性。

- 首先介绍了一种紧凑的反向块(CIB)结构,该结构采用廉价的深度卷积进行空间混合,以及成本效益高的点卷积进行通道混合,如图3(b)所示。

- 然后,提出一种秩引导块分配策略,在保持竞争力容量的同时实现最佳效率。

具体来说,给定一个模型,我们根据其所有阶段的内在秩按升序排列。我们进一步检查了用 CIB 替换领先阶段的基本块的性能变化。如果与给定模型相比没有性能下降,我们继续替换下一个阶段,否则停止该过程。因此,我们可以在跨阶段和模型规模上实现自适应紧凑块设计,在不牺牲性能的情况下实现更高的效率。【精度驱动模型设计 】

进一步探索大核卷积和自注意力机制在精度驱动设计中的应用,旨在以最小成本提升性能。

- (1)大核卷积 。

采用大核深度卷积是扩大感受野、增强模型能力的有效方法。然而,简单地在所有阶段使用它们可能会污染用于检测小物体的浅层特征,同时在高分辨率阶段引入显著的输入输出开销和延迟。

因此,我们提出在 CIB 的深度阶段中利用大核深度卷积。具体而言,将 CIB 中第二个3×3深度卷积的核尺寸增加到7×7。此外,我们采用结构重参数化技术引入另一个3×3深度卷积分支,以缓解优化问题而不增加推理开销。随着模型规模的增大,其感受野自然扩展,使用大核卷积的优势逐渐减弱。因此,我们仅在小模型规模时采用大核卷积。- (2) 部分自注意力(PSA) 。

自注意力机制因其卓越的全局建模能力,被广泛应用于各类视觉任务。然而,该机制存在计算复杂度高、内存占用大的问题。针对这一挑战,结合当前注意力头冗余现象,我们提出了一种高效的局部自注意力(PSA)模块设计,如图3.( c)所示。

具体而言,我们在1×1卷积后将特征均匀分割为两个部分。

我们只将一部分输入由多头自注意力模块(MHSA)和前向网络(FFN)组成的 NPSA 块中。然后将两部分连接并通过1×1卷积融合 。

此外,我们参考文献[22]的方法,将查询和键的维度设置为MHSA中值维度的一半,并用批归一化替代层归一化以加快推理速度。同时,PSA仅在分辨率最低的第四阶段后配置,避免了自注意力机制因二次方计算复杂度带来的过高开销。通过这种方式,我们以较低计算成本将全局表征学习能力融入YOLO模型,显著提升了模型性能。4 Experiments

4.1 实施细节

- 选择YOLOv8 作为基线模型,因其在延迟与精度之间取得了令人称道的平衡,并且有多种模型尺寸可供选择。

- 采用一致的双分配方法进行无 NMS 训练,并基于此进行整体效率与精度驱动的模型设计,从而提出了YOLOv10模型。YOLOv10与YOLOv8具有相同的变体,即N/S/M/L/X。

- 此外,通过简单增加YOLOv10-M的宽度比例因子,推导出一个新的变体YOLOv10-B。

我们在COCO 上验证了所提出的检测器,在相同的从头训练设置下。此外,所有模型的延迟测试均在T4 GPU上使用TensorRT FP16完成。

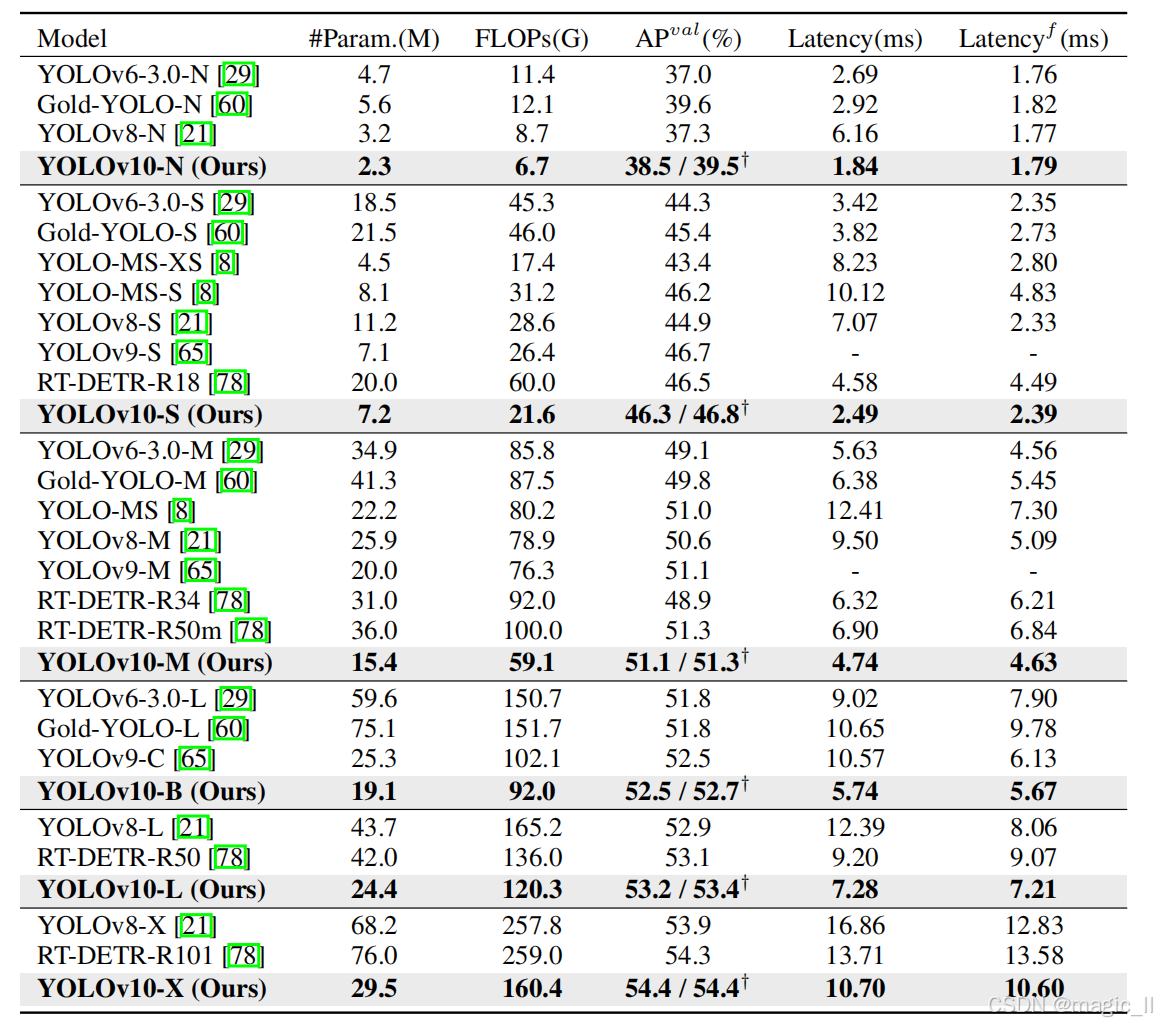

4.2 与现有技术的比较

如表1所示,我们的YOLOv10在不同模型规模下均实现了业界领先的性能和端到端延迟。

- 首先将YOLOv10与基线模型YOLOv8进行对比。在N/S/M/L/X五个变体上,YOLOv10分别实现了1.2%/1.4%/0.5%/0.3%/0.5%的平均精度提升,参数量减少28%/36%/41%/44%/57%,计算量减少23%/24%/25%/27%/38%,延迟降低70%/65%/50%/41%/37%。

- 与其他YOLO模型相比,YOLOv10在准确性和计算成本之间也表现出更优的平衡

- 对于轻量级和小型模型,YOLOv10-N/S在准确性和性能上分别比 YOLOv6-3.0-N /S 高出1.5个AP和2.0个AP,参数减少51%和61%,计算量减少41%和52%。

- 对于中型模型,与YOLOv9-C/YOLO-MS 相比,YOLOv10-B/M在保持相同或更优性能的同时,延迟降低了46%和62%。

- 对于大型模型,与Gold-YOLO-L 相比,我们的YOLOv10-L参数减少了68%,延迟降低了32%,同时性能显著提升了1.4%。

- 与RT-DETR 相比,YOLOv10在性能和延迟方面都有显著提升。值得注意的是,在性能相近的情况下,YOLOv10-S/X的推理速度分别比RT-DETR-R18/R101快1.8倍和1.3倍。这些结果充分证明了YOLOv10作为实时端到端检测器的优越性。

- 我们还采用原始的一对多训练方法,将YOLOv10与其他YOLO模型进行对比。参照文献,本研究重点评估了模型前向过程的性能与延迟(Latencyf)。如表1所示,YOLOv10在不同模型规模下均展现出业界领先的性能与效率,充分验证了我们架构设计的有效性。

4.3 模型分析

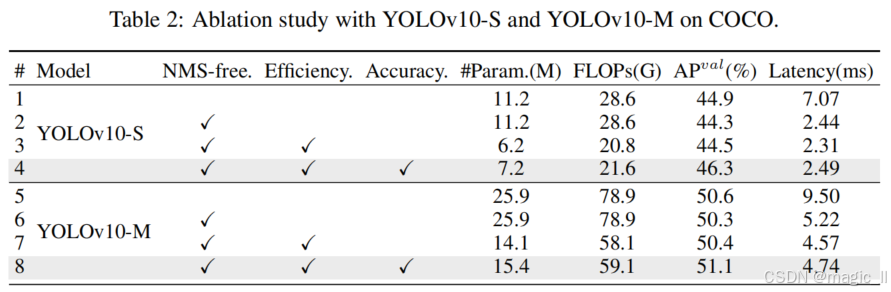

【消融研究 】

在表2中展示了基于YOLOv10-S和YOLOv10-M的消融结果。

- 采用【一致的双重分配进行无 NMS 训练】,显著降低了YOLOv10-S的端到端延迟4.63毫秒,同时保持了44.3%的平均精度。

- 【基于效率驱动的模型设计】减少了11.8百万参数和20.8 GFlOPs,YOLOv10-M的延迟显著降低了0.65毫秒,充分证明了其有效性。

- 【基于准确度驱动的模型设计 】仅增加了0.18毫秒和0.17毫秒的延迟开销,分别使YOLOv10-S和YOLOv10-M的平均精度提高了1.8和0.7,这充分展示了其优越性。

【无 NMS 训练分析】

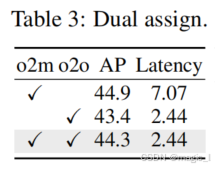

- 双标签分配

提出了针对无 NMS 的YOLO的双标签分配,这可以在训练时提供丰富的单对多(o2m)分支监督,并在推理时实现单对单(o2o)分支的高效性。具体来说,我们分别引入了仅使用o2m分支和仅使用o2o分支的基线模型。如表3所示,我们的双标签分配实现了最佳的AP-延迟权衡。

- 一致性匹配度量

引入一致性匹配度量,使一对一头部与一对多头部更加协调。我们在不同 α o 2 o α_{o2o} αo2o 和 β o 2 o β_{o2o} βo2o 下基于YOLOv8-S(即表2中的#1)验证了其优势。如表4所示,所提出的一致性匹配度量,即 α o 2 o = r ⋅ α o 2 m α_{o2o}=r · α_{o2m} αo2o=r⋅αo2m 和 β o 2 o = r ⋅ β o 2 m β_{o2o}=r · β_{o2m} βo2o=r⋅βo2m ,在一对多头部中可以达到最优性能,其中 α o 2 m = 0.5 α_{o2m}=0.5 αo2m=0.5且 β o 2 m = 6.0 β_{o2m}=6.0 βo2m=6.0。这种改进可归因于监督差距的减少( A = t o 2 o , i − I ( i ∈ Ω ) τ o 2 m , i + ∑ k ∈ Ω \ { i } t o 2 m , k A=t_{o2o,i}-\mathbb{I}(i\in\Omega)\tau_{o2m,i}+\sum_{k\in\Omega\backslash\{i\}}t_{o2m,k} A=to2o,i−I(i∈Ω)τo2m,i+∑k∈Ω\{i}to2m,k),这提供了两个分支之间更好的监督对齐。此外,所提出的一致性匹配度量消除了对详尽超参数调优的需求,这在实际场景中具有吸引力。- 与单对多训练相比的性能差距

尽管在无 NMS 训练下实现了更优的端到端性能,但我们观察到 与使用 NMS 的原始单对多训练相比仍存在性能差距。此外,我们注意到随着模型规模的增加,这种差距逐渐缩小。

因此,我们合理地得出结论,这种差距可归因于模型能力的局限性。值得注意的是,与使用 NMS 的原始单对多训练不同,无 NMS 训练需要更多具有区分性的特征来进行一对一匹配。以YOLOv10-N模型为例,其有限的能力导致提取的特征缺乏足够的区分度,从而导致更显著的1.0%平均精度(AP)性能差距。相比之下,YOLOv10-X模型具有更强的能力和更多具有区分性的特征,在两种训练策略之间未表现出性能差距。在图4中,我们可视化了COCO验证集上每个锚点提取特征与其他所有锚点特征的平均余弦相似度。我们观察到,随着模型规模的增加,锚点之间的特征相似度呈现下降趋势,这有利于一对一匹配。基于这一见解,我们将在未来的工作中探索进一步缩小差距并实现更高端到端性能的方法。【针对效率驱动模型设计的分析 】

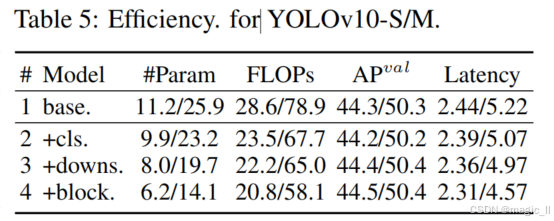

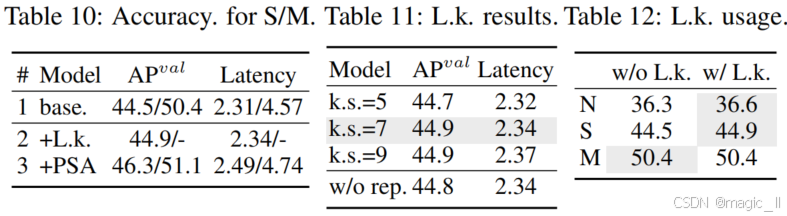

通过实验逐步整合基于YOLOv10-S/M的效率驱动设计要素。基准模型为未采用效率-精度驱动设计的YOLOv10-S/M模型(即表2中的#2/#6)。如表5所示,轻量级分类头、空间通道解耦降采样 以及 秩引导块设计 的每个设计组件,均有助于减少参数数量、浮点运算量(FLOPs)和延迟。值得注意的是,这些改进在保持性能竞争力的同时实现。

- 轻量级分类头。

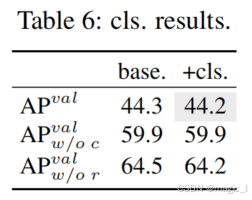

我们基于表5中#1和#2的YOLOv10-S 数据集,分析预测类别和定位误差对性能的影响,方法参照文献[7]。具体而言,通过一对一匹配将预测结果与实例进行对应。随后用实例标签替换预测类别分数,得到无分类误差的APval w/o c。同理,用实例位置替换预测位置,得到无回归误差的APval w/o r。如表6所示,APval w/o r显著高于APval w/o c,表明消除回归误差能带来更大性能提升。因此,性能瓶颈主要存在于回归任务环节。采用轻量级分类头可在不牺牲性能的前提下实现更高效率。

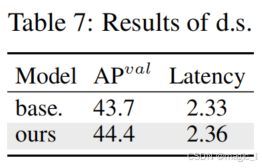

- 空间通道解耦降采样技术

为提升效率,我们采用解耦降采样策略:先通过逐点卷积(PW)扩展通道维度,再通过深度卷积(DW)降低分辨率,从而最大限度保留信息。该方法与传统降采样方式(先用深度卷积减小空间尺寸,再用逐点卷积进行通道调制)形成对比,对比依据为表5中YOLOv10-S模型的第3种方法。如表7所示,我们的降采样策略在信息损失更少的前提下,实现了0.7%的平均精度提升。

- 紧凑反向块(CIB)

我们将 CIB 作为紧凑的基本构建模块引入。我们基于表5中#4的YOLOv10-S验证其有效性。具体来说,我们引入了反向残差块(IRB)作为基线,如表8所示,其平均精度达到43.7%,略逊于最优结果。随后,我们在IRB后附加了一个3×3的深度卷积(DW),记为"IRB-DW"。这带来了0.5%的AP改进。与"IRB-DW"相比,我们的CIB通过在前面 prepend 一个 DW ,以极小的开销进一步将AP提升了0.3%,体现了其优越性。

另外,yolov10仅在CIB中使用了结构重参数- 秩引导块设计。

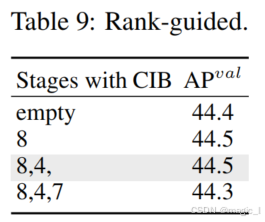

我们引入秩引导块设计,以自适应地整合紧凑块设计,从而提高模型效率。我们在表5中基于YOLOv10-S的#3验证了其优势。根据内在秩升序排列的阶段为8-4-7-3-5-1-6-2,如图3(a)所示。如表9所示,当逐步用高效的 CIB 替换每个阶段的瓶颈块时,我们观察到从第7阶段开始性能下降。在内在秩较低且冗余较多的第8和第4阶段,我们可以采用高效的块设计而不影响性能。这些结果表明,秩引导块设计可以作为提高模型效率的有效策略。

【关于精度驱动模型设计的分析】

这里展示了基于YOLOv10-S/M模型逐步整合精度驱动设计要素的成果。基准模型为整合效率驱动设计后的YOLOv10-S/M模型(即表2中的#3/#7)。如表10所示,采用大核卷积和PSA模块后,YOLOv10-S模型的平均精度分别提升了0.4%和1.4%,同时延迟仅增加0.03毫秒和0.15毫秒。值得注意的是,YOLOv10-M模型未采用大核卷积技术(详见表12)。

- 大核卷积技术。

首先基于表10中YOLOv10-S的#2模型,研究了不同核尺寸的影响。如表11所示,随着核尺寸增大,性能持续提升并在7×7核尺寸附近趋于稳定,这表明大感知野具有显著优势。此外,训练过程中移除重参数化分支仅导致平均精度下降0.1%,验证了该优化策略的有效性。进一步基于YOLOv10-N/S/M模型规模,我们考察了大核卷积的跨模型优势。表12显示,由于YOLOv10-M模型本身具有较大的感受野,采用大核卷积并未带来性能提升。因此,我们仅在YOLOv10-N/S等小型模型中采用大核卷积技术。- 部分自注意力(Partial self-attention PSA)。

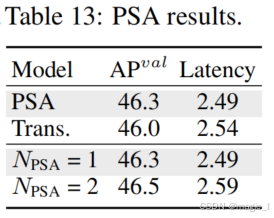

我们引入PSA以在最小成本下增强全局建模能力,从而提升性能。首先,我们在表10中基于YOLOv10-S的第3项验证了其有效性。具体来说,我们引入了变压器块,即 MHSA 后跟 FFN ,作为基线,记为"Trans"。如表13所示,与之相比,PSA带来了0.3%的平均精度提升,同时延迟减少了0.05毫秒。性能的提升可能归因于自注意力中优化问题[68,10]的缓解,通过减少注意力头的冗余。此外,我们研究了不同 NPSA 的影响。如表13所示,将 NPSA 增加到2获得了0.2%的平均精度提升,但延迟增加了0.1毫秒。因此,我们默认将 NPSA 设置为1,以在保持高效率的同时增强模型能力。

【论文阅读】【yolo系列】YOLOv10: Real-Time End-to-End Object Detection

magic_ll2025-12-11 9:02

相关推荐

向哆哆3 天前

高精度织物缺陷检测数据集(适用YOLO系列/1000+标注)(已标注+划分/可直接训练)前网易架构师-高司机3 天前

带标注的驾驶员安全带识别数据集,识别率99.5%,可识别有无系安全带,支持yolo,coco json,pascal voc xml格式薛定e的猫咪3 天前

【AAAI 2025】基于扩散模型的昂贵多目标贝叶斯优化码农三叔3 天前

(3-2-01)视觉感知:目标检测与分类YMWM_3 天前

论文阅读“SimVLA: A Simple VLA Baseline for Robotic Manipulation“m0_650108243 天前

VLN-Zero:零样本机器人导航的神经符号视觉语言规划框架向哆哆3 天前

粉尘环境分类检测千张图数据集(适用YOLO系列)(已标注+划分/可直接训练)琅琊榜首20204 天前

移动端AI挂机新范式:YOLOv8+NCNN实现无Root视觉自动化沃达德软件4 天前

模糊图像复原技术解析晓山清4 天前

【论文阅读】Self-supervised Learning of Person-specific Facial Dynamics for APR