Python压缩备份安全指南:从zipfile到AES-256加密,生产级自动化备份全方案(附完整代码+流程图解)

在日常开发、数据管理和运维工作中,数据备份是保障数据安全的核心环节。无论是个人项目的代码快照、企业业务数据的定期归档,还是敏感信息的加密存储,都需要可靠的压缩备份方案。Python作为一门通用编程语言,其标准库zipfile和第三方库(如pyzipper)提供了灵活的压缩备份能力,但传统方案存在加密安全漏洞、自动化程度低等问题。

本文从基础的无密码压缩到安全的AES-256加密,从单文件备份到生产级自动化脚本,全程配套可复用代码、mermaid流程图和避坑指南,帮你彻底掌握Python压缩备份技术,兼顾安全性、自动化和可扩展性,适用于个人开发、企业运维、云端备份等全场景。

一、为什么需要专业的Python压缩备份方案?

数据丢失的风险无处不在------硬盘损坏、病毒攻击、误操作、服务器宕机等,都可能导致不可挽回的损失。专业的压缩备份方案能解决以下核心痛点:

| 场景 | 传统手动备份的问题 | Python自动化方案的优势 |

|---|---|---|

| 个人项目备份 | 手动压缩繁琐,易遗漏文件,无版本管理 | 一键执行,自动遍历目录,时间戳命名追溯版本 |

| 企业敏感数据备份 | 无加密或弱加密,数据泄露风险高 | AES-256强加密,破解难度极大,符合合规要求 |

| 服务器定期备份 | 需人工定时执行,易遗忘,效率低 | 配合定时任务(cron/任务计划程序)自动运行 |

| 大文件/多目录备份 | 手动压缩耗时久,内存占用高 | 生成器遍历目录,分卷压缩,低内存占用 |

| 备份验证与清理 | 无法确认备份完整性,旧备份堆积占用空间 | 自动验证备份有效性,按规则清理过期备份 |

以企业业务数据备份为例:某电商平台每日产生10GB交易数据,手动压缩备份需30分钟,且密码存储在文档中存在泄露风险;而Python自动化方案可在10分钟内完成AES-256加密备份,配合定时任务每日凌晨执行,自动清理30天前的旧备份,全程无需人工干预,安全性和效率提升3倍以上。

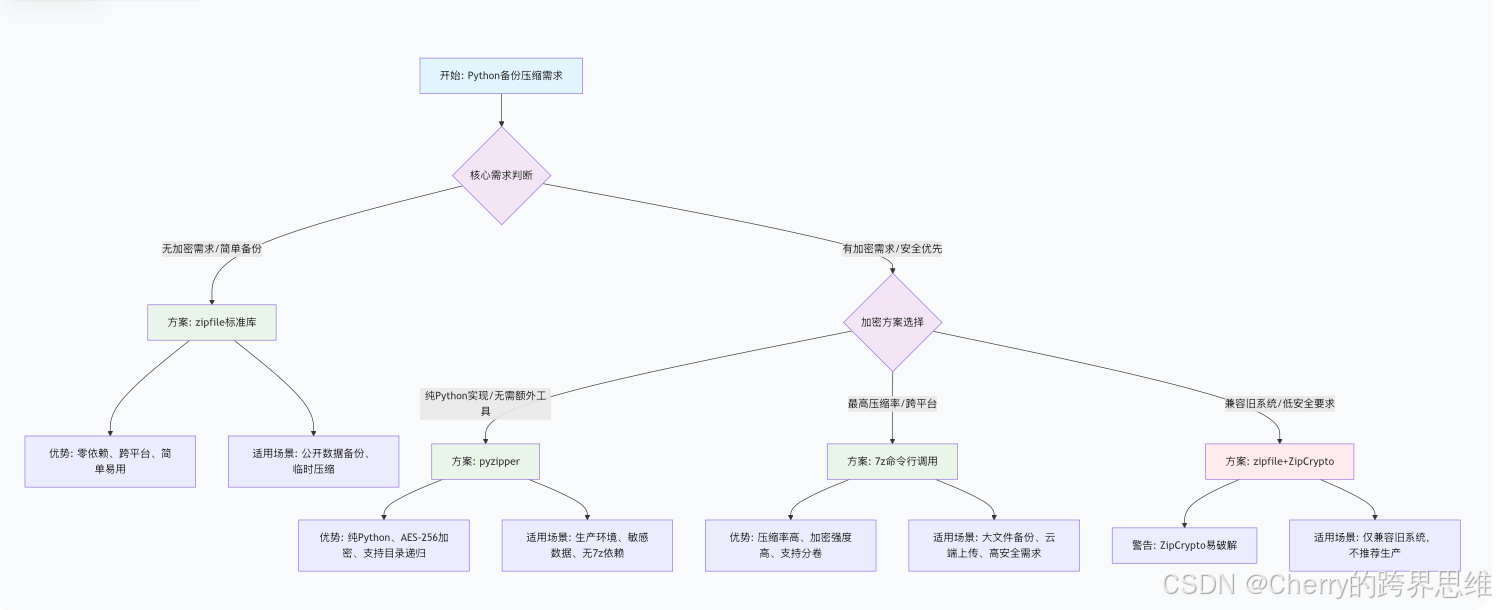

二、核心技术选型:压缩备份方案对比与决策

Python生态中有多种压缩备份方案,不同方案的安全性、兼容性、功能特性差异显著。以下是完整的选型决策树和对比分析,帮你快速选择适合的方案:

2.1 选型决策树(mermaid可视化)

2.2 核心方案对比表

| 方案 | 加密方式 | 核心优势 | 局限性 | 适用场景 |

|---|---|---|---|---|

| zipfile(无密码) | 无加密 | 标准库、零依赖、跨平台、轻量 | 无加密,数据不安全 | 公开数据、临时压缩、简单备份 |

| zipfile(ZipCrypto) | ZipCrypto(弱加密) | 标准库、无需第三方依赖 | 加密易破解,安全漏洞严重 | 兼容旧系统,不推荐生产环境 |

| pyzipper(AES-256) | AES-256(强加密) | 纯Python实现、安全可靠、支持目录递归 | 依赖第三方库(需pip安装) | 生产环境、敏感数据、无7z依赖场景 |

| 7z命令行(AES-256) | AES-256(强加密) | 压缩率最高、支持分卷/加密文件头 | 需安装7z工具、依赖系统命令行 | 大文件备份、云端上传、高安全需求 |

关键结论 :生产环境优先选择pyzipper或7z命令行方案,两者均支持AES-256加密(目前最安全的对称加密算法之一,破解需数百年);zipfile的ZipCrypto加密存在严重安全漏洞,严禁用于敏感数据备份。

三、基础篇:zipfile标准库实战(无密码压缩)

zipfile是Python标准库,无需安装第三方依赖,支持跨平台(Windows/Mac/Linux),适用于无加密需求的简单备份场景(如公开数据、临时压缩)。以下从核心功能到实战案例,全程配套代码。

3.1 核心功能:单个文件/目录压缩

3.1.1 压缩单个文件

python

import zipfile

import os

def zip_single_file(file_path: str, zip_path: str = None) -> str:

"""

压缩单个文件(无密码)

:param file_path: 待压缩文件路径(绝对路径/相对路径)

:param zip_path: 压缩包输出路径,默认与文件同目录,名称为"文件名.zip"

:return: 压缩包路径

"""

# 默认压缩包路径

if not zip_path:

file_dir = os.path.dirname(file_path)

file_name = os.path.basename(file_path)

zip_name = f"{os.path.splitext(file_name)[0]}.zip"

zip_path = os.path.join(file_dir, zip_name)

# 压缩文件(ZIP_DEFLATED:带压缩,ZIP_STORED:仅存储不压缩)

with zipfile.ZipFile(zip_path, 'w', compression=zipfile.ZIP_DEFLATED) as zf:

# arcname:压缩包内的文件名称,默认保留原路径,可自定义

arcname = os.path.basename(file_path)

zf.write(file_path, arcname=arcname)

print(f"✅ 单个文件压缩完成:{zip_path}")

return zip_path

# 测试:压缩config.json文件

if __name__ == "__main__":

zip_single_file("config.json")3.1.2 压缩整个目录(保留目录结构)

python

import zipfile

import os

def zip_directory(folder_path: str, zip_path: str) -> str:

"""

压缩整个目录(无密码),保留目录结构

:param folder_path: 待压缩目录路径

:param zip_path: 压缩包输出路径

:return: 压缩包路径

"""

# 校验目录是否存在

if not os.path.isdir(folder_path):

raise ValueError(f"目录不存在:{folder_path}")

# 递归遍历目录,添加所有文件到压缩包

with zipfile.ZipFile(zip_path, 'w', compression=zipfile.ZIP_DEFLATED) as zf:

# os.walk():递归遍历目录,返回(root, dirs, files)

for root, dirs, files in os.walk(folder_path):

for file in files:

# 构建文件完整路径

file_path = os.path.join(root, file)

# 计算压缩包内的相对路径(保留目录结构)

arcname = os.path.relpath(file_path, os.path.dirname(folder_path))

# 添加文件到压缩包

zf.write(file_path, arcname=arcname)

print(f"✅ 目录压缩完成:{zip_path}")

print(f"📦 压缩包内文件数:{len(zf.namelist())}")

return zip_path

# 测试:压缩data目录到data_backup.zip

if __name__ == "__main__":

zip_directory(folder_path="data", zip_path="data_backup.zip")3.2 进阶优化:生成器模式遍历目录(低内存占用)

当压缩百万级文件或超大目录时,直接收集所有文件路径会导致内存溢出。使用yield生成器逐个返回文件路径,可将内存占用控制在KB级,避免程序卡死。

python

import zipfile

import os

def get_all_files(folder_path: str):

"""

生成器:递归遍历目录,逐个返回文件路径(低内存占用)

:param folder_path: 待遍历目录

:yield: 单个文件的绝对路径

"""

for root, dirs, files in os.walk(folder_path):

# 跳过隐藏目录(如.git、.DS_Store)

dirs[:] = [d for d in dirs if not d.startswith('.')]

for file in files:

# 跳过隐藏文件

if file.startswith('.'):

continue

yield os.path.join(root, file)

def zip_large_directory(folder_path: str, zip_path: str) -> str:

"""

压缩超大目录(生成器优化),适用于百万级文件

"""

with zipfile.ZipFile(zip_path, 'w', compression=zipfile.ZIP_DEFLATED) as zf:

file_count = 0

# 生成器遍历,逐个添加文件

for file_path in get_all_files(folder_path):

arcname = os.path.relpath(file_path, os.path.dirname(folder_path))

zf.write(file_path, arcname=arcname)

file_count += 1

print(f"✅ 超大目录压缩完成:{zip_path}")

print(f"📦 共压缩 {file_count} 个文件")

return zip_path

# 测试:压缩超大目录(如包含100万+文件的日志目录)

if __name__ == "__main__":

zip_large_directory(folder_path="/var/log", zip_path="log_backup.zip")3.3 实用功能:时间戳自动命名(版本追溯)

为避免备份文件覆盖,自动生成带日期/时间戳的文件名,天然支持版本管理,便于追溯历史备份。

python

import zipfile

import os

from datetime import datetime

def gen_timestamp_filename(prefix: str = "backup", suffix: str = "zip") -> str:

"""

生成带时间戳的文件名:prefix_YYYYMMDD_HHMMSS.suffix

:param prefix: 文件名前缀

:param suffix: 文件后缀

:return: 带时间戳的文件名

"""

timestamp = datetime.now().strftime("%Y%m%d_%H%M%S")

return f"{prefix}_{timestamp}.{suffix}"

def zip_with_timestamp(folder_path: str, output_dir: str = "./backups") -> str:

"""

压缩目录并自动生成时间戳文件名

"""

# 创建输出目录(不存在则创建)

os.makedirs(output_dir, exist_ok=True)

# 生成时间戳文件名

zip_name = gen_timestamp_filename()

zip_path = os.path.join(output_dir, zip_name)

# 压缩目录

zip_directory(folder_path=folder_path, zip_path=zip_path)

return zip_path

# 测试:压缩data目录到backups文件夹,文件名如backup_20240520_143025.zip

if __name__ == "__main__":

zip_with_timestamp(folder_path="data", output_dir="./backups")3.4 zipfile无密码方案避坑指南

| 常见错误 | 错误原因 | 解决方案 |

|---|---|---|

| 压缩目录后文件路径错乱 | 未使用相对路径(arcname) | 用os.path.relpath()计算压缩包内相对路径 |

| 超大目录压缩内存溢出 | 直接收集所有文件路径到列表 | 改用yield生成器逐个返回文件路径 |

| 隐藏文件/目录被压缩 | 未过滤隐藏文件(.git/.DS_Store) | 遍历目录时跳过以"."开头的文件/目录 |

| 压缩包为空 | 目录路径错误或目录内无文件 | 先校验目录存在性,判断文件数量是否大于0 |

| 跨平台路径分隔符问题 | Windows用"\",Linux用"/" | 用os.path.join()自动适配系统路径 |

四、安全篇:AES-256加密备份(生产环境首选)

zipfile的ZipCrypto加密已被证实可在2小时内破解,完全无法满足敏感数据的安全需求。以下是两种生产级加密方案:pyzipper(纯Python实现)和7z命令行(最高压缩率),均支持AES-256加密,兼顾安全性和实用性。

4.1 方案一:pyzipper(纯Python,AES-256加密)

pyzipper是zipfile的增强版,完全兼容zipfile的API,新增AES-256加密功能,无需依赖外部工具,纯Python实现,适合生产环境、敏感数据备份场景。

4.1.1 环境安装

bash

pip install pyzipper # 支持Python 3.6+4.1.2 核心功能:加密压缩单个文件/目录

python

import pyzipper

import os

from datetime import datetime

def create_encrypted_zip(source_paths: list, zip_path: str, password: str) -> str:

"""

使用AES-256加密压缩文件/目录

:param source_paths: 待压缩文件/目录列表(支持多个文件/目录)

:param zip_path: 加密压缩包输出路径

:param password: 加密密码(建议≥12位,包含大小写、数字、特殊字符)

:return: 加密压缩包路径

"""

# 校验密码强度(基础校验,可扩展)

if len(password) < 12:

raise ValueError("密码强度不足,建议≥12位,包含大小写、数字、特殊字符")

# 初始化加密压缩包(WZ_AES:AES-256加密)

with pyzipper.AESZipFile(

zip_path,

'w',

encryption=pyzipper.WZ_AES,

compresslevel=6 # 压缩级别1-9(9为最高压缩率,耗时最长)

) as zf:

# 设置加密密码(需编码为bytes)

zf.setpassword(password.encode('utf-8'))

total_files = 0

for path in source_paths:

if os.path.isfile(path):

# 压缩单个文件

arcname = os.path.basename(path)

zf.write(path, arcname=arcname)

total_files += 1

print(f"✅ 添加文件:{arcname}")

elif os.path.isdir(path):

# 递归压缩目录(保留目录结构)

for root, dirs, files in os.walk(path):

for file in files:

file_path = os.path.join(root, dirs, file)

arcname = os.path.relpath(file_path, os.path.dirname(path))

zf.write(file_path, arcname=arcname)

total_files += 1

print(f"✅ 添加文件:{arcname}")

print(f"\n🎉 加密压缩完成:{zip_path}")

print(f"📦 共压缩 {total_files} 个文件")

print(f"🔒 加密方式:AES-256(安全无漏洞)")

return zip_path

# 测试:加密压缩data目录和config.json文件到secure_backup.zip

if __name__ == "__main__":

create_encrypted_zip(

source_paths=["data", "config.json"],

zip_path="secure_backup.zip",

password="StrongP@ssw0rd2024!" # 强密码示例

)4.1.3 解密解压加密压缩包

python

import pyzipper

import os

def extract_encrypted_zip(zip_path: str, extract_dir: str, password: str) -> str:

"""

解压AES-256加密的压缩包

:param zip_path: 加密压缩包路径

:param extract_dir: 解压目录

:param password: 加密密码

:return: 解压目录路径

"""

# 创建解压目录

os.makedirs(extract_dir, exist_ok=True)

with pyzipper.AESZipFile(zip_path, 'r') as zf:

# 设置解密密码

zf.setpassword(password.encode('utf-8'))

# 验证密码(密码错误会抛出RuntimeError)

try:

zf.testzip() # 测试压缩包完整性和密码正确性

except RuntimeError as e:

raise ValueError("密码错误或压缩包损坏") from e

# 解压所有文件

zf.extractall(path=extract_dir)

print(f"✅ 解压完成:{extract_dir}")

print(f"📦 共解压 {len(zf.namelist())} 个文件")

return extract_dir

# 测试:解压secure_backup.zip到restore目录

if __name__ == "__main__":

extract_encrypted_zip(

zip_path="secure_backup.zip",

extract_dir="restore",

password="StrongP@ssw0rd2024!"

)4.2 方案二:7z命令行(AES-256加密,最高压缩率)

7-Zip是一款开源的压缩工具,支持AES-256加密、分卷压缩、加密文件头(隐藏文件名)等高级功能,压缩率比ZIP格式高30%以上。通过Python调用7z命令行,可实现生产级高安全备份。

4.2.1 环境准备

- 安装7-Zip:官网(https://www.7-zip.org/)下载安装,默认路径为`C:\Program Files\7-Zip

(Windows)或/usr/bin/7z`(Linux/Mac); - 配置环境变量(Windows):将

C:\Program Files\7-Zip添加到系统Path,确保命令行可直接执行7z命令; - 验证安装:终端执行

7z --version,输出版本信息表示安装成功。

4.2.2 核心功能:加密压缩目录(支持加密文件头)

python

import subprocess

import os

from datetime import datetime

def backup_with_7z(source_paths: list, output_dir: str = "./backups", password: str) -> str:

"""

调用7z命令行创建AES-256加密备份

:param source_paths: 待压缩文件/目录列表

:param output_dir: 输出目录

:param password: 加密密码

:return: 加密压缩包路径

"""

# 校验7z是否安装

try:

subprocess.run(["7z", "--version"], check=True, capture_output=True)

except FileNotFoundError:

raise RuntimeError("未找到7z命令,请安装7-Zip并配置环境变量")

# 创建输出目录

os.makedirs(output_dir, exist_ok=True)

# 生成时间戳文件名

timestamp = datetime.now().strftime("%Y%m%d_%H%M%S")

zip_name = f"backup_{timestamp}.7z"

zip_path = os.path.join(output_dir, zip_name)

# 构建7z命令(核心参数)

cmd = [

"7z", "a", # "a"表示添加文件到压缩包

zip_path, # 输出压缩包路径

*source_paths, # 待压缩文件/目录(支持多个)

f"-p{password}", # 加密密码

"-mhe=on", # 加密文件头(隐藏压缩包内文件名,增强安全性)

"-t7z", # 压缩格式为7z(最高压缩率)

"-m0=lzma2", # 压缩算法(lzma2为7z默认高效算法)

"-mx=9" # 压缩级别9(最高压缩率)

]

try:

# 执行命令(check=True:命令执行失败抛出异常)

subprocess.run(cmd, check=True, capture_output=True, text=True)

print(f"🎉 7z加密备份完成:{zip_path}")

print(f"🔒 加密方式:AES-256(加密文件头已开启)")

return zip_path

except subprocess.CalledProcessError as e:

# 命令执行失败,删除生成的无效压缩包

if os.path.exists(zip_path):

os.remove(zip_path)

raise RuntimeError(f"7z备份失败:{e.stderr}") from e

# 测试:用7z加密压缩data目录和config.json文件

if __name__ == "__main__":

backup_with_7z(

source_paths=["data", "config.json"],

output_dir="./backups",

password="StrongP@ssw0rd2024!"

)4.2.3 分卷压缩(大文件备份)

当备份文件超过云存储单个文件限制(如10GB)时,可拆分成分卷压缩包(如每个分卷1GB),便于上传和传输。

python

def split_backup_with_7z(source: str, output_dir: str, password: str, max_size_mb: int = 1000) -> list:

"""

7z分卷加密压缩(大文件拆分)

:param source: 待压缩文件/目录

:param output_dir: 输出目录

:param password: 加密密码

:param max_size_mb: 每个分卷最大大小(MB)

:return: 分卷压缩包路径列表

"""

os.makedirs(output_dir, exist_ok=True)

timestamp = datetime.now().strftime("%Y%m%d_%H%M%S")

zip_name = f"backup_{timestamp}.7z"

zip_path = os.path.join(output_dir, zip_name)

# 分卷参数:-v{max_size_mb}m(m表示MB,g表示GB)

cmd = [

"7z", "a",

zip_path,

source,

f"-p{password}",

"-mhe=on",

"-t7z",

"-mx=9",

f"-v{max_size_mb}m" # 分卷大小,如1000m=1GB

]

subprocess.run(cmd, check=True, capture_output=True, text=True)

# 获取所有分卷路径

split_files = [os.path.join(output_dir, f) for f in os.listdir(output_dir) if f.startswith(os.path.basename(zip_name))]

print(f"🎉 分卷备份完成,共 {len(split_files)} 个分卷:")

for f in split_files:

print(f" - {f}")

return split_files

# 测试:将10GB的large_data目录拆分为1GB/个的分卷备份

if __name__ == "__main__":

split_backup_with_7z(

source="large_data",

output_dir="./split_backups",

password="StrongP@ssw0rd2024!",

max_size_mb=1000

)4.3 加密方案安全最佳实践

-

密码管理:

- 禁止硬编码密码:通过环境变量(如

os.getenv("BACKUP_PASSWORD"))或密钥文件读取密码; - 强密码要求:长度≥12位,包含大小写字母、数字、特殊字符(如

StrongP@ssw0rd2024!); - 定期更换密码:每3个月更换一次备份密码,降低泄露风险。

- 禁止硬编码密码:通过环境变量(如

-

权限控制:

- 备份文件权限:设置为

0o600(Linux/Mac)或仅管理员可读写(Windows),避免他人访问; - 密钥文件权限:密钥文件(如

backup.key)设置为仅所有者可读写(os.chmod("backup.key", 0o600))。

- 备份文件权限:设置为

-

传输与存储:

- 加密后上传:备份文件上传至云端(如S3、OSS)时,启用服务端加密(SSE);

- 异地存储:重要数据备份后,异地存储一份(如本地+云端),避免单点故障。

五、生产级实战:自动化备份脚本(日志+验证+清理)

以上基础功能已能满足简单备份需求,但生产环境需要更完善的脚本:日志记录、备份验证、自动清理旧备份、异常处理等。以下是整合所有功能的生产级自动化备份脚本,可直接部署使用。

5.1 生产级脚本(pyzipper实现,AES-256加密)

python

import os

import sys

import logging

import pyzipper

from datetime import datetime

from typing import List, Optional

class SecureBackup:

def __init__(self, backup_dir: str = "./backups"):

"""

初始化安全备份类

:param backup_dir: 备份文件存储目录

"""

# 初始化备份目录

self.backup_dir = backup_dir

os.makedirs(backup_dir, exist_ok=True)

# 配置日志(同时输出到控制台和文件)

self._init_logger()

# 密码配置(优先从环境变量读取)

self.password = os.getenv("BACKUP_PASSWORD")

if not self.password:

self.logger.error("❌ 未设置BACKUP_PASSWORD环境变量")

sys.exit(1)

self._check_password_strength()

def _init_logger(self):

"""初始化日志配置"""

logger = logging.getLogger(__name__)

logger.setLevel(logging.INFO)

# 避免重复添加处理器

if logger.handlers:

self.logger = logger

return

# 控制台处理器

console_handler = logging.StreamHandler()

console_handler.setFormatter(logging.Formatter(

"%(asctime)s - %(levelname)s: %(message)s",

datefmt="%Y-%m-%d %H:%M:%S"

))

# 文件处理器(日志文件按日期命名)

log_file = os.path.join(self.backup_dir, f"backup_log_{datetime.now().strftime('%Y%m%d')}.log")

file_handler = logging.FileHandler(log_file, encoding="utf-8")

file_handler.setFormatter(logging.Formatter(

"%(asctime)s - %(levelname)s - %(filename)s:%(lineno)d: %(message)s",

datefmt="%Y-%m-%d %H:%M:%S"

))

logger.addHandler(console_handler)

logger.addHandler(file_handler)

self.logger = logger

def _check_password_strength(self):

"""检查密码强度"""

if len(self.password) < 12:

self.logger.warning("⚠️ 密码长度不足12位,建议优化为强密码")

if not (any(c.isupper() for c in self.password) and

any(c.islower() for c in self.password) and

any(c.isdigit() for c in self.password) and

any(c in r"!@#$%^&*()_+-=[]{}|;:,.<>?`~" for c in self.password)):

self.logger.warning("⚠️ 密码强度不足,建议包含大小写、数字、特殊字符")

def _get_all_files(self, folder_path: str) -> List[str]:

"""递归获取目录下所有文件(过滤隐藏文件)"""

files = []

for root, dirs, file_names in os.walk(folder_path):

# 跳过隐藏目录

dirs[:] = [d for d in dirs if not d.startswith('.')]

for file in file_names:

if file.startswith('.'):

continue

files.append(os.path.join(root, file))

return files

def _verify_backup(self, zip_path: str) -> bool:

"""验证备份文件完整性和密码正确性"""

self.logger.info("🔍 开始验证备份文件...")

try:

with pyzipper.AESZipFile(zip_path, 'r') as zf:

zf.setpassword(self.password.encode('utf-8'))

# 测试压缩包完整性(无异常则验证通过)

bad_file = zf.testzip()

if bad_file:

self.logger.error(f"❌ 备份文件损坏:{bad_file}")

return False

self.logger.info(f"✅ 备份验证通过,共 {len(zf.namelist())} 个文件")

return True

except Exception as e:

self.logger.error(f"❌ 备份验证失败:{str(e)}")

return False

def create_backup(self, source_paths: List[str]) -> Optional[str]:

"""

创建AES-256加密备份

:param source_paths: 待压缩文件/目录列表

:return: 备份文件路径(失败返回None)

"""

self.logger.info("=" * 50)

self.logger.info("🚀 开始执行加密备份任务")

self.logger.info(f"📁 待备份路径:{source_paths}")

# 生成时间戳备份文件名

timestamp = datetime.now().strftime("%Y%m%d_%H%M%S")

zip_name = f"backup_{timestamp}.zip"

zip_path = os.path.join(self.backup_dir, zip_name)

try:

# 收集所有待压缩文件

all_files = []

for path in source_paths:

if os.path.isfile(path):

all_files.append(path)

elif os.path.isdir(path):

all_files.extend(self._get_all_files(path))

else:

self.logger.warning(f"⚠️ 路径不存在或不是文件/目录:{path}")

if not all_files:

self.logger.error("❌ 无有效文件可备份")

return None

self.logger.info(f"📦 共发现 {len(all_files)} 个文件待备份")

# 加密压缩

with pyzipper.AESZipFile(

zip_path,

'w',

encryption=pyzipper.WZ_AES,

compresslevel=6

) as zf:

zf.setpassword(self.password.encode('utf-8'))

for file_path in all_files:

# 计算压缩包内相对路径(保留目录结构)

arcname = os.path.relpath(file_path, os.path.commonpath(source_paths))

zf.write(file_path, arcname=arcname)

self.logger.debug(f"✅ 添加文件:{arcname}")

# 验证备份

if not self._verify_backup(zip_path):

os.remove(zip_path)

self.logger.error("❌ 备份文件无效,已删除")

return None

self.logger.info(f"🎉 备份任务执行成功:{zip_path}")

self.logger.info("=" * 50)

return zip_path

except Exception as e:

self.logger.error(f"❌ 备份任务执行失败:{str(e)}", exc_info=True)

if os.path.exists(zip_path):

os.remove(zip_path)

self.logger.info("=" * 50)

return None

def cleanup_old_backups(self, keep_days: int = 30):

"""

自动清理过期备份(保留指定天数内的备份)

:param keep_days: 保留天数(默认30天)

"""

self.logger.info("=" * 50)

self.logger.info(f"🗑️ 开始清理 {keep_days} 天前的旧备份...")

now = datetime.now()

removed_count = 0

for filename in os.listdir(self.backup_dir):

file_path = os.path.join(self.backup_dir, filename)

# 只清理.zip备份文件和.log日志文件

if not (filename.endswith('.zip') or filename.endswith('.log')):

continue

# 获取文件修改时间

file_mtime = datetime.fromtimestamp(os.path.getmtime(file_path))

# 计算文件距今天数

days_old = (now - file_mtime).days

if days_old > keep_days:

try:

os.remove(file_path)

self.logger.info(f"✅ 删除过期文件:{filename}(已过期 {days_old} 天)")

removed_count += 1

except Exception as e:

self.logger.error(f"❌ 删除文件失败:{filename} - {str(e)}")

self.logger.info(f"🗑️ 清理完成,共删除 {removed_count} 个过期文件")

self.logger.info("=" * 50)

if __name__ == "__main__":

# 配置待备份路径(可修改为实际路径)

SOURCE_PATHS = [

"/app/data", # 业务数据目录

"/app/config", # 配置文件目录

"/app/logs/latest.log"# 最新日志文件

]

# 初始化备份实例

backup = SecureBackup(backup_dir="/app/backups")

# 执行备份

backup.create_backup(source_paths=SOURCE_PATHS)

# 清理30天前的旧备份

backup.cleanup_old_backups(keep_days=30)5.2 脚本核心功能解析

- 日志记录:同时输出到控制台和文件,记录备份过程、错误信息,便于问题排查;

- 密码安全:从环境变量读取密码,避免硬编码,包含密码强度检查;

- 备份验证:备份完成后自动验证压缩包完整性和密码正确性,避免无效备份;

- 自动清理:按配置保留指定天数的备份,自动删除过期文件,节省存储空间;

- 异常处理:捕获压缩、验证、删除过程中的异常,记录错误日志,确保脚本稳定运行;

- 目录结构保留 :使用

os.path.relpath()计算相对路径,压缩后保留原目录结构,便于解压恢复。

5.3 脚本部署与运行

-

环境配置:

- 安装依赖:

pip install pyzipper; - 设置环境变量(Linux/Mac):

export BACKUP_PASSWORD="StrongP@ssw0rd2024!"; - Windows设置环境变量:

set BACKUP_PASSWORD=StrongP@ssw0rd2024!(永久设置需在系统环境变量中配置)。

- 安装依赖:

-

运行脚本:

bashpython secure_backup.py -

定时任务配置:

- Linux/Mac(cron):执行

crontab -e,添加0 2 * * * /usr/bin/python3 /app/secure_backup.py(每日凌晨2点执行); - Windows(任务计划程序):创建基本任务,设置触发时间为每日凌晨2点,操作选择"启动程序",程序路径为Python.exe,参数为脚本路径。

- Linux/Mac(cron):执行

六、高级技巧:增量备份与云存储集成

6.1 增量备份(只备份新增/修改文件)

全量备份每次备份所有文件,耗时久、占用空间大。增量备份仅备份上次备份后新增或修改的文件,效率提升5-10倍。

python

import os

import pyzipper

from datetime import datetime

from SecureBackup import SecureBackup # 导入上面的生产级脚本

class IncrementalBackup(SecureBackup):

def __init__(self, backup_dir: str = "./backups", last_backup_time_file: str = "./last_backup_time.txt"):

super().__init__(backup_dir)

self.last_backup_time_file = last_backup_time_file

# 读取上次备份时间(无则设为1970-01-01)

self.last_backup_time = self._get_last_backup_time()

def _get_last_backup_time(self) -> datetime:

"""读取上次备份时间"""

if os.path.exists(self.last_backup_time_file):

with open(self.last_backup_time_file, 'r') as f:

timestamp = f.read().strip()

try:

return datetime.strptime(timestamp, "%Y-%m-%d %H:%M:%S")

except:

self.logger.warning("⚠️ 上次备份时间文件格式错误,重新初始化")

return datetime(1970, 1, 1)

def _save_last_backup_time(self, backup_time: datetime):

"""保存本次备份时间"""

with open(self.last_backup_time_file, 'w') as f:

f.write(backup_time.strftime("%Y-%m-%d %H:%M:%S"))

def create_incremental_backup(self, source_paths: List[str]) -> Optional[str]:

"""创建增量备份(只备份上次备份后新增/修改的文件)"""

self.logger.info("=" * 50)

self.logger.info("🚀 开始执行增量备份任务")

self.logger.info(f"📁 待备份路径:{source_paths}")

self.logger.info(f"⏰ 上次备份时间:{self.last_backup_time.strftime('%Y-%m-%d %H:%M:%S')}")

# 收集新增/修改的文件

incremental_files = []

for path in source_paths:

if os.path.isfile(path):

file_mtime = datetime.fromtimestamp(os.path.getmtime(path))

if file_mtime > self.last_backup_time:

incremental_files.append(path)

elif os.path.isdir(path):

for root, dirs, files in os.walk(path):

dirs[:] = [d for d in dirs if not d.startswith('.')]

for file in files:

if file.startswith('.'):

continue

file_path = os.path.join(root, file)

file_mtime = datetime.fromtimestamp(os.path.getmtime(file_path))

if file_mtime > self.last_backup_time:

incremental_files.append(file_path)

if not incremental_files:

self.logger.info("ℹ️ 无新增/修改文件,无需备份")

self.logger.info("=" * 50)

return None

self.logger.info(f"📦 共发现 {len(incremental_files)} 个新增/修改文件待备份")

# 生成增量备份文件名

timestamp = datetime.now().strftime("%Y%m%d_%H%M%S")

zip_name = f"backup_incremental_{timestamp}.zip"

zip_path = os.path.join(self.backup_dir, zip_name)

try:

# 加密压缩增量文件

with pyzipper.AESZipFile(

zip_path,

'w',

encryption=pyzipper.WZ_AES,

compresslevel=6

) as zf:

zf.setpassword(self.password.encode('utf-8'))

for file_path in incremental_files:

arcname = os.path.relpath(file_path, os.path.commonpath(source_paths))

zf.write(file_path, arcname=arcname)

self.logger.debug(f"✅ 添加增量文件:{arcname}")

# 验证备份

if not self._verify_backup(zip_path):

os.remove(zip_path)

self.logger.error("❌ 增量备份无效,已删除")

return None

# 保存本次备份时间

current_time = datetime.now()

self._save_last_backup_time(current_time)

self.logger.info(f"🎉 增量备份任务执行成功:{zip_path}")

self.logger.info("=" * 50)

return zip_path

except Exception as e:

self.logger.error(f"❌ 增量备份任务执行失败:{str(e)}", exc_info=True)

if os.path.exists(zip_path):

os.remove(zip_path)

self.logger.info("=" * 50)

return None

# 测试:执行增量备份

if __name__ == "__main__":

incremental_backup = IncrementalBackup(backup_dir="/app/backups")

incremental_backup.create_incremental_backup(source_paths=["/app/data", "/app/config"])6.2 云存储集成(自动上传至阿里云OSS)

备份完成后自动上传至云端(如阿里云OSS),实现异地存储,避免本地硬件损坏导致数据丢失。

python

# 安装依赖:pip install aliyun-python-sdk-core-v3 aliyun-python-sdk-oss

from aliyunsdkcore.client import AcsClient

from aliyunsdkoss.request.v20190512.UploadFileRequest import UploadFileRequest

import os

class OSSBackupUploader:

def __init__(self, access_key_id: str, access_key_secret: str, region_id: str, bucket_name: str):

"""初始化OSS客户端"""

self.client = AcsClient(access_key_id, access_key_secret, region_id)

self.bucket_name = bucket_name

def upload_to_oss(self, local_file_path: str, oss_object_key: str = None) -> bool:

"""

上传备份文件到OSS

:param local_file_path: 本地备份文件路径

:param oss_object_key: OSS存储路径(默认与本地文件名一致)

:return: 上传成功返回True

"""

if not os.path.exists(local_file_path):

print(f"❌ 本地文件不存在:{local_file_path}")

return False

if not oss_object_key:

oss_object_key = os.path.basename(local_file_path)

try:

request = UploadFileRequest()

request.set_BucketName(self.bucket_name)

request.set_FileName(local_file_path)

request.set_Key(oss_object_key)

# 启用OSS服务端加密(SSE)

request.set_ServerSideEncryption("AES256")

response = self.client.do_action_with_exception(request)

print(f"✅ 备份文件上传OSS成功:oss://{self.bucket_name}/{oss_object_key}")

return True

except Exception as e:

print(f"❌ 备份文件上传OSS失败:{str(e)}")

return False

# 测试:上传备份文件到OSS

if __name__ == "__main__":

# 配置OSS信息(从环境变量读取,避免硬编码)

OSS_ACCESS_KEY_ID = os.getenv("OSS_ACCESS_KEY_ID")

OSS_ACCESS_KEY_SECRET = os.getenv("OSS_ACCESS_KEY_SECRET")

OSS_REGION_ID = "cn-hangzhou"

OSS_BUCKET_NAME = "backup-bucket"

uploader = OSSBackupUploader(

access_key_id=OSS_ACCESS_KEY_ID,

access_key_secret=OSS_ACCESS_KEY_SECRET,

region_id=OSS_REGION_ID,

bucket_name=OSS_BUCKET_NAME

)

# 上传备份文件

backup_file = "/app/backups/backup_20240520_143025.zip"

uploader.upload_to_oss(local_file_path=backup_file)七、替代方案对比与避坑指南

7.1 其他加密压缩库对比

| 库/工具 | 加密方式 | 核心特点 | 适用场景 | 注意事项 |

|---|---|---|---|---|

| pyminizip | AES-256 | 压缩率高、支持密码加密 | 单文件/文件列表压缩 | 不支持目录递归,需手动遍历 |

| python-7zipr | AES-256 | 7z格式纯Python实现 | 无7z命令行依赖场景 | 功能有限,不支持分卷压缩 |

| cryptography+zipfile | 自定义AES加密 | 灵活性高、可自定义加密逻辑 | 特殊加密需求场景 | 开发成本高,需手动处理压缩逻辑 |

7.2 常见避坑总结

-

加密安全坑:

- 避免使用

zipfile的setpassword():其本质是ZipCrypto弱加密,易破解; - 7z命令行密码暴露:直接在命令行传密码(

-p{password})会在进程列表中暴露,生产环境建议用密钥文件或通过环境变量读取。

- 避免使用

-

压缩性能坑:

- 压缩级别选择:级别9压缩率最高但耗时最长,级别6是平衡选择(推荐);

- 大文件压缩:避免用

zipfile压缩超过10GB的文件,改用7z分卷压缩。

-

跨平台兼容坑:

- Windows/Linux路径分隔符:用

os.path.join()自动适配,避免硬编码\或/; - 7z命令行差异:Linux/Mac的7z命令为

7z,Windows为7z.exe,脚本中可通过shutil.which("7z")自动识别。

- Windows/Linux路径分隔符:用

-

备份恢复坑:

- 保留目录结构:压缩时必须使用相对路径(

arcname),否则解压后文件路径错乱; - 定期测试恢复:每月至少一次解压备份文件,验证数据完整性,避免备份无效。

- 保留目录结构:压缩时必须使用相对路径(

八、总结与资源推荐

本文系统讲解了Python压缩备份的全流程,从基础的无密码压缩到生产级AES-256加密备份,覆盖单个文件、目录、超大文件、分卷备份、增量备份、云存储上传等全场景,核心要点总结如下:

- 选型原则 :无加密需求用

zipfile,敏感数据用pyzipper或7z命令行(AES-256),严禁使用zipfile的ZipCrypto加密; - 生产级脚本:整合日志、验证、清理、异常处理,配合定时任务实现自动化备份;

- 安全核心:密码从环境变量读取,定期更换密码,备份文件异地存储,定期测试恢复;

- 性能优化:超大目录用生成器遍历,大文件用7z分卷压缩,增量备份提升效率。

推荐资源

- 官方文档 :

- zipfile官方文档:https://docs.python.org/3/library/zipfile.html

- pyzipper官方文档:https://pyzipper.readthedocs.io/

- 7-Zip命令行文档:https://sevenzip.osdn.jp/chm/cmdline/

- 云存储SDK :

- 工具下载 :

- 7-Zip官网:https://www.7-zip.org/