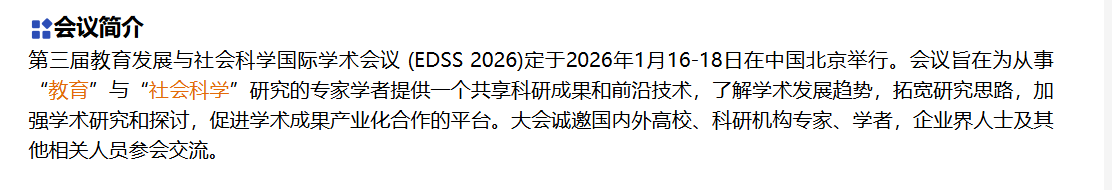

重要信息

**时间:**2026年1月16-18日

**地点:**2026年1月16-18日

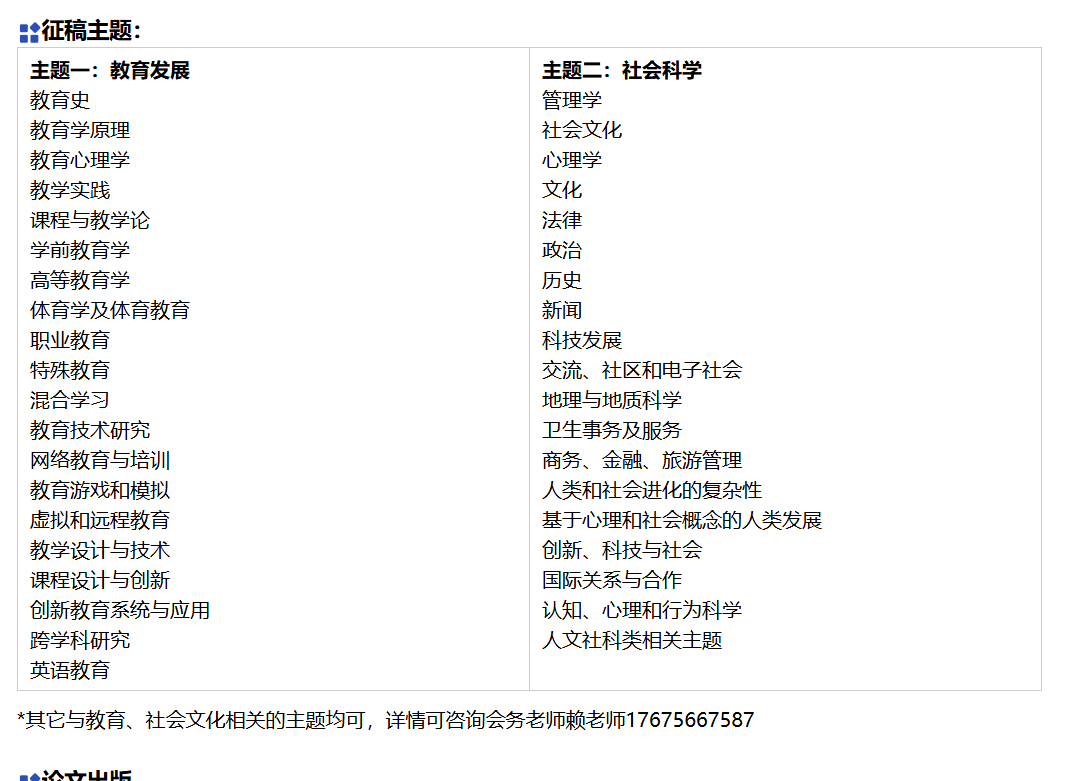

征稿主题

一、领域概述:教育发展与社会科学的交叉融合体系

教育发展与社会科学(EDSS)是聚焦教育系统演进、教育公平、社会治理与教育互构的交叉研究领域,涵盖教育政策分析、数字化教育、社会分层与教育机会、教育评估体系等核心方向,也是第三届 EDSS 2026 国际学术会议重点关注的前沿议题。该领域的技术与研究体系可分为研究方法层、应用场景层、评估决策层三大维度,具体如下表所示:

| 技术 / 研究层级 | 核心内容 | 关键方法 / 技术 | 典型应用场景 |

|---|---|---|---|

| 研究方法层 | 教育数据统计分析、社会调查建模、质性研究量化 | 回归分析、结构方程模型 (SEM)、文本挖掘、机器学习建模 | 教育公平性量化分析、社会舆情对教育政策的影响研究 |

| 应用场景层 | 数字化教育、终身学习体系、教育扶贫、家校社协同 | 在线教育平台设计、学习行为分析、教育资源分配优化 | 乡村教育数字化转型、成人继续教育体系构建、特殊教育保障 |

| 评估决策层 | 教育政策评估、教育质量监测、社会发展适配性分析 | 政策效果评估模型、多维度教育评价指标体系、因果推断 | 双减政策效果分析、区域教育发展水平评估、教育投入产出分析 |

1.1 核心发展趋势

- 数据驱动化:依托大数据、机器学习实现教育问题的精准分析与教育政策的科学制定;

- 公平普惠化:聚焦弱势群体教育机会保障,推动教育资源的均衡化配置;

- 终身学习化:适配社会发展需求,构建覆盖全生命周期的教育体系;

- 跨学科融合:深度融合社会学、经济学、心理学、信息技术,破解复杂教育社会问题。

二、教育发展核心研究方法与 Python 实现

教育发展研究的核心是通过量化分析揭示教育现象背后的社会规律,以下实现教育数据统计分析、文本挖掘(教育政策分析)等关键方法。

2.1 教育公平性量化分析(多元回归 + 基尼系数)

教育公平性分析是 EDSS 的核心议题,通过多元回归分析影响教育机会的社会因素,结合基尼系数量化教育资源分配公平性:

python

运行

import numpy as np

import pandas as pd

import statsmodels.api as sm

from scipy.stats import norm

class EducationEquityAnalysis:

"""教育公平性量化分析工具"""

def __init__(self, data_path):

# 加载教育调查数据(示例字段:家庭收入、地区、父母学历、受教育年限、教育资源投入)

self.df = pd.read_csv(data_path)

# 数据预处理:缺失值填充

self.df = self.df.fillna(self.df.mean(numeric_only=True))

def multiple_regression_analysis(self):

"""多元回归分析:识别影响受教育年限的社会因素"""

# 自变量:家庭收入、父母学历(标准化)、地区(哑变量)

X = self.df[['家庭收入', '父母学历均值']]

X = sm.add_constant(X) # 添加常数项

# 地区哑变量

region_dummies = pd.get_dummies(self.df['地区'], prefix='地区', drop_first=True)

X = pd.concat([X, region_dummies], axis=1)

# 因变量:受教育年限

y = self.df['受教育年限']

# 构建回归模型

model = sm.OLS(y, X).fit()

print("多元回归分析结果:")

print(model.summary())

# 提取关键系数(影响程度)

coefs = model.params.drop('const')

print("\n各因素对受教育年限的影响系数:")

for factor, coef in coefs.items():

print(f"{factor}:{coef:.4f}")

return model

def gini_coefficient(self, data):

"""计算基尼系数(量化教育资源分配公平性)"""

# 排序

data = np.sort(data)

n = len(data)

# 计算基尼系数

cumsum = np.cumsum(data)

gini = (n + 1 - 2 * np.sum(cumsum) / cumsum[-1]) / n

return gini

# 测试(模拟数据)

if __name__ == "__main__":

# 生成模拟教育调查数据

np.random.seed(42)

n_samples = 1000

data = {

'家庭收入': np.random.normal(10, 3, n_samples), # 家庭年收入(万元)

'父母学历均值': np.random.randint(6, 20, n_samples), # 父母学历均值(年)

'地区': np.random.choice(['一线城市', '二线城市', '三线城市', '农村'], n_samples),

'受教育年限': 0.5 * np.random.normal(10, 3, n_samples) + 0.8 * np.random.randint(6, 20, n_samples) + np.random.normal(0, 1, n_samples),

'教育资源投入': np.random.normal(5, 2, n_samples) # 人均教育资源投入(万元)

}

df = pd.DataFrame(data)

df.to_csv('education_survey_data.csv', index=False)

# 实例化分析工具

equity_analysis = EducationEquityAnalysis('education_survey_data.csv')

# 多元回归分析

equity_analysis.multiple_regression_analysis()

# 计算教育资源投入基尼系数

gini = equity_analysis.gini_coefficient(df['教育资源投入'])

print(f"\n教育资源投入基尼系数:{gini:.4f}(<0.2绝对公平,0.2-0.3相对公平,0.3-0.4合理区间)")2.2 教育政策文本挖掘(主题建模 + 情感分析)

通过文本挖掘分析教育政策文本的主题分布、社会舆情对教育政策的情感倾向,为政策优化提供依据:

python

运行

import pandas as pd

import jieba

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.decomposition import LatentDirichletAllocation

from snownlp import SnowNLP

class EducationPolicyAnalysis:

"""教育政策文本挖掘与情感分析"""

def __init__(self, text_data):

self.text_data = text_data # 政策文本/舆情文本列表

# 停用词表(中文)

self.stop_words = self.load_stop_words()

def load_stop_words(self):

"""加载中文停用词"""

stop_words = ['的', '了', '在', '是', '我', '有', '和', '就', '不', '人', '都', '一', '一个', '上', '也', '很', '到', '说', '要', '去', '你', '会', '着', '没有', '看', '能', '这', '那', '他', '她']

return stop_words

def text_preprocess(self, text):

"""文本预处理:分词+去停用词"""

# 分词

words = jieba.lcut(text)

# 去停用词+过滤非中文

words_filtered = [w for w in words if w not in self.stop_words and w.strip() and '\u4e00' <= w <= '\u9fff']

return ' '.join(words_filtered)

def lda_topic_modeling(self, n_topics=5, n_top_words=10):

"""LDA主题建模:提取政策文本核心主题"""

# 预处理文本

texts_processed = [self.text_preprocess(text) for text in self.text_data]

# 构建TF-IDF矩阵

tfidf = TfidfVectorizer(max_df=0.9, min_df=2)

tfidf_matrix = tfidf.fit_transform(texts_processed)

# LDA建模

lda = LatentDirichletAllocation(n_components=n_topics, random_state=42)

lda.fit(tfidf_matrix)

# 输出主题-关键词

print("LDA主题建模结果(教育政策核心主题):")

feature_names = tfidf.get_feature_names_out()

for topic_idx, topic in enumerate(lda.components_):

top_words = [feature_names[i] for i in topic.argsort()[:-n_top_words - 1:-1]]

print(f"主题{topic_idx+1}:{' '.join(top_words)}")

return lda, tfidf

def sentiment_analysis(self):

"""情感分析:分析舆情对教育政策的情感倾向"""

sentiments = []

for text in self.text_data:

s = SnowNLP(text)

sentiments.append(s.sentiments) # 情感值(0-1,越接近1越积极)

# 统计情感分布

positive = sum(1 for s in sentiments if s >= 0.7)

neutral = sum(1 for s in sentiments if 0.3 < s < 0.7)

negative = sum(1 for s in sentiments if s <= 0.3)

print("\n教育政策舆情情感分布:")

print(f"积极:{positive}条({positive/len(sentiments)*100:.2f}%)")

print(f"中性:{neutral}条({neutral/len(sentiments)*100:.2f}%)")

print(f"消极:{negative}条({negative/len(sentiments)*100:.2f}%)")

print(f"平均情感值:{np.mean(sentiments):.4f}")

return sentiments

# 测试(模拟教育政策舆情文本)

if __name__ == "__main__":

# 模拟教育政策相关舆情文本

policy_texts = [

"双减政策有效减轻了学生的作业负担,家长们普遍表示支持",

"乡村教育数字化转型需要更多的资金投入,才能缩小城乡教育差距",

"在线教育平台的质量参差不齐,需要加强监管保障学习效果",

"终身学习体系的构建有助于提升社会整体素质,适应时代发展需求",

"特殊教育资源分配不足,残疾儿童的教育机会需要更多保障",

"家校社协同育人模式效果显著,值得在全国范围内推广",

"教育扶贫政策让更多农村孩子有了接受优质教育的机会",

"当前教育评价体系过于注重分数,不利于学生全面发展",

"职业教育的社会认可度仍然较低,需要政策引导和宣传",

"高校扩招政策提升了高等教育普及率,但也带来了就业压力"

]

# 实例化分析工具

policy_analysis = EducationPolicyAnalysis(policy_texts)

# LDA主题建模

policy_analysis.lda_topic_modeling(n_topics=3, n_top_words=8)

# 情感分析

policy_analysis.sentiment_analysis()三、社会科学视角下的教育发展评估模型

3.1 教育政策效果评估(双重差分法 DID)

双重差分法是评估教育政策效果的经典因果推断方法,可有效剥离政策外因素的影响,精准衡量政策实施效果:

python

运行

import numpy as np

import pandas as pd

import statsmodels.api as sm

class DID_EducationPolicy:

"""双重差分法(DID)评估教育政策效果"""

def __init__(self, data_path):

# 加载政策评估数据(处理组/对照组,政策前后数据)

self.df = pd.read_csv(data_path)

# 构建DID核心变量

self.df['政策实施'] = (self.df['时间'] >= self.df['政策实施时间']).astype(int)

self.df['处理组'] = self.df['是否处理组'].astype(int)

self.df['DID项'] = self.df['政策实施'] * self.df['处理组']

def did_analysis(self):

"""执行DID分析:评估政策对教育成果的影响"""

# 自变量:处理组、政策实施、DID项,控制变量(地区经济水平、教育投入)

X = self.df[['处理组', '政策实施', 'DID项', '地区经济水平', '教育投入']]

X = sm.add_constant(X)

# 因变量:教育成果(如学生学业成绩、入学率等)

y = self.df['教育成果']

# 构建回归模型

model = sm.OLS(y, X).fit()

print("双重差分法(DID)政策效果评估结果:")

print(model.summary())

# 提取DID系数(政策净效应)

did_coef = model.params['DID项']

did_pvalue = model.pvalues['DID项']

print(f"\n政策净效应(DID系数):{did_coef:.4f},P值:{did_pvalue:.4f}")

if did_pvalue < 0.05:

print("政策效果具有统计显著性")

else:

print("政策效果无统计显著性")

return model

# 测试(模拟双减政策评估数据)

if __name__ == "__main__":

# 生成模拟DID数据

np.random.seed(42)

n_samples = 200

# 处理组(实施双减政策的地区)、对照组(未实施)

treat_group = np.random.choice([0, 1], n_samples, p=[0.5, 0.5])

# 政策实施时间(以2022年为界)

time = np.random.choice([2021, 2022, 2023], n_samples)

policy_implement_time = 2022

# 控制变量

region_econ = np.random.normal(10, 2, n_samples)

edu_input = np.random.normal(5, 1, n_samples)

# 教育成果(学生学业压力评分,越低越好)

edu_outcome = 8 - 0.8*treat_group*(time>=policy_implement_time) - 0.5*region_econ - 0.3*edu_input + np.random.normal(0, 1, n_samples)

data = {

'是否处理组': treat_group,

'时间': time,

'政策实施时间': [policy_implement_time]*n_samples,

'地区经济水平': region_econ,

'教育投入': edu_input,

'教育成果': edu_outcome

}

df = pd.DataFrame(data)

df.to_csv('education_policy_did_data.csv', index=False)

# 实例化DID分析工具

did_analysis = DID_EducationPolicy('education_policy_did_data.csv')

did_analysis.did_analysis()3.2 教育发展水平多维度评估(熵权 TOPSIS 法)

熵权 TOPSIS 法可客观赋权,多维度评估区域教育发展水平,为教育资源优化配置提供依据:

python

运行

import numpy as np

import pandas as pd

class EducationDevelopmentEvaluation:

"""熵权TOPSIS法评估区域教育发展水平"""

def __init__(self, data_path):

# 加载区域教育发展数据(多维度指标)

self.df = pd.read_csv(data_path, index_col='地区')

self.indicators = self.df.columns # 评估指标

self.n_regions = len(self.df) # 区域数量

self.n_indicators = len(self.indicators) # 指标数量

def data_standardization(self):

"""数据标准化(消除量纲影响)"""

df_std = (self.df - self.df.min()) / (self.df.max() - self.df.min())

# 处理0分母情况

df_std = df_std.fillna(0)

self.df_std = df_std

return df_std

def entropy_weight(self):

"""计算熵权(客观赋权)"""

# 标准化后数据避免0值

df_std = self.df_std + 1e-8

# 计算比重矩阵

p = df_std / df_std.sum(axis=0)

# 计算熵值

e = -1 / np.log(self.n_regions) * (p * np.log(p)).sum(axis=0)

# 计算差异系数

g = 1 - e

# 计算熵权

w = g / g.sum()

self.weights = w

print("各评估指标熵权:")

for idx, ind in enumerate(self.indicators):

print(f"{ind}:{w[idx]:.4f}")

return w

def topsis_evaluation(self):

"""TOPSIS综合评估"""

# 标准化+赋权

self.data_standardization()

self.entropy_weight()

df_weighted = self.df_std * self.weights

# 确定正理想解和负理想解

z_pos = df_weighted.max(axis=0)

z_neg = df_weighted.min(axis=0)

# 计算距离

d_pos = np.sqrt(((df_weighted - z_pos)**2).sum(axis=1))

d_neg = np.sqrt(((df_weighted - z_neg)**2).sum(axis=1))

# 计算贴近度(0-1,越接近1发展水平越高)

closeness = d_neg / (d_pos + d_neg)

self.closeness = closeness

# 排序

result = pd.DataFrame({

'贴近度': closeness,

'排名': closeness.rank(ascending=False).astype(int)

})

result = result.sort_values('排名')

print("\n各地区教育发展水平评估结果:")

print(result)

return result

# 测试(模拟区域教育发展数据)

if __name__ == "__main__":

# 模拟6个地区,5个评估指标(均为正向指标)

regions = ['地区A', '地区B', '地区C', '地区D', '地区E', '地区F']

indicators = [

'义务教育入学率(%)',

'人均教育经费(元)',

'教师学历达标率(%)',

'数字化教育覆盖率(%)',

'生均校舍面积(㎡)'

]

np.random.seed(42)

data = np.random.uniform(80, 98, (6, 5))

# 人为设置地区A发展水平最高,地区F最低

data[0] += 5

data[-1] -= 5

df = pd.DataFrame(data, index=regions, columns=indicators)

df.to_csv('education_development_data.csv')

# 实例化评估工具

edu_evaluation = EducationDevelopmentEvaluation('education_development_data.csv')

edu_evaluation.topsis_evaluation()四、EDSS 领域核心挑战与突破方向

4.1 核心挑战梳理

| 挑战维度 | 具体问题 | 行业 / 研究痛点 |

|---|---|---|

| 研究方法 | 教育数据碎片化、质性研究量化难、因果推断准确性低 | 跨地区数据难以整合,主观研究结论缺乏量化支撑,政策效果评估易受混淆变量影响 |

| 教育实践 | 教育资源分配不均、数字化教育鸿沟、终身学习体系不完善 | 城乡 / 区域教育差距仍存,老年 / 弱势群体数字化学习能力不足,继续教育资源适配性差 |

| 政策落地 | 政策执行偏差、评估体系单一、社会适配性不足 | 政策在基层执行中变形,教育评估过度注重分数,政策未充分考虑社会结构差异 |

| 跨学科融合 | 学科壁垒明显、理论与实践脱节 | 社会学理论难以指导教育实践,教育问题分析缺乏多学科视角 |

4.2 关键突破方向

- 数据融合与治理:构建全国统一的教育数据平台,整合教育、经济、社会多维度数据,为研究提供基础支撑;

- 方法创新:结合机器学习与因果推断,提升教育政策效果评估的准确性;推动质性研究的量化转型,增强研究结论的客观性;

- 公平导向的资源配置:建立动态的教育资源均衡配置机制,聚焦弱势群体(农村、特殊儿童、老年学习者)的教育保障;

- 多元化评估体系:构建涵盖学业、能力、素养、社会适应力的多维度教育评估体系,摆脱 "唯分数论";

- 跨学科协同:建立教育 - 社会 - 经济 - 心理跨学科研究联盟,推动理论研究与教育实践的深度融合。

五、国际交流与合作机会

作为国际学术会议,将吸引全球范围内的专家学者参与。无论是发表研究成果、聆听特邀报告,还是在圆桌论坛中与行业大咖交流,都能拓宽国际视野,甚至找到潜在的合作伙伴。对于高校师生来说,这也是展示研究、积累学术人脉的好机会。