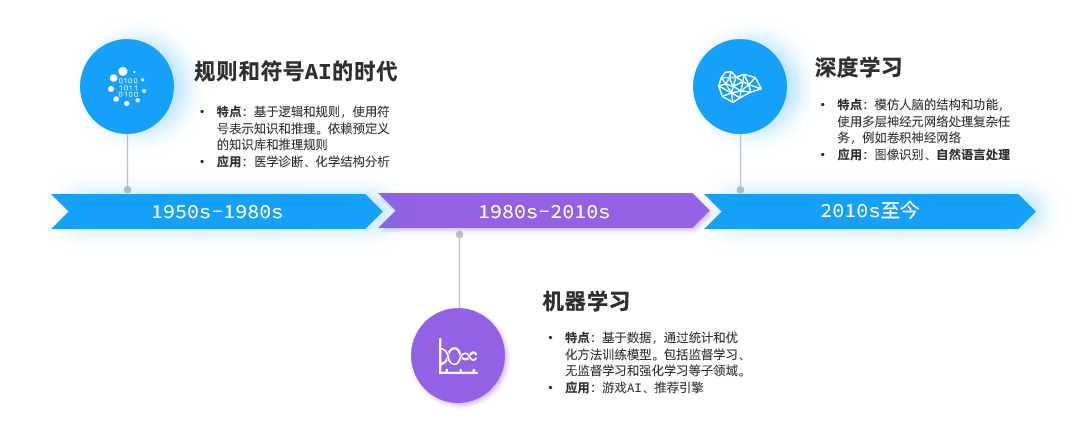

AI,即人工智能(Artificial Intelligence),是一门跨越计算机科学、数学、神经科学等多领域的前沿学科,其核心目标是赋予机器类人的认知能力 ------ 包括自主思考、逻辑推理、持续学习与复杂问题解决。从早期的规则式算法到如今的智能交互,AI 的发展历经半个多世纪的迭代,而真正推动其迈入 "通用智能" 雏形阶段的,正是深度学习领域自然语言处理(Natural Language Processing, NLP)技术的突破性进展,其中最关键的里程碑式发明,便是 Transformer 神经网络模型。如今我们日常接触的 GPT 系列、DeepSeek、文心一言等主流大模型,无论功能如何多样,其底层架构的核心骨架始终是 Transformer。

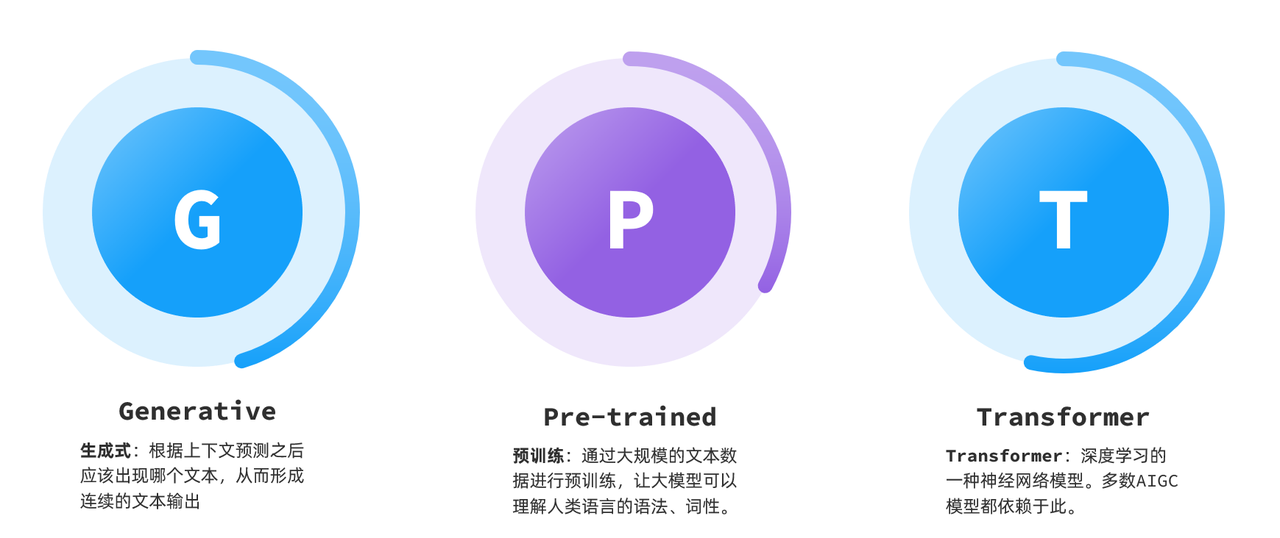

以 GPT(Generative Pre-trained Transformer)这一现象级模型为例,其英文缩写恰好完整勾勒出与 Transformer 的深度绑定:"Generative(生成式)" 定义了它的核心能力 ------ 能够自主创作连贯文本、对话响应等内容;"Pre-trained(预训练)" 揭示了它的学习模式 ------ 通过海量文本数据(涵盖书籍、网页、学术论文等)提前完成知识积累,无需从零开始学习;而 "Transformer" 则是支撑这一切能力的技术基石,如同建筑的钢筋骨架,决定了模型的信息处理效率与智能上限。那么,这个诞生于 2017 年的神经网络,究竟藏着怎样的技术玄机,能撑起如今 AI 的强大功能呢?

追溯 Transformer 的起源,它并非为 "对话" 而生。2017 年,Google 团队在顶级学术会议上发表了一篇名为《Attention is All You Need》(注意力就是你所需要的一切)的论文,首次提出了 Transformer 架构,其最初的应用场景是机器翻译 ------ 解决不同语言之间的精准转换问题。在此之前,传统神经网络处理语言时,往往采用 "逐词递进" 的方式,如同阅读时只能逐字逐句推进,无法同时关注上下文的关联,效率低且理解能力有限。而 Transformer 的革命性突破,正是其核心的 "自注意力机制"(Self-Attention):这一机制让模型能够像人类阅读文章时那样,在处理某个词语时,同时 "看到" 整个句子甚至更长文本中的所有词语,并根据语义关联度调整关注度 ------ 比如理解 "他" 这个代词时,能自动定位到前文对应的人物,理解 "这一技术" 时,能精准关联到前文提到的核心发明。

更令人惊叹的是,Transformer 的能力边界并未局限于文字。由于其注意力机制本质上是对 "序列信息" 的灵活处理,而音频(按时间序列排列)、图片(按像素矩阵序列排列)等数据都可转化为序列形式,因此它天然具备跨模态处理能力。依托这一特性,各类颠覆想象的创新应用应运而生:音频领域,模型能实现实时语音转文字(如会议记录工具)、文本转自然语音(如有声书生成),甚至能模仿特定人的音色;图像领域,Dall-E、MidJourney 等知名模型凭借 Transformer 的跨模态理解能力,将抽象的文字描述(如 "一只穿着西装的猫咪坐在月球上喝咖啡")精准转化为细节丰富、逻辑自洽的创意画作,让文字的想象力通过视觉直观呈现;更有多模态模型能同时处理文字、图片、音频,实现 "看图说话""语音指令生成视频" 等复杂功能。

而我们日常频繁互动的大语言模型(Large Language Models, 简称 LLM),则为 Transformer 开辟了另一核心应用场景 ------自回归推理预测。在模型的训练阶段,研发人员会向 Transformer 输入海量的文本数据(从古典文学到现代科技论文,从日常对话到学术报告),同时也会融入音频、图片等结构化数据的特征。模型的核心任务并非 "记忆" 这些数据,而是通过学习数据中的语言规律、逻辑关系,推测出 "当前序列之后最可能出现的内容"。

这个推测过程并非主观判断,而是基于复杂的数学计算:模型会将输入信息转化为高维向量,通过注意力机制计算每个向量与其他向量的关联权重,再经过多层神经网络的运算,最终输出一个 "概率分布"------ 比如在 "我想去北京" 这句话之后,"旅游" 的出现概率是 35%,"出差" 是 28%,"探亲" 是 15%,其余词汇的概率则更低。此时,模型会选择概率最高的词汇作为预测结果。

这时候很多人会疑惑:仅仅是预测下一个词语,怎么能让 ChatGPT 这类工具生成大段连贯、逻辑通顺的对话呢?答案其实是 LLM 采用的 "自回归持续生成" 模式 ------ 这是一种看似 "笨拙" 却异常有效的方法。

具体来说,生成过程分为三个核心步骤:第一步,模型接收用户输入的初始文本(如 "介绍一下人工智能"),通过内部运算预测出第一个后续词语(如 "人工智能");第二步,将这个新生成的词语与初始文本拼接,形成新的文本序列("介绍一下人工智能 人工智能");第三步,把这个更新后的序列重新输入模型,再次进行下一个词语的预测(如 "是")。如此循环往复,每生成一个词语就将其融入上下文,再基于新的上下文进行下一次预测,如同滚雪球一般,一步步拼凑出完整的长文本。

这也正是我们和 AI 聊天时,总能看到内容逐字、逐词输出的原因 ------ 它并非提前写好了完整回复,而是在实时完成 "预测 - 拼接 - 再预测" 的循环计算,每一个字符的出现,都是模型动态推理的结果。这种模式看似简单,却能依托 Transformer 强大的上下文理解能力,让生成的内容始终保持逻辑连贯、语义通顺,甚至能根据对话中的新信息调整后续回复方向。

从 2017 年论文中的机器翻译架构,到如今支撑多模态创作、智能对话、逻辑推理的核心技术,Transformer 用其独特的注意力机制和灵活的架构,彻底改变了 AI 的发展轨迹。它不仅是大模型的技术基石,更重新定义了机器与数据的交互方式 ------ 让机器从 "被动执行指令" 升级为 "主动理解意义"。而 LLM 的持续生成模式,则让这份技术潜力转化成了我们触手可及的智能体验,让曾经遥远的 "类人智能" 走进了日常生活的方方面面。