文章目录

- 目录

-

- 一、Eino核心特点

- 二、Eino核心组件解析(

- 三、主流LLM框架多维度对比

- 四、Eino社区生态与支持

-

- [1. 生态核心数据](#1. 生态核心数据)

- [2. 生态优势](#2. 生态优势)

- 五、Eino适用场景与选型建议

-

- [1. 推荐使用场景](#1. 推荐使用场景)

- [2. 谨慎选择场景](#2. 谨慎选择场景)

- 总结

目录

若对您有帮助的话,请点赞收藏加关注哦,您的关注是我持续创作的动力!有问题请私信或联系邮箱:funian.gm@gmail.com

作为字节跳动开源的Go语言大模型应用开发框架,Eino以"组件化、强类型、高并发"为核心,专为解决LLM应用工程化落地痛点而生。其凭借Go语言的性能优势与灵活的编排能力,已在抖音、豆包等核心业务中规模化应用。

一、Eino核心特点

Eino的设计围绕LLM应用开发的核心痛点,平衡了开发效率、性能与可维护性,核心特点如下:

| 核心特点 | 详细说明 | 核心价值 |

|---|---|---|

| 强类型Go语言基因 | 基于Go语言开发,组件输入输出类型严格对齐,编译时校验错误 | 降低运行时故障,提升长期维护效率 |

| 组件化极致抽象 | 拆分ChatModel、Tool等标准化组件,支持多模态嵌套与插拔替换 | 复杂系统可维护性提升300%以上 |

| 三重智能编排模式 | 支持Graph(图编排)、Chain(链编排)、Workflow(工作流编排) | 覆盖从简单流程到复杂多Agent协作的全场景 |

| 高性能并发调度 | 基于Pregel模型的DAG执行引擎,默认启用Eager执行策略 | 推理效率较传统串行框架提升5-8倍 |

| 革命性流式处理 | 独创StreamReader/StreamWriter机制,支持流拼接、合并等四大范式 | 毫秒级延迟响应,适配实时对话、流式文档分析 |

| 企业级DevOps支持 | 配套EinoDev可视化平台,集成Langfuse观测工具 | 调试效率提升70%,支持全链路监控 |

| 开箱即用生态 | 预置50+组件,覆盖主流大模型接入、知识库管理等场景 | 跳过重复造轮子,快速启动生产级项目 |

| 并发安全设计 | 移除非线程安全接口,通过ProcessState回调保障状态安全 | 消除高并发场景下的竞态风险 |

二、Eino核心组件解析(

Eino的核心组件围绕LLM应用全流程设计,各组件通过标准化接口协同工作,以下是核心组件清单:

| 核心组件 | 核心功能 | 典型使用场景 |

|---|---|---|

| ChatModel | 对接GPT/GLM/豆包等主流大模型,支持生成式推理与工具调用决策 | 大模型交互核心,负责意图识别与结果生成 |

| ChatTemplate | 动态拼接系统指令、对话历史与用户查询,生成标准化提示词 | Prompt工程管理,统一多场景提示词格式 |

| Tool | 扩展大模型能力,支持自定义工具注册,内置常用工具集 | 数据库查询、IP查询、文件操作等外部能力集成 |

| Retriever | 从向量库/文档库检索相关内容,支持多路召回策略 | 知识库问答、上下文补充、语义搜索 |

| Lambda | 嵌入自定义代码逻辑,处理数据格式转换与业务规则校验 | 结果格式化、中间数据处理、业务逻辑注入 |

| StreamReader/StreamWriter | 流式数据处理,支持拼接、合并、复制、转换四大能力 | 实时对话系统、大文件流式分析、多流协同 |

| Graph/Chain/Workflow | 组件编排引擎,定义执行顺序与依赖关系 | 单Agent流程、多Agent协作、固定业务流水线 |

| MultiAgent | 多智能体管理组件,支持Agent路由与协同决策 | 复杂任务拆解、多角色协作场景(如客服+技术支持) |

注:Eino v0.4.0版本为核心更新,默认启用AllPredecessor触发的Eager执行,移除compose.GetState接口,全面提升并发安全性与执行效率。

三、主流LLM框架多维度对比

选择LLM框架需结合语言生态、性能、场景适配性等因素,以下是Eino与LangChain、LlamaIndex、Dify的核心维度对比:

| 对比维度 | Eino(Go) | LangChain(Python) | LlamaIndex(Python) | Dify(低代码) |

|---|---|---|---|---|

| 设计定位 | 企业级LLM应用开发框架 | 通用LLM应用开发框架 | 知识库增强LLM框架 | 可视化LLM低代码平台 |

| 核心优势 | 高并发、强类型、工程化 | 生态丰富、插件众多 | 知识库处理能力强 | 零代码/低代码、易用性高 |

| 并发处理能力 | 十万级QPS | 千级QPS | 千级QPS | 万级QPS(平台托管) |

| 类型安全 | 编译时校验 | 运行时校验 | 运行时校验 | 无(配置化) |

| 组件复用率 | 85% | 40% | 55% | 70%(平台限定组件) |

| 部署复杂度 | 原生支持K8s | 需容器化改造 | 需容器化改造 | 平台托管(无需部署) |

| 维护成本 | 低(强类型+工程化) | 高(动态类型) | 高(动态类型) | 低(平台维护) |

| 复杂逻辑支持 | 完全支持(代码级灵活扩展) | 支持(但动态类型易出错) | 有限(侧重知识库场景) | 受限(可视化配置边界) |

| 适用场景 | 中大型生产级LLM应用、高并发服务 | 快速原型验证、科研实验 | 知识库问答专项场景 | 非技术人员快速搭建应用 |

性能补充说明:

- 字节跳动内部压测显示,Eino内存泄漏发生率仅0.05%,远低于LangChain的3.2%

- 流式处理场景下,Eino延迟降至毫秒级,较Python框架平均降低60%以上

- 高并发场景下启用WithEagerExecution后,响应延迟再降15%,吞吐量提升10%+

四、Eino社区生态与支持

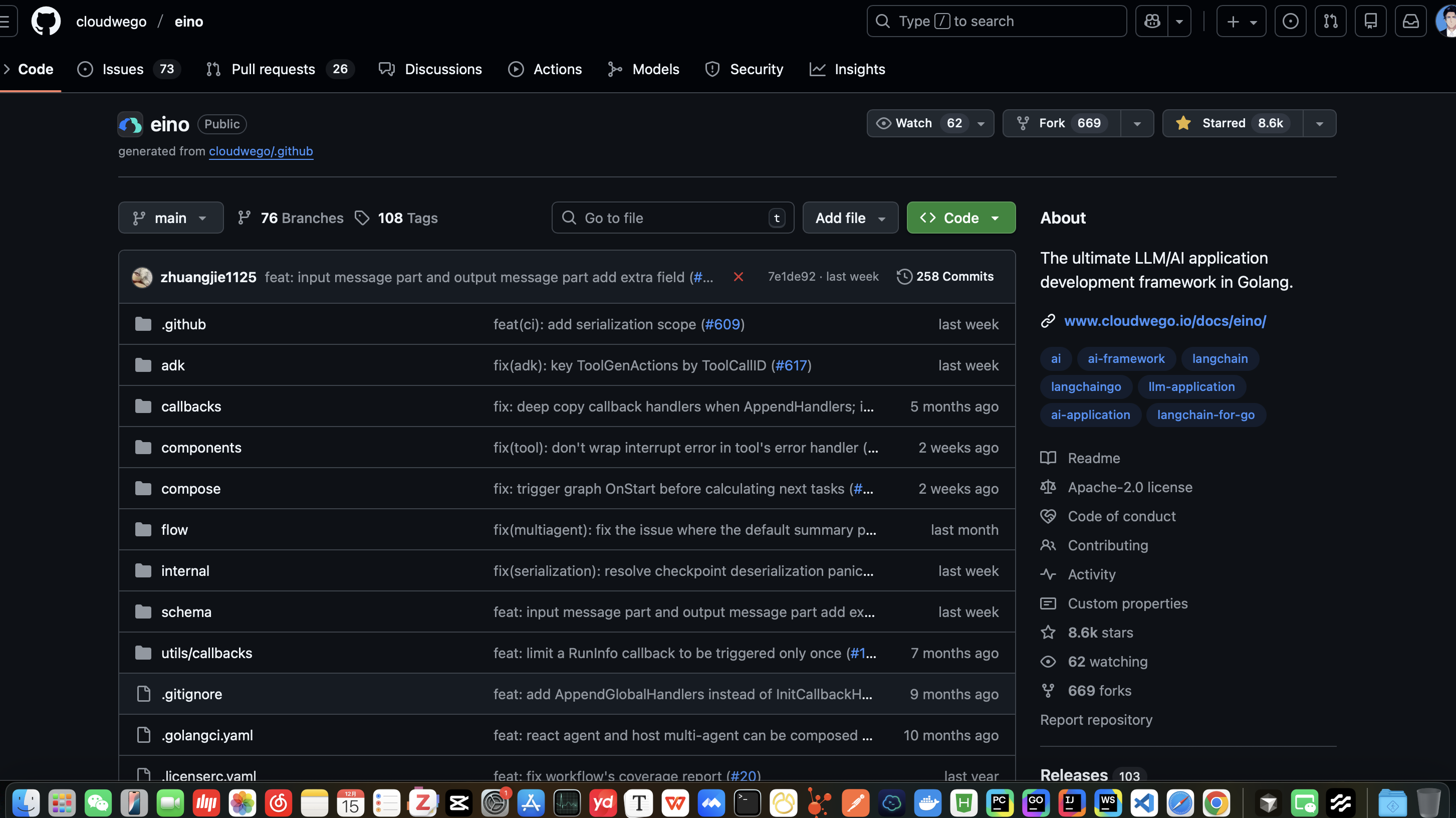

Eino采用"官方主导+社区共建"的生态模式,依托字节跳动技术沉淀与CloudWeGo社区资源,生态成熟度持续提升:

1. 生态核心数据

| 生态指标 | 具体情况 |

|---|---|

| 版本迭代 | 持续高频更新,最新稳定版v0.4.0,支持默认Eager执行 |

| 贡献者与维护 | CloudWeGo团队核心维护,社区贡献者持续增长 |

| 企业用户 | 字节跳动内部(抖音、豆包、扣子)数百个服务接入 |

| 扩展生态 | eino-ext扩展包提供OAuth安全网关、SLA监控等企业级工具 |

| 学术合作 | 与清华CoAI实验室共建智能体行为树等前沿模块 |

| 学习资源 | 中文官方文档、GitHub示例库、可视化Playground |

| 问题响应 | GitHub仓库活跃,Issues响应及时,版本兼容策略清晰 |

2. 生态优势

- 内外统一代码库,字节跳动核心业务实践反哺社区版本

- 完善的中文文档体系,从快速入门到高级特性全覆盖

- 丰富的开源示例,包含单Agent、多Agent、流式处理等典型场景

- 可视化调试工具支持,降低复杂编排流程的调试难度

- 支持编辑器插件与源码双向转换,兼顾可视化与代码级开发

五、Eino适用场景与选型建议

1. 推荐使用场景

- 中大型生产级LLM应用(需高并发、高稳定性支持)

- 复杂业务逻辑的AI智能体开发(多步骤决策、多Agent协作)

- 实时响应要求高的场景(实时对话、流式数据分析)

- 团队技术栈为Go语言,追求工程化与可维护性的项目

- 从Python框架迁移,需要提升性能与稳定性的LLM应用

2. 谨慎选择场景

- 非技术人员快速搭建原型(建议选择Dify等低代码平台)

- 纯知识库问答场景(建议选择LlamaIndex专项框架)

- 追求极致轻量化的简单API服务(框架本身有一定生态重量)

- 团队无Go语言基础,且短期内无技术栈迁移计划

总结

Eino作为首个Go语言工业化LLM开发框架,填补了传统Python框架在性能、并发安全与工程化方面的短板。其核心优势在于将Go语言的强类型、高并发特性与LLM应用的组件化、编排化需求深度融合,既解决了动态类型框架的维护难题,又提供了灵活的扩展能力。

对于追求生产级稳定性、高并发处理与长期可维护性的团队来说,Eino是LLM应用开发的优选框架。尤其适合需要从原型快速迭代到规模化部署的企业级项目,以及多场景、复杂逻辑的AI智能体开发。随着社区生态的持续完善,Eino有望成为AI时代的"Spring框架",引领LLM应用开发进入工业化时代。