引言:人工智能时代的核心驱动力

在人工智能与机器学习飞速发展的今天,深度学习框架已成为技术落地的核心基础设施。TensorFlow 作为谷歌开源的深度学习框架,自 2015 年首次发布以来,凭借其强大的功能、灵活的架构和庞大的社区支持,迅速成为全球开发者、研究员和企业首选的深度学习工具之一。从图像识别、自然语言处理到自动驾驶、医疗诊断,TensorFlow 在各行各业的智能化转型中扮演着关键角色。本文将从框架本质、核心特性、安装配置、基础操作、实战案例、进阶优化等多个维度,结合完整代码示例,全方位解析 TensorFlow 的技术细节与应用场景,帮助读者从入门到精通,真正掌握这一强大的 AI 工具。

一、TensorFlow 框架概述

1.1 什么是 TensorFlow?

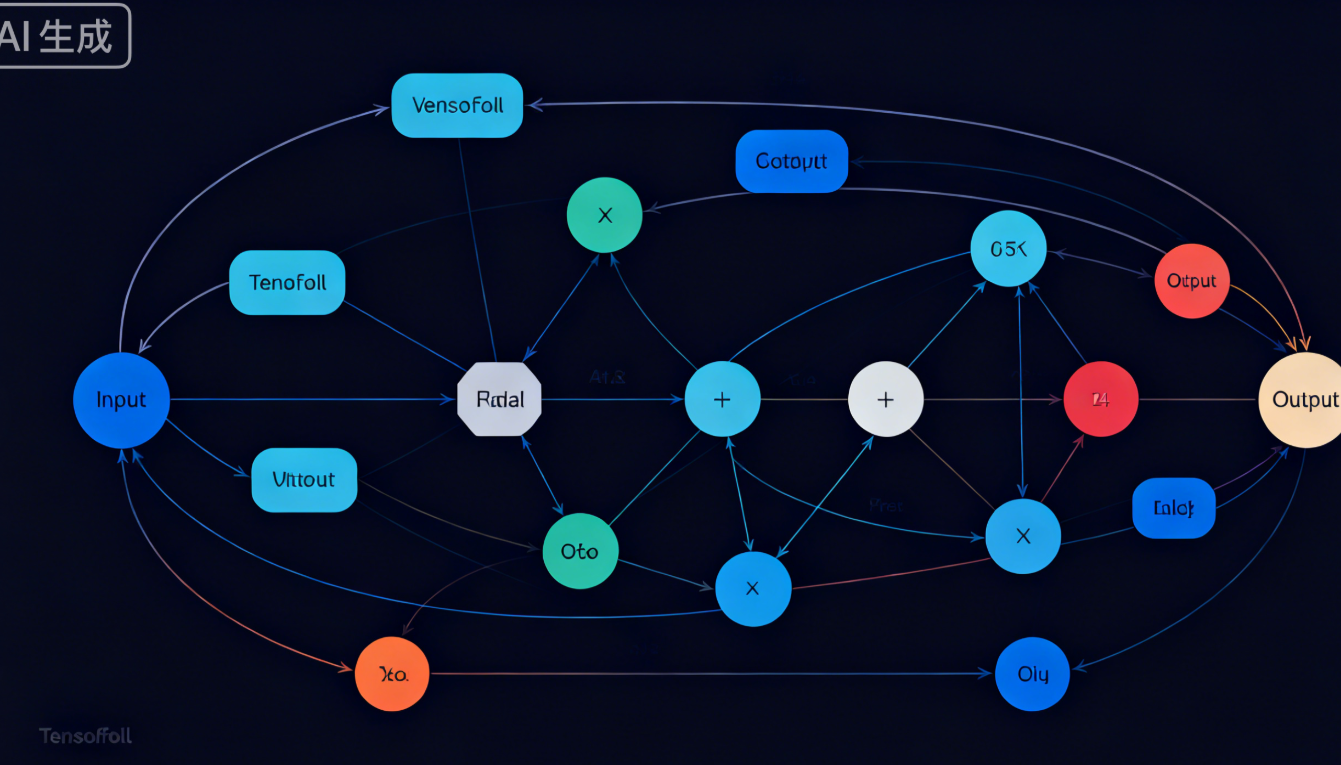

TensorFlow(简称 TF)是一个基于数据流图(Data Flow Graph)的开源机器学习框架,由谷歌大脑团队(Google Brain)开发并维护。其名称由 "Tensor"(张量)和 "Flow"(流)组成,形象地描述了框架的核心思想:数据以张量的形式在计算图中流动,完成模型的训练与推理。

- 张量(Tensor):TensorFlow 中最基本的数据结构,可理解为多维数组。例如,标量(0 维张量)、向量(1 维张量)、矩阵(2 维张量)、三维及以上数组(高维张量)。张量是模型输入、输出和参数的载体,所有计算操作都围绕张量展开。

- 计算图(Computational Graph):由节点(Node)和边(Edge)组成的有向图。节点代表具体的计算操作(如加法、乘法、卷积等),边代表张量的传递路径。TensorFlow 的计算过程本质上是在计算图中执行张量的流动与变换。

1.2 TensorFlow 的发展历程

- 2015 年 11 月:TensorFlow 0.1 版本正式开源,支持 Python API,引发行业广泛关注。

- 2017 年 2 月:TensorFlow 1.0 版本发布,引入静态计算图机制,优化了性能和稳定性,成为生产环境的主流选择。

- 2019 年 10 月:TensorFlow 2.0 版本重磅推出,采用动态计算图(Eager Execution)作为默认模式,简化了 API 设计,降低了入门门槛,同时兼容 1.x 版本代码。

- 2021 年:TensorFlow 2.6、2.7 等版本持续迭代,增强了对分布式训练、边缘设备部署的支持,整合了 TensorFlow Lite(移动端部署)、TensorFlow.js(浏览器端部署)等生态工具。

- 至今:TensorFlow 仍保持高频更新,不断适配新的硬件架构(如 GPU、TPU)和算法模型(如 Transformer、扩散模型),生态系统日趋完善。

1.3 TensorFlow 的核心优势

- 强大的生态系统:TensorFlow 拥有丰富的配套工具,如 TensorBoard(可视化工具)、TensorFlow Hub(预训练模型库)、TensorFlow Serving(模型部署工具)等,覆盖从模型开发、训练、调试到部署的全流程。

- 多平台兼容性:支持在 Windows、Linux、macOS 等操作系统运行,可部署于 CPU、GPU、TPU 等硬件设备,同时兼容移动端(Android、iOS)、浏览器、边缘设备(如树莓派)等多种场景。

- 灵活的编程模型:TensorFlow 2.x 默认启用动态计算图,允许开发者像编写普通 Python 代码一样调试模型,同时支持静态计算图模式,满足高性能生产环境需求。

- 丰富的算法支持:内置大量经典机器学习算法(如线性回归、决策树)和深度学习模型(如 CNN、RNN、Transformer),支持自定义网络结构,适配图像、文本、语音等多类型数据。

- 大规模分布式训练:提供完善的分布式训练 API,支持数据并行、模型并行等多种分布式策略,可利用多 GPU、多节点集群加速训练过程,处理海量数据。

- 活跃的社区支持:全球数百万开发者参与社区贡献,官方文档详细全面,Stack Overflow、GitHub 等平台有大量问题解答和开源项目,学习资源丰富。

二、TensorFlow 环境安装与配置

2.1 环境准备

TensorFlow 支持 Python 3.7-3.11 版本(不同 TF 版本对 Python 的兼容性略有差异,建议参考官方文档)。在安装 TensorFlow 前,需确保已安装 Python 环境和包管理工具 pip。

2.1.1 检查 Python 环境

打开终端(Windows 为命令提示符或 PowerShell,Linux/macOS 为终端),输入以下命令检查 Python 版本:

python --version # 或 python3 --version(部分系统)若未安装 Python,可从Python 官网下载对应版本并安装(建议勾选 "Add Python to PATH")。

2.1.2 升级 pip 工具

为确保安装顺利,建议升级 pip 至最新版本:

pip install --upgrade pip # 或 pip3 install --upgrade pip2.2 安装 TensorFlow

TensorFlow 提供 CPU 版本和 GPU 版本,其中 GPU 版本需依赖 NVIDIA 显卡和 CUDA、cuDNN 环境,训练速度远快于 CPU 版本。以下分别介绍两种版本的安装方法。

2.2.1 CPU 版本安装

适合无 NVIDIA 显卡或仅需简单测试的场景,安装命令如下:

pip install tensorflow # 安装最新稳定版

# 若需指定版本(如2.10.0),则:

# pip install tensorflow==2.10.02.2.2 GPU 版本安装

适合大规模模型训练,需先配置 CUDA 和 cuDNN 环境,步骤如下:

-

安装 TensorFlow GPU 版本:

pip install tensorflow-gpu # TF 2.0+版本已将CPU和GPU版本合并,上述命令等价于安装支持GPU的TF

若需指定版本:

pip install tensorflow-gpu==2.10.0

2.2.3 验证安装成功

安装完成后,在 Python 交互式环境中输入以下代码,验证 TensorFlow 是否正常运行:

import tensorflow as tf

# 查看TensorFlow版本

print("TensorFlow版本:", tf.__version__)

# 检查GPU是否可用(GPU版本)

print("GPU是否可用:", tf.config.list_physical_devices('GPU'))

# 执行简单计算

a = tf.constant(10)

b = tf.constant(20)

c = a + b

print("10 + 20 =", c.numpy())若输出 TensorFlow 版本、GPU 状态(GPU 版本)和计算结果,说明安装成功。

2.3 集成开发环境(IDE)推荐

为提升开发效率,推荐使用以下 IDE:

- PyCharm:功能强大的 Python IDE,支持 TensorFlow 代码自动补全、调试、项目管理,社区版免费可用。

- Jupyter Notebook/JupyterLab:交互式编程环境,适合编写和运行代码片段、可视化结果,广泛用于机器学习实验。安装命令:pip install jupyterlab,启动命令:jupyter lab。

- VS Code:轻量级编辑器,安装 Python 插件后可支持 TensorFlow 开发,支持代码高亮、调试、终端集成。

三、TensorFlow 核心概念与基础操作

3.1 张量(Tensor)详解

张量是 TensorFlow 中数据的基本载体,所有输入数据、模型参数、中间结果和输出结果都以张量形式存在。

3.1.1 张量的维度与形状

- 维度(Rank):张量的维数,如标量(0 维)、向量(1 维)、矩阵(2 维)、3 维张量(如彩色图像:高度 × 宽度 × 通道数)等。

- 形状(Shape):张量各维度的大小,用元组表示,如向量[1,2,3]的形状为(3,),矩阵[[1,2],[3,4]]的形状为(2,2)。

- 数据类型(Dtype):张量中元素的数据类型,如tf.float32(32 位浮点数)、tf.float64(64 位浮点数)、tf.int32(32 位整数)、tf.bool(布尔值)等。

3.1.2 张量的创建

TensorFlow 提供多种创建张量的方法,以下是常用函数:

-

创建常量张量(tf.constant):创建值不可变的张量。

import tensorflow as tf

0维张量(标量)

tensor_0d = tf.constant(5, dtype=tf.int32)

print("0维张量:", tensor_0d)

print("形状:", tensor_0d.shape)

print("数据类型:", tensor_0d.dtype)

1维张量(向量)

tensor_1d = tf.constant([1, 2, 3, 4, 5], dtype=tf.float32)

print("\n1维张量:", tensor_1d)

print("形状:", tensor_1d.shape)

2维张量(矩阵)

tensor_2d = tf.constant([[1, 2], [3, 4], [5, 6]], dtype=tf.int64)

print("\n2维张量:", tensor_2d)

print("形状:", tensor_2d.shape)

3维张量

tensor_3d = tf.constant([[[1, 2], [3, 4]], [[5, 6], [7, 8]]])

print("\n3维张量:", tensor_3d)

print("形状:", tensor_3d.shape) # 输出(2, 2, 2),表示2个2×2的矩阵

-

创建特殊张量:

创建全0张量(tf.zeros)

zeros_tensor = tf.zeros(shape=(3, 4), dtype=tf.float32)

print("全0张量:\n", zeros_tensor)

创建全1张量(tf.ones)

ones_tensor = tf.ones(shape=(2, 3), dtype=tf.int32)

print("\n全1张量:\n", ones_tensor)

创建指定值的张量(tf.fill)

fill_tensor = tf.fill(dims=(2, 2), value=10)

print("\n全为10的张量:\n", fill_tensor)

创建随机张量(tf.random.normal:正态分布,tf.random.uniform:均匀分布)

normal_tensor = tf.random.normal(shape=(3, 3), mean=0, stddev=1) # 均值0,标准差1的正态分布

uniform_tensor = tf.random.uniform(shape=(2, 4), minval=0, maxval=10, dtype=tf.int32) # 0-10的均匀分布

print("\n正态分布随机张量:\n", normal_tensor)

print("\n均匀分布随机张量:\n", uniform_tensor)

创建序列张量(tf.range)

range_tensor = tf.range(start=0, limit=10, delta=2) # 从0到10(不包含10),步长2

print("\n序列张量:", range_tensor)

3.1.3 张量的常用操作

张量形状变换:

# 查看形状(shape属性)

tensor = tf.constant([[1, 2, 3], [4, 5, 6]])

print("原张量:\n", tensor)

print("原形状:", tensor.shape)

# 改变形状(tf.reshape):需保证总元素个数不变

reshaped_tensor = tf.reshape(tensor, shape=(3, 2))

print("\nreshape为(3,2):\n", reshaped_tensor)

# 展平张量(reshape为1维)

flattened_tensor = tf.reshape(tensor, shape=(-1,)) # -1表示自动计算该维度大小

print("\n展平后的张量:", flattened_tensor)

# 转置张量(tf.transpose)

transposed_tensor = tf.transpose(tensor)

print("\n转置后的张量:\n", transposed_tensor)

张量的数据类型转换:

tensor_int = tf.constant([1, 2, 3], dtype=tf.int32)

print("原张量(int32):", tensor_int)

# 转换为float32

tensor_float = tf.cast(tensor_int, dtype=tf.float32)

print("转换为float32:", tensor_float)

# 转换为bool

tensor_bool = tf.cast(tensor_int, dtype=tf.bool) # 非0值为True,0为False

print("转换为bool:", tensor_bool)

张量的索引与切片:

tensor = tf.constant([[1, 2, 3, 4], [5, 6, 7, 8], [9, 10, 11, 12]])

print("原张量:\n", tensor)

# 索引:获取单个元素(行索引,列索引)

element = tensor[1, 2] # 获取第2行第3列元素(索引从0开始)

print("\n索引(1,2)对应的元素:", element.numpy())

# 切片:获取子张量

# 格式:tensor[start:end:step, start:end:step, ...](左闭右开)

slice1 = tensor[0:2, :] # 获取前2行所有列

print("\n前2行所有列:\n", slice1)

slice2 = tensor[:, 1:3] # 获取所有行的第2-3列

print("\n所有行的第2-3列:\n", slice2)

slice3 = tensor[1:, 2:] # 获取第2行及以后,第3列及以后

print("\n第2行及以后,第3列及以后:\n", slice3)

slice4 = tensor[::2, ::2] # 步长为2,获取奇数行和奇数列

print("\n步长为2的切片:\n", slice4)

张量的数学运算:

a = tf.constant([[1, 2], [3, 4]], dtype=tf.float32)

b = tf.constant([[5, 6], [7, 8]], dtype=tf.float32)

# 元素级加法(tf.add)

add = tf.add(a, b) # 等价于 a + b

print("元素级加法:\n", add)

# 元素级乘法(tf.multiply)

multiply = tf.multiply(a, b) # 等价于 a * b

print("\n元素级乘法:\n", multiply)

# 矩阵乘法(tf.matmul)

matmul = tf.matmul(a, b) # 等价于 a @ b

print("\n矩阵乘法:\n", matmul)

# 平方(tf.square)

square = tf.square(a)

print("\n平方:\n", square)

# 求和(tf.reduce_sum):默认对所有元素求和

sum_all = tf.reduce_sum(a)

print("\n所有元素求和:", sum_all)

# 按行求和(axis=0为按列,axis=1为按行)

sum_rows = tf.reduce_sum(a, axis=1)

print("\n按行求和:", sum_rows)

# 均值(tf.reduce_mean)

mean = tf.reduce_mean(a)

print("\n所有元素均值:", mean)

张量与 NumPy 数组的转换:

TensorFlow 张量与 NumPy 数组可相互转换,方便与其他 Python 库(如 NumPy、Matplotlib)协同使用。

import numpy as np

# 张量转换为NumPy数组(numpy()方法)

tensor = tf.constant([1, 2, 3, 4])

numpy_arr = tensor.numpy()

print("张量转换为NumPy数组:", numpy_arr, type(numpy_arr))

# NumPy数组转换为张量(tf.convert_to_tensor)

numpy_arr2 = np.array([[5, 6], [7, 8]])

tensor2 = tf.convert_to_tensor(numpy_arr2)

print("\nNumPy数组转换为张量:\n", tensor2, type(tensor2))3.2 计算图(Computational Graph)

计算图是 TensorFlow 的核心执行模型,由节点(操作)和边(张量)组成。在 TensorFlow 1.x 中,计算图是静态的,需先定义图结构,再通过会话(Session)执行;而 TensorFlow 2.x 默认启用动态计算图(Eager Execution),计算操作立即执行,无需手动定义会话,更符合 Python 的编程习惯。

3.2.1 动态计算图(Eager Execution)

动态计算图是 TensorFlow 2.x 的默认模式,支持即时执行、即时反馈,便于调试。

import tensorflow as tf

# 动态计算图模式(默认启用)

a = tf.constant(2)

b = tf.constant(3)

c = a + b # 立即执行计算

print("动态计算图结果:", c.numpy())

# 调试时可直接打印中间结果

d = tf.multiply(c, 4)

print("中间结果d:", d.numpy())3.2.2 静态计算图(Graph Execution)

静态计算图需先定义所有操作和张量,再通过tf.function装饰器将函数转换为计算图,适合生产环境,可优化性能(如操作融合、内存优化)。

import tensorflow as tf

# 定义静态计算图函数(@tf.function装饰器)

@tf.function

def static_graph(a, b):

c = a + b

d = tf.multiply(c, 4)

return d

# 执行静态计算图

a = tf.constant(2)

b = tf.constant(3)

result = static_graph(a, b)

print("静态计算图结果:", result.numpy())

# 查看计算图结构(需结合TensorBoard)

# 注:@tf.function装饰的函数会被TensorFlow自动优化为计算图3.3 自动微分(AutoGrad)

深度学习模型的训练核心是通过反向传播算法计算损失函数对模型参数的梯度,进而更新参数。TensorFlow 的tf.GradientTape API 提供自动微分功能,无需手动推导梯度公式,极大简化了模型训练过程。

3.3.1 基本用法

import tensorflow as tf

# 定义自变量(需设置trainable=True,默认True)

x = tf.Variable(3.0, dtype=tf.float32)

# 定义函数y = x²

def compute_y(x):

return x ** 2

# 使用tf.GradientTape记录计算过程

with tf.GradientTape() as tape:

y = compute_y(x)

# 计算y对x的梯度(dy/dx = 2x)

dy_dx = tape.gradient(y, x)

print("y = x² 在x=3处的梯度:", dy_dx.numpy()) # 输出6.0

3.3.2 多变量梯度计算

import tensorflow as tf

# 定义多个自变量

x = tf.Variable(2.0, dtype=tf.float32)

y = tf.Variable(3.0, dtype=tf.float32)

# 定义函数z = x² + 2xy + y²

with tf.GradientTape() as tape:

z = x ** 2 + 2 * x * y + y ** 2

# 计算z对x和y的梯度(dz/dx=2x+2y,dz/dy=2x+2y)

dz_dx, dz_dy = tape.gradient(z, [x, y])

print("dz/dx =", dz_dx.numpy()) # 输出2*2+2*3=10.0

print("dz/dy =", dz_dy.numpy()) # 输出2*2+2*3=10.0

3.3.3 持久化梯度带(persistent=True)

默认情况下,tf.GradientTape只能计算一次梯度,若需多次计算梯度,需设置persistent=True,并在使用后手动删除梯度带。

import tensorflow as tf

x = tf.Variable(4.0, dtype=tf.float32)

with tf.GradientTape(persistent=True) as tape:

y = x ** 2

z = y ** 2 # z = (x²)² = x⁴

# 计算y对x的梯度(dy/dx=2x)

dy_dx = tape.gradient(y, x)

print("dy/dx =", dy_dx.numpy()) # 输出8.0

# 计算z对x的梯度(dz/dx=4x³)

dz_dx = tape.gradient(z, x)

print("dz/dx =", dz_dx.numpy()) # 输出4*(4³)=256.0

# 删除梯度带,释放资源

del tape3.4 变量(Variable)

模型的参数(如权重、偏置)需要在训练过程中不断更新,因此不能使用常量张量(tf.constant),而需使用变量(tf.Variable)。变量是一种特殊的张量,支持赋值更新,默认可训练(trainable=True)。

3.4.1 变量的创建与初始化

import tensorflow as tf

# 创建变量(初始值为全0)

w = tf.Variable(tf.zeros(shape=(3, 4), dtype=tf.float32), name="weight")

b = tf.Variable(tf.ones(shape=(4,), dtype=tf.float32), name="bias")

print("权重变量w:\n", w)

print("偏置变量b:\n", b)

print("w的名称:", w.name)

print("w是否可训练:", w.trainable)3.4.2 变量的更新

变量的更新需通过assign方法或赋值运算符(=),但在训练过程中,通常通过优化器自动更新变量。

import tensorflow as tf

w = tf.Variable(tf.constant([1.0, 2.0]))

# 方法1:assign方法更新

w.assign([3.0, 4.0])

print("assign更新后:", w.numpy())

# 方法2:assign_add(增量更新)

w.assign_add([1.0, 1.0])

print("assign_add更新后:", w.numpy())

# 方法3:assign_sub(减量更新)

w.assign_sub([0.5, 0.5])

print("assign_sub更新后:", w.numpy())

# 方法4:直接赋值(TF 2.x支持)

w = tf.Variable([5.0, 6.0])

print("直接赋值后:", w.numpy())四、TensorFlow 常用 API 与模型构建

4.1 Keras API 概述

Keras 是一个高层神经网络 API,简洁易用,支持快速构建和训练深度学习模型。TensorFlow 2.x 将 Keras 作为官方高层 API(tf.keras),与 TensorFlow 底层功能深度集成,既保留了 Keras 的简洁性,又具备 TensorFlow 的高性能和灵活性。

tf.keras的核心优势:

- 模块化设计:模型由层(Layer)组成,支持自定义层和模型。

- 丰富的预定义层:内置全连接层、卷积层、池化层、循环层等多种层类型。

- 便捷的模型训练:提供model.fit()方法,封装了训练循环、梯度计算、参数更新等流程。

- 支持模型保存与加载:可保存模型结构、权重、优化器状态,方便后续部署和继续训练。

4.2 Sequential 模型(序贯模型)

Sequential模型是tf.keras中最简单的模型类型,适用于线性堆叠的网络结构(即每层只有一个输入和一个输出,层与层之间依次连接)。

4.2.1 构建 Sequential 模型

以简单的全连接神经网络为例,构建用于二分类任务的模型:

import tensorflow as tf

from tensorflow.keras import Sequential

from tensorflow.keras.layers import Dense, Dropout

# 构建Sequential模型

model = Sequential([

# 输入层:指定输入维度(input_shape),无需指定批量大小

Dense(units=64, activation='relu', input_shape=(10,), name="input_layer"),

# 隐藏层1:64个神经元,ReLU激活函数

Dense(units=64, activation='relu', name="hidden_layer1"),

# Dropout层:防止过拟合,随机丢弃50%的神经元

Dropout(rate=0.5, name="dropout_layer"),

# 隐藏层2:32个神经元,ReLU激活函数

Dense(units=32, activation='relu', name="hidden_layer2"),

# 输出层:2个神经元(二分类),sigmoid激活函数(输出概率)

Dense(units=2, activation='sigmoid', name="output_layer")

])

# 查看模型结构

model.summary()4.2.2 模型编译(compile)

在训练模型前,需通过model.compile()方法配置训练参数,包括优化器、损失函数、评估指标:

# 编译模型

model.compile(

optimizer=tf.keras.optimizers.Adam(learning_rate=0.001), # 优化器:Adam,学习率0.001

loss=tf.keras.losses.SparseCategoricalCrossentropy(), # 损失函数:稀疏分类交叉熵(适用于整数标签)

metrics=['accuracy'] # 评估指标:准确率

)常用优化器:

- Adam:自适应学习率优化器,收敛速度快,应用广泛。

- SGD:随机梯度下降优化器,基础优化器,可配合动量(momentum)使用。

- RMSprop:基于梯度平方的自适应学习率优化器。

常用损失函数:

- 分类任务:SparseCategoricalCrossentropy(稀疏标签,整数形式)、CategoricalCrossentropy(独热编码标签)、BinaryCrossentropy(二分类)。

- 回归任务:MeanSquaredError(均方误差)、MeanAbsoluteError(平均绝对误差)。

常用评估指标:

- 分类任务:accuracy(准确率)、precision(精确率)、recall(召回率)、f1_score(F1 分数)。

- 回归任务:mse(均方误差)、mae(平均绝对误差)、r2(R² 分数)。

4.2.3 模型训练(fit)

使用model.fit()方法训练模型,需传入训练数据、标签、批次大小(batch_size)、训练轮数(epochs)等参数:

import numpy as np

# 生成模拟训练数据(特征维度10,样本数1000)

x_train = np.random.randn(1000, 10).astype(np.float32)

# 生成模拟标签(二分类,0或1)

y_train = np.random.randint(0, 2, size=(1000,)).astype(np.int32)

# 生成模拟验证数据(用于监控训练过程,避免过拟合)

x_val = np.random.randn(200, 10).astype(np.float32)

y_val = np.random.randint(0, 2, size=(200,)).astype(np.int32)

# 训练模型

history = model.fit(

x=x_train, # 训练特征

y=y_train, # 训练标签

batch_size=32, # 批次大小:每次训练使用32个样本

epochs=10, # 训练轮数:遍历整个训练集10次

validation_data=(x_val, y_val), # 验证数据

verbose=1 # 训练过程输出模式:1为显示进度条

)

model.fit()返回的history对象包含训练过程中的损失值和评估指标,可用于可视化训练曲线:

import matplotlib.pyplot as plt

# 提取训练历史数据

train_loss = history.history['loss']

val_loss = history.history['val_loss']

train_acc = history.history['accuracy']

val_acc = history.history['val_accuracy']

epochs = range(1, len(train_loss) + 1)

# 绘制损失曲线

plt.figure(figsize=(12, 4))

plt.subplot(1, 2, 1)

plt.plot(epochs, train_loss, 'b-', label='训练损失')

plt.plot(epochs, val_loss, 'r-', label='验证损失')

plt.title('训练损失与验证损失')

plt.xlabel('轮数(Epochs)')

plt.ylabel('损失值(Loss)')

plt.legend()

# 绘制准确率曲线

plt.subplot(1, 2, 2)

plt.plot(epochs, train_acc, 'b-', label='训练准确率')

plt.plot(epochs, val_acc, 'r-', label='验证准确率')

plt.title('训练准确率与验证准确率')

plt.xlabel('轮数(Epochs)')

plt.ylabel('准确率(Accuracy)')

plt.legend()

plt.tight_layout()

plt.show()4.2.4 模型预测(predict)

训练完成后,使用model.predict()方法对新数据进行预测:

# 生成模拟测试数据

x_test = np.random.randn(5, 10).astype(np.float32)

# 预测概率

y_pred_prob = model.predict(x_test, verbose=0)

print("预测概率:\n", y_pred_prob)

# 转换为预测标签(取概率最大的类别)

y_pred = np.argmax(y_pred_prob, axis=1)

print("预测标签:", y_pred)4.3 Functional API(函数式 API)

Sequential模型仅适用于线性网络结构,而Functional API支持构建更复杂的网络结构,如多输入、多输出、残差连接、共享层等,是tf.keras中最灵活的模型构建方式。

4.3.1 构建多输入单输出模型

以 "用户点击率预测" 为例,假设输入特征包括用户特征(10 维)和物品特征(8 维),输出为点击概率(二分类):

import tensorflow as tf

from tensorflow.keras.layers import Input, Dense, Concatenate, Dropout

from tensorflow.keras.models import Model

# 定义输入层

user_input = Input(shape=(10,), name="user_input") # 用户特征输入(10维)

item_input = Input(shape=(8,), name="item_input") # 物品特征输入(8维)

# 处理用户特征的子网络

user_x = Dense(64, activation='relu')(user_input)

user_x = Dropout(0.5)(user_x)

user_x = Dense(32, activation='relu')(user_x)

# 处理物品特征的子网络

item_x = Dense(64, activation='relu')(item_input)

item_x = Dropout(0.5)(item_x)

item_x = Dense(32, activation='relu')(item_x)

# 拼接用户特征和物品特征

concat_x = Concatenate(axis=1)([user_x, item_x])

# 输出层

output = Dense(1, activation='sigmoid', name="output")(concat_x)

# 构建模型(指定输入和输出)

model = Model(inputs=[user_input, item_input], outputs=output)

# 查看模型结构

model.summary()

4.3.2 模型编译与训练

# 编译模型

model.compile(

optimizer=tf.keras.optimizers.Adam(learning_rate=0.001),

loss=tf.keras.losses.BinaryCrossentropy(),

metrics=['accuracy']

)

# 生成模拟数据

user_train = np.random.randn(1000, 10).astype(np.float32) # 用户训练数据

item_train = np.random.randn(1000, 8).astype(np.float32) # 物品训练数据

y_train = np.random.randint(0, 2, size=(1000,)).astype(np.float32) # 训练标签(0或1)

user_val = np.random.randn(200, 10).astype(np.float32) # 用户验证数据

item_val = np.random.randn(200, 8).astype(np.float32) # 物品验证数据

y_val = np.random.randint(0, 2, size=(200,)).astype(np.float32) # 验证标签

# 训练模型(输入为列表形式)

history = model.fit(

x=[user_train, item_train],

y=y_train,

batch_size=32,

epochs=10,

validation_data=([user_val, item_val], y_val),

verbose=1

)

4.3.3 模型预测

# 生成模拟测试数据

user_test = np.random.randn(5, 10).astype(np.float32)

item_test = np.random.randn(5, 8).astype(np.float32)

# 预测点击概率

y_pred_prob = model.predict([user_test, item_test], verbose=0)

print("点击概率预测:\n", y_pred_prob)

# 转换为预测标签(阈值0.5)

y_pred = (y_pred_prob > 0.5).astype(np.int32)

print("点击预测标签:", y_pred.flatten())

4.4 自定义层与模型

tf.keras支持自定义层(Layer)和自定义模型(Model),满足特殊的网络结构需求。

4.4.1 自定义层(Custom Layer)

以自定义一个带权重和偏置的全连接层为例:

import tensorflow as tf

from tensorflow.keras.layers import Layer

class CustomDense(Layer):

def __init__(self, units=32, activation=None, **kwargs):

super(CustomDense, self).__init__(**kwargs)

self.units = units # 神经元个数

self.activation = tf.keras.activations.get(activation) # 激活函数

# 构建层的权重(在第一次调用时执行)

def build(self, input_shape):

# 权重:输入维度 × 神经元个数

self.kernel = self.add_weight(

name='kernel',

shape=(input_shape[-1], self.units),

initializer='glorot_uniform', # 初始化方式

trainable=True # 可训练

)

# 偏置:神经元个数 × 1

self.bias = self.add_weight(

name='bias',

shape=(self.units,),

initializer='zeros',

trainable=True

)

super(CustomDense, self).build(input_shape)

# 前向传播(核心方法)

def call(self, inputs):

# 计算:inputs @ kernel + bias

outputs = tf.matmul(inputs, self.kernel) + self.bias

# 应用激活函数

if self.activation is not None:

outputs = self.activation(outputs)

return outputs

# 序列化层(可选,用于模型保存与加载)

def get_config(self):

config = super(CustomDense, self).get_config()

config.update({

'units': self.units,

'activation': tf.keras.activations.serialize(self.activation)

})

return config

使用自定义层构建模型:

from tensorflow.keras.models import Sequential

model = Sequential([

CustomDense(units=64, activation='relu', input_shape=(10,)),

CustomDense(units=32, activation='relu'),

CustomDense(units=1, activation='sigmoid')

])

model.compile(

optimizer='adam',

loss='binary_crossentropy',

metrics=['accuracy']

)

model.summary()

4.4.2 自定义模型(Custom Model)

通过继承tf.keras.Model类,可自定义更复杂的模型结构,灵活控制训练过程:

import tensorflow as tf

from tensorflow.keras.models import Model

from tensorflow.keras.layers import Dense, Dropout

class CustomModel(Model):

def __init__(self, units1=64, units2=32, **kwargs):

super(CustomModel, self).__init__(**kwargs)

# 定义层

self.dense1 = Dense(units1, activation='relu')

self.dropout = Dropout(0.5)

self.dense2 = Dense(units2, activation='relu')

self.dense3 = Dense(1, activation='sigmoid')

# 前向传播

def call(self, inputs, training=False):

x = self.dense1(inputs)

x = self.dropout(x, training=training) # training=True时启用Dropout

x = self.dense2(x)

outputs = self.dense3(x)

return outputs

# 自定义训练步骤(可选,默认使用model.fit())

def train_step(self, data):

x, y = data

# 记录计算过程,用于自动微分

with tf.GradientTape() as tape:

y_pred = self(x, training=True) # 前向传播

loss = self.compiled_loss(y, y_pred) # 计算损失

# 计算梯度

trainable_vars = self.trainable_variables

gradients = tape.gradient(loss, trainable_vars)

# 更新参数

self.optimizer.apply_gradients(zip(gradients, trainable_vars))

# 更新评估指标

self.compiled_metrics.update_state(y, y_pred)

# 返回损失和指标

return {m.name: m.result() for m in self.metrics}

使用自定义模型训练:

# 构建模型

model = CustomModel(units1=64, units2=32)

# 编译模型

model.compile(

optimizer=tf.keras.optimizers.Adam(learning_rate=0.001),

loss=tf.keras.losses.BinaryCrossentropy(),

metrics=['accuracy']

)

# 生成模拟数据

x_train = np.random.randn(1000, 10).astype(np.float32)

y_train = np.random.randint(0, 2, size=(1000,)).astype(np.float32)

# 训练模型

model.fit(x_train, y_train, batch_size=32, epochs=10, verbose=1)五、TensorFlow 实战案例:图像分类(CNN)

5.1 案例背景

图像分类是深度学习的经典应用场景,卷积神经网络(CNN)是处理图像数据的核心模型。本案例将使用 TensorFlow 构建 CNN 模型,对 CIFAR-10 数据集进行分类。CIFAR-10 数据集包含 10 个类别(飞机、汽车、鸟类、猫、鹿、狗、青蛙、马、船、卡车)的 60000 张 32×32 彩色图像,其中训练集 50000 张,测试集 10000 张。

5.2 数据准备

TensorFlow 内置了 CIFAR-10 数据集,可通过tf.keras.datasets直接加载:

import tensorflow as tf

from tensorflow.keras.datasets import cifar10

from tensorflow.keras.utils import to_categorical

import matplotlib.pyplot as plt

import numpy as np

# 加载CIFAR-10数据集

(x_train, y_train), (x_test, y_test) = cifar10.load_data()

# 查看数据形状

print("训练集图像形状:", x_train.shape) # (50000, 32, 32, 3):50000张32×32×3的彩色图像

print("训练集标签形状:", y_train.shape) # (50000, 1):50000个标签(整数形式)

print("测试集图像形状:", x_test.shape) # (10000, 32, 32, 3)

print("测试集标签形状:", y_test.shape) # (10000, 1)

# 定义类别名称

class_names = ['airplane', 'automobile', 'bird', 'cat', 'deer',

'dog', 'frog', 'horse', 'ship', 'truck']

# 可视化部分训练数据

plt.figure(figsize=(10, 10))

for i in range(25):

plt.subplot(5, 5, i+1)

plt.xticks([])

plt.yticks([])

plt.grid(False)

plt.imshow(x_train[i], cmap=plt.cm.binary)

# 显示标签

plt.xlabel(class_names[y_train[i][0]])

plt.show()

# 数据预处理

# 1. 归一化:将像素值从[0, 255]转换为[0, 1]

x_train = x_train.astype('float32') / 255.0

x_test = x_test.astype('float32') / 255.0

# 2. 标签独热编码(适应CategoricalCrossentropy损失函数)

y_train = to_categorical(y_train, num_classes=10)

y_test = to_categorical(y_test, num_classes=10)

# 查看预处理后的数据

print("\n预处理后训练集标签形状:", y_train.shape) # (50000, 10)

print("预处理后测试集标签形状:", y_test.shape) # (10000, 10)

5.3 构建 CNN 模型

使用tf.keras的 Functional API 构建 CNN 模型,结构如下:

卷积层(Conv2D):提取图像特征。

池化层(MaxPooling2D):降低特征图维度,减少参数数量,防止过拟合。

Dropout 层:随机丢弃部分神经元,防止过拟合。

全连接层(Dense):分类决策。

from tensorflow.keras.layers import Input, Conv2D, MaxPooling2D, Flatten, Dense, Dropout, BatchNormalization

from tensorflow.keras.models import Model

from tensorflow.keras.optimizers import Adam

from tensorflow.keras.losses import CategoricalCrossentropy

from tensorflow.keras.metrics import CategoricalAccuracy

# 定义输入层(32×32×3的彩色图像)

inputs = Input(shape=(32, 32, 3), name="image_input")

# 卷积块1

x = Conv2D(filters=32, kernel_size=(3, 3), padding='same', activation='relu')(inputs)

x = BatchNormalization()(x) # 批量归一化:加速训练,提升稳定性

x = MaxPooling2D(pool_size=(2, 2), strides=(2, 2))(x) # 池化:2×2池化核,步长2

x = Dropout(rate=0.25)(x) # Dropout:丢弃25%的神经元

# 卷积块2

x = Conv2D(filters=64, kernel_size=(3, 3), padding='same', activation='relu')(x)

x = BatchNormalization()(x)

x = MaxPooling2D(pool_size=(2, 2), strides=(2, 2))(x)

x = Dropout(rate=0.25)(x)

# 卷积块3

x = Conv2D(filters=128, kernel_size=(3, 3), padding='same', activation='relu')(x)

x = BatchNormalization()(x)

x = MaxPooling2D(pool_size=(2, 2), strides=(2, 2))(x)

x = Dropout(rate=0.25)(x)

# 展平特征图(从4维张量转换为2维张量)

x = Flatten()(x)

# 全连接层

x = Dense(units=512, activation='relu')(x)

x = BatchNormalization()(x)

x = Dropout(rate=0.5)(x)

# 输出层(10个类别,softmax激活函数:输出各类别概率之和为1)

outputs = Dense(units=10, activation='softmax', name="output")(outputs)

# 构建模型

model = Model(inputs=inputs, outputs=outputs)

# 查看模型结构

model.summary()

5.4 模型编译与训练

# 编译模型

model.compile(

optimizer=Adam(learning_rate=0.001), # 优化器:Adam

loss=CategoricalCrossentropy(), # 损失函数:分类交叉熵

metrics=[CategoricalAccuracy(name='accuracy')] # 评估指标:分类准确率

)

# 定义回调函数(可选,用于优化训练过程)

callbacks = [

# 早停法:当验证损失连续5轮不下降时,停止训练(防止过拟合)

tf.keras.callbacks.EarlyStopping(

monitor='val_loss',

patience=5,

restore_best_weights=True # 恢复验证损失最小的模型权重

),

# 学习率调度:每3轮学习率衰减为原来的0.9

tf.keras.callbacks.ReduceLROnPlateau(

monitor='val_loss',

factor=0.9,

patience=3,

min_lr=1e-6 # 最小学习率

),

# TensorBoard:可视化训练过程(运行命令:tensorboard --logdir=logs)

tf.keras.callbacks.TensorBoard(log_dir='logs/cifar10_cnn')

]

# 训练模型

history = model.fit(

x=x_train,

y=y_train,

batch_size=64,

epochs=50,

validation_split=0.1, # 从训练集中划分10%作为验证集

callbacks=callbacks,

verbose=1

)

5.5 模型评估与可视化

# 在测试集上评估模型

test_loss, test_acc = model.evaluate(x_test, y_test, verbose=0)

print(f"测试集准确率:{test_acc:.4f}")

print(f"测试集损失值:{test_loss:.4f}")

# 可视化训练曲线

plt.figure(figsize=(12, 4))

# 损失曲线

plt.subplot(1, 2, 1)

plt.plot(history.history['loss'], 'b-', label='训练损失')

plt.plot(history.history['val_loss'], 'r-', label='验证损失')

plt.title('训练损失与验证损失')

plt.xlabel('轮数(Epochs)')

plt.ylabel('损失值(Loss)')

plt.legend()

# 准确率曲线

plt.subplot(1, 2, 2)

plt.plot(history.history['accuracy'], 'b-', label='训练准确率')

plt.plot(history.history['val_accuracy'], 'r-', label='验证准确率')

plt.title('训练准确率与验证准确率')

plt.xlabel('轮数(Epochs)')

plt.ylabel('准确率(Accuracy)')

plt.legend()

plt.tight_layout()

plt.show()

# 模型预测

# 从测试集中随机选择5张图像进行预测

indices = np.random.choice(len(x_test), 5, replace=False)

x_pred = x_test[indices]

y_true = y_test[indices]

# 预测概率

y_pred_prob = model.predict(x_pred, verbose=0)

# 预测标签(取概率最大的类别)

y_pred = np.argmax(y_pred_prob, axis=1)

# 真实标签

y_true_label = np.argmax(y_true, axis=1)

# 可视化预测结果

plt.figure(figsize=(15, 3))

for i in range(5):

plt.subplot(1, 5, i+1)

plt.xticks([])

plt.yticks([])

plt.grid(False)

plt.imshow(x_pred[i], cmap=plt.cm.binary)

# 显示真实标签和预测标签

true_label = class_names[y_true_label[i]]

pred_label = class_names[y_pred[i]]

color = 'green' if true_label == pred_label else 'red'

plt.xlabel(f"真实:{true_label}\n预测:{pred_label}", color=color)

plt.show()

5.6 模型保存与加载

训练完成后,可将模型保存为文件,便于后续部署或继续训练:

# 方法1:保存完整模型(包含结构、权重、优化器状态)

model.save('cifar10_cnn_model.h5') # HDF5格式

print("模型保存成功!")

# 加载完整模型

loaded_model = tf.keras.models.load_model('cifar10_cnn_model.h5')

print("模型加载成功!")

# 验证加载的模型

loaded_test_loss, loaded_test_acc = loaded_model.evaluate(x_test, y_test, verbose=0)

print(f"加载模型后的测试集准确率:{loaded_test_acc:.4f}")

# 方法2:仅保存权重(需手动构建模型结构后加载)

model.save_weights('cifar10_cnn_weights.h5')

print("权重保存成功!")

# 构建新模型(结构与原模型一致)

# ...(此处省略模型构建代码,与5.3节相同)...

# 加载权重

new_model.load_weights('cifar10_cnn_weights.h5')

print("权重加载成功!")

# 编译新模型(加载权重后需重新编译)

new_model.compile(

optimizer=Adam(learning_rate=0.001),

loss=CategoricalCrossentropy(),

metrics=[CategoricalAccuracy()]

)

# 验证新模型

new_test_loss, new_test_acc = new_model.evaluate(x_test, y_test, verbose=0)

print(f"加载权重后的测试集准确率:{new_test_acc:.4f}")