引言

在过去的十年中,云计算的核心价值已从"资源获取"转向"创新效率"。人们不再满足于仅仅能用云,而是希望能以最低成本、最快速度构建可落地的智能应用。然而,对许多初学者和小型团队来说,云计算的第一个障碍往往并非技术,而是成本。配置复杂、计费不透明、忘记关闭实例后账单暴涨,这些都让不少人望而却步。

为了解决这种"账单焦虑",亚马逊云科技推出了全新升级的 Free Tier 2.0 免费计划。这一计划不仅让上云变得更轻松,也为AI创新提供了一个"零风险"的试验平台。而当Free Tier 2.0与亚马逊云科技的Serverless架构结合时,开发者终于可以用几行Python代码、一个Lambda函数,就完成一个完整的AI推理服务部署。本文将结合 DeepSeek R1 模型在 Amazon Bedrock 上的无服务器部署案例,展示如何在Free Tier 2.0的环境中快速搭建可用的AI API,从注册到调用,完整体验"云端新起点"。

一、从账单焦虑到自由创新:Free Tier2.0的新体验

传统的Free Tier虽然为新用户提供了部分免费资源,但限制较多、门槛较高------例如,部分服务需要绑定国际信用卡、免费额度分散且难以追踪、部分实例超出限制即刻计费。许多初次上云的开发者因此被动放弃了实验计划。

而 Free Tier 2.0 则以全新的方式重构了这一体验。新注册用户可立即获得100美元抵扣金,完成若干基础任务(如启动EC2、部署Lambda、体验RDS、调用Bedrock或设置Budgets)后,再获额外100美元,总计可用额度200美元。整个阶段最长可持续六个月,在此期间,除非用户主动升级账户,否则不会产生任何额外费用。

更重要的是,新版支持银联信用卡与人民币结算,让国内开发者无需外币支付方式即可使用全球云服务。这一机制意味着,开发者可以在一个完全可控的预算范围内自由实验,随时启动、暂停或删除资源而无需担心账单问题。

这种模式让创新回归本质------你可以将更多时间用于验证思路、搭建架构、探索AI服务,而非在成本上精打细算。接下来,我们将基于这笔抵扣金,构建一个真正"零门槛"的无服务器AI服务:一个运行在Bedrock上的DeepSeek R1智能模型API。

二、Serverless与Bedrock:让AI应用从概念走向实践

Serverless(无服务器架构)并不意味着没有服务器,而是开发者不需要管理服务器。所有的计算资源由亚马逊云科技自动分配、运行和销毁,用户只需编写业务逻辑。配合 Amazon Bedrock平台的模型托管服务,AI推理也可以以Serverless的方式运行。

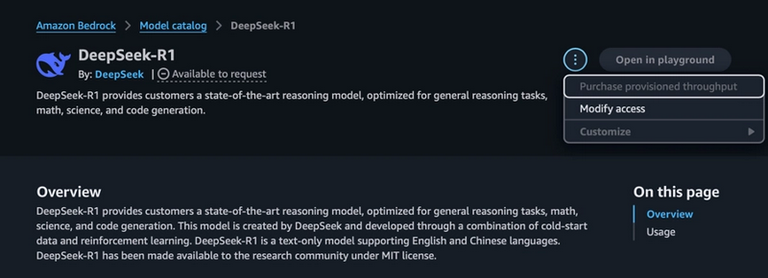

自2025年起,亚马逊云科技在Bedrock中提供了 DeepSeek R1模型的完全托管版本,开发者无需上传模型文件、配置GPU环境或维护容器镜像,只需通过API调用,即可完成推理请求。这极大降低了AI开发的工程门槛,让AI开发真正具备"即开即用"的体验。

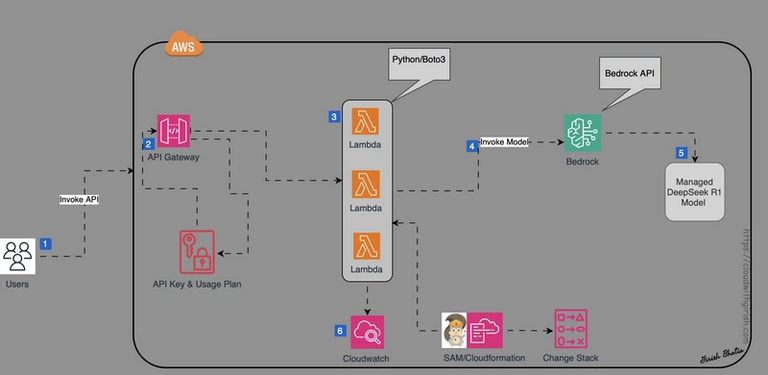

下图展示了整个架构的组成关系:

整套Serverless架构由三部分组成:

- Amazon Bedrock 负责托管并调用DeepSeek R1模型;

- Amazon Lambda 用于运行Python逻辑并封装推理接口;

- API Gateway 将Lambda函数暴露为标准HTTP端点供外部调用。

这意味着整个AI服务无需配置EC2、无需Docker镜像、无需维护GPU节点,只需关注核心业务逻辑即可。

三、在Bedrock中申请DeepSeek R1访问权限

部署前,需要在Amazon Bedrock控制台申请访问DeepSeek R1模型。打开Bedrock主页,点击模型列表中的DeepSeek R1,选择 "Modify Access" 并提交申请。

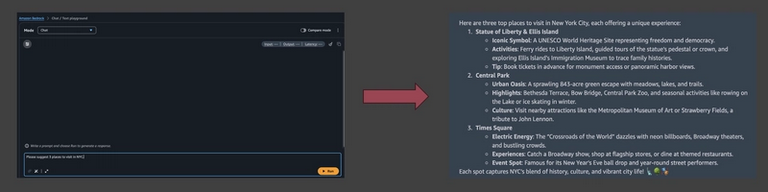

获批后,可直接在 Bedrock Playground 中体验模型功能。输入一个提示词,例如:

Please suggest 3 places to visit in NYC.模型将即时返回生成结果:

Playground让开发者无需写代码即可测试推理逻辑,这对于Free Tier用户来说是一种极具性价比的学习途径。

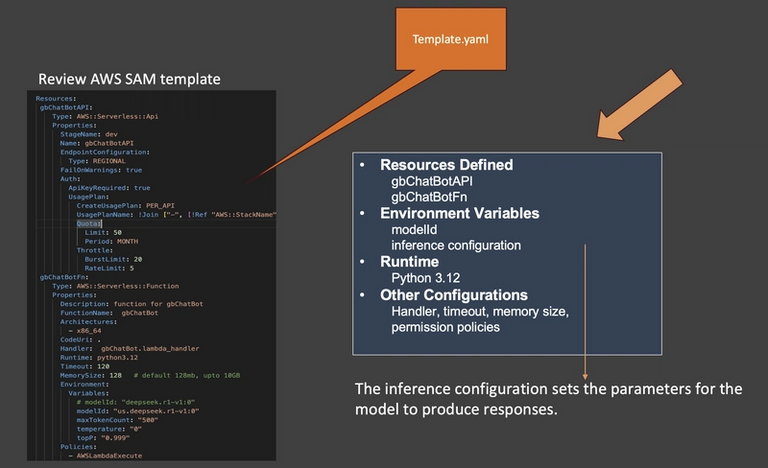

四、创建Lambda函数与API Gateway

在本地环境中,使用Amazon SAM定义Lambda函数与API结构。模板如下:

Lambda函数代码示例如下:

import boto3

import json

def lambda_handler(event, context):

body = json.loads(event['body'])

client = boto3.client('bedrock-runtime', region_name='us-east-1')

response = client.invoke_model(

modelId='deepseek.r1',

contentType='application/json',

body=json.dumps({"inputText": body['prompt']})

)

result = json.loads(response['body'].read())

return {

'statusCode': 200,

'body': json.dumps({'response': result['outputText']})

}构建与本地测试命令如下:

sam build

sam local invoke -e events/event.json部署到云端后执行:

sam deploy --guided几分钟后,亚马逊云科技会自动创建所需的Lambda函数与API Gateway端点,一个真正意义上的Serverless AI服务即告诞生。

五、验证API响应

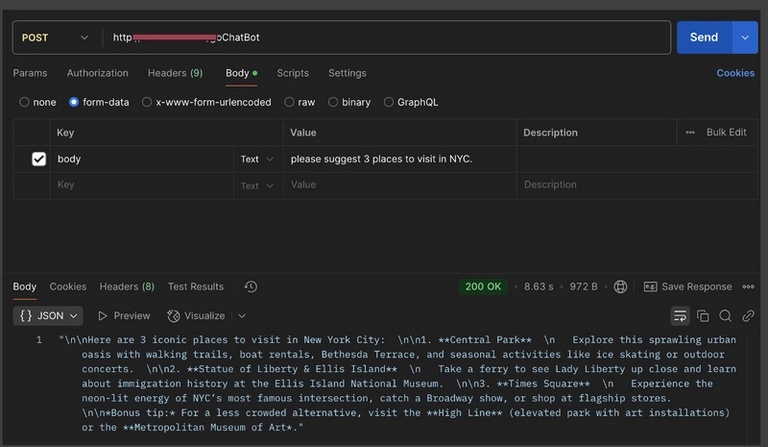

部署成功后,可通过Postman或curl验证服务响应。发送POST请求:

{

"prompt": "Explain why serverless architecture is ideal for AI applications."

}返回结果将包含模型的推理输出,通常在1秒内响应完成。

值得注意的是,这一服务的运行与计费完全符合Serverless特征:只有在调用时才计费,而空闲时间不产生成本。对于Free Tier 2.0用户而言,短期内几乎可以视为"零成本运行"。

六、Free Tier + Serverless:创新的双引擎

Free Tier 2.0与Serverless的结合,是亚马逊云科技生态中最具战略意义的一步。前者降低了试错成本,让更多人敢于开始;后者则提升了资源利用效率,让创意能持续演化。

对个人开发者而言,Free Tier是一张探索通行证;对高校或科研团队而言,它是实验与教学的理想平台;对初创企业而言,它是零预算验证商业可行性的机会。而Serverless则为这些不同用户提供了同一条技术路径------从原型到生产,不再有技术断层。

一个学生可以在Free Tier上部署第一个API项目;当需求扩大、访问量增长时,只需升级配置,便可平滑迁移到付费架构而无需重构代码。亚马逊云科技的云端生态因此形成了一个完整的成长闭环:从"无门槛起步"到"可持续扩展",每一个创新环节都有对应的技术支撑。

七、结语:让创新回归简单

整个实践证明,在亚马逊云科技的生态中,AI不再是"高成本的实验",而是"低门槛的工程"。从注册账户、获取抵扣金,到构建Lambda函数、部署API、调用模型,这一切都可以在一天之内完成。Free Tier 2.0让开发者从账单焦虑中解放出来,而Serverless与Bedrock的结合,则让AI的部署和管理变得像写函数一样简单。

真正的创新从不依赖预算的大小,而取决于思维的速度。如今,亚马逊云科技正通过Free Tier 2.0与Serverless的组合,让每一个开发者、研究者和企业都能以可负担的方式,进入AI的未来。从创意到生产,从实验到产业,云的意义正在被重新定义。200美元的抵扣金,也许只是第一步;但它代表的,是一个让每个想法都能在云端生根发芽的新时代。

以上就是本文的全部内容啦。最后提醒一下各位工友,如果后续不再使用相关服务,别忘了在控制台关闭,避免超出免费额度产生费用~