在本地windows电脑使用Docker搭建xinference环境

- [1. 整体描述](#1. 整体描述)

- [2. 前期准备](#2. 前期准备)

-

- [2.1 Docker安装](#2.1 Docker安装)

- [2.2 Xinference网站](#2.2 Xinference网站)

- [3. Xinference安装](#3. Xinference安装)

-

- [3.1 选择类型](#3.1 选择类型)

- [3.2 具体安装](#3.2 具体安装)

- [3.3 启动页面](#3.3 启动页面)

- 总结

1. 整体描述

Xorbits Inference (Xinference) 是一个开源平台,用于简化各种 AI 模型的运行和集成。借助 Xinference,您可以使用任何开源 LLM、嵌入模型和多模态模型在云端或本地环境中运行推理,并创建强大的 AI 应用。

2. 前期准备

2.1 Docker安装

在本地安装Docker Desktop,可以参考这个文章:在本地windows电脑搭建Dify环境

2.2 Xinference网站

这里把Xinference相关网站附上,以便查询相关资料

github地址:github地址

官方文档地址:官方文档地址

3. Xinference安装

3.1 选择类型

安装分为GPU加速版本和CPU版本,根据自己电脑选择,我这电脑没有GPU,就选择CPU版本。

3.2 具体安装

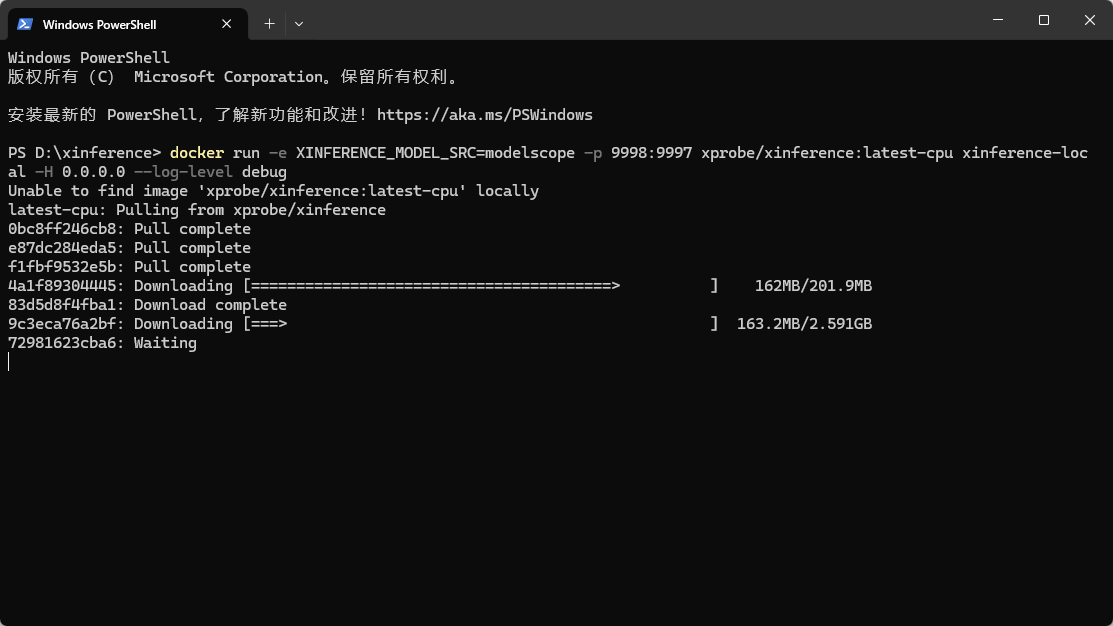

执行如下cmd命令:

bash

docker run -e XINFERENCE_MODEL_SRC=modelscope -p 9998:9997 xprobe/xinference:latest-cpu xinference-local -H 0.0.0.0 --log-level debug执行之后,会自动进入下载,等待...

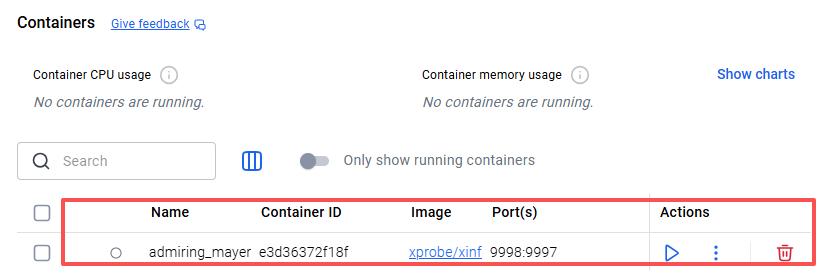

等待安装完成,在Docker Desktop上会有:

3.3 启动页面

点击启动按钮,运行容器,然后访问页面:http://localhost:9998/

会进入xinference的页面。

总结

至此,xinference就安装完成了,和Ollama相比,xinference多模态全覆盖:支持文本生成(LLM)、Embedding(如BGE、E5)、Rerank、语音合成(TTS)、语音识别(STT)等任务,Ollama基本都是LLM语言模型。