叩丁狼k8s - 组件篇

文章目录

- [叩丁狼k8s - 组件篇](#叩丁狼k8s - 组件篇)

-

- 一:搭建k8s集群

- 二:深入Pod(重点)

- 三:控制器-资源调度(重点)

-

- [1:Label 和 Selector](#1:Label 和 Selector)

- 2:Deployment

- 3:StatefulSet

-

- 3.1:核心特性

- 3.2:工作原理剖析

- 3.3:使用场景

- 3.4:使用示例

- 3.5:局限性

- [3.6:statefulSet vs Deployment](#3.6:statefulSet vs Deployment)

- 4:DaemonSet

-

- 4.1:核心思想

- 4.2:daemonSet典型使用场景

- 4.3:工作原理解析

- 4.4:deamonSet实例

- 4.5:容忍度和污点

- [4.6:如何控制 DaemonSet 的运行范围](#4.6:如何控制 DaemonSet 的运行范围)

- [5:HPA 自动扩/缩容](#5:HPA 自动扩/缩容)

-

- 5.1:关键组件

- 5.2:核心算法

- 5.3:一个完整的示例

- 5.4:观察HPA工作

- [5.5:HPA 的最佳实践与注意事项](#5.5:HPA 的最佳实践与注意事项)

- 5.6:和其他的扩缩容对比

- 四:服务发布

-

- 1:service(重点)

- 2:Ingress

-

- 2.1:Ingress介绍

- 2.2:Ingress工作原理

- [2.3:Ingress controller](#2.3:Ingress controller)

- [2.4:编写 ingress 规则](#2.4:编写 ingress 规则)

- 五:配置和存储

-

- 1:配置管理

- 2:持久化存储(挂载)

-

- 2.1:volumes卷

- 2.2:NFS挂载

-

- 2.2.1:部署NFS过程

-

- [2.2.1.1:部署NFS Server](#2.2.1.1:部署NFS Server)

- 2.2.1.2:准备k8s节点

- 2.2.1.3:k8s中使用nfs

- 2.2.2:高级配置与优化

- 2.2.3:NFS和其他存储方案的对比

- 2.3:pv和pvc

- 六:高级调度

- 七:身份认证和权限

-

- 1:用户账户和服务账户

-

- [1.1:Service Account 自动化机制](#1.1:Service Account 自动化机制)

- 2:认证和授权

- 八:云餐厅-组件总结

-

- 1:基础设施:餐厅的物理空间

-

- [1.1:node - 厨房的工作台](#1.1:node - 厨房的工作台)

- [1.2:Master Node - 餐厅经理办公室](#1.2:Master Node - 餐厅经理办公室)

- 2:基本生产单元:菜品制作

-

- [2.1:pod - 一份完整的菜品订单](#2.1:pod - 一份完整的菜品订单)

- 3:自动化管理:智能生产线

-

- [3.1:deployment - 标准化菜品生产线](#3.1:deployment - 标准化菜品生产线)

- [3.2:statefulSet - 需要顺序的套餐](#3.2:statefulSet - 需要顺序的套餐)

- [3.3:daemonSet - 每个工作台的标配](#3.3:daemonSet - 每个工作台的标配)

- [3.4:job - 一次性特别任务](#3.4:job - 一次性特别任务)

- [3.5:cronJob - 定期重复任务](#3.5:cronJob - 定期重复任务)

- 4:服务接入:前厅服务

-

- [4.1:service - 餐厅服务员](#4.1:service - 餐厅服务员)

- [4.2:Ingress - 餐厅领班/前台](#4.2:Ingress - 餐厅领班/前台)

- 5:配置管理:菜谱与秘方

-

- [5.1:ConfigMap - 标准菜谱](#5.1:ConfigMap - 标准菜谱)

- [5.2:Secret - 保险柜里的秘方](#5.2:Secret - 保险柜里的秘方)

- 6:存储管理:食材仓库

-

- [6.1:Volume - 临时储物架](#6.1:Volume - 临时储物架)

- [6.2:PersistentVolume - 餐厅的仓库](#6.2:PersistentVolume - 餐厅的仓库)

- [6.3:StorageClass - 仓库中介](#6.3:StorageClass - 仓库中介)

- 7:控制平面:餐厅管理层

-

- [7.1:kube-apiserver - 前台接待处](#7.1:kube-apiserver - 前台接待处)

- [7.2:etcd - 餐厅总账本](#7.2:etcd - 餐厅总账本)

- [7.3:kube-scheduler -- 任务分配员](#7.3:kube-scheduler – 任务分配员)

- [7.4:kube-controller-manager - 各部门主管](#7.4:kube-controller-manager - 各部门主管)

- 8:节点组件:工作台内部

-

- 8.1:kubelet:工作台监工

- 8.2:kube-proxy:内部接线员

- [8.3:Container Runtime:厨师技能](#8.3:Container Runtime:厨师技能)

- 9:完整工作流:一份订单的旅程

其实很少用叩丁狼视频的部分了,大多数都是整理deepseek!!,大多是文章结构借鉴

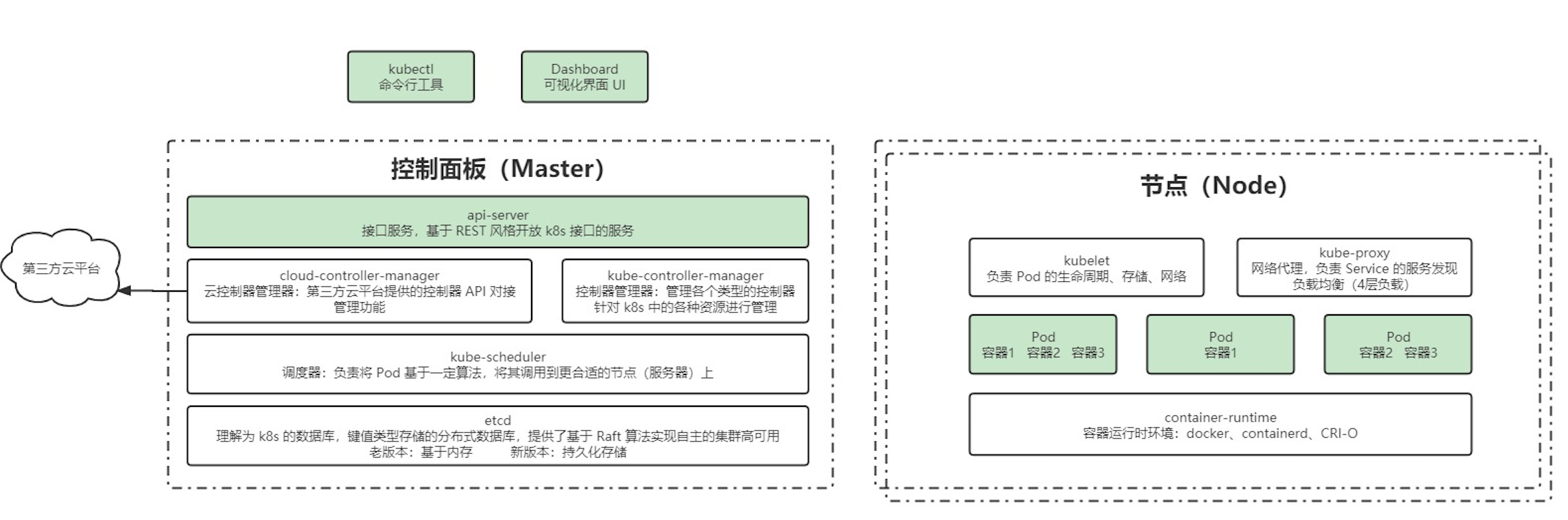

一:搭建k8s集群

1:搭建方案(重点)

1.1:minikube

minikube 是一个工具, 能让你在本地运行 Kubernetes。

minikube 在你的个人计算机(包括 Windows、macOS 和 Linux PC)上运行一个一体化(all-in-one)或多节点的本地 Kubernetes 集群,以便你来尝试 Kubernetes 或者开展每天的开发工作。

1.2:kubeadm(重点)

你可以使用 kubeadm 工具来创建和管理 Kubernetes 集群。

该工具能够执行必要的动作并用一种用户友好的方式启动一个可用的、安全的集群。

安装 kubeadm 展示了如何安装 kubeadm 的过程。一旦安装了 kubeadm, 你就可以使用它来创建一个集群。

🚀 服务器要求

最低配置:2核、2G内存、20G硬盘

最好能联网,不能联网的话需要有提供对应镜像的私有仓库

这里使用虚拟机模拟多节点:

- k8s-master:192.168.113.120

- k8s-node1:192.168.113.121

- k8s-node2:192.168.113.122

🚀 软件环境

- 操作系统:CentOS 7

- Docker:20+

- k8s:1.23.6

🚀 安装步骤

1️⃣ 为所有的节点进行初始化操作

shell

# 关闭防火墙

systemctl stop firewalld

systemctl disable firewalld

# 关闭selinux

sed -i 's/enforcing/disabled/' /etc/selinux/config # 永久

setenforce 0 # 临时

# 关闭swap

swapoff -a # 临时

sed -ri 's/.*swap.*/#&/' /etc/fstab # 永久

# 关闭完swap后,一定要重启一下虚拟机!!!

# 根据规划设置主机名

hostnamectl set-hostname <hostname>

# 在master添加hosts

cat >> /etc/hosts << EOF

192.168.113.120 k8s-master

192.168.113.121 k8s-node1

192.168.113.122 k8s-node2

EOF

# 将桥接的IPv4流量传递到iptables的链

cat > /etc/sysctl.d/k8s.conf << EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

sysctl --system # 生效

# 时间同步

yum install ntpdate -y

ntpdate time.windows.com2️⃣ 为所有的节点安装基础软件

- 安装docker并启动

- 配置k8s镜像加速

- 安装 kubeadm、kubelet、kubectl

- 重启docker

shell

# ---- 安装docker ----

# 这里我们安装docker的底层工具,会自动提示我们下载,很快就会完成了

sudo yum install -y yum-utils device-mapper-persistent-data lvm2

# 增加阿里云的docker下载仓库,默认情况下,Docker的官方是从国外的服务器上下载的,下载速度是非常慢的,甚至失败

# 所以在这里我们是使用yum-config-manager组件来指定一个新的下载资源,指向的是阿里云的应用服务器,以此提高下载速度

sudo yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

sudo yum makecache fast # centos stream 9这个镜像没有fast参数,可以不要这个

sudo yum -y install docker-ce

# 启动docker

sudo service docker start

# 查看版本验证docker是否安装成功

docker version

# 准备配置aliyun镜像加速https://cr.console.aliyun.com/cn-hangzhou/instances/mirrors

# ----- 配置k8s的镜像加速 -----

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF

# ----- 安装 kubeadm、kubelet、kubectl ------

yum install -y kubelet-1.23.6 kubeadm-1.23.6 kubectl-1.23.6

# 允许kubelet开机自启

systemctl enable kubelet

# 配置关闭 Docker 的 cgroups,修改 /etc/docker/daemon.json,加入以下内容

"exec-opts": ["native.cgroupdriver=systemd"]

# 重启 docker

systemctl daemon-reload

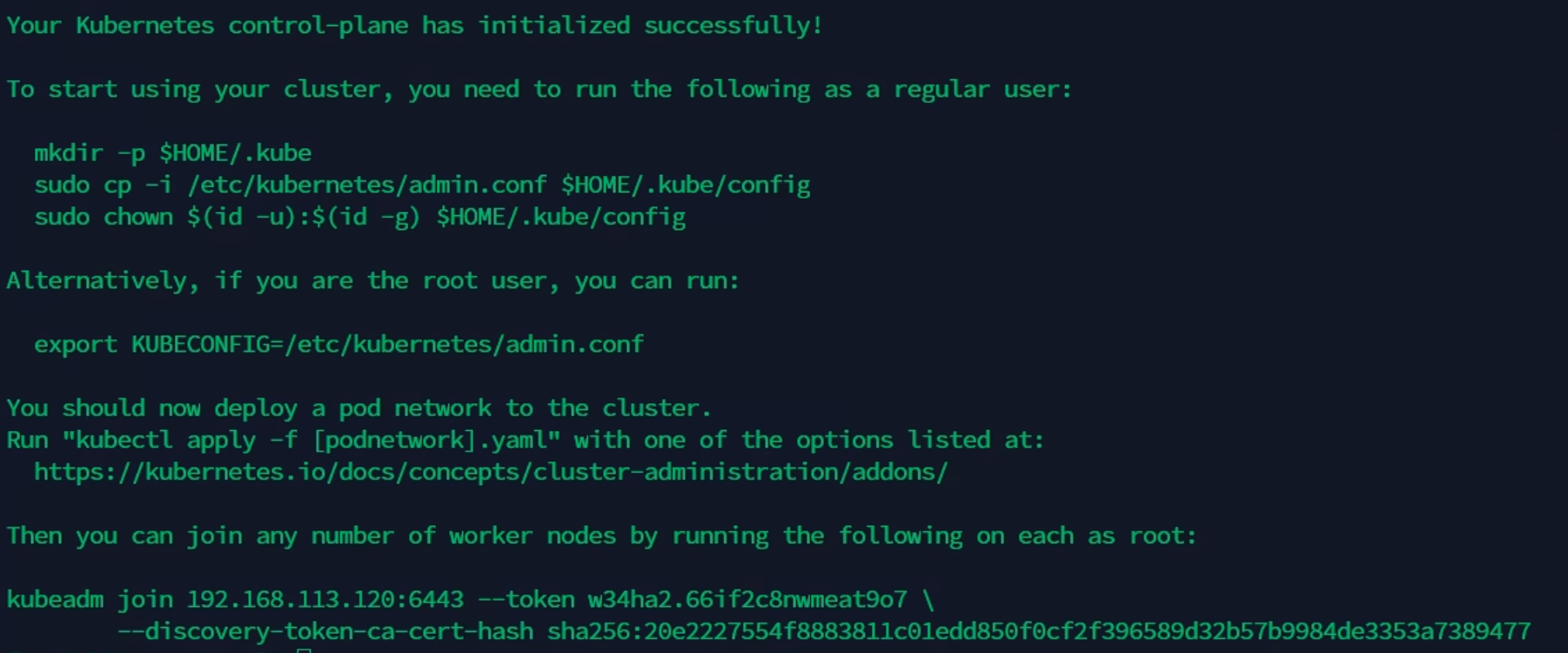

systemctl restart docker3️⃣ 部署k8s master,注意是在master节点上执行如下命令

shell

# 在 Master 节点下执行, 通过kubeadm

kubeadm init \

--apiserver-advertise-address=192.168.113.120 \

--image-repository registry.aliyuncs.com/google_containers \

--kubernetes-version v1.23.6 \

--service-cidr=10.96.0.0/12 \

--pod-network-cidr=10.244.0.0/16

# 安装成功后,复制如下配置并执行

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

kubectl get nodes

shell

# 这里参数说明一下

kubeadm init \

--apiserver-advertise-address=192.168.113.120 \ # 指定master监听的地址,修改为自己的master地址

--image-repository registry.aliyuncs.com/google_containers \ # 指定为aliyun的下载源,最好用国内的

--kubernetes-version v1.23.6 \ # 指定k8s版本

--service-cidr=10.96.0.0/12 \ # 设置集群内部的网络 - 这个不管你的ip是啥都不会变

--pod-network-cidr=10.244.0.0/16 # 设置pod的网络 - 这个不管你的ip是啥都不会变

# service-cidr 和 pod-network-cidr 最好就用这个,不然需要修改后面的 kube-flannel.yaml 文件

# 这组命令的目的是为当前用户设置kubectl的配置文件,以便能够使用kubectl命令来管理Kubernetes集群。

# 首先,它确保.kube目录存在;

mkdir -p $HOME/.kube

# 然后,将集群管理员的配置文件复制到用户的.kube目录下,并重命名为config;

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

# 最后,更改这个配置文件的所有权,使其属于当前用户。

sudo chown $(id -u):$(id -g) $HOME/.kube/config4️⃣ 加入k8s node

下面的命令不能在master操作了,要在两个node(192.168.112.121, 192.168.112.122)中操作

shell

# 分别在 k8s-node1 和 k8s-node2 执行

# 下方命令可以在 k8s master 控制台初始化成功后复制 join 命令

# 如果不小心清屏了这个命令就看不到了,所以最好先复制下来再清屏

# 如果超过了24小时,token也过期了,需要重新申请

kubeadm join \

192.168.113.120:6443 \

--token w34ha2.66if2c8nwmeat9o7

--discovery-token-ca-cert-hash sha256:20e2227554f8883811c01edd850f0cf2f396589d32b57b9984de3353a7389477

# 如果初始化的 token 不小心清空了,可以通过如下命令获取或者重新申请

# 如果 token 已经过期,就重新申请

kubeadm token create

# token 没有过期可以通过如下命令获取

kubeadm token list

# 获取 --discovery-token-ca-cert-hash 值,得到值后需要在前面拼接上 sha256:

openssl x509 -pubkey -in /etc/kubernetes/pki/ca.crt | openssl rsa -pubin -outform der 2>/dev/null | \

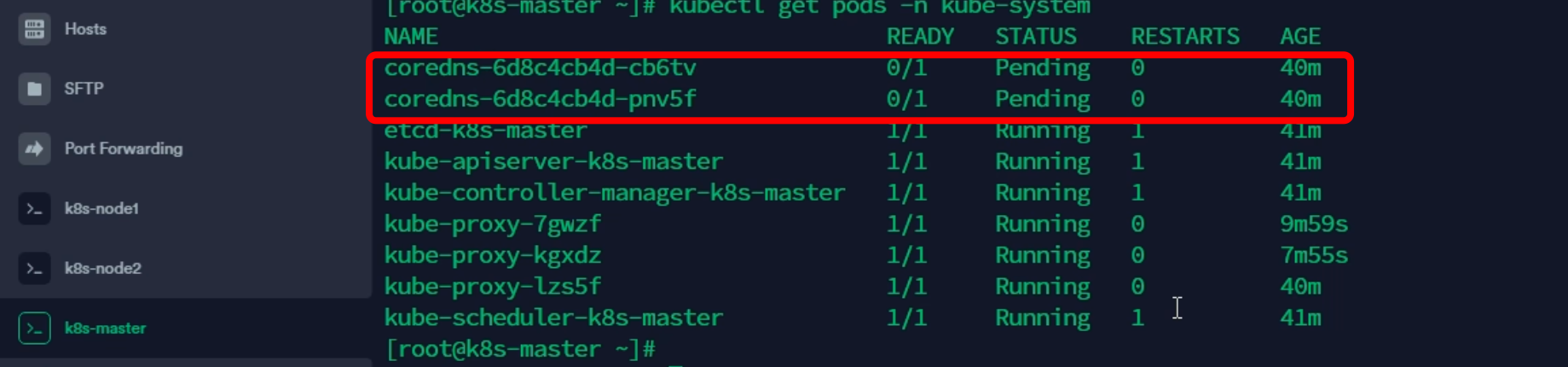

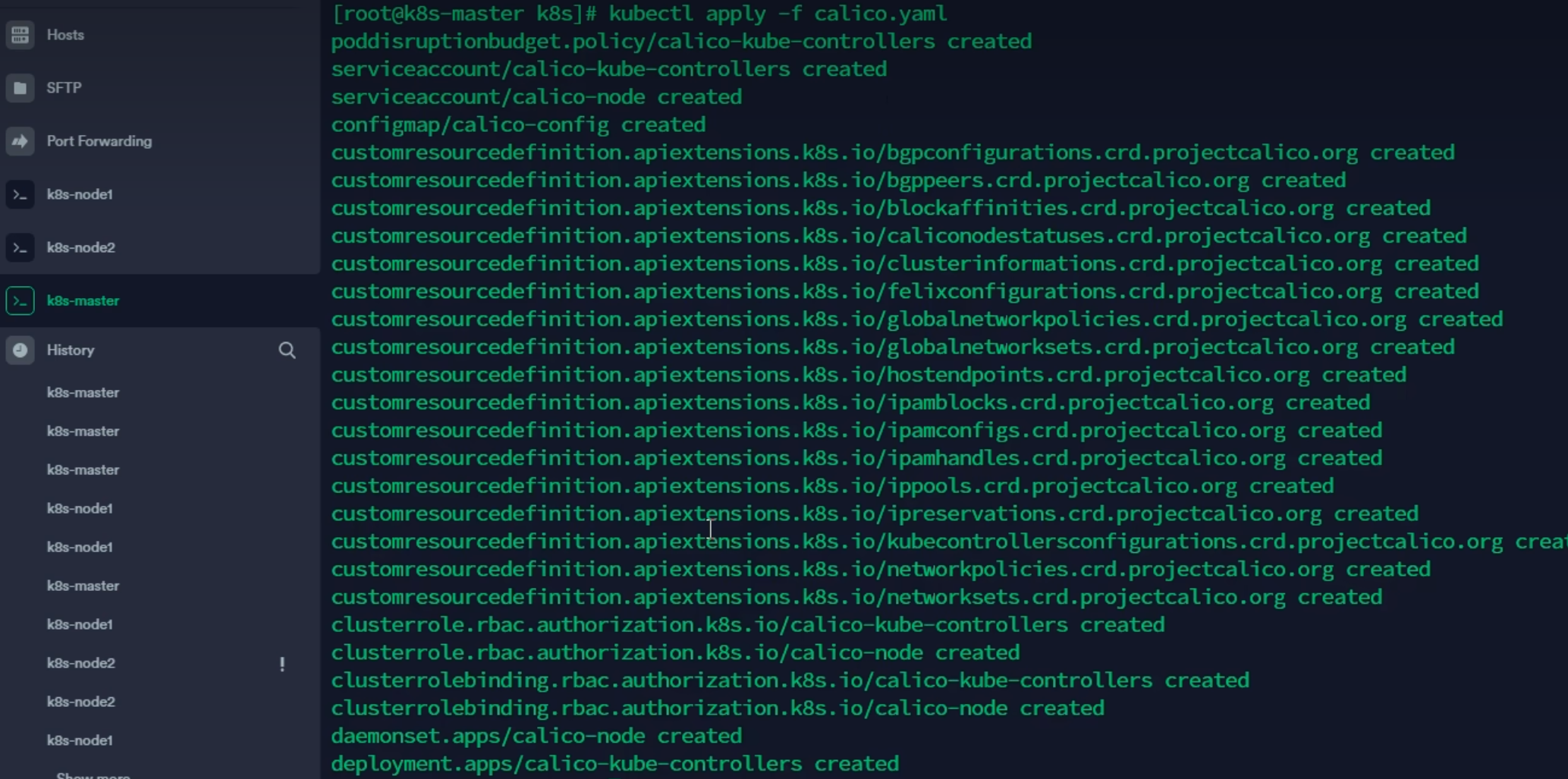

openssl dgst -sha256 -hex | sed 's/^.* //'5️⃣ 部署 CNI 网络插件

此时我们发现节点状态都是noReady的,同时使用kubectl get pods -n kube-system发现有的没有就绪

shell

# 在 master 节点上执行

# 下载 calico 配置文件,可能会网络超时

curl https://docs.projectcalico.org/manifests/calico.yaml -O

# 修改 calico.yaml 文件:

# 1. CALICO_IPV4POOL_CIDR 配置,修改为与初始化的 cidr 相同

# 2. IP_AUTODETECTION_METHOD 下的网卡名称

# 3. 删除镜像 docker.io/ 前缀,避免下载过慢导致失败

sed -i 's#docker.io/##g' calico.yaml

# 执行yaml

kubectl apply -f calico.yaml

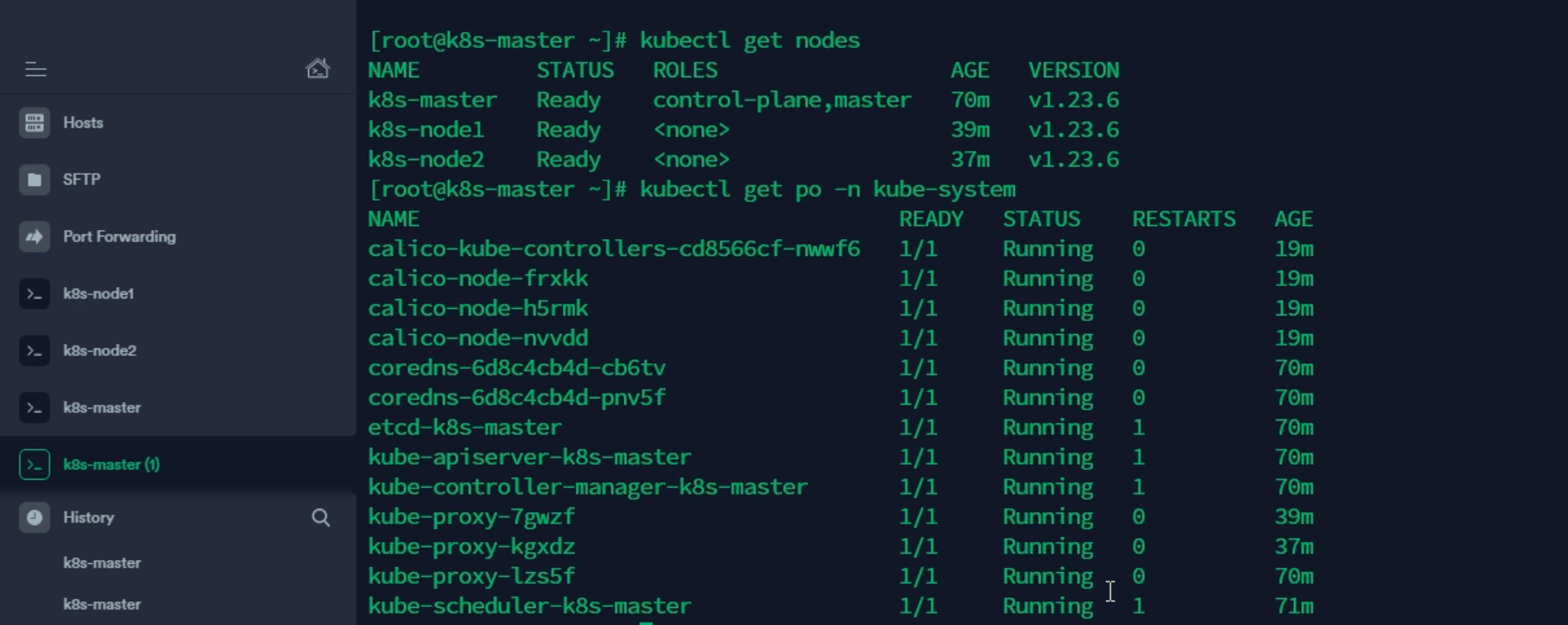

安装完CNI网络插件后,三个节点的状态就变成Ready了

同时 kubectl get pod -n kube-system 查看pod状态,可以看到,状态都是Running运行状态。

🚀 然后检查master节点(非健康状态才执行下面的内容)

使用 kubectl get cs 检查master节点状态

如果看到controller-manager、scheduler 的状态为 unhealthy,表示不健康的状态。此时我们需要修改配置文件

shell

vim /etc/kubernetes/manifests/kube-scheduler.yaml

将 --port=0注释掉

vim /etc/kubernetes/manifests/kube-controller-manager.yaml

将 --port=0注释掉然后我们再次查询服务是否正常:

- 使用

kubectl get pods -A命令查询所有pod是否正常运行 - 使用

kubectl get cs命令查询master是否正常 - 使用

kubectl get nodes命令查询node节点是否ready

6️⃣ 测试

这里测试下部署nginx, 使用下面的命令部署之后发现在3个节点访问nginx都可以访问到

shell

# 创建部署

# 创建一个无状态的应用集群nginx, 指定使用的镜像是nginx

kubectl create deployment nginx --image=nginx

# 暴露端口

# expose暴露80端口

kubectl expose deployment nginx --port=80 --type=NodePort

# 查看 pod 以及服务信息

kubectl get pod,svc2:kubectl(重点)

Kubernetes 提供 kubectl 是使用 Kubernetes API 与 Kubernetes 集群的控制面板进行通信的命令行工具。

命令非常多,官方命令文档如下:命令

但是肯定不需要全部记住那么多命令,现用现搜索,脑子记住几个关键的就行, 熟练使用

--help

shell

# 所有命令的目录

$ kubectl --help

# 获取指定命令的详细信息(假设要查询get的详细信息)

$ kubectl get --help🚀 在工作节点中使用

当前的集群中只有master节点是能够使用kubectl的,要想node节点也能使用,需要配置如下的内容:

1️⃣ 将 master 节点中 /etc/kubernetes/admin.conf 拷贝到需要运行的服务器的 /etc/kubernetes 目录中

shell

# 将本地计算机上的 Kubernetes 集群管理配置文件 admin.conf,安全地复制到名为 k8s-node1 的远程服务器的指定目录下

# scp -> 用于在网络上安全地在主机之间传输文件的命令行工具, 通过SSH协议进行通信

# /etc/kubernetes/admin.conf -> 这是源文件路径,即你要复制的"是什么"和"从哪里来"

# root@k8s-node1 -> 目标主机的认证信息,即"复制到哪里去"

# 指定使用 root 用户身份登录到远程主机。因为要向 /etc/kubernetes 系统目录写入文件,通常需要 root 权限

# 这是远程主机的主机名或 IP 地址。你的本地计算机必须能够通过这个主机名解析到正确的 IP 地址

# @ 和 ::这是固定的语法分隔符。@ 前面是用户名,后面是主机名;: 后面是目标路径

# /etc/kubernetes -> 是目标路径,即文件在远程主机上"放在哪里"。

scp /etc/kubernetes/admin.conf root@k8s-node1:/etc/kubernetes

scp /etc/kubernetes/admin.conf root@k8s-node2:/etc/kubernetes2️⃣ 在对应的服务器上(node1, node2)配置环境变量

shell

# 将admin.conf写入到环境变量中

echo "export KUBECONFIG=/etc/kubernetes/admin.conf" >> ~/.bash_profile

# 刷新

source ~/.bash_profile2.1:对资源操作

这里简单过一下就行,常用的就是get/create/scale/delete...

前置需要掌握的

🎉 平时接触最多的五类对象,都有对应的别名,可以在输入命令行的时候输入别名简写

| 资源名称 | 别名 |

|---|---|

| pods | po |

| nodes | no |

| namespace | ns |

| deployment | deploy |

| services | svc |

🎉 操作选项说明:

| 操作选项 | 含义 | 说明 |

|---|---|---|

-f |

file | 指定使用的资源清单 |

-o |

output | 指定输出指定的资源清单 |

-p |

patch | 直接指定json/yaml格式的字符串,定义具体的修改内容 |

-l |

label | 指定标签 |

🎉 对于-o选项表示格式化输出的形式

| 语法 | 说明 |

|---|---|

-o json |

输出 json 格式 |

-o name |

仅打印资源名称 |

-o wide |

以纯文本格式输出所有信息 |

-o yaml |

输出 yaml 格式 |

对象创建相关的操作 - create / run

shell

# kubectl create -f 资源清单名/资源清单路径 --> 通过资源清单创建资源

# kubectl run 实例名 --image=镜像名 --> 启动 xxx 实例

# kubectl explain 资源名 --> 获取指定资源的文档说明

$ kubectl create -f ./my-manifest.yaml # 使用my-manifest.yaml创建资源

$ kubectl create -f ./my1.yaml -f ./my2.yaml # 使用my1.yaml,my2.yaml多个文件创建资源

$ kubectl create -f ./dir # 使用目录下的所有清单文件来创建资源

$ kubectl create -f https://git.io/vPieo # 使用 url 来创建资源

$ kubectl run nginx --image=nginx # 启动一个 nginx 实例

$ kubectl explain pods,svc # 获取 pod 和 svc 的文档显示和查找资源 - get

shell

# kubectl get -> 列出指定的资源,可以跟一些附加参数规定命名空间,详细信息等等

$ kubectl get services # 列出所有 namespace 中的所有 service

$ kubectl get pods --all-namespaces # 列出所有 namespace 中的所有 pod

$ kubectl get pods -o wide # 列出所有 pod 并显示详细信息

$ kubectl get deployment my-dep # 列出指定 deployment

$ kubectl get pods --include-uninitialized # 列出该 namespace 中的所有 pod 包括未初始化的

$ kubectl get services --sort-by=.metadata.name # List Services Sorted by Name

$ kubectl get pods --sort-by='.status.containerStatuses[0].restartCount' # 根据重启次数排序列出 pod

# 获取所有具有 app=cassandra 的 pod 中的 version 标签

$ kubectl get pods --selector=app=cassandra rc -o \

jsonpath='{.items[*].metadata.labels.version}'

# 获取所有节点的 ExternalIP

$ kubectl get nodes -o jsonpath='{.items[*].status.addresses[?(@.type=="ExternalIP")].address}'

# 列出当前 Pod 中使用的 Secret

$ kubectl get pods -o json | jq '.items[].spec.containers[].env[]?.valueFrom.secretKeyRef.name' | grep -v null | sort | uniq

# 查看哪些节点已就绪

$ JSONPATH='{range .items[*]}{@.metadata.name}:{range @.status.conditions[*]}{@.type}={@.status};{end}{end}' \

&& kubectl get nodes -o jsonpath="$JSONPATH" | grep "Ready=True"

# 列出属于某个 PC 的 Pod 的名字

# "jq"命令用于转换复杂的 jsonpath,参考 https://stedolan.github.io/jq/

$ sel=${$(kubectl get rc my-rc --output=json | jq -j '.spec.selector | to_entries | .[] | "\(.key)=\(.value),"')%?}

$ echo $(kubectl get pods --selector=$sel --output=jsonpath={.items..metadata.name})

# kubectl describe -> 使用详细输出来描述命令

$ kubectl describe nodes my-node

$ kubectl describe pods my-pod更新资源 - rolling-update / replace

shell

$ kubectl rolling-update frontend-v1 -f frontend-v2.json # 通过指定的清单滚动更新 pod frontend-v1

$ kubectl rolling-update frontend-v1 frontend-v2 --image=image:v2 # 更新资源名称并更新镜像

$ kubectl rolling-update frontend --image=image:v2 # 更新 frontend pod 中的镜像

$ kubectl rolling-update frontend-v1 frontend-v2 --rollback # 退出已存在的进行中的滚动更新

$ cat pod.json | kubectl replace -f - # 基于 stdin 输入的 JSON 替换 pod

# 强制替换,删除后重新创建资源。会导致服务中断。

$ kubectl replace --force -f ./pod.json

# 为 nginx RC 创建服务,启用本地 80 端口连接到容器上的 8000 端口

$ kubectl expose rc nginx --port=80 --target-port=8000

# 更新单容器 pod 的镜像版本(tag)到 v4

$ kubectl get pod mypod -o yaml | sed 's/\(image: myimage\):.*$/\1:v4/' | kubectl replace -f -

$ kubectl label pods my-pod new-label=awesome # 添加标签

$ kubectl annotate pods my-pod icon-url=http://goo.gl/XXBTWq # 添加注解

$ kubectl autoscale deployment foo --min=2 --max=10 # 自动扩展 deployment "foo"修补资源

shell

$ kubectl patch node k8s-node-1 -p '{"spec":{"unschedulable":true}}' # 部分更新节点

# 更新容器镜像; spec.containers[*].name 是必须的,因为这是合并的关键字

$ kubectl patch pod valid-pod -p '{"spec":{"containers":[{"name":"kubernetes-serve-hostname","image":"new image"}]}}'

# 使用具有位置数组的 json 补丁更新容器镜像

$ kubectl patch pod valid-pod --type='json' -p='[{"op": "replace", "path": "/spec/containers/0/image", "value":"new image"}]'

# 使用具有位置数组的 json 补丁禁用 deployment 的 livenessProbe

$ kubectl patch deployment valid-deployment --type json -p='[{"op": "remove", "path": "/spec/template/spec/containers/0/livenessProbe"}]'编辑资源 - edit

shell

$ kubectl edit svc/docker-registry # 编辑名为 docker-registry 的 service

$ KUBE_EDITOR="nano" kubectl edit svc/docker-registry # 使用其它编辑器手动扩缩容 - scale

shell

$ kubectl scale --replicas=3 rs/foo # Scale a replicaset named 'foo' to 3

$ kubectl scale --replicas=3 -f foo.yaml # Scale a resource specified in "foo.yaml" to 3

$ kubectl scale --current-replicas=2 --replicas=3 deployment/mysql # If the deployment named mysql's current size is 2, scale mysql to 3

$ kubectl scale --replicas=5 rc/foo rc/bar rc/baz # Scale multiple replication controllers删除资源 - delete

shell

$ kubectl delete -f ./pod.json # 删除 pod.json 文件中定义的类型和名称的 pod

$ kubectl delete pod,service baz foo # 删除名为"baz"的 pod 和名为"foo"的 service

$ kubectl delete pods,services -l name=myLabel # 删除具有 name=myLabel 标签的 pod 和 serivce

$ kubectl delete pods,services -l name=myLabel --include-uninitialized # 删除具有 name=myLabel 标签的 pod 和 service,包括尚未初始化的

$ kubectl -n my-ns delete po,svc --all # 删除 my-ns namespace 下的所有 pod 和 serivce,包括尚未初始化的2.2:pod与集群操作

和运行中的pod进行交互,查看pod信息等

-ccontainer -> 指定pod中的某个容器-ffollow -> 指定跟随模式,表示实时的,持续的输出到控制台-istdin -> 使用标准输入打开-ttypseudo-TTY -> 分配一个伪终端--分隔符 -> 分隔kubectl自己的参数和要传递给容器内部执行的命令

shell

# 查看pod日志或者pod中指定的容器的日志,-f区分是否实时打印日志

$ kubectl logs my-pod # dump 输出 pod 的日志(stdout)

$ kubectl logs my-pod -c my-container # dump 输出 pod 中容器的日志(stdout,pod 中有多个容器的情况下使用)

$ kubectl logs -f my-pod # 流式输出 pod 的日志(stdout)

$ kubectl logs -f my-pod -c my-container # 流式输出 pod 中容器的日志(stdout,pod 中有多个容器的情况下使用)

# 运行临时pod, 一般测试用

$ kubectl run -i --tty busybox --image=busybox -- sh # 交互式 shell 的方式运行 pod

# 连接和其他执行命令的操作

$ kubectl attach my-pod -i # 连接到运行中的容器

$ kubectl port-forward my-pod 5000:6000 # 转发 pod 中的 6000 端口到本地的 5000 端口

$ kubectl exec my-pod -- ls / # 在已存在的容器中执行命令(只有一个容器的情况下)

$ kubectl exec my-pod -c my-container -- ls / # 在已存在的容器中执行命令(pod 中有多个容器的情况下)

$ kubectl top pod POD_NAME --containers # 显示指定 pod 和容器的指标度量节点和集群的的相关操作

shell

$ kubectl cordon my-node # 标记 my-node 不可调度

$ kubectl drain my-node # 清空 my-node 以待维护

$ kubectl uncordon my-node # 标记 my-node 可调度

$ kubectl top node my-node # 显示 my-node 的指标度量

$ kubectl cluster-info # 显示 master 和服务的地址

$ kubectl cluster-info dump # 将当前集群状态输出到 stdout

$ kubectl cluster-info dump --output-directory=/path/to/cluster-state # 将当前集群状态输出到 /path/to/cluster-state

# 如果该键和影响的污点(taint)已存在,则使用指定的值替换

$ kubectl taint nodes foo dedicated=special-user:NoSchedule3:API概述(简单了解)

官网文档:https://kubernetes.io/zh-cn/docs/reference/using-api/

REST API是k8s系统的重要部分,组件之间的所有操作和通信均由API Server处理的 REST API调用

大多数情况下,API定义和实现都符合标准的rest格式,可以通过kubectl命令管理工具或其他命令行工具来执行。

3.1:类型说明

alpha

- 包含 alpha 名称的版本(例如v1alpha1)。

- 该软件可能包含错误。启用一个功能可能会导致 bug。默认情况下,功能可能会被禁用。

- 随时可能会丢弃对该功能的支持,恕不另行通知。

- API 可能在以后的软件版本中以不兼容的方式更改,恕不另行通知。

- 该软件建议仅在短期测试集群中使用,因为错误的风险增加和缺乏长期支持。

beta

- 包含 beta 名称的版本(例如 v2beta3)。

- 该软件经过很好的测试。启用功能被认为是安全的。默认情况下功能是开启的。

- 细节可能会改变,但功能在后续版本不会被删除

- 对象的模式或语义在随后的 beta 版本或 Stable 版本中可能以不兼容的方式发生变化。如果这种情况发生时,官方会提供迁移操作指南。这可能需要删除、编辑和重新创建API对象。

- 该版本在后续可能会更改一些不兼容地方,所以建议用于非关键业务,如果你有多个可以独立升级的集群,你也可以放宽此限制。

- 大家使用过的 Beta 版本后,可以多给社区反馈,如果此版本在后续更新后将不会有太大变化。

stable

- 该版本名称命名方式:vX 这里 X 是一个整数。

- Stable 版本的功能特性,将出现在后续发布的软件版本中。

3.2:废弃api

https://kubernetes.io/zh-cn/docs/reference/using-api/deprecation-guide/

二:深入Pod(重点)

1:Pod的配置文件

yaml

apiVersion: v1 # api 文档版本

kind: Pod # 资源对象类型,也可以配置为像Deployment、StatefulSet这一类的对象

metadata: # Pod 相关的元数据,用于描述 Pod 的数据

name: nginx-demo # Pod 的名称

labels: # 定义 Pod 的标签

type: app # 自定义 label 标签,名字为 type,值为 app

test: 1.0.0 # 自定义 label 标签,描述 Pod 版本号

namespace: 'default' # 命名空间的配置

spec: # 期望 Pod 按照这里面的描述进行创建

containers: # 对于 Pod 中的容器描述

- name: nginx # 容器的名称

image: nginx:1.7.9 # 指定容器的镜像

imagePullPolicy: IfNotPresent # 镜像拉取策略,指定如果本地有就用本地的,如果没有就拉取远程的

command: # 指定容器启动时执行的命令

- nginx

- -g

- 'daemon off;' # nginx -g 'daemon off;'

workingDir: /usr/share/nginx/html # 定义容器启动后的工作目录

ports:

- name: http # 端口名称

containerPort: 80 # 描述容器内要暴露什么端口

protocol: TCP # 描述该端口是基于哪种协议通信的

- env: # 环境变量

name: JVM_OPTS # 环境变量名称

value: '-Xms128m -Xmx128m' # 环境变量的值

reousrces:

requests: # 最少需要多少资源

cpu: 100m # 限制 cpu 最少使用 0.1 个核心

memory: 128Mi # 限制内存最少使用 128兆

limits: # 最多可以用多少资源

cpu: 200m # 限制 cpu 最多使用 0.2 个核心

memory: 256Mi # 限制 最多使用 256兆

restartPolicy: OnFailure # 重启策略,只有失败的情况才会重启2:探针

容器内应用的监测机制,根据不同的探针来判断容器应用当前的状态

2.1:探针的类型

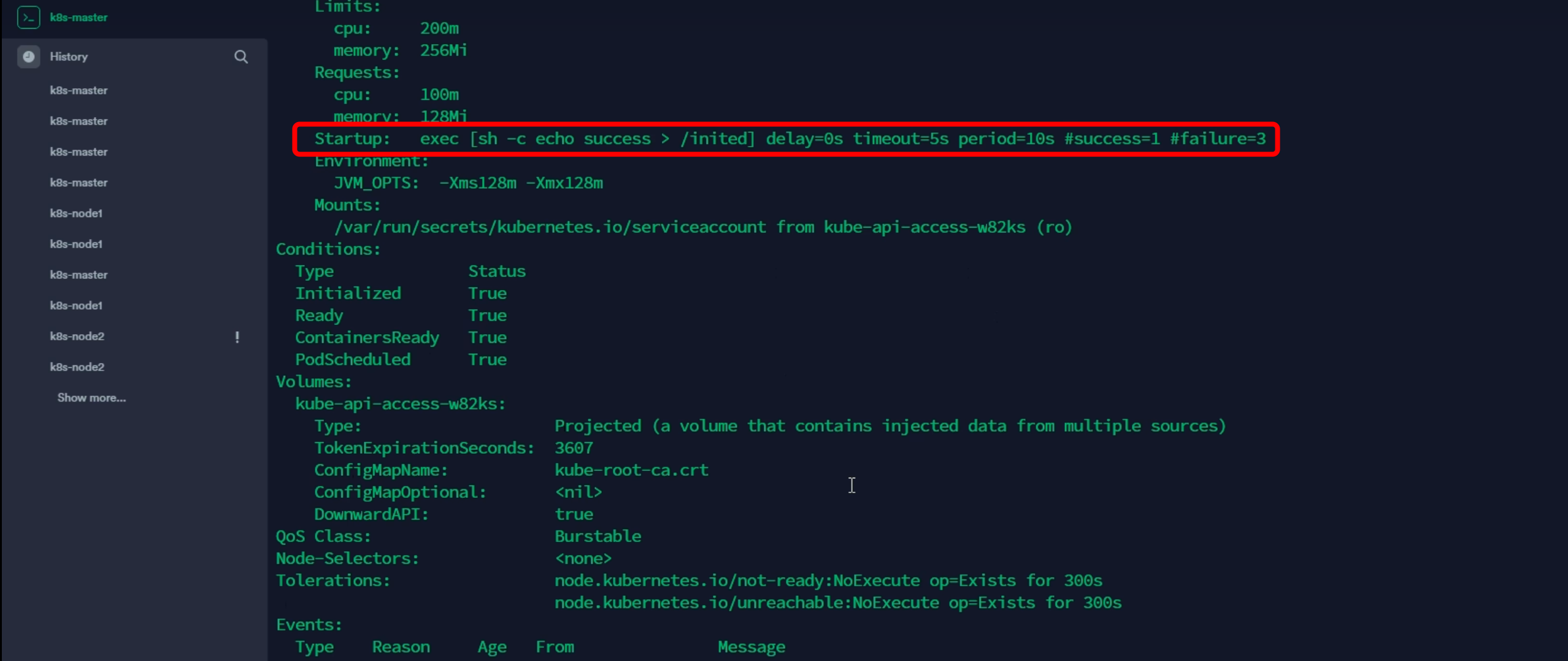

StartupProbe - 是否启动? - 该探针优先,会先禁用其他的探针

k8s 1.16 版本新增的探针,用于判断应用程序是否已经启动了。

当配置了 startupProbe 后,会先禁用其他探针,直到 startupProbe 成功后,其他探针才会继续。

作用:由于有时候不能准确预估应用一定是多长时间启动成功,因此配置另外两种方式不方便配置初始化时长来检测,而配置了 statupProbe 后,只有在应用启动成功了,才会执行另外两种探针,可以更加方便的结合使用另外两种探针使用。

yaml

startupProbe: # 定义了一个启动探针,用于检测容器内的应用程序是否已完成启动。

# 它的主要目的是保护慢启动容器,在其完成启动前,暂停存活探针和就绪探针的执行。

httpGet: # 指定使用HTTP GET请求的方式进行启动检查。

path: /api/startup # HTTP GET请求访问的服务器路径。这里检查的是容器内服务的'/api/startup'端点。

# 这个端点通常被设计为在应用程序完全启动成功后才返回成功响应。

port: 80 # HTTP GET请求访问的容器端口号。这里检查的是容器内80端口(标准的HTTP端口)。这个配置看起来很简单,因为它只定义了最核心的检查方式(httpGet),而省略了其他参数。Kubernetes 会为省略的参数使用默认值。

未写明但实际生效的重要参数(使用默认值):

failureThreshold: 默认值 = 30 (旧版本k8s)或 默认值 = 3 (较新版本k8s,请查阅对应版本文档)- 这意味着 kubelet 会尝试非常多次(例如30次)才会放弃并重启容器。这是启动探针最关键的特性,它为慢启动应用提供了充足的启动时间。

periodSeconds: 默认值 = 10- 每次探测执行的间隔时间是10秒。

timeoutSeconds: 默认值 = 1- 每次探测请求的超时时间为1秒。

successThreshold: 默认值 = 1- 只需要1次探测成功,即认为启动成功。

initialDelaySeconds: 默认值 = 0- 容器启动后立即开始执行启动探测。

这个启动探针的完整行为解读:

- 何时启动:容器启动后立即(

initialDelaySeconds: 0)开始第一次探测。 - 如何检查:向容器内

80端口的/api/startup路径发送 HTTP GET 请求。 - 等待响应:期望在

1秒内(timeoutSeconds: 1)收到成功的 HTTP 响应(状态码 2xx 或 3xx)。 - 判定结果:

- 成功:只要有一次请求成功,kubelet 就认为容器已启动完成。随后,存活探针和就绪探针会开始接管后续的健康检查工作。

- 失败/超时:如果请求失败或超时,kubelet 会等待

10秒(periodSeconds: 10)后再次尝试。

- 最终失败:如果连续失败了很多次(例如

failureThreshold: 30*periodSeconds: 10= 300秒),kubelet 就会放弃等待,并重启容器。

为什么需要 Startup Probe?

它的存在是为了解决一个特定问题:对于那些启动速度非常慢的应用程序(例如大型Java应用、需要初始化大量数据的应用),在启动完成之前,它们的存活探针和就绪探针肯定会失败。

如果没有 startupProbe:

- 存活探针 (

livenessProbe) 会在失败多次后,误以为应用启动失败,从而错误地重启这个正在努力启动的容器,导致它永远无法成功启动。

有了 startupProbe:

- 在启动探针成功之前,存活探针和就绪探针都会被禁用。

- 启动探针拥有非常高的

failureThreshold,允许容器在较长时间内(例如5分钟)持续报告"未启动",而不会触发重启。 - 一旦应用程序自己准备好了,启动探针成功,控制权就交给

livenessProbe和readinessProbe来负责运行时的健康检查。

简单比喻:

- Startup Probe:像是给一个正在开机的大型机器一个"请勿打扰"的牌子。在它自己完成开机自检并亮起"准备就绪"的绿灯之前,你不会去碰它,也不会因为它开机时噪音大、灯乱闪就把它电源拔了。

- 等绿灯亮了(启动探针成功),你才会开始定期检查它是否在正常运转(Liveness)和是否空闲可以接新任务(Readiness)。

livenessProbe - 是否运行(活没活着),如果没有或者将会执行重启策略

用于探测容器中的应用是否运行,如果探测失败,kubelet 会根据配置的重启策略进行重启

若没有配置,默认就认为容器启动成功,不会执行重启策略。

yaml

livenessProbe: # 定义了一个存活探针,用于检测容器是否仍在健康运行。如果探测失败,k8s会重启容器。

failureThreshold: 5 # 连续探测失败5次后,k8s才会将容器判定为不健康并重启它。这提供了一定的缓冲,避免因临时故障重启。

httpGet: # 指定使用HTTP GET请求的方式进行健康检查。

path: /health # HTTP GET请求访问的服务器路径。这里检查的是容器内Web服务的'/health'端点。

port: 8080 # HTTP GET请求访问的容器端口号。这里检查的是容器内8080端口。

scheme: HTTP # 用于连接的健康检查的协议(HTTP 或 HTTPS)。这里使用的是HTTP协议。

initialDelaySeconds: 60 # 容器启动后,等待60秒后才开始第一次执行存活探测。给应用足够的启动时间。

periodSeconds: 10 # 每次执行存活探测的间隔时间是10秒。即每10秒检查一次。

successThreshold: 1 # 探测失败后,只要有一次成功,即被认定为探测成功。对于livenessProbe,此值必须为1。

timeoutSeconds: 5 # 每次探测请求的超时时间为5秒。如果5秒内没有响应,则本次探测判定为失败。- 等待 :容器启动后,先等待

60秒 (initialDelaySeconds)。 - 开始检查 :60秒后,发起第一次健康检查。向容器内

8080端口的/health路径发送一个 HTTP GET 请求。 - 等待响应 :它期望在

5秒内 (timeoutSeconds) 收到一个成功的 HTTP 响应状态码 (2xx 或 3xx)。 - 判定结果 :

- 如果请求在5秒内成功返回,则探测成功。

- 如果请求超时(5秒内无响应)或返回错误状态码(如4xx, 5xx),则探测失败。

- 后续检查 :无论第一次成功与否,它都会每

10秒 (periodSeconds) 重复一次步骤2-4的检查。 - 失败处理 :如果连续

5次 (failureThreshold) 探测都失败了,Kubernetes 就会判定容器不健康,并重启这个容器。 - 恢复处理 :一旦失败后(比如连续失败了3次),只要有一次探测成功,失败计数器就会被重置。因为

successThreshold是1。

readinessProbe - 当前的应用是否能干活(能不能干活)?

用于探测容器内的程序是否健康

它的返回值如果返回 success,那么就认为该容器已经完全启动,并且该容器是可以接收外部流量的。

yaml

readinessProbe: # 定义了一个就绪探针,用于检测容器是否已准备就绪,可以开始接收外部流量。

failureThreshold: 3 # 连续探测失败3次后,k8s会将容器标记为"未就绪"(Unready)。该容器将从服务的负载均衡器中移除,不再接收任何流量。

httpGet: # 指定使用HTTP GET请求的方式进行就绪检查。

path: /ready # HTTP GET请求访问的服务器路径。这里检查的是容器内Web服务的'/ready'端点。

port: 8181 # HTTP GET请求访问的容器端口号。这里检查的是容器内8181端口。

scheme: HTTP # 用于连接的健康检查的协议(HTTP 或 HTTPS)。这里使用的是HTTP协议。

periodSeconds: 10 # 每次执行就绪探测的间隔时间是10秒。即每10秒检查一次容器是否就绪。

successThreshold: 1 # 对于就绪探针,探测失败后,只要有一次成功,该容器就会被标记为"就绪"(Ready),并重新开始接收流量。

timeoutSeconds: 1 # 每次探测请求的超时时间为1秒。如果1秒内没有响应,则本次探测判定为失败。这个 readinessProbe 的行为与 livenessProbe 类似,但目的和后果完全不同:

- 目的不同:

- Liveness (存活):检查容器是否活着。失败会重启容器。

- Readiness (就绪):检查容器是否准备好工作。失败只会停止向该容器发送流量,但不会重启它。

- 常见配置差异:

initialDelaySeconds:这个就绪探针配置里没有显式设置initialDelaySeconds。Kubernetes 会使用默认值0,意味着容器启动后立即开始进行就绪检查。这通常适用于启动很快的轻量级服务,或者希望尽快开始检查的服务。如果应用启动慢,最好也加上这个参数。timeoutSeconds:这里的超时时间设置为1秒,比存活探针的5秒更短。这表明对就绪检查的响应速度要求更高,期望服务能快速反馈其状态。failureThreshold:失败阈值3次,与存活探针的5次相比,可能意味着希望更快地将不健康的实例从服务中剔除。

- 行为总结:

- 容器启动后立即开始就绪检查。

- 每

10秒向:8181/ready发送一次 HTTP 请求,要求1秒内得到成功响应。 - 如果连续

3次检查失败,Kubernetes 会将 Pod 的状态标记为Unready,并从所有关联的 Service 的端点列表(Endpoints)中移除该 Pod。流量不会再被路由到这个 Pod。 - 之后,检查会继续进行。一旦有一次检查成功(

successThreshold: 1),Pod 又会被重新标记为Ready,并加回到服务的端点列表中,重新开始接收流量。

简单比喻:

- Liveness Probe:像是检查一个人的心脏是否还在跳。不跳了就要采取抢救(重启)。

- Readiness Probe:像是检查一个人是否睡醒了并且能接电话。没醒就不给他派新任务(流量),但不会去叫醒(重启)他,让他继续睡。

2.2:探针探测的方式

execAction -> 以命令的方式进行探测

在容器内部执行一个命令,如果返回值为 0,则任务容器时健康的。

yaml

livenessProbe:

exec:

command:

- cat

- /healthtcpsocketAction -> 以tcpsocket连接的方式进行探测

通过 tcp 连接监测容器内端口是否开放,如果开放则证明该容器健康

yaml

livenessProbe:

tcpSocket:

port: 80httpgetAction -> 通过HTTP请求的方式检测探针

生产环境用的较多的方式,发送 HTTP 请求到容器内的应用程序

如果接口返回的状态码在 200~400 之间,则认为容器健康。

yaml

livenessProbe:

failureThreshold: 5 # 允许失败的阈值

httpGet:

path: /health

port: 8080

scheme: HTTP # 通过http请求8080端口的/healthAPI,检测容器是否健康

httpHeaders:

- name: xxx

value: xxx2.3:参数配置

| 参数 | 说明 |

|---|---|

| initialDelaySeconds | 初始化时间 |

| timeoutSeconds | 超时时间 |

| periodSeconds | 监测间隔时间 |

| successThreshold | 检查 ? 次成功就表示成功 |

| failureThreshold | 监测失败 ? 次就表示失败 |

2.4:使用方式示例

yaml

apiVersion: v1 # api 文档版本

kind: Pod # 资源对象类型,也可以配置为像Deployment、StatefulSet这一类的对象

metadata: # Pod 相关的元数据,用于描述 Pod 的数据

name: nginx-po # Pod 的名称

labels: # 定义 Pod 的标签

type: app # 自定义 label 标签,名字为 type,值为 app

test: 1.0.0 # 自定义 label 标签,描述 Pod 版本号

namespace: 'default' # 命名空间的配置

spec: # 期望 Pod 按照这里面的描述进行po

containers: # 对于 Pod 中的容器描述

- name: nginx # 容器的名称

image: nginx:1.7.9 # 指定容器的镜像

imagePullPolicy: IfNotPresent # 镜像拉取策略,指定如果本地有就用本地的,如果没有就拉取远程的

startupProde: # 应用启动探针配置

tcpSocket:

port: 80

failureThreshold: 3 # 失败3次才算真正的失败

periodSecond: 10 # 间隔时间

successThreshold: 1 # 多少次成功算成功

timeoutSeconds: 5 # 超时时间

command: # 指定容器启动时执行的命令

- nginx

- -g

- 'daemon off;' # nginx -g 'daemon off;'

workingDir: /usr/share/nginx/html # 定义容器启动后的工作目录

ports:

- name: http # 端口名称

containerPort: 80 # 描述容器内要暴露什么端口

protocol: TCP # 描述该端口是基于哪种协议通信的

- env: # 环境变量

name: JVM_OPTS # 环境变量名称

value: '-Xms128m -Xmx128m' # 环境变量的值

reousrces:

requests: # 最少需要多少资源

cpu: 100m # 限制 cpu 最少使用 0.1 个核心

memory: 128Mi # 限制内存最少使用 128兆

limits: # 最多可以用多少资源

cpu: 200m # 限制 cpu 最多使用 0.2 个核心

memory: 256Mi # 限制 最多使用 256兆

restartPolicy: OnFailure # 重启策略,只有失败的情况才会重启

shell

# 这部分的常用命令

kubectl create -f nginx-po.yml # 通过指定的资源文件创建资源

kubectl describe po nginx-po # 查看指定资源的具体情况,在这里可以看到探针的处理情况

kubectl get po nginx-po # 获取指定pod资源的启动情况

kubectl exec -it nginx-po -c nginx -- cat /inited # 查看指定pod资源的初始化日志

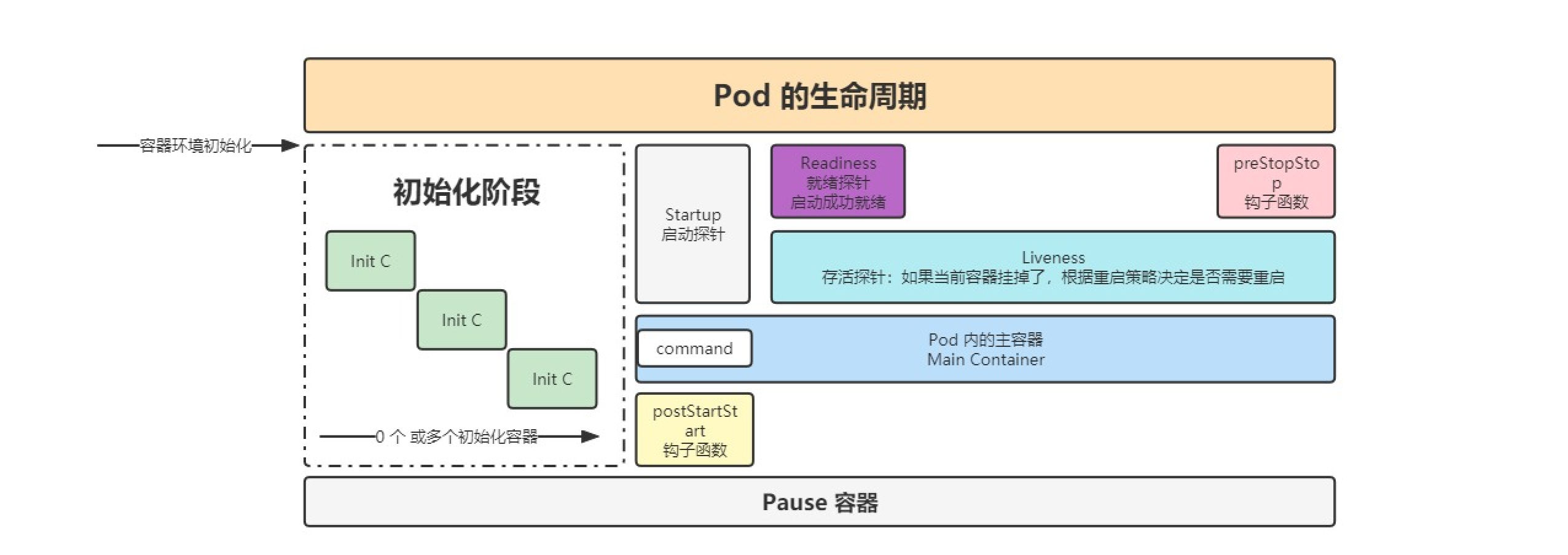

3:生命周期

初始化 -> 容器创建完成 -> postStart钩子 -> 对容器各种操作 -> preStop钩子 -> 容器销毁

yaml

apiVersion: v1 # api 文档版本

kind: Pod # 资源对象类型,也可以配置为像Deployment、StatefulSet这一类的对象

metadata: # Pod 相关的元数据,用于描述 Pod 的数据

name: nginx-po # Pod 的名称

labels: # 定义 Pod 的标签

type: app # 自定义 label 标签,名字为 type,值为 app

test: 1.0.0 # 自定义 label 标签,描述 Pod 版本号

namespace: 'default' # 命名空间的配置

spec: # 期望 Pod 按照这里面的描述进行po

# 变为删除中的状态后,会给 pod 一个宽限期,让 pod 去执行一些清理或销毁操作。

terminationGracePeriodSeconds: 30

containers: # 对于 Pod 中的容器描述

- name: nginx # 容器的名称

image: nginx:1.7.9 # 指定容器的镜像

imagePullPolicy: IfNotPresent # 镜像拉取策略,指定如果本地有就用本地的,如果没有就拉取远程的

# 可以控制容器创建之后和容器停止之前完成的额外的动作....

lifecycle:

postStart: # 容创建完成后执行的动作,不能保证该操作一定在容器的 command 之前执行,一般不使用

exec: # 可以是 exec / httpGet / tcpSocket

command:

- sh

- -c

- 'mkdir /data'

preStop: # 在容器停止前执行的动作

httpGet: # 发送一个 http 请求

path: /

port: 80

exec: # 执行一个命令

command:

- sh

- -c

- sleep 9

startupProde: # 应用启动探针配置

tcpSocket:

port: 80

failureThreshold: 3 # 失败3次才算真正的失败

periodSecond: 10 # 间隔时间

successThreshold: 1 # 多少次成功算成功

timeoutSeconds: 5 # 超时时间

command: # 指定容器启动时执行的命令

- nginx

- -g

- 'daemon off;' # nginx -g 'daemon off;'

workingDir: /usr/share/nginx/html # 定义容器启动后的工作目录

ports:

- name: http # 端口名称

containerPort: 80 # 描述容器内要暴露什么端口

protocol: TCP # 描述该端口是基于哪种协议通信的

- env: # 环境变量

name: JVM_OPTS # 环境变量名称

value: '-Xms128m -Xmx128m' # 环境变量的值

reousrces:

requests: # 最少需要多少资源

cpu: 100m # 限制 cpu 最少使用 0.1 个核心

memory: 128Mi # 限制内存最少使用 128兆

limits: # 最多可以用多少资源

cpu: 200m # 限制 cpu 最多使用 0.2 个核心

memory: 256Mi # 限制 最多使用 256兆

restartPolicy: OnFailure # 重启策略,只有失败的情况才会重启🚀 pod退出流程:endpoint删除pod的ip地址 -> pod变成terminating状态 -> 执行preStop钩子函数(注册中心下线,数据的清理和销毁)

三:控制器-资源调度(重点)

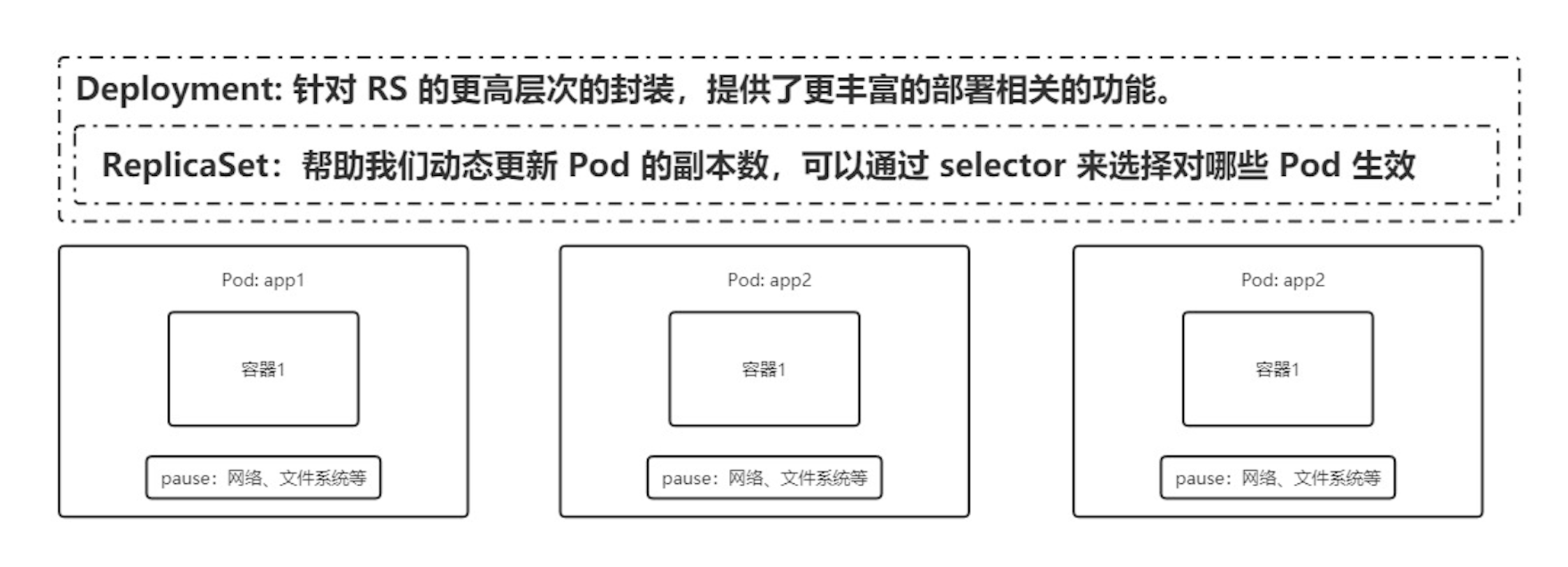

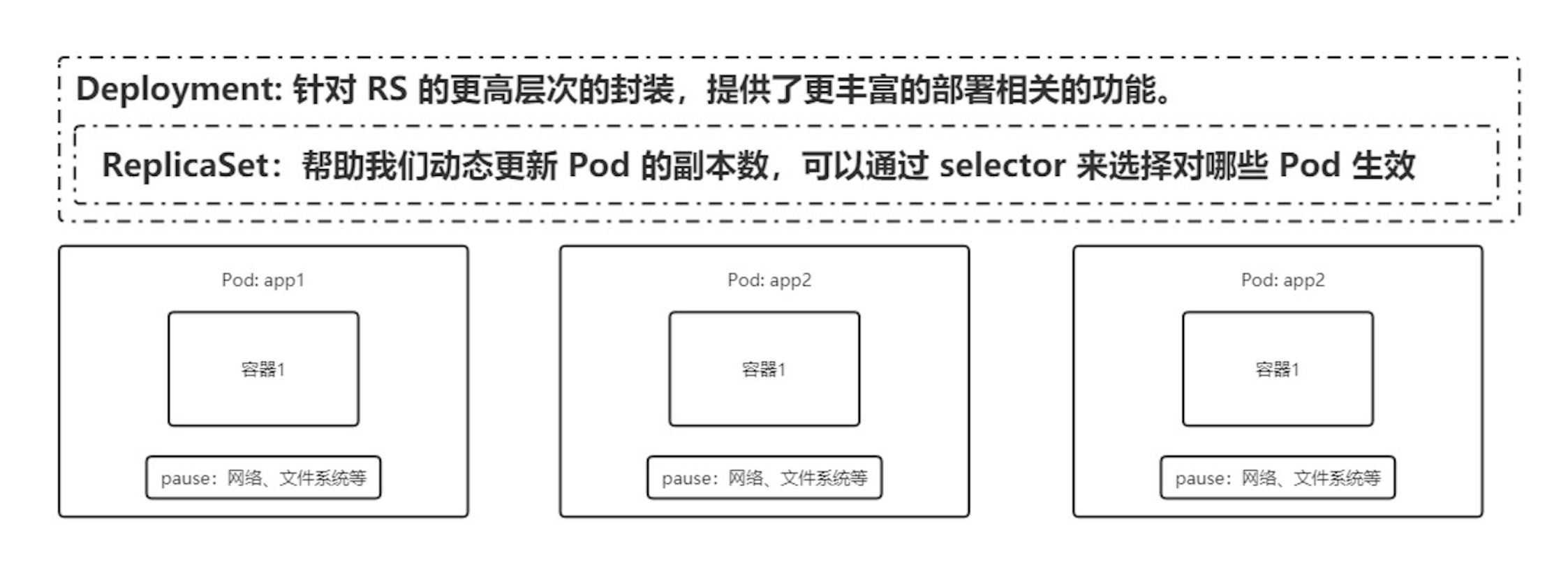

原生的Pod无法进行自动的扩缩容,同时无法直接编辑对应的资源清单,因此我们很少直接操作Pod,而是通过操作控制器的方式实现对容器资源的管理

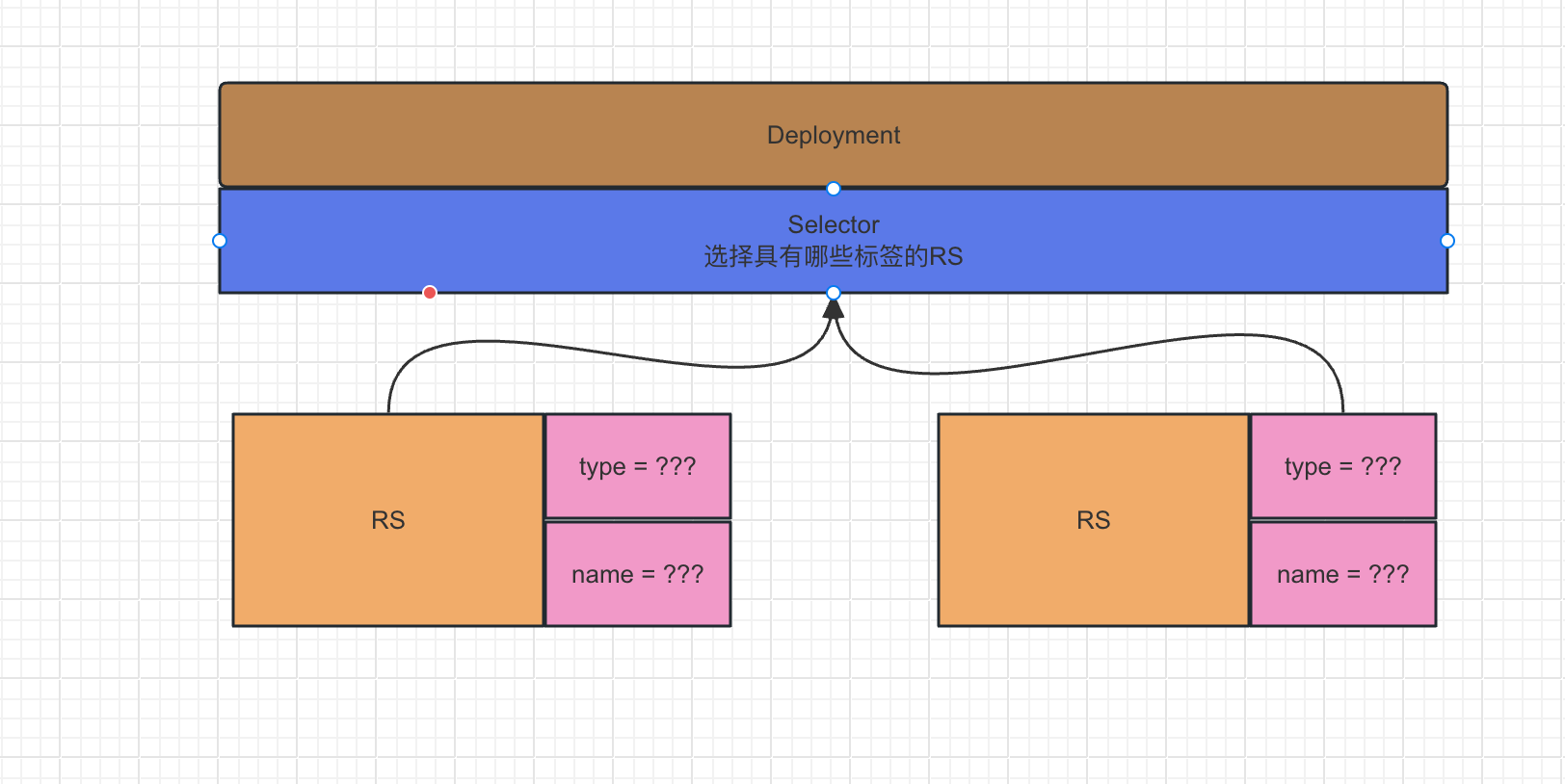

1:Label 和 Selector

先想一想为啥要有这两个东西?

以RS和Deployment举例:

- RS是无状态应用的副本集,用于管理pod的扩容和缩容的

- Deployment是部署RS和Pod用的,里面包含RS,他会创建对应的RS和Pod,对应用进行滚动更新或者回滚,动态的扩容

那么如果将Deployment和RS进行相关联呢?

K8s没有采用强制的硬编码方式关联,因为这样一旦双方中的一方发生改变,映射关系可能就失效了

因此Label和Selector应运而生!!

在RS中定义一些有关当前RS特性的标签,然后Deployment通过Selector选择器选择指定的RS与其形成映射

1.1:标签Label

- 可以在资源清单中的

metadata.labels中进行配置 - 可以使用kubectl进行设置:

- 创建临时的label ->

kubectl label po <资源名称> app=hello - 修改已经存在的标签 ->

kubectl label po <资源名称> app=hello2 --overwrite

- 创建临时的label ->

- 可以使用kubectl进行查询:

- 按照label单值进行查找 ->

kubectl get po -A -l app=hello - 查看所有节点的labels ->

kubectl get po --show-labels

- 按照label单值进行查找 ->

1.2:选择器selector

- 可以在各对象的配置

spec.selector或其他可以写selector的属性中编写 - 可以使用kubectl进行查询

- 匹配单个值,查找

app=hello的 pod ->kubectl get po -A -l app=hello - 匹配多个值 ->

kubectl get po -A -l 'k8s-app in (metrics-server, kubernetes-dashboard)' - 查找

version!=1 and app=nginx的 pod 信息 ->kubectl get po -l version!=1,app=nginx - 不等值 + 语句 ->

kubectl get po -A -l version!=1,'app in (busybox, nginx)'

- 匹配单个值,查找

2:Deployment

2.1:deploy的创建

对于Deployment的创建,因为我们可能不会资源清单的方式,可以使用kubectl的方式进行创建

shell

# 创建一个基于nginx1.7.9镜像的deployment

kubectl create deploy nginx-deploy --image=nginx:1.7.9

# 或执行

kubectl create -f xxx.yaml --record

# --record 会在 annotation 中记录当前命令创建或升级了资源,后续可以查看做过哪些变动操作。

# 查看部署信息

kubectl get deployments

# 查看 rs

kubectl get rs

# 查看 pod 以及展示标签,可以看到是关联的那个 rs

kubectl get pods --show-labels2.2:滚动更新,回滚,扩容缩容

滚动更新

⚠️ 只有修改了 deployment 配置文件中的 template 中的属性后,才会触发更新操作

shell

# 修改 nginx 版本号 -> set image

kubectl set image deployment/nginx-deployment nginx=nginx:1.9.1

# 或者修改

kubectl edit deployment/nginx-deployment

# 查看滚动更新的过程

kubectl rollout status deploy <deployment_name>

# 查看部署描述,最后展示发生的事件列表也可以看到滚动更新过程

kubectl describe deploy <deployment_name>

# 查看部署信息

通过 kubectl get deployments 获取部署信息,UP-TO-DATE 表示已经有多少副本达到了配置中要求的数目

通过 kubectl get rs 可以看到增加了一个新的 rs

通过 kubectl get pods 可以看到所有 pod 关联的 rs 变成了新的🎉 假设当前有 5 个 nginx:1.7.9 版本,你想将版本更新为 1.9.1,当更新成功第三个以后,你马上又将期望更新的版本改为 1.9.2,那么此时会立马删除之前的三个,并且立马开启更新 1.9.2 的任务

回滚

有时候你可能想回退一个Deployment,例如,当Deployment不稳定时,比如一直crash looping。

可以通过设置 .spec.revisonHistoryLimit 来指定 deployment 保留多少 revison

如果设置为 0,则不允许 deployment 回退了。

shell

kubectl rollout history deployment/nginx-deploy # 可以获取 revison 的列表

kubectl rollout history deployment/nginx-deploy --revision=2 # 可以查看详细信息

# 确认要回退的版本后,可以通过

kubectl rollout undo deployment/nginx-deploy # 可以回退到上一个版本

kubectl rollout undo deployment/nginx-deploy --to-revision=2 # 也可以回退到指定的 revision

# 检验

kubectl get deployment

kubectl describe deployment扩容和缩容

shell

通过 kube scale 命令可以进行自动扩容/缩容,以及通过 kube edit 编辑 replcas 也可以实现扩容/缩容

扩容与缩容只是直接创建副本数,没有更新 pod template 因此不会创建新的 rs2.3:暂停和恢复

由于每次对 pod template 中的信息发生修改后,都会触发更新 deployment 操作

那么此时如果频繁修改信息,就会产生多次更新,而实际上只需要执行最后一次更新即可

当出现此类情况时我们就可以暂停 deployment 的 rollout

shell

# 实现暂停

kubectl rollout pause deployment <name>

# 检测配置是否发生了更改?

kubectl get deploy <name> -o yaml

# 恢复rollout

kubectl rollout deploy <name>

# 恢复后,我们再次查看 rs 和 po 信息,我们可以看到就开始进行滚动更新操作了

kubectl get rs

kubectl get po2.4:deploy的配置文件

元数据 + 规约(副本数 + 选择器 + 更新策略 + pod template的元数据 + 规约)

yaml

apiVersion: apps/v1 # deployment api 版本

kind: Deployment # 资源类型为 deployment

# 声明命名空间,名称和标签

metadata: # 元信息

labels: # 标签

app: nginx-deploy # 具体的 key: value 配置形式

name: nginx-deploy # deployment 的名字

namespace: default # 所在的命名空间

# 规约,声明期望的状态

spec:

replicas: 1 # 期望副本数

revisionHistoryLimit: 10 # 进行滚动更新后,保留的历史版本数

selector: # 选择器,用于找到匹配的 RS

matchLabels: # 按照标签匹配

app: nginx-deploy # 匹配的标签key/value

strategy: # 更新策略

rollingUpdate: # 滚动更新配置

maxSurge: 25% # 进行滚动更新时,更新的个数最多可以超过期望副本数的个数/比例

maxUnavailable: 25% # 进行滚动更新时,最大不可用比例更新比例,表示在所有副本数中,最多可以有多少个不更新成功

type: RollingUpdate # 更新类型,采用滚动更新

# template模板 -> pod的规约声明

template: # pod 模板

metadata: # pod 的元信息

labels: # pod 的标签

app: nginx-deploy

spec: # pod 期望信息

containers: # pod 的容器

- image: nginx:1.7.9 # 镜像

imagePullPolicy: IfNotPresent # 拉取策略

name: nginx # 容器名称

restartPolicy: Always # 重启策略

terminationGracePeriodSeconds: 30 # 删除操作最多宽限多长时间3:StatefulSet

在 Kubernetes 中,最常见的用于部署应用的工作负载控制器是 Deployment。Deployment 非常适合无状态应用,它的 Pod 是完全相同、可随意替换的。你不需要关心哪个 Pod 在运行,也不需要关心它们启动的顺序和身份。

但是,对于有状态应用,情况就完全不同了。有状态应用(如 MySQL、Kafka、ZooKeeper、Elasticsearch 等)具有以下一个或多个特点:

- 稳定的、唯一的网络标识符:每个实例都有一个固定的、可被发现的主机名。

- 稳定的、持久的存储:每个实例都需要自己独立的存储卷,即使 Pod 被重新调度,也需要挂载回同一个存储。

- 有序的、优雅的部署和扩展:在启动新实例之前,必须确保之前的实例已经准备就绪(例如,数据库主从配置)。

- 有序的、优雅的删除和终止:在终止实例时,顺序是反向的。

- 有序的滚动更新:按顺序进行应用版本的更新。

Deployment 无法满足这些需求。为此,Kubernetes 引入了 StatefulSet 这个控制器,专门用于管理有状态应用。

3.1:核心特性

稳定的网络标识

StatefulSet 为每个 Pod 提供一个唯一且固定的名称,格式为:<statefulset-name>-<ordinal-index>

例如,一个名为 kafka 的 StatefulSet,创建 3 个副本,Pod 名称将分别是:kafka-0、kafka-1、kafka-2

这些 Pod 名称在 Pod 的生命周期内是稳定的。

即使 kafka-1 这个 Pod 被重新调度到另一个节点上,它的名字依然会是 kafka-1。

此外,还会创建一个无头 Service,用于管理 Pod 的网络身份。

每个 Pod 会获得一个唯一的 DNS 记录:<pod-name>.<service-name>.<namespace>.svc.cluster.local

集群中的其他应用可以通过这个固定的DNS访问Pod

稳定的持久化存储

这是 StatefulSet 最核心的功能之一。它通过 VolumeClaimTemplate(存储卷申请模板)来实现。

-

在定义 StatefulSet 时,你可以创建一个

volumeClaimTemplates。 -

当 StatefulSet 创建 Pod 时(例如

kafka-0),它会根据这个模板自动创建一个 PersistentVolumeClaim- 名称格式为:

<volumeClaimTemplateName>-<podName>。

- 名称格式为:

-

这个 PVC 随后会绑定到一个 PV,从而为 Pod 提供存储。

- PV:就是图书馆里一本本具体的、物理存在的书。比如《三体》第一册、《哈利波特与魔法石》等等。每一本都是独立的、实实在在的资源。

- PVC:就是读者提交的借书申请单。申请单上写着:"我想借一本科幻小说,精装版的"。它不关心具体是哪一本《三体》,只要符合要求就行。

-

每个 Pod(

kafka-0,kafka-1, ...)都会获得自己独立的 PVC 和 PV。 -

当 Pod 被重新调度时,新的 Pod 实例会自动挂载到它原来使用的那个 PV 上,从而保证了数据的持久化和稳定性。

- 独立房间:StatefulSet 给每个"手下"(Pod)都分了一个独立的、带锁的房间(PV) 和一把专属的钥匙(PVC),谁也不抢谁的。

- 人走房留:即使某个"手下"因为意外情况消失了,他的房间也会一直给他留着,里面的东西不动。

- 来人接班:会再来一个同名同姓的新"手下",他用原来的那把专属钥匙,打开原来的那个房间,一切照旧。

这样,就保证了像 Kafka、MySQL 这种"有状态"的应用,每个实例的数据都不会丢,身份也不会乱,从而实现了 "数据的持久化和稳定性"。

有序的 pod 管理

StatefulSet 严格遵循顺序规则,这是其"状态"的另一个体现。

- 部署/扩容时:按索引顺序从大到小(0, 1, 2, ...) 创建 Pod。必须等前一个 Pod(

kafka-0)成功进入 Running 和 Ready 状态后,才会创建下一个 Pod(kafka-1)。 - 删除/缩容时:按索引顺序从大到小(..., 2, 1, 0) 终止 Pod。必须等

kafka-2完全终止后,才会终止kafka-1。 - 滚动更新时:默认策略是

RollingUpdate,它会按与 Pod 索引相反的顺序(从最大的索引开始)逐个地、安全地更新 Pod。

这种顺序性对于有主从关系的集群(如 MySQL、Redis)至关重要,因为它确保了主节点(通常是索引为0的 Pod)首先启动并稳定运行。

3.2:工作原理剖析

要理解 StatefulSet,需要明白它和以下几个 Kubernetes 组件/资源的关系:

- StatefulSet Controller:核心控制器,负责创建、更新、删除 Pod,并确保 Pod 的数量和状态符合预期。

- 无头 Service:你必须手动创建一个

ClusterIP类型为None的 Service。- 这个 Service 不提供负载均衡,它的作用是告诉 Kubernetes 不要为这些 Pod 分配集群 IP

- 而是让 DNS 系统为每个 Pod 返回其独立的 DNS A 记录。这是实现稳定网络发现的基石。

- PersistentVolume Provisioner

- 当

volumeClaimTemplates中指定了storageClassName时,动态卷制备器会按需自动创建 PV。

- 当

3.3:使用场景

- 数据库集群:MySQL Galera Cluster, PostgreSQL 高可用集群, MongoDB 副本集。

- 消息队列:Kafka 集群, RabbitMQ 集群。

- 键值存储:etcd, Zookeeper。

- 分布式数据存储:Elasticsearch, Redis Cluster。

- 任何需要持久化数据和稳定网络身份的应用程序。

3.4:使用示例

假设我们要部署一个名为 my-app 的有状态应用,它有三个副本,每个副本都需要自己的存储

先创建一个无头service - 保证稳定网络发现的基石

yaml

apiVersion: v1

kind: Service

metadata:

name: my-app-service

labels:

app: my-app

spec:

ports:

- port: 80 # 这定义了服务端口。虽然不进行负载均衡,但这个端口信息在 DNS 发现和 Pod 间直接通信时仍然有用。

name: web

# 一个普通的 Service 会被分配一个虚拟的 IP 地址(ClusterIP),作为负载均衡器,将请求转发到后端的多个 Pod。

# 当设置为 None 时,Kubernetes 不会为这个 Service 分配 ClusterIP,也不会进行负载均衡。

# 它的唯一目的变成了:为匹配的 Pod 提供稳定的网络身份标识

clusterIP: None # 这就是"无头"的定义

selector:

# 这个选择器告诉 Service:"请关注所有带有标签 app: my-app 的 Pod"。

# 它不负责路由流量,而是负责发现这些 Pod,并为它们创建 DNS 记录

app: my-app # 这个选择器必须匹配 StatefulSet 中 Pod 的标签创建statefulSet的资源清单

yaml

apiVersion: apps/v1

kind: StatefulSet

metadata:

name: my-app

spec:

# 你所管理的 Pod 的网络身份,由名为 my-app-service 的无头服务来定义和提供。

# 有了这个关联,StatefulSet 在创建 Pod 时,才会知道该让哪个 Service 来为这些 Pod 创建 DNS 记录

serviceName: "my-app-service" # 这是 StatefulSet 和无头服务之间的桥梁,必须指向上面创建的无头 Service

replicas: 3

selector:

matchLabels: # 这组配置是标准的控制器模式。StatefulSet 通过 selector 来识别哪些 Pod 归它管理。

app: my-app # 必须匹配 template.metadata.labels

# 这个标签 app: my-app 也正是无头服务 my-app-service 的 selector 所寻找的标签。

# 这就完成了 Pod、StatefulSet 和 Service 三者的关联。

template:

metadata:

labels:

app: my-app # 这是 Pod 的标签,被 Service 的 selector 使用

spec:

containers:

- name: nginx

image: nginx:latest

ports:

- containerPort: 80

name: web

volumeMounts:

- name: www # 这个名字必须与 volumeClaimTemplates.name 一致

mountPath: /usr/share/nginx/html # 请把名为 www 的存储卷,挂载到容器内的 /usr/share/nginx/html 路径下

volumeClaimTemplates: # 核心部分:存储卷申请模板

- metadata:

name: www # 这是 StatefulSet 的灵魂。它是一个"模板",用于为每个 Pod 自动创建独立的 PVC

spec: # 这个 PVC 会去动态或静态地绑定一个 PV,从而为 Pod my-app-0 提供 1Gi 的、独立的、持久的存储。

accessModes: [ "ReadWriteOnce" ]

storageClassName: "standard" # 假设你的集群有名为 "standard" 的 StorageClass

resources:

requests:

storage: 1Gi

- 提交清单 :用户通过

kubectl apply提交了无头 Service 和 StatefulSet 的配置文件。 - 控制器工作:StatefulSet 控制器监测到新的 StatefulSet 资源,开始行动。

- 有序创建 :

- 控制器按顺序(0, 1, 2)创建 Pod。

- 在创建每个 Pod(如

my-app-0)时,根据volumeClaimTemplates自动创建一个唯一的 PVC(www-my-app-0)。 - 该 PVC 根据其规格(

storageClassName: "standard")动态地制备并绑定一个 PV(如pv-0)。 - Pod 的

volumeMounts将名为www的卷(来自于 PVCwww-my-app-0)挂载到容器内的指定路径。

- 网络注册 :

- 无头 Service

my-app-service持续监控带有标签app: my-app的 Pod。 - 每当一个 Pod 创建成功并进入 Ready 状态,Service 就为其在 Kubernetes 的 DNS 中注册一条唯一的 A 记录。

- 无头 Service

- 最终状态 :

- 稳定的网络:每个 Pod 都有一个固定的、可通过 DNS 直接访问的域名。

- 稳定的存储:每个 Pod 都拥有自己独立的、永久的存储卷。即使 Pod

my-app-0被删除重建,新的my-app-0Pod 也会通过同名 PVC 挂载回原来的 PV,数据不会丢失。

部署和验证

bash

# 应用配置,使用apply -f

kubectl apply -f service.yaml

kubectl apply -f statefulset.yaml

# 观察pod的创建 get

# 你会清晰地看到 Pod 按顺序启动:my-app-0 -> my-app-1 -> my-app-2。

kubectl get pods -w -l app=my-app

# 查看pvc

kubectl get pvc

# 会有如下类似的输出

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS AGE

www-my-app-0 Bound pvc-12345678-90ab-cdef-1234-567890abcdef 1Gi RWO standard 5m

www-my-app-1 Bound pvc-abcdef12-3456-7890-abcd-ef1234567890 1Gi RWO standard 4m

www-my-app-2 Bound pvc-09876543-21ba-dcfe-4321-098765432109 1Gi RWO standard 3m

# 在集群内另一个 Pod 中,你可以通过固定的 DNS 名来访问特定的 Pod:

# 进入另一个临时 Pod

kubectl run -it --rm --image=busybox:1.28 test-pod -- /bin/sh

# 在 test-pod 内部执行

nslookup my-app-0.my-app-service3.5:局限性

- 存储复杂性:你需要负责管理底层存储的备份、恢复和扩缩容。删除 StatefulSet 时,其关联的 PVC 默认不会被删除,需要手动清理,以防止数据丢失。

- 网络复杂性 :应用本身需要能够处理集群发现和成员管理(例如,

kafka-0需要知道如何找到kafka-1和kafka-2)。StatefulSet 只提供了稳定的身份,不提供集群组建逻辑。 - 速度较慢:由于有序性的要求,部署、扩缩容和更新的速度会比 Deployment 慢。

3.6:statefulSet vs Deployment

| 特性 | Deployment(无状态) | StatefulSet(有状态) |

|---|---|---|

| Pod 名称 | 随机哈希 | 固定,有序 |

| 网络标识 | 通过 Service 负载均衡 | 固定的 DNS 名,可通过无头 Service 直接访问 Pod |

| 存储 | 共享或临时存储 | 独立的持久化存储,与 Pod 绑定 |

| 部署/删除顺序 | 并行,无序 | 严格按顺序进行 |

| 适用场景 | Web 前端、无状态 API | 数据库、消息队列、分布式存储 |

简单来说,StatefulSet 是 Kubernetes 为有状态应用提供的"一等公民"支持。

StatefulSet 通过稳定的网络标识、持久化存储和有序的 Pod 管理,将有状态应用的复杂需求抽象成了简单的 Kubernetes 资源定义,使得在云原生环境中运行像 MySQL、Kafka 这样的复杂系统成为可能。

4:DaemonSet

DaemonSet 是 Kubernetes 中一个非常核心的工作负载控制器,它确保所有(或部分)节点上都运行一个 Pod 的副本。

当有节点加入集群时,Pod 会在新节点上创建;当有节点从集群移除时,这些 Pod 也会被垃圾回收。

4.1:核心思想

核心思想就是每一个节点一个Pod

可以把 DaemonSet 想象成一个集群级别的"守护进程"部署工具。

- Deployment:关心的是维护一定数量的、无状态的 Pod 副本,至于这些 Pod 运行在哪个节点上,它不关心。

- StatefulSet:关心的是维护有状态的、有唯一标识的 Pod 副本,同样不严格关心节点。

- DaemonSet:关心的是节点本身。它的目标是确保每一个符合条件的节点上都运行一个它管理的 Pod 实例。

4.2:daemonSet典型使用场景

DaemonSet 非常适合运行那些提供节点级别基础设施服务的 Pod。

- 集群存储守护进程:例如

glusterd、ceph。每个节点都需要运行一个存储守护进程,来提供分布式的存储服务。 - 日志收集守护进程:例如

Fluentd、Filebeat。每个节点上都需要一个日志收集器,用于收集该节点上所有容器产生的日志,并统一发送到后端的日志存储(如 Elasticsearch)。 - 监控采集守护进程:例如

Prometheus Node Exporter。每个节点上都需要一个 agent 来收集该节点的硬件和操作系统指标(如 CPU、内存、磁盘使用率),供 Prometheus 抓取。 - 网络插件:例如 Calico、Weave Net 等 CNI 网络插件,通常以 DaemonSet 的形式运行,在每个节点上提供网络策略和路由功能。

- 安全与合规:在每个节点上运行安全审计、漏洞扫描或合规性检查的代理。

4.3:工作原理解析

DaemonSet 控制器的工作流程非常直接:

- 监听节点变化:DaemonSet 控制器持续监听(watch)Kubernetes API Server,关注集群中节点的添加和删除事件。

- 节点添加:当一个新的节点被加入到集群中时,DaemonSet 控制器会立即检测到这个事件。它会根据定义的 Pod 模板(

spec.template),在这个新节点上创建一个 Pod。 - 节点删除:当一个节点被从集群中移除(或被标记为不可调度

NoSchedule),DaemonSet 控制器会检测到这一变化,并删除运行在该节点上的 Pod。 - 节点选择器:DaemonSet 可以通过

nodeSelector或nodeAffinity来限制 Pod 只运行在部分节点上,而不是全部节点。

对比

| 特性 | Deployment | StatefulSet | DaemonSet |

|---|---|---|---|

| 核心目标 | 维护一组无状态的 Pod 副本 | 维护一组有状态的、有序的 Pod 副本 | 确保每个节点上都运行一个 Pod 副本 |

| Pod 身份 | 可互换,无唯一标识 | 唯一、稳定的标识(有序编号) | 与节点强关联,身份由所在节点定义 |

| 副本数量 | 由 replicas 定义,与节点数无关 |

由 replicas 定义,与节点数无关 |

自动与集群中符合条件的节点数保持一致 |

| 存储 | 通常使用共享存储或临时存储 | 每个 Pod 拥有独立的持久化存储(PVC) | 通常使用 hostPath 访问节点本地资源 |

| 典型场景 | Web 服务器、API 后端 | 数据库(MySQL)、消息队列(Kafka) | 日志收集(Fluentd)、监控代理(Node Exporter) |

4.4:deamonSet实例

部署 Fluentd 日志收集器 - 假设我们要在每一个节点上部署fluentd日志收集器实例

yaml

apiVersion: apps/v1

kind: DaemonSet

metadata:

name: fluentd-elasticsearch

namespace: kube-system

labels:

k8s-app: fluentd-logging

spec:

selector:

matchLabels:

name: fluentd-elasticsearch # 必须匹配 template 中的标签

template:

metadata:

labels:

name: fluentd-elasticsearch # 这个标签被 DaemonSet 的 selector 使用,用于识别和管理pod

spec:

# 容忍度 (Tolerations):允许 Pod 被调度到带有污点的节点上

# 容忍了控制平面(Control-Plane)和主节点(Master)的污点,使得该pod可以在任意的节点上运行

tolerations:

- key: node-role.kubernetes.io/control-plane

operator: Exists

effect: NoSchedule

- key: node-role.kubernetes.io/master

operator: Exists

effect: NoSchedule

# pod说明 - container说明

containers:

- name: fluentd-elasticsearch # 容器的名称

image: quay.io/fluentd_elasticsearch/fluentd:v2.5.2 # 使用的镜像

resources: # 资源说明

limits:

memory: 200Mi

requests:

cpu: 100m

memory: 200Mi

# 日志收集器需要访问节点上的文件系统。

# 这里使用了 hostPath 卷,将节点上的目录

# 如 /var/log 和 /var/lib/docker/containers挂载到 Pod 的容器内部。

# 这样,Fluentd 容器就能读取这些目录下的日志文件了。

volumeMounts: # 挂载说明

- name: varlog

mountPath: /var/log

- name: varlibdockercontainers

mountPath: /var/lib/docker/containers

readOnly: true

- name: config-volume

mountPath: /etc/fluent/fluent.conf

subPath: fluent.conf

terminationGracePeriodSeconds: 30

volumes: # 数据卷说明

- name: varlog

hostPath:

path: /var/log

- name: varlibdockercontainers

hostPath:

path: /var/lib/docker/containers

- name: config-volume

configMap:

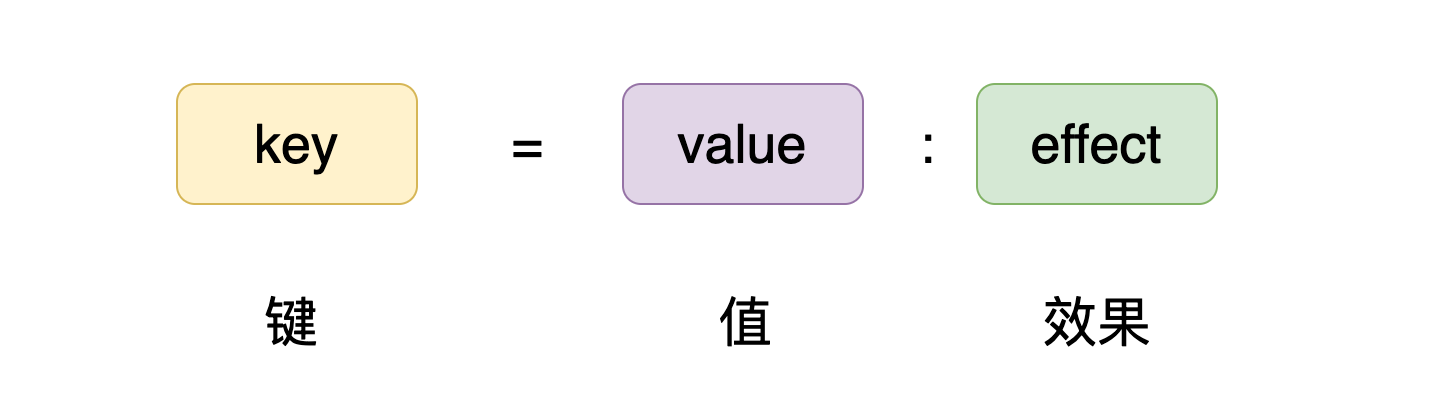

name: fluentd-config4.5:容忍度和污点

容忍度是deamonSet非常重要的概念,Kubernetes 集群的主节点(Master) 通常自带一个污点(Taint)

例如上面说明的:node-role.kubernetes.io/control-plane:NoSchedule

污点的存在可以:防止普通工作负载 Pod 被调度到主节点上。

如果我们希望 DaemonSet 的 Pod(如日志收集器)也能在主节点上运行,就必须在 Pod 模板中声明相应的 tolerations,表示"我容忍这个污点,请允许我调度上去"。

例如上面的例子中:Pod 容忍了控制平面(Control-Plane)和主节点(Master)的污点,因此它可以在所有节点(包括主节点) 上运行。

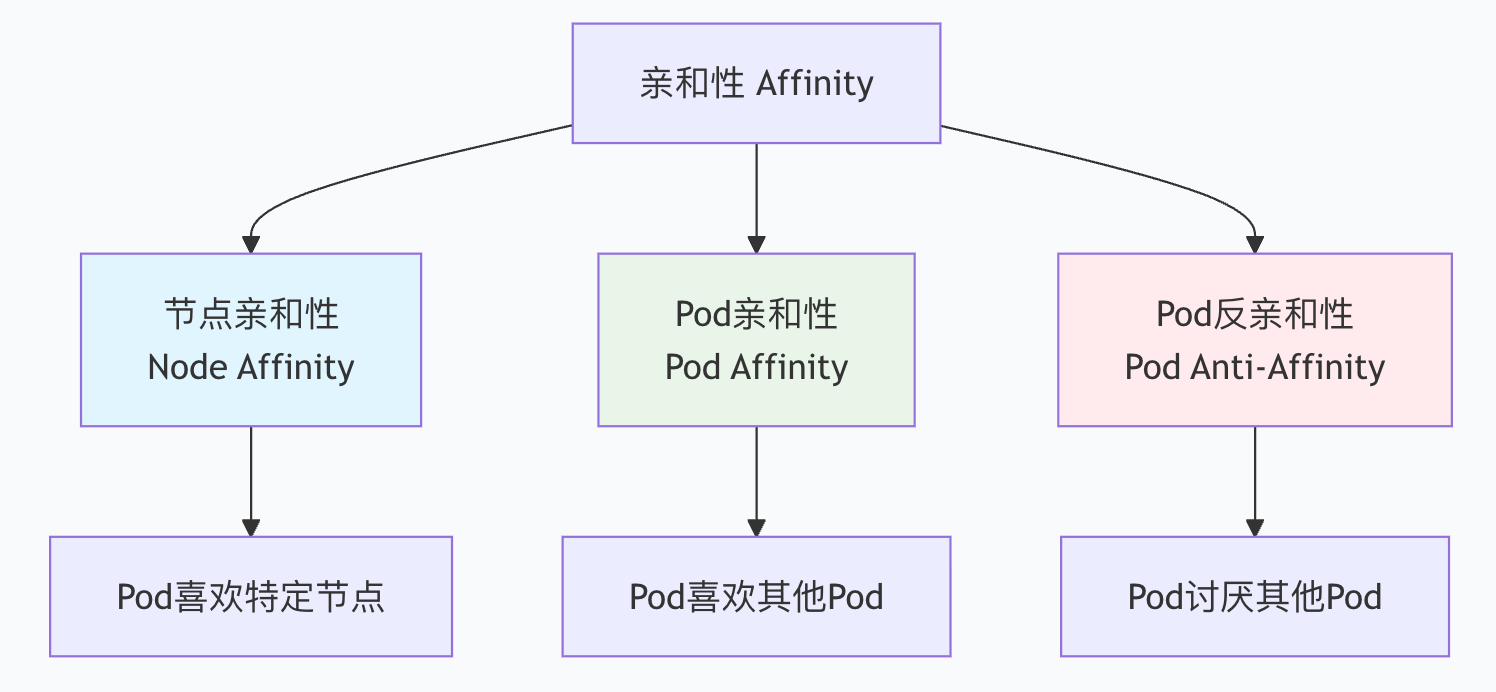

4.6:如何控制 DaemonSet 的运行范围

你并不总是希望 DaemonSet 在所有节点上运行。可以通过以下两种方式控制:

nodeSelector - 节点选择器

只在带有特定标签的节点上运行。

- 先给节点打上标签

kubectl label nodes <node-name> disktype=ssd - 然后在 DaemonSet 的

spec.template.spec中配置nodeSelector:

yaml

spec:

template:

spec:

nodeSelector:

disktype: ssd

containers:

- ...样,DaemonSet 只会在标签为 disktype=ssd 的节点上创建 Pod。

使用

nodeAffinity(节点亲和性)

nodeAffinity 提供了比 nodeSelector 更强大、更灵活的表达式来控制 Pod 的调度。

yaml

spec:

template:

spec:

affinity:

nodeAffinity:

requiredDuringSchedulingIgnoredDuringExecution:

nodeSelectorTerms:

- matchExpressions: # 这表示 Pod 只能被调度到带有 disktype 标签,且值为 ssd 或 nvme 的节点上。

- key: disktype

operator: In

values:

- ssd

- nvme

containers:

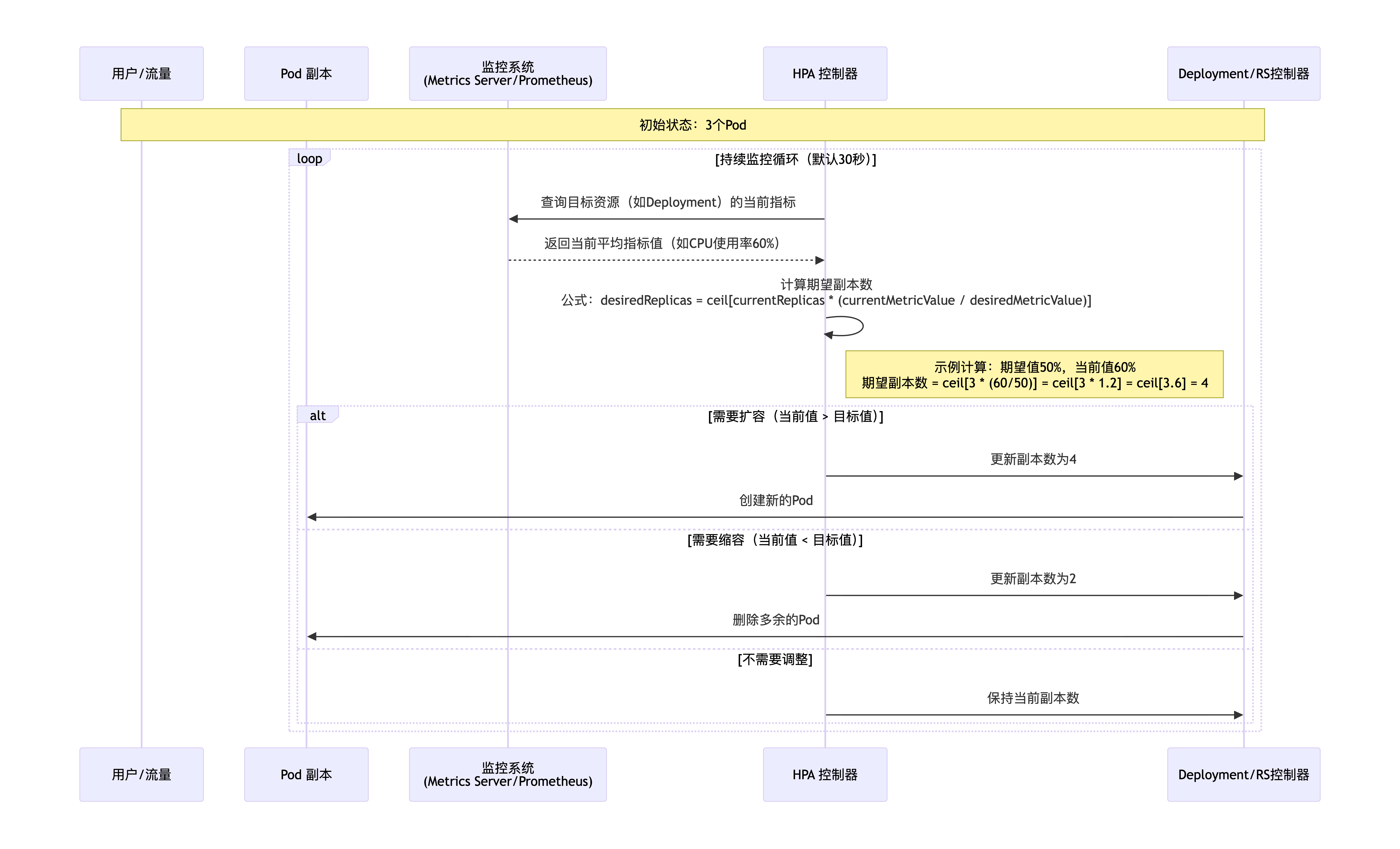

- ...5:HPA 自动扩/缩容

HPA 是一种控制器,它能根据实时监控到的应用负载(如 CPU 使用率、内存使用率或其他自定义指标),自动地调整 Pod 的数量,以确保应用始终有适量的资源来处理流量。

在传统运维中:

- 流量高峰时,需要手动扩容 Pod 数量,响应慢,容易出错。

- 流量低谷时,需要手动缩容,否则造成资源浪费。

HPA 解决了这个痛点,实现了 "按需分配、弹性伸缩" 的云原生核心理念。

5.1:关键组件

指标来源 - Metrics Source

- Metrics Server:核心指标,如 CPU/内存使用率(必须安装)。

- Custom Metrics API:自定义指标,如 QPS(每秒查询数)、请求延迟等(需额外组件如 Prometheus Adapter)。

HPA Controller

- 定期(默认每 30 秒)检查目标资源(如 Deployment、StatefulSet)的指标。

- 根据当前指标值与目标值的比例,计算期望的 Pod 副本数。

- 更新目标资源(如 Deployment)的

replicas字段。

工作负载控制器

- Deployment、ReplicaSet 或 StatefulSet 控制器检测到

replicas字段变化,然后创建或删除 Pod

5.2:核心算法

HPA的核心算法是,当检测到目标资源的指标后,如何计算出对应的副本数

期望副本数 = ceil[当前副本数 * (当前指标值 / 目标指标值)]假设一个 Deployment 当前有 3 个 Pod,HPA 配置的目标 CPU 使用率为 50%。

场景:需要扩容

- 当前平均 CPU 使用率:60%

- 计算:

期望副本数 = ceil[3 * (60 / 50)] = ceil[3 * 1.2] = ceil[3.6] = 4 - 结果:HPA 会将 Pod 数扩容到 4 个

场景:需要缩容

- 当前平均 CPU 使用率:30%

- 计算:

期望副本数 = ceil[3 * (30 / 50)] = ceil[3 * 0.6] = ceil[1.8] = 2 - 结果:HPA 会将 Pod 数缩容到 2 个

5.3:一个完整的示例

第一步:准备Metrics Server

bash

# 使用 kubectl 安装(以最新版本为例)

kubectl apply -f https://github.com/kubernetes-sigs/metrics-server/releases/latest/download/components.yaml

# 验证安装

kubectl top nodes

kubectl top pods第二步:创建一个deployment(这里测试)

yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: php-apache

spec:

selector:

matchLabels:

run: php-apache

replicas: 1

template:

metadata:

labels:

run: php-apache

spec:

containers:

- name: php-apache

image: k8s.gcr.io/hpa-example

ports:

- containerPort: 80

resources:

requests:

cpu: 200m # 非常重要!HPA 依赖 requests 进行计算

memory: 256Mi

limits:

cpu: 500m

memory: 512Mi

---

apiVersion: v1

kind: Service

metadata:

name: php-apache

labels:

run: php-apache

spec:

ports:

- port: 80

selector:

run: php-apache🔴 必须设置 resources.requests,否则 HPA 无法计算 CPU 使用率百分比。

第三步:创建HPA

yaml

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler # 指定kind = HPA

metadata:

name: php-apache-hpa

spec:

scaleTargetRef:

apiVersion: apps/v1

kind: Deployment

name: php-apache # 指向要自动扩缩容的 Deployment

minReplicas: 1 # 最小副本数

maxReplicas: 10 # 最大副本数

metrics:

- type: Resource

resource:

name: cpu

target:

type: Utilization # 使用率模式

averageUtilization: 50 # 目标 CPU 使用率:50%

behavior: # 扩缩容行为配置(v2beta2+ 版本特性)

scaleDown:

stabilizationWindowSeconds: 300 # 缩容稳定窗口:5分钟

policies:

- type: Percent

value: 10

periodSeconds: 60

scaleUp:

stabilizationWindowSeconds: 0 # 扩容立即执行

policies:

- type: Percent

value: 100

periodSeconds: 15扩展 - 扩缩容行为配置

这是 HPA v2 的强大特性,可以防止 Pod 数量剧烈波动:

yaml

behavior:

scaleDown: # 缩容策略

stabilizationWindowSeconds: 300 # 稳定窗口:指标下降后等待5分钟再缩容

policies:

- type: Percent # 百分比策略

value: 10 # 每次最多减少当前副本数的10%

periodSeconds: 60 # 每60秒评估一次

- type: Pods # 绝对值策略

value: 2 # 每次最多减少2个Pod

periodSeconds: 60

selectPolicy: Min # 取最保守的策略(取最小值)

scaleUp: # 扩容策略

stabilizationWindowSeconds: 0 # 0表示立即扩容

policies:

- type: Percent

value: 100 # 每次最多增加当前副本数的100%(即翻倍)

periodSeconds: 15 # 每15秒评估一次5.4:观察HPA工作

最常见的就是检查指定的HPA的工作状态

bash

# 查看 HPA 详细信息

kubectl describe hpa php-apache-hpa

# 输出示例:

Name: php-apache-hpa

Namespace: default

Labels: <none>

Annotations: <none>

CreationTimestamp: Mon, 01 Jan 2023 12:00:00 +0800

Reference: Deployment/php-apache

Metrics: ( current / target )

resource cpu on pods (as a percentage of request): 0% (0) / 50%

Min replicas: 1

Max replicas: 10

Deployment pods: 1 current / 1 desired

Conditions:

Type Status Reason Message

---- ------ ------ -------

AbleToScale True ReadyForNewScale recommended size matches current size

ScalingActive True ValidMetricFound the HPA was able to successfully calculate...

ScalingLimited False DesiredWithinRange the desired count is within the acceptable range

Events: <none>我们上面已经部署了一个

php-apache应用(Deployment + Service)同时创建了一个 HPA,目标是保持 CPU 使用率在 50%

现在我们要模拟线上流量,观察 HPA 如何自动响应

bash

kubectl run \ # 创建一个 Pod

-i --tty \ # 交互式终端,允许我们与容器交互(但这里实际是自动运行命令)

load-generator \ # Pod 名称

--rm \ # Pod 退出后自动删除

--image=busybox \ # 使用轻量级 busybox 镜像

--restart=Never -- \ # Pod 退出后不重启, -- 是分隔 kubectl 参数和容器命令

/bin/sh -c "while sleep 0.01; do wget -q -O- http://php-apache; done" # 每 10 毫秒就向我们的 php-apache 服务发送一次 HTTP 请求,持续不断。使用无限循环的内部指令,不断的提升php-apache CPU占用率,观察HPA的行动

bash

# 持续观察 HPA 的变化

watch -n 1 kubectl get hpa php-apache-hpa

# ------ 初始状态

NAME REFERENCE TARGET MINPODS MAXPODS REPLICAS AGE

php-apache-hpa Deployment/php-apache 0%/50% 1 10 1 5m

# 启动创建load-generator Pod脚本后,等待大约 30-60 秒(HPA 默认检查间隔),你会看到:

NAME REFERENCE TARGET MINPODS MAXPODS REPLICAS AGE

php-apache-hpa Deployment/php-apache 45%/50% 1 10 1 6m

# 触发扩容

NAME REFERENCE TARGET MINPODS MAXPODS REPLICAS AGE

php-apache-hpa Deployment/php-apache 68%/50% 1 10 1 6m30s

# 这里显示 68% 但 REPLICAS 还是 1,因为 HPA 刚检测到,还没执行扩容

NAME REFERENCE TARGET MINPODS MAXPODS REPLICAS AGE

php-apache-hpa Deployment/php-apache 68%/50% 1 10 2 7m

# 新 Pod 就绪,负载均衡

NAME REFERENCE TARGET MINPODS MAXPODS REPLICAS AGE

php-apache-hpa Deployment/php-apache 35%/50% 1 10 2 8m

# 停止负载脚本,观察缩容

NAME REFERENCE TARGET MINPODS MAXPODS REPLICAS AGE

php-apache-hpa Deployment/php-apache 5%/50% 1 10 2 15m

NAME REFERENCE TARGET MINPODS MAXPODS REPLICAS AGE

php-apache-hpa Deployment/php-apache 5%/50% 1 10 1 16m5.5:HPA 的最佳实践与注意事项

最佳实践

- 设置合理的 requests:这是 HPA 计算的基础

- 使用 readinessProbe:确保新 Pod 完全就绪后再纳入负载计算

- 配置 behavior:防止抖动,尤其是

scaleDown.stabilizationWindowSeconds - 渐进式扩缩容:设置

policies避免副本数突变 - 监控 HPA 事件:

kubectl describe hpa查看 Events - 预热期设置:对于 JVM 等需要预热的应用,适当延长扩容等待时间

使用HPA常见的问题

HPA 不工作:

- 检查 Metrics Server 是否安装

- 检查 Pod 是否设置了

resources.requests - 检查

kubectl top pods能否获取指标

扩容太激进或缩容太快:

- 调整

behavior配置 - 增加

stabilizationWindowSeconds

使用自定义指标:

- 需要安装 Prometheus + Prometheus Adapter

- 确保指标名称和格式正确

5.6:和其他的扩缩容对比

| 特性 | HPA(水平扩缩容) | VPA(垂直扩缩容) | Cluster Autoscaler(集群扩缩容) |

|---|---|---|---|

| 扩缩对象 | Pod 数量 | Pod 资源 requests/limits | 节点数量 |

| 调整方式 | 增减 Pod | 调整单个 Pod 的 CPU/内存 | 增减工作节点 |

| 适用场景 | 无状态应用 | 有状态/无状态应用 | 节点资源不足时 |

| 重启 Pod | 不需要(新创建) | 需要(更新资源) | 不需要 |

四:服务发布

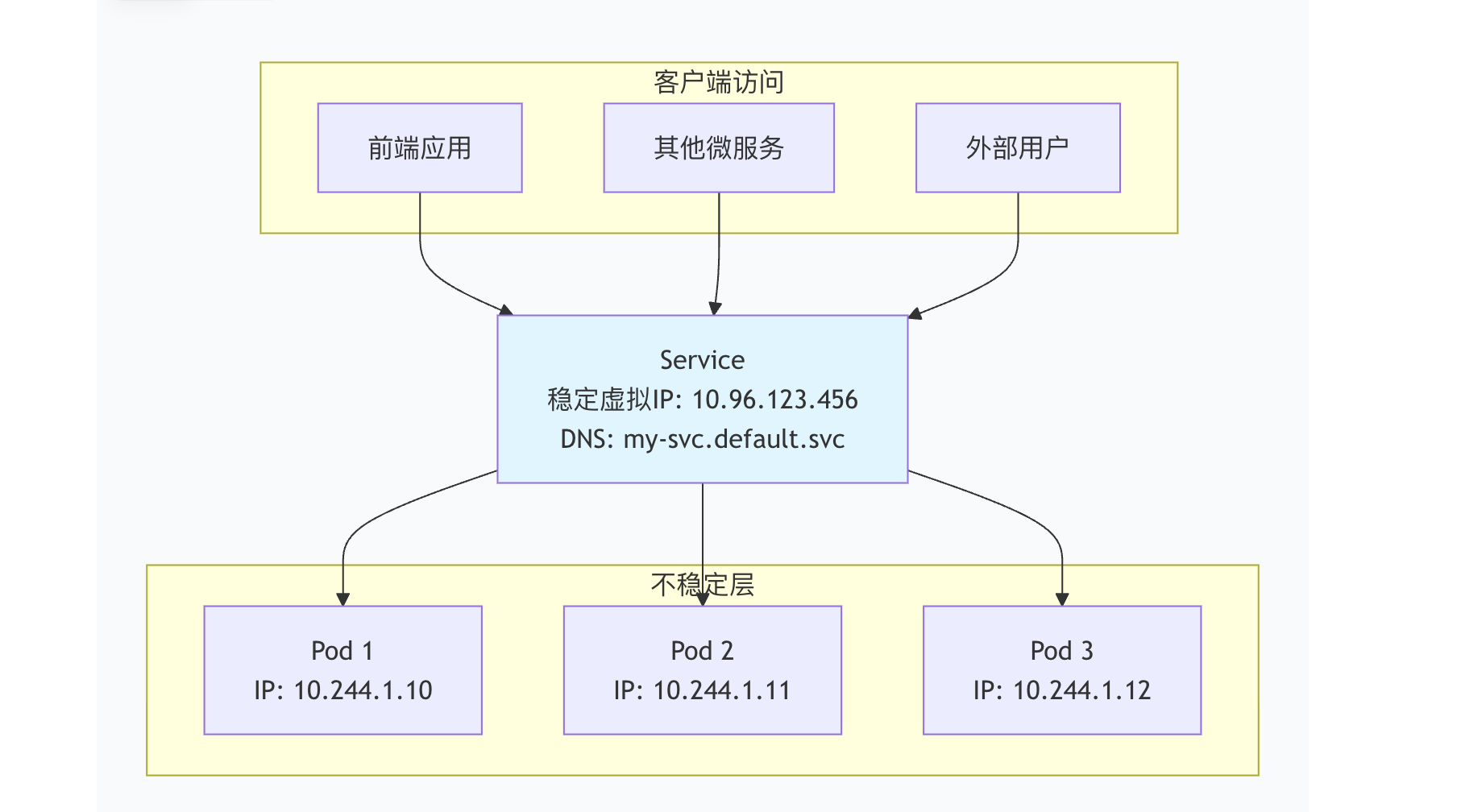

1:service(重点)

在学习service前,先说说为什么需要service,核心原因是pod的问题

- 动态 IP:Pod 的 IP 地址不是固定的。当 Pod 重启、迁移或扩缩容时,IP 会变化。

- 多个副本:一个 Deployment 可能有多个 Pod 副本,每个都有不同的 IP。

- 健康检查:如何知道哪个 Pod 是健康的,可以接收流量?

如果没有service,每次 Pod 变化,你都需要手动更新所有依赖它的应用配置,这在动态的 Kubernetes 环境中完全不可行。

1.1:service的本质

service的本质就是在pod之上创建了一个稳定的抽象层:

service的核心价值

稳定的虚拟 IP(ClusterIP):客户端只需要记住这个 IP

负载均衡:将请求均匀分发到后端的健康 Pod

服务发现:通过 DNS 名称访问服务

会话保持:可选地将同一客户端的请求转发到同一 Pod

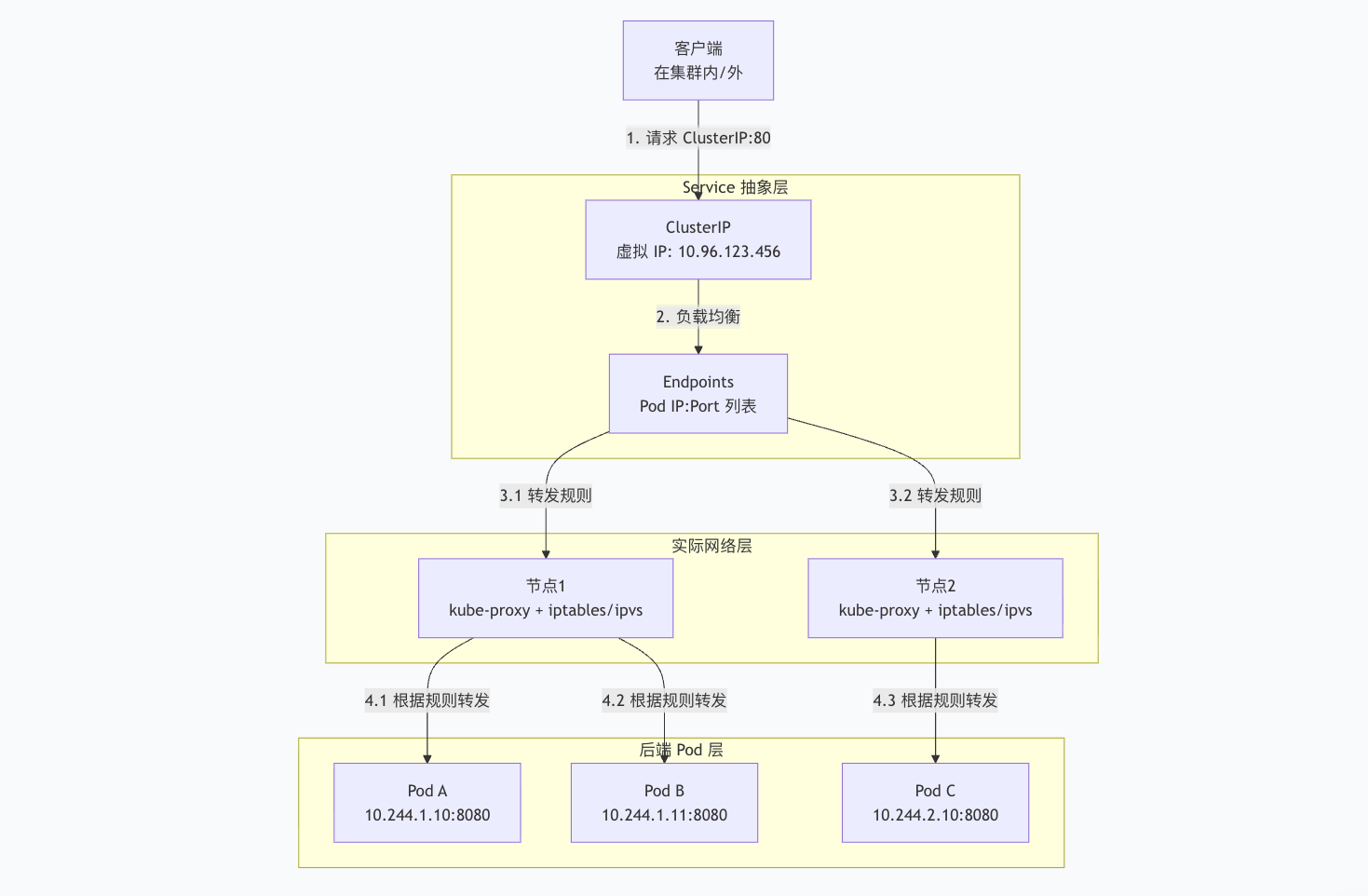

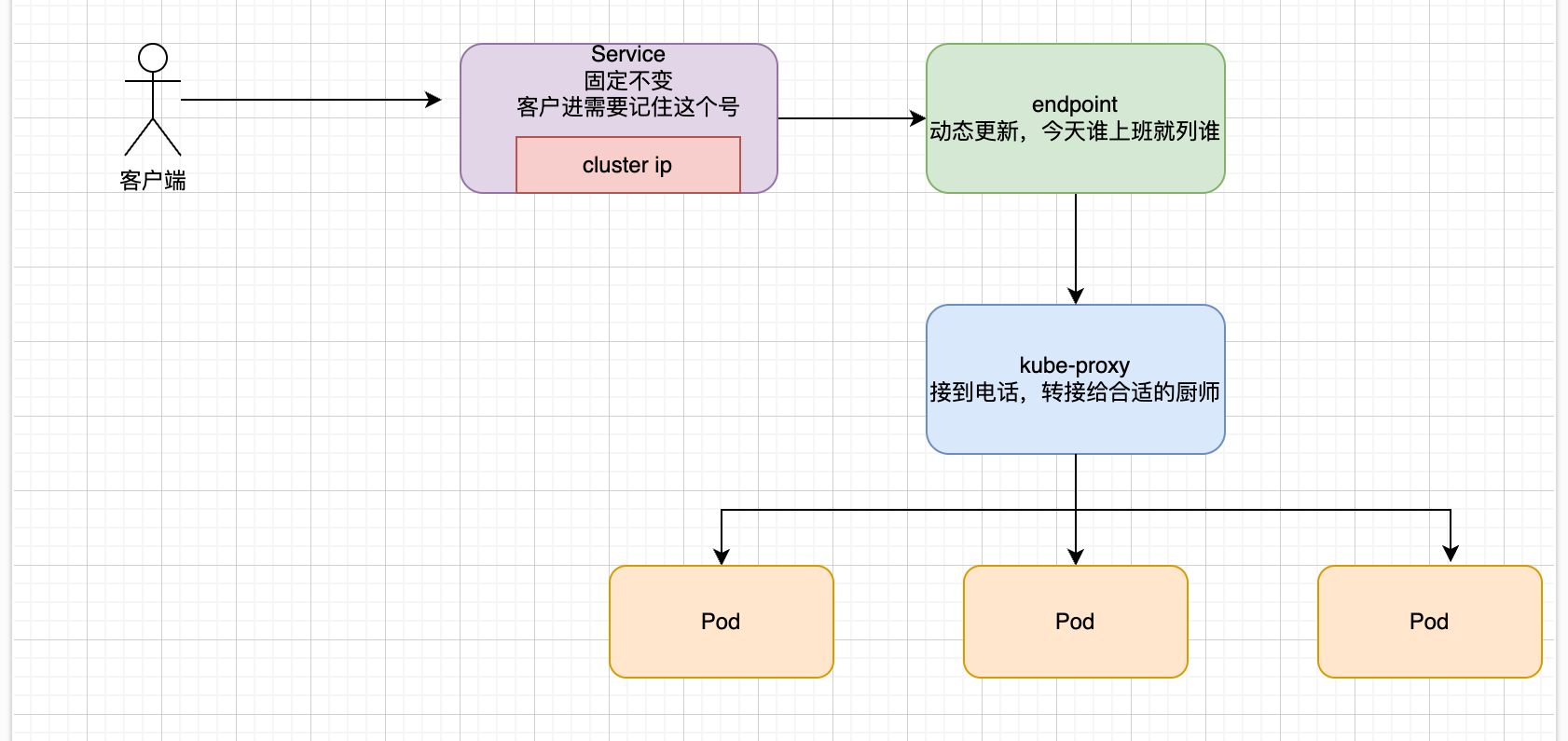

1.2:service工作原理

整体结构

Service 本身不转发流量,它只是规则的制定者,真正干活的是节点上的网络组件

核心组件

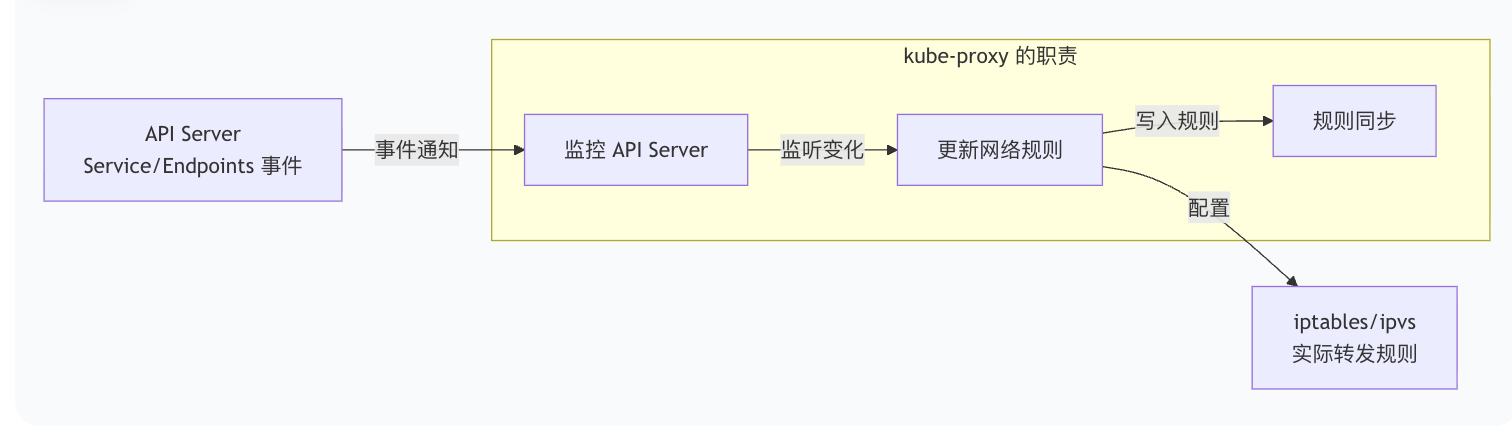

1️⃣ kube-proxy:流量的实际指挥者

kube-proxy 不是传统意义上的代理(proxy),它不直接转发数据包。它的核心工作是:

Kube-proxy主要有iptables模式、ipvs模式和userspace模式(已被废弃)

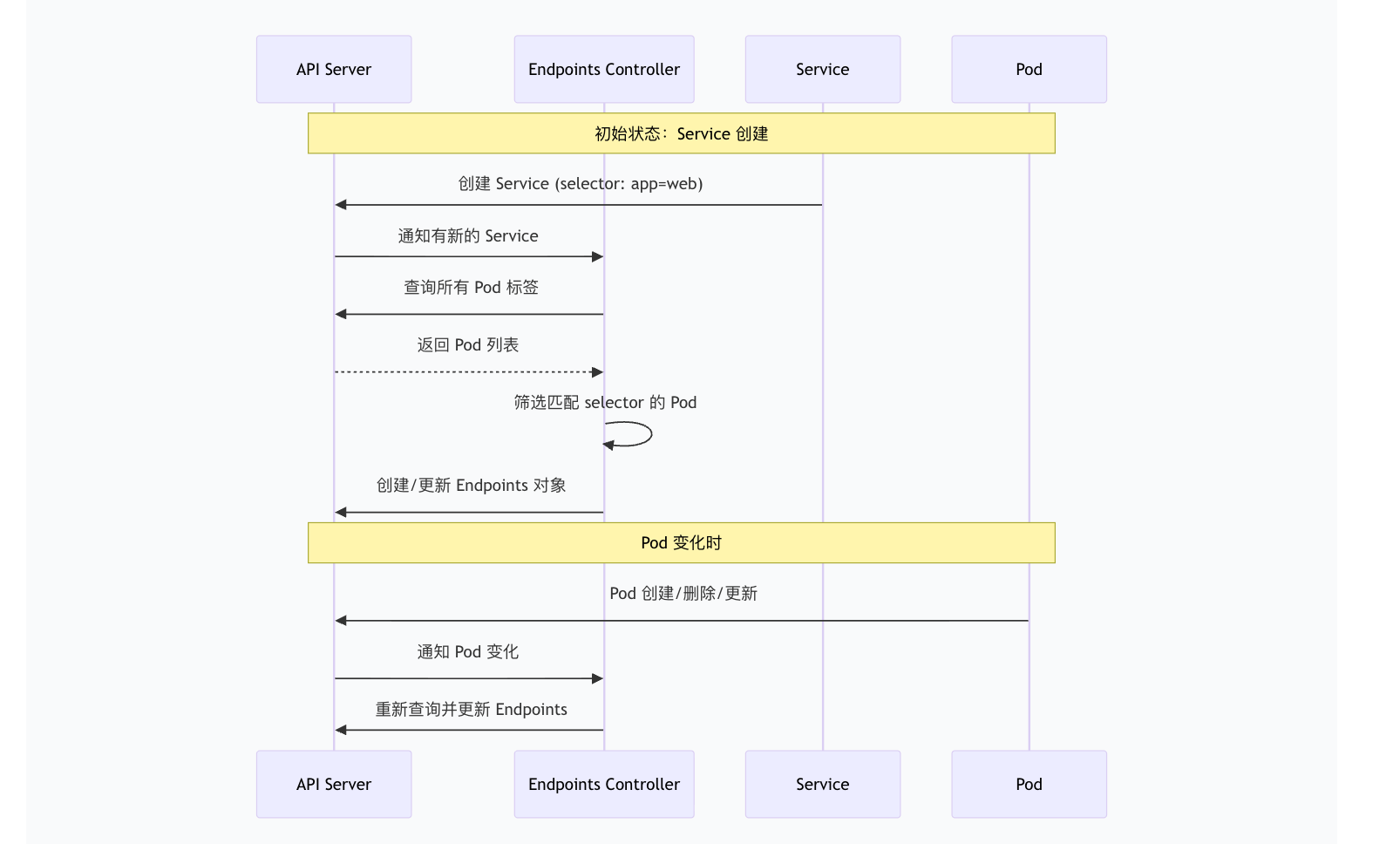

2️⃣ endpoints控制器:Pod的追踪器

Endpoints 控制器是 kube-controller-manager 的一部分,它的工作流:

bash

# 查看 Service 的 Endpoints

kubectl get endpoints my-service -o yaml

yaml

# 输出示例:

apiVersion: v1

kind: Endpoints

metadata:

name: my-service

namespace: default

subsets:

- addresses:

- ip: 10.244.1.10

nodeName: node1

targetRef:

kind: Pod

name: web-pod-1

- ip: 10.244.1.11

nodeName: node1

targetRef:

kind: Pod

name: web-pod-2

ports:

- port: 8080

protocol: TCP如果 Endpoints 为空,说明没有 Pod 匹配 Service 的 selector!

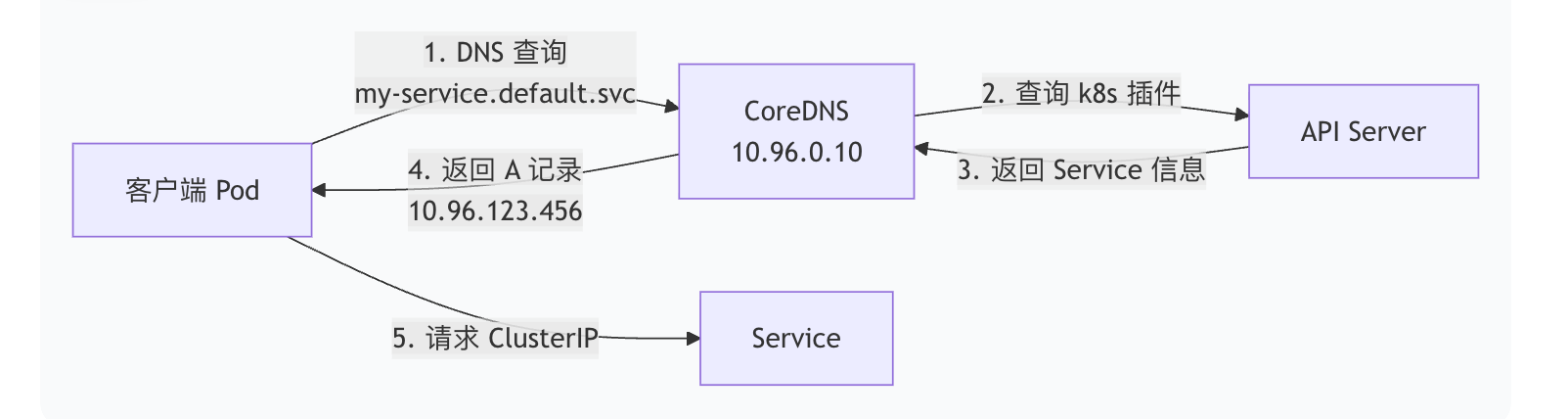

3️⃣ coreDNS:服务的电话本

coreDNS为service提供DNS解析

bash

# 在 Pod 中测试 DNS

kubectl run -it --rm --image=busybox dns-test -- /bin/sh

# 查询完整域名

nslookup my-service.default.svc.cluster.local

# 查询同一命名空间内的服务(简写)

nslookup my-service

# 查询不同命名空间

nslookup my-service.other-namespace

# 对于 Headless Service(clusterIP: None)

nslookup headless-service

# 返回所有 Pod IP,而不是 Service IP把 Service 想象成一个餐厅的订餐热线:

| 组件 | 餐厅类比 | 说明 |

|---|---|---|

| Service | 订餐热线号码 | 固定不变,客户只需记住这个号 |

| ClusterIP | 热线总机号码 | 虚拟号码,不直接对应厨师 |

| Endpoints | 值班厨师名单 | 动态更新,谁今天上班就列谁 |

| kube-proxy | 接线员系统 | 接到电话,转接给合适的厨师 |

| Pod | 厨师 | 实际做菜的人,可能换班、请假 |

| 客户端 | 顾客 | 只打电话,不关心哪个厨师做菜 |

- 配置阶段:餐厅设置热线电话,登记今天上班的厨师

- 接线阶段:接线员系统学习:热线→厨师1、热线→厨师2...

- 服务阶段:顾客打电话→接线员接听→转给空闲厨师→厨师做菜→送回给顾客

所以:Service = 稳定的虚拟IP + 动态的Pod发现 + 智能的负载均衡

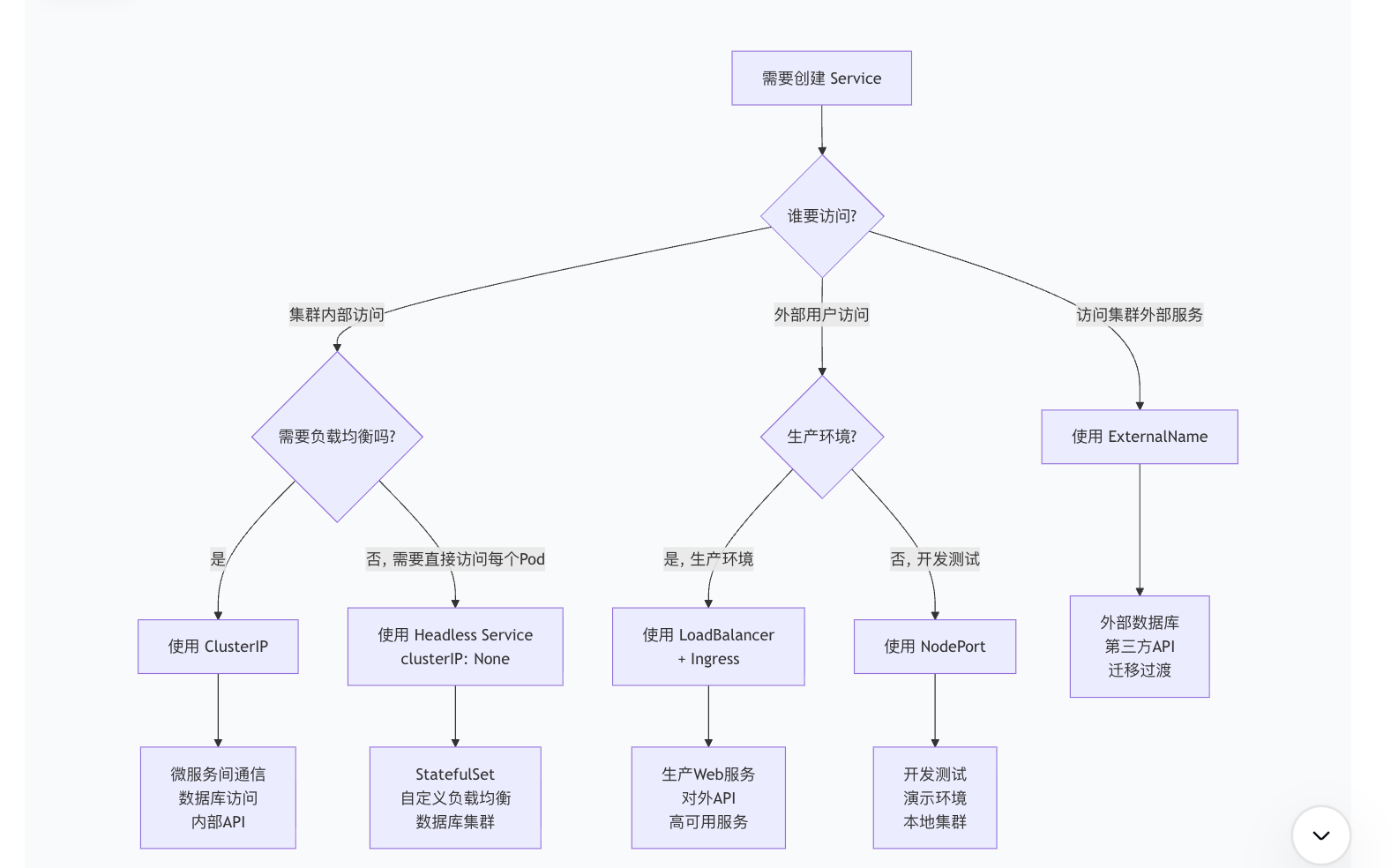

1.3:service类型

clusterIP -> 集群内部服务 -> 默认类型

clusterIP分配一个集群内部的虚拟 IP 地址(在 Service CIDR 范围内,如 10.96.0.0/12),只能从集群内部访问

yaml

apiVersion: v1

kind: Service

metadata:

name: backend-api

spec:

type: ClusterIP # 可省略,默认就是 ClusterIP

selector:

app: backend

ports:

- port: 80 # Service 对外的端口

targetPort: 8080 # Pod 监听的端口

protocol: TCP 上面是指定service类型为clusterIP的定义,可以通过如下的方式进行访问

bash

# 方式1:使用 DNS 名称(推荐)

# 在同一命名空间内

curl http://backend-api

# 在不同命名空间

curl http://backend-api.dev.svc.cluster.local

# 方式2:使用 ClusterIP

# 先获取 ClusterIP

kubectl get svc backend-api

# NAME TYPE CLUSTER-IP PORT(S)

# backend-api ClusterIP 10.96.123.456 80/TCP

curl http://10.96.123.456| 场景 | 说明 | 示例 |

|---|---|---|

| 微服务间通信 | 服务之间内部调用 | 前端调用用户服务 |

| 数据库访问 | 应用访问数据库 | Web应用访问 MySQL |

| 内部API | 不对外暴露的API | 监控API、管理API |

| 缓存访问 | 访问Redis/Memcached | 应用访问Redis缓存 |

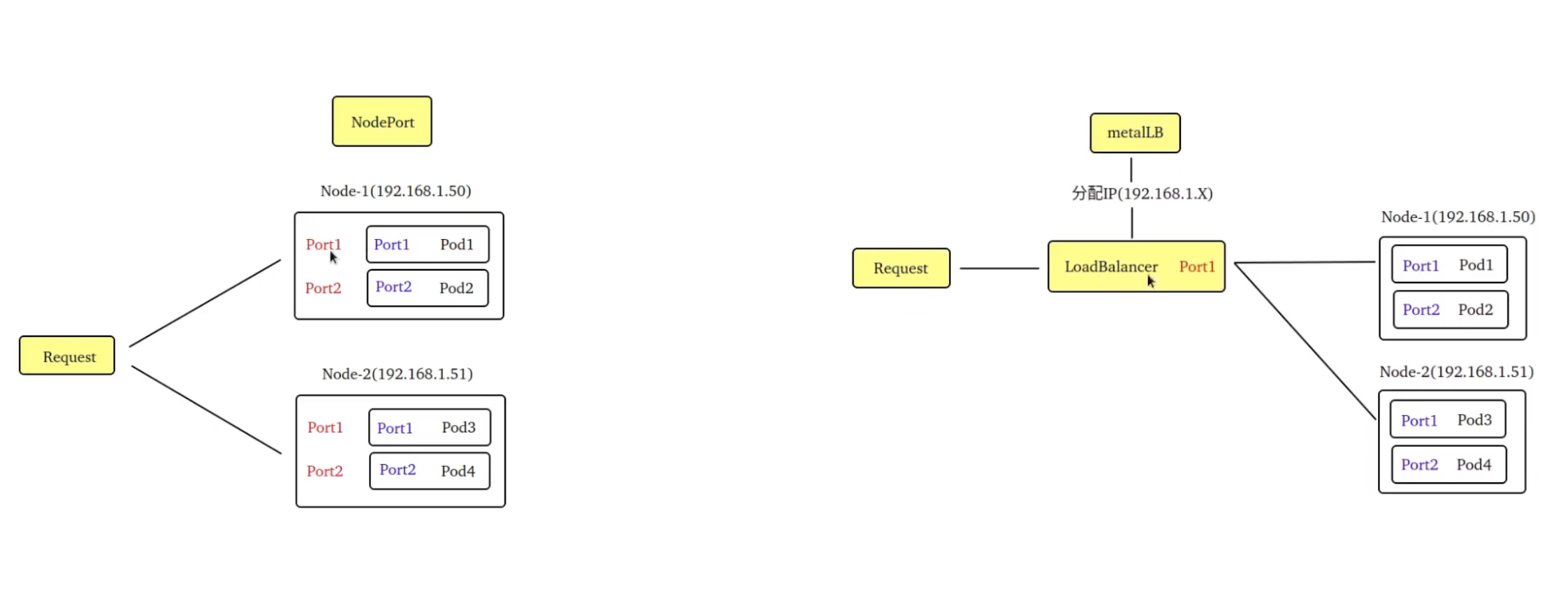

nodeport -> 节点端口服务

在每个节点上打开一个固定端口(30000-32767),外部用户可以通过 任何节点的IP:NodePort 访问服务。

yaml

apiVersion: v1

kind: Service

metadata:

name: web-app

spec:

type: NodePort

selector:

app: web

ports:

- port: 80 # Service 端口(集群内部用)

targetPort: 8080 # Pod 端口

nodePort: 31080 # 节点端口(可选,不指定则随机分配)

bash

# 1. 查看分配的 NodePort

kubectl get svc web-app

# NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S)

# web-app NodePort 10.96.123.456 <none> 80:31080/TCP

# ↑节点端口

# 2. 通过节点IP访问(假设节点IP是 192.168.1.100)

curl http://192.168.1.100:31080

curl http://192.168.1.101:31080 # 另一个节点也可以| 场景 | 说明 | 优点 | 缺点 |

|---|---|---|---|

| 开发测试 | 快速验证服务 | 简单,无需额外配置 | 端口范围有限 |

| 演示环境 | 给客户演示 | 直接访问,无需域名 | 需要知道节点IP |

| 没有云负载均衡器 | 本地/裸机集群 | 不依赖云服务 | 需要外部负载均衡 |

| 临时外部访问 | 临时暴露服务 | 快速启用 | 生产环境不推荐 |

在nodeport可以指定流量路径:

yaml

spec:

type: NodePort

externalTrafficPolicy: Local # 或者Cluster(默认的流量路径是cluster)- Cluster:流量可能跨节点,丢失真实客户端IP

- Local:保留客户端IP,但要求节点上有 Pod(否则连接失败)

LoadBalance -> 云负载均衡器

LoadBalancer 是 NodePort 的升级版,它会自动创建云厂商的负载均衡器(如 AWS ELB、GCP Load Balancer、Azure LB),并提供外部 IP 或 DNS 名称。

yaml

apiVersion: v1

kind: Service

metadata:

name: production-web

spec:

type: LoadBalancer

selector:

app: web

ports:

- port: 80

targetPort: 8080

# 云厂商特定注解

# metadata:

# annotations:

# service.beta.kubernetes.io/aws-load-balancer-type: "nlb"

bash

# 查看 LoadBalancer 分配的外部 IP/DNS

kubectl get svc production-web

# NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S)

# production-web LoadBalancer 10.96.123.456 203.0.113.100 80:31080/TCP

# ↑云厂商分配的外部IP

# 外部访问

curl http://203.0.113.100

# 或者使用云厂商分配的 DNS

curl http://xxx.elb.amazonaws.com| 场景 | 说明 | 云厂商配置示例 |

|---|---|---|

| 生产环境 Web 服务 | 对外提供 Web 服务 | AWS: ELB/NLB |

| API 网关 | 对外 API 入口 | GCP: HTTP(S) Load Balancer |

| 需要 SSL 终止 | HTTPS 服务 | Azure: Application Gateway |

| 高可用需求 | 多区域负载均衡 | 跨可用区部署 |

下面是阿里云配置示例:

yaml

apiVersion: v1

kind: Service

metadata:

name: aliyun-lb-service

annotations: # 注解说明

service.beta.kubernetes.io/alibaba-cloud-loadbalancer-address-type: "intranet"

service.beta.kubernetes.io/alibaba-cloud-loadbalancer-charge-type: "paybybandwidth"

spec:

type: LoadBalancerExternalName -> 外部服务代理

ExternalName 是一种特殊的 Service,它没有 selector,也不创建 Endpoints,而是返回一个 DNS CNAME 记录,将 Service 名称重定向到外部域名。

yaml

apiVersion: v1

kind: Service

metadata:

name: external-database

spec:

type: ExternalName

externalName: database.company.com # 外部服务地址

bash

集群内部访问: http://external-database.default.svc

↓

DNS 解析时返回 CNAME 记录

↓

实际解析到: database.company.com

↓

访问外部服务| 场景 | 说明 | 示例 |

|---|---|---|

| 访问外部数据库 | 迁移过程中访问云数据库 | AWS RDS, Cloud SQL |

| 第三方API | 访问外部 SaaS 服务 | Stripe, SendGrid API |

| 混合云架构 | 访问本地数据中心服务 | 本地 Oracle 数据库 |

| 逐步迁移 | 从外部服务迁移到内部 | 临时重定向 |

选择树

一个完整的电商服务配置

yaml

# 1. 前端 Web(对外访问)

apiVersion: v1

kind: Service

metadata:

name: frontend-web

annotations:

service.beta.kubernetes.io/aws-load-balancer-ssl-cert: "arn:aws:acm:..."

spec:

type: LoadBalancer # 生产环境对外

ports:

- name: https

port: 443

targetPort: 3000

selector:

app: frontend

# 2. 后端 API(集群内部)

apiVersion: v1

kind: Service

metadata:

name: backend-api

spec:

type: ClusterIP # 内部服务

ports:

- port: 80

targetPort: 8080

selector:

app: backend

# 3. 数据库(有状态,直接访问每个实例)

apiVersion: v1

kind: Service

metadata:

name: mysql

spec:

clusterIP: None # Headless Service

ports:

- port: 3306

selector:

app: mysql

# 4. 外部支付网关

apiVersion: v1

kind: Service

metadata:

name: payment-gateway

spec:

type: ExternalName

externalName: api.stripe.com

# 5. Redis缓存(集群内部)

apiVersion: v1

kind: Service

metadata:

name: redis

spec:

type: ClusterIP

ports:

- port: 6379

selector:

app: redis| 特性 | ClusterIP | NodePort | LoadBalancer | ExternalName |

|---|---|---|---|---|

| 访问范围 | 集群内部 | 节点IP:端口 | 外部IP/DNS | 外部服务 |

| IP分配 | 虚拟ClusterIP | ClusterIP+节点端口 | 云厂商外部IP | 无 |

| 负载均衡 | 有 | 有 | 有(云LB) | 无 |

| 成本 | 免费 | 免费 | 云厂商收费 | 免费 |

| 生产适用 | 内部服务 | 不推荐 | 推荐 | 特殊场景 |

| 配置复杂度 | 简单 | 简单 | 中等(云特定) | 简单 |

| DNS | 集群内部DNS | 需知道节点IP | 外部DNS | CNAME重定向 |

🎉 黄金法则:

- 集群内部通信 → ClusterIP

- 生产环境对外 → LoadBalancer + Ingress

- 开发测试 → NodePort

- 有状态应用 → Headless Service

- 访问外部服务 → ExternalName

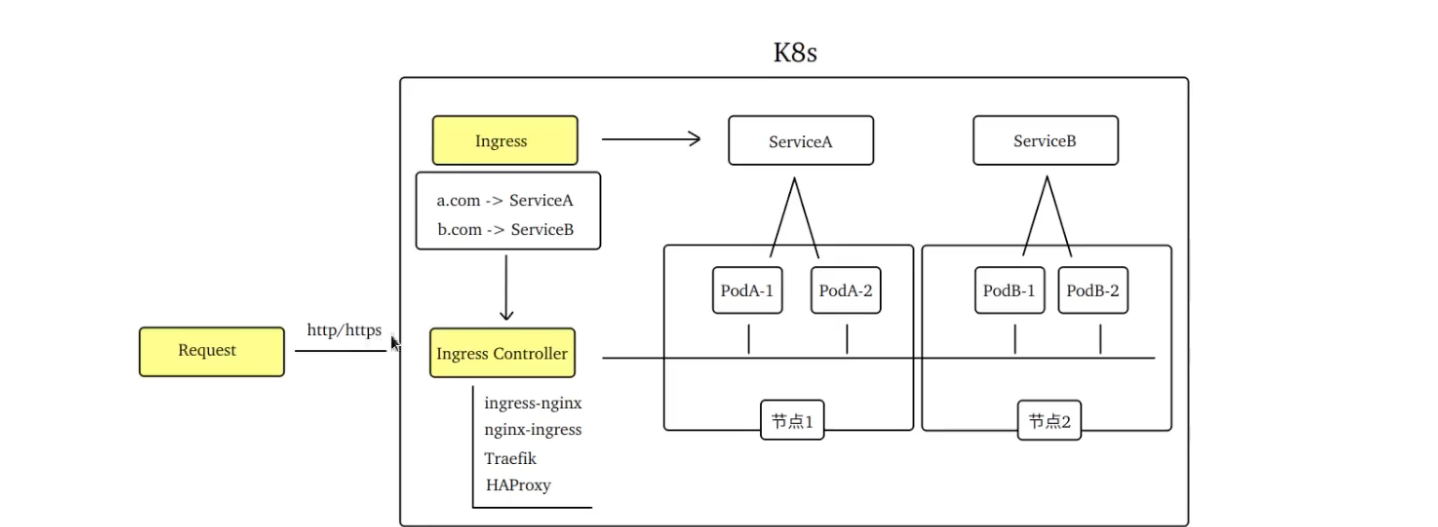

2:Ingress

2.1:Ingress介绍

Ingress 是 Kubernetes 的 API 对象,它管理外部访问集群内部服务的 HTTP 和 HTTPS 路由规则。

所以,简单来说:Ingress = HTTP/HTTPS 的路由规则管理器

Ingress充当了k8s的网关,负责接收外部的请求,并将请求根据既定的规则转发到正确的目标上(对外暴露service的一种方式)

为什么还有ingress呢,因为上面介绍的暴露service的两种方式都存在弊端

| 方式 | 优点 | 缺点 |

|---|---|---|

| nodePort | 简单直接,暴露节点的端口就可以了 | 占用节点端口,依赖节点(节点故障无法访问等等) |

| LoadBalance | 不占用节点端口,高可用(VIP漂移) | 需要单独的配置LB插件 |

2.2:Ingress工作原理

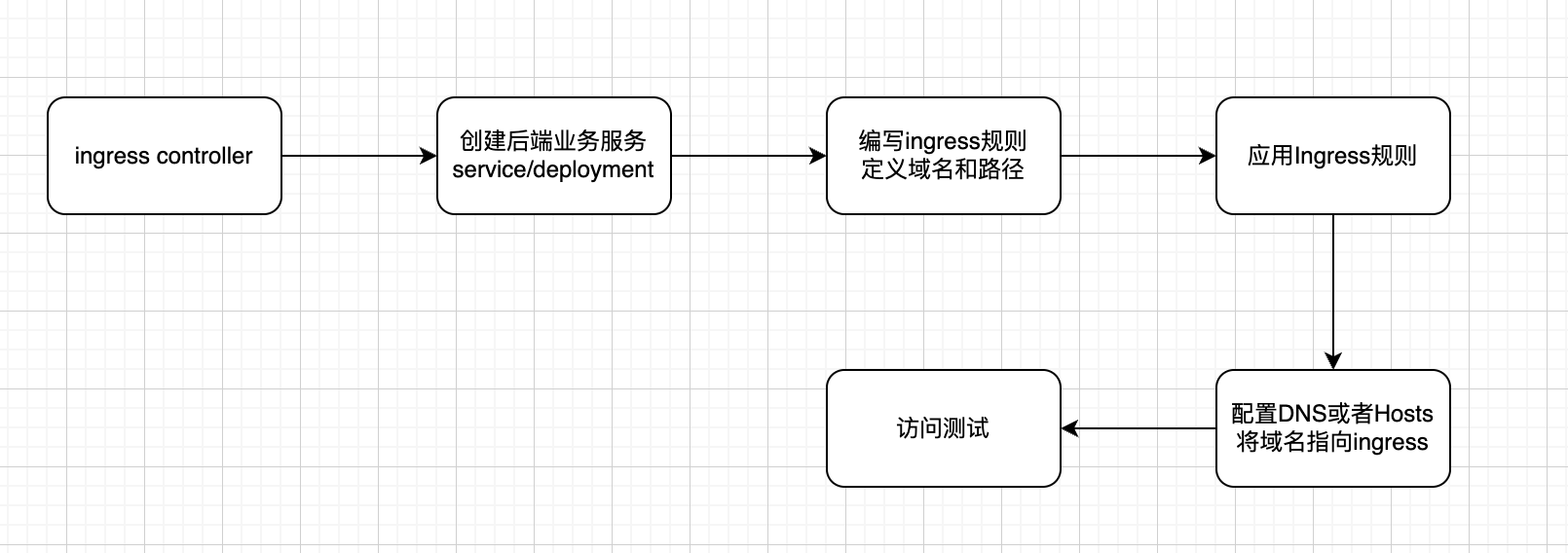

1.Ingress通过http/https对外暴露服务

- Ingress负责反代规则(哪个域名对应哪个service)

- Ingress Controller负责读取Ingress规则将请求转发至合适的Pod,并可动态感知Ingress规则变化

2.3:Ingress controller

Ingress Controller 是负责处理 Ingress 请求的组件。

Kubernetes 提供了多种 Ingress Controller,可以根据需要选择。以下是常用的 Ingress Controller:

- Nginx Ingress Controller:基于 Nginx 的 Ingress Controller,功能强大,易于配置。

- HAProxy Ingress Controller:基于 HAProxy 的 Ingress Controller,性能优异,适用于高并发场景。

- Contour Ingress Controller:基于 Envoy 的 Ingress Controller,功能丰富,适用于多云场景。

常规来说,我们一般使用nginx ingress, 先下载对应yaml文件 - [https://gitee.com/mirrors/ingress-nginx\]

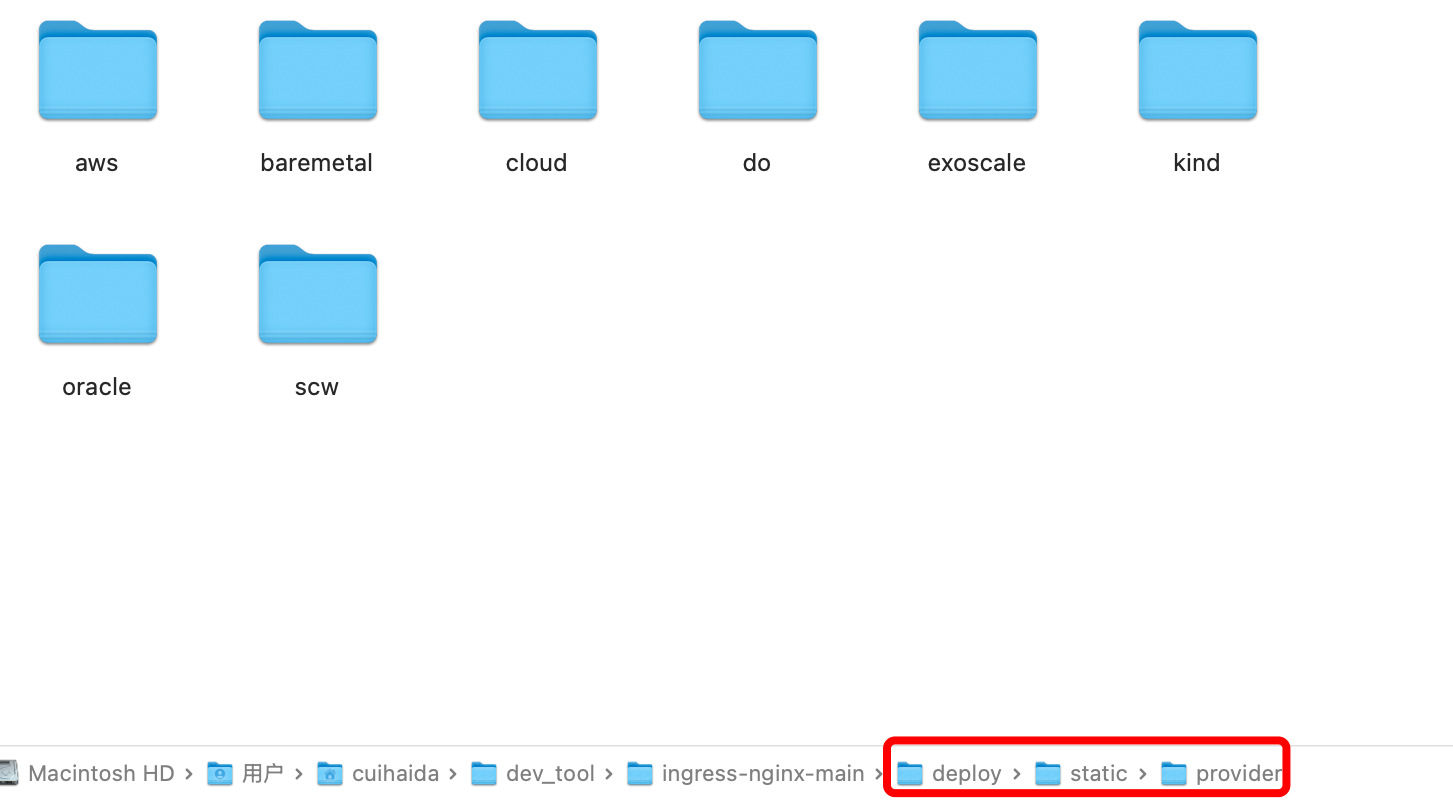

下载之后,在这个deploy/static/provider文件夹下发现有下面这么多文件夹:

对于大多数国内用户,如果你的Kubernetes集群是搭建在:

- 阿里云、腾讯云、华为云等公有云上 → 应选择

cloud目录下的deploy.yaml。 - 公司内部机房或家用服务器上 → 应选择

baremetal目录下的deploy.yaml。

bash

# 替换镜像

# 将文件中的 registry.k8s.io 镜像替换为国内源

# 使用sed命令一键替换(推荐)

sed -i 's|registry.k8s.io/ingress-nginx/|registry.aliyuncs.com/google_containers/|g' deploy.yaml

# 部署

kubectl apply -f deploy.yaml2.4:编写 ingress 规则

在部署好ingress controller之后,后续最为关键的就是要编写ingress规则

先部署一个测试的后端业务服务,这里使用最为经典的nginx

yaml

# nginx-app.yaml

apiVersion: apps/v1

kind: Deployment # 声明资源类型是deployment -> 无状态资源

metadata:

name: nginx-deployment # 声明名称

spec: # 设置规约值

replicas: 2 # 声明副本数为2

selector:

matchLabels:

app: nginx # 声明选择器是Pod中标签为nginx的

template: # 声明模板 -> pod

metadata:

labels:

app: nginx # 声明模板标签为nginx

spec: # 模板规约,容器的名称,使用的镜像,暴露的端口

containers:

- name: nginx

image: nginx:alpine

ports:

- containerPort: 80

---

apiVersion: v1

kind: Service # 声明资源的类型是Service, 东西流量,为了微服务之间的互相调用

metadata:

name: nginx-service

spec:

selector:

app: nginx # 声明选择器是nginx的App

ports:

- protocol: TCP

port: 80

targetPort: 80

type: ClusterIP # 使用clusterIP的service类型

bash

kubectl apply -f nginx-app.yaml创建 Ingress 规则(核心步骤)

这是最关键的一步,它定义了外部访问的路由规则。

以下是一个将特定域名流量转发到上面创建的 nginx-service 的示例

将外部 HTTP/HTTPS 流量路由到内部服务的核心配置。

yaml

apiVersion: networking.k8s.io/v1 # Kubernetes API版本,v1是当前稳定版本

kind: Ingress # 资源类型:Ingress

metadata:

name: example-ingress # Ingress资源的名称,在命名空间中必须唯一

spec:

rules:

- host: "demo.yourdomain.com" # 规则1:基于域名的虚拟主机

# - host: "api.yourdomain.com" # 规则2:可以添加多个规则

http:

paths:

- pathType: Prefix # 前缀匹配

path: "/"

backend:

service:

name: nginx-service # # Service资源名称,必须在同一命名空间

port:

number: 80 # # Service端口(或使用 name: "http" 引用端口名称)

bash

kubectl apply -f example-ingress.yamlpathType - 路径匹配模式(v1 API 关键字段)

| 类型 | 匹配规则 | 示例 path: "/api" |

优先级 |

|---|---|---|---|

Exact |

精确匹配,区分大小写 | 匹配 /api,不匹配 /api/ 或 /api/v1 |

高 |

Prefix |

前缀匹配,按路径元素分隔 | 匹配 /api,/api/v1,不匹配 /apis |

中 |

ImplementationSpecific |

由 Ingress Controller 决定 | 取决于实现,通常同 Prefix |

低 |

匹配优先级:精确匹配 > 前缀匹配(更长的路径前缀优先)。

- 用户访问

http://demo.yourdomain.com/ - DNS解析到 Ingress Controller 的 Service IP(云负载均衡器或节点IP)

- Ingress Controller(Nginx) 接收请求,查看

Host: demo.yourdomain.com头 - 匹配规则:找到对应

host的规则,然后按pathType和path匹配路径 - 转发请求:将请求代理到

nginx-service:80这个 Service - Service 负载均衡到后端 Pod(你的应用容器)

五:配置和存储

1:配置管理

Kubernetes(K8s)的配置管理是其核心能力之一,它旨在将应用配置(如配置文件、环境变量、命令行参数等)从容器镜像中解耦,从而实现 "一次构建,到处部署" 的云原生理念

在传统模式下,配置通常被"硬编码"到应用代码或Docker镜像中,导致不同环境(开发、测试、生产)需要不同的镜像,管理复杂且易出错。K8s的配置管理通过一系列原生API对象解决了这个问题。

K8s的配置管理的核心是:将配置数据作为独立的K8s资源进行管理,并通过卷(Volume)或环境变量等方式动态注入到Pod容器中,实现配置与应用的分离。

1.1:configMap

管理非敏感的配置数据,例如配置文件、命令行参数、环境变量、端口号等。

- 数据以键值对(key-value)形式存储。

- Value可以是简单的字符串,也可以是完整的配置文件内容(如JSON、XML、Properties、YAML等)。

- 存储大小有限制(默认约1MB in etcd)。

创建configMap的资源清单

yaml

apiVersion: v1

kind: ConfigMap

metadata:

name: game-config

namespace: default

labels:

app: game

tier: backend

data:

# 简单键值对

game.type: "mmorpg"

game.difficulty: "hard"

# 配置文件内容(整个文件作为值)

server.properties: |

enemy.types=aliens,monsters

player.maximum-lives=5

level.complexity=high

# 另一个配置文件

ui.properties: |

color.good=purple

color.bad=yellow

allow.textmode=true

# JSON 配置

config.json: |

{

"logging": {

"level": "DEBUG",

"file": "/var/log/app.log"

},

"features": {

"enableCache": true,

"maxItems": 100

}

}在 Pod 中使用 ConfigMap

- 作为环境变量: 将整个ConfigMap或特定键注入为容器环境变量。

- 作为文件(Volume挂载): 最常用、最灵活的方式。将ConfigMap中的每个键作为一个文件挂载到容器内的指定目录,文件内容即为键对应的值。支持热更新(Pod内文件会自动更新,但应用是否需要重载取决于自身)。

- 作为命令行参数: 通过环境变量间接传递。

yaml

apiVersion: v1

kind: Pod

metadata:

name: configmap-env-pod

spec:

containers:

- name: test-container

image: busybox

command: [ "/bin/sh", "-c", "env" ]

env:

# 定义环境变量 LOG_LEVEL,值来自 ConfigMap

- name: LOG_LEVEL

valueFrom:

configMapKeyRef:

name: app-config # ConfigMap 名称

key: log-level # ConfigMap 中的键

optional: false # 可选,如果为 true,ConfigMap 不存在时 Pod 也能启动

yaml

apiVersion: v1

kind: Pod

metadata:

name: configmap-env-all-pod

spec:

containers:

- name: test-container

image: busybox

command: [ "/bin/sh", "-c", "env" ]

envFrom:

- configMapRef:

name: app-config # 将 ConfigMap 中的所有键值对作为环境变量

yaml

apiVersion: v1

kind: Pod

metadata:

name: configmap-volume-pod

spec:

containers:

- name: test-container

image: busybox

command: [ "/bin/sh", "-c", "ls -la /etc/config && cat /etc/config/*" ]

volumeMounts:

- name: config-volume

mountPath: /etc/config # ConfigMap 中的每个键都会成为一个文件

readOnly: true

volumes:

- name: config-volume

configMap:

name: game-config # 引用的 ConfigMap

# 挂载效果

/etc/config/

├── game.type # 文件内容: "mmorpg"

├── game.difficulty # 文件内容: "hard"

├── server.properties # 文件内容: "enemy.types=aliens..."

└── ui.properties # 文件内容: "color.good=purple..."🎉 对于一些敏感服务的配置文件,在线上有时是不允许修改的,此时在配置 configmap 时可以设置 immutable: true 来禁止修改

1.2:Secret

专门用于管理和存储敏感信息,如密码、OAuth令牌、SSH密钥、TLS证书等。

使用方式与ConfigMap几乎完全相同(也支持环境变量和Volume挂载)。

K8s会对Secret数据进行Base64编码(仅是一种简单的混淆,并非加密)。在Master节点上,etcd中存储的数据可以启用静态加密。

Secret有三种主要类型:

Opaque(通用,默认)kubernetes.io/tls(TLS证书)kubernetes.io/dockerconfigjson(镜像仓库认证)。

| 场景 | 使用 ConfigMap | 使用 Secret |

|---|---|---|

| 数据库连接字符串 | ❌ 敏感 | ✅ 使用 Secret |

| 日志级别 | ✅ 非敏感 | ❌ |

| API 端点 URL | ✅ 非敏感 | ❌ |

| TLS 证书 | ❌ 敏感 | ✅ 使用 Secret |

| 特性开关 | ✅ 非敏感 | ❌ |

1.3:subPath

使用 ConfigMap 或 Secret 挂载到目录的时候,会将容器中源目录给覆盖掉,此时我们可能只想覆盖目录中的某一个文件,但是这样的操作会覆盖整个文件,因此需要使用到 SubPath

假设你有一个容器镜像,其目录结构如下:

/opt/app/

├── app.jar

├── config/

│ ├── application.yaml # 需要被替换的配置

│ └── security.yaml # 需要保留的默认配置

└── logs/如果你直接将 ConfigMap 挂载到 /opt/app/config:

yaml

volumeMounts:

- name: config-volume

mountPath: /opt/app/config # 这会覆盖整个 config 目录!security.yaml 文件会消失!因为整个目录被 ConfigMap 的内容覆盖了。

这时候subPath就派出用场了:

yaml

volumeMounts:

- name: config-volume

mountPath: /opt/app/config/application.yaml # 挂载到特定文件路径

subPath: application.yaml # 只挂载这个文件挂载ConfigMap中的单个文件

yaml

# 指定configmap的资源文件,这里声明application.yaml和logging.yaml

apiVersion: v1

kind: ConfigMap

metadata:

name: app-config

data:

application.yaml: |

server:

port: 8080

database:

url: jdbc:mysql://localhost:3306/mydb

logging.yaml: |

logging:

level: INFO

file: /var/log/app.log

# pod文件资源

apiVersion: v1

kind: Pod

metadata:

name: subpath-example # pod的名称

spec:

containers:

- name: app # 容器名称

image: myapp:latest # 使用的镜像

volumeMounts: # 指定文件挂载

- name: config-volume

mountPath: /etc/app/application.yaml # 挂载为单个文件

subPath: application.yaml # 只挂载这个键

- name: config-volume

mountPath: /etc/app/logging.yaml # 挂载另一个文件

subPath: logging.yaml

volumes: # 指定卷

- name: config-volume

configMap:

name: app-config挂载 Secret 中的特定文件(TLS 证书)

yaml

apiVersion: v1

kind: Secret

metadata:

name: tls-secret

type: kubernetes.io/tls

data:

tls.crt: LS0tLS1CRUdJTiBDRVJUSUZJQ0FURS0t...

tls.key: LS0tLS1CRUdJTiBQUklWQVRFIEtFWS0t...

---

apiVersion: v1

kind: Pod

metadata:

name: web-server

spec:

containers:

- name: nginx

image: nginx:latest

volumeMounts:

- name: tls-volume

mountPath: /etc/nginx/ssl/server.crt # 挂载证书文件

subPath: tls.crt

- name: tls-volume

mountPath: /etc/nginx/ssl/server.key # 挂载私钥文件

subPath: tls.key

volumes:

- name: tls-volume

secret:

secretName: tls-secret1.4:配置热更新

我们通常会将项目的配置文件作为 configmap 然后挂载到 pod,那么如果更新 configmap 中的配置,会不会更新到 pod 中呢?这得分成几种情况:

- 默认方式:会更新,更新周期是更新时间 + 缓存时间

- subPath:不会更新

- 变量形式:如果 pod 中的一个变量是从 configmap 或 secret 中得到,同样也是不会更新的

对于 subPath 的方式,我们可以取消 subPath 的使用,将配置文件挂载到一个不存在的目录,避免目录的覆盖,然后再利用软连接的形式,将该文件链接到目标位置,但是如果目标位置原本就有文件,可能无法创建软链接,此时可以基于 postStart 操作执行删除命令,将默认的吻技安删除即可

2:持久化存储(挂载)

为什么需要持久化存储呢?

- 普通容器存储:容器内部的文件是临时的,容器重启→数据丢失(就像电脑重启后,内存中的数据消失)

- 持久化存储:数据独立于容器生命周期存在(就像把文件保存到硬盘,电脑重启后文件还在)

典型的应用场景:

- 数据库(MySQL、PostgreSQL)

- 文件共享服务

- 日志集中存储

- 应用配置文件

2.1:volumes卷

卷就像是给你的容器挂载了一个外部的U盘,与Pod生命周期绑定:Pod删除,Volume通常也会被清理

主要有两种类型:

2.1.1:emptyDir

临时目录,Pod删除数据就没了

yaml

# 定义一个使用 EmptyDir 临时存储卷的 Pod 资源

apiVersion: v1 # API版本:Pod 属于核心组资源,v1 是稳定版本

kind: Pod # 资源类型:声明该YAML文件定义的是 Pod 资源

metadata: # 元数据段:用于描述 Pod 的基础信息(名称、标签、注解等)

name: test-pd # Pod名称:在所属命名空间内唯一标识该Pod

spec: # 规格段:定义 Pod 的核心配置(容器、存储、网络、调度等)

containers: # 容器列表:一个Pod可包含多个容器,此处是数组形式(- 开头表示元素)

- image: nginx # 容器镜像:使用官方 nginx 镜像(默认拉取最新版)

name: nginx-emptydir # 容器名称:在Pod内唯一标识该容器

volumeMounts: # 容器挂载配置:定义该容器需要挂载的 Volume 列表

- mountPath: /cache # 挂载路径:将 Volume 挂载到容器内的 /cache 目录

name: cache-volume # 挂载的Volume名称:关联下方 spec.volumes 中定义的 cache-volume(名称必须一致)

volumes: # Pod级Volume列表:定义该Pod可用的存储卷(所有容器可共享)

- name: cache-volume # Volume名称:与容器 volumeMounts.name 对应,作为挂载关联标识

emptyDir: {} # Volume类型:emptyDir(空目录卷),{} 表示使用默认配置

# emptyDir特性:Pod调度到节点后自动创建,Pod删除/迁移时数据永久丢失

# 默认存储在节点磁盘,可配置 medium: Memory 改为内存存储(tmpfs)2.1.2:hostPath

使用节点本地目录(⚠️危险:节点故障数据可能丢失)

yaml

apiVersion: v1

kind: Pod

metadata:

name: test-pd

spec:

containers:

- image: nginx

name: nginx-volume

volumeMounts:

- mountPath: /test-pd # 挂载到容器的哪个目录

name: test-volume # 挂载哪个 volume

volumes:

- name: test-volume

hostPath:

path: /data # 节点中的目录

type: Directory # 检查类型,在挂载前对挂载目录做什么检查操作,有多种选项,默认为空字符串,不做任何检查

类型:

空字符串:默认类型,不做任何检查

DirectoryOrCreate:如果给定的 path 不存在,就创建一个 755 的空目录

Directory:这个目录必须存在

FileOrCreate:如果给定的文件不存在,则创建一个空文件,权限为 644

File:这个文件必须存在

Socket:UNIX 套接字,必须存在

CharDevice:字符设备,必须存在

BlockDevice:块设备,必须存在Kubernetes 节点(Node) 主机文件系统 Pod: test-pd Container: nginx-volume 关联映射(双向同步) 数据同步 Volume: test-volume

(HostPath 类型) /test-pd

(容器内挂载点) /data

(主机目录 / HostPath 源) 容器内读写 /test-pd 等同于读写主机 /data type: Directory

挂载前检查主机 /data 是已存在目录

2.2:NFS挂载

网络共享存储 - 就像公司里的网络共享盘(NAS),所有电脑都能访问

- 网络共享:多节点可以同时访问同一存储

- 数据集中管理:数据存储在单独的NFS服务器

- 需要额外部署:需要先搭建NFS服务器

2.2.1:部署NFS过程

2.2.1.1:部署NFS Server

方案一:独立服务器部署

bash

# 在专用服务器上(假设IP:192.168.1.100)

# 1. 安装NFS服务

sudo apt-get update

sudo apt-get install nfs-kernel-server -y # Ubuntu/Debian

# 或

sudo yum install nfs-utils -y # CentOS/RHEL

# 2. 创建共享目录

sudo mkdir -p /data/nfs-share

sudo chmod 777 /data/nfs-share # 简化权限,生产环境需细化

# 3. 配置共享目录

sudo vim /etc/exports方案二:在K8s集群内部署NFS Server

yaml

# nfs-server.yaml

apiVersion: apps/v1 # 使用Deployment资源的API版本

kind: Deployment # 定义资源类型为部署控制器

metadata: # 资源的元数据部分

name: nfs-server # 部署的名称,用于标识和引用

spec: # 部署的具体规格配置

replicas: 1 # Pod副本数量,设为1表示只运行一个NFS服务器实例

selector: # 标签选择器,用于选择要管理的Pod

matchLabels: # 匹配标签的条件

app: nfs-server # 必须匹配标签app=nfs-server的Pod

template: # Pod模板定义,描述如何创建Pod

metadata: # Pod的元数据

labels: # 给Pod设置的标签

app: nfs-server # 标签键值对,与上面的选择器匹配

spec: # Pod的具体规格

containers: # 容器定义列表

- name: nfs-server # 容器名称

image: gcr.io/google_containers/volume-nfs:0.8 # NFS服务器容器镜像

ports: # 容器暴露的端口列表

- name: nfs # 端口名称,便于识别

containerPort: 2049 # NFS协议主端口,用于文件传输

- name: mountd # 端口名称

containerPort: 20048 # NFS挂载守护进程端口,处理挂载请求

- name: rpcbind # 端口名称

containerPort: 111 # RPC绑定端口,NFS依赖的服务端口

securityContext: # 容器的安全上下文配置

privileged: true # 授予容器特权模式,NFS服务需要访问内核功能

volumeMounts: # 容器内的卷挂载配置

- mountPath: /exports # 容器内的挂载点路径,NFS将共享此目录

name: nfs-data # 引用的卷名称,必须与下面的volumes名称匹配

volumes: # Pod级别的存储卷定义

- name: nfs-data # 卷名称,供容器引用

hostPath: # 卷类型:使用宿主机路径

path: /data/nfs # 宿主机上的实际目录路径

---

apiVersion: v1 # 使用Service资源的API版本

kind: Service # 定义资源类型为服务

metadata: # 服务的元数据

name: nfs-server # 服务的名称

spec: # 服务的规格配置

ports: # 服务暴露的端口列表

- name: nfs # 端口名称

port: 2049 # 服务端口,集群内部访问时使用的端口

targetPort: 2049 # 容器端口,流量转发到容器的这个端口

- name: mountd # 端口名称

port: 20048 # 服务端口

targetPort: 20048 # 容器端口

- name: rpcbind # 端口名称

port: 111 # 服务端口

targetPort: 111 # 容器端口

selector: # 标签选择器,指定后端Pod

app: nfs-server # 选择标签为app=nfs-server的Pod作为后端

clusterIP: None # 设置为Headless Service,不分配集群IP

# 这样Pod可以直接通过DNS记录访问,适合有状态服务宿主机存储 Kubernetes集群 DNS查询 返回Pod IP 读写数据 宿主机 /data/nfs nfs-server Service NFS Server Pod NFS客户端Pod

2.2.1.2:准备k8s节点

bash

# 在每个K8s Worker节点上安装NFS客户端

# Ubuntu/Debian

sudo apt-get install nfs-common -y

# CentOS/RHEL

sudo yum install nfs-utils -y

# 测试连接

showmount -e 192.168.1.100

# 应显示:/data/nfs-share *2.2.1.3:k8s中使用nfs

方式一:直接在pod中使用

yaml

# nfs-pod-direct.yaml

apiVersion: v1

kind: Pod

metadata:

name: nfs-web

spec:

containers:

- name: web-server

image: nginx

volumeMounts:

- name: nfs-storage

mountPath: /usr/share/nginx/html # Nginx默认网页目录

readOnly: false

volumes:

- name: nfs-storage

nfs:

server: 192.168.1.100 # NFS服务器IP

path: /data/nfs-share # 共享目录

readOnly: false # 读写模式方式二:生产环境中推荐使用PVC/PV方式

yaml

# 1. 创建PV(持久卷)

# nfs-pv.yaml

apiVersion: v1

kind: PersistentVolume

metadata:

name: nfs-pv

labels:

type: nfs

spec:

capacity:

storage: 10Gi # 逻辑容量

volumeMode: Filesystem

accessModes:

- ReadWriteMany # NFS支持多节点读写

persistentVolumeReclaimPolicy: Retain # 删除策略

storageClassName: nfs

nfs:

path: /data/nfs-share # NFS共享路径

server: 192.168.1.100 # NFS服务器IP

readOnly: false

yaml

# 2. 创建PVC(持久卷声明)

# nfs-pvc.yaml

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: nfs-pvc

spec:

accessModes:

- ReadWriteMany

storageClassName: nfs

resources:

requests:

storage: 5Gi # 申请5GB,不能超过PV的10GB

yaml

# 3. Pod使用PVC

# nfs-pod-pvc.yaml

apiVersion: v1

kind: Pod

metadata:

name: nfs-pod

spec:

containers:

- name: app

image: busybox

command: ["sh", "-c", "echo 'Hello from NFS' > /data/hello.txt && tail -f /dev/null"]

volumeMounts:

- name: nfs-volume