在大模型(LLM)应用爆发的今天,成本高、延迟大、资源消耗重成为落地的核心瓶颈。而 Prompt Caching(提示缓存) 正是解决这些问题的关键技术之一。

一、什么是 Prompt Caching?

Prompt Caching(提示缓存) 是指:

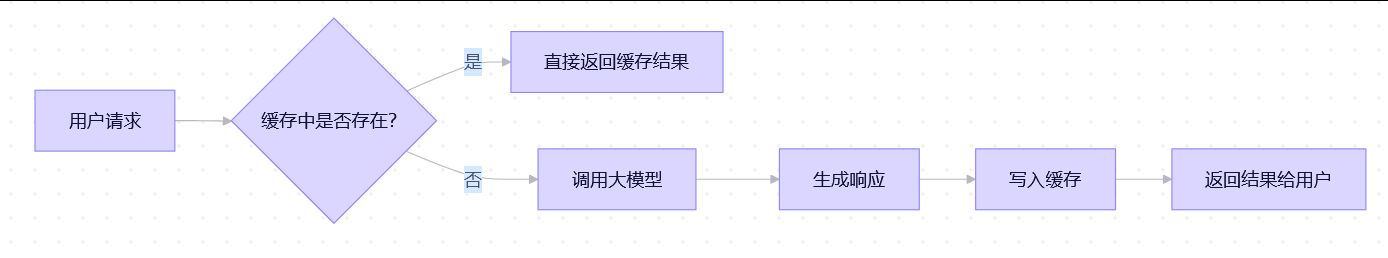

将用户输入的 prompt(提示)与其对应的 LLM 生成结果进行缓存,当下次遇到相同或高度相似的 prompt 时,直接返回缓存结果,避免重复调用大模型。简单说:"同样的问题,只问一次大模型,后面都查缓存。"

这类似于 Web 开发中的:

Redis 缓存数据库查询结果

CDN 缓存静态网页

浏览器缓存 API 响应二、Prompt Caching 的核心工作原理

关键组件:

- 缓存 Key:通常是 prompt 的哈希值(如 MD5、SHA256)

- 缓存 Value:LLM 的完整输出(文本、JSON、function call 等)

- 缓存存储:Redis、Memcached、本地内存等

- TTL(过期时间):防止缓存长期失效(如 1 小时)

三、如何实现 Prompt Caching?(代码示例)

基础版:精确匹配缓存(Python + Redis)

python

import redis

import hashlib

import openai

# 初始化 Redis

cache = redis.Redis(host='localhost', port=6379, decode_responses=True)

def cached_llm_call(prompt: str, ttl: int = 3600) -> str:

# 1. 生成唯一 key

key = "prompt:" + hashlib.md5(prompt.encode()).hexdigest()

# 2. 尝试读缓存

cached = cache.get(key)

if cached:

print("命中缓存")

return cached

# 3. 未命中,调用大模型

print("未命中缓存,调用 LLM...")

response = openai.ChatCompletion.create(

model="gpt-4-turbo",

messages=[{"role": "user", "content": prompt}]

)

result = response.choices[0].message["content"]

# 4. 写入缓存(带过期时间)

cache.setex(key, ttl, result)

return result进阶版:语义相似缓存(基于 Embedding)

适用于"问法不同但意思一样"的场景,如:

"怎么重置密码?"

"忘记密码了怎么办?"

python

from sentence_transformers import SentenceTransformer

import numpy as np

model = SentenceTransformer('all-MiniLM-L6-v2')

def get_similar_cached_response(prompt: str, threshold=0.95):

prompt_emb = model.encode(prompt)

# 遍历缓存中的所有 (prompt, response, embedding)

for cached_prompt, (response, emb) in cache_with_emb.items():

similarity = np.dot(prompt_emb, emb) / (np.linalg.norm(prompt_emb) * np.linalg.norm(emb))

if similarity >= threshold:

return response # 返回语义相似的结果

return None实际生产中可用 向量数据库(如 Pinecone、Milvus) 高效检索近邻。

四、为什么 Prompt Caching 特别适合高并发系统?

我们通过一个真实场景对比说明:

核心价值:降本 + 降延迟 + 抗压

我们通过一个真实场景对比说明:

场景:客服问答系统(日活 10 万用户)

| 指标 | 无缓存 | 有 Prompt Caching |

|---|---|---|

| 日均请求量 | 500000 次 | 500000 次 |

| 重复/相似问题占比 | 70%(如"如何退货?") | --- |

| 实际调用 LLM 次数 | 500,000 次 | 15000 次(↓70%) |

| 月成本($0.01/次) | $5000 | $1500 |

| P99 延迟 80 ms | 1200 ms | (缓存命中 <10ms) |

| 服务器压力 | 需 20 个 LLM 实例 | 仅需 6 个 |

结论:缓存让系统成本直降 70%,延迟降低 15 倍

高并发下的三大优势详解:

-

大幅降低 LLM 调用成本

大模型按 token 或请求计费(如 OpenAI、Claude、阿里百炼)

缓存命中 = 0 成本

对于 FAQ、模板化问题(如"写周报"、"生成商品描述"),缓存命中率可达 60%~90%

-

极致降低响应延迟

LLM 推理通常需 200ms ~ 2s

Redis 缓存读取仅需 0.1 ~ 2ms

用户体验从"等待"变为"秒回"

-

提升系统吞吐与稳定性

高并发时,LLM 服务易成瓶颈(限流、排队、超时)

缓存将 70% 流量挡在 LLM 之外,极大缓解后端压力

即使 LLM 服务宕机,缓存仍可提供基础服务能力

五、哪些场景最适合用 Prompt Caching?

| 强烈推荐 | 谨慎使用 | 不适合 |

|---|---|---|

| FAQ 问答(客服、帮助中心) | 个性化推荐(结果因人而异) | 实时数据查询(股价、天气) |

| 模板生成(邮件、周报、文案) | 多轮对话上下文 | 高频变化内容(新闻摘要) |

| 固定指令("总结以下文本") | 含用户私有数据的问题 | 创意生成(每次要不同) |

| 工具调用的固定参数组合 | 需要最新知识的问题 | 安全敏感操作(如支付) |

黄金法则:

"如果这个问题的答案在 1 小时内不会变,就值得缓存。"六、生产环境最佳实践

设置合理 TTL

静态内容:TTL = 24 小时

半动态内容:TTL = 1 小时

敏感内容:不缓存

缓存 Key 加上下文前缀

python

key = f"prompt:{user_id}:{prompt_hash}" # 避免用户间信息泄露-

监控缓存命中率

目标:>60%

若命中率低,考虑引入语义缓存

-

缓存预热(Cache Warm-up)

上线前预先缓存高频问题,避免冷启动冲击 LLM

- 安全过滤

不缓存含身份证、手机号等 PII(个人身份信息)的 prompt

七、生产环境Prompt Caching难点

难点一:"相同 Prompt"的定义模糊 ------ 精确匹配 vs 语义相似

问题本质:

用户问法千变万化,但意图相同。例如:

"怎么重置密码?"

"忘记密码了怎么办?"

"账号登不上,能帮我找回吗?"如果只做 精确字符串匹配(如 MD5 哈希),这些请求都会被当作"不同 prompt",缓存命中率极低(<10%)。

但如果做 语义相似匹配,又面临:

如何定义"足够相似"?(阈值设 0.9 还是 0.85?)

相似但不等价的问题被错误复用(如"iPhone 15 多少钱?" vs "iPhone 14 多少钱?")后果:

缓存命中率低 → 成本没降下来

错误复用 → 返回错误答案(幻觉升级为事实错误)应对策略:

| 方案 | 缺点 | 不适合 | 适用场景 |

|---|---|---|---|

| 精确匹配 + 标准化预处理(如转小写、去标点、参数提取) | 简单可靠,0 错误 | 覆盖率低 | 模板化指令(如 /summarize {text}) |

| Embedding + 向量检索(用 Sentence-BERT 计算相似度) | 覆盖率高 | 可能误匹配 | FAQ、客服问答 |

| 混合策略:先精确匹配,失败再语义匹配 | 平衡准确与覆盖 | 实现复杂 | 高要求生产系统 |

难点二:上下文敏感性 ------ 同一 prompt,不同用户/状态,答案不同

问题本质:

很多 prompt 看似相同,但依赖外部上下文,不能通用缓存。

典型场景:

yaml

用户 A: "我的订单状态是什么?" → 需查 A 的订单

用户 B: "我的订单状态是什么?" → 需查 B 的订单若缓存 "我的订单状态是什么?" → "已发货",用户 B 会看到用户 A 的结果!

其他例子:

"我有多少积分?"(依赖用户 ID)

"最近的会议安排?"(依赖日历上下文)

多轮对话中的省略句:"那呢?"、"还有吗?"后果:

严重隐私泄露

逻辑错乱,用户体验崩溃应对策略:

缓存 Key 必须包含上下文标识

python

key = f"prompt:{user_id}:{session_id}:{prompt_hash}"禁止缓存含"我"、"我的"、"当前"等指代词的 prompt

(可通过 NER 或规则过滤)

在 Agent 架构中,仅缓存"纯工具调用"结果,而非最终回复

例如缓存 query_order(order_id="ORD123") → {"status": "shipped"},而非自然语言回复。

黄金法则:只有"无状态、无用户上下文"的 prompt 才适合全局缓存。难点三:缓存污染与过期 ------ 答案会"变老"甚至"变错"

问题本质:

LLM 的输出可能随时间失效:

事实变化:

"OpenAI CEO 是谁?" → 2023 年答 Sam Altman,2024 年可能变。

模型更新:

GPT-4 Turbo 比 GPT-4 更准确,旧缓存答案可能过时。

业务规则变更:

"退货政策"从 7 天变为 15 天。若缓存长期不更新,系统会持续返回错误或过时信息。

后果:

用户得到错误答案

品牌信任度下降

客服投诉激增应对策略:

| 策略 | 说明 |

|---|---|

| 设置合理 TTL | 静态内容(如数学公式)→ 7 天;动态内容(如政策)→ 1 小时 |

| 主动失效机制 | 当检测到知识更新(如爬虫抓到新网页),批量清除相关缓存 |

| 版本化缓存 | key = f"v2:{prompt_hash}",模型升级后自动切换 |

| 缓存+实时校验 | 返回缓存前,用轻量 API 验证关键事实(如订单是否存在) |

高级方案:用 RAG(检索增强生成)替代纯缓存------每次查询都检索最新文档,再生成答案,从根本上避免过期。

难点四:缓存爆炸与存储成本 ------ Key 太多,内存撑不住

问题本质:

在高并发系统中:

日均 unique prompt 可达 百万级

每个缓存项占 1~10 KB

总存储需求 = 10 GB ~ 100 GB+若全部存 Redis,成本高昂;若用本地内存,重启即丢失。

后果:

缓存服务 OOM(内存溢出)

Redis 费用超过 LLM 调用费

缓存未命中率反而上升(因 LRU 淘汰太频繁)应对策略:

分层缓存(Cache Hierarchy)

L1:本地内存(Caffeine)→ 存高频热点(Top 1000)

L2:Redis 集群 → 存中频请求

L3:不缓存 → 低频请求直连 LLM

只缓存高价值 prompt

通过监控,仅缓存:

调用成本高(长文本生成)

延迟敏感(前端展示)

高频重复(>100 次/天)

压缩存储

用 zstd 压缩 response

只存必要字段(如 JSON 中的 content,去掉 usage 等元数据)难点五:安全与合规风险 ------ 缓存可能泄露隐私

问题本质:

用户 prompt 可能包含:

身份证号、手机号、银行卡

公司内部文档

医疗记录若这些内容被写入缓存(尤其是共享缓存),可能被其他用户或攻击者读取。

后果:

违反 GDPR / CCPA / 《个人信息保护法》

法律诉讼与巨额罚款

公司声誉毁灭性打击应对策略:

敏感信息过滤(PII Detection)

在写缓存前,用正则或 NER 模型扫描:

python

if contains_pii(prompt) or contains_pii(response):

skip_caching()隔离存储

用户私有数据 → 仅存本地内存,TTL=0(请求结束即销毁)

公共数据 → 可存共享缓存

加密缓存

对缓存 value 做 AES 加密(但会增加 CPU 开销)

绝对原则:任何含用户私有数据的交互,禁止进入共享缓存。难点六:评估与监控困难 ------ 不知道缓存是否有效

问题本质:

团队常误以为"加了缓存=省钱了",但实际可能:

缓存命中率仅 5%

错误复用导致用户投诉

TTL 设置不合理,频繁穿透却因缺乏监控而浑然不知。

必须监控的指标:

| 指标 | 健康值 | 工具 |

|---|---|---|

| 缓存命中率 | >60% | Prometheus + Grafana |

| 平均缓存延迟 | <5ms | APM(如 Datadog) |

| 缓存错误率 | =0% | 日志告警(ELK) |

| 存储使用量 | <80% | 内存 Redis INFO |

| TTL 分布 | 符合预期 | 自定义埋点 |

建议:上线缓存功能时,必须配套埋点 + 告警,否则等于"盲跑"。

总结:Prompt Caching 的难点全景图

| 难点 | 核心挑战 | 解决方向 |

|---|---|---|

| 语义匹配 | 相同意图 ≠ 相同文本 | 意图识别 + 向量检索 |

| 上下文敏感 | "我的" ≠ 通用 | Key 加用户/会话 ID |

| 答案过期 | 世界在变,缓存在静止 | TTL + 主动失效 + RAG |

| 存储爆炸 | 百万级 unique prompt | 分层缓存 + 只缓高价值 |

| 隐私泄露 | PII 进缓存 = 高危 | 敏感过滤 + 隔离存储 |

| 监控缺失 | 无效缓存难发现 | 埋点 + 告警 + 评估 |

最终建议

Prompt Caching 不是"加一行代码"就能生效的功能,而是一个需要精心设计的子系统。在实施前,请务必回答:

我的 prompt 是否无状态、无用户上下文?

答案是否会随时间变化?

是否包含敏感信息?

我的缓存命中率目标是多少?如何测量?八、总结

Prompt Caching 不是"可选项",而是高并发 LLM 应用的"必选项"。它通过 牺牲少量存储空间,换取:

70%+ 的成本节省

10 倍以上的延迟降低

系统稳定性和可扩展性大幅提升在构建客服机器人、智能助手、内容生成平台等高并发场景时,可以在架构早期就集成 Prompt Caching 机制。否则,随着流量增长,将面临成本失控、服务雪崩的风险。