人们眼中的天才之所以卓越非凡,并非天资超人一等而是付出了持续不断的努力。1万小时的锤炼是任何人从平凡变成超凡的必要条件。------------ 马尔科姆·格拉德威尔

🌟 Hello,我是Xxtaoaooo!

🌈 "代码是逻辑的诗篇,架构是思想的交响"

一、引言

2025 年底,大模型赛道迎来新一轮技术跃迁。智谱 AI 正式发布 GLM-4.7 ,MiniMax 紧随其后推出 M2.1 版本。这两款模型不仅在通用能力上持续逼近国际顶尖水平,更在长上下文理解、代码生成、Agent 任务规划、多模态支持等关键场景中展现出显著工程优势。

然而对开发者而言,模型再强,如果试用门槛高、接入成本大、切换不灵活,就难以真正落地。 过去想要体验一款新模型,往往需要分别注册智谱、MiniMax 等多个平台账号;阅读风格迥异的 API 文档;编写适配不同认证方式、请求格式、错误码的调用代码;手动比价、测延迟、跑稳定性测试,这一整套流程下来想想都头疼,宝藏 MaaS 平台 "Ai Ping" ------ 让开发者无需关心底层供应商差异,只专注业务逻辑本身,完美解决上述问题。

目前邀请好友体验 AI Ping (aiping.cn),好友完成账号注册后双方均可获得20元平台算力点,所有模型及供应商全场通用!邀一个赚一个,上不封顶!同时 GLM-4.7 与 MiniMax M2.1 已正式接入 AI Ping 平台,并同步开放 免费试用 !可以通过此专属链接注册登录,送30的算力: https://aiping.cn/#?channel_partner_code=GQCOZLGJ

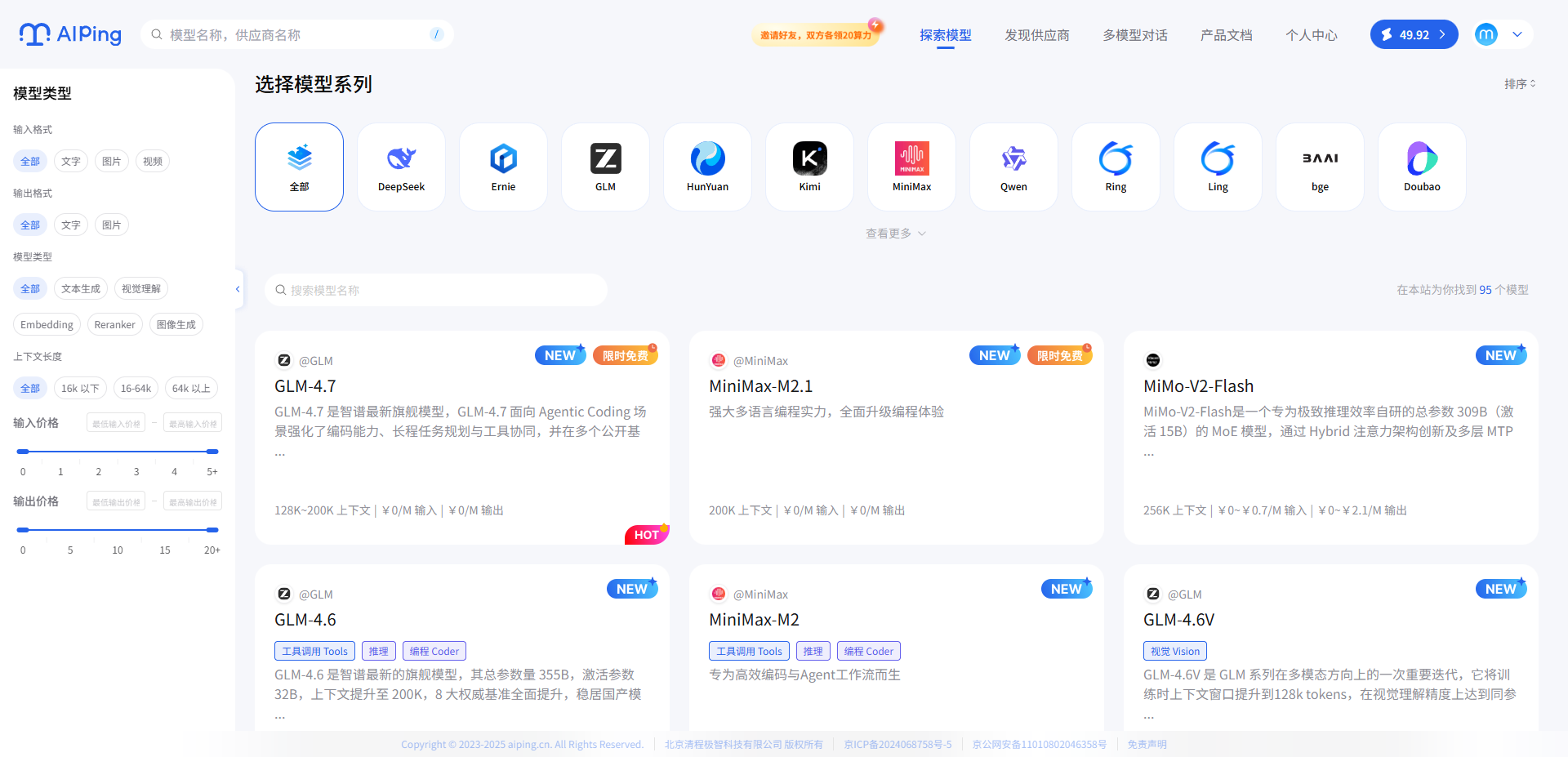

二、AI Ping 介绍

AI Ping(aiping.cn)是国内领先的大模型服务评测与聚合平台,致力于为开发者提供客观、实时的模型性能数据 和统一、稳定的 API 调用入口 。面对当前大模型生态碎片化 、接口不兼容 、选型成本高 等痛点,AI Ping 通过标准化接口屏蔽底层差异,让开发者只需一次集成,即可无缝调用多家厂商的模型服务。

平台核心能力包括:多供应商统一调用 (一套代码自由切换不同模型)、性能数据可视化 (实时展示延迟、吞吐、价格、可靠性等关键指标),以及智能路由(根据业务需求自动选择最优供应商,高峰保稳、低峰省钱)。无论你是快速验证创意,还是构建高可用的线上服务,AI Ping 都能显著降低大模型接入与运维的复杂度。

现在登录 AI Ping 可免费体验两款旗舰模型,该平台已接入6家供应商,在调用速度与稳定性上提供多重保障,帮助我们零门槛跑通复杂工程与长时 Agent 任务,快速验证哪种模型与调用方案更适合自身业务。

在 AI Ping 官网还可以网页端免费体验 GLM-4.7 与 MiniMax M2.1 模型能力

三、GLM-4.7 与 MiniMax M2.1 模型

GLM-4.7 延续了智谱在逻辑推理与文本连贯性上的强项,支持高达 128K 的上下文长度,特别适合小说创作、法律文书分析、复杂对话系统等长程任务;MiniMax M2.1 则凭借其 MoE(Mixture of Experts)架构,在吞吐量和响应速度上实现突破,实测吞吐可达 99 tokens/s,同时新增对视觉输入的支持(M2.1-Vision),为多模态应用打开新可能。

3.1 GLM-4.7 简介

GLM-4.7 是智谱最新旗舰模型 ,GLM-4.7 面向 Agentic Coding 场景强化了编码能力 、长程任务规划 与工具协同 ,**并在多个公开基准的当期榜单中取得开源模型中的领先表现。**通用能力提升,回复更简洁自然,写作更具沉浸感。在执行复杂智能体任务,在工具调用时指令遵循更强,Artifacts 与 Agentic Coding 的前端美感和长程任务完成效率进一步提升。

Ai Ping 提供相关供应商数据:

调用示例:

curl -N -X POST https://www.aiping.cn/api/v1/chat/completions \

-H "Authorization: Bearer apiKey" \

-H "Content-Type: application/json" \

-d '{

"model": "GLM-4.7",

"stream": true,

"messages": [

{

"role": "user",

"content": "Hello"

}

],

"extra_body": {

"provider": {

"only": [],

"order": [],

"sort": null,

"input_price_range": [],

"output_price_range": [],

"input_length_range": [],

"throughput_range": [],

"latency_range": []

}

}

}'3.2 MiniMax M2.1简介

MiniMax M2.1 是 MiniMax 基于其 MoE(Mixture of Experts)架构推出的高性能大模型,主打高吞吐、低延迟与多模态能力 。在纯文本任务中,M2.1 实测吞吐量可达 99 tokens/s ,P90 延迟稳定在 500ms 以内,特别适合高并发的在线服务场景,如智能客服、实时内容生成或游戏 NPC 对话系统。更值得关注的是,M2.1 同步推出了 M2.1-Vision 多模态版本,支持图像输入与图文联合理解,可应用于视觉问答、电商图文生成、UI 自动描述等创新场景。得益于其灵活的专家路由机制,M2.1 在保持高性能的同时有效控制推理成本,为开发者提供兼具速度与性价比的选择。

Ai Ping 提供相关供应商数据:

调用示例:

curl -N -X POST https://www.aiping.cn/api/v1/chat/completions \

-H "Authorization: Bearer apikey" \

-H "Content-Type: application/json" \

-d '{

"model": "MiniMax-M2.1",

"stream": true,

"messages": [

{

"role": "user",

"content": "Hello"

}

],

"extra_body": {

"provider": {

"only": [],

"order": [],

"sort": null,

"input_price_range": [],

"output_price_range": [],

"input_length_range": [],

"throughput_range": [],

"latency_range": []

}

}

}'3.3 各模型特点

面向真实工程的编码能力

- GLM-4.7 强调复杂任务的稳定完成与工程交付;

- MiniMax M2.1 系统强化 Rust / Go / Java / C++ 等多语言工程,服务真实生产代码。

Agent 与工具调用导向

- GLM-4.7 通过可控思考机制提升多步任务稳定性;

- MiniMax M2.1 通过高效 MoE 与收敛推理路径,适合连续编码与长链 Agent 执行。

长期运行下的效率与成本权衡

- GLM-4.7 支持推理强度按需调节,在准确率与成本间灵活取舍;

- MiniMax M2.1 以低激活参数与长上下文优势,提升吞吐与持续运行效率。

四、5分钟实现 Claude Code 集成 AI Ping

AiPing 目前支持 Claude Code、cline、codex、cursor、trae、roo code、Kilo code 等主流 coding 工具;甚至沉浸式翻译、Cherry Studio 办公助手等场景工具,可直接使用 AIPing 基础功能。

下面是AI Ping 集成 Claude Code 完整教程

4.1 Claude Code 安装

// 安装Claude Code之前需要安装Node.js 版本>18 和 安装Git

npm install -g @anthropic-ai/claude-code

// 使用

cd your-awesome-project

claude4.2 Claude Code 中使用 AI Ping

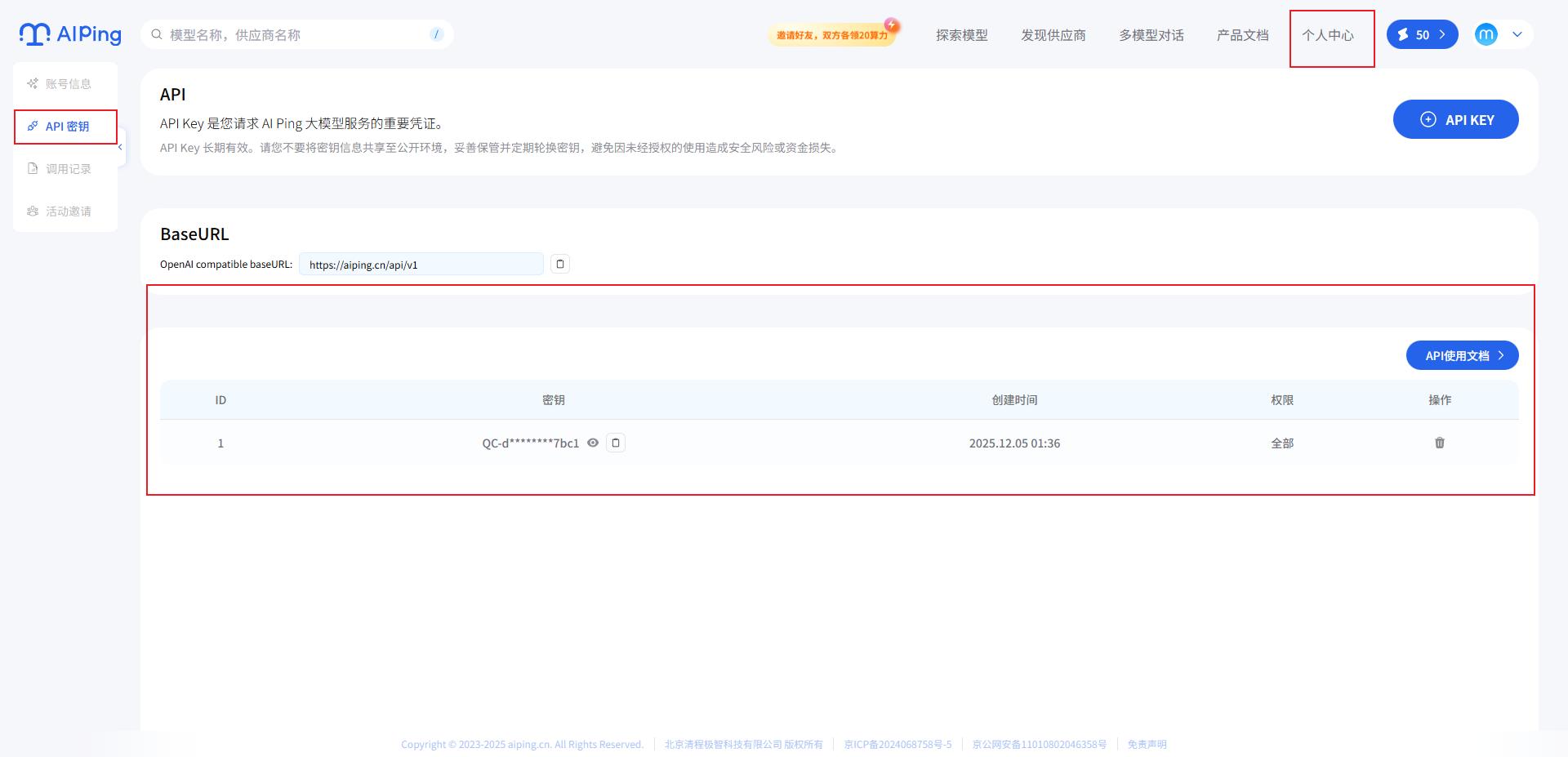

在集成AI Ping之前,需要先注册登录一下

创建个人API密钥

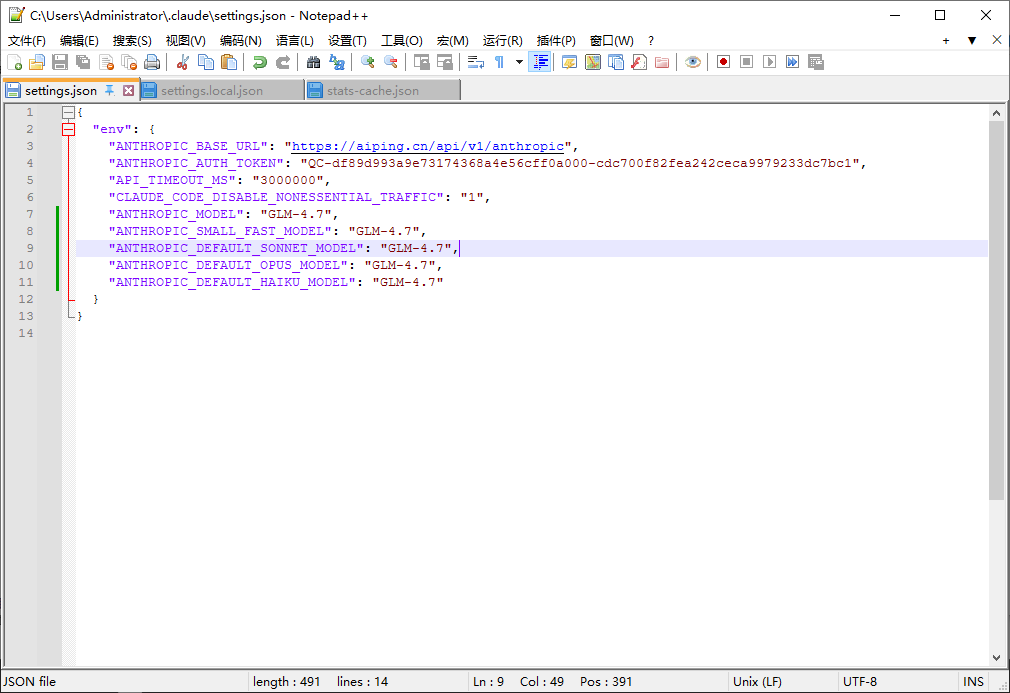

最后配置 Claude Code

-

编辑或创建 Claude Code 的配置文件,路径为 ~/.claude/settings.json,在该文件中添加或更新 env 字段,其中,需要将 YOUR_API_KEY 替换为从 AI Ping 平台获取的 API Key

{

"env": {

"ANTHROPIC_BASE_URL": "https://aiping.cn/api/v1/anthropic",

"ANTHROPIC_AUTH_TOKEN": "<YOUR_API_KEY>",

"API_TIMEOUT_MS": "3000000",

"CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC": 1,

"ANTHROPIC_MODEL": "GLM-4.7" 或者 "MiniMax M2.1",

"ANTHROPIC_SMALL_FAST_MODEL": "GLM-4.7" 或者 "MiniMax M2.1",

"ANTHROPIC_DEFAULT_SONNET_MODEL": "GLM-4.7" 或者 "MiniMax M2.1",

"ANTHROPIC_DEFAULT_OPUS_MODEL": "GLM-4.7" 或者 "MiniMax M2.1",

"ANTHROPIC_DEFAULT_HAIKU_MODEL": "GLM-4.7" 或者 "MiniMax M2.1"

}

}

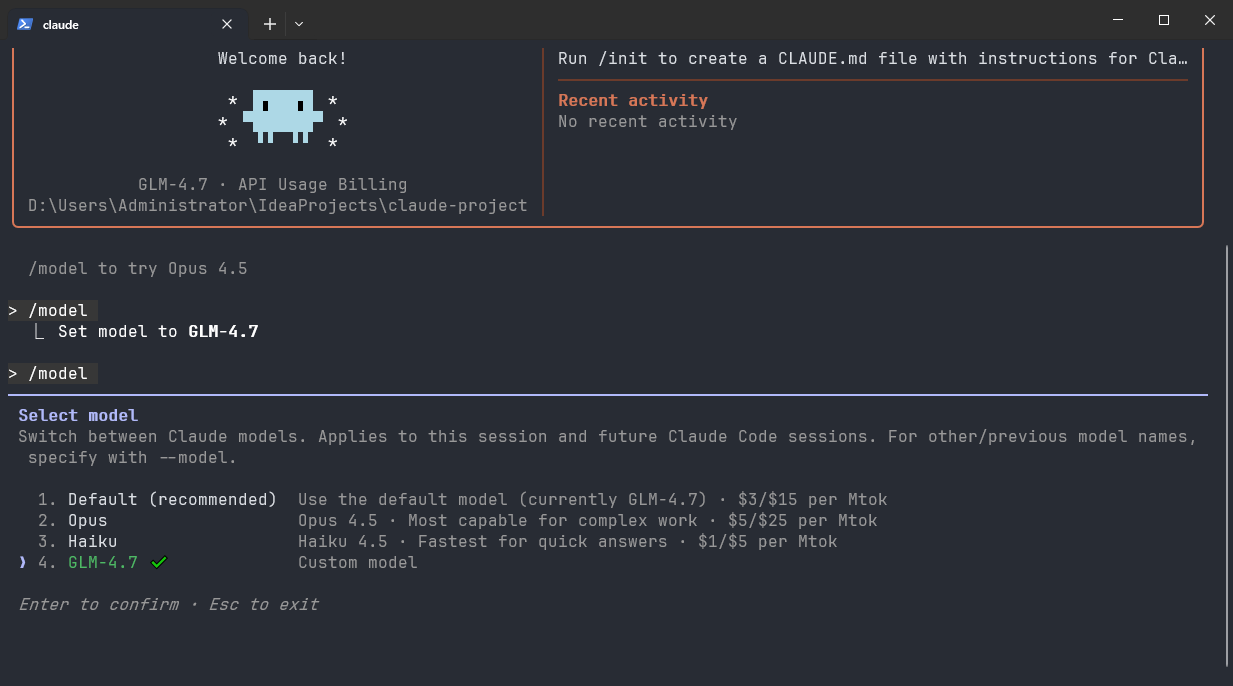

-

配置完成后,进入工作目录,在终端中运行 claude 命令以启动 Claude Code

-

启动后,选择 "信任此文件夹 (Trust This Folder)",以允许 Claude Code 访问该文件夹中的文件,随后开始在 Claude Code 中使用 GLM-4.7 或 MiniMax M2.1 模型。

五、MiniMax M2.1 模型能力实测

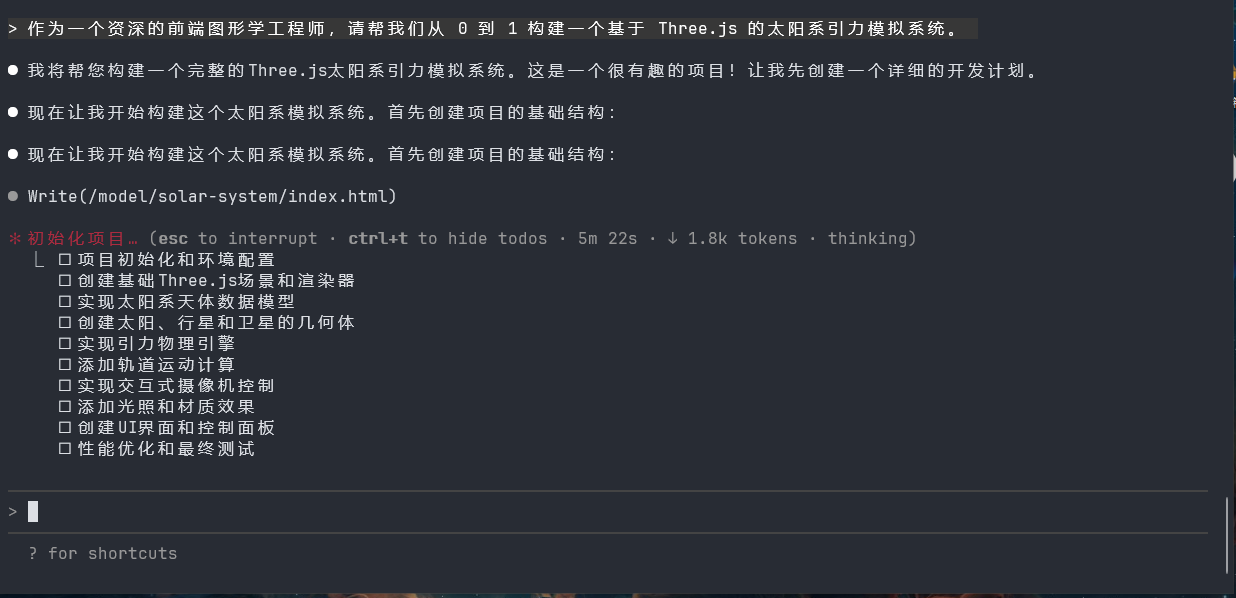

为了真实评估 MiniMax M2.1 在复杂工程任务中的表现,我使用以下提示词进行测试:

作为一个资深的前端图形学工程师,请帮我们从 0 到 1 构建一个基于 Three.js 的太阳系引力模拟系统。该任务要求模型不仅理解天体物理中的万有引力公式 (F = G·m₁m₂/r²),还需掌握 Three.js 的场景搭建、轨道动画、性能优化 等前端图形学知识,并输出可运行、结构清晰、注释完整的代码。

MiniMax M2.1 的效果非常不错,并且执行步骤合理、逻辑清晰:

- 分步规划清晰

模型首先列出实现步骤:初始化场景 → 创建太阳与行星 → 计算引力加速度 → 更新位置与速度 → 添加轨道可视化 → 优化帧率。这种"先设计后编码"的思路,体现了其对工程流程的理解。 - 物理逻辑准确

代码中正确实现了简化版引力模型(忽略多体扰动,采用中心力场近似),并使用Vector3进行向量运算,避免了常见错误如方向混淆或单位缺失。 - Three.js 使用规范

- 使用

OrbitControls支持视角旋转; - 为行星添加

MeshBasicMaterial与不同颜色/半径; - 通过

requestAnimationFrame驱动动画循环; - 行星轨道用

LineGeometry可视化,提升教学演示效果。

- 使用

- 代码可直接运行

输出包含完整 HTML 结构、CDN 引入 Three.js、以及模块化的 JavaScript 逻辑。我们仅需保存为.html文件并在浏览器中打开,即可看到太阳系动态运行。

效果展示:

六、总结

GLM-4.7 与 MiniMax M2.1 的发布,标志着国产大模型在通用能力、工程落地、生态支持 上迈入新阶段。但模型本身只是燃料,真正的生产力来自于高效、稳定、低成本的调用基础设施。

AI Ping 正在构建这样一个基础设施:

1. 统一接口:一次集成,调用数十家厂商的上百个模型;

2. 实时评测:7×24 小时监控延迟、吞吐、可靠性、价格等关键指标;

3. 智能路由:根据你的需求(速度优先 or 成本优先),自动选择最优供应商;

4. 免费额度:新模型上线即开放免费试用,无需充值、无需绑卡。

马上行动起来,去 AI Ping 官网体验 GLM-4.7 与 MiniMax M2.1 的免费调用吧!

🌟 嗨,我是Xxtaoaooo!

⚙️ 【点赞】让更多同行看见深度干货

🚀 【关注】持续获取行业前沿技术与经验

🧩 【评论】分享你的实战经验或技术困惑作为一名技术实践者,我始终相信:

每一次技术探讨都是认知升级的契机,期待在评论区与你碰撞灵感火花 🔥