AI Ping官方链接:https://aiping.cn/#?channel_partner_code=GQCOZLGJ

点击上述链接注册,将获得30元算力金, 小伙伴们快速体验AI Ping强大的功能吧~

前言

在人工智能技术飞速发展的今天,AI编程助手已成为开发者提升效率的利器。然而,随着市场上大模型数量的爆炸式增长,开发者们面临着前所未有的挑战:模型选择困难、 API 集成复杂、调用成本高昂、服务稳定性担忧。这些问题如同四座大山,阻碍着广大开发者充分享受AI技术带来的红利。作为AI Ping的技术专家,我将通过本文为您全面解析如何借助AI Ping这一"大模型智能路由器",构建高效、经济、稳定的下一代智能编程工作流。本文将从AI Ping的核心原理讲起,逐步深入到实战配置、高级技巧和最佳实践,帮助您彻底告别API碎片化与高成本困境。

一、深入理解AI Ping:大模型时代的"调度中枢"

1.1 大模型市场的现状与痛点

当前大模型市场呈现出"百花齐放"但"鱼龙混杂"的局面。国内外知名厂商如OpenAI、Anthropic、MiniMax、智谱AI、月之暗面等纷纷推出各自的大模型服务,总数已达数百种。然而,这种繁荣背后隐藏着诸多问题:

-

性能差异巨大:不同模型在代码生成、逻辑推理、中文理解等特定任务上表现差异显著

-

价格体系复杂:各家的计费方式(按Token、按调用次数、按时长)各不相同,难以直接比较

-

服务质量不稳定:受服务器负载、网络环境等因素影响,同一模型在不同时间的响应质量波动较大

-

技术门槛较高:需要掌握各家的SDK和API规范,学习成本不容忽视

图1-1:AI Ping 平台首页提供了清晰的模型性能排行和导航入口

1.2 AI Ping的诞生与核心定位

AI Ping是由清华系AI Infra创新企业清程极智推出的一站式 大模型 服务评测与 API 调用平台 。其核心定位是成为连接开发者与各大模型服务的"智能调度中枢",通过技术创新解决上述行业痛点。平台的核心设计理念:

-

标准化:将不同厂商的API规范统一成OpenAI兼容格式

-

透明化:通过实时性能监控和排行榜,让服务质量"看得见"

-

智能化:基于算法自动选择最优服务提供商

-

经济化:通过比价和优化调度,帮助用户节约成本

1.3 AI Ping的架构解析:三层核心设计

AI Ping的技术架构可以分为三个核心层次:

- 接入层

-

负责与各大模型服务商建立稳定连接

-

实现协议转换和数据格式统一

-

目前已完成28+主流供应商的接入,覆盖475+细分模型

- 调度层

-

核心的智能路由引擎,基于多维度数据进行决策

-

实时监控各通道的性能指标(延迟、吞吐量、错误率)

-

根据用户配置的优先级(性能优先/成本优先)进行路由选择

- 服务层

-

向开发者提供统一的REST API接口

-

提供用量统计、账单管理、性能分析等增值功能

-

支持WebSocket等高级通信协议

图1-2:AI Ping 的性能坐标图直观展示各模型在延迟和 吞吐量 上的表现

二、AI Ping的核心优势详解

2.1 全量模型聚合:一次集成,全网调用

传统模式下,开发者需要为每个模型服务商单独进行:

-

账户注册和认证

-

API Key申请和管理

-

SDK集成和适配

-

错误处理和重试逻辑

这种方式的工作量随着使用模型数量的增加呈指数级增长。而AI Ping通过统一接口彻底解决了这一问题。技术实现原理:

开发者应用 → AI Ping统一API → 协议转换层 → 各模型服务商这种架构带来的直接好处是:

-

降低90%的集成成本:只需学习一套API规范

-

提高开发效率:快速验证不同模型在特定任务上的表现

-

未来验证:当有新模型出现时,无需修改代码即可体验

2.2 智能路由引擎:AI界的"高频交易系统"

AI Ping的智能路由功能堪称其技术皇冠上的明珠。该系统的运作机制类似于金融领域的高频交易系统,能够在毫秒级别做出最优决策。路由决策的三大维度:

- 性能维度

-

实时监测各供应商的P90延迟(反映服务稳定性的关键指标)

-

跟踪吞吐量变化,识别性能瓶颈

-

根据历史数据预测未来一段时间内的性能表现

- 成本维度

-

建立全市场比价系统,实时捕捉最优价格

-

考虑不同供应商的计费规则差异(如Token计算方式不同)

-

支持用户设置预算上限和成本告警

- 质量维度

-

通过标准化测试集评估各模型的输出质量

-

针对不同任务类型(代码生成、文本创作、逻辑推理)建立专门的质量评估体系

-

结合用户反馈数据持续优化质量评估算法

图2-1:AI Ping 智能路由引擎根据性能、成本、质量等多维度数据自动选择最优供应商

实际效果数据(基于平台官方统计):

-

成本降低:平均节省50%以上API调用费用

-

性能提升:吞吐量提升33%,延迟降低20%

-

可用性:服务成功率高达99.95%

2.3 客观性能评测:让选型告别"盲人摸象"

AI Ping建立了行业领先的大模型性能评测体系,该体系具有以下特点:

评测的全面性:

-

7×24小时不间断监测:避免单时间点测试的偶然性

-

多地域部署监测点:覆盖国内外主要网络环境

-

多维度指标:包括首Token延迟、Token输出速率、错误率等

评测的客观性:

-

与清华大学、中国软件评测中心等权威机构合作

-

采用标准化的测试数据集和评估方法

-

定期发布《大模型服务性能排行榜》,成为行业选型参考

评测的实用性:

-

针对开发者常见场景设计专项测试(如代码生成、文档总结)

-

提供不同价格区间的性价比排行榜

-

支持用户自定义测试场景和评估标准

图2-2:AI Ping 提供的实时性能排行榜帮助开发者基于数据做出科学选型决策

2.4 成本透明化管理:让每一分钱都花在明处

传统的模型调用中,成本控制是个黑盒问题。AI Ping通过以下机制实现完全的成本透明化:

实时用量监控:

-

精确到每个请求的Token消耗统计

-

支持按项目、按模型、按时间维度进行用量分析

-

提供用量预测和预算提醒功能

智能成本优化:

-

自动识别并提示成本异常波动

-

推荐更具性价比的模型替代方案

-

提供闲时调度建议,利用价格波动节约成本

三、AI Ping的典型应用场景

3.1 智能编程辅助:从"代码打字员"到"逻辑架构师"

AI Ping与主流编程工具的结合,让开发者实现真正的"Vibe Coding"(氛围编程)。

支持的工具生态:

-

IDE 插件:VSCode + Cline/Claude Code、Cursor、JetBrains全家桶

-

CLI 工具:Claude Code、Codex CLI、Grok CLI

-

低代码 平台:Dify、Coze、LangChain

典型 工作流 提升:

-

代码生成:通过自然语言描述需求,自动生成高质量代码

-

代码审查:智能识别潜在bug和优化点

-

文档生成:自动生成API文档和代码注释

-

测试用例 编写:快速生成单元测试和集成测试用例

3.2 企业级应用开发:降本增效的利器

对于需要大规模使用AI能力的企业,AI Ping提供企业级解决方案:

统一管理平台:

-

多项目资源隔离和权限管理

-

集中式的API Key管理和轮换

-

详细的访问日志和审计功能

定制化路由策略:

-

根据业务优先级设置不同的路由规则

-

支持私有化模型与公有云模型的混合调度

-

合规性要求和数据隐私保护

3.3 学术研究与模型评测

对于研究机构和模型开发者,AI Ping提供了强大的基准测试平台:

标准化评测环境:

-

消除环境差异对评测结果的影响

-

提供可复现的评测流程和结果

-

支持自定义评测指标和数据集

四、实战教程:从零开始配置AI Ping工作流

4.1 环境准备与账号注册

步骤1:访问AI Ping 平台

- 打开浏览器,访问 AI Ping官网。

图4-1:在AI Ping 官网首页

- 点击右上角"登录"按钮,进行账号的注册与登录。支持手机验证码免注册登录与账号密码登录。

图4-2:AI Ping 登录/注册页面

**注意:**通过别人的邀请码进行注册通常会获得免费算力额度,足够初期体验使用

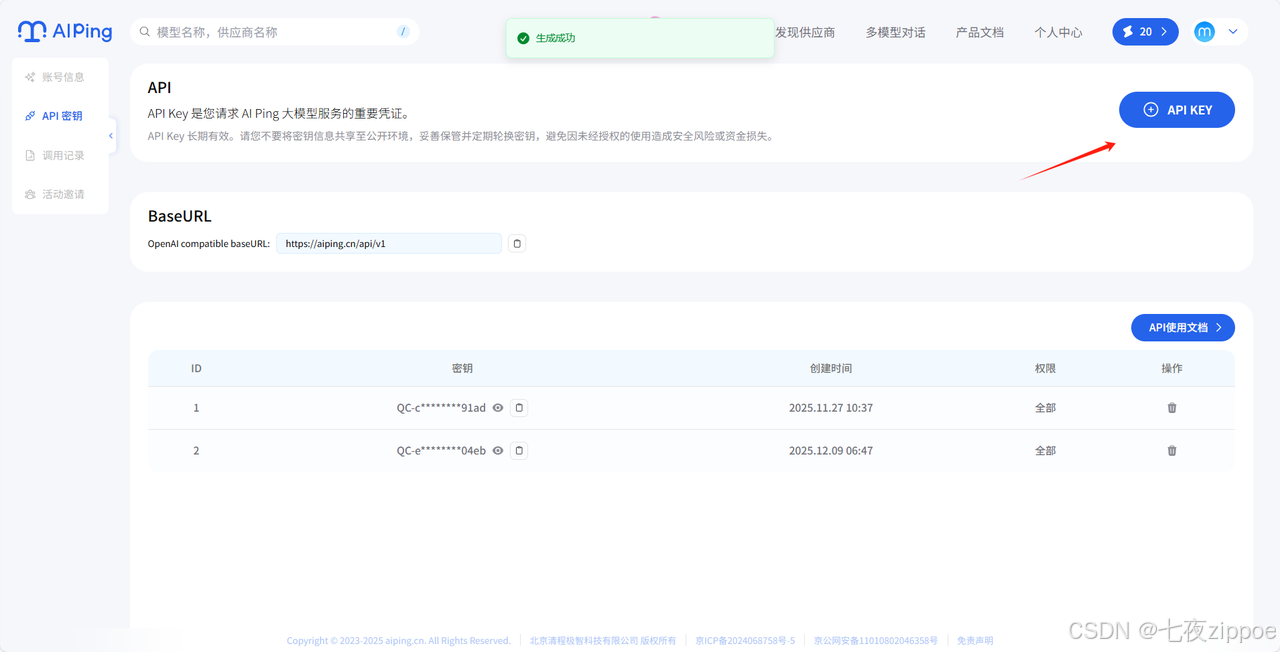

步骤2:获取 API Key

-

登录后进入【个人中心】→ 【API密钥】

-

注册账号时,系统会默认为您创建一个 API key。

-

若需新增,点击右上角的 "API KEY" 按钮即可创建新的以

QC-开头的 API key。使用时点击列表密钥中的复制按钮即可。

图4-3: API KEY创建使用页面

- 重要:请妥善保管密钥,避免泄露。您可以随时删除它。

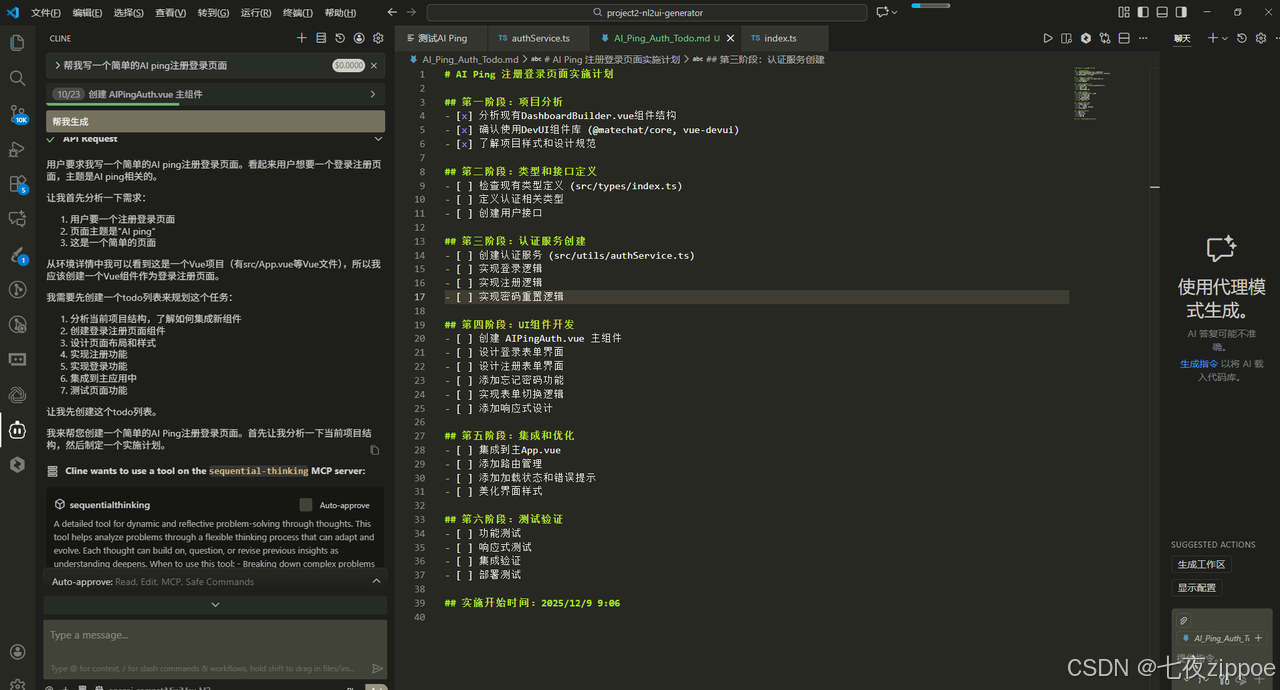

4.2 VSCode + Cline插件配置详解

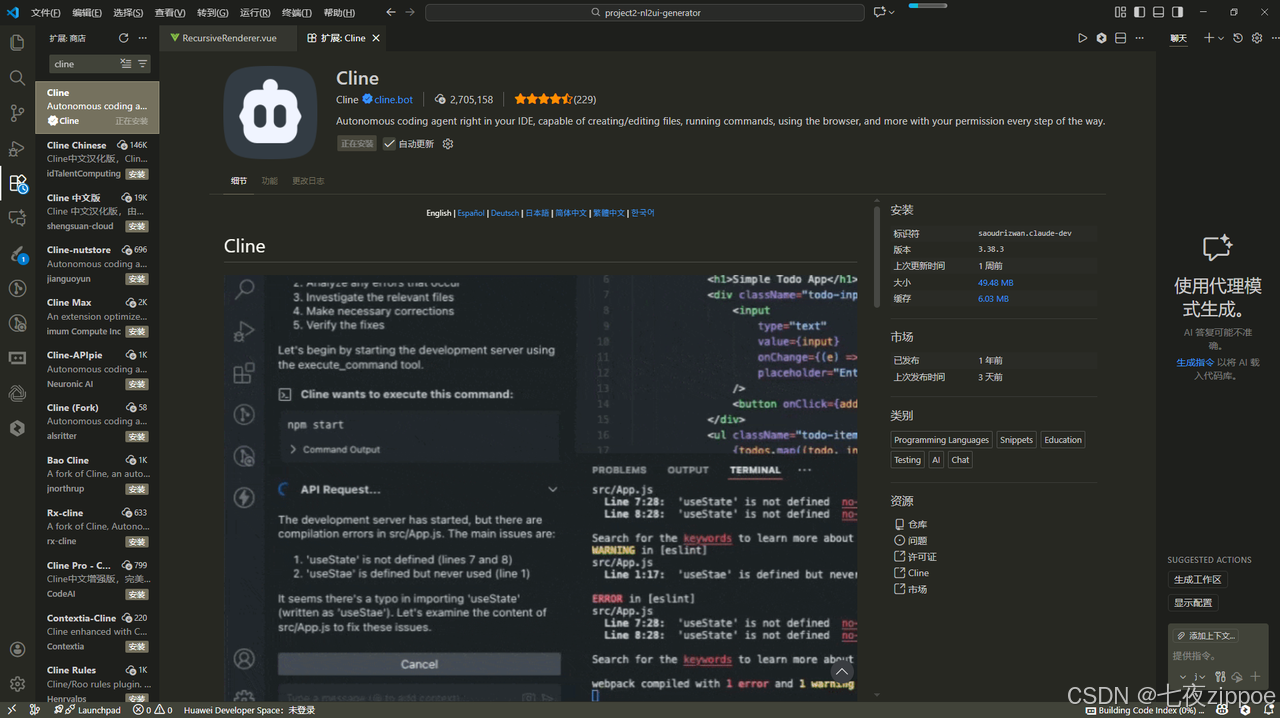

Cline(原Claude Dev)是目前最受欢迎的AI编程插件之一,与AI Ping的集成度最高。详细配置步骤:

-

安装Cline插件

-

打开VSCode,进入扩展市场

-

搜索"Cline"或"Roo Code"

-

点击安装并重启VSCode

-

图4-4:VSCode安装Cline插件

-

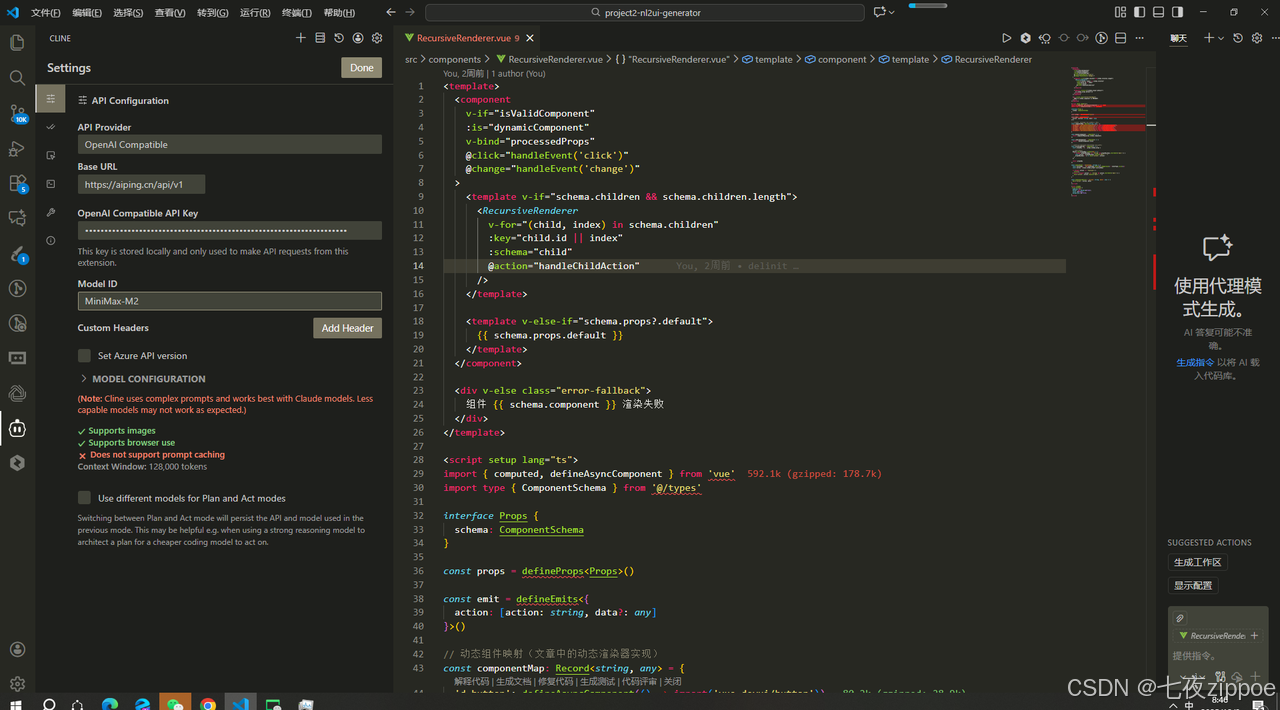

基础配置

-

打开VSCode设置(Ctrl+,)

-

搜索"Cline"相关配置项

-

设置以下关键参数:

-

API Provider: OpenAI Compatible

-

Base URL: https://aiping.cn/api/v1

-

API Key: 您从AI Ping获取的API Key

-

点击右上角的 "Done",保存配置

-

Model ID: 可留空(使用智能路由)或指定如MiniMax-M2

-

-

图4-4:VSCode Cline插件相关AI Ping 的配置展示

-

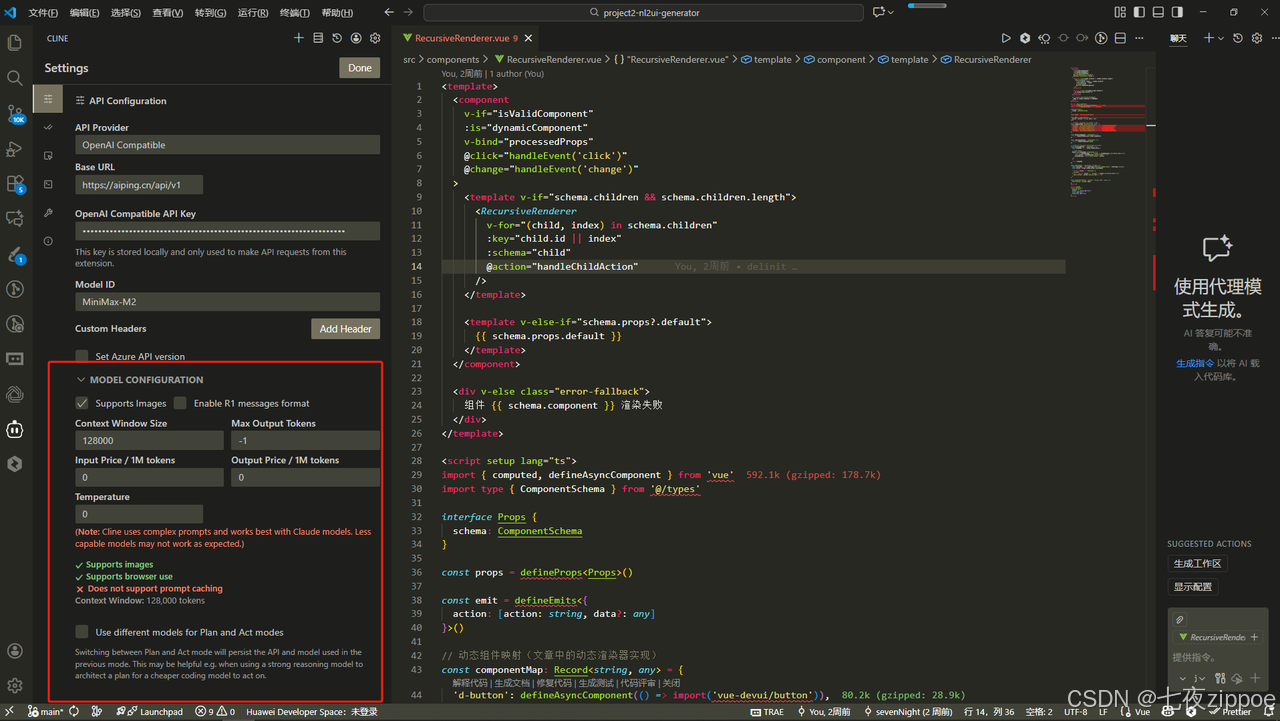

高级配置(可选)

-

设置最大Token数

-

配置温度参数(控制生成多样性)

-

设置请求超时时间

-

图4-6:VSCode Cline插件相关AI Ping 的高级配置参数设置

-

验证配置

-

新建一个文件,尝试让AI生成简单代码

-

观察Cline插件的响应状态指示器

-

检查AI Ping控制台的用量统计,确认调用成功

-

图4-7:在VSCode中配置Cline插件使用AI Ping 测试

4.3 Claude Code命令行工具配置

对于喜欢命令行操作的开发者,Claude Code提供了极致的效率体验。安装与配置:

bash

# 安装Claude Code(需要Node.js 18+)

npm install -g @anthropic-ai/claude-code

# 验证安装

claude --version配置文件设置 :Claude Code的配置文件通常位于~/.claude/settings.json(Linux/macOS)或%USERPROFILE%.claude\settings.json(Windows)。配置文件内容示例:

bash

{

"env": {

"ANTHROPIC_BASE_URL": "https://aiping.cn/api/v1/anthropic",

"ANTHROPIC_AUTH_TOKEN": "<您的AI_PING_API_KEY>",

"API_TIMEOUT_MS": "300000",

"CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC": 1,

"ANTHROPIC_MODEL": "MiniMax-M2",

"ANTHROPIC_SMALL_FAST_MODEL": "MiniMax-M2",

"ANTHROPIC_DEFAULT_SONNET_MODEL": "MiniMax-M2"

}

}基本使用:

bash

# 进入项目目录

cd /path/to/your/project

# 启动Claude Code交互式会话

claude

# 或者在命令行中直接提问

claude "帮我优化这个Python函数的性能"4.4 在Python项目中直接集成AI Ping

对于需要将AI能力集成到自有应用中的场景,可以直接调用AI Ping的API。基本调用示例:

python

import requests

import json

class AIPingClient:

def __init__(self, api_key):

self.base_url = "https://aiping.cn/api/v1"

self.headers = {

'Authorization': f'Bearer {api_key}',

'Content-Type': 'application/json'

}

def chat_completion(self, messages, model=None, temperature=0.7):

payload = {

"messages": messages,

"temperature": temperature

}

if model:

payload["model"] = model

response = requests.post(

f"{self.base_url}/chat/completions",

headers=self.headers,

json=payload

)

if response.status_code == 200:

return response.json()

else:

raise Exception(f"API调用失败: {response.text}")

# 使用示例

client = AIPingClient("您的API Key")

response = client.chat_completion([

{"role": "user", "content": "用Python实现快速排序算法"}

])

print(response['choices'][0]['message']['content'])高级功能集成:

-

流式输出(用于实现打字机效果)

-

函数调用(结构化数据提取)

-

多模态处理(图片、文档等)

五、免费模型深度评测与使用技巧

目前AI Ping平台提供了多款限时免费的高性能模型,以下是详细评测和使用建议。

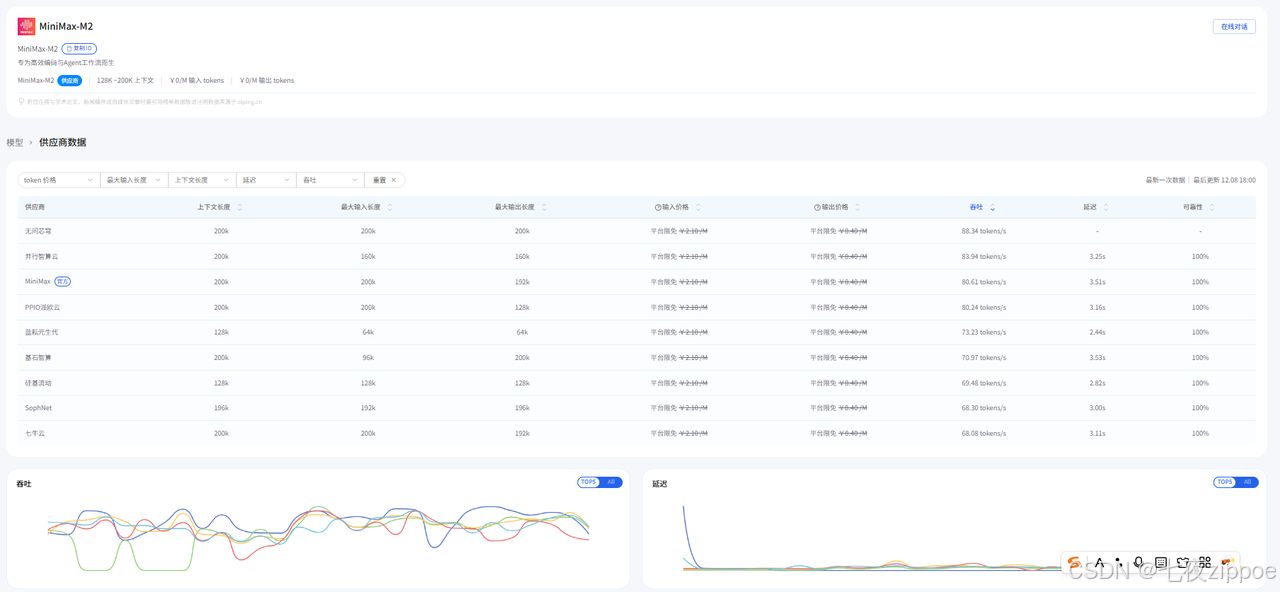

5.1 MiniMax-M2:速度与精度的完美平衡

图5-1:MiniMax-M2模型

模型特点:

-

发布方:MiniMax(深度求索)

-

主要优势:极快的响应速度,优秀的代码生成能力

-

适用场景:实时编程辅助、代码补全、简单逻辑推理

性能数据:

-

首Token延迟:200-400ms

-

输出速度:50-80 Token/秒

-

代码通过率:82%(在HumanEval基准测试)

使用技巧:

-

适合需要快速响应的交互式场景

-

在提示词中明确指定编程语言和框架效果更好

-

对于复杂算法问题,建议拆分成多个简单问题

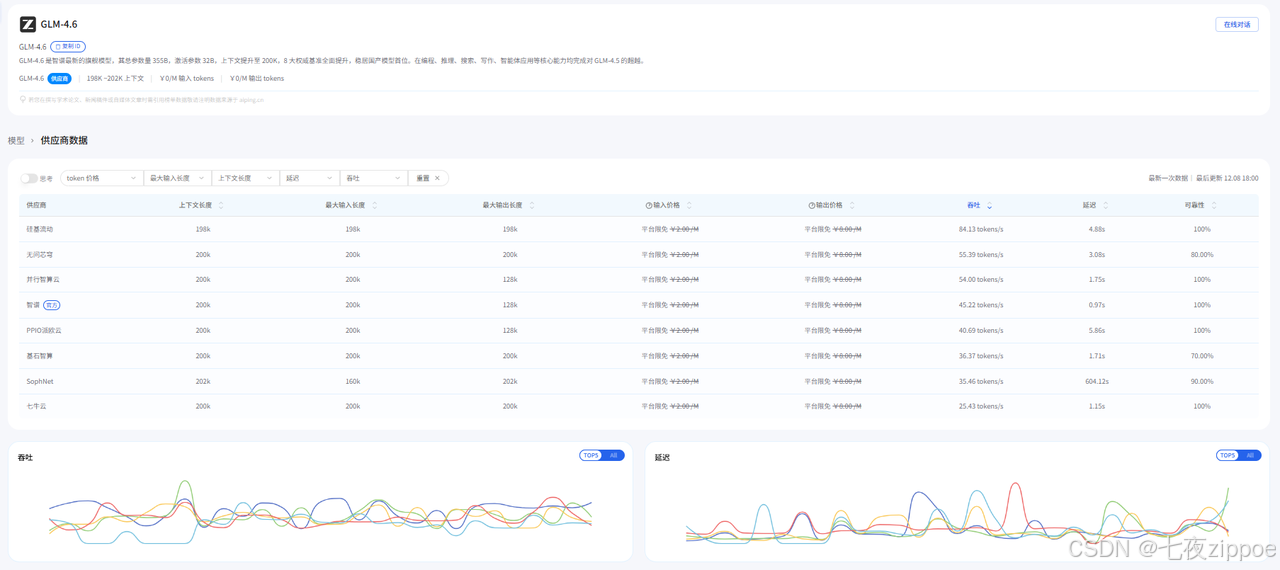

5.2 GLM-4.6:中文场景的深度优化

图5-2: GLM-4.6模型

模型特点:

-

发布方:智谱AI

-

主要优势:卓越的中文理解能力,强大的综合推理能力

-

适用场景:中文文档处理、复杂业务逻辑、系统设计

性能数据:

-

中文理解准确率:89%

-

长文本处理:支持128K上下文

-

多步骤任务解决率:76%

使用技巧:

-

在处理中文需求时表现最佳

-

适合需要深度思考的复杂编程任务

-

利用其长上下文能力处理大型代码库分析

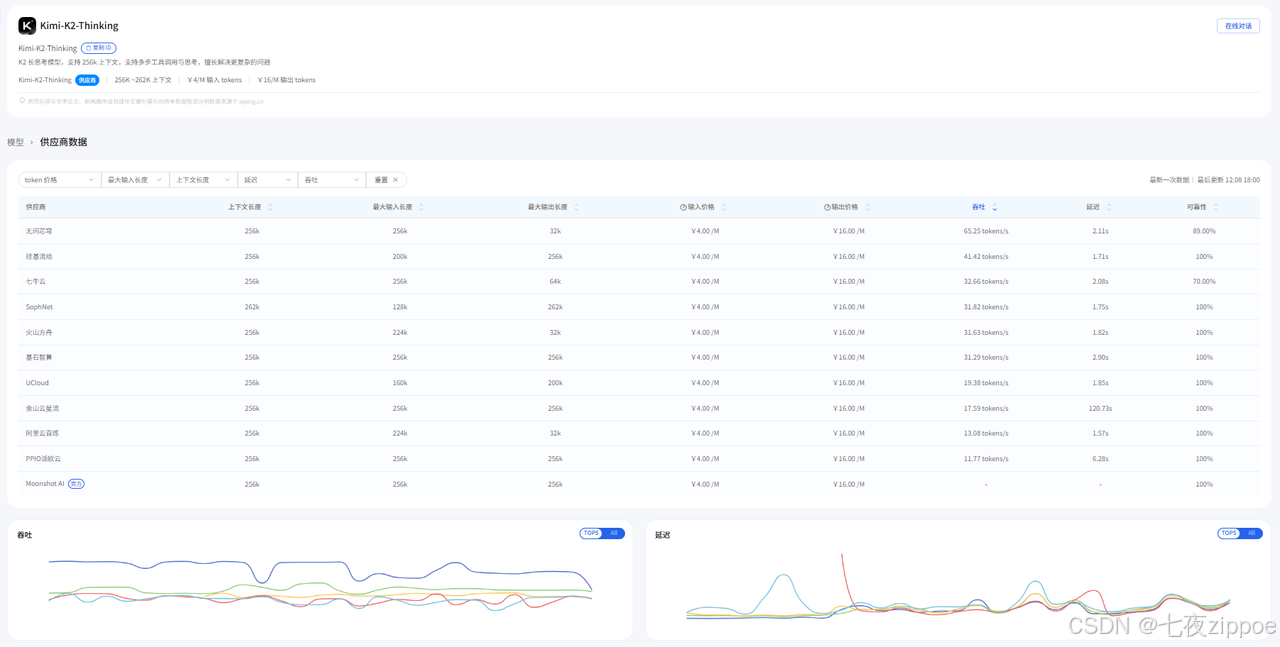

5.3 Kimi-K2-Thinking:超长文本处理的王者

图5-3: Kimi-K2-Thinking模型

模型特点:

-

发布方:月之暗面

-

主要优势:超长上下文窗口(200K+),强大的思维链推理

-

适用场景:大型项目分析、文档总结、复杂系统架构设计

性能数据:

-

上下文长度:200,000+ Token

-

长文档理解准确率:85%

-

复杂推理任务成功率:71%

使用技巧:

-

适合处理整个代码库的分析和重构建议

-

在提示词中充分利用其思维链能力,要求"逐步思考"

-

对于超长文档,建议先提供摘要再询问细节

六、高级技巧与最佳实践

6.1 提示词工程优化

针对AI Ping 环境的特别优化:

- 明确指定任务类型

python

// 好的提示词

你是一个资深Python后端开发专家,请帮我优化这个数据库查询函数的性能...

// 差的提示词

优化这个函数...-

利用模型特有优势

-

对MiniMax-M2:强调速度和简洁性

-

对GLM-4.6:充分利用其中文理解能力

-

对Kimi-K2-Thinking:提供充足上下文,要求逐步推理

-

-

迭代式优化策略

-

第一轮:获取基础实现

-

第二轮:要求优化和改进

-

第三轮:针对特定边缘案例进行加固

-

6.2 成本优化策略

智能路由配置:

python

# 根据任务类型自动选择模型

def get_optimal_model(task_type, budget_constraint):

if task_type == "code_generation" and budget_constraint == "low":

return None # 让AI Ping智能路由选择

elif task_type == "document_analysis":

return "aiping/kimi-k2-thinking"

# ... 其他规则用量监控与告警:

-

设置每日/每月用量上限

-

配置成本异常波动告警

-

定期审查用量报告,优化使用模式

6.3 性能与稳定性保障

重试机制实现:

python

import time

from requests.exceptions import RequestException

def robust_api_call(client, messages, max_retries=3):

for attempt in range(max_retries):

try:

response = client.chat_completion(messages)

return response

except RequestException as e:

if attempt == max_retries - 1:

raise e

wait_time = 2 ** attempt # 指数退避

time.sleep(wait_time)缓存策略:

-

对频繁查询的常见问题建立缓存

-

根据业务需求设置合理的缓存过期时间

-

注意缓存敏感信息和实时性要求高的内容

七、典型应用案例深度解析

7.1 个人开发者:零成本构建全功能开发环境

背景 :独立开发者张工,预算有限但需要高效的AI编程助手。解决方案:

-

注册AI Ping获取免费额度

-

配置VSCode + Cline插件

-

使用智能路由,不指定具体模型

成效:

-

零资金投入获得企业级AI编程能力

-

开发效率提升3倍以上

-

代码质量显著提高,bug率降低40%

7.2 创业团队:快速迭代的产品开发

背景 :10人技术团队,需要快速开发MVP产品。解决方案:

-

统一使用AI Ping作为AI能力底座

-

为不同场景配置不同的路由策略

-

代码生成:成本优先模式

-

技术方案设计:质量优先模式

-

-

建立团队共享的提示词库和最佳实践

成效:

-

API相关开发成本降低60%

-

产品迭代速度提升50%

-

团队协作效率显著提高

7.3 企业用户:规模化AI能力集成

背景 :大型企业需要将AI能力集成到现有产品线。解决方案:

-

采用AI Ping企业版,实现多项目资源隔离

-

建立私有化模型与公有模型的混合调度

-

实现细粒度的权限管理和审计日志

成效:

-

统一管理全公司的AI资源

-

满足合规性和安全性要求

-

总体拥有成本(TCO)降低45%

八、未来展望与生态发展

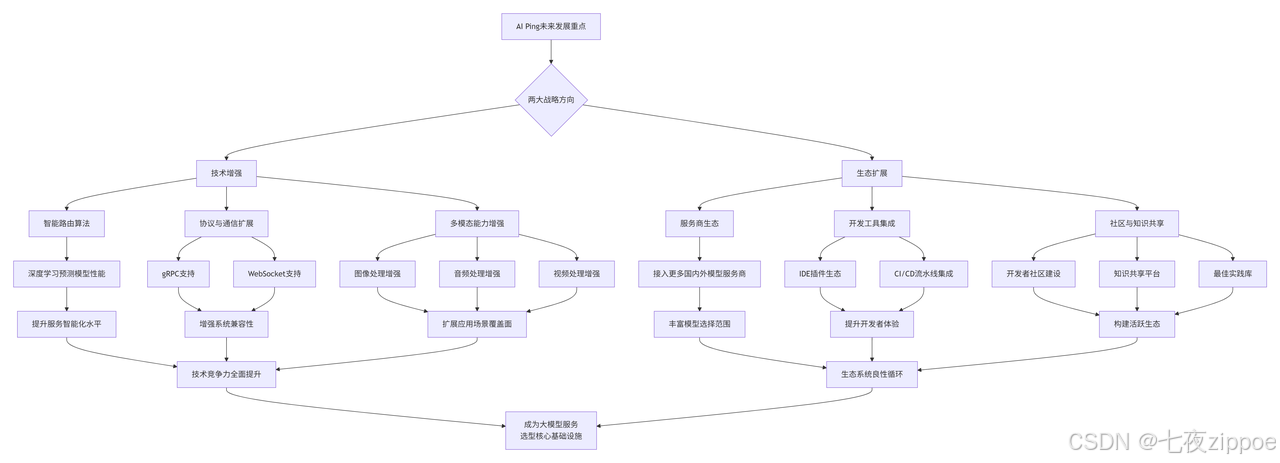

8.1 AI Ping技术路线图

8.2 行业趋势与机遇

随着大模型技术的普及,我们预见以下趋势:模型服务化 :模型能力将像云计算资源一样标准化和商品化垂直化解决方案 :针对特定行业和场景的定制化模型服务将涌现边缘计算融合:云端大模型与边缘设备的协同计算成为重要方向

九、总结与行动指南

AI Ping通过其创新的"智能路由+统一API"模式,真正实现了让每个开发者平等享受AI红利 的愿景。无论您是个人开发者、创业团队还是企业用户,都能从中获得显著的价值。立即行动清单:

-

注册体验 :访问 AI Ping官网注册账号;

-

基础配置:选择最适合您的开发工具(VSCode+Cline或Claude Code)进行配置;

-

实践探索:从简单的代码生成任务开始,逐步探索更复杂的应用场景;

-

优化提升:根据本文的最佳实践,持续优化您的使用模式和提示词技巧;

-

参与社区:加入AI Ping开发者社区,与其他用户交流经验。

资源获取:

在AI技术日新月异的今天,掌握像AI Ping这样的高效工具,将帮助您在激烈的技术竞争中保持领先地位。立即开始您的AI Ping之旅,体验智能编程的全新工作流吧!