LangChain 表达式语言(LCEL)的推出,标志着 AI 应用开发从"脚本时代"进入了"声明式编排时代"。很多人初看 LCEL,以为它只是几个竖线管道符(|)的语法糖。但实际上,LCEL 隐藏着一套强大的工具箱,能帮助我们解决数据流转、容错机制、记忆管理等复杂的生产级问题。

本文将深入剖析 LCEL 的 10 个关键特性,带你从"会写代码"进阶到"构建架构"。

第一部分:数据流的掌控艺术

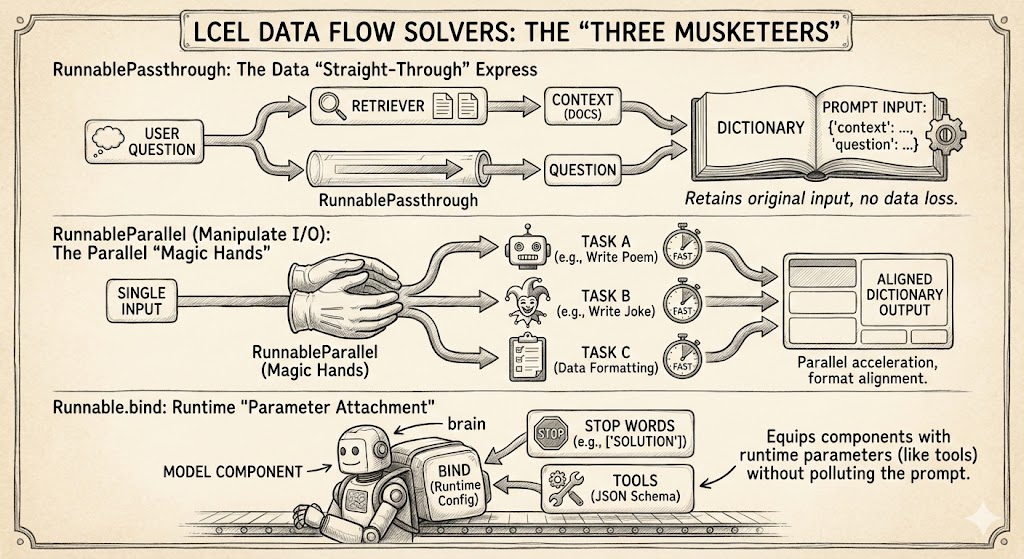

在构建 RAG(检索增强生成)或复杂链条时,数据如何在组件间传递是最大的痛点。以下三个特性是解决数据流问题的"三剑客"。

1. RunnablePassthrough:数据的"直通车"

在流水线中,我们经常遇到这样的困境:下一步(如 Prompt)需要两个参数(context 和 question),但上一步只有一根管道流过来(比如用户的 question)。

RunnablePassthrough 就是为此而生的。它像一个占位符,允许输入数据"原样通过",通常配合并行处理使用。

-

核心作用:保留原始输入,防止数据在中间步骤丢失。

-

经典场景:RAG 检索。

Python

# 输入是 "问题" chain = { "context": retriever, # 一路去查资料变身为文档 "question": RunnablePassthrough() # 另一路保持原样,作为问题传下去 } # 输出给 Prompt 的就是完整的字典:{"context": ..., "question": ...}

2. RunnableParallel (操纵输入和输出):并行的"魔术手"

RunnableParallel(旧称 RunnableMap)是数据格式转换的核心。它不仅能将单一输入"分身"为多个输出,还能利用并行计算能力加速执行。

-

核心作用:

-

格式对齐:将上一步的输出调整为下一步(通常是 Prompt)所需的字典格式。

-

并行加速:如果链条中有两个互不依赖的任务(例如同时写一首诗和写一个笑话),它会自动并行执行,将总耗时压缩至最慢任务的耗时。

-

-

最佳实践 :结合

itemgetter从复杂的输入字典中精准提取字段,像手术刀一样处理数据。

3. Runnable.bind:运行时的"参数挂载"

有时候,我们需要给链条中的某个组件(特别是大模型)传递一些常量配置,这些配置既不是用户输入的,也不是上一步生成的。

-

核心作用:给组件"自带干粮"。

-

经典场景:

-

控制生成 :

model.bind(stop=["SOLUTION"]),让模型遇到特定词就停止。 -

OpenAI 工具调用 :这是最强大的用法。通过

model.bind(tools=tools),你可以将定义好的 JSON Schema 工具箱直接挂载到模型上,让模型具备调用外部函数的能力,而无需污染 Prompt。

-

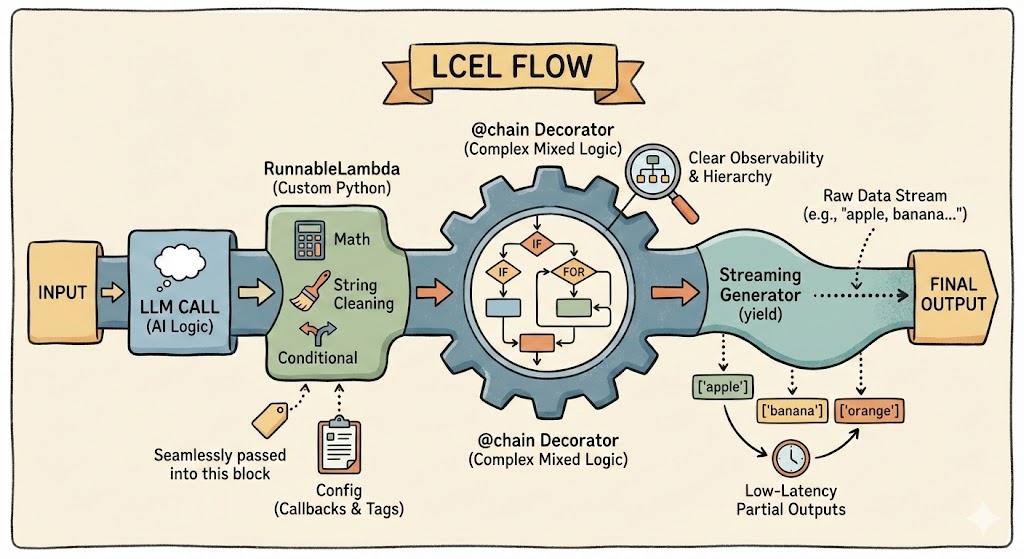

第二部分:自定义逻辑与流式增强

LCEL 不仅仅是调用 API,它允许你通过 Python 代码无缝嵌入复杂的业务逻辑。

4. 运行自定义函数 (RunnableLambda)

LCEL 的流水线并不排斥原生 Python 代码。通过 RunnableLambda,你可以将任何 Python 函数包装成链条的一部分。

-

核心作用:处理非 AI 逻辑,如数学计算、字符串清洗、复杂的条件判断。

-

高级技巧 :自定义函数可以接收

RunnableConfig参数。这意味着即使是在你手写的 Python 函数内部运行的子链,也能正确传递回调函数(Callbacks)和标签(Tags),确保监控链路(如 LangSmith)不中断。

5. @chain 装饰器:混合开发的终极形态

当你觉得用 | 符号拼接链条逻辑过于复杂(例如涉及循环或多重嵌套判断)时,@chain 装饰器是你的救星。

-

核心作用:将任意 Python 函数直接转换为 Runnable 对象。

-

优势 :在被装饰的函数内部,你可以随意混合使用 Python 的原生控制流(

if,for)和 LCEL 语法。同时,它还能保留 LangChain 的可观察性,在监控后台呈现出清晰的层级结构,而不是散落的日志。

6. 流式自定义生成器函数:不打断的"流水线"

Python 的 yield 关键字在 LCEL 中得到了原生支持。这是构建低延迟 AI 应用的关键。

-

核心作用 :允许你在处理流式数据时,一边接收、一边处理、一边输出。

-

经典场景 :自定义输出解析器。例如,模型正在生成逗号分隔的列表

"apple, banana, orange..."。使用生成器函数,你可以在检测到第一个逗号时,立刻向前端发送["apple"],而不需要等整句话生成完。这极大地提升了用户体验。

第三部分:构建健壮与智能的系统

生产环境是残酷的,我们需要容错机制、记忆能力和决策能力。

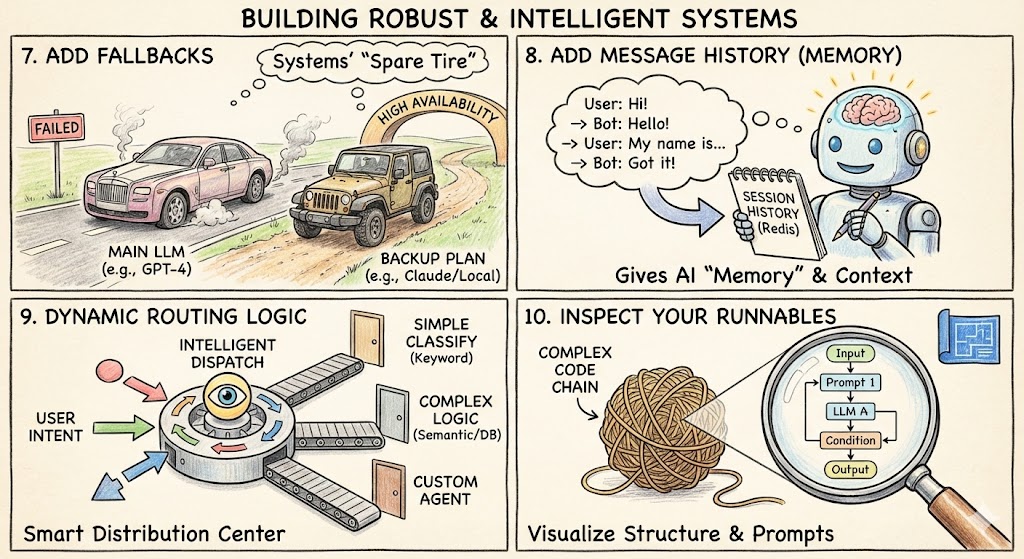

7. 添加回退 (Fallbacks):系统的"备胎计划"

依赖单一 LLM 供应商由于网络波动、限流或宕机,风险极高。回退机制允许你定义优先顺序。

-

核心作用:高可用性保障。

-

工作流:主模型(如 GPT-4)报错 -> 自动切换备用模型(如 Claude 或本地模型)。

-

细节:不仅仅是模型,整个链条都可以回退。如果复杂的 RAG 链条失败,可以回退到一个简单的通用问答链条,确保用户永远不会看到"系统错误"。

8. 添加消息历史记录 (Memory):赋予 AI"记忆"

默认情况下,LLM 是无状态的。RunnableWithMessageHistory 是让 Chatbot 记住上下文的标准组件。

-

核心作用:自动管理 Session。

-

工作原理 :它像一个中间件,在调用模型前,根据

session_id自动从存储(如 Redis)中拉取历史记录注入 Prompt;在模型回复后,自动将新对话存回存储。 -

配置 :需要精准配置

input_messages_key(新消息)和history_messages_key(历史插槽),以确保 Prompt 格式正确。

9. 动态路由逻辑:智能分发中心

根据用户的意图,走不同的处理流程,是构建 Agent(智能体)的雏形。

-

核心作用:非确定性链条。根据输入决定下一步执行谁。

-

实现方式:

-

RunnableBranch:声明式的路由,适合简单的分类(如:关键词匹配)。

-

自定义工厂函数:编程式路由,通过 Python 函数编写复杂的路由逻辑(如:语义分析、数据库查询状态),返回对应的 Runnable 对象。

-

10. 检查你的可运行对象:透视代码结构

LCEL 代码写起来像一条线,但实际运行逻辑可能是一张复杂的图。

-

核心作用:可视化与调试。

-

工具:

-

chain.get_graph().print_ascii():打印出链条的 ASCII 流程图,帮你检查并行分支和逻辑连接是否正确。 -

chain.get_prompts():一键提取链条中嵌套的所有 Prompt 模板,方便进行内容审查和统一管理。

-

结语

LangChain 的 LCEL 不仅仅是一种语法,它是一套构建认知架构的标准化语言。

-

用 Passthrough 和 Parallel 管理数据;

-

用 Bind 和 Custom Functions 增强能力;

-

用 Fallbacks 和 Memory 确保稳定;

-

用 Routing 实现智能。