文章目录

- [语言学:自然语言处理 (NLP) 的底层逻辑](#语言学:自然语言处理 (NLP) 的底层逻辑)

-

- [第一层:声音的密码 ------ 语音学与音系学](#第一层:声音的密码 —— 语音学与音系学)

-

- [1. 语音学 :物理层面的声音](#1. 语音学 :物理层面的声音)

- [2. 音系学 :抽象层面的规律](#2. 音系学 :抽象层面的规律)

- [第二层:词汇的积木 ------ 形态学](#第二层:词汇的积木 —— 形态学)

-

- [1. 核心概念:语素](#1. 核心概念:语素)

- [2. 中西构词法的巨大差异](#2. 中西构词法的巨大差异)

- [第三层:句子的骨架 ------ 句法学](#第三层:句子的骨架 —— 句法学)

-

- [1. 两大分析流派](#1. 两大分析流派)

- [2. 中文的特殊挑战](#2. 中文的特殊挑战)

- [第四层:意义的深渊 ------ 语义学](#第四层:意义的深渊 —— 语义学)

-

- [1. 词汇语义:从符号到向量](#1. 词汇语义:从符号到向量)

- [2. 句子语义:谁对谁做了什么?](#2. 句子语义:谁对谁做了什么?)

- [第五层:言外之意 ------ 语用学](#第五层:言外之意 —— 语用学)

- 总结:从语言学到大模型 (LLM)

语言学:自然语言处理 (NLP) 的底层逻辑

自然语言处理(NLP)是人工智能皇冠上的明珠,而语言学则是这顶皇冠的基石。如果说深度学习提供了"算力"和"算法",那么语言学则提供了"数据逻辑"和"解构规则"。

要让机器像人一样理解语言,我们必须先搞清楚:人类语言究竟是如何运作的?我们将沿着语音 -> 词汇 -> 句法 -> 语义 -> 语用的层级,逐层拆解。

第一层:声音的密码 ------ 语音学与音系学

(让机器"听见"与"发声"),这一层是语言的物理入口。计算机处理语音(ASR)或合成语音(TTS)时,必须理解声音是如何产生和感知的。

1. 语音学 :物理层面的声音

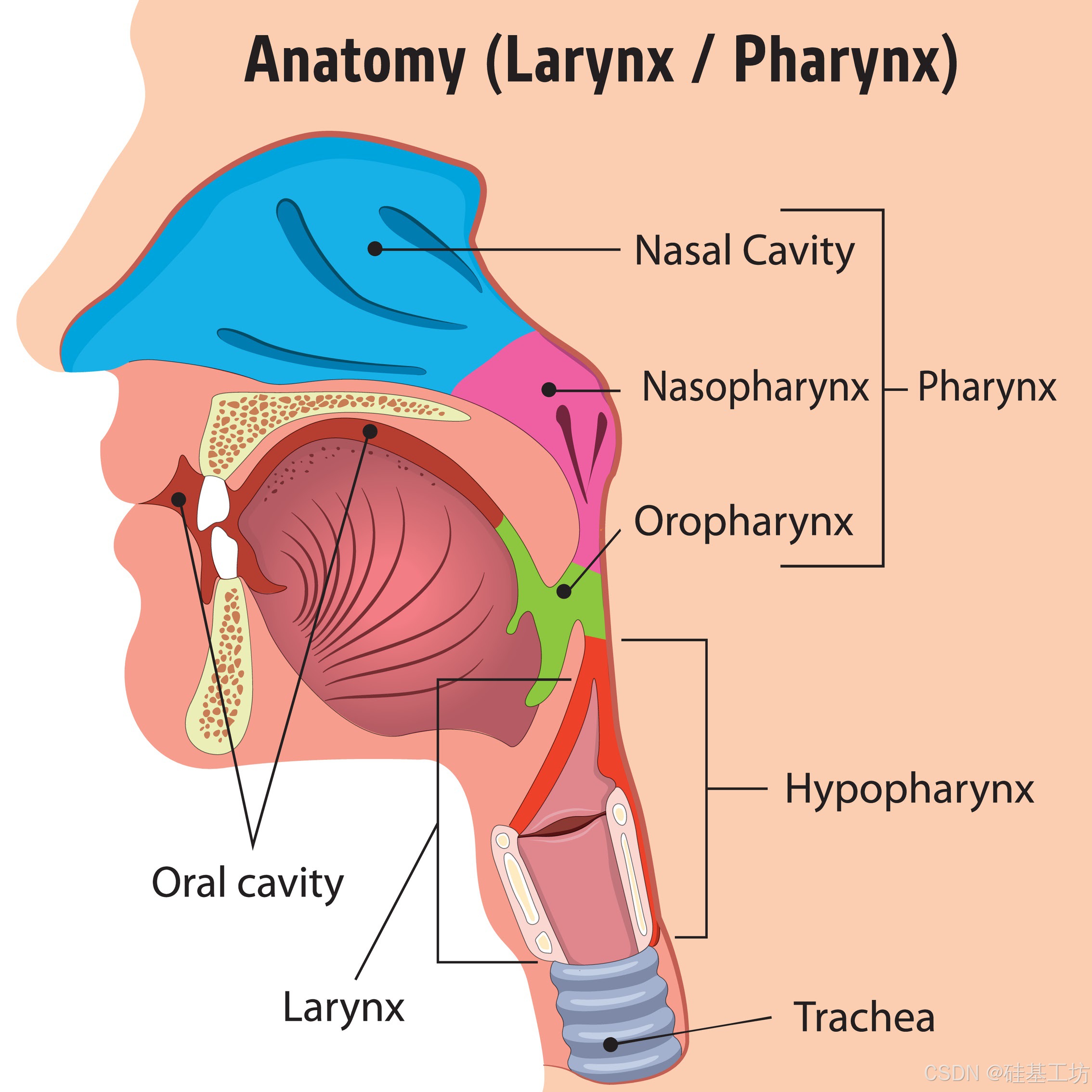

研究声音的产生(发音)、传播(声学)和感知(听觉)。

- 元音与辅音: 类似于音乐的音符。

- 辅音(气流受阻):如爆破音 /p/, /b/。

- 元音(气流通畅):由舌位高低前后决定,如 /a/, /i/, /u/。

- 发音器官: 理解声带震动(浊音)与不震动(清音)的区别,是语音合成真实感的关键。

2. 音系学 :抽象层面的规律

研究声音如何在特定语言中发挥区别意义的功能。

- 音位 (Phoneme): 能够区别意义的最小单位。比如英语中 pit 和 bit 的区别在于 /p/ 和 /b/。

- 声调 (Tone): 汉语的灵魂。妈 (mā) 和 马 (mǎ) 音节相同,但声调不同导致意义完全不同。这是中文语音识别的一大难点。

NLP 应用:

- 语音识别 (ASR): 将声波波形映射到音位序列。

- 语音合成 (TTS): 不仅要读出字,还要计算韵律(Prosody)和重音,让 AI 说话不带"机器味"。

第二层:词汇的积木 ------ 形态学

(让机器理解"词"的构成)

词是语言意义的最小独立单位,但词本身也是由更小的零件拼装起来的。

1. 核心概念:语素

语素是最小的有意义单位。

- 词根 (Root): 词的核心,如 "happy"。

- 词缀 (Affix): 改变意义或词性的零件。

- un- (前缀,表否定) + happy + -ness (后缀,名词化) = unhappiness。

2. 中西构词法的巨大差异

- 英语(屈折语): 词形变化丰富。run, runs, ran, running 。NLP 需要做词干提取 (Stemming) 或 词形还原 (Lemmatization) 来把它们归一化。

- 汉语(孤立语): 没有词形变化(不说"我吃ed饭")。但汉语有着强大的复合构词法 :

- 电脑 = 电 + 脑

- 手机 = 手 + 机

- 说明 (动词+补语)、地震(主语+谓语)

NLP 应用:

- 分词 (Tokenization): 英文靠空格,中文靠算法。BERT 等模型使用的 Subword (子词) 技术(如 Byte-Pair Encoding),正是利用形态学原理,解决未登录词(OOV)问题。

第三层:句子的骨架 ------ 句法学

(让机器理解"语法结构")

单词堆在一起不是句子,结构决定了逻辑。"狗咬人" 和 "人咬狗" 词汇一样,但结构不同,新闻价值也不同。

1. 两大分析流派

- 短语结构文法 (Constituency Parsing): 把句子拆成层级块。

- S (句子) -> NP (名词短语) + VP (动词短语)

- "那个穿红裙子的女孩 (NP) | 吃了 (V) | 一个苹果 (NP)"

- 依存文法 (Dependency Parsing): 关注词与词之间的支配关系。核心是动词。

- "吃" 是核心,"女孩" 是主语(施事),"苹果" 是宾语(受事)。

2. 中文的特殊挑战

- 意合为主: 英文重"形合"(用连接词),中文重"意合"(靠逻辑)。

- 英文:Because it rains, I won't go.

- 中文:下雨了,不去。(省略了关联词和主语,机器容易晕)。

- 流水句: 中文句子往往很长,由逗号分隔多个分句,主语经常在中间省略或变换。

NLP 应用:

- 机器翻译: 必须理解源语言的句法树,才能转换成目标语言的语序(如英语SVO变为日语SOV)。

- 语法纠错: Word/Grammarly 的红线提示,背后就是句法分析器。

第四层:意义的深渊 ------ 语义学

(让机器懂"意思")

语法正确不代表有意义(如:"绿色的想法愤怒地睡觉")。语义学研究如何计算意义。

1. 词汇语义:从符号到向量

- 多义词: Bank 是银行还是河岸?需要词义消歧 (WSD)。

- 向量表示 (Word Embedding): 现代 NLP 的核心突破。将词义映射到高维空间。

- 经典公式:King - Man + Woman ≈ Queen。

- 距离越近,语义越相似(如"猫"和"狗"距离近,"猫"和"汽车"距离远)。

2. 句子语义:谁对谁做了什么?

- 语义角色标注 (SRL): 无论句子是被动还是倒装,核心逻辑不变。

- 我打破了窗户。 / 窗户被我打破了。 / 把窗户打破的是我。

- 施事:我;受事:窗户;动作:打破。

NLP 应用:

- RAG (检索增强生成): 基于语义相似度检索相关文档,防止大模型胡说八道。

- 知识图谱: 提取实体间的语义关系(实体A -[关系]-> 实体B)。

第五层:言外之意 ------ 语用学

(让机器读懂"空气")

这是 NLP 的最高阶挑战。在这个层面,字面意思往往不是真实意图。

- 语境 (Context):

- A: "你会开车吗?"

- B: "我喝酒了。"

- 字面上 B 没有回答是或否,但语用上 B 的意思是 "我不能开"。

- 言语行为 (Speech Acts):

- "这就不是人干的事!" ------ 这是在骂人,还是在夸奖神迹?完全取决于语境。

- 指代消解:

- "小明打了小强,因为他偷了东西。" 这个"他"是谁?人类通过常识知道是小强,机器则很难判断。

NLP 应用:

- 多轮对话系统: ChatGPT 之所以强大,是因为它能记住之前的对话历史(上下文),并理解用户的隐含意图(如反讽)。

总结:从语言学到大模型 (LLM)

传统的 NLP 试图用代码手动写出上述所有规则(规则学派),结果失败了,因为语言太复杂。 后来的统计 NLP 试图计算词出现的概率(统计学派)。 现在的 大语言模型 (LLM) ,如 GPT,通过阅读海量文本,隐式地学会了上述所有层级:

- 它学会了拼写(形态学);

- 它学会了语法(句法学);

- 它理解了概念关联(语义学);

- 它甚至学会了看眼色(语用学)。

掌握语言学基础,能让你明白 AI 为什么会犯错(如幻觉、逻辑断裂),以及如何设计更好的提示词(Prompt Engineering)来引导模型遵循人类的语言逻辑。