最后应该是Raw Data级融合

与点云级融合(处理的是 x,y,zx,y,z 坐标)不同,Raw Data 融合直接处理传感器输出的最原始信号:

-

Camera: 原始像素亮度值 (Pixel Intensity / RAW Bayer)。

-

LiDAR: 原始光子计数波形 (Photon Count / Full Waveform)。

-

Radar: 原始中频信号或频域数据 (ADC Data / Range-Doppler Map)。

目前,这种融合在学术界很热,但在量产车上极少见(因为算力消耗巨大且带宽惊人),主要用于极端环境下的增强感知。

1. 什么是 Raw‑Data 级感知融合

在自动驾驶系统中,各类传感器(摄像头、激光雷达、毫米波雷达、超声波等)会在同一时刻产生原始测量数据。Raw‑Data 级融合(也称 早期融合 / 前期融合)直接在这些未经过高级特征提取的原始数据层面进行空间对齐、投影或拼接,然后再送入统一的感知网络进行特征学习和目标检测。相比于在检测结果或高层特征上再融合,Raw‑Data 融合能够保留最完整的环境信息,从而提升感知的精度和鲁棒性。

为什么要做这么底层的融合?

传统的点云/目标级融合都有"信息损失":

-

LiDAR 把波形变成了点,丢掉了回波的形状信息(这能区分雾气和实物)。

-

Radar 把频域图通过 CFAR 变成了点,丢掉了微弱目标的能量(这能检测被遮挡的行人)。

Raw Data 融合试图保留所有原始信息,让深度神经网络自己去提取特征,而不是依赖人工设计的预处理(如 ISP 或 CFAR)。

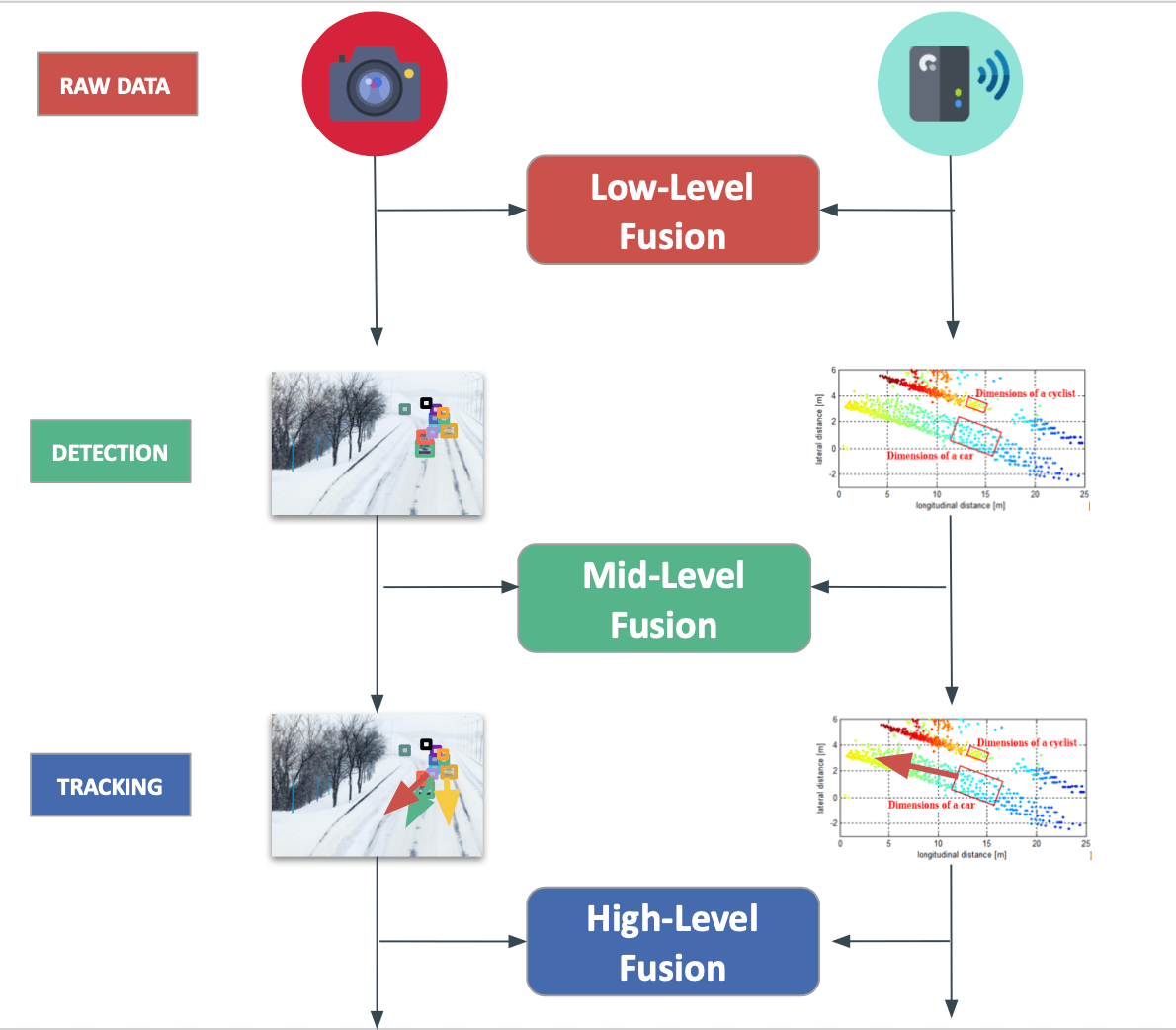

2. 融合范式的层次划分

| 融合层级 | 主要特点 | 典型实现方式 |

|---|---|---|

| 原始数据层(前期融合) | 直接对齐原始图像、点云、雷达回波等;数据量大、对时空同步要求高 | 投影到统一坐标系、拼接成多通道 BEV、点云‑图像拼接(Point‑Painting) |

| 特征层(中期融合) | 先对每个模态提取特征,再在特征空间进行融合;兼顾信息完整性与计算效率 | CNN‑Feature + PointNet++‑Feature → Cross‑Attention、Transformer 融合 |

| 目标层(后期融合) | 只融合各模态的检测框或轨迹;通信开销最小,信息损失最大 | 多模态检测结果加权平均、置信度融合、轨迹级卡尔曼滤波 |

这一定义来源于多篇综述与技术报告的统一划分。

主流的 Raw‑Data 融合算法与技术路线

A. Radar-Optical Fusion (雷达频谱图+图像)

这是目前最有潜力的方向,特别是对于恶劣天气。

-

输入:

-

Camera: RGB 图像。

-

Radar: Range-Doppler (R-D) Map 或 Range-Azimuth (R-A) Map(这是经过一次 FFT 后的频谱热力图,保留了所有反射能量)。

-

算法架构:

-

双流网络 (Two-Stream CNN):

-

一路 CNN 处理图像。

-

另一路 CNN 处理雷达热力图(把它当成单通道图像处理)。

-

变换融合: 由于图像是透视投影,雷达图是极坐标俯视图,需要通过STN (Spatial Transformer Network) 将两者变换到同一坐标系下进行 Pixel-to-Pixel 的特征拼接。

-

优势: 在大雾、暴雨中,图像全白,普通雷达算法滤掉了微弱信号,但 Raw Data 融合能从雷达底噪中"抠"出障碍物的轮廓。

B. LiDAR Waveform + Camera (全波形+图像)

针对 SPAD(单光子雪崩二极管)或 Flash LiDAR。

-

输入:

-

LiDAR: 不是 (x,y,z)(x,y,z),而是每个像素点随时间变化的光强波形图 (Full Waveform)。

-

融合逻辑:

-

将 LiDAR 波形看作 1D 时序信号(类似语音),用 RNN/LSTM 或 1D-CNN 提取特征。

-

与图像特征进行 Early Fusion。

-

场景: 穿透半透明物体(如树丛、伪装网、浓烟)。波形数据包含了"穿透"过程中的所有回波峰值。

3. GNSS + IMU 的紧耦合 (Tight Coupling) - 工业界已量产

这是最典型的 Raw Data 融合,已经非常成熟。

-

输入:

-

GNSS: 伪距 (Pseudorange) 和 载波相位 (Carrier Phase) ------ 还没解算出经纬度。

-

IMU: 加速度 和 角速度。

-

融合算法 (Raw Data Fusion):

-

状态向量: 不仅包含位置速度,还包含GNSS 接收机钟差、钟漂、IMU 零偏等底层物理量。

-

EKF 更新: 利用 IMU 积分推算出的位置,去预测每颗卫星的理论伪距。计算"实测伪距 - 理论伪距"的残差 (Innovation),来修正系统状态。

-

优势:

-

在城市峡谷 (Urban Canyon) 中,如果只能看到 2 颗卫星(无法独立定位),松耦合会挂掉,但 Raw Data 紧耦合依然能利用这 2 颗卫星的伪距来约束 IMU 的漂移,维持高精度定位。

| 方法/思路 | 关键技术 | 代表性工作(年份) |

|---|---|---|

| 投影‑拼接(Projection‑Fusion) | 将 LiDAR 点云投影到摄像头图像平面或 BEV 平面,形成多通道图像(RGB + 深度/强度) | PointPainting (CVPR 2020)、Lift‑Splat‑Shoot (CVPR 2021) |

| 体素‑网格融合(Voxel‑Fusion) | 将点云离散化为体素,摄像头特征映射到同一体素网格,统一输入 3D CNN | VoxelFusion (IV 2022)、BEVFusion (CVPR 2022) |

| 跨模态 Transformer(Cross‑Modal Attention) | 使用自注意力机制在不同模态特征之间建立关联,支持长程依赖 | TransFusion (ICCV 2023)、CoBEVT (NeurIPS 2023) |

| 端到端原始数据学习(End‑to‑End Raw Fusion) | 直接把原始图像、点云、雷达回波喂入统一的深度网络,网络内部自行完成对齐与特征抽取 | DeepFusion (RAL 2022)、FocalFusion (ICRA 2024) |

| 多传感器协同感知(Cooperative Perception) | 通过 V2X 将多车/路侧的原始感知数据共享后进行统一融合,提升远距感知 | C‑Fusion (ITSC 2024)、Cooperative BEV (IEEE 2025) |

这些技术在近两年内陆续在顶级会议上出现,体现了 Raw‑Data 融合从"投影拼接"向"跨模态 Transformer"以及"协同感知"方向的演进。

4. 关键技术要点

时空同步与标定

需要高精度的时间戳对齐(纳秒级)以及外参标定(相机‑LiDAR、雷达‑相机)。误差会直接导致投影错位,影响融合效果。

统一坐标系与数据表示

常用的统一表示包括:

BEV(Bird‑Eye View):将所有模态映射到地面平面,便于卷积操作。

点云‑图像混合体素:在 3D voxel 中嵌入图像特征。

数据压缩与带宽

原始数据体积大(尤其是 LiDAR 点云),在车联网(V2X)场景下需要压缩或分层传输。常见方案:稀疏点云、深度图、特征压缩码流。

网络结构设计

双流网络(Image‑Branch + LiDAR‑Branch) → 跨模态注意力层 → BEV 编码器 → 检测/分割头。

端到端学习:通过自监督或多任务学习让网络自行学习对齐方式,降低标定依赖。

鲁棒性与安全

融合算法需在恶劣天气、光照变化、传感器失效等情况下保持稳定。常用的冗余策略是 不对称融合:在关键场景下优先使用高可信度的原始数据。

5. 近期研究热点与代表性工作

| 方向 | 代表论文/报告 | 亮点 |

|---|---|---|

| BEV‑Transformer 融合 | BEVFusion (CVPR 2022) | 将多模态原始数据统一映射到 BEV,使用 Transformer 跨帧建模,实现 3D 检测精度提升 5% 以上。 |

| 跨模态注意力 | TransFusion (ICCV 2023) | 通过跨模态自注意力直接在原始点云与图像特征上交互,显著降低误检率。 |

| 协同感知(V2X) | Cooperative BEV (IEEE 2025) | 多车共享原始点云/图像,统一 BEV 融合后实现 30 m 远距目标检测。 |

| 端到端原始数据学习 | DeepFusion (RAL 2022) | 采用全卷积网络直接处理原始雷达回波与图像,省去手工投影步骤。 |

| 轻量化 Raw‑Fusion | FocalFusion (ICRA 2024) | 通过稀疏卷积和特征压缩,实现在车规级芯片上实时运行(>30 FPS)。 |

| 行业白皮书 | 《汽车智能驾驶技术及产业发展白皮书》(2025) | 总结了原始数据层融合在 L3‑L4 级别的实际落地进展,指出硬件算力与带宽是关键瓶颈。 |

6. 实际应用场景与挑战

| 场景 | 典型需求 | 主要挑战 |

|---|---|---|

| 城市道路感知 | 多目标检测、行人/自行车识别 | 高密度目标导致点云遮挡,需要高分辨率投影与注意力机制。 |

| 高速公路 | 远距车辆检测、车道线感知 | 需要更远的感知范围,雷达‑摄像头原始数据融合是关键。 |

| 恶劣天气 | 雾、雨、强光下的感知 | 视觉信息受损,原始雷达/激光点云的权重需提升;不对称融合策略可提升鲁棒性。 |

| 车路协同(V2X) | 跨车共享原始感知数据 | 带宽受限、时延敏感;需采用分层压缩与边缘预处理。 |

| 边缘计算平台 | 实时性(≤30 ms) | 计算资源受限,轻量化网络(稀疏卷积、量化模型)是必然趋势。 |

7. 小结

-

Raw‑Data 级感知融合 是实现高精度、全场景自动驾驶的核心技术之一,能够最大化利用多传感器的互补信息。

-

目前主流方法围绕 投影‑拼接、体素‑网格、跨模态 Transformer 三大技术路线展开,并逐步向 协同感知 与 端到端原始学习 方向演进。

-

关键难点在于 时空同步、标定、数据压缩与实时计算,这些问题在行业白皮书和最新研究中被反复提及。

-

随着车规级算力提升、5G‑V2X 网络成熟以及新型 ActiveCamera 超级传感器的出现(融合激光雷达与摄像头),Raw‑Data 融合将在 L3‑L4 乃至 L5 级别的商用落地中发挥决定性作用。

挑战与瓶颈

既然 Raw Data 融合这么强,为什么不用?

带宽爆炸:

- Radar 的 Object List 只有几 KB/s,但 ADC Raw Data 可能高达 Gbps 级。车载以太网扛不住,智驾芯片的内存带宽也扛不住。

黑盒与标定:

- 原始信号对时空对齐极其敏感。如果 Camera 和 Radar 的时间戳差了 1ms,或者外参差了 0.1 度,融合网络就会彻底失效,且极难调试(因为人眼看不懂 R-D Map)。

算力消耗:

- 处理高维张量(如 4D Radar Cube)需要巨大的卷积算力。

总结

-

GNSS+IMU 已经在做 Raw Data 融合(紧耦合)。

-

Radar+Camera 正在从 Feature 级向 Raw Data (R-D Map) 级演进,主要为了解决鬼探头和恶劣天气问题。

-

LiDAR 通常止步于 Point 级,全波形融合目前主要用于测绘和军用,自动驾驶中极其罕见。