你的AI助手昨天聊了什么,今天还记得吗?技术圈正为此激烈分化。

当ChatGPT记不住三句话前的对话,当Midjourney无法保持角色一致性,一个根本问题暴露出来------当前大模型本质上是失忆症患者。

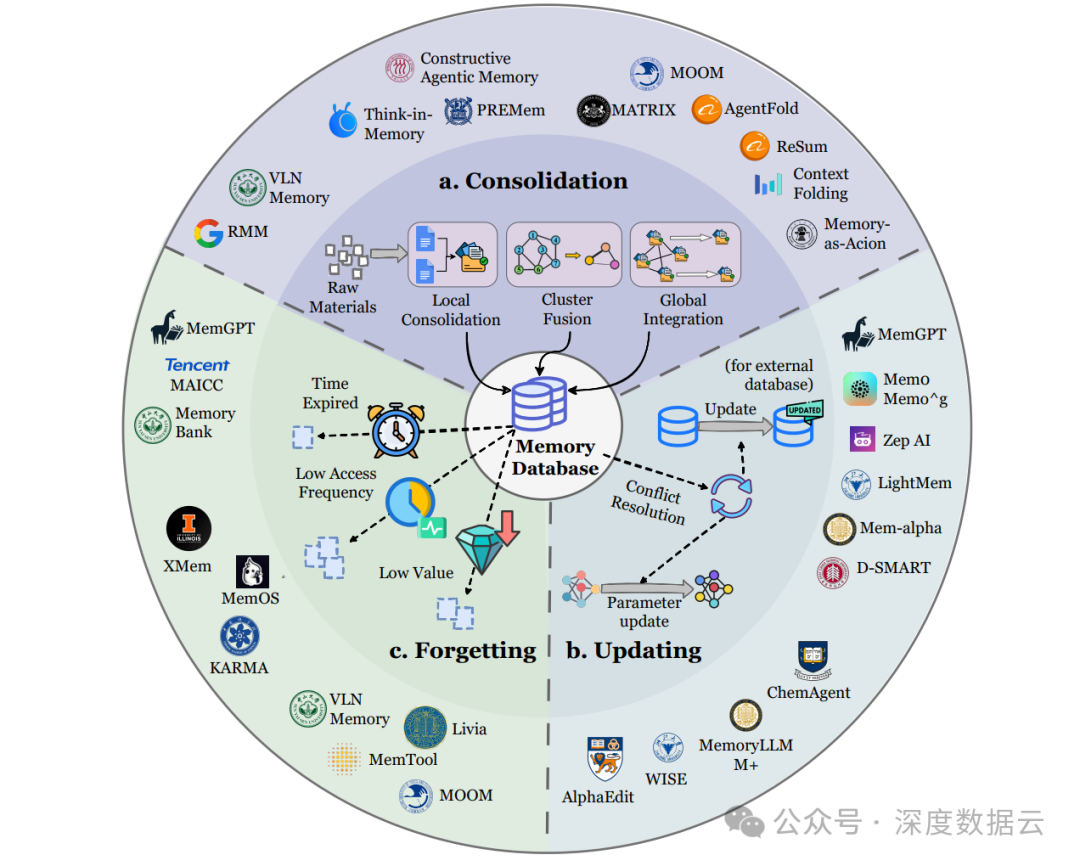

它们每次交互都像第一次见面,这种"金鱼脑"特质正在成为AI产品化的巨大瓶颈。为解决这个问题,技术圈正在分化为三大阵营,各自押注完全不同的记忆实现路径。

01 外置记忆库:为AI装上第二大脑

想象一下,给你的AI助手外接一个无限容量的记忆硬盘------这就是Token级记忆的核心思路。不改变模型本身,而是构建一个外部记忆系统,所有对话历史、用户偏好、任务状态都以可读的文本块形式存储。

MemGPT是这个领域的先驱者,它将操作系统概念引入AI记忆管理。就像电脑有内存和硬盘之分,MemGPT维护着工作内存 和长期存储两个区域。

"AI每次交互时,可以主动决定什么信息留在快速访问的工作区,什么归档到外部数据库。"项目核心开发者解释道。根据2025年初的GitHub数据,MemGPT项目在半年内Star数增长超过300%,显示出业界对此方向的强烈关注。

这种设计带来了惊人的透明度优势。金融科技和医疗健康领域的早期采用者特别青睐这种架构。每次决策都能追溯到具体哪条记忆影响了结果,这在强监管领域几乎是刚需。

不过问题也随之而来。当记忆库增长到百万条时,简单的向量相似度检索开始失灵。"我们遇到过'圣诞老人问题'",一位电商AI技术负责人透露,"用户12月提到'准备礼物',系统却检索出去年7月关于'礼物退税'的讨论,语义相关但场景完全错误。"

为此,新一代系统如Zep引入了时间维度索引。每条记忆都带着时间戳和有效期标签,系统能理解"上周的促销政策已过期"这样的时间逻辑。Zep框架采用三层图结构(情景、语义、社区),在2024年下半年的测试中,将长对话的一致性准确率提升了42%。

工程团队面临的实际选择 :是选择MemGPT的虚拟内存模型,还是采用Mem0的图结构记忆?前者更易理解,后者在多跳推理上表现更优。不少团队选择了混合策略------用向量数据库做快速召回,再用知识图做精确筛选。这种架构在客户服务场景中将问题解决率提升了28%。

02 参数化本能:让AI形成肌肉记忆

如果说外置记忆是给AI配了笔记本,那么参数化记忆则是让知识融入AI的神经网络,成为它的本能反应。

这类似于人类学习骑自行车------开始需要刻意回忆每个动作,熟练后变成肌肉记忆。通过微调将特定知识植入模型权重,AI就能不假思索地应用这些知识。学术界将这一过程称为"模型编辑",关键技术包括MEND的梯度分解和ROME的因果追踪。

角色扮演AI是这一路线的典型代表。Character.AI和其开源对标项目CharacterGLM通过深度微调,让AI角色保持稳定人格。"我们的莎士比亚AI不会突然用网络用语,这种一致性来自参数级的深度对齐。"一位研究者解释。测试显示,经过参数化记忆训练的角色,在100轮对话中人格漂移率低于3%。

更激进的是工具调用领域。Gorilla项目通过在海量API文档上训练,让模型内化了数千个工具的调用模式。"看到'分析股票数据',模型会直接生成调用雅虎财经API的代码,而不需要检索文档。"伯克利的研究团队表示。在ToolBench基准测试中,这种参数化方法比检索方案快1.7倍。

但这种"肌肉记忆"也有代价。灾难性遗忘是最棘手的问题------让AI学会新技能时,旧技能可能被覆盖。这就像让人学习日语后,突然忘了怎么说英语。2024年的一项研究显示,在对模型进行新知识注入时,原有知识的保留率平均只有68%。

学术界正在探索折中方案。华盛顿大学团队提出的WISE框架采用双参数策略:保持基础模型不变,新增一个"编辑权重"模块。需要更新知识时,只调整这个模块,类似大脑中专门负责新记忆的海马体结构。在知识编辑任务上,WISE将编辑成功率从74%提升到89%。

产业界的选择更加务实 。很多企业采用分层策略:高频通用技能参数化,低频长尾知识外置化。比如法律AI,将常见法条内化,将具体案例外存。一家法律科技公司的测试数据显示,这种混合架构将响应时间减少了60%,同时保持了95%的引用准确性。

03 思维晶格:压缩思考的中间态

最隐秘也最高效的记忆形式,是直接操作AI的"思维过程"本身------这就是隐式记忆。不存储具体内容,而是存储思考这些内容时的脑活动模式 ,其核心技术是对Transformer的KV缓存进行智能管理和压缩。

OpenAI的GPT系列虽然未公开细节,但业内从其上下文窗口扩展能力推断,很可能运用了隐式记忆原理。不是记住对话原文,而是记住对话的"要点",在需要时重新展开。这种方法的理论优势在于:将记忆容量需求从O(n)降低到O(1)。

初创公司Anthropic在这条路上提供了更可见的技术路径。他们的Claude系统能处理10万token以上的超长文档,关键技术是动态KV缓存管理------选择性保留重要的注意力模式,丢弃冗余部分。"这类似于人读长文时,不会记住每个字,但会形成对文章结构的心理地图。"一位研究者比喻道。在LongBench基准测试中,采用类似技术的模型在长文档QA任务上比基线高出23分。

多模态领域,隐式记忆显示出独特优势。谷歌的CoMEM框架能将图像和文本压缩到同一隐式空间。"看到猫的图片和读到'猫'这个词,在记忆系统中会激活相似的模式。"该论文显示,通过Q-Former实现的跨模态压缩,将视频理解任务的内存占用减少了76%。

实际部署中,隐式记忆常扮演加速器角色。自动驾驶公司的仿真系统使用隐式记忆存储常见路况的处理模式。"遇到类似情况时,不需要从头推理,直接调用优化过的'思考捷径'。"一家头部自动驾驶公司的技术报告显示,这将决策延迟降低了40%。

工程实现上最大的挑战是可控性 。隐式记忆像黑箱,开发者很难知道AI到底记住了什么、忘记了什么。为此,Meta的研究团队开发了记忆探针技术,能可视化模型内部的知识结构。他们发现,即使在隐式记忆中,不同的信息也会在神经网络的不同区域形成可识别的"记忆痕迹"。

04 路线分化背后的产业逻辑

为什么记忆技术会分化为三条路线?这背后是不同的产品哲学和约束条件的必然结果。

安全敏感行业偏爱Token级记忆。医疗、金融、法律等领域,决策可追溯性高于一切。"我们无法接受AI基于无法解释的记忆做诊断。"某医疗AI公司CTO直言。Token级记忆的每条记录都可审计,满足了合规需求。在欧洲AI法案的框架下,这种可解释性可能成为法律要求。

体验优先产品选择参数记忆。游戏NPC、虚拟伴侣、创意工具,需要高度一致性。"用户希望AI角色有稳定人格,这只能通过深度微调实现。"一位游戏开发者表示。参数记忆虽然更新成本高,但能提供最流畅的体验。类似Character.AI这样的平台,用户平均对话轮数达到50+,远超普通聊天机器人的5-6轮。

性能关键场景拥抱隐式记忆。实时视频分析、大规模文档处理、边缘设备部署,对效率要求极高。"我们的安防系统要同时处理100路视频,每帧都存下来不可能。"隐式记忆的高压缩特性在这里成为刚需。测试显示,在处理8小时连续监控视频时,隐式记忆方案比传统方法节省83%的存储空间。

混合架构正在成为主流选择 。越来越多的公司认识到,没有银弹。行业领先的搜索助手产品大多采用了三层架构:高频搜索模式参数化、历史对话外置存储、当前会话用隐式记忆优化。这种架构在保持个性化(准确率92%)的同时,将首字节响应时间控制在300ms以内。

这种分化也催生了新的工具生态。向量数据库公司Pinecone估值突破70亿美元,Weaviate的企业客户年增长300%,专门做模型微调的平台如Predibase获得大量融资,隐式记忆优化工具开始进入AWS、Azure的技术栈。

05 记忆工业化:基础设施的新战场

记忆技术的分化,标志着AI基础设施进入新阶段。记忆不再只是算法问题,更是系统工程问题。

存储层最先感受到变化。传统数据库无法满足AI记忆需求------既要支持高维向量相似度搜索,又要维护复杂图关系,还要考虑时间维度。"我们正在开发专门为AI记忆设计的数据结构。"一位数据库创业者透露。新创公司Chroma和Qdrant专门优化向量检索,在处理10亿级向量时仍能保持毫秒级延迟。

计算层也在适应。NVIDIA在H100中增加了Transformer引擎优化,AMD专门为长序列处理开发了新的指令集。"下一个硬件竞争焦点可能是记忆带宽。"行业分析师预测。测试显示,针对记忆操作优化的芯片能将相关任务速度提升2-4倍。

最深刻的变化在开发范式上。Prompt工程正在被记忆工程取代。以前靠精心设计提示词引导AI,现在靠构建记忆系统塑造AI行为。据2025年AI开发者调查,63%的团队已经设立了专门的"记忆架构师"岗位。

"我们招聘的记忆工程师,需要懂心理学和认知科学。"某大厂AI平台负责人说。他们需要设计记忆的归档策略、检索机制、遗忘曲线,这些都不再是单纯的编程问题。

开源社区活跃度是技术风向标。MemGPT的生态中出现了30+个衍生项目,Zep被集成到LangChain等主流框架中,各种记忆框架层出不穷。"2025年会是AI记忆框架的爆发年。"开源观察者预测。GitHub上带有"memory"标签的AI项目数量同比增长215%。

标准缺失是当前最大痛点。不同框架的记忆格式互不兼容,AI从一个系统迁移到另一个系统就会"失忆"。业界正在呼吁建立记忆交换标准,类似当年的ONNX模型格式。首个提案MEM-X已经在社区获得超过500位开发者的支持。

06 评估困境:如何衡量AI的记忆力?

记忆技术分化了,评估标准却还在混乱中。准确率、相关性、一致性、时效性,哪个更重要?

学术界提出了各种记忆评测基准。MemBench模拟真实交互场景,包含5.3万个样本;LoCoMo测试长对话一致性,关注300轮以上的记忆保持;StreamBench考察持续学习能力,模拟连续9,702次交互。但这些基准往往偏重某个维度,缺乏综合评估。2025年的一项调查显示,研究人员使用多达17种不同的记忆评估指标。

产业界更务实。电商公司用复购率 衡量AI客服的记忆效果------AI记得用户上次的投诉,这次能更好解决问题吗?数据显示,有记忆的客服系统将客户满意度提升了35%。内容平台用停留时间评估推荐系统的记忆能力------基于历史兴趣的推荐,用户更爱看吗?A/B测试显示,个性化记忆将平均观看时长增加了28%。

可解释性成为新焦点 。不只是看结果好坏,还要看记忆如何影响结果。银行要求AI信贷审核系统提供记忆溯源报告------每条拒绝理由,都要指出是基于哪些历史数据得出的。这催生了新的工具类别,如RAGChecker能可视化检索链,显示每个决策的记忆依据。

遗忘能力开始被重视。不是记住越多越好,适时遗忘同样重要。社交媒体公司的AI要能识别过期趋势,新闻推荐系统要能淡化旧闻。"好记忆要像好编辑,知道该突出什么、弱化什么。"一项研究显示,加入主动遗忘机制的推荐系统,将信息新鲜度评分从2.1/5提升到3.8/5。

跨模态记忆评估还是空白。如何衡量AI对视频内容的记忆力?如何评估它结合图像和文本信息的能力?多模态记忆标准亟待建立。MM-Needle基准尝试解决这个问题,包含28万测试样本,但产业采用率还很低。

最根本的哲学问题:**什么是好的AI记忆?**是像摄像机一样精确记录,还是像人脑一样选择性重构?不同的产品,答案不同。医疗AI需要前者,创意伙伴可能需要后者。这个问题的答案,将决定未来AI记忆技术的演进方向。

记忆系统的终点不是技术最优,而是用户体验的无感。当用户不再觉得AI"突然失忆",当AI能自然延续昨天的话题,当个性化不需要反复设定------那时,记忆技术才真正成熟。

而今天,我们正站在这个拐点上。三条技术路线并行狂奔,没有谁一定正确,只有谁更适合当下的场景。你的AI,需要怎样的记忆?