目录

1.Windows

LLaMA-Factory 的 Github地址:https://github.com/hiyouga/LLaMA-Factory

克隆仓库(我的windows目录是D:\Program Files\LLaMa-Factory,linux可以直接在根目录克隆)

git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git切换到项目目录

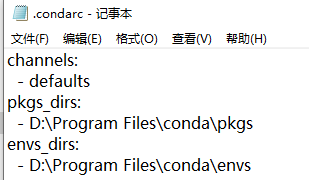

cd LLaMA-Factory修改配置,将 conda 虚拟环境安装到数据盘

(如果你已经配置过则不用这步)

mkdir -p "D:\Program Files\conda\pkgs"

conda config --add pkgs_dirs "D:\Program Files\conda\pkgs"

mkdir -p "D:\Program Files\conda\envs"

conda config --add envs_dirs "D:\Program Files\conda\envs"或者直接去c盘修改配置(C:\Users\Administrator\.condarc)

按下win键,输入Anaconda Prompt,用管理员打开

(如果你已经将conda放到环境变量,就在当前目录操作即可)

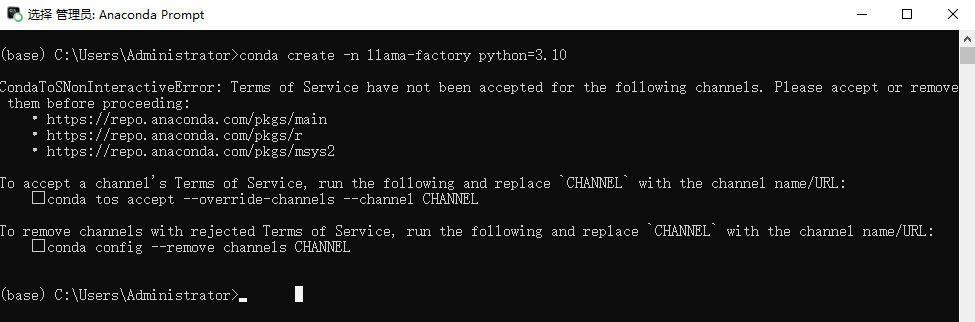

创建 conda 虚拟环境(一定要 3.10 的 python 版本,不然和 LLaMA-Factory 不兼容)

conda create -n llama-factory python=3.10

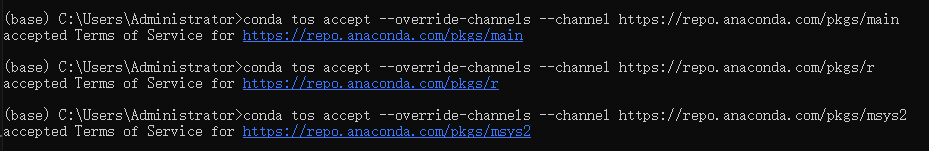

接受所有条款,然后重新执行上述操作

conda tos accept --override-channels --channel https://repo.anaconda.com/pkgs/main

conda tos accept --override-channels --channel https://repo.anaconda.com/pkgs/r

conda tos accept --override-channels --channel https://repo.anaconda.com/pkgs/msys2

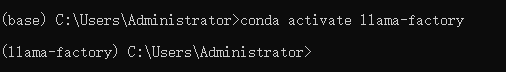

激活环境

conda activate llama-factory

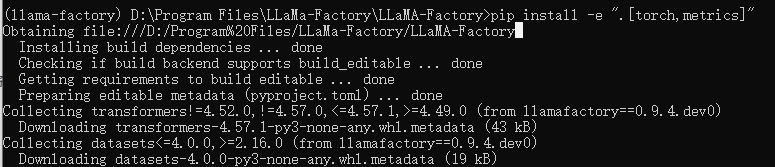

下载依赖

pip install -e ".[torch,metrics]"

从错误信息可以看出两个主要问题:

-

SSL证书验证失败 :无法通过HTTPS连接到PyPI下载

setuptools -

pip版本过旧:您使用的是pip 20.3.1,而最新版本是25.0.1

报错的话就先激活环境,同时一定要初始化(当前目录或者是Anaconda Prompt)

conda init重新下载依赖即可

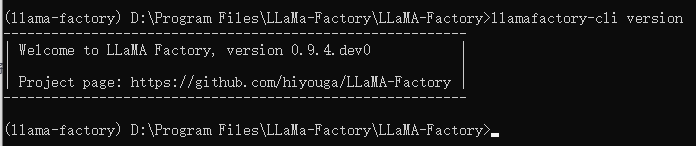

检验是否安装成功

llamafactory-cli version

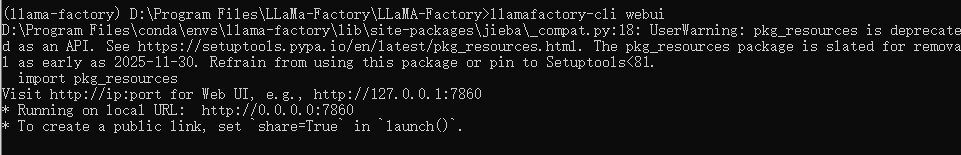

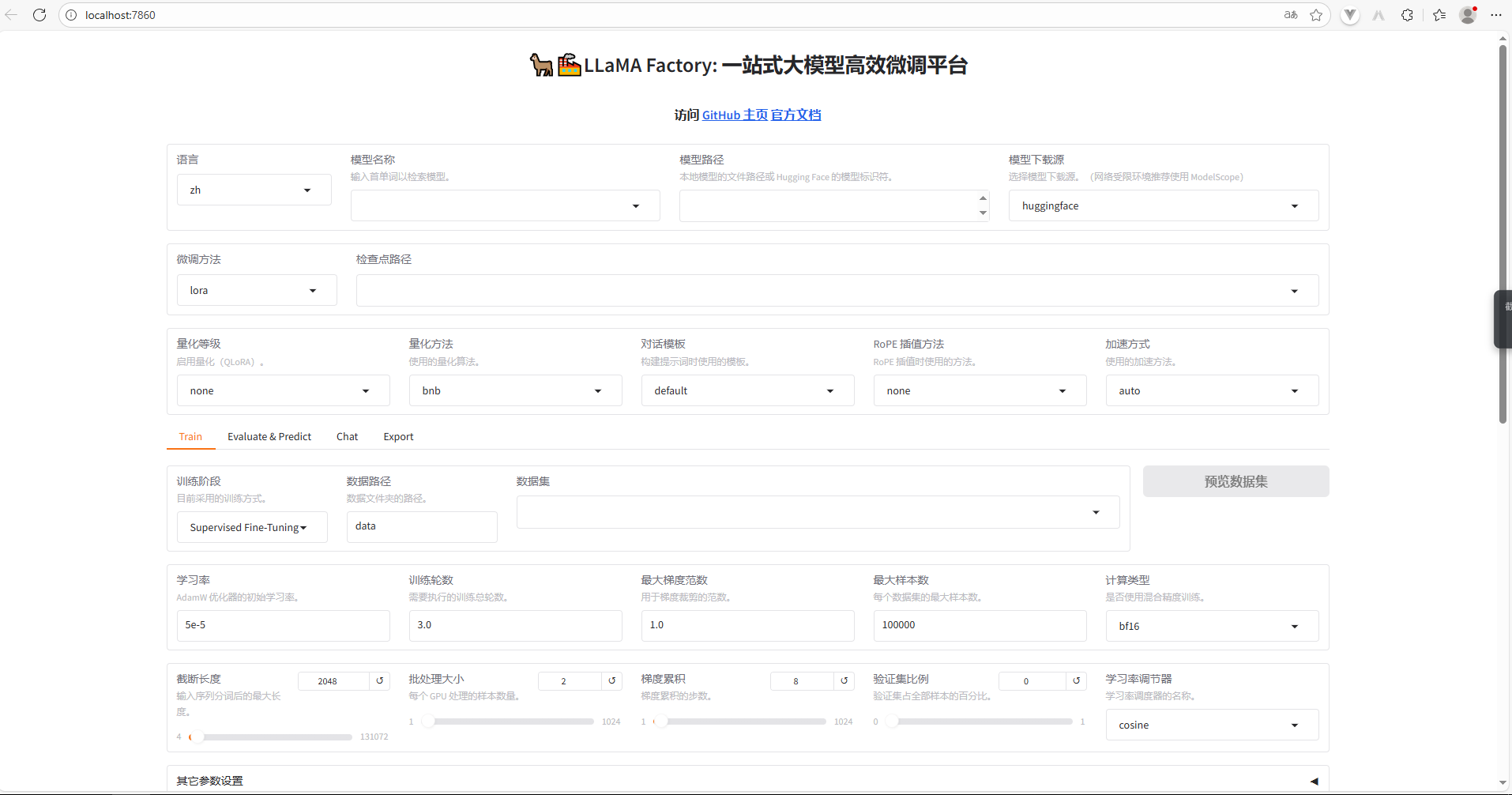

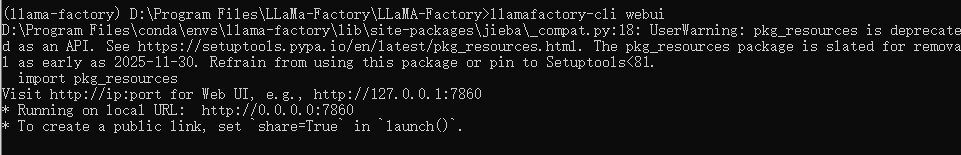

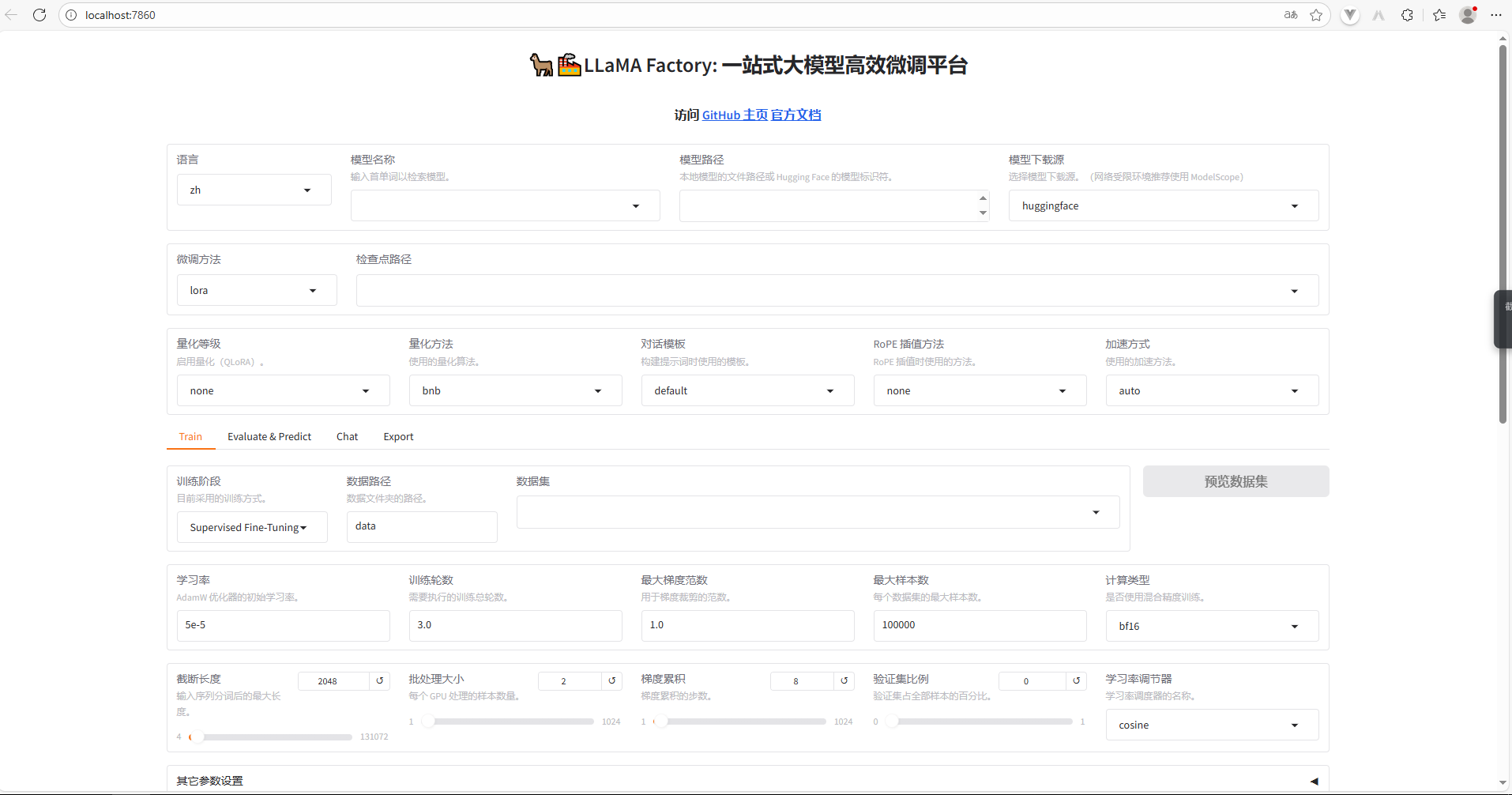

启动 LLama-Factory 的可视化微调界面 (由 Gradio 驱动)

llamafactory-cli webui

访问LLaMA Factory (QXC-20250903GVX)

这里我们需要新开一个终端(D:\Program Files\LLaMa-Factory输入cmd),记得要先激活llama-factory环境

创建文件夹统一存放所有基座模型

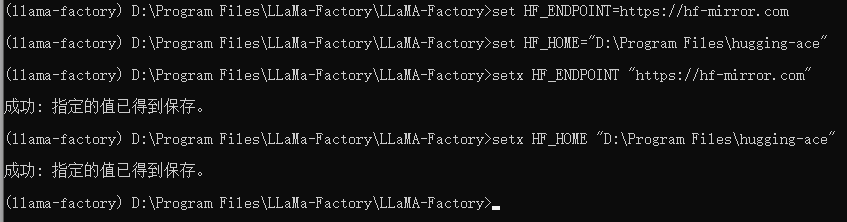

mkdir "D:\Program Files\hugging-face"修改 HuggingFace 的镜像源

set HF_ENDPOINT=https://hf-mirror.com修改模型下载的默认位置

set "HF_HOME=D:\Program Files\hugging-face"这种配置方式只在当前 shell 会话中有效,如果你希望这个环境变量在每次启动终端时都生效,可以执行以下操作(但没必要)

setx HF_ENDPOINT "https://hf-mirror.com"

setx "HF_HOME=D:\Program Files\hugging-ace"检查环境变量是否生效

echo %HF_ENDPOINT%

echo %HF_HOME%

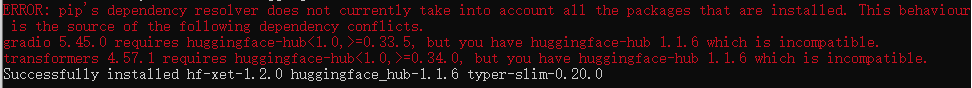

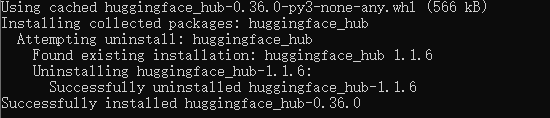

安装 HuggingFace 官方下载工具

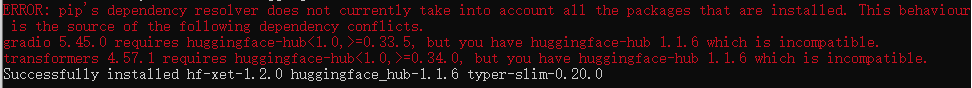

pip install -U huggingface_hub下载可能会报如下错误,这是因为 hugging-face 的版本太高了,安装低版本的就可以了

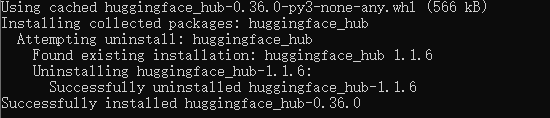

安装低版本,再次执行上述操作即可

pip install "huggingface_hub<1.0"

执行下载命令

huggingface-cli download --resume-download deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B下载之后就可以直接开始微调了

2.Linux

大部分操作跟windows一样

克隆仓库(我的windows目录是D:\Program Files\LLaMa-Factory,linux可以直接在根目录克隆)

git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git切换到项目目录

cd LLaMA-Factory修改配置,将 conda 虚拟环境安装到数据盘

(如果你已经配置过则不用这步)

mkdir -p /root/autodl-tmp/conda/pkgs

conda config --add pkgs_dirs /root/autodl-tmp/conda/pkgs

mkdir -p /root/autodl-tmp/conda/envs

conda config --add envs_dirs /root/autodl-tmp/conda/envs以管理员方式打开Anacnoda Prompt (如果你已经将conda放到环境变量,就在当前目录操作即可)

创建 conda 虚拟环境(一定要 3.10 的 python 版本,不然和 LLaMA-Factory 不兼容)

conda create -n llama-factory python=3.10如有需要,接受所有条款,然后重新执行上述操作

conda tos accept --override-channels --channel https://repo.anaconda.com/pkgs/main

conda tos accept --override-channels --channel https://repo.anaconda.com/pkgs/r

conda tos accept --override-channels --channel https://repo.anaconda.com/pkgs/msys2激活环境

conda activate llama-factory下载依赖

pip install -e ".[torch,metrics]"报错的话就先激活环境,同时一定要初始化(当前目录或者是Anaconda Prompt),重新执行上述命令

conda init检验是否安装成功

llamafactory-cli version启动 LLama-Factory 的可视化微调界面 (由 Gradio 驱动)

llamafactory-cli webui

访问LLaMA Factory (QXC-20250903GVX)

这里我们需要新开一个终端,记得要先激活llama-factory环境

创建文件夹统一存放所有基座模型

mkdir hugging-face修改 HuggingFace 的镜像源

export HF_ENDPOINT=https://hf-mirror.com修改模型下载的默认位置

export HF_HOME=/root/autodl-tmp/Hugging-Face这种配置方式只在当前 shell 会话中有效,如果你希望这个环境变量在每次启动终端时都生效,可以执行以下操作(但没必要)

echo 'export HF_ENDPOINT="https://hf-mirror.com"' >> ~/.bashrc

echo 'export HF_HOME="/root/autodl-tmp/hugging-face"' >> ~/.bashrc

# 重新加载配置

source ~/.bashrc检查环境变量是否生效

echo $HF_ENDPOINT

echo $HF_HOME安装 HuggingFace 官方下载工具

pip install -U huggingface_hub下载可能会报如下错误,这是因为 hugging-face 的版本太高了,安装低版本的就可以了

安装低版本,再次执行上述操作即可

pip install "huggingface_hub<1.0"

执行下载命令

huggingface-cli download --resume-download deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B下载之后就可以直接开始微调了

3.微调操作(待更新)

...