目录

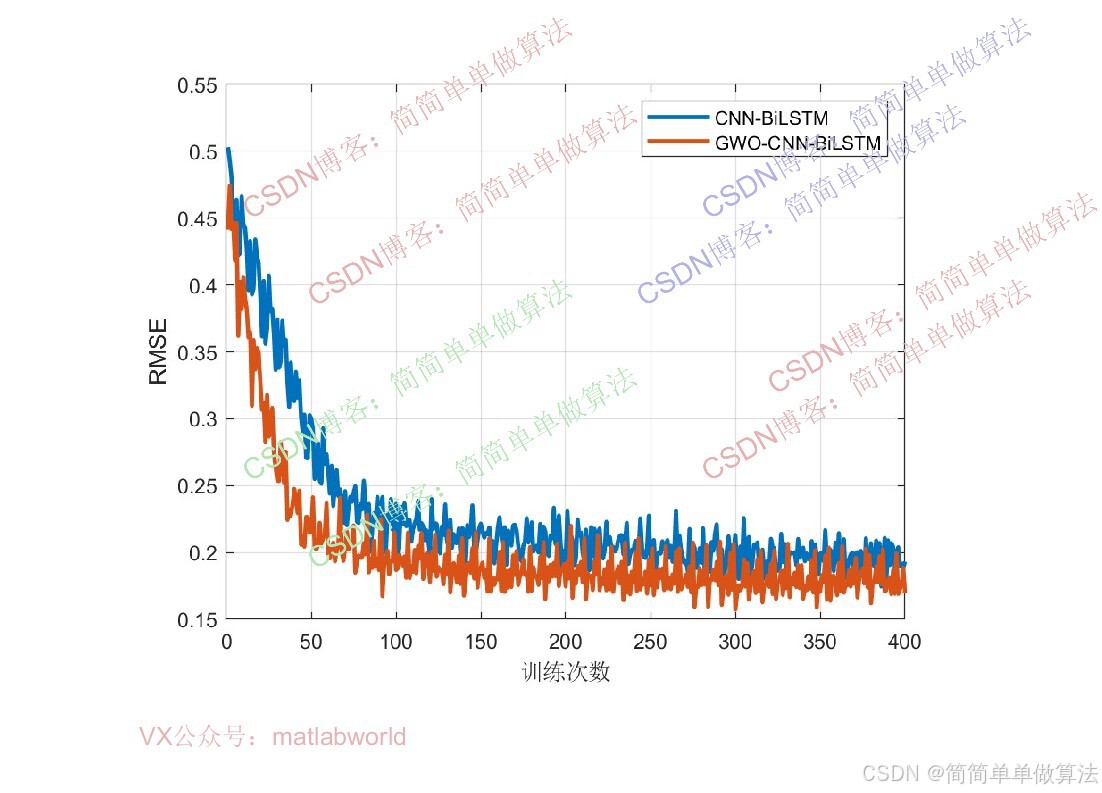

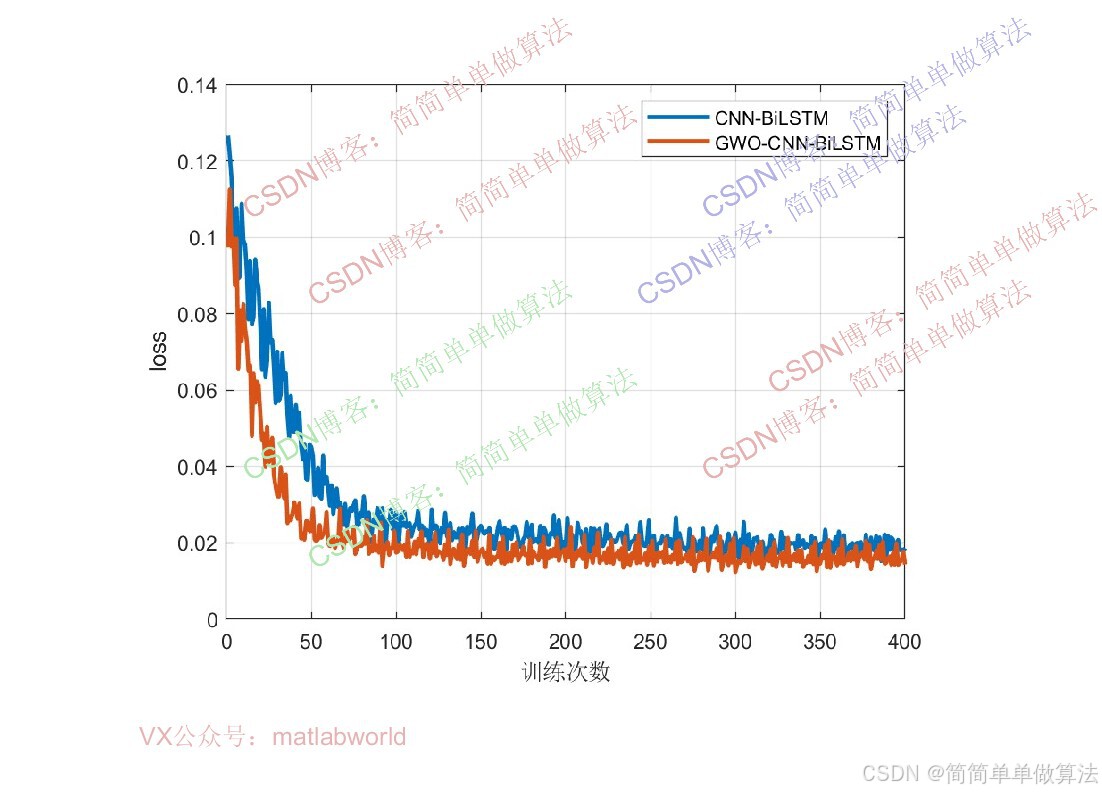

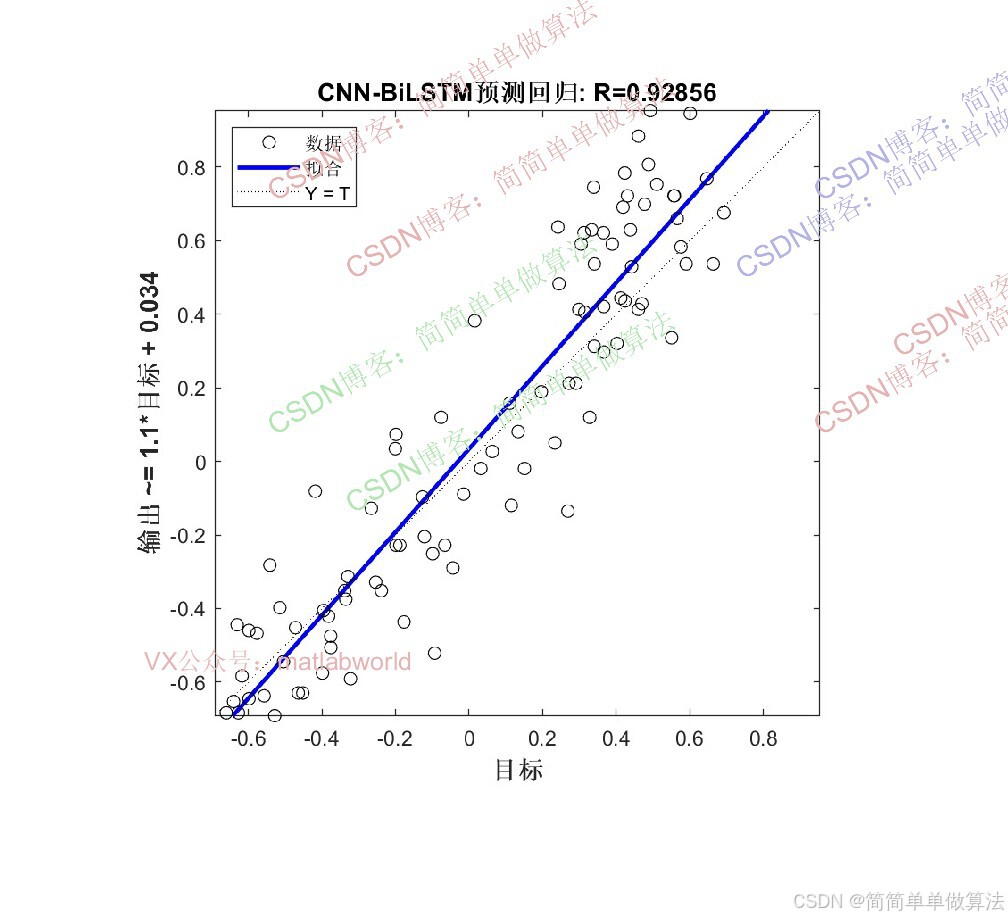

本文提出一种基于GWO优化的CNN-BiLSTM混合神经网络模型,用于多输入单输出回归预测任务。该方法通过GWO优化BiLSTM的隐含层节点数和学习率,以模型训练误差作为适应度函数,经过遗传操作筛选最优超参数组合。算法在Matlab2024b环境下实现,包含完整的训练流程和预测功能,通过对比预测数据与真实数据的误差评估模型性能。

1.前言

算法通过WOA优化将BiLSTM的隐含层个数和学习率作为WOA的优化变量,以CNN-BiLSTM模型在训练集上的回归预测误差作为WOA的适应度函数,通过迭代筛选最优超参数组合,再将最优超参数代入CNN-BiLSTM模型完成最终的多输入单输出回归预测。

2.算法运行效果图预览

(完整程序运行后无水印)

3.算法运行软件版本

Matlab2024b(推荐)或者matlab2022b

4.部分核心程序

(完整版代码包含中文注释和操作步骤视频)

......................................................

LR = X(1);

numHiddenUnits = floor(X(2))+1;% 定义隐藏层中LSTM单元的数量

rng('default')

%CNN-BiLSTM网络

layers = func_model2(Nxin,Nyout,fz,numHiddenUnits);

%选项

%最大迭代次数

Miters = 50;

% 学习率

Lr = 0.005;

if gpuDeviceCount>0

mydevice = 'gpu';

else

mydevice = 'cpu';

end

options = trainingOptions( 'adam', ...

'MaxEpochs',Miters, ...

'GradientThreshold',1, ...

'InitialLearnRate',LR, ...

'LearnRateSchedule','piecewise', ...

'LearnRateDropPeriod',20, ...

'LearnRateDropFactor',0.8, ...

'L2Regularization',1e-3,...

'Verbose',false, ...

'ExecutionEnvironment',mydevice,...

'Plots','training-progress');

%训练

[net,INFO] = trainNetwork(Xtrains,Ytrains,layers,options);

%预测

YPred = predict(net,XTests,"ExecutionEnvironment",mydevice);

YPred = double(YPred');

err1=mean(abs(YPred-Ytest));

figure;

subplot(211)

plot(YPred);

hold on

plot(Ytest);

legend('预测数据','真实数据');

subplot(212)

plot(YPred-Ytest);

ylim([-1,1]);

title(['预测误差:',num2str(err1)]);

save R2.mat err1 YPred Ytest net INFO yy

2415.算法理论概述

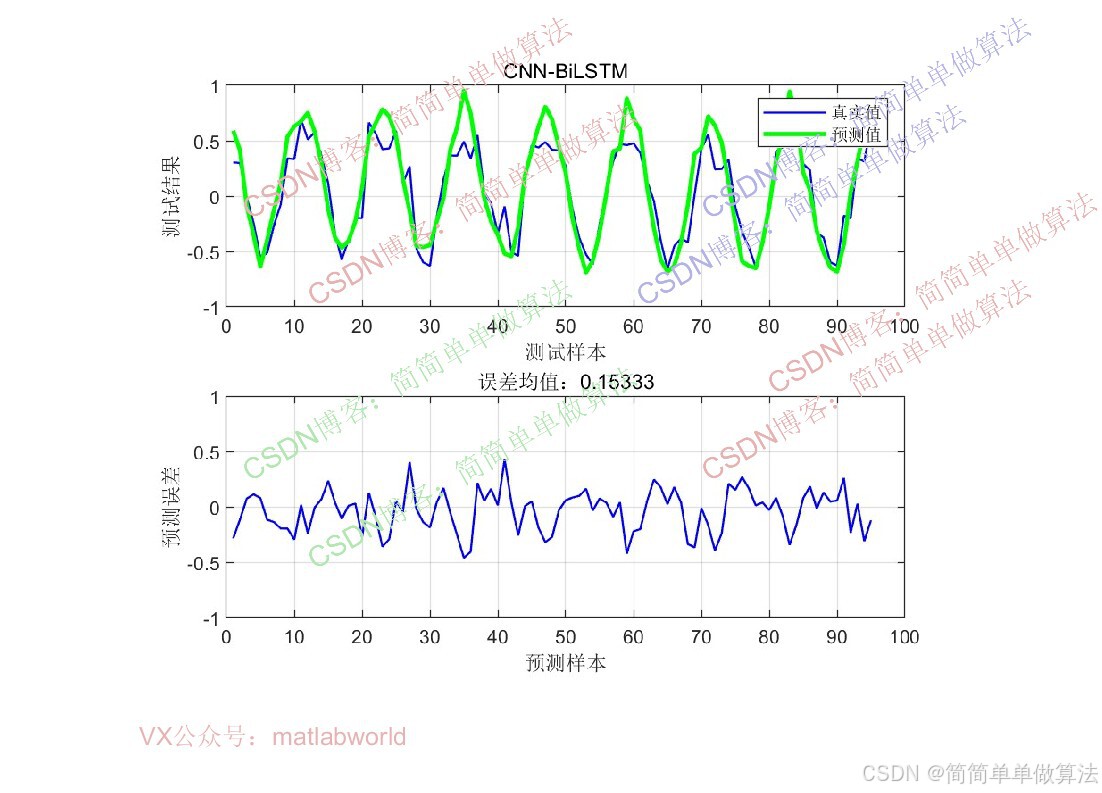

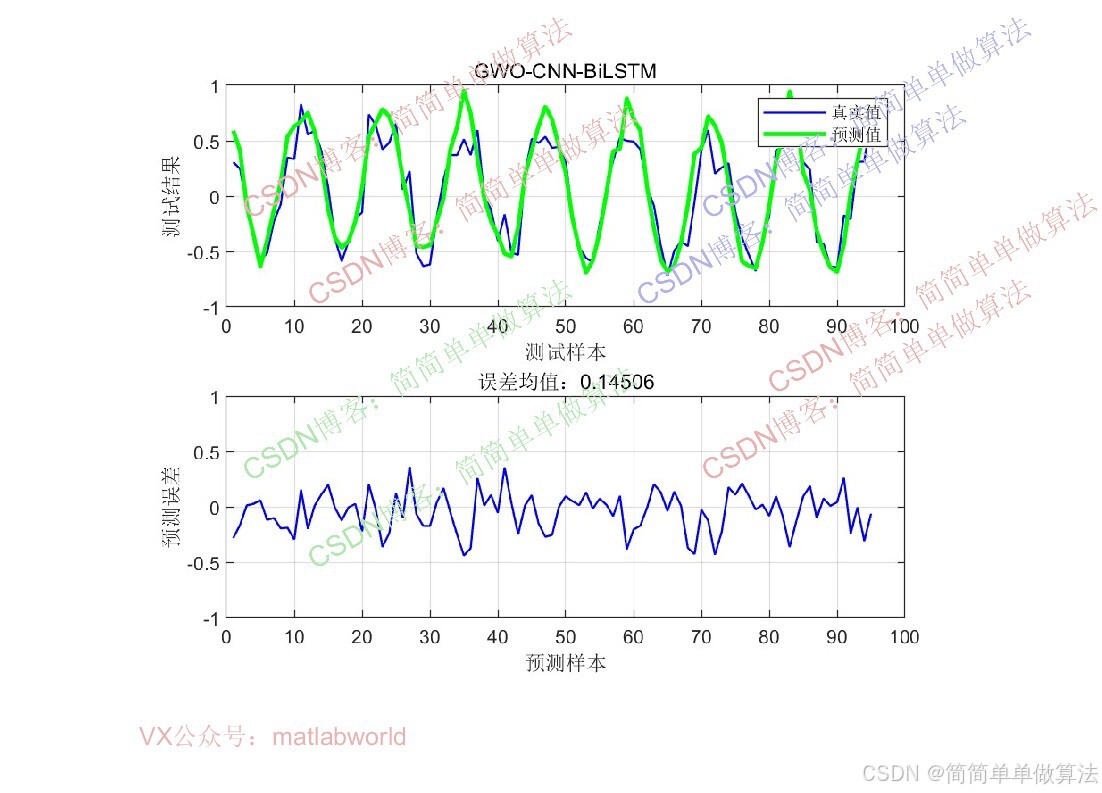

**数据准备:**生成/加载多输入单输出回归数据集,进行预处理(归一化、划分训练集 / 测试集、构造时序输入格式)。

**模型构建:**搭建CNN-BiLSTM网络(CNN提取局部空间特征,BiLSTM提取双向时序特征,全连接层输出回归结果)。

CNN-BiLSTM存在大量待优化的超参数(LSTM隐藏层神经元数、学习率等),这些超参数直接影响模型性能,WOA通过全局搜索找到最优超参数组合,替代人工调参的盲目性。

GWO优化:用GWO优化CNN-BiLSTM的关键超参数(如学习率、LSTM隐藏层节点数、正则化系数等),以模型训练集的均方误差(MSE)作为适应度函数。

模型训练与预测:用优化后的最优超参数构建最终模型,进行训练和测试,评估预测效果。 结果可视化:绘制真实值与预测值对比图、误差分布图,展示模型性能。

6.参考文献

1\]Ang L , Baoyu Z , Liyan Z ,et al.The Application of the CNN-BiLSTM-TPA Model Based on Deep Learning in Porosity Prediction\[J\].Journal of Geophysics and Engineering, 2025.DOI:10. 1093/jge/gxaf141. ## 7.算法完整程序工程 **OOOOO** **OOO** **O** **关注后输入自动回复码:0021**