一、算法简介

SIFT(Scale-Invariant Feature Transform,尺度不变特征变换)是计算机视觉领域经典的特征提取算法,由 David Lowe 于 2004 年提出。其核心优势在于具备尺度不变性和旋转不变性 ------ 无论图像被放大 / 缩小、旋转,都能稳定提取出关键特征点,解决了传统特征提取算法对尺度和旋转敏感的痛点。

SIFT 算法通过构建尺度空间、检测极值点、精确定位关键点、生成特征描述子四个核心步骤,将图像特征转化为 128 维的数值向量,广泛应用于图像匹配、目标识别、全景拼接、三维重建等场景,是后续诸多特征提取算法(如 SURF、ORB)的基础。

二、原理解析

SIFT 算法的核心思想是:在不同尺度空间中寻找稳定的极值点,通过精确定位和方向 归一化 ,生成具有 鲁棒性 的特征描述子。整个流程可分为四大模块,每个模块环环相扣:

(一)模块 1:构建尺度空间(Scale Space)

核心目标

模拟人眼在不同距离下观察物体的效果,让计算机能在 "清晰 / 模糊""大 / 小" 等不同尺度下检测特征,确保特征的尺度不变性。

实现步骤

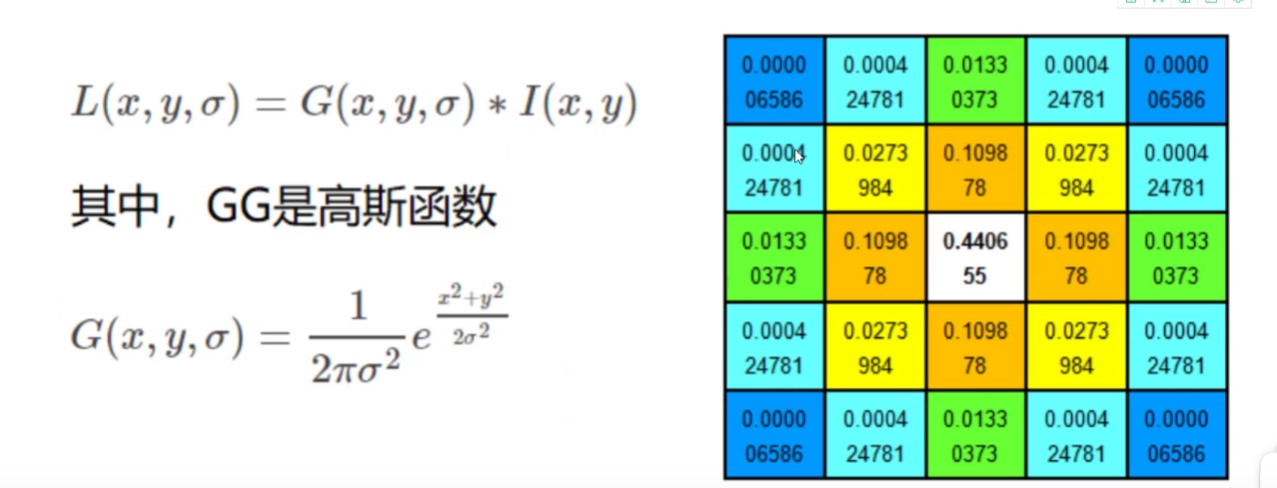

1. 高斯滤波 (Gaussian Blur):

对原始图像进行不同标准差(σ)的高斯滤波,σ 越大,图像越模糊。通过不同 σ 值构建同一分辨率下的多个模糊版本,形成 "尺度层"。

- 高斯滤波的核心是权重矩阵:离中心像素越近,权重越大,确保中心像素对结果影响更显著。

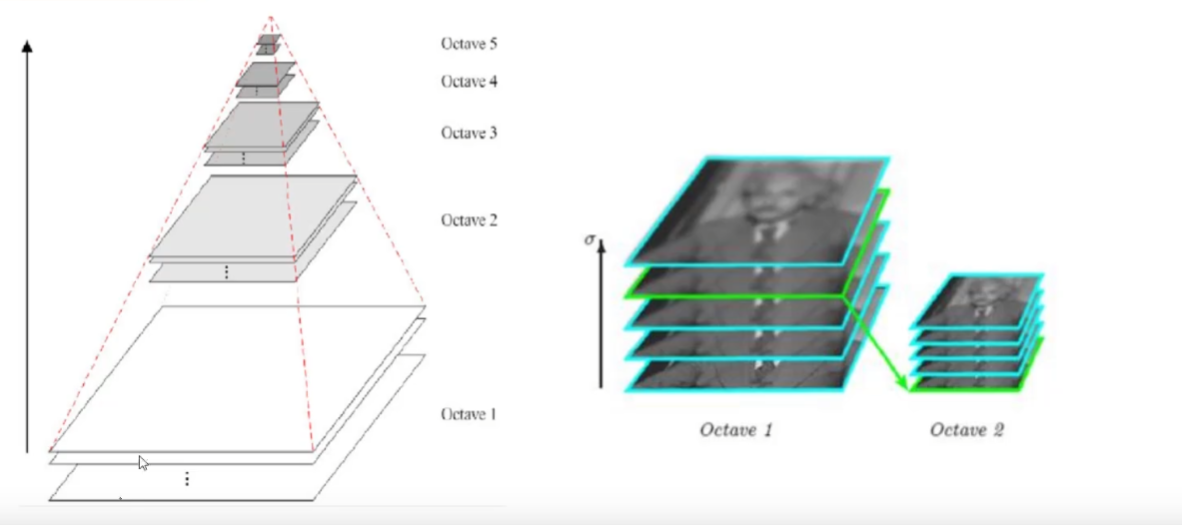

2、图像金字塔 (Image Pyramid )

将经过高斯滤波的图像下采样(如缩小为原来的 1/2),形成不同分辨率的图像层,每层再进行多尺度高斯滤波。

最终形成的尺度空间 = 金字塔层数 × 每层尺度层数,例如:4 层金字塔 × 6 个尺度层 = 24 个尺度图像。

关键概念

- 尺度:σ 值决定,σ 越大代表 "大尺度"(观察远处物体),σ 越小代表 "小尺度"(观察近处物体)。

(二)模块 2:高斯差分金字塔(DoG)与极值检测

核心目标

从尺度空间中筛选出潜在的关键点(极值点),这些点在局部范围内是亮度变化最显著的点。

实现步骤

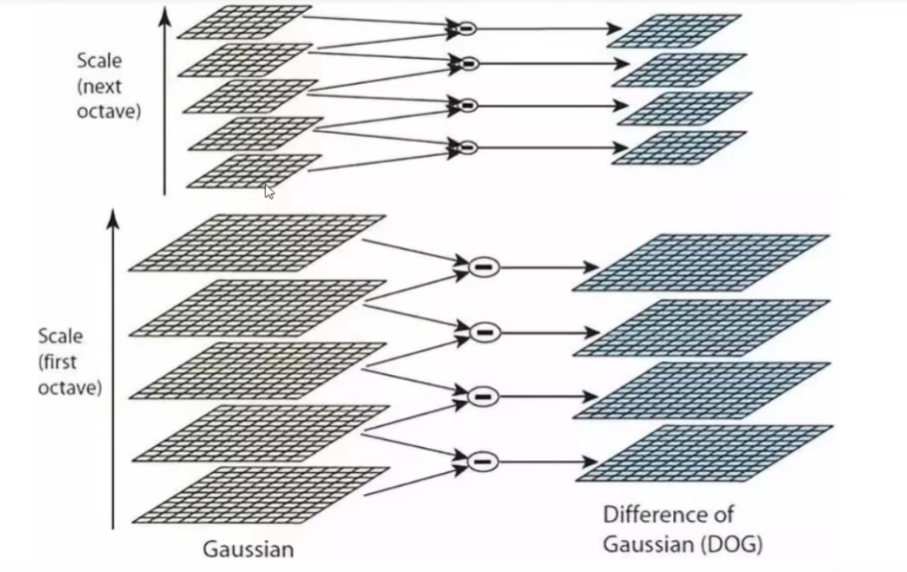

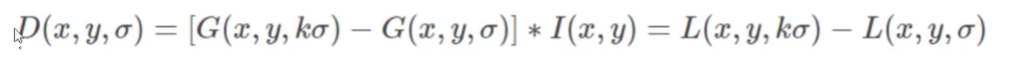

1. 构建 DoG 金字塔:对同一分辨率下的相邻两个尺度层(高斯滤波结果)做差分运算(后一层减前一层),得到高斯差分图像(DoG,Difference of Gaussians)。

- 例如:某分辨率下有 6 个尺度层,可得到 5 个 DoG 图像。

2. 极值检测 :对 DoG 图像中的每个像素,与周围 26 个像素(同层 8 个相邻像素 + 上层 9 个像素 + 下层 9 个像素)进行比较,若该像素是局部最大值或最小值,则判定为潜在关键点。

- 注意:金字塔最顶层和最底层的 DoG 图像无法进行极值检测(缺乏上下层参考)。

为什么用 DoG?

DoG 能高效近似图像的拉普拉斯金字塔(LoG),同时计算量更小,可快速突出图像中的边缘、角点等显著特征。 西格玛表示高斯模糊的参数。

(三)模块 3:关键点精确定位与过滤

核心目标

剔除不稳定的关键点(如边界点、噪声点),并对离散的极值点进行精确 拟合,得到更准确的关键点位置。

实现步骤

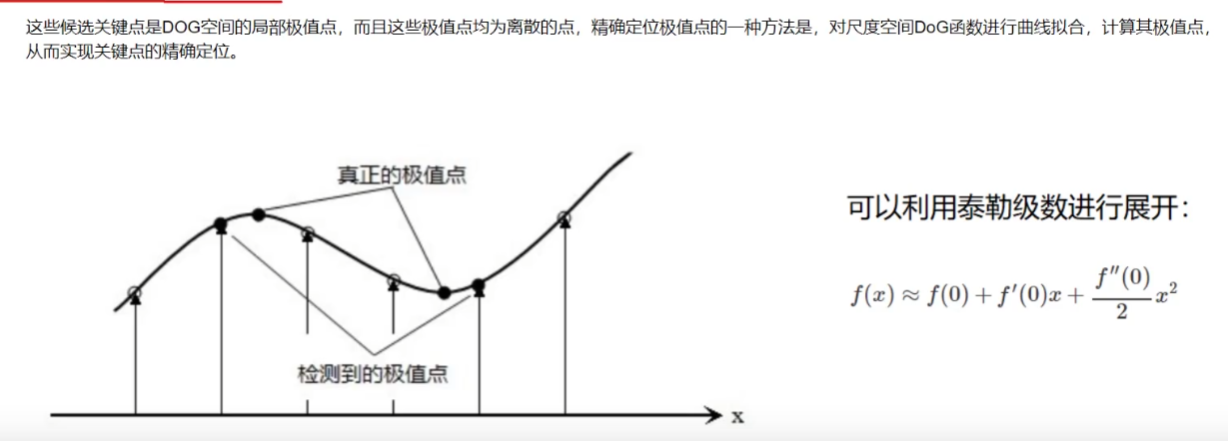

1.亚 像素 级精确定位:通过泰勒展开将离散的极值点拟合成连续函数,求解函数的极值位置,修正关键点的坐标(x、y、σ),得到亚像素级的精确位置。

原理:离散极值点可能不是真实极值点,通过连续函数拟合可修正偏差。

消除边界响应:使用黑塞矩阵(Hessian Matrix)计算关键点的特征值 λ₁(大特征值)和 λ₂(小特征值),若 λ₁/λ₂ > 10(论文推荐阈值),则判定为边界点,予以剔除。

逻辑:边界点的特征值差异极大,而稳定的关键点特征值相对均衡。

阈值过滤:设定关键点响应值阈值,剔除响应值过低的噪声点。

(四)模块 4:生成特征描述子

核心目标

将关键点转化为计算机可识别的数值向量(特征描述子),确保向量具有旋转不变性和光照鲁棒性。

实现步骤

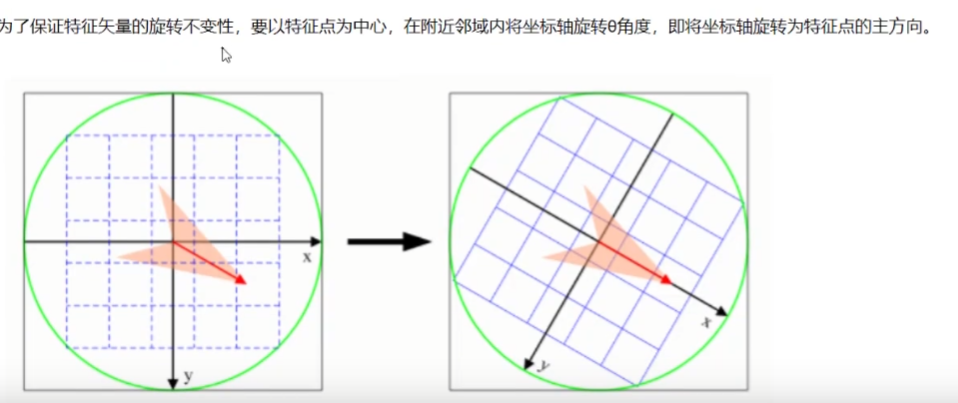

1. 方向 归一化 (旋转不变性) :

-

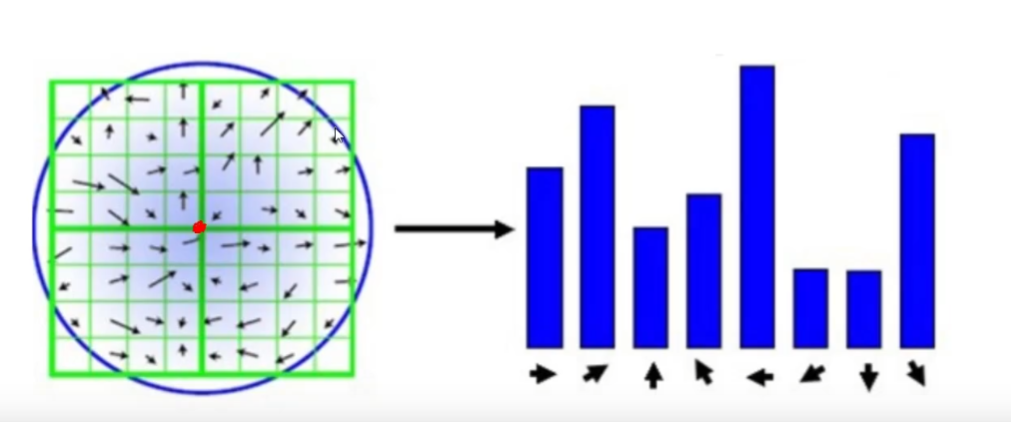

以关键点为中心,统计其邻域(如 16×16 区域)内所有像素的梯度方向和梯度模值。

-

将梯度方向划分为 8 个区间(0°~45°、45°~90°、...、315°~360°),构建梯度方向直方图,直方图的峰值对应的方向即为关键点的 "主方向"。

-

将关键点邻域旋转至主方向,确保无论原始图像如何旋转,特征描述子的方向始终一致。

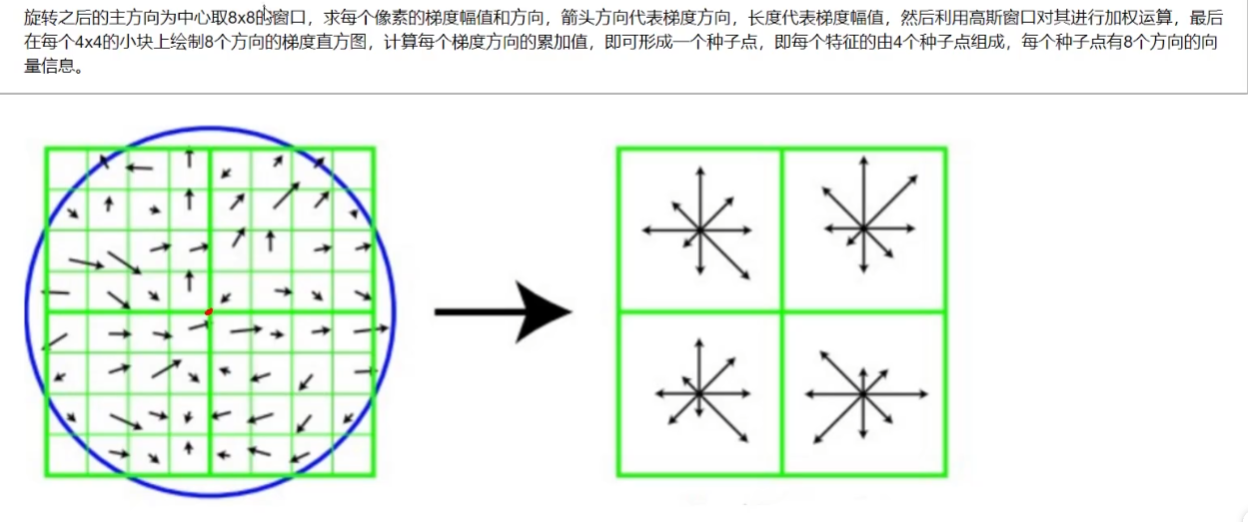

2.构建 特征向量:

-

以旋转后的主方向为基准,取关键点周围 16×16 的邻域,将其划分为 4×4 的子区域(共 16 个子区域)。

-

每个子区域统计 8 个方向的梯度直方图,得到 8 维向量。

-

16 个子区域的 8 维向量拼接,形成 128 维的特征描述子(论文推荐,确保区分度和鲁棒性)。

3.归一化 与加权:

-

对 128 维向量进行归一化处理,降低光照变化的影响。

-

采用高斯加权(邻域中心权重高、边缘权重低),增强特征描述子的稳定性。

三、OpenCV 代码实现步骤

(一)环境准备:安装指定版本 OpenCV

SIFT 算法从 OpenCV 3.4.3 版本开始进入专利保护,需安装 3.4.3 以下版本(推荐 3.4.1.15):

python

# 卸载现有高版本OpenCV

pip uninstall opencv-python opencv-contrib-python -y

# 安装兼容版本

pip install opencv-python==3.4.1.15 opencv-contrib-python==3.4.1.15(二)核心函数解析

OpenCV 中 SIFT 相关核心操作通过**cv2.xfeatures2d.SIFT_create()**实现,主要方法:

-

detect(gray_img):检测图像中的关键点,返回关键点列表(包含位置、尺度、方向等信息)。 -

compute(gray_img, keypoints):根据关键点生成特征描述子,返回(关键点,128 维描述子矩阵)。 -

drawKeypoints(img, keypoints, out_img):绘制关键点到图像上。

(三)完整代码示例

python

import cv2

import numpy as np

# 1. 读取图像并预处理

img = cv2.imread("lena.jpg") # 读取彩色图像

gray = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY) # 转换为灰度图# 2. 实例化SIFT算法

sift = cv2.xfeatures2d.SIFT_create()# 3. 检测关键点

keypoints = sift.detect(gray, None) # None表示无需掩码# 4. 生成特征描述子

keypoints, descriptors = sift.compute(gray, keypoints)# 5. 绘制关键点(圆圈大小表示尺度,箭头表示主方向)

img_with_kp = cv2.drawKeypoints(

img, keypoints, None,

flags=cv2.DRAW_MATCHES_FLAGS_DRAW_RICH_KEYPOINTS # 绘制丰富信息(尺度+方向))# 6. 打印关键信息print(f"检测到的关键点数量:{len(keypoints)}")print(f"特征描述子形状:{descriptors.shape}") # 输出 (关键点数量, 128)# 7. 显示结果

cv2.imshow("SIFT Keypoints", img_with_kp)

cv2.waitKey(0)

cv2.destroyAllWindows()# 保存结果

cv2.imwrite("sift_keypoints_lena.jpg", img_with_kp)

(四)代码关键说明

-

输入图像:必须为灰度图,SIFT 算法基于灰度梯度计算特征。

-

关键点绘制:

DRAW_MATCHES_FLAGS_DRAW_RICH_KEYPOINTS参数会绘制关键点的尺度(圆圈大小)和主方向(箭头),直观展示特征信息。 -

特征描述子:

descriptors是 N×128 的矩阵(N 为关键点数量),每一行对应一个关键点的 128 维特征向量。

四、示例与效果展示

(一)测试图像

选择经典的 Lena 图像(512×512 像素)和建筑图像,测试不同场景下的特征提取效果。

(二)检测效果

-

Lena 图像:

-

检测到约 200 + 个关键点,主要集中在面部轮廓、眼睛、鼻子等边缘和角点区域。

-

关键点的圆圈大小随尺度变化(面部细节处圆圈小,轮廓处圆圈大),箭头方向对应主方向。

-

-

建筑图像:

- 关键点集中在墙体转角、窗户边缘、屋顶轮廓等结构显著区域,边界点被有效剔除。

(三)特征匹配示例(扩展)

SIFT 的核心应用之一是特征匹配,以下是简单匹配代码:

python

# 读取两张待匹配图像

img1 = cv2.imread("img1.jpg")

img2 = cv2.imread("img2.jpg")

gray1 = cv2.cvtColor(img1, cv2.COLOR_BGR2GRAY)

gray2 = cv2.cvtColor(img2, cv2.COLOR_BGR2GRAY)

# 提取SIFT特征

sift = cv2.xfeatures2d.SIFT_create()

kp1, des1 = sift.detectAndCompute(gray1, None)

kp2, des2 = sift.detectAndCompute(gray2, None)

# 暴力匹配(BF匹配)

bf = cv2.BFMatcher()

matches = bf.match(des1, des2)

# 绘制匹配结果

img_matches = cv2.drawMatches(img1, kp1, img2, kp2, matches[:50], None) # 绘制前50个匹配对

cv2.imshow("SIFT Matches", img_matches)

cv2.waitKey(0)

cv2.destroyAllWindows()- 效果:正确匹配的特征对会显示为连接两张图像的直线,尺度和旋转变化下仍能稳定匹配。

五、总结与应用建议

(一)算法优势与局限

优势

-

完全的尺度不变性和旋转不变性,适应复杂场景变化。

-

特征描述子鲁棒性强,对光照变化、噪声有一定容忍度。

-

特征区分度高,128 维向量能有效表征图像局部特征。

局限

-

计算量较大,实时性不如 FAST、ORB 等算法。

-

专利保护限制:OpenCV 3.4.3 + 版本无法免费使用,需降级或使用替代算法(如 ORB)。

-

对模糊图像敏感:过度模糊会导致梯度信息丢失,特征提取效果下降。

(二)实际应用场景

-

图像匹配与拼接:如全景图拼接、多视角图像对齐。

-

目标识别与跟踪:通过特征匹配定位目标位置,跟踪目标运动。

-

三维重建:利用不同视角的 SIFT 特征对应关系,恢复场景三维结构。

-

图像检索:以 128 维特征向量为索引,实现相似图像检索。

(三)实践建议

参数调整技巧:

-

nfeatures:指定提取的最大关键点数量(默认 0,无限制),需根据图像复杂度调整。 -

contrastThreshold:对比度阈值(默认 0.04),值越大,剔除的弱特征越多。 -

edgeThreshold:边缘阈值(默认 10),值越大,允许的边界点越多。 -

预处理优化:

-

对噪声较大的图像,先进行高斯模糊(

cv2.GaussianBlur),再提取 SIFT 特征。 -

避免图像过度曝光或阴影,确保灰度梯度信息清晰。

-

-

替代方案:

-

若需实时性:使用 ORB 算法(无专利限制,速度快,兼具尺度和旋转不变性)。

-

若需更高鲁棒性:使用 SURF 算法(SIFT 的加速版本,专利保护同样限制)。

-