一、技术简介

全景图像拼接是将多张重叠的局部图像,通过特征匹配、变换对齐和融合拼接,生成一张宽视角、无明显拼接痕迹的完整图像技术。其核心逻辑是找到图像间的重叠特征点,通过数学变换实现图像对齐,最终完成无缝融合。

该技术广泛应用于手机全景摄影、无人机航拍测绘、虚拟现实(VR)场景构建等领域,核心依赖特征提取(如 SIFT)、特征匹配、单应性矩阵求解和图像融合四大关键步骤,是计算机视觉中 "图像配准 + 图像融合" 的典型应用。

二、核心原理

全景拼接的本质是 "先对齐,后融合",整个流程可拆解为五大核心步骤,环环相扣确保拼接效果:

(一)步骤 1:图像预处理与特征提取

核心目标

从每张输入图像中提取稳定的特征点和特征向量,为后续匹配提供依据。

实现逻辑

-

图像预处理:将输入图像转换为灰度图(减少计算量),可选高斯模糊降噪。

-

特征提取:使用具有尺度不变性和旋转不变性的算法(如 SIFT),检测图像中的关键点(如边缘、角点),并生成 128 维特征向量。

- 选择 SIFT 的原因:即使图像存在缩放、旋转或光照变化,仍能稳定提取特征,确保重叠区域的特征点可匹配。

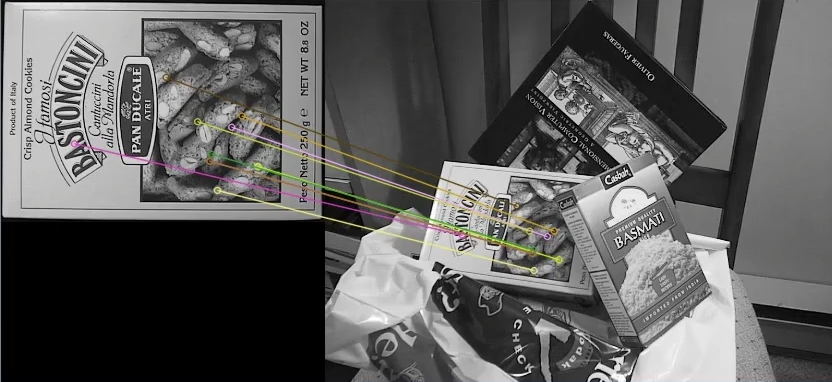

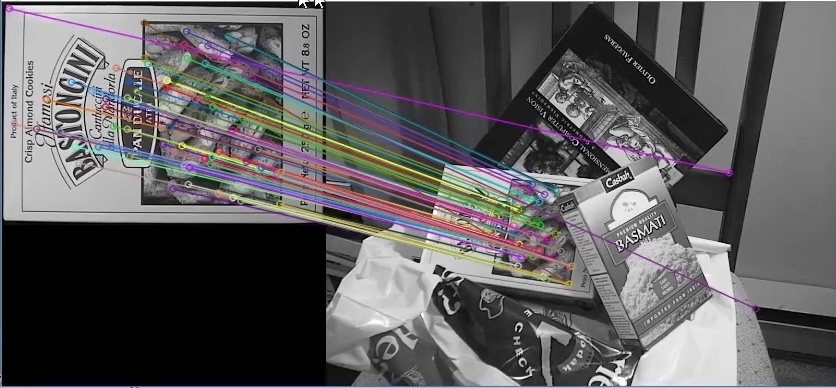

(二)步骤 2:特征匹配与过滤

核心目标

找到不同图像间的匹配特征点(即重叠区域的对应点),并剔除错误匹配点(外点)。

实现方法

基础匹配:

- 蛮力匹配(BF 匹配):直接计算两张图像 特征向量 **间的欧式距离,距离越小则匹配度越高,**适用于少量图像拼接。

python

cv_show('img1', img1)

cv_show('img2', img2)

sift = cv2.xfeatures2d.SIFT_create()

kp1, des1 = sift.detectAndCompute(img1, None)

kp2, des2 = sift.detectAndCompute(img2, None)

# crossCheck表示两个特征点要互相匹配,例如A中的第i个特征点与B中的第j个特征点最近的,并且B中的第j个特征点到A中的第i个特征点也是

# NORM_L2:归一化数组的(欧几里德距离),如果其他特征计算方法需要考虑不同的匹配计算方式

bf = cv2.BFMatcher(crossCheck=True)1对1匹配

python

matches = bf.match(des1, des2)

matches = sorted(matches, key=lambda x: x.distance)

img3 = cv2.drawMatches(img1, kp1, img2, kp2, matches[:10], None, flags=2)

cv_show('img3', img3)

-

KNN 匹配(K=2):为每个特征点匹配两个最近邻特征点,通过 "近邻距离比" 过滤错误匹配。knnMatch

python

bf = cv2.BFMatcher()

matches = bf.knnMatch(des1, des2, k=2)

good = []

for m, n in matches:

if m.distance < 0.75 * n.distance:

good.append([m])

img3 = cv2.drawMatchesKnn(img1, kp1, img2, kp2, good, None, flags=2)

cv_show('img3', img3)

过滤策略:

-

距离比过滤:若第一个匹配点与第二个匹配点的距离比小于 0.75(经验阈值),则保留该匹配对,否则视为错误匹配。

-

交叉检查(Cross Check):仅保留 "双向最优匹配" 的特征对(即 A 图的点 i 匹配 B 图的点 j,且 B 图的点 j 也匹配 A 图的点 i),进一步提纯匹配结果。

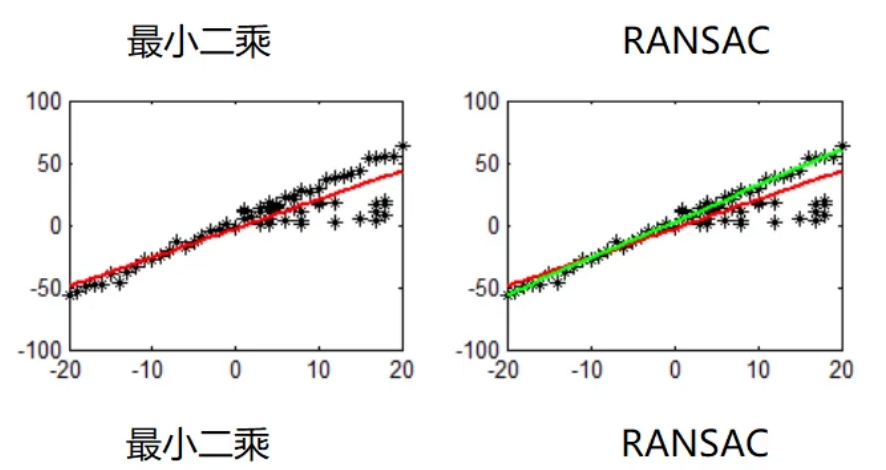

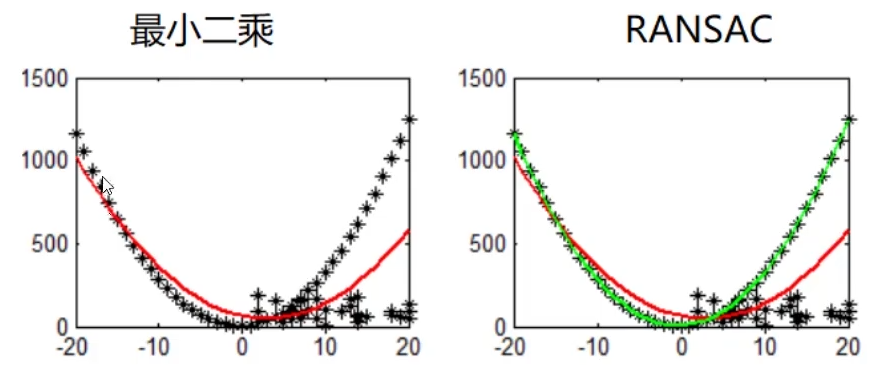

(三)步骤 3:RANSAC 算法与单应性矩阵求解

核心目标

通过鲁棒算法剔除剩余外点,求解图像间的变换矩阵(单应性矩阵 H),实现图像对齐。

二阶的情况

关键概念与逻辑

-

单应性矩阵(Homography Matrix):

-

定义:3×3 的矩阵 H,描述两张图像间的投影变换关系,可将一张图像的像素点映射到另一张图像的对应位置。

-

求解条件:需至少 4 对正确匹配的特征点(4 对对应点可构建 8 个方程,求解 H 矩阵的 8 个未知参数)。

-

-

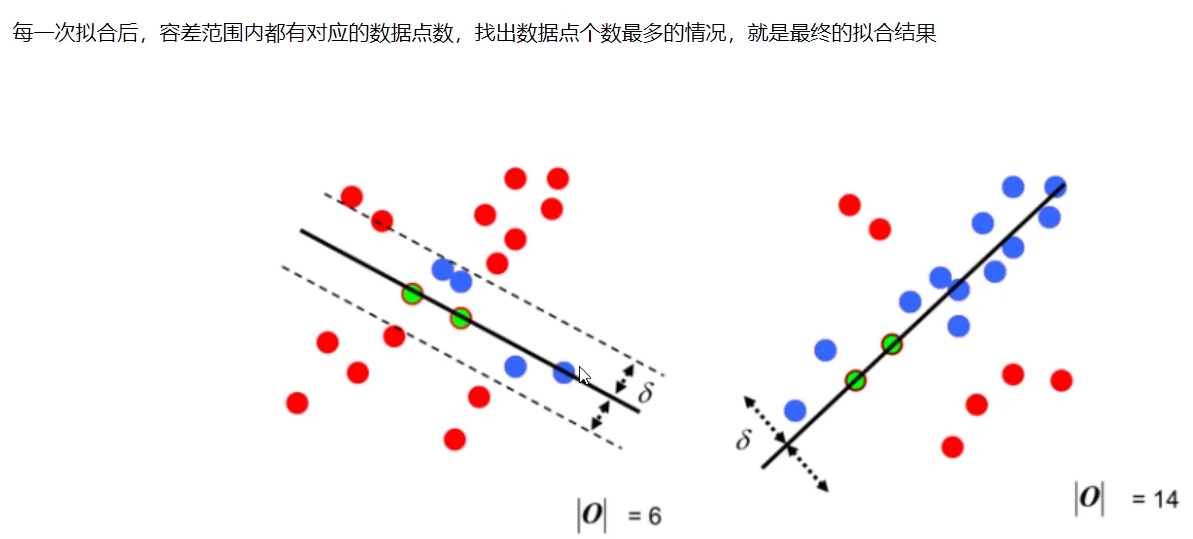

RANSAC 算法(随机抽样一致性算法):

-

核心问题:直接用所有匹配点求解 H 矩阵,可能受错误匹配点(外点)干扰,导致变换矩阵失真。

-

工作原理:

-

随机抽取 4 对匹配点,求解初始 H 矩阵;

-

设定容忍范围(重投影误差阈值),统计满足该矩阵变换的内点(正确匹配点)数量;

-

迭代多次(如 1000 次),选择内点数量最多的 H 矩阵作为最优解;

-

用最优 H 矩阵对应的内点重新求解,得到最终的单应性矩阵。

-

-

四)步骤 4:图像变换与对齐

核心目标

根据求解的单应性矩阵 H,对其中一张图像(通常是待拼接的非基准图像)进行投影变换,使其与基准图像的重叠区域完全对齐。

实现逻辑

-

选择基准图像:通常选择中间位置或特征最丰富的图像作为基准(如第一张图像)。

-

投影变换:调用 OpenCV 的

cv2.warpPerspective()函数,将待拼接图像通过 H 矩阵映射到基准图像的坐标系中,实现空间对齐。- 注意:变换后图像可能出现黑边(未被映射的区域),后续需通过融合处理消除。

(五)步骤 5:图像融合

核心目标

将对齐后的多张图像无缝拼接,消除拼接边界的亮度差异、过渡痕迹,生成自然的全景图。

常用方法

-

简单拼接:直接将对齐后的图像按坐标叠加,适用于亮度一致、重叠区域大的图像(易出现明显边界)。

-

线性融合(加权平均):

-

原理:在重叠区域,从基准图像到待拼接图像,权重从 1 平滑过渡到 0,实现像素值的渐变融合。

-

公式:重叠区域像素值 = 基准图像像素 ×(1 - α) + 待拼接图像像素 ×α(α 从 0 到 1 渐变)。

-

-

多分辨率融合(拉普拉斯金字塔融合):适用于复杂光照场景,融合效果更自然,无明显边界痕迹(计算量稍大)。

三、OpenCV 代码实现步骤

(一)环境准备

需安装 OpenCV 3.4.1.15 版本(支持 SIFT 算法),安装命令参考:

python

pip install opencv-python==3.4.1.15 opencv-contrib-python==3.4.1.15(二)完整代码示例

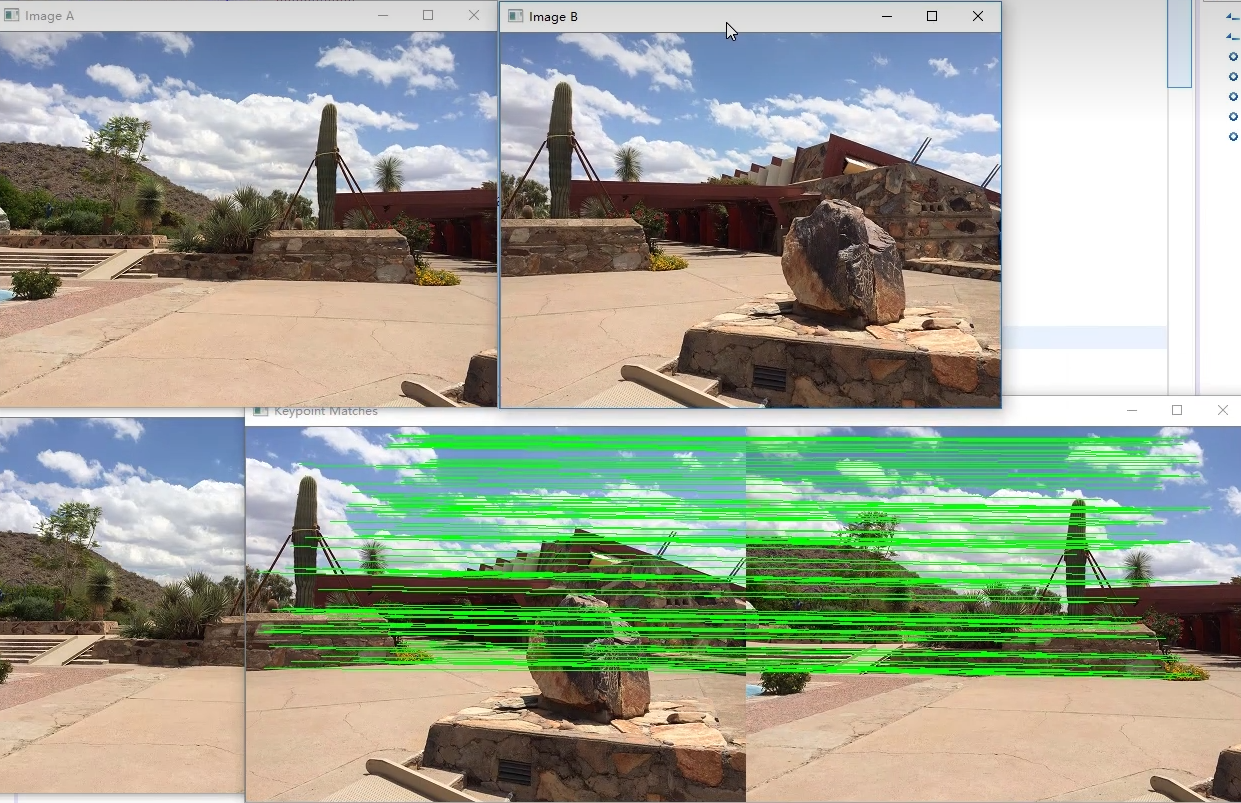

中间结果

拼接结果

以两张重叠图像拼接为例(上面代码实现):

python

import numpy as np

import cv2

class Stitcher:

#拼接函数

def stitch(self, images, ratio=0.75, reprojThresh=4.0,showMatches=False):

#获取输入图片

(imageB, imageA) = images

#检测A、B图片的SIFT关键特征点,并计算特征描述子

(kpsA, featuresA) = self.detectAndDescribe(imageA)

(kpsB, featuresB) = self.detectAndDescribe(imageB)

# 匹配两张图片的所有特征点,返回匹配结果

M = self.matchKeypoints(kpsA, kpsB, featuresA, featuresB, ratio, reprojThresh)

# 如果返回结果为空,没有匹配成功的特征点,退出算法

if M is None:

return None

# 否则,提取匹配结果

# H是3x3视角变换矩阵

(matches, H, status) = M

# 将图片A进行视角变换,result是变换后图片

result = cv2.warpPerspective(imageA, H, (imageA.shape[1] + imageB.shape[1], imageA.shape[0]))

self.cv_show('result', result)

# 将图片B传入result图片最左端

result[0:imageB.shape[0], 0:imageB.shape[1]] = imageB

self.cv_show('result', result)

# 检测是否需要显示图片匹配

if showMatches:

# 生成匹配图片

vis = self.drawMatches(imageA, imageB, kpsA, kpsB, matches, status)

# 返回结果

return (result, vis)

# 返回匹配结果

return result

def cv_show(self,name,img):

cv2.imshow(name, img)

cv2.waitKey(0)

cv2.destroyAllWindows()

def detectAndDescribe(self, image):

# 将彩色图片转换成灰度图

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 建立SIFT生成器

descriptor = cv2.xfeatures2d.SIFT_create()

# 检测SIFT特征点,并计算描述子

(kps, features) = descriptor.detectAndCompute(image, None)

# 将结果转换成NumPy数组

kps = np.float32([kp.pt for kp in kps])

# 返回特征点集,及对应的描述特征

return (kps, features)

def matchKeypoints(self, kpsA, kpsB, featuresA, featuresB, ratio, reprojThresh):

# 建立暴力匹配器

matcher = cv2.BFMatcher()

# 使用KNN检测来自A、B图的SIFT特征匹配对,K=2

rawMatches = matcher.knnMatch(featuresA, featuresB, 2)

matches = []

for m in rawMatches:

# 当最近距离跟次近距离的比值小于ratio值时,保留此匹配对

if len(m) == 2 and m[0].distance < m[1].distance * ratio:

# 存储两个点在featuresA, featuresB中的索引值

matches.append((m[0].trainIdx, m[0].queryIdx))

# 当筛选后的匹配对大于4时,计算视角变换矩阵

if len(matches) > 4:

# 获取匹配对的点坐标

ptsA = np.float32([kpsA[i] for (_, i) in matches])

ptsB = np.float32([kpsB[i] for (i, _) in matches])

# 计算视角变换矩阵

(H, status) = cv2.findHomography(ptsA, ptsB, cv2.RANSAC, reprojThresh)

# 返回结果

return (matches, H, status)

# 如果匹配对小于4时,返回None

return None

def drawMatches(self, imageA, imageB, kpsA, kpsB, matches, status):

# 初始化可视化图片,将A、B图左右连接到一起

(hA, wA) = imageA.shape[:2]

(hB, wB) = imageB.shape[:2]

vis = np.zeros((max(hA, hB), wA + wB, 3), dtype="uint8")

vis[0:hA, 0:wA] = imageA

vis[0:hB, wA:] = imageB

# 联合遍历,画出匹配对

for ((trainIdx, queryIdx), s) in zip(matches, status):

# 当点对匹配成功时,画到可视化图上

if s == 1:

# 画出匹配对

ptA = (int(kpsA[queryIdx][0]), int(kpsA[queryIdx][1]))

ptB = (int(kpsB[trainIdx][0]) + wA, int(kpsB[trainIdx][1]))

cv2.line(vis, ptA, ptB, (0, 255, 0), 1)

# 返回可视化结果

return vis主函数:

python

from Stitcher import Stitcher

import cv2

# 读取拼接图片

imageA = cv2.imread("left_01.png")

imageB = cv2.imread("right_01.png")

# 把图片拼接成全景图

stitcher = Stitcher()

(result, vis) = stitcher.stitch([imageA, imageB], showMatches=True)

# 显示所有图片

cv2.imshow("Image A", imageA)

cv2.imshow("Image B", imageB)

cv2.imshow("Keypoint Matches", vis)

cv2.imshow("Result", result)

cv2.waitKey(0)

cv2.destroyAllWindows()