目录

[一、按测试阶段分类:软件测试的 "全生命周期之旅"](#一、按测试阶段分类:软件测试的 “全生命周期之旅”)

[1.1 单元测试:软件的 "零部件质检"](#1.1 单元测试:软件的 “零部件质检”)

[1.1.1 什么是单元测试?](#1.1.1 什么是单元测试?)

[1.1.2 单元测试的核心要素](#1.1.2 单元测试的核心要素)

[1.1.3 单元测试的实际案例:冒泡排序函数的单元测试](#1.1.3 单元测试的实际案例:冒泡排序函数的单元测试)

[(3)使用 JUnit 框架实现测试脚本](#(3)使用 JUnit 框架实现测试脚本)

[1.1.4 单元测试工具推荐](#1.1.4 单元测试工具推荐)

[1.1.5 新手注意事项](#1.1.5 新手注意事项)

[1.2 集成测试:软件的 "模块组装验证"](#1.2 集成测试:软件的 “模块组装验证”)

[1.2.1 什么是集成测试?](#1.2.1 什么是集成测试?)

[1.2.2 集成测试的核心要素](#1.2.2 集成测试的核心要素)

[1.2.3 集成测试的常用策略](#1.2.3 集成测试的常用策略)

[1.2.4 集成测试工具推荐](#1.2.4 集成测试工具推荐)

[1.2.5 新手注意事项](#1.2.5 新手注意事项)

[1.3 系统测试:软件的 "全面质检"](#1.3 系统测试:软件的 “全面质检”)

[1.3.1 什么是系统测试?](#1.3.1 什么是系统测试?)

[1.3.2 系统测试的核心要素](#1.3.2 系统测试的核心要素)

[1.3.3 系统测试的核心子类型](#1.3.3 系统测试的核心子类型)

[1.3.4 系统测试的关键流程:冒烟测试与回归测试](#1.3.4 系统测试的关键流程:冒烟测试与回归测试)

[(1)冒烟测试:系统测试的 "准入门槛"](#(1)冒烟测试:系统测试的 “准入门槛”)

[(2)回归测试:系统测试的 "质量保障"](#(2)回归测试:系统测试的 “质量保障”)

[1.3.5 系统测试的实际案例:电商 APP 系统测试计划(简化版)](#1.3.5 系统测试的实际案例:电商 APP 系统测试计划(简化版))

[1.3.6 系统测试工具推荐](#1.3.6 系统测试工具推荐)

[1.3.7 新手注意事项](#1.3.7 新手注意事项)

[1.4 验收测试:软件的 "交付终审"](#1.4 验收测试:软件的 “交付终审”)

[1.4.1 什么是验收测试?](#1.4.1 什么是验收测试?)

[1.4.2 验收测试的核心要素](#1.4.2 验收测试的核心要素)

[1.4.3 验收测试的常见类型](#1.4.3 验收测试的常见类型)

[1.4.5 新手注意事项](#1.4.5 新手注意事项)

[1.5 四大测试阶段的核心对比](#1.5 四大测试阶段的核心对比)

[二、按是否手工测试分类:手工测试 vs 自动化测试,效率与灵活的平衡](#二、按是否手工测试分类:手工测试 vs 自动化测试,效率与灵活的平衡)

[2.1 手工测试:测试的 "基础防线"](#2.1 手工测试:测试的 “基础防线”)

[2.1.1 什么是手工测试?](#2.1.1 什么是手工测试?)

[2.1.2 手工测试的核心适用场景](#2.1.2 手工测试的核心适用场景)

[2.1.3 手工测试的优缺点](#2.1.3 手工测试的优缺点)

[2.1.4 新手注意事项](#2.1.4 新手注意事项)

[2.2 自动化测试:测试的 "效率利器"](#2.2 自动化测试:测试的 “效率利器”)

[2.2.1 什么是自动化测试?](#2.2.1 什么是自动化测试?)

[2.2.2 自动化测试的核心分类](#2.2.2 自动化测试的核心分类)

[2.2.3 自动化测试的核心适用场景](#2.2.3 自动化测试的核心适用场景)

[2.2.4 自动化测试的优缺点](#2.2.4 自动化测试的优缺点)

[2.2.5 自动化测试工具推荐](#2.2.5 自动化测试工具推荐)

[2.2.6 新手注意事项](#2.2.6 新手注意事项)

[2.3 手工测试与自动化测试的协同策略](#2.3 手工测试与自动化测试的协同策略)

[三、按实施组织分类:谁来执行测试?------α 测试、β 测试、第三方测试](#三、按实施组织分类:谁来执行测试?——α 测试、β 测试、第三方测试)

[3.1 α 测试:软件的 "内部内测"](#3.1 α 测试:软件的 “内部内测”)

[3.1.1 什么是 α 测试?](#3.1.1 什么是 α 测试?)

[3.1.2 新手注意事项](#3.1.2 新手注意事项)

[3.2 β 测试:软件的 "公开公测"](#3.2 β 测试:软件的 “公开公测”)

[3.2.1 什么是 β 测试?](#3.2.1 什么是 β 测试?)

[3.2.2 β 测试的实际案例:某短视频 APP 的 β 测试](#3.2.2 β 测试的实际案例:某短视频 APP 的 β 测试)

[3.2.3 α 测试与 β 测试的核心对比](#3.2.3 α 测试与 β 测试的核心对比)

[3.2.4 新手注意事项](#3.2.4 新手注意事项)

[3.3 第三方测试:软件的 "中立质检"](#3.3 第三方测试:软件的 “中立质检”)

[3.3.1 什么是第三方测试?](#3.3.1 什么是第三方测试?)

[3.3.2 第三方测试的核心优势](#3.3.2 第三方测试的核心优势)

[3.3.3 新手注意事项](#3.3.3 新手注意事项)

[四、按测试地域分类:本地测试 vs 国际化测试,适配不同市场需求](#四、按测试地域分类:本地测试 vs 国际化测试,适配不同市场需求)

[4.1 本地测试:聚焦本土市场的 "精准适配"](#4.1 本地测试:聚焦本土市场的 “精准适配”)

[4.1.1 什么是本地测试?](#4.1.1 什么是本地测试?)

[4.2 国际化测试:面向全球市场的 "全面适配"](#4.2 国际化测试:面向全球市场的 “全面适配”)

[4.2.1 什么是国际化测试?](#4.2.1 什么是国际化测试?)

[4.2.2 国际化测试的核心内容](#4.2.2 国际化测试的核心内容)

[4.2.3 国际化测试工具推荐](#4.2.3 国际化测试工具推荐)

[4.2.4 新手注意事项](#4.2.4 新手注意事项)

前言

今天这篇文章,我们将收尾整个测试分类系列,聚焦剩下的四大实用维度 ------"按测试阶段分类"、"按是否手工测试分类"、"按实施组织分类"、"按测试地域分类"。

这四大维度看似独立,实则贯穿软件测试的全生命周期:从编码阶段的单元测试,到上线前的验收测试;从人工执行的手工测试,到机器自动化测试;从公司内部的 α 测试,到全球用户参与的 β 测试;从本地市场的适配测试,到跨国产品的国际化测试。每个维度都直接关联实际工作场景,是面试、项目实操的高频考点。下面就让我们正式开始吧!

一、按测试阶段分类:软件测试的 "全生命周期之旅"

按测试阶段分类,是最贴合软件开发流程的分类方式。一款软件从一行代码诞生,到最终交付用户手中,每个阶段的测试重点、测试对象、测试方法都截然不同 ------ 就像汽车生产:先检查零部件(单元测试),再组装验证(集成测试),接着全面质检(系统测试),最后用户试驾(验收测试)。

这一维度的核心价值的是:让测试工作与开发流程同步,早发现、早修复问题,降低测试成本。下面我们按 "单元测试→集成测试→系统测试→验收测试" 的流程,逐一拆解每个阶段的核心要点。

1.1 单元测试:软件的 "零部件质检"

1.1.1 什么是单元测试?

单元测试(Unit Testing),是针对软件的最小组成单元进行的测试,比如一个函数、一个类、一个方法。测试的核心是验证单个单元的逻辑正确性,不依赖其他模块或外部系统。

核心特点:"最小粒度、隔离测试",测试时需排除其他模块的干扰(比如用 Mock 工具模拟依赖的接口或数据)。

核心目标:确保每个最小单元都能按照设计要求正确工作,发现单元内部的逻辑漏洞、语法错误、边界条件问题等,避免这些问题流入后续阶段。

打个比方:就像汽车厂检查采购的发动机、车轮等零部件,确保每个零件都符合生产标准,不会因为单个零件缺陷导致整车故障。

1.1.2 单元测试的核心要素

| 要素 | 具体说明 |

|---|---|

| 测试阶段 | 编码同步进行(编码后立即测试),或编码前(TDD 测试驱动开发) |

| 测试对象 | 最小组成单元(函数、类、方法等,由团队定义) |

| 测试人员 | 开发工程师(主力)或白盒测试工程师(需具备代码阅读和编程能力) |

| 测试依据 | 代码注释、详细设计文档、接口定义 |

| 测试方法 | 以白盒测试为主,结合静态测试(代码评审)和动态测试(用例执行) |

| 测试内容 | 模块接口测试、局部数据结构测试、路径覆盖测试、错误处理测试、边界值测试 |

1.1.3 单元测试的实际案例:冒泡排序函数的单元测试

以 Java 语言的冒泡排序函数为例,演示单元测试的实施过程:

(1)被测代码(冒泡排序函数)

java

public class BubbleSort {

// 冒泡排序函数:对int数组进行升序排序

public static void bubbleSort(int[] arr) {

if (arr == null || arr.length <= 1) {

return; // 空数组或长度为1的数组无需排序

}

int n = arr.length;

for (int i = 0; i < n - 1; i++) {

boolean swapped = false; // 标记是否发生交换

for (int j = 0; j < n - i - 1; j++) {

if (arr[j] > arr[j + 1]) {

// 交换相邻元素

int temp = arr[j];

arr[j] = arr[j + 1];

arr[j + 1] = temp;

swapped = true;

}

}

if (!swapped) {

break; // 无交换时提前退出,优化性能

}

}

}

}(2)设计单元测试用例

根据单元测试的核心内容,设计覆盖接口、边界、异常场景的用例:

| 用例编号 | 测试场景 | 输入数组 | 预期输出数组 | 测试目的 |

|---|---|---|---|---|

| 1 | 正常无序数组 | [64, 34, 25, 12] | [12, 25, 34, 64] | 验证核心排序逻辑 |

| 2 | 空数组 | [] | [] | 验证边界条件(空输入) |

| 3 | 长度为 1 的数组 | [5] | [5] | 验证边界条件(最小长度) |

| 4 | 已有序数组 | [1, 2, 3, 4] | [1, 2, 3, 4] | 验证优化逻辑(提前退出) |

| 5 | 含重复元素的数组 | [4, 2, 4, 1, 3] | [1, 2, 3, 4, 4] | 验证重复元素处理能力 |

| 6 | 逆序数组 | [5, 4, 3, 2, 1] | [1, 2, 3, 4, 5] | 验证最坏场景下的排序逻辑 |

| 7 | 输入 null | null | null | 验证异常输入处理能力 |

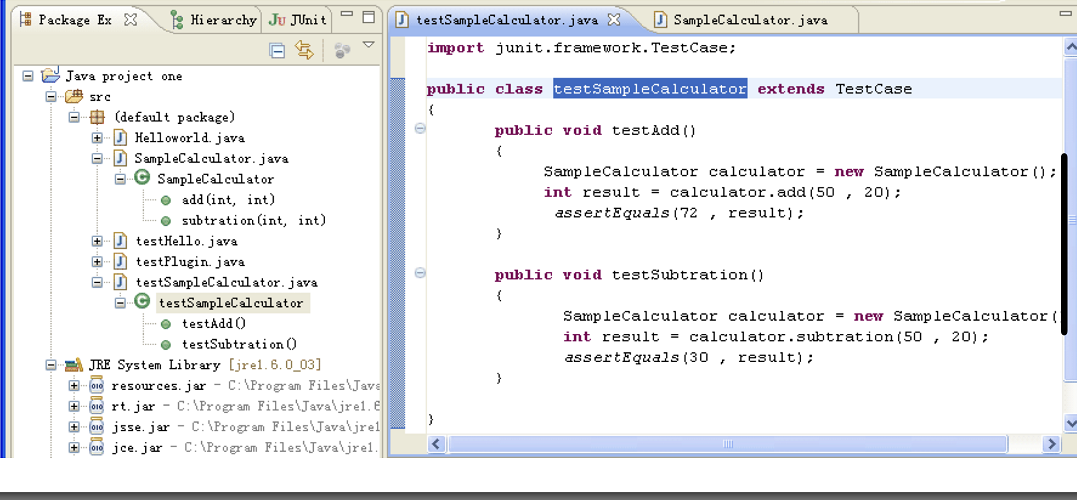

(3)使用 JUnit 框架实现测试脚本

JUnit 是 Java 语言最常用的单元测试框架,支持注解、断言等功能,简化测试脚本编写:

java

import org.junit.jupiter.api.Test;

import static org.junit.jupiter.api.Assertions.assertArrayEquals;

public class BubbleSortTest {

// 测试正常无序数组

@Test

public void testNormalUnorderedArray() {

int[] arr = {64, 34, 25, 12};

int[] expected = {12, 25, 34, 64};

BubbleSort.bubbleSort(arr);

assertArrayEquals(expected, arr); // 断言实际结果与预期一致

}

// 测试空数组

@Test

public void testEmptyArray() {

int[] arr = {};

int[] expected = {};

BubbleSort.bubbleSort(arr);

assertArrayEquals(expected, arr);

}

// 测试长度为1的数组

@Test

public void testSingleElementArray() {

int[] arr = {5};

int[] expected = {5};

BubbleSort.bubbleSort(arr);

assertArrayEquals(expected, arr);

}

// 测试已有序数组

@Test

public void testAlreadySortedArray() {

int[] arr = {1, 2, 3, 4};

int[] expected = {1, 2, 3, 4};

BubbleSort.bubbleSort(arr);

assertArrayEquals(expected, arr);

}

// 测试含重复元素的数组

@Test

public void testArrayWithDuplicates() {

int[] arr = {4, 2, 4, 1, 3};

int[] expected = {1, 2, 3, 4, 4};

BubbleSort.bubbleSort(arr);

assertArrayEquals(expected, arr);

}

// 测试逆序数组

@Test

public void testReverseSortedArray() {

int[] arr = {5, 4, 3, 2, 1};

int[] expected = {1, 2, 3, 4, 5};

BubbleSort.bubbleSort(arr);

assertArrayEquals(expected, arr);

}

// 测试输入null

@Test

public void testNullInput() {

int[] arr = null;

BubbleSort.bubbleSort(arr); // 无异常抛出即通过

}

}(4)执行测试与结果分析

运行 JUnit 测试脚本后,若所有用例的断言都通过,则说明冒泡排序函数的单元测试通过;若某条用例失败(如逆序数组排序结果不符合预期),则需定位代码逻辑问题(如循环条件错误)并修复,直至所有用例通过。

1.1.4 单元测试工具推荐

不同编程语言对应不同的单元测试框架和工具,常用工具整理如下:

| 工具类型 | 常用工具 | 适用场景 |

|---|---|---|

| 单元测试框架 | JUnit(Java)、pytest(Python)、NUnit(.NET)、XCTest(iOS)、Espresso(Android) | 编写和执行单元测试用例 |

| 代码覆盖率工具 | JaCoCo(Java)、Coverage.py(Python)、Cobertura(多语言) | 统计测试用例的代码覆盖程度 |

| Mock 工具 | Mockito(Java)、unittest.mock(Python)、EasyMock(Java) | 模拟依赖的接口或数据,隔离测试 |

| 静态分析工具 | SonarQube(多语言)、CheckStyle(Java)、Pylint(Python) | 代码规范检查、逻辑漏洞检测 |

1.1.5 新手注意事项

单元测试不是 "开发的额外工作":很多开发认为单元测试浪费时间,但实际上,单元测试能提前发现代码中的低级错误(如空指针、循环条件错误),避免这些错误在集成测试、系统测试阶段才暴露,大幅降低修复成本。

测试用例要覆盖核心场景:新手容易只测试 "正常流程",而忽略边界条件(如空数组、长度为 1 的数组)和异常场景(如输入 null)。好的单元测试用例应覆盖 "正常 + 边界 + 异常",确保单元的鲁棒性。

保持测试的独立性:单元测试应独立于其他模块,不依赖外部系统(如数据库、网络接口),通过 Mock 工具模拟依赖,避免因外部环境问题导致测试失败。

1.2 集成测试:软件的 "模块组装验证"

1.2.1 什么是集成测试?

集成测试(Integration Testing),又称联合测试、组装测试,是将多个已通过单元测试的模块,按照设计要求组装起来,测试模块之间的接口交互、数据传输是否正确的过程。

核心特点:"模块联动、接口聚焦",不关注单个模块的内部逻辑,重点验证模块间的协作是否正常。

核心目标:发现模块间接口的兼容性问题、数据传输错误、功能冲突等,确保组装后的系统能正常协同工作。

打个比方:就像汽车厂将发动机、车轮、底盘等零部件组装成整车后,测试发动机与变速箱的配合、车轮与底盘的连接是否正常,确保汽车能正常行驶。

1.2.2 集成测试的核心要素

| 要素 | 具体说明 |

|---|---|

| 测试阶段 | 单元测试通过后,系统测试之前 |

| 测试对象 | 模块间的接口(如函数调用、API 接口、数据传递通道) |

| 测试人员 | 白盒测试工程师、开发工程师(需了解模块间的接口设计) |

| 测试依据 | 概要设计文档、接口规格说明书、单元测试报告 |

| 测试方法 | 灰盒测试为主(结合黑盒测试的功能验证和白盒测试的接口逻辑覆盖) |

| 测试内容 | 模块间数据传输正确性、接口参数校验、模块间功能冲突、全局数据结构一致性、单模块缺陷对系统的影响 |

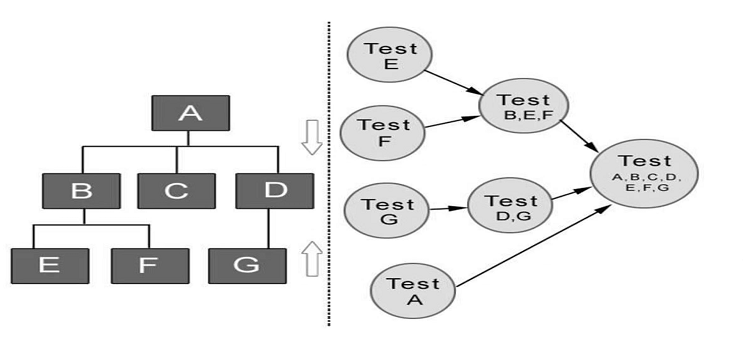

1.2.3 集成测试的常用策略

集成测试的核心是 "如何组装模块",常用的组装策略有 4 种,不同策略适用于不同的项目场景:

自顶向下集成:从顶层模块(如系统入口模块)开始,逐步集成下层模块,通过 Mock 工具模拟未集成的下层模块。适用于核心模块在顶层的项目,能 early 验证核心功能,但 Mock 工具的使用成本较高。

自底向上集成:从底层模块(如数据访问模块)开始,逐步集成上层模块,需要编写驱动程序(Driver)调用底层模块。适用于底层模块稳定的项目,测试效率高,但核心功能验证较晚。

混合集成(三明治集成):结合自顶向下和自底向上的策略,先集成中间层模块,再分别向上、向下集成。适用于大型复杂项目,平衡了核心功能验证和测试效率。

一次性集成:将所有模块一次性组装完成后进行测试。适用于小型项目(模块少、接口简单),测试成本低,但问题定位困难(难以确定是哪个模块的接口问题)。

1.2.4 集成测试工具推荐

| 工具类型 | 常用工具 | 适用场景 |

|---|---|---|

| 接口测试工具 | Postman、RestAssured(Java)、Pytest+Requests(Python)、SoapUI | 模拟模块间接口调用、验证响应 |

| 接口文档工具 | Swagger、YApi、RAP | 查看接口规格、生成测试数据 |

| 抓包工具 | Fiddler、Wireshark、Charles | 捕获模块间的接口数据,分析传输过程 |

| Mock 工具 | Mockito、EasyMock、WireMock | 模拟未集成模块的接口响应 |

| 测试管理工具 | TestRail、禅道、JIRA | 管理测试用例、跟踪缺陷 |

1.2.5 新手注意事项

集成测试的核心是 "接口",不是 "功能":新手容易陷入 "测试模块功能" 的误区,而忽略接口交互的细节(如参数格式、数据类型、响应时间)。记住:集成测试的重点是 "模块间能不能配合工作",而不是 "单个模块能不能工作"。

测试用例要覆盖接口的异常场景:比如接口参数错误、接口超时、模块宕机等,这些异常场景在实际运行中容易出现问题,必须重点覆盖。

问题定位要 "精准":集成测试中发现的问题,可能涉及多个模块,需通过接口日志、抓包工具等定位问题根源(是哪个模块的接口设计或实现错误),避免盲目甩锅。

1.3 系统测试:软件的 "全面质检"

1.3.1 什么是系统测试?

系统测试(System Testing),是将通过集成测试的软件系统,作为一个整体,在模拟生产环境下进行的全面测试,验证系统是否满足所有功能性和非功能性需求。

核心特点:"整体视角、全面覆盖",不关注单个模块或接口,而是从用户角度验证整个系统的表现。

核心目标:确保系统作为一个整体,能满足用户的所有需求,包括功能完整性、性能稳定性、安全性、易用性、兼容性等,发现系统层面的问题(如模块协同导致的性能瓶颈、全局数据不一致等)。

打个比方:就像汽车厂对组装好的整车进行全面测试,包括加速性能、刹车性能、舒适性、安全性(碰撞测试)、油耗等,确保汽车符合用户的所有使用需求。

1.3.2 系统测试的核心要素

| 要素 | 具体说明 |

|---|---|

| 测试阶段 | 集成测试通过后,验收测试之前 |

| 测试对象 | 整个软件系统(包括硬件、软件、网络、数据等) |

| 测试人员 | 黑盒测试工程师(主力)、专项测试工程师(性能、安全、兼容性测试) |

| 测试依据 | 需求规格说明书、用户手册、行业标准(如安全等保 2.0) |

| 测试方法 | 黑盒测试为主,结合专项测试(性能、安全、兼容性等) |

| 测试内容 | 功能测试、性能测试、可靠性测试、安全性测试、易用性测试、兼容性测试、数据备份与恢复测试等 |

1.3.3 系统测试的核心子类型

系统测试覆盖的内容广泛,核心子类型包括:

功能测试:验证系统的所有功能是否符合需求,比如电商 APP 的 "浏览商品、加入购物车、下单支付、退货退款" 等功能是否正常。

性能测试:验证系统在不同负载下的表现,比如 1000 人并发访问时的响应时间、吞吐量、资源利用率等。

可靠性测试:验证系统长时间运行的稳定性,比如 7×24 小时不间断运行是否会崩溃、是否有内存泄漏等。

安全性测试:验证系统的抗攻击能力,比如防止 SQL 注入、XSS 注入、权限越界等安全漏洞。

易用性测试:验证系统的用户体验,比如操作流程是否顺畅、提示是否清晰、界面是否友好等。

兼容性测试:验证系统在不同环境下的表现,比如不同操作系统(Windows、macOS、iOS、Android)、不同浏览器(Chrome、Firefox、Edge)、不同硬件配置下的兼容性。

数据备份与恢复测试:验证系统的数据备份是否完整、恢复是否正常,比如数据库崩溃后能否通过备份恢复数据。

1.3.4 系统测试的关键流程:冒烟测试与回归测试

系统测试过程中,有两个关键的辅助测试类型,贯穿测试全流程:

(1)冒烟测试:系统测试的 "准入门槛"

- 定义:冒烟测试(Smoke Testing)是系统测试前的快速验证,仅测试系统的核心功能和主流程是否正常,确保系统具备进一步测试的条件。

- 核心目标:"快速判断系统是否可测",避免因核心功能失效导致后续测试工作白费。

- 实际案例:电商 APP 提测后,冒烟测试仅需验证 "打开 APP→浏览商品→加入购物车→下单" 的主流程是否正常,无需测试细节功能(如优惠券使用、地址编辑)。

- 特点:用例少、执行快(通常 10-30 分钟),不通过则打回开发修复,通过后再进行正式系统测试。

(2)回归测试:系统测试的 "质量保障"

- 定义:回归测试(Regression Testing)是在系统发生变更(如修复缺陷、新增功能)后,重新测试相关功能,确保变更未引入新的错误,且原有功能不受影响。

- 核心目标 :"防止旧问题复现、新问题引入",是保障系统质量的关键环节。

- 实际案例:电商 APP 修复 "支付失败" 的缺陷后,回归测试需验证 "支付功能" 是否正常,同时验证 "下单、订单查询、退款" 等相关功能是否不受影响。

- 特点:重复性强,适合自动化执行(如用 Selenium、Appium 编写回归测试脚本),能大幅提升测试效率。

1.3.5 系统测试的实际案例:电商 APP 系统测试计划(简化版)

| 测试类型 | 测试内容 | 测试工具 / 方法 | 预期指标 |

|---|---|---|---|

| 功能测试 | 核心流程(浏览→加购→下单→支付→退款)、单个功能点(登录、注册、地址管理) | 手工测试 + Postman(接口功能) | 功能覆盖率 100%,无严重缺陷 |

| 性能测试 | 并发测试(1000 人并发下单)、响应时间测试(核心功能≤2 秒)、耐久性测试(72 小时运行) | JMeter、PerfDog(移动端) | 响应时间≤2 秒,无崩溃、无内存泄漏 |

| 安全性测试 | 登录认证、权限控制、SQL 注入防护、敏感数据加密 | OWASP ZAP、Burp Suite | 无高危安全漏洞 |

| 易用性测试 | 操作流程合理性、提示信息清晰度、界面友好性 | 人工测试 + Hotjar(用户行为分析) | 用户完成核心任务的平均时间≤3 分钟 |

| 兼容性测试 | 不同手机型号(iOS 15/16、Android 11/12)、不同网络(WiFi/4G/5G) | Testin、BrowserStack | 无兼容性缺陷 |

| 数据备份与恢复测试 | 数据库备份、误删除数据恢复、系统崩溃后数据恢复 | 手工操作 + 数据库备份工具 | 数据恢复成功率 100%,无数据丢失 |

1.3.6 系统测试工具推荐

| 测试类型 | 常用工具 |

|---|---|

| 功能测试 | Selenium(Web 端)、Appium(移动端)、Postman(接口)、Playwright(跨端) |

| 性能测试 | JMeter、LoadRunner、Gatling、PerfDog(移动端) |

| 安全性测试 | OWASP ZAP、Burp Suite、Metasploit、Nessus |

| 易用性测试 | Hotjar、UserTesting、Figma(设计稿验证) |

| 兼容性测试 | Testin、BrowserStack、Sauce Labs |

| 回归测试自动化 | Selenium+JUnit、Appium+Python、Cypress(Web 端) |

1.3.7 新手注意事项

测试环境要贴近生产:系统测试的结果是否有效,关键在于测试环境是否模拟生产环境(硬件、软件、网络、数据量)。如果测试环境与生产环境差异过大,测试结果可能失真(如性能测试结果比生产环境好很多)。

重视非功能性需求测试:新手容易只关注功能测试,而忽略性能、安全性、易用性等非功能性需求。但实际使用中,非功能性问题(如系统卡顿、账号被盗、操作复杂)对用户体验的影响更大,甚至导致用户放弃使用。

回归测试要 "精准":回归测试不是重复执行所有用例,而是选择与变更相关的用例(如修复缺陷的功能、受影响的相关功能),避免浪费测试资源。

1.4 验收测试:软件的 "交付终审"

1.4.1 什么是验收测试?

验收测试(Acceptance Testing),是软件部署前的最后一次测试,由用户或需求方主导,验证软件是否满足验收标准,决定是否接受该软件。

核心特点:"用户视角、实际场景",测试环境通常是生产环境或模拟生产环境,测试用例基于用户的实际使用场景。

核心目标:确保软件符合用户的实际需求,具备交付条件,让用户对软件质量满意,同意接收和使用。

打个比方:就像用户在 4S 店试驾汽车,检查汽车的外观、性能、舒适性等是否符合自己的预期,决定是否购买。

1.4.2 验收测试的核心要素

| 要素 | 具体说明 |

|---|---|

| 测试阶段 | 系统测试通过后,软件部署前 |

| 测试对象 | 整个软件系统(包括软硬件、文档、培训材料等) |

| 测试人员 | 最终用户、需求方代表(主导),测试工程师提供技术支持 |

| 测试依据 | 用户需求说明书、验收标准文档、项目合同 |

| 测试方法 | 黑盒测试为主,模拟用户实际使用场景 |

| 测试内容 | 核心功能验证、用户操作流程、文档完整性(用户手册、安装指南)、培训效果等 |

1.4.3 验收测试的常见类型

用户验收测试(UAT,User Acceptance Testing):最常见的验收测试类型,由最终用户在实际使用环境中测试,验证软件是否能满足日常工作需求。比如企业采购的 OA 系统,由企业员工进行 UAT 测试,验证请假、审批、文件流转等功能是否符合工作流程。

业务验收测试(BAT,Business Acceptance Testing):由业务专家主导,验证软件是否符合业务流程和行业规范。比如金融行业的核心系统,由金融业务专家测试,验证转账、对账、风控等功能是否符合金融行业的业务规则。

合规验收测试(Compliance Acceptance Testing):验证软件是否符合相关的法律法规和行业标准。比如医疗软件需要符合《医疗器械软件注册审查指导原则》,电商软件需要符合《电子商务法》《个人信息保护法》。

1.4.5 新手注意事项

提前明确验收标准:验收测试前,需与用户或需求方共同制定清晰的验收标准(如功能覆盖率、响应时间、无严重缺陷等),避免测试后因 "标准不一致" 产生纠纷。

提供完善的支持材料:验收测试时,需向用户提供用户手册、安装指南、常见问题解答(FAQ)等材料,帮助用户快速上手测试,提高验收效率。

及时响应验收过程中的问题:用户在验收测试中发现的问题,需及时协调开发修复,确保问题在部署前解决,避免影响交付进度。

1.5 四大测试阶段的核心对比

| 对比维度 | 单元测试 | 集成测试 | 系统测试 | 验收测试 |

|---|---|---|---|---|

| 测试对象 | 最小组成单元(函数、类、方法) | 模块间的接口 | 整个软件系统(软硬件一体) | 整个软件系统(含文档、培训材料) |

| 测试人员 | 开发工程师、白盒测试工程师 | 白盒测试工程师、开发工程师 | 黑盒测试工程师、专项测试工程师 | 用户、需求方代表(主导) |

| 测试依据 | 代码注释、详细设计文档 | 概要设计文档、接口规格说明书 | 需求规格说明书、行业标准 | 用户需求说明书、验收标准、项目合同 |

| 测试方法 | 白盒测试为主 | 灰盒测试为主 | 黑盒测试 + 专项测试 | 黑盒测试(模拟实际使用场景) |

| 核心目标 | 验证单个单元的逻辑正确性 | 验证模块间的接口兼容性 | 验证系统满足所有需求(功能 + 非功能) | 验证系统符合用户预期,具备交付条件 |

| 测试成本 | 低(早期发现问题,修复成本低) | 中 | 高(覆盖全面,测试周期长) | 中(用户主导,测试范围聚焦核心场景) |

总结:四大测试阶段层层递进,从 "最小单元" 到 "整个系统",从 "开发视角" 到 "用户视角",形成了软件测试的全流程保障体系。在实际项目中,大家需根据项目规模和复杂度,合理分配各阶段的测试资源,确保软件质量。

二、按是否手工测试分类:手工测试 vs 自动化测试,效率与灵活的平衡

按是否手工测试分类,核心是 "测试执行的主体是人工还是机器"------ 手工测试靠人执行用例,灵活但效率低;自动化测试靠机器执行脚本,高效但缺乏灵活性。两者不是替代关系,而是互补关系,需根据测试场景合理选择。

2.1 手工测试:测试的 "基础防线"

2.1.1 什么是手工测试?

手工测试(Manual Testing),是指测试人员按照测试用例,手动操作软件,输入测试数据,观察输出结果,对比预期结果是否一致的测试方式。

核心特点:"人工主导、灵活应变",测试人员可以根据实际情况调整测试步骤,发现非预期的问题(如界面卡顿、提示不友好)。

核心目标:验证软件功能的正确性和用户体验的合理性,尤其适合需要主观判断、场景多变的测试场景。

打个比方:就像老师手工批改作业,逐题检查学生的答案,不仅能判断对错,还能发现学生的解题思路问题、书写规范问题等。

2.1.2 手工测试的核心适用场景

功能探索性测试:无明确测试用例,测试人员自由探索软件功能,发现潜在问题(如易用性问题、隐藏的功能缺陷)。

用户体验测试:需要主观判断的场景(如界面美观度、操作流程顺畅度、提示信息清晰度),机器无法替代人工的主观感受。

短期项目或需求频繁变更的项目:自动化测试脚本的编写和维护成本高,手工测试更灵活、成本更低。

功能不稳定的早期版本:软件早期版本功能频繁变更、缺陷较多,手工测试可以快速适应变化,无需频繁修改脚本。

特殊场景测试:如硬件设备交互测试(手机摄像头、打印机连接)、异常场景测试(网络中断、断电恢复),手工测试更易模拟。

2.1.3 手工测试的优缺点

| 优点 | 缺点 |

|---|---|

| 对测试人员技术要求低,易上手 | 效率低,重复性工作繁琐(如回归测试) |

| 灵活应变,能发现非预期问题 | 易受人为因素影响(如疲劳、疏忽导致漏测) |

| 适合探索性测试、用户体验测试 | 测试结果难以量化(如 "操作顺畅" 无统一标准) |

| 测试成本低(无需编写脚本、购买工具) | 大规模并发、长时间运行等场景难以模拟 |

2.1.4 新手注意事项

测试用例要清晰、可执行:手工测试依赖测试用例,用例需明确测试步骤、输入数据、预期结果,避免因用例模糊导致测试结果不一致。

注重细节观察:手工测试时,不仅要验证功能是否正确,还要关注界面显示、提示信息、响应速度等细节,发现非功能性问题。

记录测试过程和结果:测试过程中发现的问题,需详细记录(如操作步骤、截图、日志),方便开发定位和修复。

2.2 自动化测试:测试的 "效率利器"

2.2.1 什么是自动化测试?

自动化测试(Automation Testing),是指通过编写测试脚本或使用自动化工具,让机器在预设条件下自动执行测试用例,对比实际输出结果与预期结果,生成测试报告的测试方式。

核心特点:"机器主导、高效重复",一旦脚本编写完成,可反复执行,不受人为因素影响,适合重复性高、规则明确的测试场景。

核心目标:提高测试效率,降低测试成本,尤其适合回归测试、性能测试、大规模并发测试等场景。

打个比方:就像用机器批改选择题试卷,机器可以快速批改大量试卷,准确判断对错,大幅提高批改效率,但无法批改主观题。

2.2.2 自动化测试的核心分类

按测试对象和目标,自动化测试可分为以下常见类型:

功能自动化测试:自动验证软件功能是否正确,如接口自动化测试(Postman、RestAssured)、UI 自动化测试(Selenium、Appium)。

性能自动化测试:自动模拟不同负载,测试系统的性能指标,如 JMeter、LoadRunner。

安全自动化测试:自动扫描软件的安全漏洞,如 OWASP ZAP、Burp Suite 的自动化扫描功能。

兼容性自动化测试:自动在不同环境下执行测试用例,验证兼容性,如 BrowserStack、Testin。

其中,接口自动化测试的投入产出比(ROI)最高------ 接口变化频率低、脚本维护成本低、执行速度快;而 UI 自动化测试受界面变化影响大,脚本维护成本高,ROI 相对较低。

2.2.3 自动化测试的核心适用场景

回归测试:软件变更后,重复执行原有测试用例,验证变更未引入新问题,自动化测试可大幅节省时间。

性能测试:模拟大规模并发、长时间运行等场景,手工测试无法完成,自动化工具(如 JMeter)可精准模拟。

大规模测试:需要执行大量测试用例(如几百条、几千条),手工测试效率低,自动化测试可快速完成。

夜间测试:长时间运行的测试(如耐久性测试),可在夜间自动执行,不影响白天工作,次日查看结果。

规则明确的测试:测试步骤固定、输入输出明确的场景(如接口参数校验、登录功能),适合自动化执行。

2.2.4 自动化测试的优缺点

| 优点 | 缺点 |

|---|---|

| 效率高,可反复执行(回归测试优势明显) | 对测试人员技术要求高(需掌握编程、脚本编写) |

| 测试结果客观、可量化,无人工误差 | 脚本编写和维护成本高(界面变更需修改脚本) |

| 适合大规模并发、长时间运行测试 | 缺乏灵活性,无法发现非预期问题(如易用性问题) |

| 可夜间自动执行,节省人力成本 | 不适用于探索性测试、用户体验测试 |

2.2.5 自动化测试工具推荐

| 测试类型 | 常用工具 | 适用场景 |

|---|---|---|

| 接口自动化 | Postman、RestAssured(Java)、Pytest+Requests(Python)、SoapUI | 接口功能验证、回归测试 |

| UI 自动化 | Selenium(Web 端)、Appium(移动端)、Playwright(跨端)、Cypress(Web 端) | Web / 移动端功能验证、回归测试 |

| 性能自动化 | JMeter、LoadRunner、Gatling、Locust(Python) | 并发测试、响应时间测试、耐久性测试 |

| 安全自动化 | OWASP ZAP、Burp Suite、Nessus、Snyk(依赖组件漏洞扫描) | 安全漏洞扫描、合规检查 |

| 兼容性自动化 | BrowserStack、Testin、Sauce Labs | 跨浏览器、跨设备兼容性测试 |

| 自动化框架 | JUnit(Java)、pytest(Python)、TestNG(Java) | 组织测试用例、生成测试报告 |

2.2.6 新手注意事项

不要盲目追求 "全自动化":自动化测试不是万能的,需根据场景选择 ------ 探索性测试、用户体验测试适合手工测试,回归测试、性能测试适合自动化测试。

优先选择 "高 ROI" 的场景:新手入门自动化测试,应从接口自动化开始(ROI 高),再逐步学习 UI 自动化,避免一开始就挑战复杂场景。

重视脚本的可维护性:编写自动化脚本时,需遵循模块化、数据驱动的原则(如将测试数据放在配置文件中),方便后续维护和扩展。

自动化测试不能替代手工测试:自动化测试只能验证预期的问题,无法发现非预期的问题(如界面卡顿、提示不友好),必须与手工测试结合。

2.3 手工测试与自动化测试的协同策略

实际项目中,手工测试与自动化测试不是对立的,而是协同工作,合理分配可最大化测试效率和质量:

测试阶段协同:

- 需求初期(功能不稳定):以手工测试为主,进行探索性测试、功能验证。

- 需求稳定后(版本迭代):将核心功能、回归测试用例自动化,手工测试聚焦新功能、用户体验。

测试类型协同:

- 功能测试:核心流程自动化,边缘场景、探索性测试手工执行。

- 性能测试:自动化工具模拟负载,手工验证性能瓶颈的用户体验。

- 安全性测试:自动化工具扫描漏洞,手工进行渗透测试(复杂漏洞验证)。

资源分配协同:

- 人力有限时:优先自动化高频重复的测试(如回归测试),手工测试聚焦关键功能和用户体验。

- 项目周期短:以手工测试为主,自动化测试仅覆盖核心流程;项目周期长:增加自动化测试比例,降低长期测试成本。

三、按实施组织分类:谁来执行测试?------α 测试、β 测试、第三方测试

按实施组织分类,核心是 "测试的执行主体是谁"------ 不同的执行主体,测试的目的、场景、结果用途都不同。这一维度的核心价值是:通过不同角色的测试,全面验证软件质量,满足不同阶段的质量要求。

3.1 α 测试:软件的 "内部内测"

3.1.1 什么是 α 测试?

α 测试(Alpha Testing),又称内测,是由软件公司内部的用户(非开发、非测试人员) 在模拟生产环境下进行的测试。

核心特点:"内部用户、受控环境",测试环境由开发方控制,用户数量少(通常几十人),测试时间集中。

核心目标:在软件对外发布前,由内部用户发现明显的功能缺陷、易用性问题,验证软件的基本可用性(FLURPS:功能、可使用性、可靠性、性能、支持),为后续的 β 测试打下基础。

注意:α 测试不能由程序员或测试人员完成,因为他们对软件的了解过深,无法模拟普通用户的使用习惯和视角。

3.1.2 新手注意事项

选择合适的内部用户:α 测试的用户应是 "非技术人员",能模拟普通用户的使用习惯,避免选择开发、测试、产品等技术相关人员。

明确测试重点:α 测试的重点是 "基本可用性",无需测试复杂场景,只需确保核心功能正常、操作流程顺畅。

建立问题反馈渠道:为内部用户提供便捷的问题反馈渠道(如微信群、在线表单),鼓励用户及时反馈问题。

3.2 β 测试:软件的 "公开公测"

3.2.1 什么是 β 测试?

β 测试(Beta Testing),又称公测,是由软件的最终用户(外部用户) 在实际使用环境下进行的测试。

核心特点:"外部用户、非受控环境",测试环境由用户自行提供(如用户的手机、电脑、网络),用户数量多(通常几百人甚至几千人),测试时间不集中,使用场景多样。

核心目标:在真实使用场景下,发现软件的潜在问题(如兼容性问题、特殊网络环境下的缺陷),收集用户的使用反馈和建议,优化软件的用户体验和稳定性,为正式发布做准备。

常见形式:通过发放邀请码、公开招募测试用户等方式,让用户参与测试,比如百度搜索 AI 伙伴的内测邀请、手机 APP 的 "抢先体验版"。

3.2.2 β 测试的实际案例:某短视频 APP 的 β 测试

- 测试主体:通过官方公众号、应用商店招募的 1000 名外部用户(涵盖不同年龄段、手机型号、网络环境)。

- 测试环境:用户的自有手机(iOS、Android 不同版本)、家庭 / 办公网络(WiFi、4G、5G)。

- 测试内容:所有功能(拍摄、剪辑、发布、点赞、评论、分享)的稳定性和易用性,不同环境下的兼容性,网络波动时的表现。

- 测试流程 :

- 发布 β 测试版本(应用商店抢先版),提供反馈入口(APP 内 "意见反馈" 按钮)。

- 用户自由使用,记录遇到的问题(如闪退、卡顿、视频无法发布),提交反馈和建议。

- 测试负责人定期收集反馈,筛选高频问题和严重缺陷,提交开发修复。

- 持续迭代优化,直至 β 测试结束,发布正式版本。

3.2.3 α 测试与 β 测试的核心对比

| 对比维度 | α 测试 | β 测试 |

|---|---|---|

| 测试主体 | 公司内部非技术用户 | 外部最终用户 |

| 测试环境 | 开发方控制的模拟生产环境 | 用户自行提供的实际使用环境 |

| 用户数量 | 少(几十人) | 多(几百人 - 几千人) |

| 测试时间 | 集中(几天 - 几周) | 分散(几周 - 几个月) |

| 测试目的 | 验证基本可用性,发现明显缺陷 | 验证真实场景下的稳定性,收集用户反馈 |

| 问题类型 | 功能缺陷、易用性问题 | 兼容性问题、特殊场景缺陷、用户体验建议 |

| 反馈渠道 | 内部沟通渠道(如微信群、邮件) | APP 内反馈入口、官方论坛、客服渠道 |

3.2.4 新手注意事项

筛选多样化的测试用户:β 测试的用户应覆盖不同年龄段、设备型号、网络环境,确保测试场景的多样性,发现更多潜在问题。

明确测试规则和反馈方式:向用户说明测试的目的、范围、反馈方式(如如何提交问题、需要提供哪些信息),提高反馈的有效性。

及时响应用户反馈:用户提交的问题和建议需及时处理,向用户反馈修复进度,提升用户的参与感和满意度。

3.3 第三方测试:软件的 "中立质检"

3.3.1 什么是第三方测试?

第三方测试(Third-Party Testing),是由独立于开发方和用户方的第三方机构进行的测试,该机构具备专业的测试资质和技术能力。

核心特点:"中立、专业、权威",第三方机构与开发方、用户方无利益关系,测试结果客观公正,具有法律效力(部分场景)。

核心目标:为软件质量提供权威的评估报告,满足行业监管要求、项目验收要求或用户对质量的信任需求。

常见场景:政府项目、金融系统、医疗软件、大型企业采购项目等,通常要求第三方测试机构出具测试报告,作为项目验收的依据。

3.3.2 第三方测试的核心优势

客观性:第三方机构独立于开发方和用户方,测试结果不受利益干扰,更客观公正。

专业性:第三方机构具备专业的测试团队、工具和方法,能覆盖更全面的测试场景(如安全合规测试、性能极限测试)。

权威性:第三方机构出具的测试报告具有法律效力,可作为项目验收、行业监管的依据。

降低风险:对于用户方而言,第三方测试可降低采购风险(确保软件符合要求);对于开发方而言,第三方测试可提前发现问题,避免验收时出现纠纷。

3.3.3 新手注意事项

选择具备资质的第三方机构:第三方测试的权威性依赖机构的资质,需选择具备 CMA、CNAS(中国合格评定国家认可委员会)等资质的机构。

明确测试范围和标准:测试前,需与第三方机构、开发方、用户方共同明确测试范围、验收标准,避免测试过程中出现分歧。

配合测试实施:开发方需提供测试环境、测试数据、接口文档等支持,确保第三方测试顺利进行。

四、按测试地域分类:本地测试 vs 国际化测试,适配不同市场需求

随着软件的全球化普及,很多产品需要面向不同国家和地区的用户,按测试地域分类的核心价值是:确保软件在不同地域、不同语言、不同文化背景下的可用性和适应性。

4.1 本地测试:聚焦本土市场的 "精准适配"

4.1.1 什么是本地测试?

本地测试(Local Testing),是指针对软件的目标本土市场,进行的适配测试,确保软件符合本土用户的使用习惯、语言环境、文化背景。

核心特点:"单一地域、精准适配",测试范围聚焦本土市场的核心需求,无需考虑多语言、多文化的差异。

核心目标:确保软件在本土市场的可用性和用户体验,比如中文界面、符合中国用户习惯的操作流程、适配中国的网络环境和硬件设备。

我们之前讨论的大部分测试(如功能测试、性能测试、易用性测试)都属于本地测试,这里不再赘述,重点讲解国际化测试。

4.2 国际化测试:面向全球市场的 "全面适配"

4.2.1 什么是国际化测试?

国际化测试(Internationalization Testing,简称 I18N 测试),是指测试软件在不同国家和地区、不同语言、不同文化背景下的可用性和适应性,确保软件能快速适配全球不同市场。

核心特点:"多地域、多语言、多文化",测试范围覆盖不同的语言、时区、货币、日期格式、文化习俗等。

核心目标:确保软件具备 "全球通用" 的能力,无需大规模修改代码,即可适配不同国家和地区的需求,比如抖音的国际版 TikTok,支持多种语言、不同的内容推荐机制。

4.2.2 国际化测试的核心内容

国际化测试的核心是**"适配差异"**,主要包括以下 6 个方面:

-

语言适配测试:

- 验证软件界面、提示信息、用户手册等是否支持多语言(如中文、英文、西班牙语、阿拉伯语)。

- 验证翻译的准确性(无错别字、无歧义)、完整性(无未翻译的内容)、一致性(同一术语翻译统一)。

- 验证语言切换后的界面布局是否正常(如阿拉伯语是从右到左书写,界面是否适配)。

-

时区与日期格式适配测试:

- 验证软件是否支持不同时区(如中国时区 GMT+8、美国时区 GMT-5),时间显示是否准确(如跨时区的会议预约、日志记录)。

- 验证日期格式是否符合当地习惯(如中国 "年 - 月 - 日"、美国 "月 / 日 / 年"、欧洲 "日。月. 年")。

-

货币与数字格式适配测试:

- 验证软件是否支持不同货币单位(如人民币 CNY、美元 USD、欧元 EUR),货币符号的显示是否正确(如 $、€、¥)。

- 验证数字格式是否符合当地习惯(如千位分隔符,中国用 ","、德国用 ".")。

-

文化习俗适配测试:

- 验证软件的界面设计、图标、颜色是否符合当地的文化习俗(如红色在中国代表吉祥,在南非代表哀悼;绿色在穆斯林国家代表神圣)。

- 验证内容是否符合当地的法律法规和道德规范(如宗教内容、敏感话题的限制)。

-

硬件与网络适配测试:

- 验证软件在不同国家的硬件设备上的兼容性(如不同频段的手机、当地流行的电脑型号)。

- 验证软件在不同国家的网络环境下的表现(如不同的网络带宽、延迟、运营商)。

-

功能适配测试:

- 验证软件的功能是否符合当地的用户需求(如支付功能支持当地的支付方式,中国支持微信、支付宝,国外支持 PayPal、Credit Card)。

- 验证软件的服务是否适配当地的政策(如数据存储是否符合当地的隐私法规,如欧盟 GDPR)。

4.2.3 国际化测试工具推荐

| 工具类型 | 常用工具 | 适用场景 |

|---|---|---|

| 多语言测试工具 | SDL Trados、MemoQ、Transifex | 多语言翻译管理、翻译一致性检查 |

| 界面适配测试工具 | BrowserStack、Sauce Labs | 不同语言、不同设备的界面适配测试 |

| 本地化测试平台 | Lionbridge、TransPerfect | 专业的国际化测试服务平台 |

| 合规性测试工具 | TrustArc(GDPR 合规)、OneTrust(隐私合规) | 当地隐私法规、政策合规测试 |

4.2.4 新手注意事项

提前规划国际化架构:软件设计初期就应考虑国际化需求(如采用 Unicode 编码、将文本与代码分离),避免后期修改成本过高。

重视小语种和特殊语言的测试:如阿拉伯语(从右到左书写)、日语(多字符集)、泰语(特殊字符),这些语言的适配容易出现问题,需重点测试。

结合当地用户参与测试:国际化测试需要了解当地的文化习俗和使用习惯,最好邀请当地用户参与测试,收集真实反馈。

总结

至此,"软件测试分类" 系列三篇文章已全部完结。从测试目标到执行方式,从测试方法到测试阶段,再到执行组织和地域适配,我们全面拆解了软件测试的八大核心分类维度,形成了完整的知识框架。

希望这个系列能帮助大家告别测试分类的 "概念混淆",在面试中从容应对相关问题,在实际工作中快速选择合适的测试类型,高效开展测试工作。如果大家有任何疑问或建议,欢迎在评论区留言交流~ 祝大家在测试的道路上越走越远!