在 AI 应用爆发的今天,我们经常需要同时使用多个大模型服务------有的平台优惠力度大,有的模型在某些任务上表现更好,还有的提供商网络访问更稳定。但为每一个服务单独配置 API、管理密钥、对接客户端,无疑增加了使用门槛和运维成本。

今天要介绍的开源项目 Personal LLM API,正是为了解决这一问题而生。它是一个专为个人用户设计的轻量级 LLM 接口聚合服务,让你能够通过一个统一的入口,灵活调度和管理来自不同提供商的 AI 模型。

🎯 项目简介

Personal LLM API 基于 Python 和 FastAPI 构建,提供了与 OpenAI API 完全兼容的接口规范。与同类项目相比,它更加注重个人使用的简洁性 和极致的交互体验,尤其在与高颜值客户端(如 Cherry Studio)搭配时,能实现丝滑的"打字机"流式输出效果。

GitHub 项目地址:github.com/NLP-LOVE/pe...

核心亮点

- 🧩 多模型统一管理:支持火山云、阿里云、硅基流动、OpenRouter 等主流平台,轻松实现模型的切换与负载均衡。

- ⚡ 深度优化流式输出:针对流式响应做了特别优化,完美适配 Cherry Studio 等客户端的主题与字体设计,带来沉浸式对话体验。

- 🛠️ 低代码管理后台:基于百度 amis 框架构建的可视化管理界面,无需前端知识即可轻松配置模型、查看统计、管理对话历史。

- 🐍 全栈 Python:从后端到管理界面,技术栈统一,易于理解和二次开发。

- 🚀 开箱即用:资源占用低,部署简单,特别适合运行在个人服务器或 VPS 上。

🚀 核心功能一览

- ✅ 完整的 OpenAI API 兼容(

/v1/chat/completions和/chat/completions) - ✅ 支持 Function Calling 与 Web Search(联网搜索)

- ✅ 火山云

response接口转标准chat接口,便于客户端接入 - ✅ 多模型间自动轮询负载均衡

- ✅ 完整的使用量统计与可视化

- ✅ 支持 SQLite / MySQL 数据库

- ✅ 可配置代理访问,方便网络环境适配

🏗️ 技术架构

- 后端框架:FastAPI(高性能异步 API 服务)

- 前端管理:amis 低代码框架 + TailwindCSS

- 数据库:SQLite(默认)或 MySQL

- 部署:纯 Python 环境,依赖清晰

📦 快速部署

部署仅需几步:

- 确保 Python 版本 ≥ 3.9

- 安装依赖:

pip install -r requirements.txt - 修改

app_config.yaml配置文件(设置数据库、代理等) - 运行主程序:

python3 main_personal_llm.py - 访问后台管理界面:

http://127.0.0.1:2321/dashboard,并配置模型后即可使用/chat/completions接口

🍓 与 Cherry Studio 完美搭配

该项目特别优化了与 Cherry Studio 客户端的兼容性。你只需在 Personal LLM API 后台配置好模型密钥,然后在 Cherry Studio 中添加一个自定义 OpenAI 兼容接口,即可享受:

- 无缝的流式对话体验

- 支持深度思考(Chain of Thought)参数控制

- 统一的界面主题与字体渲染

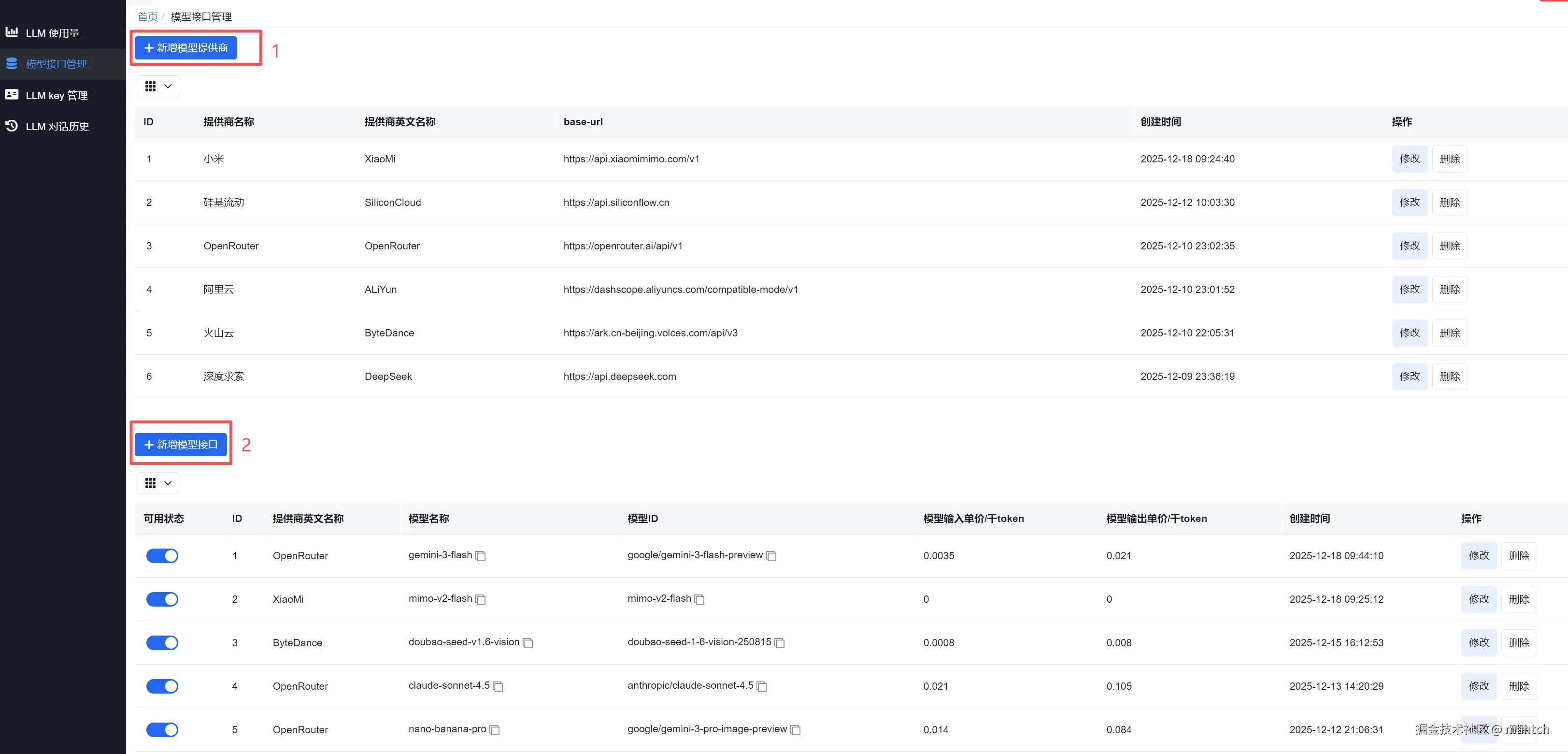

📊 后台管理演示

项目提供了完整的管理功能,包括:

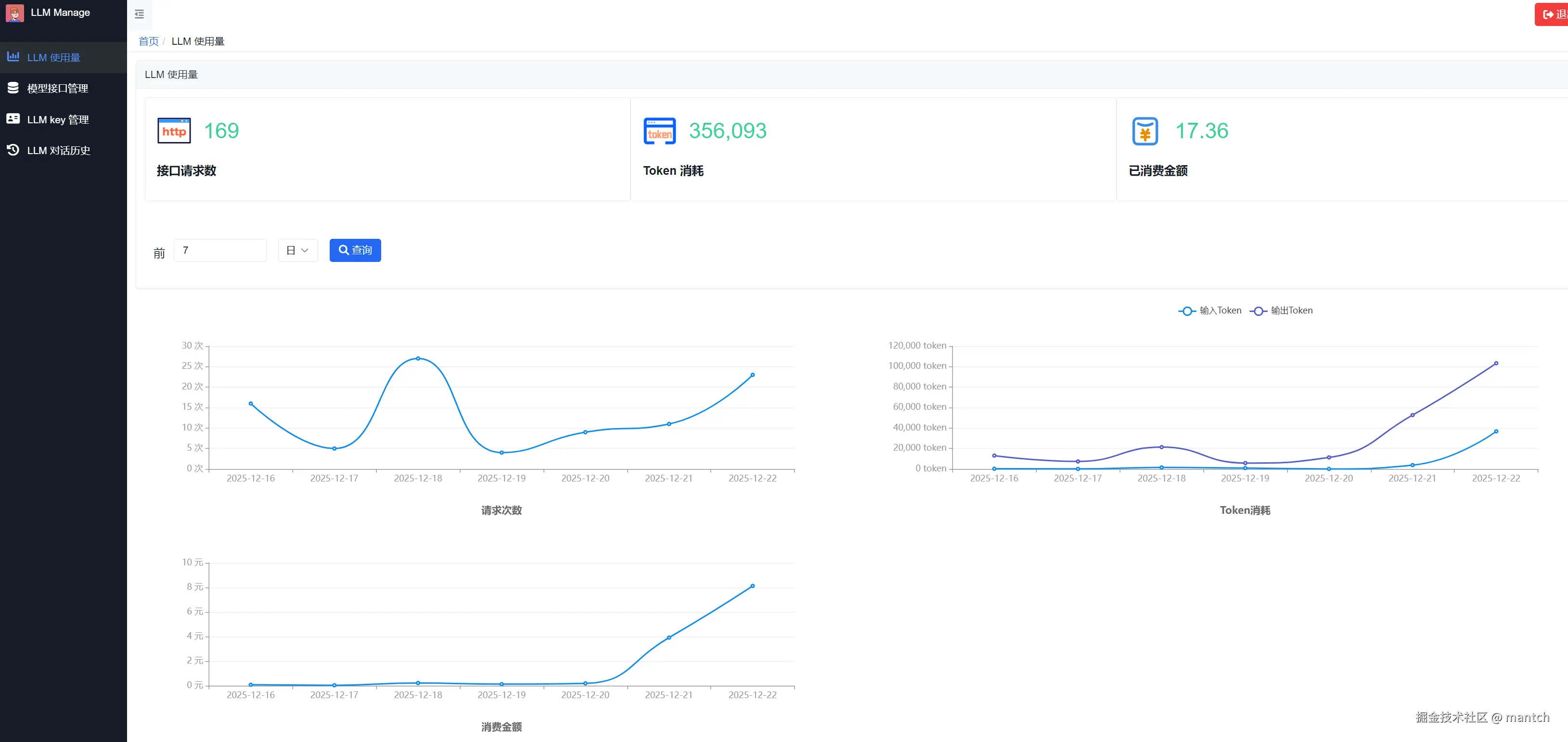

- 使用统计:直观查看各模型调用次数、Token 消耗、费用估算

- 模型与密钥管理:灵活添加、禁用、轮询多个 API Key

- 对话历史:保存和检索过往对话记录

- 系统配置:代理设置、数据库切换等

体验 Demo:🔗 llmdashboard.demo.dx3906.info/dashboard/l... (账号:test,密码:12345678)

🔮 未来规划

项目作者还计划加入更多实用功能:

- RAG(检索增强生成)应用与接口支持

- 基于 SeekDB 的 AI 原生数据库集成

- Prompt 模板管理

结语

无论你是 AI 爱好者、开发者,还是经常需要切换使用不同大模型的个人用户,Personal LLM API 都能为你提供一个干净、统一、可控的 AI 入口。它用简洁的技术栈解决了多模型管理的痛点,让每个人都能轻松拥有属于自己的智能助手调度中心。

项目地址 :github.com/NLP-LOVE/Pe...

如果你正在寻找一个轻量、易扩展、且对个人用户友好的 LLM 接口聚合方案,不妨试试这个项目,或许它能成为你 AI 工作流中那个"恰到好处"的枢纽。

微信公众号: