开篇

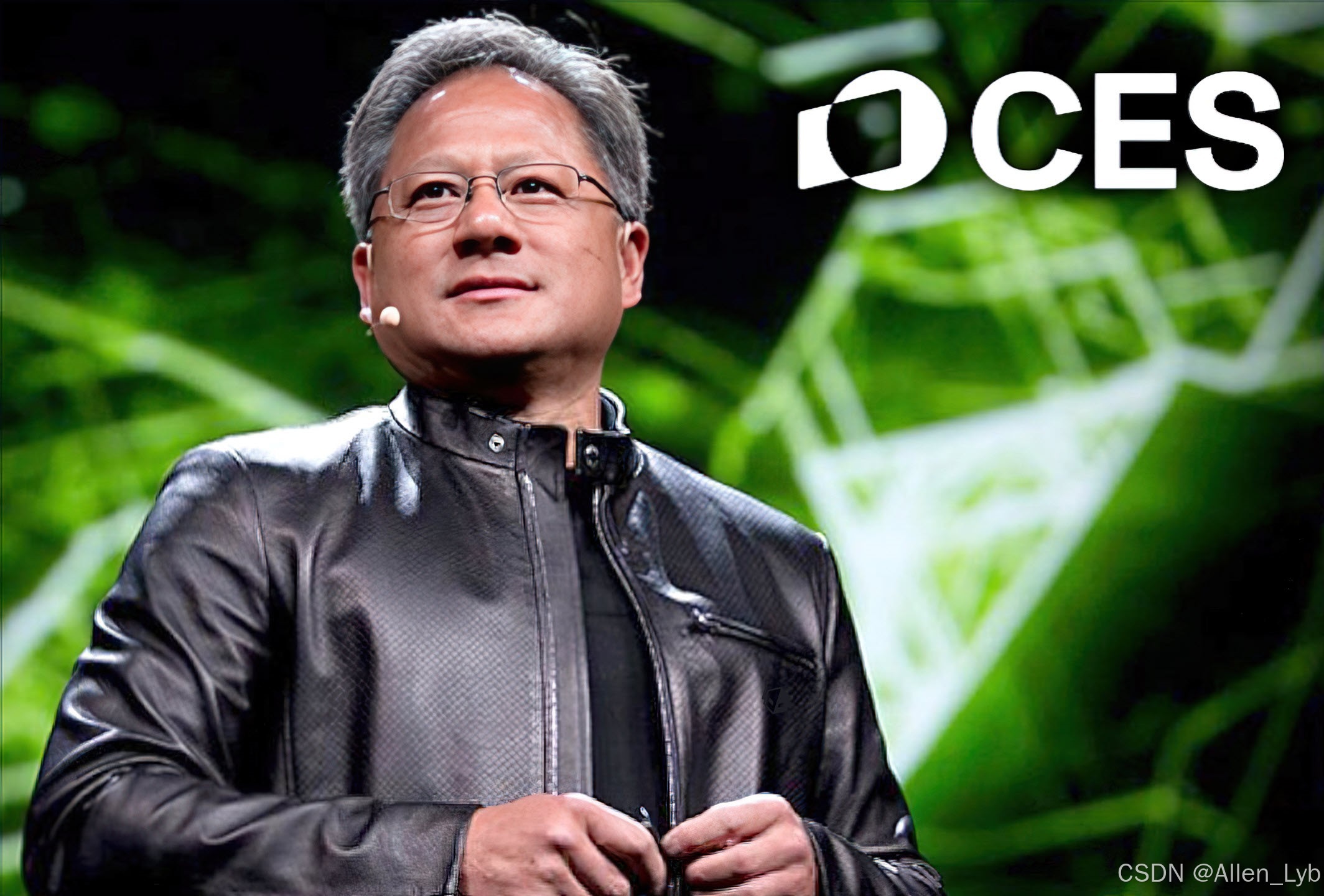

在CES 2026的主题演讲中,NVIDIA创始人兼CEO黄仁勋并未止步于展示新一代芯片的性能飞跃,而是勾勒了一幅更为宏大的产业蓝图:

计算范式正在被"加速计算+AI"彻底重构 。其核心论点是,一个价值约

10万亿美元 的传统计算产业(涵盖数据中心、边缘与车端)正在整体"现代化",迈向一个由

AI工厂 驱动的未来。演讲的主角并非单一产品,而是以"

Rubin "命名的、六芯一体的下一代AI超级计算平台,它标志着竞争维度已从单纯的硬件性能,全面升级为端到端的系统协同、成本效率与运营可靠性的比拼。与此同时,NVIDIA通过开源模型组合、物理AI平台与桌边超算等一系列动作,正将其生态从云和数据中心,深度扩展至机器人、自动驾驶乃至每个开发者的桌面,旨在定义下一个十年的AI基础设施标准。

1) 演讲主线在讲什么

A. 开场定调:AI 正在把"过去十年的计算"整体翻新

他把核心叙事定为:加速计算 + AI 让整个计算范式变了,过去约 10 万亿美元规模 的传统计算正在被现代化重构(本质是让数据中心、边缘、车端都进入"AI 工厂化")。(NVIDIA Blog)

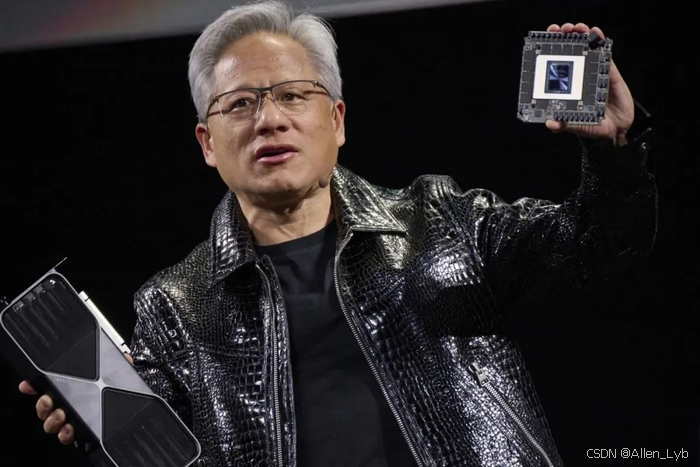

B. 第一主角:Rubin(Vera Rubin)= "极致协同设计"的六芯平台

官方定义非常明确:这不是单颗 GPU 发布,而是 6 个关键部件一起作为"一个 AI 超级计算机"发布 (Vera CPU、Rubin GPU、NVLink 6、ConnectX-9、BlueField-4、Spectrum-6)。(NVIDIA Newsroom)

战略含义 :NVIDIA 继续把竞争维度从"卖卡"推到"卖平台/系统",用端到端协同把成本曲线打下来(新闻稿直接写:推理 token 成本最多降到 Blackwell 的 1/10,训练 MoE 用卡数降到 1/4)。(NVIDIA Newsroom)

C. 第二主角:推理时代的"AI 原生存储/上下文基础设施"

他强调长上下文、多轮 agentic reasoning 会让 KV-cache(推理上下文)变成新的基础设施层,于是引出 Inference Context Memory Storage Platform ,并点名由 BlueField-4 作为关键加速/控制点。(NVIDIA Newsroom)

D. "开放模型组合拳":用 6 大领域开源模型把生态做厚

官方回顾把 open models 分成医疗、气候、通用推理、多模态/机器人、具身智能、自动驾驶等域,并强调"完全开放"来让各行业/国家都能上车。(NVIDIA Blog)

E. 物理 AI:机器人从"能动"走向"会学、会推理"

CES 当天新闻稿里,NVIDIA 把"新一代机器人/自主机器"与 Cosmos、GR00T 开放模型、Isaac Lab-Arena、OSMO 等工具链绑定(这是偏平台/软件,但确实是演讲重点方向)。(NVIDIA Newsroom)

F. 自动驾驶:DRIVE Hyperion 生态扩张 + Thor 算力锚点

官方博客明确给出:DRIVE Hyperion 的参考架构核心是 两颗 DRIVE AGX Thor SoC(Blackwell 架构) ,并给出 **>2,000 FP4 TFLOPS(约 1,000 INT8 TOPS)**这一关键数字。(NVIDIA Blog)

G. "桌边 AI 超算":DGX Spark / DGX Station 把大模型搬到桌面

官方说法很直白:DGX Spark 能在桌面跑 100B 参数级 ,DGX Station 面向 1T 参数级 ,并明确 Station 使用 GB300 Grace Blackwell Ultra superchip + 775GB coherent memory(FP4 精度) 。(NVIDIA Blog)

2) CES 2026 硬件发布/平台参数汇总

我把"演讲/官方稿里给了明确数字或明确形态"的硬件全部放进来了;不写"业内传闻参数",避免误导🙂

2.1 Rubin 平台(六芯一体)关键参数

| 组件/系统 | 官方给出的硬指标/形态 | 你该怎么理解它 |

|---|---|---|

| Rubin 平台整体 | 相对 Blackwell:推理 token 成本最多降低 10x ;训练 MoE 用 GPU 数量降低 4x ([NVIDIA Newsroom](https://nvidianews.nvidia.com/news/rubin-platform-ai-supercomputer "NVIDIA Kicks Off the Next Generation of AI With Rubin — Six New Chips, One Incredible AI Supercomputer | NVIDIA Newsroom")) |

| NVLink 6 | 每 GPU 3.6TB/s 带宽;Vera Rubin NVL72 机架 260TB/s ([NVIDIA Newsroom](https://nvidianews.nvidia.com/news/rubin-platform-ai-supercomputer "NVIDIA Kicks Off the Next Generation of AI With Rubin — Six New Chips, One Incredible AI Supercomputer | NVIDIA Newsroom")) |

| Vera CPU | 88 个 NVIDIA Olympus 自研核心 ;Armv9.2 兼容;NVLink-C2C 互联([NVIDIA Newsroom](https://nvidianews.nvidia.com/news/rubin-platform-ai-supercomputer "NVIDIA Kicks Off the Next Generation of AI With Rubin — Six New Chips, One Incredible AI Supercomputer | NVIDIA Newsroom")) |

| Rubin GPU | 50 PFLOPS NVFP4(推理) ;第三代 Transformer Engine(含硬件自适应压缩)([NVIDIA Newsroom](https://nvidianews.nvidia.com/news/rubin-platform-ai-supercomputer "NVIDIA Kicks Off the Next Generation of AI With Rubin — Six New Chips, One Incredible AI Supercomputer | NVIDIA Newsroom")) |

| Vera Rubin NVL72(机架级系统) | 72 Rubin GPU + 36 Vera CPU + NVLink 6 + ConnectX-9 + BlueField-4 一体([NVIDIA Newsroom](https://nvidianews.nvidia.com/news/rubin-platform-ai-supercomputer "NVIDIA Kicks Off the Next Generation of AI With Rubin — Six New Chips, One Incredible AI Supercomputer | NVIDIA Newsroom")) |

| Spectrum-6 / Spectrum-X Ethernet Photonics | Spectrum-6:面向 AI 以太网(提到 200G SerDes、CPO 等);Spectrum-X 光子交换:可靠性 10x、uptime 5x、更省电 5x ([NVIDIA Newsroom](https://nvidianews.nvidia.com/news/rubin-platform-ai-supercomputer "NVIDIA Kicks Off the Next Generation of AI With Rubin — Six New Chips, One Incredible AI Supercomputer | NVIDIA Newsroom")) |

| 安全/可靠性 | NVL72 被描述为首个机架级 Confidential Computing(跨 CPU/GPU/NVLink);并强调 RAS、模块化无缆托盘设计(组装/维护更快)([NVIDIA Newsroom](https://nvidianews.nvidia.com/news/rubin-platform-ai-supercomputer "NVIDIA Kicks Off the Next Generation of AI With Rubin — Six New Chips, One Incredible AI Supercomputer | NVIDIA Newsroom")) |

2.2 AI 原生存储(推理上下文基础设施)

| 项目 | 官方要点 | 关键意义 |

|---|---|---|

| Inference Context Memory Storage Platform | 用 BlueField-4 实现 KV-cache 在基础设施内的共享/复用,提升吞吐与可预测的能效扩展;并引入 ASTRA 作为系统级信任架构([NVIDIA Newsroom](https://nvidianews.nvidia.com/news/rubin-platform-ai-supercomputer "NVIDIA Kicks Off the Next Generation of AI With Rubin — Six New Chips, One Incredible AI Supercomputer | NVIDIA Newsroom")) |

2.3 自动驾驶平台(DRIVE Hyperion)

| 组件 | 官方参数 | 含义 |

|---|---|---|

| DRIVE Hyperion 核心算力 | 由 两颗 DRIVE AGX Thor SoC 组成;算力 >2,000 FP4 TFLOPS (约 1,000 INT8 TOPS ),用于 360° 传感器融合与实时推理([NVIDIA Blog](https://blogs.nvidia.com/blog/global-drive-hyperion-ecosystem-full-autonomy/ "NVIDIA Expands Global DRIVE Hyperion Ecosystem to Accelerate the Road to Full Autonomy | NVIDIA Blog")) |

2.4 桌边 AI 超算(DGX Spark / DGX Station)

| 产品 | 官方能力/参数 | 更像是在卖什么 |

|---|---|---|

| DGX Spark | 桌面系统可跑 100B 参数 级模型([NVIDIA Blog](https://blogs.nvidia.com/blog/dgx-spark-and-station-open-source-frontier-models/ "NVIDIA DGX Spark and DGX Station Power the Latest Open-Source and Frontier Models From the Desktop | NVIDIA Blog")) |

| DGX Station | GB300 Grace Blackwell Ultra superchip ;775GB coherent memory(FP4) ;可跑 1T 参数 级模型([NVIDIA Blog](https://blogs.nvidia.com/blog/dgx-spark-and-station-open-source-frontier-models/ "NVIDIA DGX Spark and DGX Station Power the Latest Open-Source and Frontier Models From the Desktop | NVIDIA Blog")) |

3) 我对这场 CES 2026 的深层解读

-

NVIDIA 把"下一代"定义成:系统协同 + 运维可用性 + 成本曲线

新闻稿给的最醒目指标不是"快多少",而是 token 成本 1/10、MoE 用卡 1/4、网络省电/uptime 。这说明它在抢的是"AI 工厂的单位产出成本",而不仅是 benchmark。(NVIDIA Newsroom)

-

推理(inference)正式被抬到与训练同等甚至更核心的位置

"上下文存储平台 + BlueField-4 + KV-cache 复用"这一套,是在回答 agentic AI 的真实痛点:上下文越来越长、会话越来越多、复用越来越重要。(NVIDIA Newsroom)

-

车端与机器人被统一进"Physical AI"叙事

自动驾驶给出 Thor 的机架级数字,机器人给出 Cosmos/GR00T/Isaac/OSMO 工具链,核心是:把"感知→决策→行动"当成同一类 AI 工作负载去平台化。(NVIDIA Blog)

-

桌边 DGX 的目的不是取代云,而是"把开发闭环缩短"

DGX Station 用 775GB coherent memory 把巨模型开发/验证挪到本地,减少排队、减少数据外流、加速迭代;再无缝扩到云。(NVIDIA Blog)

总结

综观NVIDIA在CES 2026的全面布局,其战略意图已清晰无比:它正从一家顶尖的芯片与硬件公司,加速演进为下一代AI计算范式的定义者与全栈平台生态的构建者。本次发布的核心启示在于:

- 竞争维度全面升维 :通过"Rubin"六芯平台,NVIDIA将竞争从GPU单点性能,推向以系统级协同设计 为核心的"成本曲线战争"。官方指标直指推理成本降低10倍、训练用卡数减少4倍,这意味着一场围绕AI工厂"每单位产出总拥有成本(TCO)"的终极较量已经打响。

- 基础设施重心转移 :随着AI进入Agentic(智能体)与长上下文时代,推理(Inference)正式成为与训练并驾齐驱的核心战场。为此,NVIDIA前所未有地推出了"AI原生存储/推理上下文基础设施",将KV-Cache等中间状态的管理提升至基础设施层,由BlueField-4等芯片进行加速与统筹,以解决规模化推理的吞吐与能效瓶颈。

- 生态壁垒持续加厚 :从六大领域的开源模型到机器人OSMO工具链,再到自动驾驶DRIVE Hyperion参考架构,NVIDIA正以"完全开放 "的姿态降低各行业与国家的AI准入与应用门槛。其目的不仅是提供工具,更是通过构建事实上的标准软件栈与开发范式,将整个产业生态牢牢锚定在自己的平台上。

- 计算边界无限扩展 :从数据中心机架(Vera Rubin NVL72)到开发者桌面(DGX Station),从数字世界到物理世界(Physical AI),NVIDIA致力于让任何地点、任何形态的AI工作负载 都能在其统一的计算架构上高效运行。这背后是"Grace-Blackwell-Rubin"CPU-GPU超级芯片蓝图的持续兑现,以及通过一致性内存、机密计算等技术将复杂系统简化的不懈努力。

简言之,NVIDIA此次发布的不仅是新产品,更是一套面向AI普适化时代的系统性答案。它宣告了AI竞争已进入一个以平台协同效率、生态完整度和全栈运维能力决胜负的新阶段。