环境准备

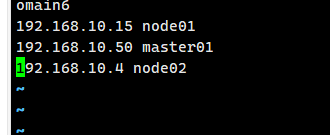

master(2C/4G,cpu核心数要求大于2):192.168.10.15

node01(2C/2G):192.168.10.50

node02(2C/2G):192.168.10.4

Docker版本:20.10.18

kubeadm版本:1.20.11

所有节点,关闭防火墙规则,关闭selinux,关闭swap交换

1. 禁用 SELinux

sed -i 's/enforcing/disabled/' /etc/selinux/config- 作用 :修改 SELinux(安全增强型 Linux)的核心配置文件,将 SELinux 的运行模式从

enforcing(强制模式,严格管控所有权限)改为disabled(禁用模式)。

2. 清空 iptables 防火墙规则

iptables -F && iptables -t nat -F && iptables -t mangle -F && iptables -X- 作用:清空所有 iptables 防火墙规则,避免默认规则干扰 K8s 等服务的网络通信。

3. 关闭交换分区(临时 + 永久)

swapoff -a # 交换分区必须要关闭

sed -ri 's/.*swap.*/#&/' /etc/fstab # 永久关闭swap分区,&符号在sed命令中代表上次匹配的结果- 第一行

swapoff -a:立即关闭系统中所有的 swap(交换分区),临时生效; - 第二行

sed -ri ...:永久禁用 swap,避免服务器重启后 swap 重新开启;-r:启用扩展正则表达式,方便匹配复杂内容;s/.*swap.*/#&/:匹配所有包含swap的行,在行首添加#注释掉(&代表匹配到的整行内容);/etc/fstab:系统开机自动挂载分区的配置文件,注释掉 swap 行就不会开机挂载。

- 为什么要关:K8s 要求关闭 swap,否则会影响 Pod 的资源调度和节点性能(K8s 默认不允许 Pod 使用 swap)。

4. 加载 ip_vs 内核模块

for i in $(ls /usr/lib/modules/$(uname -r)/kernel/net/netfilter/ipvs|grep -o "^[^.]*");do echo $i; /sbin/modinfo -F filename $i >/dev/null 2>&1 && /sbin/modprobe $i;done- 作用:自动加载所有 ip_vs 相关的内核模块(ip_vs 是 LVS 负载均衡的核心模块),为 K8s 的 kube-proxy 启用 ipvs 模式做准备(ipvs 模式性能远优于 iptables 模式)。

- 分步解释 :

$(uname -r):获取当前系统的内核版本(比如 3.10.0-1160.el7.x86_64);ls /usr/lib/modules/.../ipvs:列出 ipvs 模块的存放目录下的所有文件;grep -o "^[^.]*":只提取文件名中 "." 之前的部分(即模块名,比如ip_vs_rr);modinfo -F filename $i >/dev/null 2>&1:检查该模块是否存在,重定向输出 / 错误到空(避免无关日志);modprobe $i:加载该内核模块(只有前面检查成功才会执行)。

小结

- 禁用 SELinux:解除严格的安全管控,避免 K8s 组件权限被拦截;

- 清空 iptables 规则:消除默认防火墙对 K8s 网络的干扰;

- 禁用 swap:满足 K8s 的部署要求,保证 Pod 调度和性能;

- 加载 ip_vs 模块:为 K8s 网络代理(kube-proxy)启用高性能的 ipvs 模式。

修改主机名 master01 node01 node2 并做主机映射 vim /etc/hosts

调整内核参数

cat > /etc/sysctl.d/kubernetes.conf << EOF

net.bridge.bridge-nf-call-ip6tables=1

net.bridge.bridge-nf-call-iptables=1

net.ipv6.conf.all.disable_ipv6=1

net.ipv4.ip_forward=1

EOF

sysctl --system脚本中写入的内核参数均为 Kubernetes 运行的必要配置:让网桥设备(如 Docker / 容器网络的网桥)的流量能够被iptables规则处理。背景:Kubernetes 的网络插件(如 Flannel、Calico)依赖iptables实现 Pod 间的网络策略、地址转发,若不开启此参数,容器网络通信会异常

安装docker

docker如何安装前文已介绍这里只讲重点

yum install -y yum-utils device-mapper-persistent-data lvm2

yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

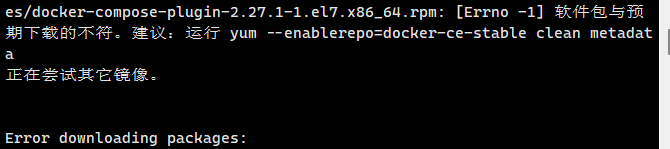

yum install -y docker-ce-20.10.18 docker-ce-cli-20.10.18 containerd.io

注意docker版本,若下错版本会有报错

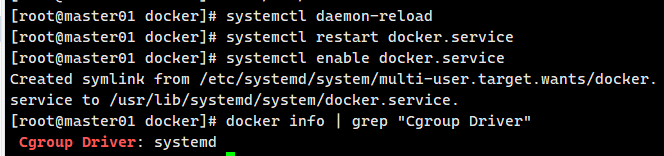

配置

mkdir /etc/docker

cat > /etc/docker/daemon.json <<EOF

{

"registry-mirrors": ["https://0a40cefd360026b40f39c00627fa6f20.mirror.swr.myhuaweicloud.com"],

"exec-opts": ["native.cgroupdriver=systemd"],

"log-driver": "json-file",

"log-opts": {

"max-size": "100m"

}

}

EOF

定义kubernetes源

cat > /etc/yum.repos.d/kubernetes.repo << EOF

[kubernetes]

name=Kubernetes

baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

EOF下载

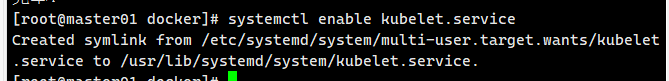

yum install -y kubelet-1.20.11 kubeadm-1.20.11 kubectl-1.20.11K8S通过kubeadm安装出来以后都是以Pod方式存在,即底层是以容器方式运行,所以kubelet必须设置开机自启

部署K8S集群

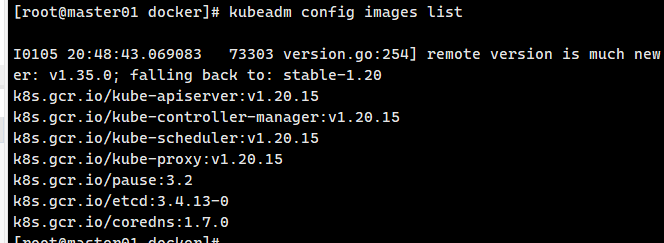

查看需要的镜像

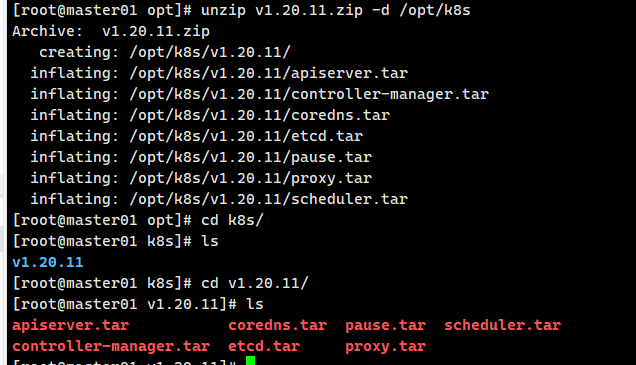

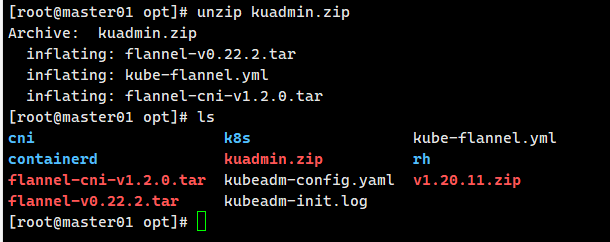

上传解压包

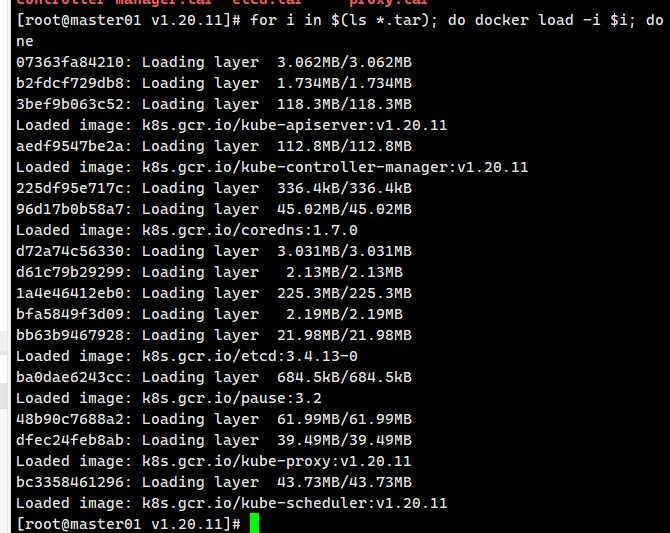

for i in (ls \*.tar); do docker load -i i; done 所有 K8s 核心组件的镜像都导入到 master 节点的 Docker 本地仓

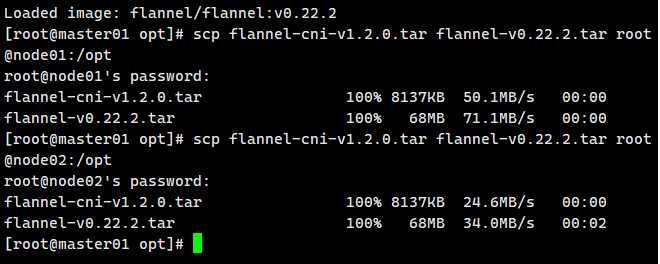

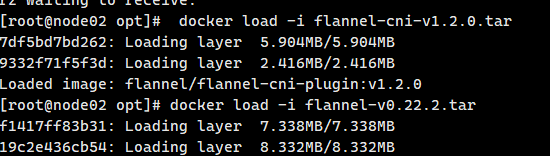

把/opt/k8s/v1.20.11目录同步到所有 node 节点 并导入镜像

# 同步到node01

scp -r /opt/k8s root@node01:/opt

# 同步到node02

scp -r /opt/k8s root@node02:/opt初始化kubeadm

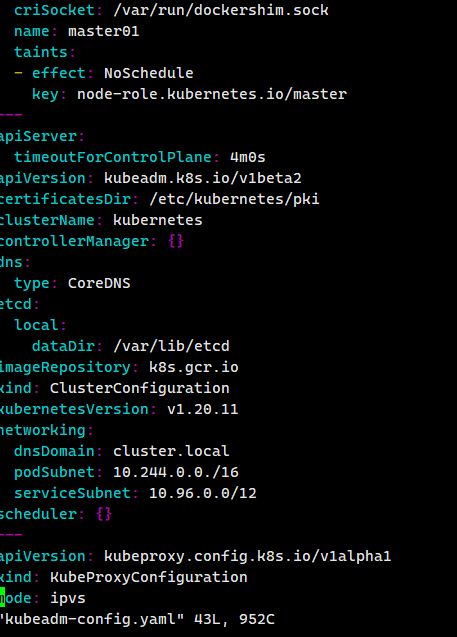

kubeadm config print init-defaults > /opt/kubeadm-config.yaml

cd /opt/

vim kubeadm-config.yaml

advertiseAddress: 192.168.10.19,kubernetesVersion: v1.20.11 ,podSubnet:"10.244.0.0/16"

末尾再添加以下内容

apiVersion: kubeproxy.config.k8s.io/v1alpha1

kind: KubeProxyConfiguration

mode: ipvs

编辑完后

kubeadm init --config=kubeadm-config.yaml --upload-certs | tee kubeadm-init.log

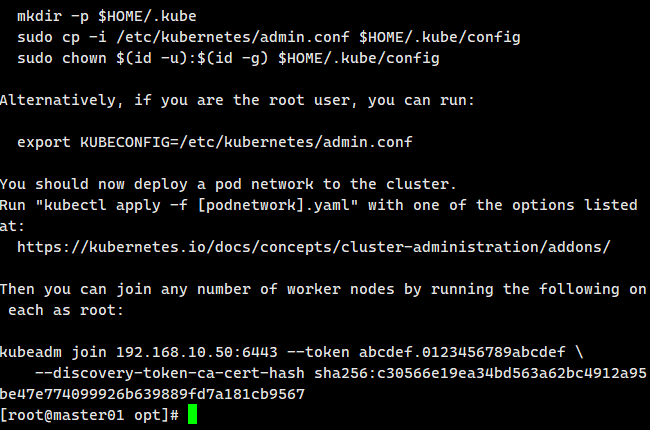

配置kubectl(K8s 命令行工具)连接集群的核心操作

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown (id -u):(id -g) $HOME/.kube/config

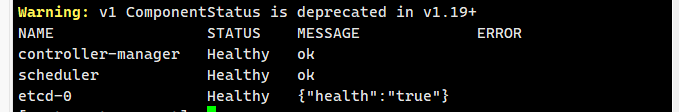

kubectl get cs 发现集群不健康,更改以下两个文件

vim /etc/kubernetes/manifests/kube-scheduler.yaml

vim /etc/kubernetes/manifests/kube-controller-manager.yaml

把--bind-address=127.0.0.1变成--bind-address=你的ip

把httpGet:字段下的hosts由127.0.0.1变成你的ip

#- --port=0 # 搜索port=0,把这一行注释掉

cd /opt/

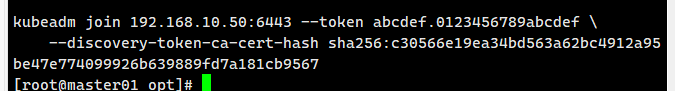

cat kubeadm-init.log 获取节点加入命令

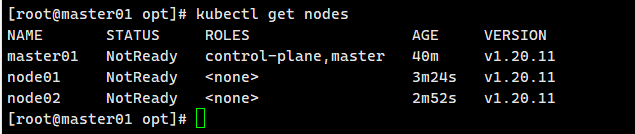

复制到node主机,完成后查看

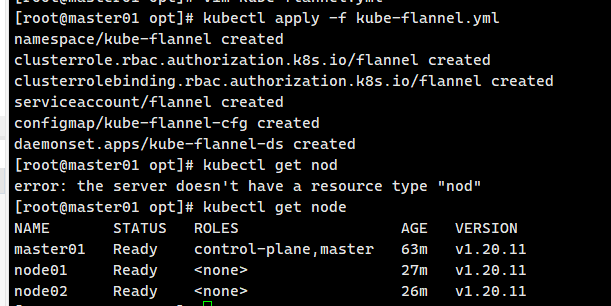

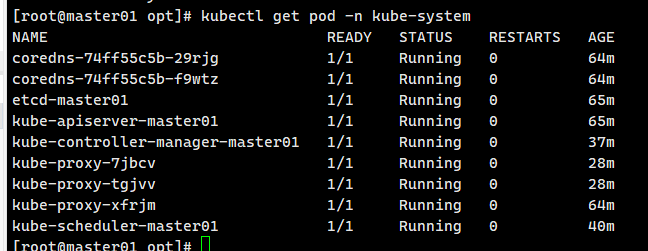

网络配置

kubectl apply -f kube-flannel.yml

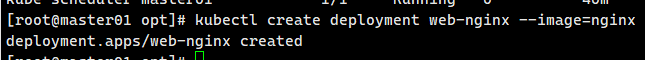

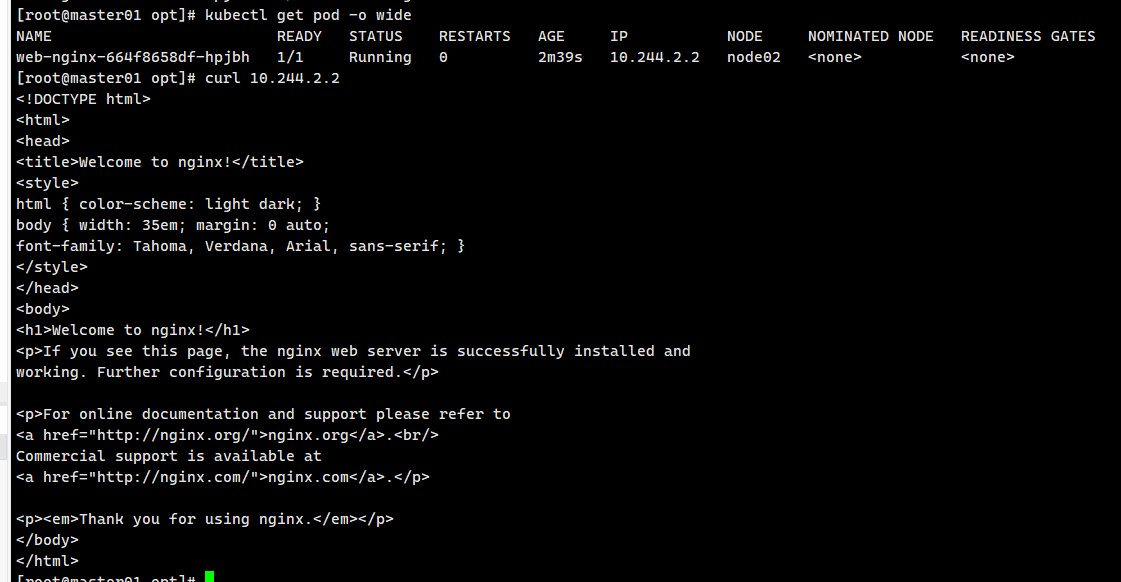

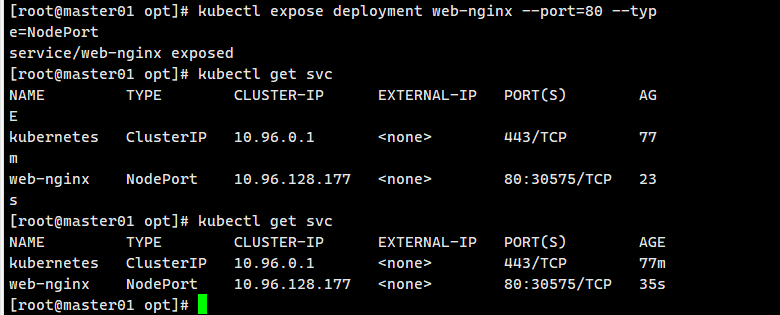

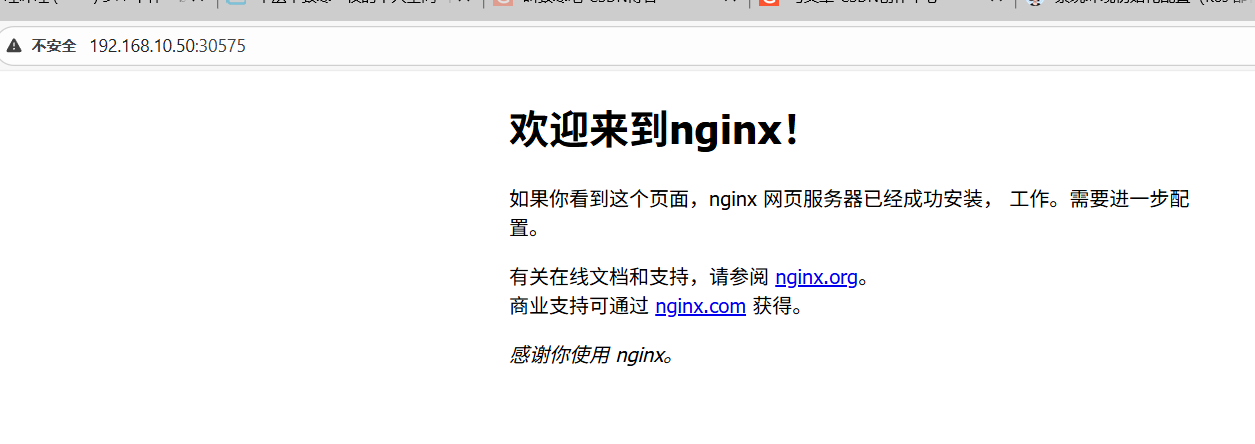

创建nginx

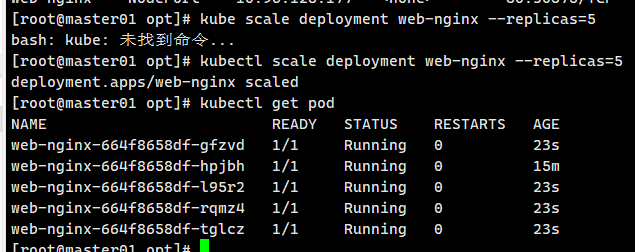

同时创建5个nginx

kubectl scale deployment web-nginx --replicas=5