卷积神经网络与应用

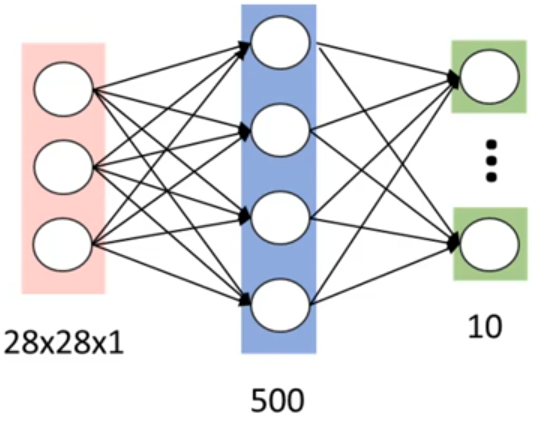

全连接网络的局限性

当图片分辨率进一步提高,如600x600的图像各层节点分别为300,200和100则参数个数为

600600 300 + 300200+200 100 ≈ 1.08亿

在图片识别过程中当图片过大时,全连接网络会导致计算速度减慢;过拟合

卷积神经网络

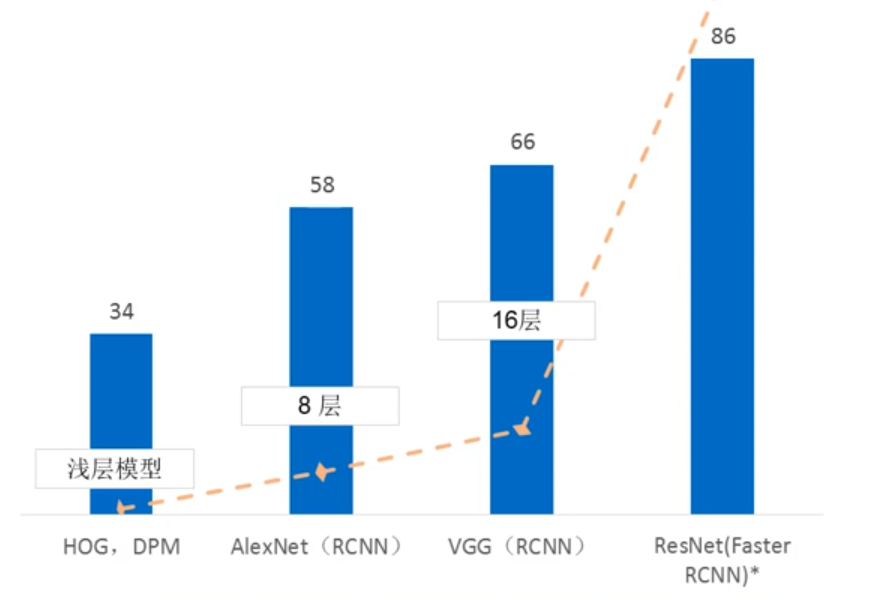

卷积神经的应用:图像分类,物体检测;看图说话;实例分割;

卷积神经网络已经成为机器视觉的一个重要工具

卷积神经网络的提出

- 1962年Hubel和Wiesel通过猫视觉皮层细胞的研究,提出了感受野的概念。视觉皮层的神经元是局部接受信息的,只受某些特定区域刺激的响应,而不是对全局图像进行感知

- 1984年日本学者Fukushima基于感受野概念提出神经认知机

- CNN可看作是神经认知机的推广形式

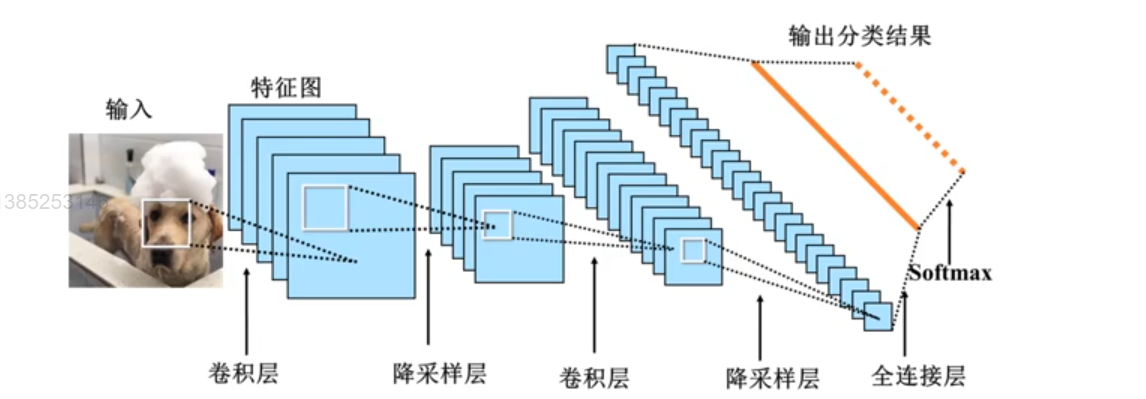

卷积神经网络结构

-

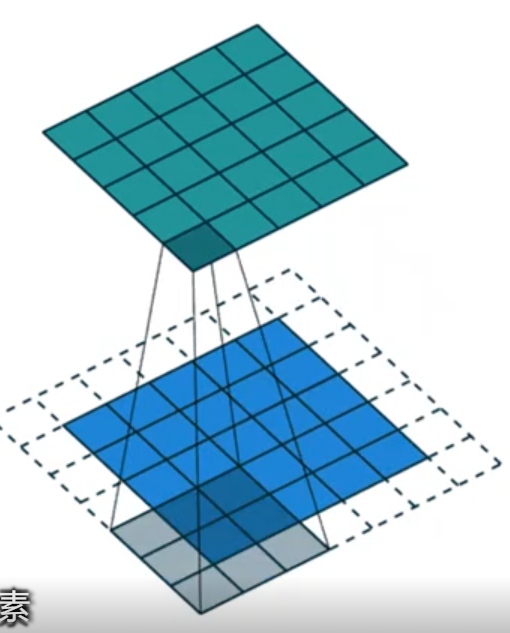

CNN是一个多层的神经网络,每层由多个二维平面组成,其中每个平面由多个独立神经元组成

-

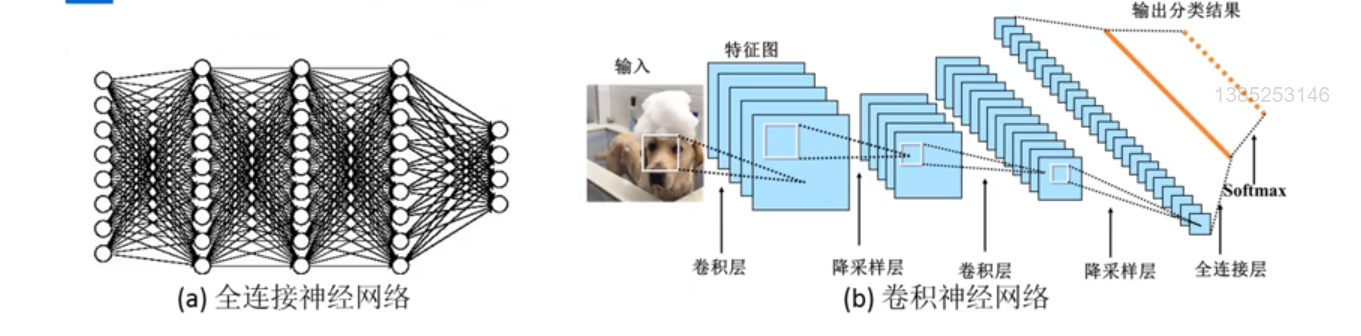

CNN结构与全连接神经网络的异同

-

输入层:将每个像素代表一种特征输入到网络中

-

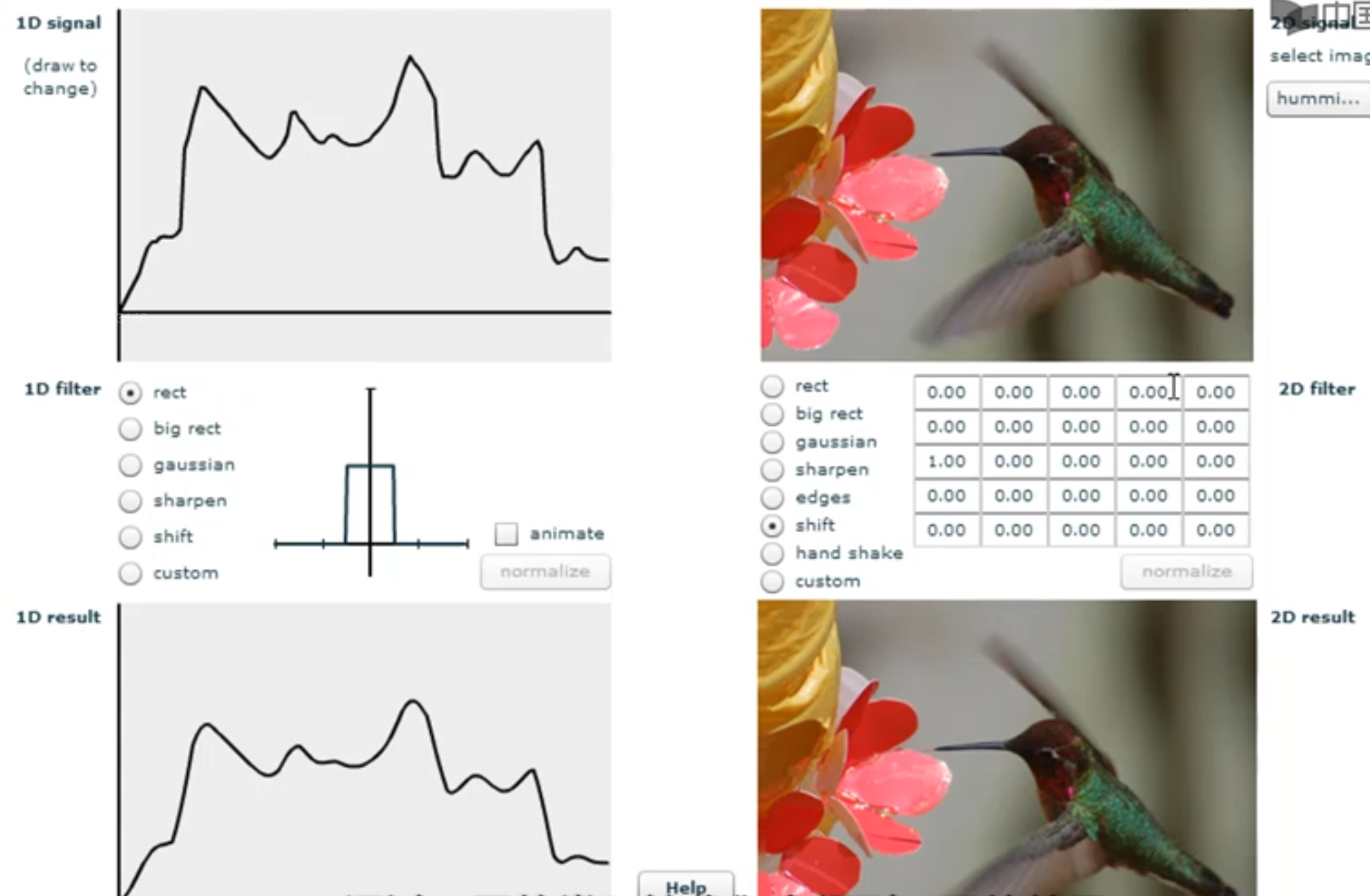

卷积层:卷积运算的主要目的是使原信号特征增强,并降低噪音

-

降采样层:降低网络训练参数及模型过拟合程度

-

全连接层:对生成的特征进行加权

-

softrmax层:获得当前样例属于不同类别的概率

卷积

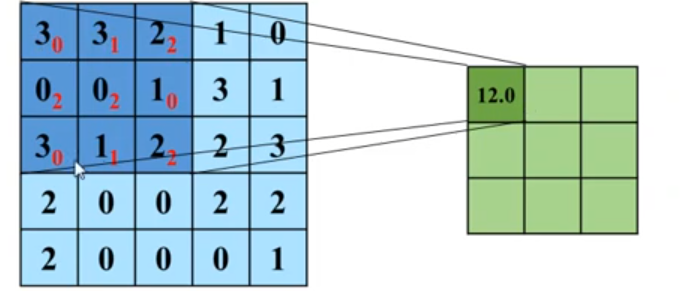

在介绍卷积网络的基本概念之前,我们先做一个矩阵运算

-

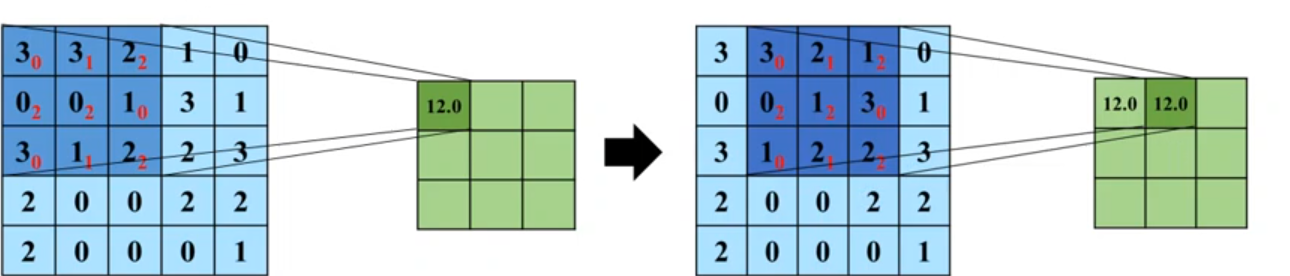

求点积:将5x5输入矩阵中3x3深蓝色的区域中每个元素分别与其对应位置的权值(红色数字)相乘,然后再相加,所得到的值作为3x3输出矩阵(绿色)的第一个元素

-

滑动窗口:将3x3权值矩阵向右移动一格(即,步长为1)

-

重复操作:同样的,将次深色区域的每个元素分别与对应的权值相乘然后再相加,所得到的值作为输出矩阵的第二个元素,重复上述操作,"求点积-滑动窗口"直到矩阵被填满。

- 卷积核在2维输入数据上"滑动",对当前输入部分的元素进行矩阵乘法,然后结果汇集为单个输出像素值,重复这个过程直到遍历整张图像,这个过程叫做卷积

- 这个权值矩阵就是卷积核

- 卷积操作后的图像称为特征图

- 卷积层:卷积运算的主要目的是原信号特征增强,并降低噪音

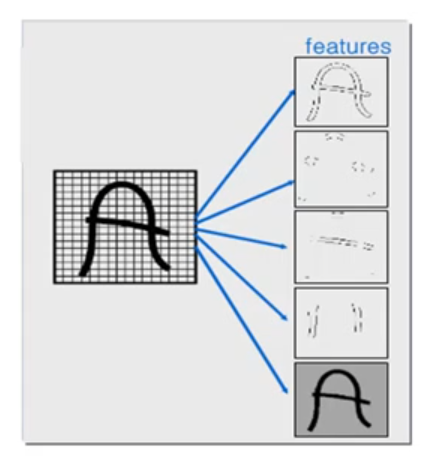

- 每个卷积层就像i骰子,将图像中符号条件的部分筛选出来

0填充

用额外的0填充到边缘,这样可以产出相同卷积层,在滑动时的卷积核可以允许原始边缘像素位于卷积中心,同时延伸到边缘之外的假像素,从而产生与输入(5x5蓝色)相同大小的输出(5x5绿色)

多通道卷积

- 每个卷积核都会将图像生成为另一副特征映射图,即一个卷积核提取一种特征

- 为了使特征提取更充分,可以添加多个卷积核以提取不同特征,也就是,多通道卷积

- 加偏置。偏置的作用是对每个feature map 加一个偏置项,以便产生最终的输出特征图

池化

-

在卷积层之后常常紧接着一个降采样层,通过减少矩阵的长和宽,从而达到减少参数的目的

-

降采样是降低特定信号的采样率的过程

-

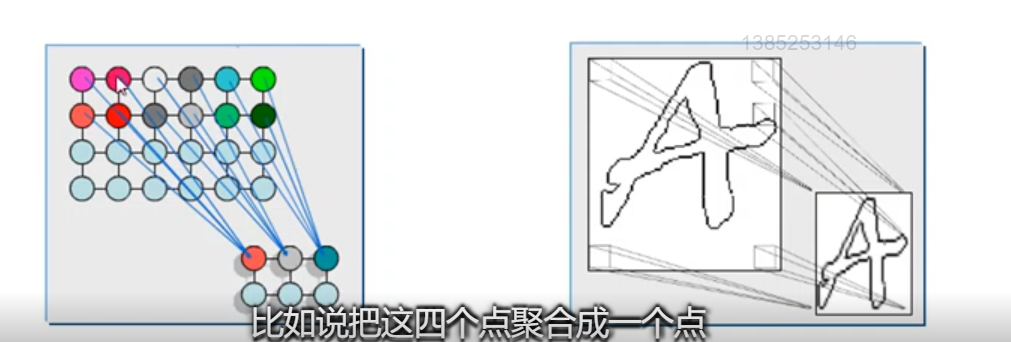

在降采样的过程中,经常用到的一种方法叫做池化,计算图像一个区域上的某个特定特征的平均值和最大值,这种聚合操作就叫做池化

-

卷积层的作用是探测上一层特征的局部连接,而池化的作用是在语义上把相似的特征合并起来,从而达到降维的目的。

这些概要统计特征不仅具有低得多的维度,同时还会改善结果(不容易过拟合)

常用的池化方法:- 均值池化:对池化区域的像素点取均值,这种方法得到的特征数据对背景信息更敏感

- 最大池化:对池化区域内所有像素点取最大值,这种方法得到的特征对纹理特征信息更加敏感

正则表达式: 输入层→(卷积层+→池化层?)+→全连接层