Netty 核心原理深度解析:EventLoop、Future/Promise 与 Pipeline

Netty 之所以在 Java 高性能网络编程领域占据统治地位,其核心秘诀在于单线程事件驱动 和异步非阻塞的架构设计。

一、EventLoop:单线程的事件循环引擎

1. 核心定义

EventLoop 是 Netty 运转的心脏。本质上,它是一个单线程的执行器。

EventLoop:单线程中,负责用 Selector 监听 IO 事件,并顺序执行对应 Channel 的 IO 与任务。任务中传递的时channel。

2. 线程组分工:Reactor 模式的落地

为了最大化并发性能,Netty 通常采用 EventLoopGroup(线程池)来管理多个 EventLoop,并采用了类似 Reactor 模式的职责分离策略:

-

BossGroup(连接接待员):

-

职责: 仅负责服务器端

ServerSocketChannel的OP_ACCEPT事件。 -

动作: 监听端口,处理客户端的新连接建立,一旦建立成功,将连接注册到 WorkerGroup。

-

-

WorkerGroup(业务服务员):

-

职责: 负责客户端

SocketChannel的读写 IO 事件(OP_READ/OP_WRITE)。 -

动作: 处理具体的数据读取、编码解码及业务逻辑触发。

-

这种监听与读写分离的设计,极大地提升了高并发场景下的吞吐量。

3. 再细粒度异步:串行化设计

在单个 EventLoop 中,Netty 将不同 Channel 的读写操作封装为异步任务。

核心机制: 即使某个 Channel 正在进行耗时的读写(例如传输大文件),它也不会阻塞整个线程导致其他 Channel 饿死。EventLoop 会通过任务队列(TaskQueue)串行执行所有 Channel 的任务。

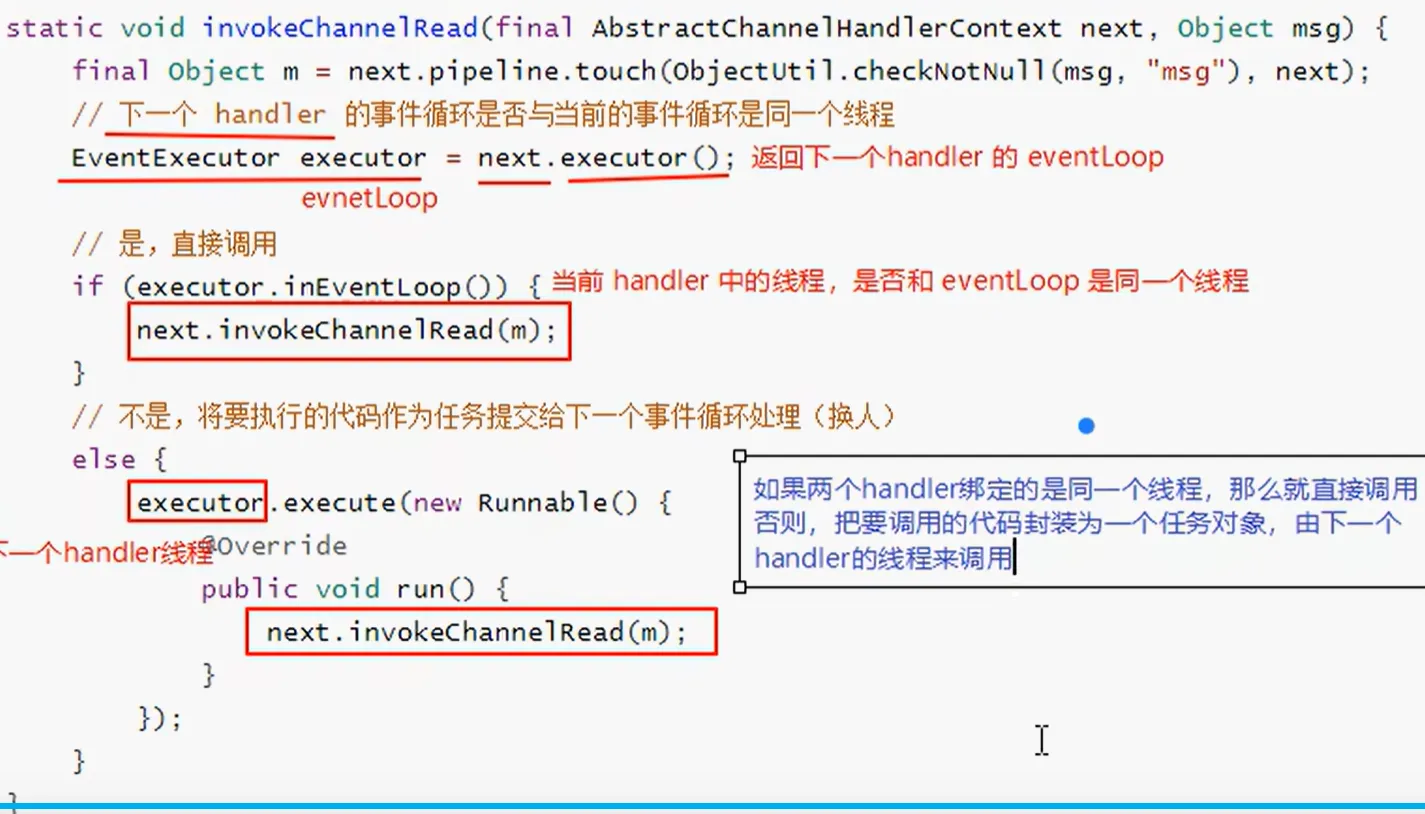

4. 跨 EventLoop 的 Handler 执行

Netty 的灵活性在于

ChannelHandler可以绑定到特定的 EventLoop。当 pipeline 传递事件时(例如invokeChannelRead),会触发以下判断逻辑:

检查: 下一个 Handler 绑定的 EventLoop 是否是当前当前正在运行的线程?

是: 直接调用该 Handler 的方法(如

channelRead)。否: 将调用逻辑封装为一个 Task,提交到目标 Handler 的 EventLoop 任务队列中等待执行。

二、异步

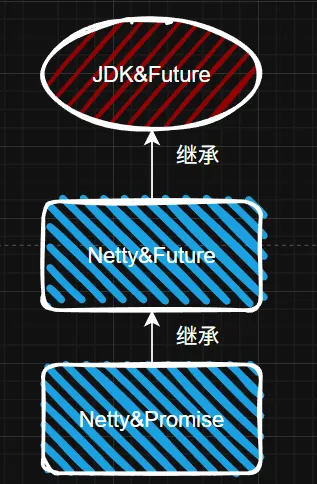

在异步编程中,如何获取执行结果至关重要。Netty 没有直接沿用 JDK 的 Future,而是对其进行了大幅增强,并引入了 Promise。

1. 功能对比:JDK Future vs Netty Future vs Promise

下表清晰展示了三者的能力差异:

| 功能特性 | JDK Future | Netty Future | Netty Promise |

|---|---|---|---|

| 基础状态 (Cancel/isDone) | ✅ | ✅ | ✅ |

| 阻塞获取 (get) | ✅ | ✅ | ✅ |

| 非阻塞获取 (getNow) | ❌ | ✅ (立即返回,未完成则 null) | ✅ |

| 阻塞等待 (await) | ❌ | ✅ (等待完成,失败不抛异常) | ✅ |

| 同步等待 (sync) | ❌ | ✅ (等待完成,失败抛异常) | ✅ |

| 结果判断 (isSuccess/cause) | ❌ | ✅ | ✅ |

| 异步回调 (addListener) | ❌ | ✅ (核心功能) | ✅ |

| 主动设置结果 (setSuccess/Failure) | ❌ | ❌ | ✅ (独有能力) |

2. 核心价值解析

-

Netty Future 的增强: 解决了 JDK Future 必须同步阻塞(

get())才能获取结果的痛点。通过addListener(),我们可以注册监听器,当任务完成时自动触发回调,实现真正的非阻塞。 -

Netty Promise 的定位: 它是可写的 Future 。它通常脱离具体的 IO 任务独立存在,作为一个"结果容器"在线程间传递。任何持有 Promise 实例的线程都可以通过

setSuccess()或setFailure()来标记任务的最终状态。

3. 实战场景:异步连接

客户端连接是典型的异步场景:

// 1. 发起连接,获得 Future

ChannelFuture future = bootstrap.connect("127.0.0.1", 8080);

// 2. 方式一:同步阻塞等待 (仅用于演示,生产环境慎用)

// future.sync();

// 3. 方式二:注册监听器,异步处理结果 (推荐)

future.addListener(f -> {

if (f.isSuccess()) {

System.out.println("✅ 连接成功,Channel:" + f.channel());

} else {

System.err.println("❌ 连接失败,原因:" + f.cause());

}

});三、Handler & Pipeline:事件处理的责任链

Netty 的逻辑处理核心是 Pipeline(流水线) ,它是由一组 Handler(处理器) 串联而成的责任链。

1. 事件传递规则

Pipeline 中的事件分为入站(Inbound)和出站(Outbound),它们的流动方向截然相反:

-

入站事件(Inbound):

-

方向: 从 Head 到 Tail(顺序执行)。

-

逻辑: 对应 Handler 的添加顺序。例如

addLast(A, B),执行顺序为 A -> B。 -

注意: 必须显式调用

super.channelRead(ctx, msg)或ctx.fireChannelRead(msg)才能将事件传给下一个 Handler。

-

-

出站事件(Outbound):

-

方向: 从 Tail 到 Head(逆序执行)。

-

逻辑: 对应 Handler 添加顺序的反向 。例如

addLast(A, B),执行顺序为 B -> A。

-

2. 关键陷阱:ctx.write() vs channel.write()

在 Handler 中写数据时,调用的对象不同,结果大相径庭:

-

ctx.write(msg): 从当前 Handler 的位置开始,向前(Tail -> Head 方向)寻找下一个 OutboundHandler。 -

channel.write(msg): 从 Pipeline 的尾部(Tail) 开始,遍历整个链条向前寻找 OutboundHandler。

最佳实践: 为了性能,通常建议使用

ctx.write(),除非你明确知道需要让数据重新经过整个 Pipeline 的处理。

3. 代码示例

Java

channel.pipeline()

// [入站] 读取数据

.addLast(new ChannelInboundHandlerAdapter() {

@Override

public void channelRead(ChannelHandlerContext ctx, Object msg) {

System.out.println("1. 读取到数据:" + msg);

// 传递给下一个入站 Handler

super.channelRead(ctx, msg);

}

})

// [出站] 编码/发送数据

.addLast(new ChannelOutboundHandlerAdapter() {

@Override

public void write(ChannelHandlerContext ctx, Object msg, ChannelPromise promise) {

System.out.println("3. 发送数据前处理");

super.write(ctx, msg, promise);

}

})

// [入站] 业务逻辑并响应

.addLast(new ChannelInboundHandlerAdapter() {

@Override

public void channelRead(ChannelHandlerContext ctx, Object msg) {

System.out.println("2. 业务处理完毕,准备响应");

// 注意:这里用 ctx.write 会从当前位置向前找 Outbound

// 因为上面有一个 OutboundHandler,所以它会被执行

ctx.write("Response Data");

}

});四、总结

Netty 的高性能并非玄学,而是源于其精密的架构设计:

-

EventLoop 通过"单线程处理多 Channel"和"任务队列"机制,在避免锁竞争的同时实现了高并发。

-

Future/Promise 体系填补了 JDK 异步编程的短板,提供了灵活的非阻塞回调和可控的结果设置能力。

-

Pipeline 利用双向链表实现了逻辑解耦,通过控制入站/出站顺序,让复杂的网络协议处理变得井然有序。