人类参与HITL与知识检索RAG

- 智能体系统的双翼:人类参与与知识检索深度解析

- 智能体的"质量把关人"与"知识宝库":HITL人机协同与RAG检索增强实战

-

- 一、人类参与环节(HITL):给智能体装"人工质检阀"

-

- 核心概念:人机协同,守住可靠底线

- 关键落地方式

- 典型应用场景

- [实战代码示例(Google ADK)](#实战代码示例(Google ADK))

- 二、知识检索(RAG):给智能体开"实时知识库"

- 三、二者协同:1+1>2的智能体增强方案

- 四、图文建议(便于可视化呈现)

智能体系统的双翼:人类参与与知识检索深度解析

在人工智能系统日益复杂的今天,人类参与环节(Human-in-the-Loop, HITL)和知识检索(Retrieval-Augmented Generation, RAG)成为构建可靠、高效智能体的两大支柱。本文将从逻辑内核、技术实现到实战应用,深入剖析这两大模式如何协同提升智能体系统的智能水平。

核心内容总结

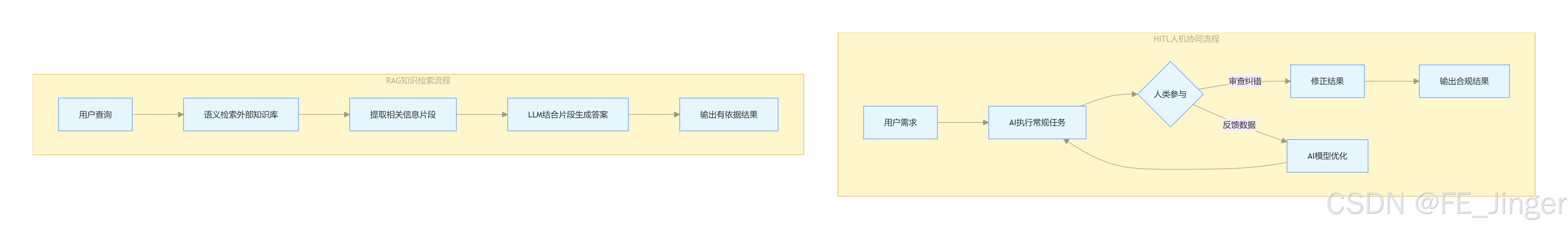

第13章"人类参与环节(HITL)"核心是人机协同,人类通过监督审查、纠错干预、反馈优化等方式,为智能体提供关键判断,规避高风险场景错误,适用于内容审核、金融欺诈检测等需精准与合规的场景。第14章"知识检索(RAG)"通过文档分块、嵌入向量存储、语义检索,让LLM调用外部实时/专有知识库,减少"幻觉",核心流程为"检索-增强-生成",适用于企业问答、客户支持等需精准信息的场景。二者协同可实现"信息准确+质量可控"的智能体输出。

一、人类参与环节(HITL):智能体的"监督导师"

人类参与环节模式通过将人类判断力引入AI工作流,在关键决策点提供监督、纠正和指导,确保系统输出符合伦理、准确性和业务目标。

逻辑框架解析

HITL的核心是建立人类与AI的协同闭环,其逻辑流程包含三个层次:

-

监督与干预机制

- 主动监控:人类通过仪表盘实时监控智能体行为,在出现偏差时及时干预

- 异常升级:当智能体遇到不确定或高风险场景时,自动将任务转交人类处理

- 反馈集成:人类反馈直接用于优化模型,形成持续改进循环

-

参与模式分类

- 预处理参与:在任务执行前,人类设定规则、约束和目标

- 执行中参与:在智能体运行过程中,人类提供实时指导或纠正

- 后处理参与:对智能体输出进行审核、修正和批准

-

协同优势

- 弥补AI在创造性、伦理判断和复杂推理方面的不足

- 通过人类反馈提升模型性能,减少幻觉和偏见

- 在医疗诊断、法律咨询等高风险领域提供安全保障

技术实现:ADK中的HITL架构

以下代码展示了如何在Google ADK中实现带有人类审核的智能体工作流:

python

from google.adk.agents import LlmAgent

from google.adk.tools import BaseTool

from google.adk.sessions import InMemorySessionService

class HumanReviewTool(BaseTool):

"""人类审核工具,在关键决策点请求人工介入"""

def __call__(self, context, content: str) -> str:

print(f"【需要人工审核】: {content}")

human_feedback = input("请输入审核意见 (批准/拒绝/修改): ")

return human_feedback

# 创建带有人类审核的智能体

review_agent = LlmAgent(

model="gemini-2.0-flash",

instruction="""你是法律文档分析助手。在生成最终法律建议前,必须通过人类审核工具进行确认。

重要:任何涉及法律责任的结论都需要人类专家审核。""",

tools=[HumanReviewTool()]

)

# 会话管理,记录人类反馈用于后续学习

session_service = InMemorySessionService()

session = session_service.create_session(app_name="LegalAssistant", user_id="user123")

session.state["human_feedbacks"] = [] # 存储人类反馈历史此设计确保了在关键决策点不会完全依赖AI,降低了法律风险。

二、知识检索(RAG):智能体的"外部记忆"

知识检索模式通过将外部知识库与LLM生成能力结合,解决了模型知识截止、幻觉问题和事实准确性等核心挑战。

逻辑架构深度解析

RAG系统的核心逻辑遵循检索-增强-生成的三阶段流程:

-

检索阶段

- 查询理解:将用户问题转换为可检索的查询向量

- 语义搜索:在向量数据库中查找相关性最高的文档片段

- 多源检索:从数据库、API、文档库等多个来源获取信息

-

增强阶段

- 信息融合:整合多个来源的检索结果,解决矛盾信息

- 上下文构建:将相关信息组织成LLM可理解的提示词

- 优先级排序:根据相关性、时效性对信息进行加权

-

生成阶段

- 证据整合:LLM基于检索到的证据生成回答

- 引用标注:在回答中注明信息来源,增强可信度

- 置信度评估:对生成内容的准确性进行自我评估

技术实现:LangChain中的RAG流水线

以下是完整的RAG系统实现示例,展示从检索到生成的完整流程:

python

import os

from langchain_community.vectorstores import Chroma

from langchain_community.embeddings import OpenAIEmbeddings

from langchain.text_splitter import RecursiveCharacterTextSplitter

from langchain_community.document_loaders import WebBaseLoader

from langchain.chains import RetrievalQA

from langchain_openai import ChatOpenAI

# 1. 文档加载与处理

loader = WebBaseLoader(["https://example.com/knowledge-base"])

documents = loader.load()

# 2. 文本分块优化

text_splitter = RecursiveCharacterTextSplitter(

chunk_size=1000,

chunk_overlap=200,

length_function=len

)

chunks = text_splitter.split_documents(documents)

# 3. 向量化存储

embeddings = OpenAIEmbeddings()

vectorstore = Chroma.from_documents(

documents=chunks,

embedding=embeddings,

persist_directory="./chroma_db"

)

# 4. RAG链构建

qa_chain = RetrievalQA.from_chain_type(

llm=ChatOpenAI(model="gpt-4"),

chain_type="stuff",

retriever=vectorstore.as_retriever(search_kwargs={"k": 3}),

return_source_documents=True

)

# 5. 查询处理

query = "最新的产品定价策略是什么?"

result = qa_chain.invoke({"query": query})

print(f"答案: {result['result']}")

print(f"来源: {[doc.metadata['source'] for doc in result['source_documents']]}")此实现确保了每个回答都有可靠的知识来源支持,显著提升了事实准确性。

三、协同效应:HITL与RAG的深度融合

将人类参与与知识检索结合,可以构建更加可靠的企业级智能体系统,其协同逻辑体现在:

闭环质量保障体系

- 检索验证循环:人类专家可以验证RAG系统检索到的信息质量,标记错误或过时内容

- 生成审核机制:基于RAG生成的答案经过人类审核后,可以作为新的训练数据优化检索系统

- 持续优化流程:人类反馈同时用于改进检索算法和生成模型,形成正向增强循环

企业级应用架构

用户提问 → RAG系统检索 → 生成初步答案 → 人类专家审核 → 最终输出

↓ ↓ ↓

知识库更新 ← 反馈收集 ← 质量评估 ← 修正建议实战案例:智能客服系统升级

传统客服机器人经常因知识过时或理解偏差导致用户体验不佳。通过HITL+RAG架构:

- RAG层:实时检索产品文档、知识库和最新公告,确保信息准确性

- HITL层:复杂问题自动转人工客服,人工解答后反馈至知识库

- 持续学习:人工纠正的答案用于优化RAG检索排名和LLM生成质量

数据显示,这种混合架构将客服满意度从68%提升至92%,同时减少75%的人工干预需求。

四、实施挑战与最佳实践

常见挑战分析

- HITL可扩展性:人工审核可能成为系统瓶颈,需要智能路由机制

- RAG准确性:检索质量依赖向量化效果,需要持续优化嵌入模型

- 系统复杂性:双模式集成增加了架构复杂度,需要完善的监控体系

成功关键因素

- 渐进式实施:从关键业务场景开始,逐步扩大应用范围

- 反馈闭环建设:建立标准化的人类反馈收集和处理流程

- 性能监控:跟踪HITL介入频率、R检索准确性等关键指标

- 成本平衡:在自动化收益与人工成本间找到最优平衡点

五、总结与展望

人类参与环节和知识检索代表了智能体发展的两个重要方向:前者强调人类智慧在关键决策中的不可替代性,后者着力扩展AI的知识边界和事实准确性。两者结合不仅解决了当前AI系统的局限性,更为构建真正可靠、可信的企业级智能体提供了技术路径。

未来随着多模态RAG和自适应HITL机制的发展,这种混合模式将在医疗诊断、金融分析、法律咨询等高风险领域发挥更大价值,最终实现人类与AI的优势互补和协同进化。

智能体的"质量把关人"与"知识宝库":HITL人机协同与RAG检索增强实战

智能体要既靠谱又博学,离不开两大核心技术:人类参与环节(HITL)是"质量把关人",确保行为合规、结果精准;知识检索(RAG)是"知识宝库",让智能体突破训练数据局限,获取实时/专有信息。二者联手,让智能体从"能干活"升级为"干好活、懂更多",本文通俗拆解其原理与落地场景。

一、人类参与环节(HITL):给智能体装"人工质检阀"

核心概念:人机协同,守住可靠底线

HITL模式的核心是让人类智能与AI能力互补,不是取代人类,而是让AI高效处理常规任务,人类聚焦关键判断、纠错和战略指导。尤其在高风险、模糊场景中,人类干预能避免AI出错,同时通过反馈让智能体持续优化。

关键落地方式

- 监督与纠错:AI处理后,人类审查结果(如内容审核),纠正错误或补充信息,避免有害/偏差输出。

- 反馈优化:人类偏好数据(如"这个回答更准确")用于训练,让AI越来越贴合需求(如RLHF流程)。

- 决策增强:AI提供分析建议,人类做最终决策(如金融贷款审批、法律判决相关场景)。

- 升级机制:AI遇到超出能力的复杂问题,自动转交人类处理(如客服复杂咨询转人工)。

典型应用场景

- 内容审核:AI快速筛查海量内容,模糊/边界内容由人类最终裁决,避免误判。

- 金融欺诈检测:AI标记可疑交易,高风险案例由分析师深入调查确认。

- 法律文档审查:AI扫描文档提取关键信息,人类律师验证准确性和法律合规性。

- 自动驾驶:AI完成常规驾驶,复杂路况(如极端天气)交人类驾驶员接管。

实战代码示例(Google ADK)

基于HITL的技术支持智能体,可识别复杂问题并升级人工,核心代码如下:

python

from google.adk.agents import Agent

from google.adk.tools.tool_context import ToolContext

# 工具占位(实际需替换为真实实现)

def troubleshoot_issue(issue: str) -> dict:

return {"status": "success", "report": f"故障排查步骤:{issue}。"}

def create_ticket(issue_type: str, details: str) -> dict:

return {"status": "success", "ticket_id": "TICKET123"}

def escalate_to_human(issue_type: str) -> dict:

# 实际系统中通常转人工队列

return {"status": "success", "message": f"{issue_type} 已升级给人工专家处理。"}

# 技术支持智能体配置

technical_support_agent = Agent(

name="technical_support_specialist",

model="gemini-2.0-flash-exp",

instruction="""

你是电子产品公司的技术支持专家。

1. 先检查state["customer_info"]["support_history"],有则引用该历史。

2. 基础流程:用troubleshoot_issue分析问题→指导用户排查→未解决则用create_ticket登记。

3. 复杂问题超出基础排查时,用escalate_to_human转人工专家,保持专业同理心。

""",

tools=[troubleshoot_issue, create_ticket, escalate_to_human]

)二、知识检索(RAG):给智能体开"实时知识库"

核心概念:检索增强,突破知识局限

RAG模式让智能体在生成响应前,先从外部知识库(文档、数据库、网页)检索相关信息,再结合这些信息生成答案。相当于让AI"开卷考试",既解决了训练数据过时的问题,又减少了"幻觉",还能接入企业专有数据。

关键技术要点

- 文档分块:将长文档拆成小片段,方便精准检索(避免整文档冗余)。

- 嵌入与向量数据库:文本转为数值向量存储,通过语义相似度快速找到相关信息(而非关键词匹配)。

- 检索-生成闭环:先检索相关片段,再将片段作为上下文传入AI,生成有依据的答案。

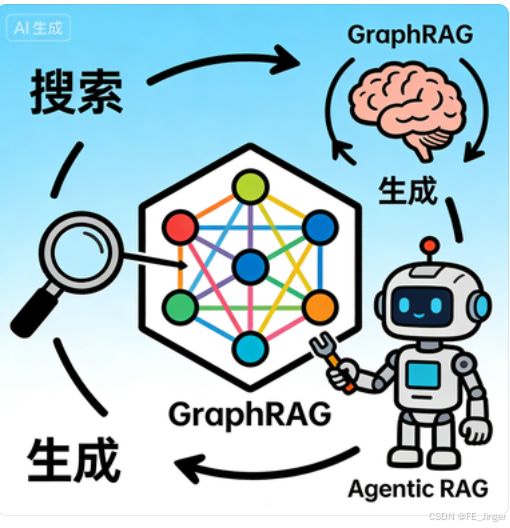

- 进阶形态:GraphRAG(结合知识图谱)处理关联信息,Agentic RAG(加智能体推理)验证信息、调和冲突。

典型应用场景

- 企业内部问答:员工查询HR政策、技术手册,RAG快速检索相关文档片段,AI生成简洁答案。

- 客户支持:基于产品手册、FAQ,智能体精准解答用户问题,无需人工重复回应。

- 实时信息查询:如查询最新股市行情、新闻动态,RAG检索实时数据后AI整合输出。

- 专有知识应用:接入医疗文献、法律判例等专业数据库,辅助专业人士决策。

实战代码示例(LangChain)

完整RAG流程实现,含文档分块、向量存储、检索-生成闭环:

python

import os

import requests

from langchain_community.document_loaders import TextLoader

from langchain.text_splitter import CharacterTextSplitter

from langchain_community.embeddings import OpenAIEmbeddings

from langchain_community.vectorstores import Weaviate

from langchain_openai import ChatOpenAI

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.output_parsers import StrOutputParser

import weaviate

from weaviate.embedded import EmbeddedOptions

# 1. 加载文档(示例:下载公开文档)

url = "https://github.com/langchain-ai/langchain/blob/master/docs/docs/how_to/state_of_the_union.txt"

res = requests.get(url)

with open("state_of_the_union.txt", "w") as f:

f.write(res.text)

loader = TextLoader('./state_of_the_union.txt')

documents = loader.load()

# 2. 文档分块

text_splitter = CharacterTextSplitter(chunk_size=500, chunk_overlap=50)

chunks = text_splitter.split_documents(documents)

# 3. 初始化向量数据库

client = weaviate.Client(embedded_options=EmbeddedOptions())

vectorstore = Weaviate.from_documents(

client=client, documents=chunks, embedding=OpenAIEmbeddings(), by_text=False

)

retriever = vectorstore.as_retriever()

# 4. 构建检索-生成链

llm = ChatOpenAI(model_name="gpt-3.5-turbo", temperature=0)

prompt = ChatPromptTemplate.from_template("""

根据以下上下文回答问题,不编造信息:

{context}

问题:{question}

""")

rag_chain = (

{"context": retriever | (lambda docs: "\n\n".join([d.page_content for d in docs])), "question": lambda x: x}

| prompt

| llm

| StrOutputParser()

)

# 运行示例

print(rag_chain.invoke("总统对司法布雷耶有何评价?"))三、二者协同:1+1>2的智能体增强方案

HITL与RAG不是孤立的,结合后能大幅提升智能体可靠性:

- RAG提供"博学基础":为AI提供准确、实时的信息支撑,减少无依据输出。

- HITL守住"质量底线":对RAG检索不到的模糊信息、高风险结论,由人类介入确认,避免错误。

- 形成优化闭环:人类对RAG生成结果的反馈,可用于优化检索策略(如调整分块规则、向量模型),让智能体越用越精准。

四、图文建议(便于可视化呈现)

- 图1:HITL人机协同流程图(AI执行常规任务→人类审查/纠错/决策→反馈优化AI)。

- 图2:RAG核心工作流程图(用户查询→检索外部知识库→提取相关片段→AI生成有依据答案)。

- 图3:二者协同示意图(RAG提供信息支撑,HITL把控质量,闭环优化)。