1. 引言

本代码库包含论文《通过可扩展查找实现条件记忆:大语言模型稀疏性的新维度》的官方实现。

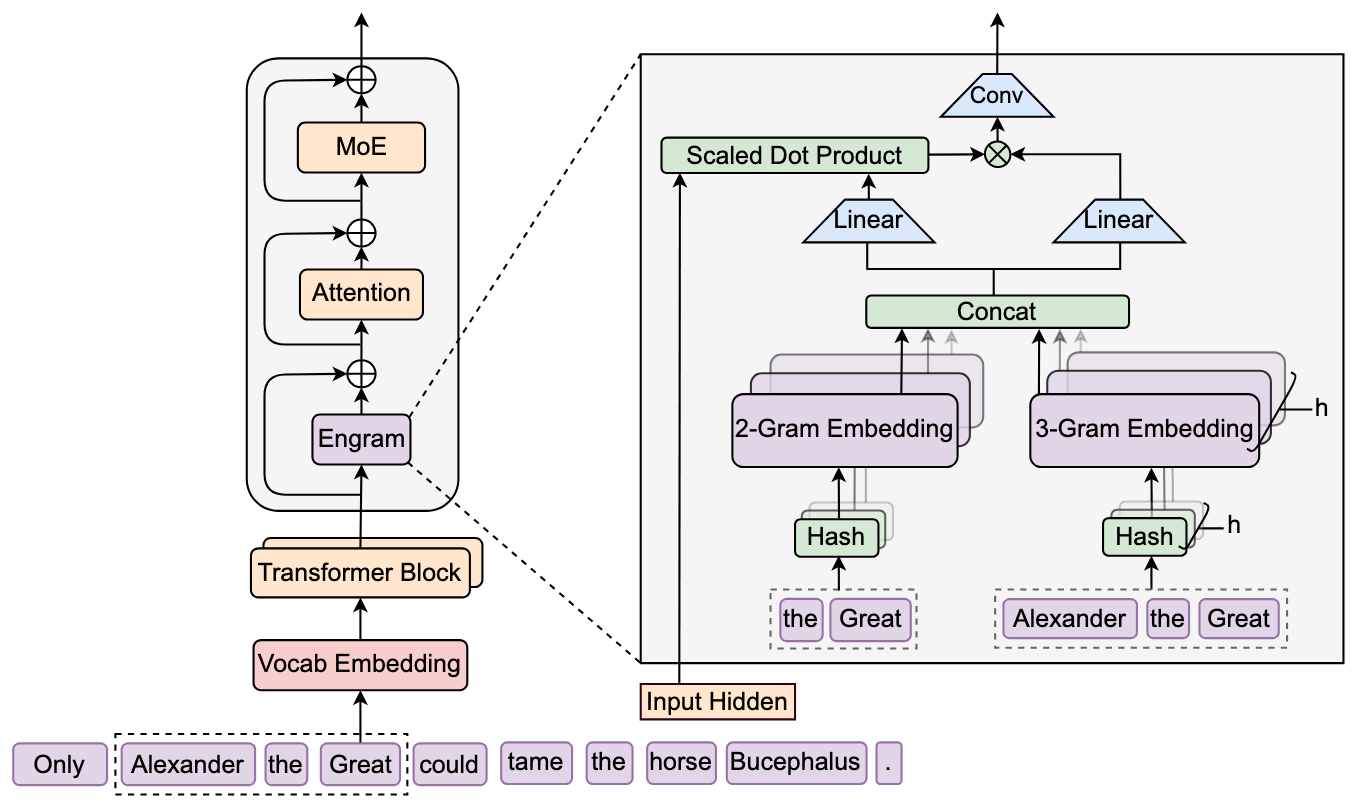

摘要: 虽然专家混合模型(MoE)通过条件计算扩展容量,但Transformer架构缺乏原生知识查找机制。为此,我们探索将条件记忆 作为补充性稀疏维度,通过Engram模块 实现------该模块将经典 N N N-gram嵌入现代化改造为支持 O ( 1 ) \mathcal{O}(1) O(1)复杂度查找。

核心贡献:

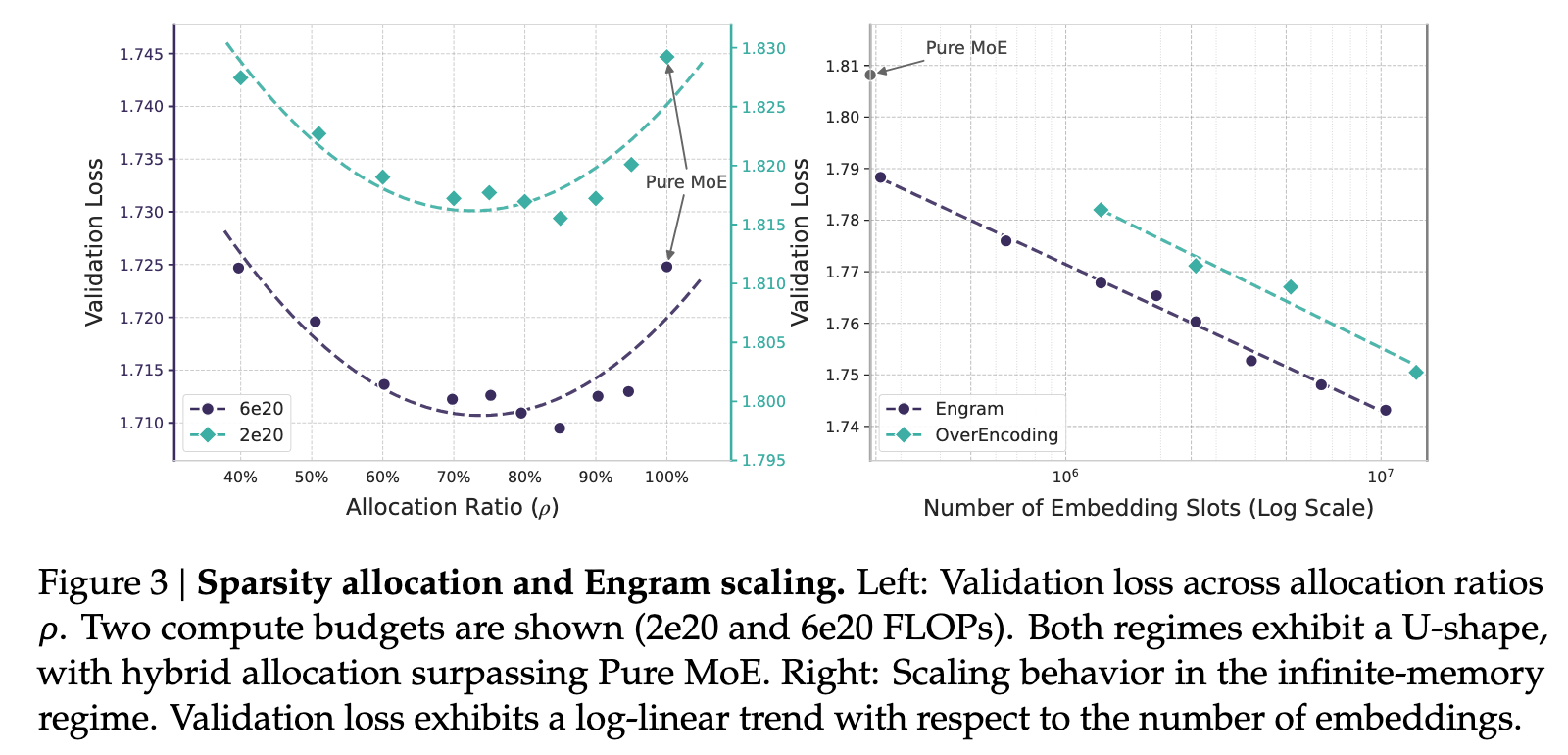

- 稀疏性分配: 提出神经计算(MoE)与静态记忆(Engram)的权衡框架,发现指导最优容量分配的U型扩展规律

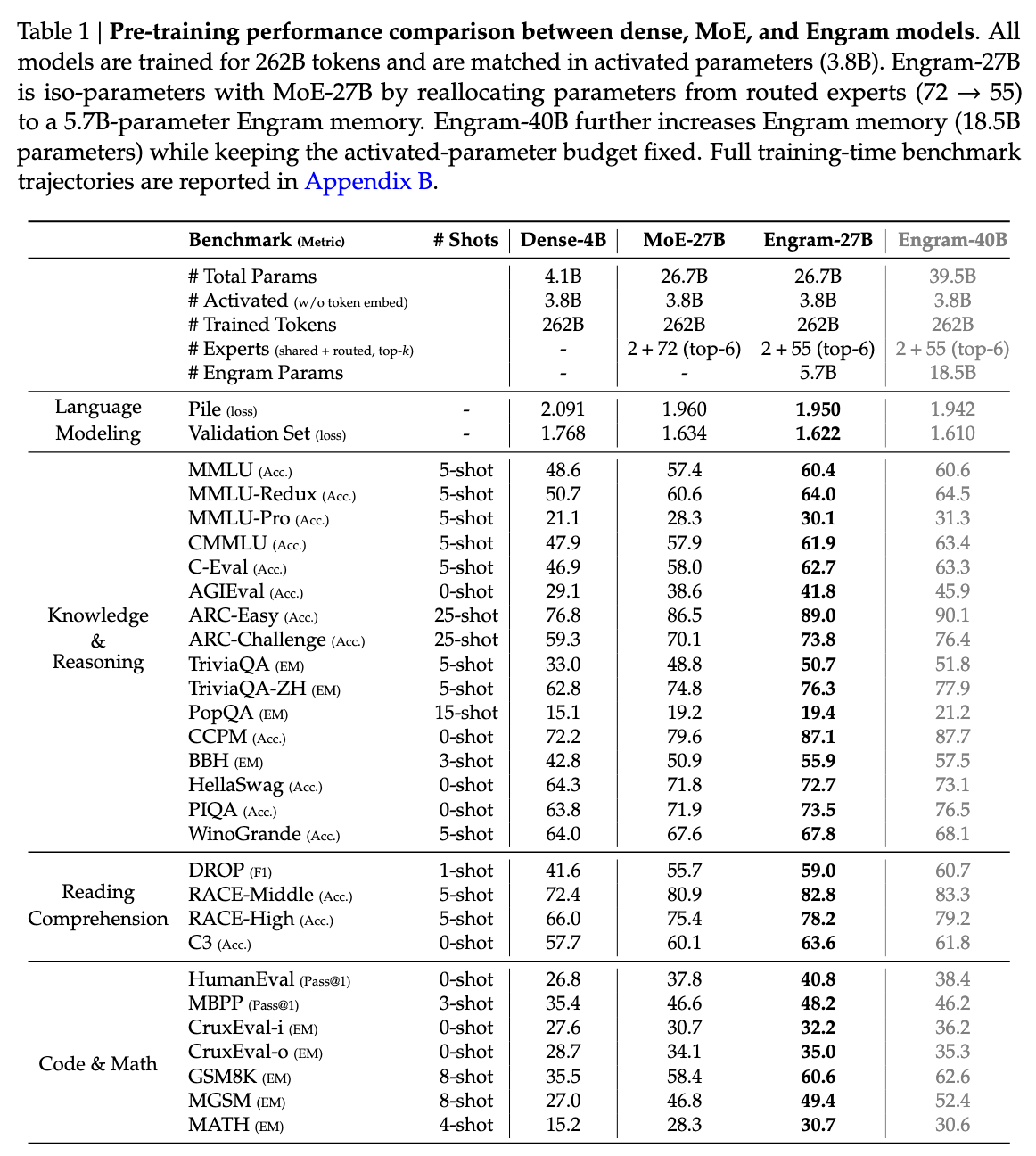

- 实证验证: 在严格等参数量与等计算量约束下,Engram-27B模型在知识、推理、代码和数学领域持续超越MoE基线

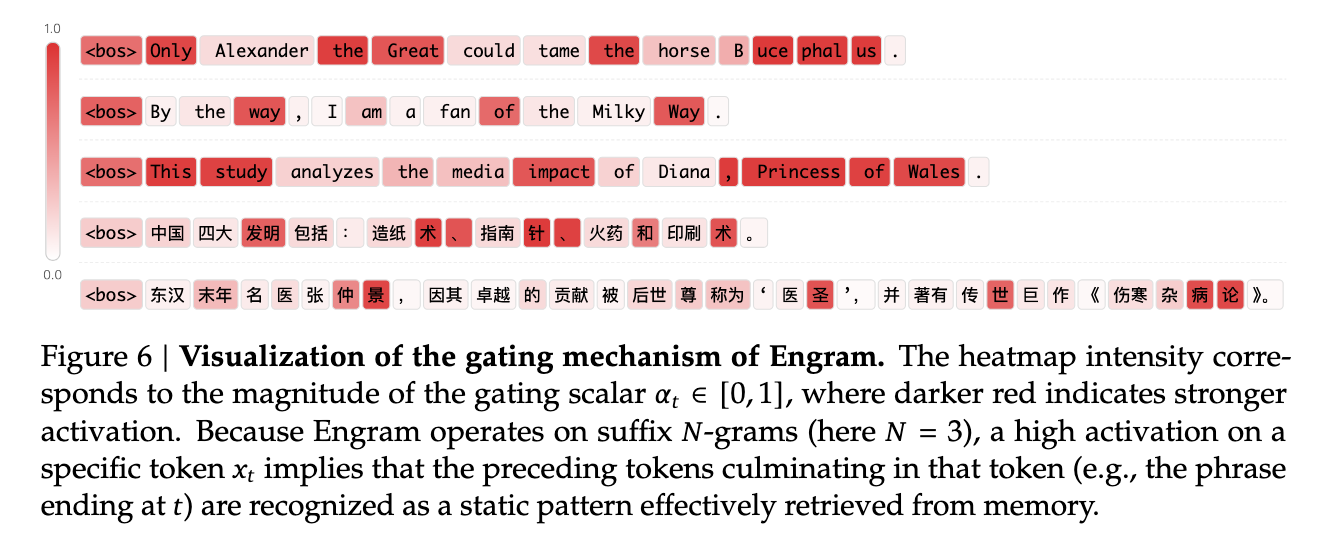

- 机制分析: 研究表明Engram能减轻浅层网络静态模式重建负担,可能为复杂推理保留有效深度

- 系统效率: 模块采用确定性寻址机制,支持将海量嵌入表卸载到主机内存,推理开销极低

2. 架构设计

Engram模块通过检索静态 N N N-gram记忆并与动态隐状态融合来增强主干网络。架构如下图所示(提供drawio源文件):

3. 评估

Scaling Law

大规模预训练

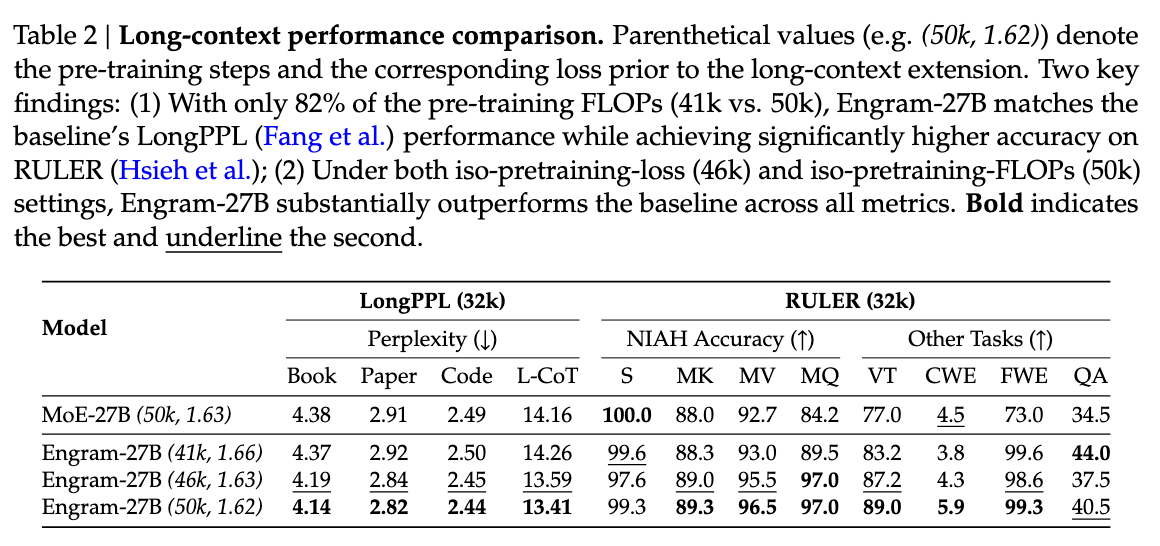

长上下文训练

4. 印迹案例研究

5. 快速开始

我们推荐使用 Python 3.8+ 和 PyTorch 环境。

bash

pip install torch numpy transformers sympy我们提供了一个独立实现来展示 Engram 模块的核心逻辑:

bash

python engram_demo_v1.py⚠️ 注意: 提供的代码是演示版本,旨在说明数据流逻辑。其中模拟了标准组件(如 Attention/MoE/mHC)以便聚焦于 Engram 模块功能。

6. 许可协议

Engram 模型的使用需遵守模型许可协议。