摘要

本文聚焦 Spring Cloud Alibaba 核心组件(Nacos、Sentinel、Seata)的理论体系,结合微服务架构落地需求,系统解析了:

- Nacos 的 "服务注册发现 + 配置中心" 双引擎能力,包括 AP/CP 模式选型、分层配置设计,并对比了 Nacos 与 Apollo/Eureka 的选型差异;

- Sentinel 的流量控制逻辑,明确其底层漏桶 / 令牌桶 / 滑动窗口算法与业务策略的对应关系,覆盖限流、熔断等核心场景;

- Seata AT 模式 的分布式事务原理,通过标准时序图还原了全局提交 / 回滚的完整流程,并对比了 Seata 与传统 2PC、TCC 的选型逻辑。

全文以 "理论 + 场景" 为核心,既补全 Spring Cloud Alibaba 的技术原理,也为微服务架构落地提供了组件选型与实践依据。

一、核心理论基础:Spring Cloud 与 Spring Cloud Alibaba 核心差异

1. 生态定位与核心价值

- Spring Cloud 是微服务架构的 "标准规范",提供服务注册发现、配置中心、网关等核心能力,但组件分散(如 Eureka、Config、Zuul),部分组件已停更(Eureka 2.x)。

- Spring Cloud Alibaba 是 "企业级实现方案",基于 Spring Cloud 规范,整合阿里开源组件(Nacos、Sentinel、Seata),具备更强的稳定性、兼容性和工程化落地能力,同时无缝对接阿里云等云服务。

2. 核心组件对应关系(聚焦本次三大组件)

|---------------|------------------------------|-----------------------------|---------------------------|

| 功能维度 | Spring Cloud 常用组件 | Spring Cloud Alibaba 组件 | 核心优势 |

| 服务注册发现 + 配置中心 | Eureka + Spring Cloud Config | Nacos | 双功能合一、支持 AP/CP 切换、动态配置热更新 |

| 服务容错(熔断 / 限流) | Hystrix + Resilience4j | Sentinel | 轻量级、规则动态配置、监控可视化、多场景适配 |

| 分布式事务 | Seata(第三方集成) | Seata(原生集成) | 与生态深度融合、支持多种模式、配置更简化 |

3. 核心设计理念

- 轻量化:组件无强依赖,可按需集成,避免 "全家桶" 式冗余。

- 工程化:提供完善的监控、告警、配置管理能力,适配企业级运维需求。

- 兼容性:完全兼容 Spring Cloud 标准 API,原有 Spring Cloud 项目可平滑迁移。

二、Nacos 核心理论

1. 核心功能:一站式服务治理双引擎

Nacos 并非简单叠加 "服务注册 + 配置管理",而是深度协同的一体化解决方案,核心功能覆盖微服务治理核心诉求:

|----------|-----------------------------------------------------------------------------------------------------------------------|-----------------------------------------------------------------------------------------------------------------------------------------------------------|---------------------------------------------|

| 功能模块 | 核心能力 | 技术实现原理 | 典型应用场景 |

| 服务注册发现 | 1. AP/CP 模式动态切换 2. 多协议服务发现(DNS/RPC) 3. 多维健康检查(TCP/HTTP/MySQL/ 自定义) 4. 服务元数据管理(版本 / 权重 / 标签) 5. 内置负载均衡策略(轮询 / 随机 / 加权) | 1. AP 模式:Distro 协议(无中心、数据分片,保障高可用,适配大多数微服务场景) 2. CP 模式:Raft 协议(强一致性,适配核心服务如订单 / 支付) 3. 健康检查:定时探活(默认 5s 间隔)+ 实例被动上报(心跳机制) 4. 服务发现:客户端订阅 + 服务端推送(配置变更时实时通知) | 微服务集群注册、多环境隔离、故障实例自动剔除、基于元数据的服务路由(如按版本灰度发布) |

| 配置中心 | 1. 动态配置推送(增量更新 + 长连接) 2. 配置灰度发布 / 版本回滚 / 权限管控 3. 多格式配置支持(YAML/JSON/Properties) | 1. 配置推送:HTTP Long Polling(长轮询,默认 30s 超时,减少无效请求) 2. 配置存储:单机嵌入式 Derby / 集群 MySQL(支持配置持久化) 3. 变更通知:配置修改后触发客户端监听回调 | 多业务线差异化配置、核心参数热更新(如限流阈值)、配置变更追溯、敏感配置加密 |

2. 服务注册发现核心要点

(1)AP/CP 模式选型与切换

- 模式差异:

- AP 模式(默认):优先保证可用性和分区容错性,数据最终一致,适合大多数微服务场景(如商品列表、用户中心);服务注册耗时短,支持大规模实例注册(万级 +)。

- CP 模式:优先保证一致性和分区容错性,适合核心服务(如订单、支付);服务注册需经过 Raft 选主确认,耗时略长,但数据无歧义。

- 切换方式:通过 Nacos 控制台或配置文件设置 spring.cloud.nacos.discovery.ephemeral=false(临时实例→持久化实例),自动切换为 CP 模式;临时实例默认 AP 模式。

(2)服务健康检查与故障隔离

Nacos 健康检查机制确保 "只将请求路由到健康实例",核心配置如下:

|----------|------------------------------------------------|-----------------------------|------------------------------|

| 检查类型 | 配置方式 | 适用场景 | 故障处理逻辑 |

| TCP 检查 | 控制台配置 "检查端口"(如 8080),Nacos 主动建立 TCP 连接 | 无 HTTP 接口的服务(如 Dubbo 服务) | 连接失败 3 次(默认),实例标记为不健康,剔除服务列表 |

| HTTP 检查 | 配置 "检查路径"(如 /actuator/health),Nacos 发送 HTTP 请求 | Spring Boot 服务(集成 Actuator) | 响应码非 200 或超时,标记为不健康 |

| 自定义检查 | 实现 HealthCheckHandler 接口,自定义健康状态判定逻辑 | 复杂业务服务(如依赖多数据源的服务) | 按自定义逻辑返回健康状态,Nacos 同步标记 |

(3)服务元数据与路由应用

- 元数据定义:服务注册时携带的附加信息(如版本号、权重、业务标签),示例配置:

java

spring:

cloud:

nacos:

discovery:

metadata:

version: v1.0 # 服务版本

weight: 10 # 负载均衡权重

tag: product # 业务标签(商品中台)- 典型应用:

- 版本路由:基于 version 元数据,实现灰度发布(如仅让 10% 流量路由到 v2.0 版本);

- 权重路由:基于 weight 元数据,让性能更好的实例承担更多流量;

- 标签路由:基于 tag 元数据,实现业务线隔离(如商品中台服务仅接收带 product 标签的请求)。

3. 配置要点:分层配置设计

Nacos 分层配置体系解决了传统配置中心 "环境混乱、复用性低、权限分散" 的问题,层级划分清晰且优先级明确:

(1)分层核心维度与作用

|-----------------|--------------------------------------------------|-----------------|---------------------------------------------------|

| 分层维度 | 核心作用 | 配置优先级(从高到低) | 配置命名规范示例 |

| 命名空间(Namespace) | 实现环境 / 租户隔离(如 dev/test/prod 环境,或商品中台 / 支付中台等业务线) | 最高 | dev-product(商品中台开发环境)、prod-pay(支付中台生产环境) |

| 分组(Group) | 同一环境下的配置归类(如基础配置组、业务配置组) | 中 | DEFAULT_GROUP(数据库 / 中间件地址)、BUSINESS_GROUP(业务规则配置) |

| 配置集(Data ID) | 具体配置文件载体,按 "服务名 - 环境 - 分组" 命名 | 低 | order-service-dev-BUSINESS_GROUP.yml |

(2)分层配置最佳实践

- 环境隔离:通过命名空间严格区分开发 / 测试 / 生产,避免配置污染;

- 配置复用:将多服务共用的基础配置(如 Redis 地址)放入 DEFAULT_GROUP,业务专属配置放入独立分组;

- 多配置加载:通过 spring.cloud.nacos.config.ext-config 配置,支持单个服务加载多个 Data ID 配置(如基础配置 + 业务配置)。

4. 技术选型要点:Nacos 服务注册 vs 其他组件

|----------|-------------------------------------|-------------------------------|-------------------------------|-------------------------------------------------------------------|

| 选型维度 | Nacos | Eureka | Zookeeper | 选型建议 |

| 核心定位 | 服务注册 + 配置中心一体化 | 纯服务注册中心(已停更) | 分布式协调框架(兼做服务注册) | 微服务架构优先选 Nacos(一站式解决方案);存量 Eureka 项目逐步迁移;Dubbo 老项目可过渡使用 Zookeeper |

| 高可用机制 | AP/CP 双模式,集群部署简单(3 节点即可) | AP 模式,无 CP 支持,集群需部署至少 3 节点 | CP 模式,强一致性,集群部署复杂(需 3 节点 +) | 核心服务需强一致性选 Nacos CP 模式;普通服务选 Nacos AP 模式 |

| 实例规模支持 | 单机支持万级实例注册,性能稳定 | 单机支持千级实例,实例过多易卡顿 | 单机支持万级实例,但服务注册耗时较长 | 大规模微服务集群(千级 + 实例)首选 Nacos |

| 生态兼容性 | 原生适配 Spring Cloud Alibaba/Dubbo/K8s | 仅适配 Spring Cloud,无 Dubbo 原生支持 | 原生适配 Dubbo,Spring Cloud 需额外集成 | Spring Cloud Alibaba 技术栈首选 Nacos;纯 Dubbo 老项目可暂用 Zookeeper |

5. 技术选型要点:Nacos 配置中心 vs Apollo

作为主流配置中心,Nacos 与 Apollo 的选型需结合团队规模、技术栈、运维成本综合判断:

|----------|-----------------------------------------------|----------------------------------------------------------|-----------------------------------------------|

| 选型维度 | Nacos | Apollo | 选型建议 |

| 核心定位 | 服务注册 + 配置中心一体化(一站式解决方案) | 纯配置中心(需搭配 Eureka/Nacos 实现服务注册) | 微服务架构优先选 Nacos(减少组件依赖,简化架构);仅需精细化配置管理选 Apollo |

| 配置推送性能 | 长轮询 + 增量更新,单机支持 10 万级配置订阅 | 长轮询 + 全量推送,单机支持 5 万级配置订阅 | 高并发配置变更场景(如秒杀活动参数调整),Nacos 性能更优 |

| 高可用部署 | 集群部署简单(3 节点 + MySQL 即可),无额外组件依赖 | 需部署 ConfigService/AdminService/Portal 等多个组件,依赖 ZooKeeper | 中小团队优先 Nacos(运维成本低);大型企业可按需选 Apollo(配置功能更极致) |

| 生态兼容性 | 原生适配 Spring Cloud Alibaba/Dubbo/K8s,无缝集成阿里系组件 | 需手动适配 Spring Cloud,与阿里系组件集成成本高 | Spring Cloud Alibaba 技术栈首选 Nacos |

| 配置灰度能力 | 支持按 IP / 服务版本灰度发布 | 支持按集群 / 机器列表 / 用户组精细化灰度 | 需极致精细化灰度(如指定某几台机器生效)选 Apollo;轻量化灰度选 Nacos |

三、Sentinel 核心理论

1. 核心定位:分布式系统的 "流量防护盾"

Sentinel 核心解决微服务场景下 "流量峰值压垮服务""故障扩散""资源滥用" 三大问题,核心设计理念是 "精准控制、动态调整、可视化监控",相较于 Hystrix/Resilience4j,其优势在于轻量级(核心包 < 1MB)、原生适配 Spring Cloud Alibaba 生态、规则动态配置无需重启服务。

2. 核心概念深化

- 资源:需保护的对象(如接口、方法、服务),是 Sentinel 防护的最小单元,支持注解(@SentinelResource)、URL 自动识别、手动编码三种定义方式。

- 规则:对资源的防护策略,包括流量控制、熔断降级、系统负载保护等,支持通过控制台、Nacos/Apollo 动态配置(生产环境推荐)。

- 上下文:标记资源调用的场景(如 "商品查询 - APP 端""商品查询 - PC 端"),支持按上下文差异化配置规则。

3. 限流策略与经典算法对应关系

Sentinel 的 "流量控制策略" 是经典算法的 "场景化封装",底层完全依赖漏桶、令牌桶等核心算法,具体对应关系如下:

|------------------------|---------------------------------------------------------------------------------------------------------------------------------|-----------------------------------------|----------------------------------------------------|-----------------------------------------|

| 经典算法 | 核心原理 | Sentinel 对应策略 | 适用场景 | 配置示例(Sentinel 控制台) |

| 漏桶算法(Leaky Bucket) | 1. 流量以固定速率 "流出" 桶(对应服务处理能力); 2. 流入速率任意,超出桶容量的流量直接丢弃或排队; 3. 核心:控制流出速率,平滑流量峰值。 | 1. QPS 限流(固定速率模式) 2. 并发线程数限流(线程池处理能力固定) | 1. 接口峰值流量平滑(如商品详情查询) 2. 慢接口保护(如报表生成,避免线程耗尽) | QPS 阈值 = 1000,流控模式 ="固定速率" |

| 令牌桶算法(Token Bucket) | 1. 系统按固定速率向桶中投放令牌; 2. 请求需获取令牌才能执行,无令牌则等待 / 丢弃; 3. 核心:支持突发流量(桶中令牌累积),同时限制长期速率。 | 1. QPS 限流(排队等待模式) 2. 热点参数限流(按参数分配令牌) | 1. 允许突发流量的接口(如秒杀下单初期) 2. 热点参数精准控制(如爆款商品 ID 单独分配令牌) | QPS 阈值 = 1000,流控模式 ="排队等待",超时时间 = 500ms |

| 滑动窗口算法(Sliding Window) | 1. 将时间划分为连续的小窗口(如 1 秒划分为 10 个 100ms 窗口); 2. 仅统计当前窗口内的请求数,避免 "临界值突刺"(如 0.9 秒和 1.1 秒各 1000 QPS 被误判为合规); 3. 核心:更精准统计流量,避免瞬时峰值突破阈值。 | 所有 QPS 相关限流策略(Sentinel 默认实现) | 所有需要精准控制 QPS 的场景(如核心业务接口) | 无需额外配置,Sentinel 默认窗口数 = 10 |

4. 流量控制策略全维度解析

|----------|------------------------------------------------------------|----------------------------------------------------------------|------------------------------------------------------------------------------------------------------------------------------------|-----------------------------------------------------------|

| 限流维度 | 具体策略 | 底层算法 | 触发条件 | 适用场景 |

| 流量控制 | 1. QPS 限流(固定速率) 2. QPS 限流(排队等待) 3. 并发线程数限流 4. 关联限流 5. 链路限流 | 1. 漏桶算法 2. 令牌桶算法 3. 漏桶算法(线程池隔离) 4. 滑动窗口 + 依赖关联 5. 滑动窗口 + 调用链标记 | 1. 每秒请求数超过固定阈值(如 1000 QPS) 2. 每秒请求数超阈值,等待获取令牌(超时丢弃) 3. 调用线程数超阈值(如 50 线程) 4. 关联接口流量超阈值(如下单接口触发库存接口限流) 5. 特定调用链路流量超阈值(如仅 APP 端调用超阈值) | 1. 通用接口峰值平滑 2. 允许突发流量的接口 3. 慢接口线程隔离 4. 上下游依赖防护 5. 精细化链路控制 |

| 熔断降级 | 1. 异常比例熔断 2. 异常数熔断 3. 慢调用比例熔断 | 熔断器模式(关闭→打开→半开) | 1. 异常率 > 阈值(如 50%),且分钟请求数≥5 2. 分钟内异常数 > 阈值(如 10 次) 3. 慢调用比例 > 阈值(如 80%) | 第三方接口调用、不稳定核心服务 |

| 热点参数限流 | 按参数值精准限流(单独分配令牌 / 窗口) | 令牌桶 + 哈希槽分区 | 特定热点参数的请求数超过阈值(如商品 ID=1001 超 500 QPS) | 热点接口精准防护(避免单个参数压垮整体服务) |

| 系统负载保护 | 按系统指标限流(CPU / 内存 / 负载) | 自适应限流算法 | CPU 使用率 > 80% / 系统负载(load1)> 阈值(如 10) | 集群整体防护(避免节点因高负载宕机) |

5. 经典算法选型决策(结合实战场景)

|------------------|-----------|-------------------------------|

| 业务需求 | 推荐算法 | Sentinel 配置方式 |

| 控制长期流量速率,不允许突发 | 漏桶算法 | QPS 限流 + 固定速率模式 |

| 允许短期突发流量,限制长期速率 | 令牌桶算法 | QPS 限流 + 排队等待模式(超时时间 = 500ms) |

| 精准控制 QPS,避免临界值突刺 | 滑动窗口算法 | 无需额外配置(Sentinel 默认启用) |

| 保护慢接口,避免线程耗尽 | 漏桶算法(线程数) | 并发线程数限流(阈值 = 50) |

6. 规则动态配置核心

Sentinel 规则支持多种配置方式,生产环境推荐 "控制台 + 配置中心" 组合,确保规则持久化与动态生效:

|-----------------|-----------|---------------------------------------------|---------------------------------|

| 配置方式 | 适用场景 | 实现原理 | 优缺点分析 |

| 控制台手动配置 | 临时调整、测试验证 | 通过 HTTP 接口推送规则至客户端,本地内存存储(服务重启后失效) | 优点:操作简单;缺点:无持久化,不适用于生产环境 |

| Nacos/Apollo 配置 | 生产环境、批量生效 | 客户端监听配置中心规则变更,实时更新本地规则(支持持久化、灰度发布) | 优点:持久化、动态生效、支持版本回滚;缺点:需额外部署配置中心 |

| 代码硬编码 | 固定规则、无需变更 | 启动时通过代码加载规则(如 FlowRuleManager.loadRules ()) | 优点:无需依赖外部组件;缺点:无法动态调整,灵活性差 |

四、Seata 核心理论

1. 核心定位:微服务分布式事务的 "一致性兜底方案"

分布式事务的核心矛盾是 "跨服务数据一致性",Seata 通过 "全局事务协调" 模式,解决微服务架构下 "下单→扣库存→减余额" 等跨服务场景的数据不一致问题,其三大核心角色分工明确:

- TC(Transaction Coordinator):事务协调器,独立部署的中间件(Seata Server),负责维护全局事务状态,协调各分支事务提交 / 回滚。

- TM(Transaction Manager):事务管理器,部署在事务发起方服务中,负责发起全局事务(创建 XID)、通知 TC 执行提交 / 回滚。

- RM(Resource Manager):资源管理器,部署在各参与方服务中,负责管理分支事务(本地事务),与 TC 通信上报分支状态,执行本地提交 / 回滚。

2. 核心事务模式对比(企业级选型依据)

Seata 支持多种事务模式,需根据业务场景(一致性要求、性能要求、侵入性接受度)选择:

|----------|-----------------------------|--------|-----------|-------------------------|----------------------------------------------------------------------------------------|

| 事务模式 | 侵入性 | 性能 | 数据一致性 | 适用场景 | 核心原理 |

| AT 模式 | 无侵入(仅需注解) | 高 | 强一致性 | 大多数微服务场景(如订单 - 库存 - 支付) | 1. 一阶段:本地事务提交 + 记录 undo_log(数据修改前快照)2. 二阶段:- 提交:删除 undo_log- 回滚:通过 undo_log 反向补偿(恢复数据) |

| TCC 模式 | 高(需手动实现 Try/Confirm/Cancel) | 极高 | 强一致性 | 核心业务场景(如佣金结算、资金交易) | 1. Try:资源检查与预留(如冻结用户余额)2. Confirm:确认提交(如扣减冻结余额)3. Cancel:释放预留资源(如解冻余额) |

| SAGA 模式 | 中(需定义补偿逻辑) | 中 | 最终一致性 | 长事务场景(如跨天订单处理、物流调度) | 正向业务流程 + 反向补偿流程(如订单取消→库存回补→余额返还),支持状态机驱动 |

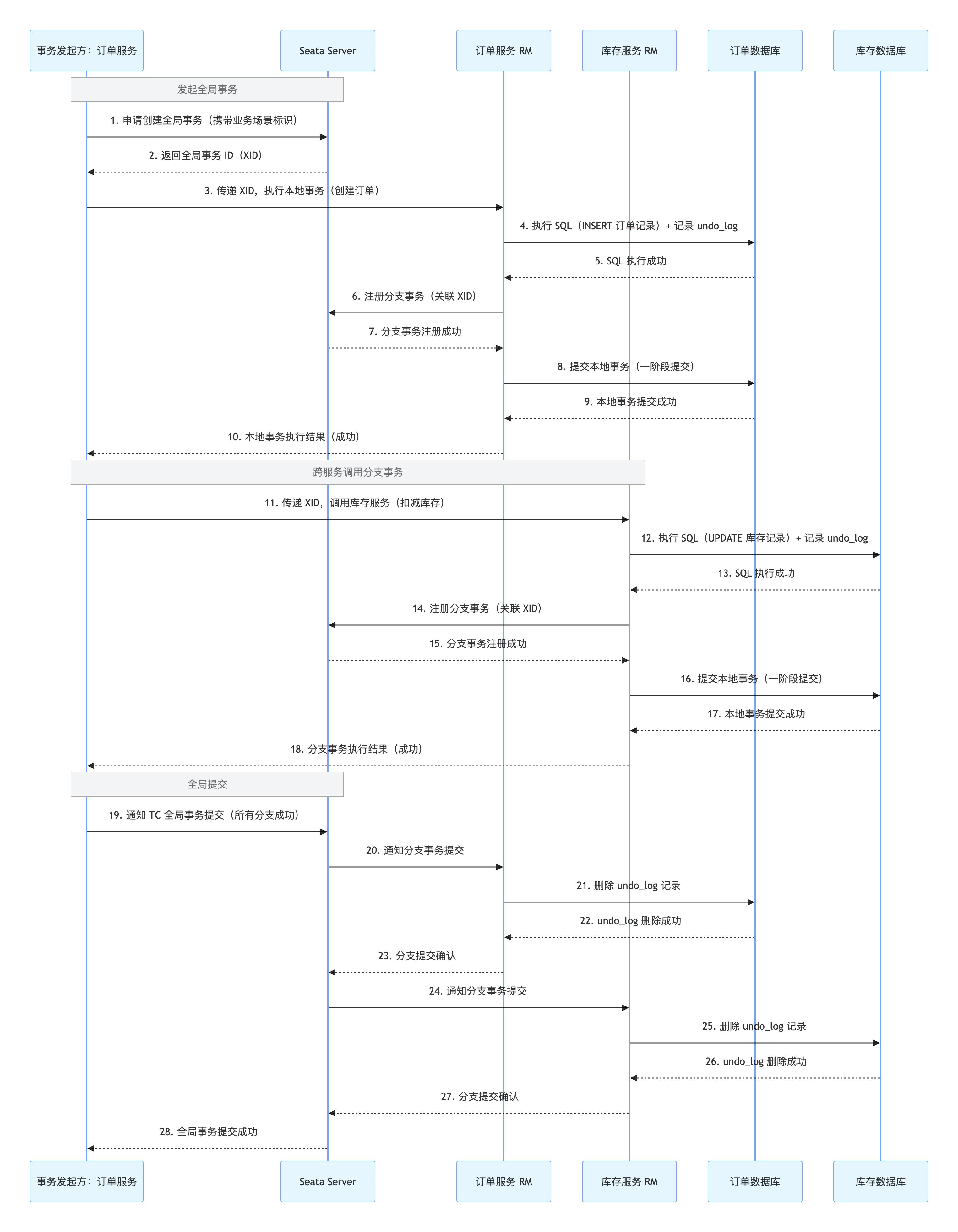

3. 核心时序图(AT 模式)

(1)全局事务提交成功时序

提交流程速记:申请 XID→分支注册→一阶段提交→全局提交→删除 undo_log;

(2)全局事务回滚失败时序

回滚流程速记:申请 XID→分支注册→一阶段提交→分支失败→全局回滚→补偿数据→删除 undo_log"

4. 技术选型要点:为何选择 Seata?

在分布式事务解决方案中,Seata 成为 Spring Cloud Alibaba 生态首选,核心优势体现在生态适配、易用性、性能三方面,对比其他方案如下:

|----------|-----------------------------------------|----------------|----------------|--------------------------|

| 选型维度 | Seata(AT 模式) | 传统 2PC | 自研 TCC | 最终一致性(MQ + 本地消息表) |

| 侵入性 | 无侵入(仅需 @GlobalTransactional 注解) | 高(需修改数据库层) | 高(需手动实现 3 个方法) | 中(需设计消息表 + 补偿逻辑) |

| 性能表现 | 高(一阶段本地提交,二阶段异步执行) | 低(两阶段均阻塞,锁粒度大) | 极高(无锁,纯业务逻辑) | 中(异步执行,依赖消息队列) |

| 数据一致性 | 强一致性 | 强一致性 | 强一致性 | 最终一致性 |

| 运维成本 | 低(Seata Server 集群部署简单) | 高(依赖数据库分布式锁) | 高(补偿逻辑维护复杂) | 中(需维护消息队列 + 死信队列) |

| 生态兼容性 | 原生适配 Spring Cloud Alibaba/Dubbo/MyBatis | 无生态适配 | 需手动集成 | 需适配消息中间件(Kafka/RabbitMQ) |

| 适用场景 | 大多数微服务场景(订单、库存、支付) | 传统单体迁移分布式场景 | 核心金融场景(资金交易) | 非核心场景(如日志同步、通知推送) |

五、核心理论总结与学习建议

1. 三大组件核心定位速记

- Nacos:"配置 + 注册" 双引擎,解决 "服务怎么找""配置怎么管" 的核心问题,是微服务治理的基础底座(重点掌握 AP/CP 选型、分层配置、健康检查)。

- Sentinel:"流量防护盾",通过多维度限流 / 熔断策略,解决 "服务扛不住""故障不扩散" 的高可用问题(重点掌握限流策略选型、规则动态配置)。

- Seata:"分布式事务协调者",通过灵活的事务模式,解决 "跨服务数据一致" 的兜底问题(重点掌握 AT 模式原理、时序流程、选型对比)。

2. 关键注意事项

- 版本兼容性:Spring Cloud Alibaba、Spring Boot、Spring Cloud 版本需严格匹配(如 Spring Boot 2.7.x 对应 Spring Cloud Alibaba 2021.0.5.0),避免集成踩坑。

- 生产环境配置:核心组件需集群部署(Nacos/Seata/Sentinel 均支持),配置持久化(Nacos 用 MySQL,Seata 用 DB 模式),搭配监控告警(对接 Prometheus/Grafana)。

- 迁移平滑性:原有 Spring Cloud 项目可逐步替换组件(先换 Nacos 替代 Eureka+Config,再换 Sentinel 替代 Hystrix,最后集成 Seata),无需整体重构。

💡 实战思考题

现有一个基于 Dubbo+Zookeeper 的微服务系统,需渐进式迁移到 Spring Cloud Alibaba(Nacos 注册 + OpenFeign 调用),如何设计迁移方案才能保障业务无感知?迁移过程中需解决哪些核心问题(如服务双注册、接口兼容性、流量平滑切换)?

欢迎在评论区分享你的解决方案,一起交流实战经验~