目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

** 选题指导:**

最新最全计算机专业毕设选题精选推荐汇总

大家好,这里是海浪学长毕设专题,本次分享的课题是

🎯基于RepVGG与注意力机制的手写潦草汉字识别算法研究

选题意义背景

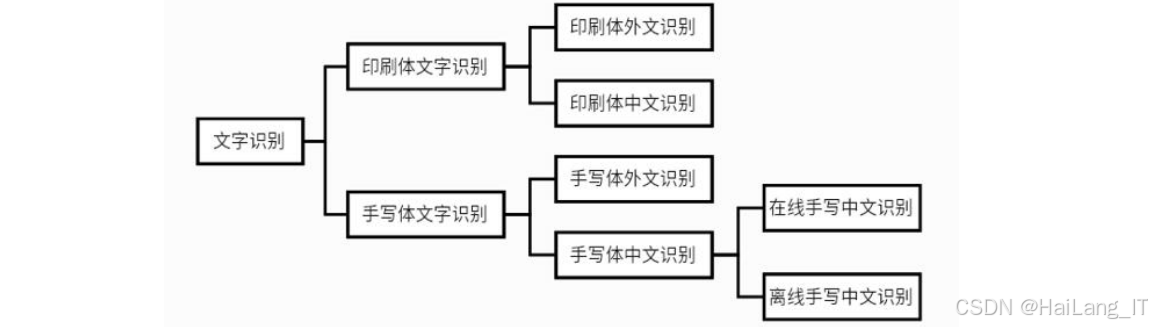

在当今信息化时代,手写汉字作为中国传统文化的重要载体,依然在教育、政务、金融等领域发挥着不可替代的作用。然而,随着数字化转型的深入推进,如何高效地将手写汉字转化为电子文本成为亟待解决的重要课题年的统计数据显示,全国每年产生的手写文档数量仍然庞大,尤其是在教育行业,学生作业、考试答卷等手写材料的数字化处理需求与日俱增。手写汉字识别技术的研究始于世纪60年代,但一直面临着诸多挑战。其中,潦草汉字的识别是最具挑战性的任务之一。传统的手写汉字识别方法主要采用模板匹配和统计特征提取等技术,这些方法在处理书写规范的汉字时表现尚可,但在面对书写风格多样、笔画粘连、变形严重的潦草汉字时,识别准确率显著下降。据2024年发布的行业报告显示,现有商业OCR系统在处理规范手写汉字时准确率可达95%以上,但对于潦草汉字,准确率往往不足70%,严重制约了其在实际应用中的推广。

与此同时,随着人工智能技术的迅猛发展,深度学习方法在图像识别领域取得了突破性进展年至2025年间,基于卷积神经网络的图像识别技术不断成熟,为解决手写汉字识别问题提供了新的思路。深度学习方法能够自动学习汉字的深层特征表示,无需人工设计特征提取器,在处理复杂多变的手写汉字时展现出了强大的优势。除了识别功能外,手写汉字的质量评价也是一个重要的研究方向。在教育领域,教师需要对学生的汉字书写质量进行评价,这是一项耗时且主观的工作。2024年的教育统计数据表明,一名小学语文教师平均每天需要批改50-60本作业,其中汉字书写评价占据了相当大的工作量。因此,开发一套能够客观、准确地评价手写汉字质量的系统,对于减轻教师负担、提高教学效率具有重要意义。

本选题旨在结合深度学习技术,设计一套能够同时实现手写潦草汉字识别和质量评价的一体化系统。该系统将从图像预处理、特征提取、模型优化等多个方面入手,重点解决潦草汉字识别准确率低、评价标准不统一等问题。通过引入RepVGG网络结构、注意力机制和SoftPool池化等先进技术,提升系统在复杂场景下的鲁棒性和准确性。本研究的开展具有重要的理论意义和实际应用价值。从理论上讲,它将进一步丰富深度学习在手写汉字处理领域的应用研究,为相关算法的优化提供新思路。从实际应用来看,该系统可以广泛应用于教育评估、文档数字化、身份认证等领域,为推动手写汉字的信息化处理提供有力支持。随着研究的深入,我们相信手写汉字识别与评价技术将在2025年及以后得到更广泛的应用,为社会各领域带来更多便利。

数据集

在本项目中,数据集的选择和处理是整个研究的基础。为了确保模型的训练效果和评价的准确性,我们采用了多个公开数据集并进行了系统性的处理。主要的数据来源包括CASIA-HWDB手写汉字数据库。该数据库是目前手写汉字识别领域使用最广泛的数据集之一,包含了大量不同书写风格的汉字样本。此外,为了构建手写汉字质量评价的参考标准,我们还收集了印刷体正楷汉字作为模板字库,用于与手写汉字进行相似度比较。CASIA-HWDB数据集通过中国科学院自动化研究所的官方渠道获取。该数据集经过严格的数据采集和标注流程,确保了数据的质量和可靠性。印刷体正楷模板字库则通过专业排版软件生成,包含了GB2312字符集中的常用汉字,保证了模板的规范性和统一性。

数据格式与规模

CASIA-HWDB数据集的原始格式为图像文件,每个汉字样本以独立的图像文件形式存储。数据集中包含了来自数百位书写者的手写汉字样本,涵盖了GB2312字符集中的3755个汉字类别。总的样本数量超过200万个,为模型的训练提供了充足的数据支持。印刷体模板字库的格式同样为图像文件,每个汉字以标准分辨率和统一的字体样式保存。整个模板库包含了与CASIA-HWDB1.1相对应的3755个汉字类别,每个汉字只有一个标准模板样本。在数据集的处理过程中,我们严格按照GB字符集的编码标准对汉字进行分类。每个汉字类别对应一个唯一的编码标识,确保了模型训练和估的一致性。此外,为了研究潦草程度对识别性能的影响,我们还根据汉字的书写规范程度将数据集划分为四个等级:L1(非常规范)、L2(较规范)、L3(较潦草)和L4(非常潦草)。这种分级方式有助于分析模型在不同难度级别上的表现差异。

数据分割

为了保证模型训练和评估的科学性,我们采用了经典的:1:1分割策略。具体来说,将总数据集的80%用于模型训练,10%用于验证,剩余的10%用于测试。这种分割方式在保证训练数据充足的同时,也为模型的泛化性能评估提供了可靠的依据。在数据分割过程中,我们特别注意了类别分布的均衡性。通过分层抽样的方法,确保训练集、验证集和测试集中各个汉字类别的样本比例保持一致,避免因数据分布不均导致模型训练偏向某些类别。

数据预处理

数据预处理是提升模型性能的关键步骤之一。针对手写汉字图像的特点,我们设计了一套完整的预处理流程,主要包括以下几个环节:

-

进行图像灰度化处理。由于原始图像可能包含不同的色彩信息,我们将其转换为灰度图像,减少数据维度的同时保留了重要的结构信息。灰度化采用加权平均值法,根据人眼对不同颜色通道的敏感度设置权重,使得处理后的图像更加符合人眼的视觉感知。

-

进行图像二值化处理。通过自适应阈值分割算法,将灰度图像转换为黑白二值图像,突出汉字的轮廓和笔画特征。二值化过程中,我们根据图像的局部特征动态调整阈值,避免了全局阈值可能导致的细节丢失问题。

-

进行图像去噪处理。采用中值滤波算法去除图像中的噪声干扰,保留汉字的边缘信息。中值滤波对于椒盐噪声等类型的噪声具有良好的抑制效果,能够有效提升图像质量。

-

进行位置标准化处理。通过计算汉字的外接矩阵,确定其在图像中的位置,然后进行平移操作,使汉字居中显示。这种处理方式有助于减少位置变化对特征提取的影响,提高模型的稳定性。

最后,进行大小统一化处理。将不同尺寸的汉字图像调整为统一的大小(如×64或128×128像素),方便模型进行批量处理。在调整过程中,我们采用双三次插值算法,保证了图像质量的同时避免了锯齿效应。

此外,为了扩充训练数据并提高模型的泛化能力,我们还进行了数据增强处理。主要包括随机旋转、缩放、平移等几何变换,以及随机亮度、对比度调整等颜色变换。这些增强操作模拟了不同拍摄条件下的图像变化,有助于提升模型在实际应用中的鲁棒性。

通过以上数据预处理步骤,我们显著提升了数据的质量和一致性,为后续的模型训练和评估奠定了坚实的基础。同时,我们还建立了完整的数据处理流程文档,确保了实验的可重复性和结果的可靠性。

功能模块介绍

本系统采用模块化设计,将复杂的功能划分为多个相互协作的模块,主要包括图像预处理模块、手写汉字识别模块、汉字质量评价模块和系统界面模块。每个模块都有明确的功能边界和接口定义,保证了系统的可维护性和扩展性。

手写汉字识别模块

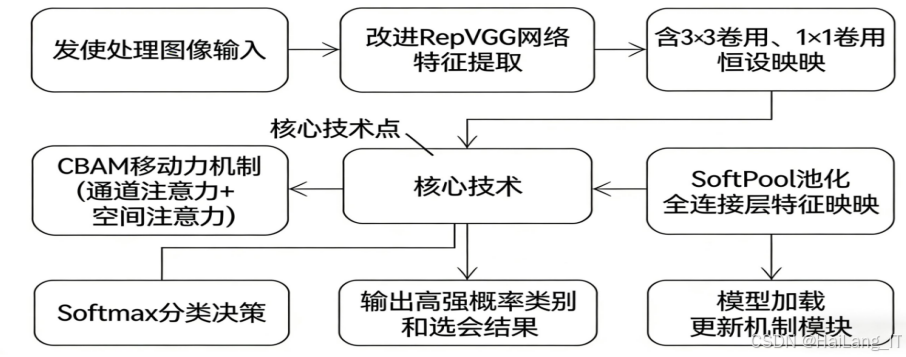

手写汉字识别模块是系统的核心功能之一,负责将预处理后的汉字图像识别为具体的汉字类别。该模块基于改进的RepVGG网络架构,结合注意力机制和SoftPool池化技术,能够有效处理各种书写风格的汉字,尤其是书写较为潦草的样本。识别模块的工作流程包括特征提取、特征融合和分类决策三个主要环节。首先,系统将预处理后的图像输入到改进的RepVGG网络中进行特征提取。RepVGG网络采用结构重参数化技术,训练时使用多分支结构(包括3×3卷积、1×1卷积和恒等映射),测试时转换为单路结构,兼顾了训练效果和推理速度。为了增强网络对汉字关键特征的关注度,系统在RepVGG的合适位置嵌入了CBAM注意力机制。CBAM注意模块分为通道注意力和空间注意力两个子模块,能够自适应地调整不同通道和空间位置的特征权重,其中通道注意力通过全局平均池化和最大池化获取通道特征的全局信息,而空间注意力则关注特征图中的空间位置信息,突出汉字的关键区域如笔画交叉点和端点等。

在池化层的设计上,系统创新性地引入了SoftPool池化技术,以替代传统的最大池化或平均池化。SoftPool通过Softmax归一化计算平滑的最大值,能够保留更多的空间信息和细节特征,对于笔画细小或粘连的潦草汉字尤为有效。特征提取完成后,系统通过全连接层将高维特征映射到汉字类别空间,并使用Softmax函数计算每个类别的概率。最后,根据概率值的大小,选择概率最高的类别作为识别结果,为了提高识别的可靠性,系统还会返回前几个高概率类别的候选结果,供用户参考。此外,识别模块包含模型加载和更新机制,支持使用预训练模型进行初始化,并可根据新的数据集进行微调。用户可以通过配置文件灵活调整模型的各项参数,如网络结构、学习率和批量大小,以适应不同的应用场景。

汉字质量评价模块

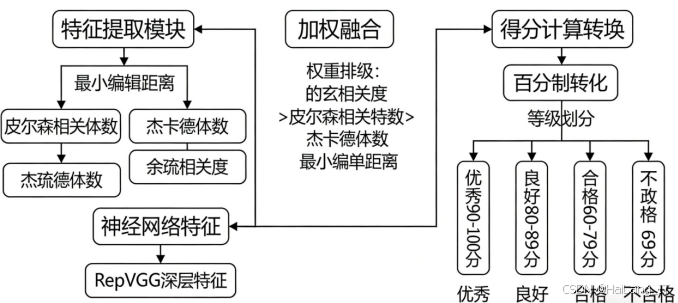

汉字质量评价模块是本系统的特色功能,负责对识别出的手写汉字进行质量评分,从而给出客观的评价结果。该模块采用结构特征与神经网络特征相结合的评价方法,能够全面反映汉字的书写质量。其核心思想是从多个维度对汉字进行评价,包括笔画完整性、结构规范性和整体美观度等。具体的评价过程分为特征提取、特征融合和得分计算三个步骤。首先,系统提取手写汉字的多种结构特征,包括最小编辑距离、皮尔森相关系数、杰卡德系数和余弦相似度等,这些特征从不同角度描述了手写汉字与标准模板字之间的差异。最小编辑距离用于衡量两个字符序列之间的差异,计算手写汉字与模板字之间的编辑距离,距离越小表示书写越规范;皮尔森相关系数用于衡量像素分布的相关性,相关系数越高则表明结构越相似;杰卡德系数用于计算像素集合的相似度;余弦相似度则通过提取汉字的重心特征和网格特征来衡量向量之间的夹角。

在特征融合阶段,系统依据不同特征的重要性设置权重,以实现加权融合。通过实验分析,确定各特征的权重优先级为余弦相似度、皮尔森相关系数、杰卡德系数和最小编辑距离。这种权重设置考虑了不同特征在评价中的贡献度,使最终的评价结果更加合理。最后,系统将融合后的特征转换为百分制得分,并根据得分将汉字质量划分为优秀、良好、合格和不合格四个等级,评价结果以直观的方式展示给用户,并提供改进建议,帮助用户提升书写质量。

系统界面模块

系统界面模块为用户提供了友好的交互界面,整合了图像上传、预处理、识别和评价等功能。界面设计遵循简洁直观的原则,确保用户能够轻松操作和使用系统。

界面模块基于PyQt框架开发,具有跨平台兼容性,支持Windows、macOS和Linux等主流操作系统。主界面分为图像显示区、功能操作区和结果展示区三个部分。图像显示区用于展示上传的原始图像和处理后的图像,支持缩放和拖动操作,方便用户查看细节。功能操作区包含图像上传、预处理参数设置、识别评价等按钮,用户可以通过简单的点击完成各项操作。结果展示区用于显示识别结果、评价得分和等级,以及相关的改进建议。

系统支持多种图像导入方式,包括文件选择、拖拽上传和粘贴截图等,满足不同场景下的使用需求。在处理过程中,界面会显示进度条,提示用户当前的处理状态。处理完成后,系统会以表格和图表的形式展示结果,直观地呈现识别准确率和评价得分的分布情况。

此外,系统还提供了批量处理功能,支持同时上传多张图像进行识别和评价,大大提高了处理效率。批量处理结果可以导出为Excel或CSV格式,方便用户进行后续分析和管理。系统还包含历史记录功能,能够保存用户的处理历史,方便用户查阅和比较不同时期的结果。

界面模块还注重用户体验的细节优化,如添加快捷键支持、提供操作提示和错误处理等。通过这些设计,系统能够为用户提供流畅、高效的使用体验,降低学习成本,提高工作效率。

算法理论

深度学习基础理论

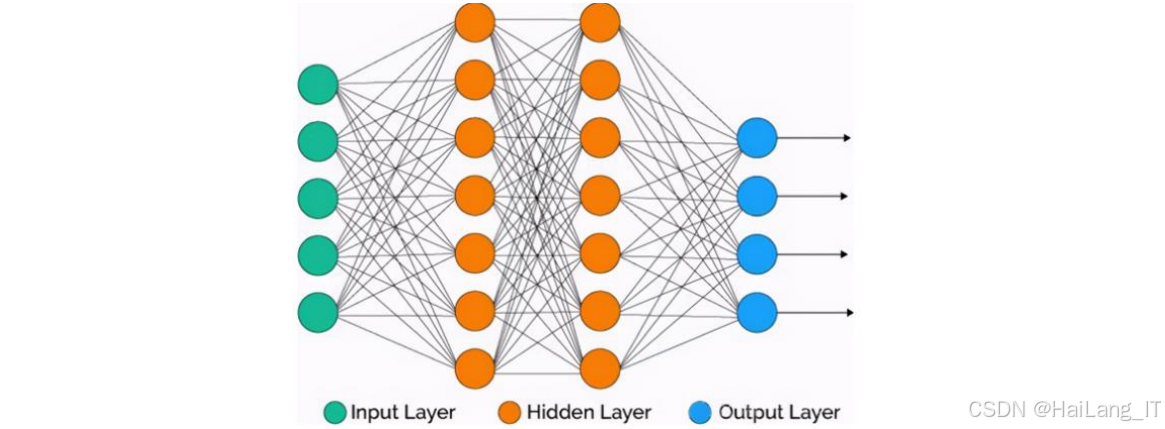

深度学习是实现手写汉字识别与评价的核心技术。它通过模拟人脑的神经网络结构,构建多层的计算模型,能够自动学习数据中的复杂特征表示。深度学习的基本单位是人工神经元,多个神经元按层次连接形成神经网络。每层神经元接收上一层的输出作为输入,经过权重调整和激活函数处理后,输出到下一层。

反向传播算法是深度学习模型训练的关键。该算法通过计算损失函数关于各层权重的梯度,从输出层向输入层反向传播,不断调整网络参数,最小化预测值与真实值之间的误差。在手写汉字识别任务中,常用的损失函数包括交叉熵损失和均方误差损失等。

激活函数在神经网络中起着非线性变换的作用,常用的激活函数包括ReLU、Sigmoid和Tanh等。ReLU函数因其计算简单、梯度消失问题小等优点,在深度学习模型中得到了广泛应用。它的表达式为f(x) = max(, x),能够有效加快模型的训练速度。

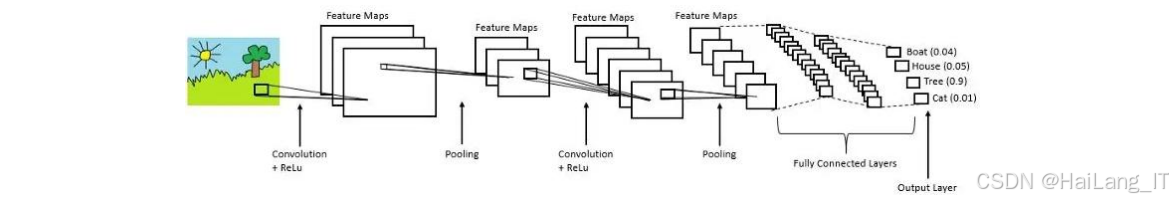

卷积神经网络理论

卷积神经网络是专为图像识别任务设计的深度学习模型,它通过卷积操作提取图像的局部特征,具有参数共享和局部连接的特点,能够有效减少模型参数数量,提高训练效率。典型的CNN结构包括输入层、卷积层、激活函数层、池化层和全连接层等。

卷积层是CNN的核心组件,通过卷积核与输入特征图进行卷积运算,提取图像的局部特征。卷积操作能够保留像素之间的空间关系,同时通过滑动窗口的方式提取不同位置的特征。在手写汉字识别中,卷积核可以学习到笔画、偏旁等局部特征,随着网络深度的增加,逐渐学习到更抽象的整体特征。

池化层用于降低特征图的空间维度,减少计算量的同时增强特征的鲁棒性。常用的池化方法包括最大池化、平均池化和SoftPool池化等。最大池化取局部区域的最大值,能够保留最显著的特征;平均池化取局部区域的平均值,能够保留更多的背景信息;SoftPool池化则通过Softmax归一化计算平滑的最大值,能够在保留重要特征的同时保持空间信息的连续性。

全连接层将卷积层提取的特征映射到最终的分类空间,通过矩阵乘法和激活函数将高维特征转换为类别概率。在手写汉字识别任务中,全连接层的输出节点数通常等于汉字类别的数量,通过Softmax函数输出每个类别的概率。

RepVGG网络理论

RepVGG网络是一种基于结构重参数化的卷积神经网络,它在保持VGG网络简单结构的同时,通过多分支结构提升了模型性能。RepVGG的核心思想是在训练时使用多分支结构(包含×3卷积、1×1卷积和恒等映射),而在推理时将多分支结构转换为单路结构,从而在不增加推理时间的情况下提高模型性能。

RepVGG的基本构建单元是RepVGG Block。在训练阶段,每个Block包含三条分支:主分支是3×3卷积;第一条辅助分支是1×1卷积;第二条辅助分支是恒等映射(仅在输入输出维度相同时存在)。三条分支的输出相加后经过激活函数得到最终输出。在推理阶段,通过结构重参数化技术,将多分支结构转换为等效的单路3×3卷积,从而减少计算量,提高推理速度。

RepVGG网络通常分为5个阶段,每个阶段包含若干个RepVGG Block。网络的通道数从第一阶段到第五阶段逐渐增加,空间分辨率逐渐降低,形成金字塔结构。这种结构设计能够有效提取不同尺度的特征,对于手写汉字这类需要多尺度特征的任务非常适合。

RepVGG的一个重要特点是其灵活性,通过调整网络的深度(层数)和宽度(通道数),可以得到不同性能和效率的模型变体。例如,RepVGG-A系列模型较小,适合计算资源有限的场景;RepVGG-B系列模型较大,性能更好,适合对准确率要求较高的场景。此外,RepVGG还提供了分组卷积版本(g型),如RepVGG-B3g4,通过分组卷积减少计算量的同时保持较高的模型性能。

注意力机制理论

注意力机制是模仿人类视觉注意力的一种机制,能够使模型自适应地关注输入数据的重要部分,提高特征提取的效率和准确性。在手写汉字识别中,注意力机制能够帮助模型关注汉字的关键区域,如笔画交叉点、偏旁位置等,从而提升对潦草汉字的识别能力。

常用的注意力机制包括SE(Squeeze-and-Excitation)、ECA(Efficient Channel Attention)和CBAM(Convolutional Block Attention Module)等。SE注意力机制通过全局池化获取通道特征的全局信息,然后使用全连接层学习通道间的依赖关系,最后通过Sigmoid函数生成通道注意力权重。ECA注意力机制是SE的改进版本,它通过一维卷积替代全连接层,减少了参数数量,同时保持了通道间的交互信息。

CBAM注意力机制结合了通道注意力和空间注意力,能够同时关注通道维度和空间维度的重要信息。通道注意力部分与SE类似,但同时使用了全局平均池化和全局最大池化,能够获取更丰富的特征信息。空间注意力部分通过对通道维度进行平均池化和最大池化,然后使用卷积层生成空间注意力权重。CBAM的这种双通道设计使其在保持计算效率的同时,能够更全面地提取特征的重要性信息。

在本系统中,我们将CBAM注意力模块嵌入到RepVGG网络中,具体位置选择在每个阶段的末尾。这样的设计能够使模型在提取完该阶段的特征后,通过注意力机制增强重要特征,抑制无关特征,从而提升特征表示的质量。

特征提取与融合理论

特征提取是手写汉字质量评价的关键环节,高质量的特征能够准确反映汉字的书写规范程度。在本系统中,我们提取了多种结构特征和神经网络特征,通过特征融合的方式综合评价汉字质量。

结构特征是基于汉字的几何形态和统计特性提取的特征,包括最小编辑距离、皮尔森相关系数、杰卡德系数和余弦相似度等。最小编辑距离用于衡量两个序列之间的差异,在汉字评价中,我们将汉字的笔画序列转换为特征向量,计算手写汉字与标准模板字之间的编辑距离。皮尔森相关系数用于衡量两个变量之间的线性相关程度,在汉字评价中,我们计算手写汉字与模板字在像素分布上的相关系数。杰卡德系数用于衡量两个集合的相似度,在汉字评价中,我们将汉字视为像素集合,计算交集与并集的比值。余弦相似度用于衡量两个向量之间的夹角,在本系统中,我们提取汉字的重心特征和网格特征,计算它们之间的余弦相似度。

神经网络特征是通过预训练的深度学习模型提取的高层语义特征,能够反映汉字的整体美观度和规范程度。在本系统中,我们使用RepVGG-B3g4模型作为特征提取器,提取全连接层之前的特征向量作为神经网络特征。这些特征包含了汉字的丰富语义信息,能够有效补充结构特征的不足。

特征融合是将不同类型的特征结合起来,形成更全面的特征表示。在本系统中,我们采用加权融合的方法,根据不同特征的重要性设置权重。通过实验分析,我们确定了各特征权重的优先级:余弦相似度 > 皮尔森相关系数 > 杰卡德系数 > 最小编辑距离。这种权重设置考虑了不同特征在评价中的贡献度,使得最终的评价结果更加合理。

最后,我们将融合后的特征转换为百分制得分,并根据得分将汉字质量划分为四个等级。评价结果不仅给出具体的分数,还提供改进建议,帮助用户提升书写质量。

核心代码

RepVGG网络实现

以下是RepVGG网络的核心实现代码,该部分定义了RepVGG的基本结构和前向传播过程。这段代码实现了RepVGG的关键特性------结构重参数化,即在训练时使用多分支结构,而在推理时转换为单路结构。

python

class RepVGGBlock(nn.Module):

def __init__(self, in_channels, out_channels, kernel_size=3, stride=1, padding=1, groups=1, deploy=False):

super(RepVGGBlock, self).__init__()

self.deploy = deploy

self.groups = groups

self.in_channels = in_channels

# 推理阶段的单路3×3卷积

self.rbr_reparam = nn.Conv2d(in_channels=in_channels, out_channels=out_channels, kernel_size=kernel_size,

stride=stride, padding=padding, groups=groups, bias=True)

# 训练阶段的多分支结构

if not self.deploy:

# 主分支:3×3卷积

self.rbr_identity = nn.BatchNorm2d(num_features=in_channels) if out_channels == in_channels and stride == 1 else None

# 辅助分支1:1×1卷积

self.rbr_dense = nn.Sequential(

nn.Conv2d(in_channels=in_channels, out_channels=out_channels, kernel_size=kernel_size,

stride=stride, padding=padding, groups=groups, bias=False),

nn.BatchNorm2d(num_features=out_channels)

)

# 辅助分支2:1×1卷积(当groups=1时使用)

if groups == 1:

self.rbr_1x1 = nn.Sequential(

nn.Conv2d(in_channels=in_channels, out_channels=out_channels, kernel_size=1,

stride=stride, padding=0, groups=groups, bias=False),

nn.BatchNorm2d(num_features=out_channels)

)

def forward(self, x):

if self.deploy:

# 推理阶段直接使用单路卷积

return self.rbr_reparam(x)

else:

# 训练阶段融合多分支输出

identity_out = 0

if self.rbr_identity is not None:

identity_out = self.rbr_identity(x)

out = self.rbr_dense(x)

if hasattr(self, 'rbr_1x1'):

out += self.rbr_1x1(x)

out += identity_out

return out

def switch_to_deploy(self):

# 将训练模型转换为推理模型

if not self.deploy:

kernel, bias = self.get_equivalent_kernel_bias()

self.rbr_reparam.weight.data = kernel

self.rbr_reparam.bias.data = bias

self.__delattr__('rbr_dense')

if hasattr(self, 'rbr_1x1'):

self.__delattr__('rbr_1x1')

if hasattr(self, 'rbr_identity'):

self.__delattr__('rbr_identity')

self.deploy = True- 实现了RepVGG的基本构建单元RepVGGBlock。在训练阶段,该Block包含三个分支:3×3卷积分支、1×1卷积分支和恒等映射分支(仅在满足条件时存在)。这三个分支的输出相加后作为最终输出,能够有效增加模型的表达能力。在推理阶段,通过switch_to_deploy方法将多分支结构转换为等效的单路3×3卷积,从而提高推理效率。

转换过程的核心是get_equivalent_kernel_bias方法(代码中未完全展示),该方法通过数学变换,将多分支结构的参数合并为单路卷积的参数。这种结构重参数化技术使得RepVGG能够在训练时享受多分支网络的性能优势,同时在推理时保持单路网络的速度优势。

在手写汉字识别任务中,RepVGG的这种设计特别适合,因为它能够有效提取汉字的多尺度特征,同时保持较快的推理速度,满足实时识别的需求。

CBAM注意力机制实现

以下是CBAM注意力模块的核心实现代码,该部分定义了通道注意力和空间注意力的计算过程。

python

class ChannelAttention(nn.Module):

def __init__(self, in_channels, reduction_ratio=16):

super(ChannelAttention, self).__init__()

self.avg_pool = nn.AdaptiveAvgPool2d(1)

self.max_pool = nn.AdaptiveMaxPool2d(1)

# 使用SoftPool替代传统池化

self.use_softpool = True

self.fc = nn.Sequential(

nn.Conv2d(in_channels, in_channels // reduction_ratio, kernel_size=1, bias=False),

nn.ReLU(inplace=True),

nn.Conv2d(in_channels // reduction_ratio, in_channels, kernel_size=1, bias=False)

)

self.sigmoid = nn.Sigmoid()

def forward(self, x):

if self.use_softpool:

# SoftPool实现

avg_out = self.soft_pool(x)

max_out = self.soft_pool(x, mode='max')

else:

avg_out = self.avg_pool(x)

max_out = self.max_pool(x)

avg_out = self.fc(avg_out)

max_out = self.fc(max_out)

out = avg_out + max_out

return self.sigmoid(out)

def soft_pool(self, x, mode='avg'):

# SoftPool实现

batch_size, channels, height, width = x.size()

x = x.view(batch_size, channels, -1)

if mode == 'avg':

# 计算权重并加权平均

soft_weights = F.softmax(x, dim=2)

out = torch.sum(x * soft_weights, dim=2, keepdim=True)

elif mode == 'max':

# 计算权重并加权最大值

soft_weights = F.softmax(x, dim=2)

out = torch.max(x * soft_weights, dim=2, keepdim=True)[0]

return out.view(batch_size, channels, 1, 1)

class SpatialAttention(nn.Module):

def __init__(self, kernel_size=7):

super(SpatialAttention, self).__init__()

assert kernel_size in (3, 7), 'kernel size must be 3 or 7'

padding = 3 if kernel_size == 7 else 1

self.conv = nn.Conv2d(2, 1, kernel_size=kernel_size, padding=padding, bias=False)

self.sigmoid = nn.Sigmoid()

def forward(self, x):

avg_out = torch.mean(x, dim=1, keepdim=True)

max_out, _ = torch.max(x, dim=1, keepdim=True)

x_cat = torch.cat([avg_out, max_out], dim=1)

x = self.conv(x_cat)

return self.sigmoid(x)

class CBAM(nn.Module):

def __init__(self, in_channels, reduction_ratio=16, kernel_size=7):

super(CBAM, self).__init__()

self.channel_attention = ChannelAttention(in_channels, reduction_ratio)

self.spatial_attention = SpatialAttention(kernel_size)

def forward(self, x):

# 先应用通道注意力

out = x * self.channel_attention(x)

# 再应用空间注意力

out = out * self.spatial_attention(out)

return out- 实现了CBAM注意力模块,包括通道注意力和空间注意力两个子模块。通道注意力通过全局池化(或SoftPool)获取通道特征的全局信息,然后通过卷积层学习通道间的依赖关系。与传统CBAM不同,我们创新性地引入了SoftPool池化技术,替代传统的平均池化和最大池化。SoftPool通过Softmax归一化计算平滑的权重,能够保留更多的空间信息和细节特征。

空间注意力通过对通道维度进行平均池化和最大池化,然后使用卷积层生成空间注意力权重。这种设计能够帮助模型关注汉字的关键空间位置,如笔画交叉点和端点等。

在手写汉字识别中,CBAM注意力模块的引入能够使模型更加关注汉字的关键特征,如笔画形状、结构关系等,从而提升对潦草汉字的识别能力。

汉字质量评价实现

以下是汉字质量评价的核心实现代码,该部分定义了多种特征提取和融合的方法。

python

class ChineseCharacterEvaluator:

def __init__(self, template_path):

self.template_dict = self.load_templates(template_path)

# 设置各特征权重

self.weights = {

'edit_distance': 0.15,

'pearson_corr': 0.25,

'jaccard_index': 0.20,

'cosine_similarity': 0.40

}

# 加载预训练的特征提取模型

self.feature_extractor = self.load_feature_extractor()

def load_templates(self, template_path):

# 加载模板字库

templates = {}

# 实际实现中会读取所有模板字的图像

return templates

def load_feature_extractor(self):

# 加载预训练的RepVGG模型作为特征提取器

model = RepVGG(num_classes=3755, deploy=True)

# 加载预训练权重

return model

def extract_structural_features(self, handwritten_img, template_img):

# 提取结构特征

features = {}

# 1. 最小编辑距离

# 首先进行骨架提取

handwritten_skeleton = self.extract_skeleton(handwritten_img)

template_skeleton = self.extract_skeleton(template_img)

# 转换为笔画序列

handwritten_seq = self.skeleton_to_sequence(handwritten_skeleton)

template_seq = self.skeleton_to_sequence(template_skeleton)

# 计算编辑距离

edit_dist = self.calculate_edit_distance(handwritten_seq, template_seq)

# 归一化到0-1范围

max_dist = max(len(handwritten_seq), len(template_seq))

features['edit_distance'] = 1 - min(edit_dist / max_dist, 1.0)

# 2. 皮尔森相关系数

features['pearson_corr'] = self.calculate_pearson_correlation(handwritten_img, template_img)

# 3. 杰卡德系数

features['jaccard_index'] = self.calculate_jaccard_index(handwritten_img, template_img)

# 4. 余弦相似度

features['cosine_similarity'] = self.calculate_cosine_similarity(handwritten_img, template_img)

return features

def extract_neural_features(self, handwritten_img, template_img):

# 使用神经网络提取特征

handwritten_feat = self.feature_extractor.extract_features(handwritten_img)

template_feat = self.feature_extractor.extract_features(template_img)

# 计算特征向量的余弦相似度

neural_similarity = torch.nn.functional.cosine_similarity(

handwritten_feat, template_feat, dim=0).item()

return neural_similarity

def evaluate(self, handwritten_img, character_label):

# 获取对应的模板字

if character_label not in self.template_dict:

return None, "Template not found"

template_img = self.template_dict[character_label]

# 提取结构特征

structural_features = self.extract_structural_features(handwritten_img, template_img)

# 提取神经网络特征

neural_similarity = self.extract_neural_features(handwritten_img, template_img)

# 融合结构特征

structural_score = 0

for key, value in structural_features.items():

structural_score += value * self.weights[key]

# 融合结构特征和神经网络特征

# 神经网络特征权重设置为0.6

final_score = 0.4 * structural_score + 0.6 * neural_similarity

# 转换为百分制

final_score = final_score * 100

# 划分等级

if final_score >= 90:

grade = "优秀"

elif final_score >= 80:

grade = "良好"

elif final_score >= 60:

grade = "合格"

else:

grade = "不合格"

return final_score, grade- 实现了汉字质量评价的核心功能,包括特征提取、特征融合和得分计算。评价过程首先提取手写汉字与模板字之间的多种结构特征,包括最小编辑距离、皮尔森相关系数、杰卡德系数和余弦相似度等。这些特征从不同角度描述了手写汉字的书写质量。

然后,使用预训练的RepVGG模型提取手写汉字的深层特征,并与模板字的特征进行比较,得到神经网络特征的相似度。最后,根据预设的权重对结构特征和神经网络特征进行加权融合,得到最终的评价得分。

在权重设置上,我们通过实验分析确定了各特征的重要性顺序:余弦相似度 > 皮尔森相关系数 > 杰卡德系数 > 最小编辑距离。同时,神经网络特征的权重设置为0.6,结构特征的权重设置为0.4,这种设置充分考虑了深度学习特征在评价中的重要作用。

评价结果不仅给出具体的百分制得分,还根据得分将汉字质量划分为优秀、良好、合格和不合格四个等级,方便用户直观地了解自己的书写水平。

重难点和创新点

研究难点

手写潦草汉字识别与评价系统的研究面临着多方面的挑战,主要包括以下几个难点:

-

手写汉字的多样性和变异性是一个巨大的挑战。不同人的书写风格各异,同一个人在不同时间、不同状态下的书写也会有所不同。尤其是潦草汉字,笔画粘连、变形严重,使得特征提取变得异常困难。如何设计一个能够适应这种多样性的模型,是研究的首要难点。

-

数据集的质量和规模对模型性能有很大影响。目前公开的手写汉字数据集虽然数量较多,但对于质量评价任务,缺乏标准的人工评价数据。构建一个包含多种潦草程度、覆盖常用汉字、标注准确的数据集,需要大量的人力和时间投入。

-

质量评价标准的客观性和一致性难以保证。不同的评价者可能有不同的评价标准,同一个评价者在不同时间的评价也可能存在差异。如何设计一套能够客观反映汉字书写质量的评价体系,使其结果与人工评价保持高度一致,是研究的关键难点。

-

模型的实时性和准确性之间存在权衡。深度神经网络模型通常具有较高的准确性,但计算复杂度也较高,难以满足实时应用的需求。如何在保证识别准确率的同时,提高模型的推理速度,是系统工程实现的重要挑战。

创新点

针对上述难点,本研究在多个方面进行了创新,主要包括以下几个创新点:

-

提出了一种基于RepVGG与注意力机制相结合的手写汉字识别模型。RepVGG网络通过结构重参数化技术,在训练时使用多分支结构提高性能,在推理时转换为单路结构提高速度,兼顾了性能和效率。我们创新性地将CBAM注意力机制嵌入到RepVGG网络中,使模型能够自适应地关注汉字的关键特征,如笔画形状、结构关系等,从而提升对潦草汉字的识别能力。

-

引入了SoftPool池化技术替代传统的池化方法。SoftPool通过Softmax归一化计算平滑的最大值,能够保留更多的空间信息和细节特征,对于笔画细小或粘连的潦草汉字尤为有效。

-

设计了一种结构特征与神经网络特征相结合的汉字质量评价方法。传统的汉字质量评价方法主要基于结构特征,如笔画完整性、结构规范性等,这些特征虽然直观,但难以捕捉汉字的整体美观度。我们创新性地将深度学习提取的高级特征引入评价体系,与传统结构特征进行融合,实现了更加全面、客观的质量评价。通过实验分析,我们确定了各特征的权重设置原则:余弦相似度 > 皮尔森相关系数 > 杰卡德系数 > 最小编辑距离,以及神经网络特征与结构特征的权重比例为6:4,使得评价结果更加合理。

-

实现了一个集识别与评价于一体的系统。传统的手写汉字处理系统通常只关注识别功能,忽略了质量评价的需求。我们设计的系统将识别和评价功能有机结合,用户上传一张手写汉字图像后,系统不仅能够识别出具体的汉字类别,还能够给出质量评价得分和等级,同时提供改进建议。这种一体化的设计大大提高了系统的实用性,为教育评估、个人练习等场景提供了有力支持。

此外,系统还具有良好的扩展性和可维护性。采用模块化设计,各个功能模块之间通过明确的接口进行通信,便于后续功能扩展和性能优化。界面设计简洁直观,支持多种图像导入方式和批量处理功能,能够满足不同用户的需求。

总结

本研究成功设计并实现了一套基于深度学习的手写潦草汉字识别与质量评价系统。该系统运用RepVGG网络、注意力机制和SoftPool池化等先进技术,解决了传统方法在潦草汉字识别上准确率低、评价标准不客观等问题,实现了从图像预处理、特征提取到识别评价的完整功能链路。

在理论研究方面,我们深入探讨了卷积神经网络、注意力机制、池化技术等在手写汉字处理中的应用。通过分析RepVGG网络的结构重参数化原理,我们发现其在保持模型性能的同时,能够显著提高推理速度,非常适合手写汉字识别这类实时性要求较高的任务。将CBAM注意力机制与RepVGG结合,能够使模型更加关注汉字的关键特征,提升对潦草汉字的识别能力。引入SoftPool池化技术,能够有效保留汉字的细节信息,进一步提高识别准确率。

在质量评价方法上,我们创新性地提出了结构特征与神经网络特征相结合的评价体系。通过提取多种结构特征(如最小编辑距离、皮尔森相关系数等)和深度学习特征,并进行合理的权重设置,实现了客观、准确的汉字质量评价。

在系统实现方面,我们采用模块化设计,将复杂的功能划分为图像预处理、手写汉字识别、汉字质量评价和系统界面等模块。界面基于PyQt5框架开发,具有良好的用户体验,支持图像上传、预处理、识别评价等功能,同时提供批量处理和结果导出等实用功能。

本研究的成果具有重要的理论意义和实际应用价值。从理论上讲,它进一步丰富了深度学习在手写汉字处理领域的应用研究,为相关算法的优化提供了新思路。从实际应用来看,该系统可以广泛应用于教育评估、文档数字化、身份认证等领域,为推动手写汉字的信息化处理提供有力支持。

当然,本研究也存在一些局限性。例如,数据集的规模和多样性还可以进一步扩大,以提高模型的泛化能力;模型的鲁棒性还可以进一步增强,以适应更复杂的应用场景;质量评价标准还可以更加细化,以提供更有针对性的改进建议。未来的研究可以在这些方向上继续深入,进一步提升系统的性能和实用性。

参考文献

1\] Liu L, Ouyang W, Wang X, et al. Deep Learning for Generic Object Detection: A Survey\[J\]. International Journal of Computer Vision, 2020, 128(2): 261-318. \[2\] Ding X, Zhang X, Ma N, et al. RepVGG: Making VGG-style ConvNets Great Again\[C\]. 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Nashville, TN, USA, 2021, 13728-13737. \[3\] Wang Q, Wu B, Zhu P, et al. ECA-net: Efficient channel attention for deep convolutional neural networks\[C\]. Proceedings of the IEEE/CVF conference on computer vision and pattern recognition, 2020, 11534-11542. \[4\] Woo S, Park J, Lee J.-Y, et al. Cbam: Convolutional block attention module\[C\]. Proceedings of the European conference on computer vision (ECCV), 2018, 3-19. \[5\] Stergiou A, Poppe R, Kalliatakis G. Refining activation downsampling with softpool\[C\]. Proceedings of the IEEE/CVF international conference on computer vision, 2021, 10357-10366. \[6\] Liu X, Hu B, Chen Q, et al. Stroke sequence-dependent deep convolutional neural network for online handwritten chinese character recognition\[J\]. IEEE Transactions on Neural Networks and Learning Systems, 2020, 31(11): 4637-4648. \[7\] Shu J, Zhu C, Shi S, et al. Ai empowered quantitative evaluation method for handwritten chinese character\[C\]. 2023 International Conference on Intelligent Education and Intelligent Research (IEIR), 2023, 1-6. \[8\] Li R, Zhang Z, Shi W, et al. Chinese character writing evaluation system based on image processing\[C\]. 7th International Conference on Computing, Control and Industrial Engineering (CCIE 2023), Singapore, 2023, 663-674. ## 最后