一、引言

随着大模型技术的普及,不管是企业开发者还是个人爱好者,都绕不开一个核心抉择:大模型到底该放在自己的设备上跑,还是直接调用云端服务商提供的接口?这个问题其实很好理解,我们可以用生活里的例子类比。本地部署就像是在家里自己做饭,我们需要花钱买厨房、买厨具、囤食材,过程虽然麻烦,但食材的新鲜度、烹饪的卫生标准全由自己掌控,而且吃的时候不用额外付费;云端调用则更像点外卖,我们不用准备任何工具,想吃什么直接下单,省时省力,但每次都要付配送费和餐费,而且食材的处理过程、厨房的卫生情况,其实是看不到的。

这两种方式的选择,本质上就是一场成本、隐私、效率以及部署方式的综合考量。今天我们从这个观点出发,对这两种方式做一个完整的介绍,顺便也复盘一下我通过线上api到本地微调部署的一个实践过程,供大家参考。

二、核心概念

1. 基础说明

1.1 大模型本地部署

- 简单而言就是把大模型的全套家当包括模型的权重文件、运行依赖的软件、处理数据的程序,全都安装在我们自己的服务器或者电脑上。

- 可以理解成把一个智能机器人完整地请到家里,它的所有思考和动作都在你眼皮底下完成,不会跑到别人家去。

- 这种方式的核心特点就是数据全程不出本地,完全自主可控,但前提是我们得有足够强大的房子来容纳这个机器人,也就是高性能的硬件设备。

1.2 大模型云端调用

- 不用下载和安装任何模型文件,直接通过网络连接,调用云服务商(比如千问、混元、OpenAI、百度智能云这些平台)已经部署好的大模型。

- 这就像我们手机里的语音助手,我们说话的时候,指令会通过网络传到服务商的服务器上,服务器里的大模型处理完,再把结果返回给我们。

- 它的核心特点是开箱即用,不用操心硬件和维护,但你的指令数据需要上传到云端,而且每用一次都可能需要付费。

1.3 推理

- 大模型工作的核心环节,不管是本地还是云端,都离不开它。

- 我们可以把推理理解成大模型"思考并生成答案" 的过程:当我们输入一个指令,比如 "写一篇关于春天的短文",大模型会根据自己训练好的海量数据和参数,一步步计算、组织语言,最后输出完整的短文。

- 这个过程非常消耗算力和内存,也是为什么大模型需要高性能硬件的原因。

1.4 API 接口

- 这是云端调用的接入许可证。API 全称是应用程序编程接口,我们可以把它想象成云端大模型的专属服务窗口。

- 开发者只需要按照服务商的要求,编写简单的代码,通过这个窗口发送指令和自己的身份凭证,就能拿到大模型返回的结果。

- 它的好处是标准化,不管你用什么编程语言,都能通过这个窗口和大模型对话,而且不用关心大模型在云端是怎么运行的。

2. 核心差异

2.1 从隐私安全角度看

- 本地部署是把门关起来做事,我们的所有数据都在自己的设备里流转,不会上传到任何外部平台,完全不用担心数据泄露;

- 而云端调用是开门请人帮忙,我们的指令数据必须传到云端服务器,虽然服务商都会承诺保护数据安全,但始终存在一定的隐私风险。

2.2 从成本投入角度看

- 本地部署是前期大出血,后期花费少,一开始需要花大价钱买高性能服务器、搭建运行环境,后期除了电费和少量维护费,基本不用再花钱;

- 而云端调用是前期投入少,后期细水长流,不用买任何硬件,注册账号就能用,但每调用一次都要按次数或字数付费,长期高频使用的话,成本会越来越高。

2.3 从效率体验角度看

- 本地部署的效率完全看家底,如果我们的硬件配置高,比如用的是带高端显卡的服务器,那么推理速度会很快;但如果硬件性能差,比如用普通家用电脑跑大模型,就可能出现卡顿、等待时间长的情况;

- 而云端调用的效率背靠大树好乘凉,云服务商拥有海量的高性能服务器集群,不管我们什么时候调用,都能快速响应,而且不用担心硬件瓶颈,唯一的短板就是依赖网络质量,如果网络卡顿,调用就可能失败。

2.4 从维护难度角度看

- 本地部署是自己当保姆,我们需要自己负责服务器的运维、模型的更新、软件环境的调试,遇到问题只能自己解决,对技术能力有一定要求;

- 而云端调用相当简单,所有的维护工作都由服务商负责,我们只需要专注于自己的业务逻辑,不用操心模型和服务器的问题。

三、基础原理与执行流程

1. 大模型运行的基本原理

不管是本地部署还是云端调用,大模型的核心工作流程其实是一样的,都是"输入→推理→输出"的三步曲,区别只在于"推理"这个环节发生的位置不同。

1.1 第一步:输入

- 就是用户把自己的需求以文本形式发送给大模型,比如"帮我写一个会议通知"、"解释一下什么是大模型量化"。

- 这个输入就像是给大模型下达的任务指令。

1.2 第二步:推理

- 这是最核心的一步。大模型接收到指令后,会调取自己训练好的参数库,通过复杂的算法计算,理解用户的需求;

- 然后生成对应的回答。这个过程就像是我们给一个学霸出了一道题,学霸在脑子里调取知识点、分析解题思路

- 最后整理出答案的过程。推理过程需要消耗大量的算力,这也是大模型对硬件要求高的根本原因。

1.3 第三步:输出

- 大模型把推理生成的结果以文本形式返回给用户,完成整个工作流程。

2. 本地部署执行流程

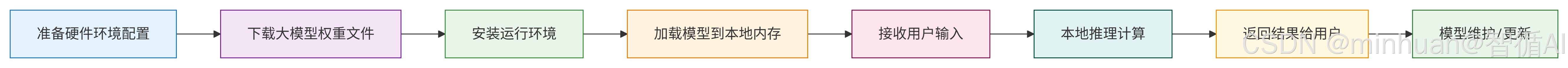

本地部署的核心,就是把 "输入→推理→输出" 的全过程,都放在自己的硬件设备上完成。下面是详细的执行流程,我们用流程图直观展示,再逐步拆解。

流程详解:

2.1 第一步:准备硬件

- 这是本地部署的前提条件,我们需要准备一台算力足够的设备,比如带RTX 4090 这类高端显卡的服务器或者电脑。为什么需要高端显卡?因为大模型的推理过程需要大量的并行计算,显卡的 GPU 就是专门干这个活的,普通电脑的 CPU 根本扛不住。

2.2 第二步:下载大模型权重文件

- 权重文件是大模型的核心,它就像是大模型的知识库,包含了模型训练好的所有参数。我们可以从 Hugging Face、ModelScope 这些公开的模型仓库下载,比如 Llama 3、Qwen、GLM 这些常用的大模型,都有对应的本地版权重文件。需要注意的是,大模型的权重文件通常很大,比如 7B 参数的模型就有十几 GB,13B 参数的模型有几十 GB,下载的时候需要耐心等待。

2.3 第三步:安装运行环境

- 大模型不能直接运行,需要依赖特定的软件框架。我们需要先安装 Python 编程语言,然后安装 PyTorch、Transformers 这些深度学习框架,这些框架是运行大模型的必备工具。安装过程中要注意版本匹配,比如 Transformers 的版本要和模型的要求一致,不然可能会出现运行报错。

2.4 第四步:加载模型到本地内存

- 这一步是把下载好的权重文件,导入到安装好的运行环境中,让模型活起来。

- 加载模型的过程需要消耗大量的内存和显存,如果我们的硬件配置不够,可能会出现内存不足的报错。

- 比如运行一个 7B 参数的模型,至少需要 16GB 以上的显存,不然根本加载不起来。

2.5 第五步:接收用户输入

- 用户通过本地的客户端,比如一个简单的网页界面或者命令行工具,提交自己的指令,比如"写一篇关于大模型本地部署的介绍"。

2.6 第六步:本地推理计算

- 这是本地部署的核心环节,模型在我们的本地硬件上完成推理过程,不需要连接任何外部网络。

- 推理的速度取决于我们的硬件性能,硬件越好,生成结果的速度就越快。比如用 RTX 4090 显卡运行 7B 参数的模型,生成一段 200 字的文本,可能只需要几秒钟;而用普通电脑的 CPU 运行,可能需要几分钟甚至更久。

2.7 第七步:返回结果给用户

- 模型把推理生成的结果返回给本地客户端,用户就能看到最终的回答了。

2.8 第八步:模型维护/更新

- 本地部署不是一劳永逸的,我们需要定期维护服务器,比如清理内存、更新软件框架;同时还要关注模型的新版本,及时下载更新权重文件,让模型的 知识库保持最新。

3. 云端调用执行流程

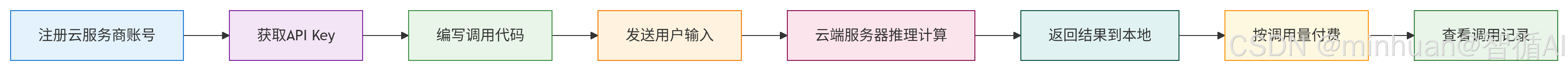

云端调用的核心,是把"推理"环节放在云服务商的服务器上完成,用户只需要负责"输入"和"接收输出"。下面是详细的执行流程,同样用流程图展示,再拆解说明。

流程详解:

3.1 第一步,注册云服务商账号

- 我们需要先选择一个提供大模型 API 服务的平台,比如 OpenAI、千帆大模型平台、百炼、混元等,然后注册一个账号。

3.2 第二步,获取 API Key

- 注册账号后,我们需要在平台的控制台里申请一个 API Key,这个 Key 是我们的专属身份凭证,每次调用大模型的时候,都需要带上这个 Key,平台才能识别我们的身份,并且记录我们的调用次数,方便后续计费。

3.3 第三步,编写调用代码

- 我们需要按照云服务商提供的文档,编写一段简单的代码,配置好请求参数;

- 比如选择哪个大模型、生成文本的最大长度、温度系数(控制生成内容的随机性)等

3.4 第四步,发送用户输入

- 用户通过我们的客户端提交指令后,我们的代码会把指令内容和 API Key 一起,通过网络发送到云服务商的服务器上。

3.5 第五步,云端服务器推理计算

- 云服务商的服务器接收到我们的请求后,会在自己的高性能服务器集群上运行大模型,完成推理过程。

- 云服务商的硬件配置通常非常高,用的是很多高性能显卡组成的集群,所以推理速度非常快,不管是多大的模型,都能在几秒钟内返回结果。

3.6 六步,返回结果到本地

- 云端服务器把推理生成的结果,通过网络传回我们的本地客户端,用户就能看到最终的回答了。

3.7 第七步,按调用量付费

- 云服务商会根据我们的调用次数或者生成文本的字数,扣除相应的费用。

- 计费方式通常是按"tokens" 计算,一个 tokens 大概对应一个汉字或者一个英文单词,价格从几分钱到几毛钱不等,具体取决于模型的大小和性能。

3.8 第八步,查看调用记录

- 我们可以在云服务商的控制台里,查看自己的调用记录和费用明细,了解自己的使用情况,方便控制成本。

四、成本、隐私、效率的考量

1. 成本考量:前期投入 vs 长期付费

成本是很多人选择部署方式的首要考虑因素,我们分两种情况详细分析,结合具体的场景和数据,让我们一眼看明白哪种方式更省钱。

1.1 本地部署的成本特点:前期高投入,后期零边际成本

本地部署的成本主要集中在前期也就是硬件采购和环境搭建阶段。

- 一台能流畅运行 7B 参数大模型的服务器,大概需要花费 1-2 万元;

- 如果要运行 13B、34B 甚至更大的模型,需要更高端的显卡和更大的内存,成本会飙升到 5 - 10 万元,甚至更高。

- 除了硬件成本,还有机房维护成本,比如服务器需要放在恒温恒湿的机房里,需要专人负责运维,这些都是前期的固定投入。

但是,一旦前期投入完成,后期的使用成本就非常低了。

- 我们不需要为每次调用付费,只需要支付电费和少量的维护费。比如一台服务器的功率大概是 500 瓦,一天 24 小时运行,电费大概是 10 元左右,一个月也就 300 元。

- 对于高频次使用的场景,比如企业内部的客服机器人,每天需要处理上万次用户咨询,本地部署的长期成本优势非常明显。

举个例子:

- 假设一个企业每天调用大模型 1 万次,采用云端调用的话,按 0.01 元 / 千 tokens 计算,每天的费用大概是 100 元,一个月就是 3000 元,一年就是 3.6 万元。

- 而如果采用本地部署,前期投入 5 万元,后期每年的电费和维护费大概是 5000 元,两年就能收回成本,之后的使用几乎是免费的。

1.2 云端调用的成本特点:前期零投入,后期按用量付费

云端调用的前期成本几乎为零,我们不需要买任何硬件,只需要注册一个账号,申请一个 API Key,就能开始使用。

- 这对于个人开发者或者小型企业来说,非常友好,不用承担高昂的硬件成本,就能享受到大模型的服务。

但是,云端调用的长期成本是无底洞,使用次数越多,成本越高。

- 比如个人开发者做一个小工具,每月调用大模型 1000 次,每次生成 100 个 tokens,费用大概是 1 元,完全可以承受;

- 但如果是企业级应用,每月调用次数达到 10 万次,费用就会涨到 1000 元,长期下来是一笔不小的开销。

另外,云端调用还有一些隐藏成本,比如网络延迟导致的重复调用、API Key 泄露导致的恶意调用等,这些都可能增加你的使用成本。

1.3 成本考量的建议

- 高频次、大规模使用,选本地部署更省钱;

- 低频次、小规模使用,选云端调用更划算。

2. 隐私考量:数据自主可控 vs 依赖服务商安全

隐私安全是企业选择部署方式的核心考量因素,尤其是金融、医疗、政务等对数据敏感的行业,数据泄露可能会带来灾难性的后果。

2.1 本地部署的隐私优势:数据 足不出户,零泄露风险

本地部署最大的优点,就是数据全程在本地流转,不会上传到任何外部平台。

- 用户的指令数据、模型的推理过程、生成的结果,都在企业自己的服务器上完成,完全自主可控。

- 我们可以根据自己的需求,搭建严格的安全防护体系,比如设置防火墙、数据加密、访问权限控制等,确保数据的安全。

举个例子:

- 医院用大模型处理患者的病历数据,如果采用本地部署,病历数据不会离开医院的内网,不用担心患者的隐私信息泄露;

- 如果采用云端调用,病历数据需要上传到云端,虽然云服务商会承诺保护数据安全,但依然存在被黑客攻击或者内部人员泄露的风险。

2.2 云端调用的隐私风险:数据出门在外,依赖第三方保护

云端调用的隐私风险主要来自两个方面:一是数据传输过程中的风险,二是云服务商的内部风险。

- 数据传输过程中,指令数据需要通过网络发送到云端,虽然云服务商会采用加密传输技术,但依然存在被黑客截获的风险;

- 数据到达云端后,会存储在服务商的服务器上,虽然服务商承诺不会泄露用户数据,但如果服务商的安全防护措施不到位,或者出现内部人员违规操作,数据就可能被泄露。

另外,很多云服务商的用户协议里,会包含 "有权使用用户数据进行模型优化" 的条款,这意味着w我们的指令数据可能会被用来训练服务商的大模型,虽然服务商通常会匿名化处理,但依然存在隐私泄露的风险。

2.3 隐私考量的建议

- 处理敏感数据,选本地部署;

- 处理非敏感数据,选云端调用。

3. 效率考量:硬件限制 vs 云端算力无限

效率体验直接影响用户的使用感受,谁都不想输入一个指令后,等半天才能看到结果。效率博弈的核心,就是硬件性能和网络质量的较量。

3.1 本地部署的效率瓶颈:看硬件家底,性能上限固定

本地部署的效率完全取决于硬件配置,硬件越好,效率越高。

- 如果我们的服务器配备了高端显卡,比如 NVIDIA A100,运行 7B 参数的模型,推理速度可以达到每秒生成 100 个 tokens 以上,几乎是实时响应;

- 但如果我们的硬件配置很低,比如用普通家用电脑的 CPU 运行,推理速度可能只有每秒几个 tokens,生成一段 200 字的文本需要几分钟,体验非常差。

- 另外,本地部署的硬件性能上限是固定的,如果我们想运行更大的模型,比如 175B 参数的 GPT-3,需要更高端的硬件,这意味着我们需要再次投入资金升级设备。

3.2 云端调用的效率优势:背靠算力大厂,性能无限扩容

云端调用的效率优势非常明显,云服务商拥有海量的高性能服务器集群,能够轻松应对大规模的并发请求。

- 不管我们什么时候调用,不管调用多少次,都能快速响应,而且不用担心硬件瓶颈。

- 比如我们需要运行 175B 参数的大模型,本地部署几乎不可能,但云端调用只需要在代码里切换一下模型名称,就能立即使用。

云端调用的唯一短板是依赖网络质量,如果我们的网络卡顿或者断网,就无法调用大模型。比如在偏远地区或者网络不稳定的环境下,云端调用的体验会大打折扣。

3.3 效率考量的建议

- 网络稳定、追求高性能,选云端调用;

- 网络不稳定、对硬件有自主控制权,选本地部署。

五、对大模型应用的意义

本地部署和云端调用的并存,不是非此即彼的竞争,而是相辅相成的互补,它们共同推动了大模型技术的普及和落地,对大模型应用的发展有着至关重要的意义。

1. 降低大模型的使用门槛,推动技术普及

云端调用的出现,让大模型的应用场景更贴合实际,个人开发者和小型企业不用承担高昂的硬件成本,就能享受到大模型的服务,这极大地降低了大模型的使用门槛。比如一个小型创业公司,不用组建技术团队,就能通过云端调用,快速开发出一款大模型应用。

而本地部署则让大模型能够在更多特殊场景下落地,比如无网络的环境、对数据隐私要求极高的行业,这些场景是云端调用无法覆盖的。两者的结合,让大模型的应用范围变得更加广泛。

2. 满足不同场景的差异化需求,促进行业落地

不同的行业和场景,对大模型的需求是不同的。

- 金融行业需要处理大量的敏感数据,对隐私安全要求极高,本地部署是最佳选择;

- 电商行业需要处理大规模的用户咨询,对效率和并发能力要求高,云端调用更合适;

- 而一些混合场景,比如企业核心数据本地处理,非敏感数据云端增强,则可以采用本地和云端的混合模式。

本地部署和云端调用的并存,让大模型能够满足不同场景的差异化需求,促进了大模型在金融、医疗、政务、电商等多个行业的落地应用。

3. 推动大模型技术的迭代升级

本地部署的需求,推动了轻量化大模型的发展。为了让大模型能够在普通硬件上运行,服务商不断优化模型结构,推出了一系列小参数、高性能的轻量化模型,比如 7B、13B 参数的 Llama 3、Qwen 等,这些模型在保持高性能的同时,大大降低了硬件要求。

而云端调用的需求,则推动了大模型 API 服务的优化。云服务商为了吸引用户,不断提升 API 的响应速度、降低调用成本、增加模型的功能,比如支持多模态输入输出、提供个性化定制服务等。

两者的相互促进,让大模型技术不断迭代升级,变得越来越强大、越来越易用。

六、几种调用方式

1. 本地部署代码示例

本地运行轻量化大模型(如 Qwen-2 7B),从 Hugging Face 官网下载 Qwen-2 7B 模型权重文件,并存放在本地文件夹

python

# 1. 导入必要的库

from transformers import AutoTokenizer, AutoModelForCausalLM

# 2. 配置模型路径:替换为你本地的模型权重存放路径

model_path = "./qwen2-7b-instruct"

# 3. 加载分词器和模型

# 分词器的作用:把用户的文本指令转换成模型能理解的数字格式

tokenizer = AutoTokenizer.from_pretrained(model_path)

# model = AutoModelForCausalLM.from_pretrained(

# model_path,

# device_map="auto" # 自动分配模型到GPU/CPU,优先使用GPU

# )

# 4. 接收用户输入:这里以手动输入为例

user_input = input("请输入你的指令:")

# 构造提示词:让模型更准确地理解用户需求

prompt = f"用户指令:{user_input}\n请给出清晰易懂的回答,语言简洁:"

# 5. 处理输入:把提示词转换成模型能处理的张量格式

inputs = tokenizer(prompt, return_tensors="pt").to(model.device)

# 6. 本地推理:生成回答

outputs = model.generate(

**inputs,

max_new_tokens=200, # 生成文本的最大长度,防止生成过长内容

temperature=0.7, # 温度系数,越小生成的内容越严谨,越大越随机

do_sample=True # 开启采样模式,让生成的内容更自然

)

# 7. 解码输出:把模型生成的数字格式转换成文本格式

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

# 8. 打印结果

print("模型回答:")

print(response)2. 云端调用代码示例

调用云端大模型 API,无需本地硬件,分别通过千问、混元、千帆的api-key形式简单说明

2.1 千问的API调用

python

import os

from openai import OpenAI

# 从环境变量中,获取 DASHSCOPE_API_KEY

api_key = os.environ.get('DASHSCOPE_API_KEY')

client = OpenAI(

# 若没有配置环境变量,请替换为:api_key="sk-xxx",

api_key=api_key,

base_url="https://dashscope.aliyuncs.com/compatible-mode/v1", # 填写DashScope服务的base_url

)

completion = client.chat.completions.create(

model="qwen-plus", # 此处以qwen-plus为例,可按需更换模型名称

messages=[

{'role': 'system', 'content': '你是一个快乐的小助手'},

{'role': 'user', 'content': 'AI大模型可以为我们做些什么?'}],

extra_body={

"enable_search": True

}

)

print(completion.model_dump_json())2.2 混元大模型的API调用

python

import json

import os

from openai import OpenAI

# 注意:这个接口可能需要企业版或特殊申请

# 请参考腾讯云官方文档确认当前可用的OpenAI兼容接口地址

# api_key = os.environ.get('TENCENT_API_KEY')

api_key = 'sk-bWlJPKjB*******************0sBVXvZ5NP8Ze'

client = OpenAI(

api_key=api_key,

# base_url可能需要根据腾讯云的最新文档进行修改

base_url="https://api.hunyuan.cloud.tencent.com/v1",

)

try:

completion = client.chat.completions.create(

model="hunyuan-lite", # 模型名称

messages=[

{'role': 'system', 'content': '你是一个快乐的小助手'},

{'role': 'user', 'content': 'AI大模型可以为我们做些什么?'}

],

# 注意:腾讯混元可能不支持extra_body参数,或者参数名不同

# extra_body={

# "enable_search": True # 联网搜索可能需要其他方式开启

# }

)

# 输出JSON格式

print(json.dumps(completion.model_dump(), ensure_ascii=False, indent=2))

except Exception as e:

print(f"调用失败: {e}")

print("\n建议使用腾讯云官方SDK(第一个方案)进行调用")2.3 千帆大模型API调用

python

# 1. 导入千帆SDK的聊天完成模块

from qianfan import ChatCompletion

# 2. 配置密钥:替换为你自己的API Key和Secret Key

ak = "your_api_key"

sk = "your_secret_key"

# 3. 创建聊天客户端:初始化连接

chat_completion = ChatCompletion(ak=ak, sk=sk)

# 4. 发送请求:调用云端大模型

response = chat_completion.do(

model="ERNIE-4.0", # 选择要调用的大模型,比如ERNIE-4.0、ERNIE-3.5等

messages=[{

"role": "user", # 消息角色,这里是用户

"content": "请写一篇关于大模型云端调用的简短介绍,100字左右" # 用户指令

}],

temperature=0.7, # 温度系数,控制生成内容的随机性

max_tokens=100 # 生成文本的最大长度

)

# 5. 解析结果:打印模型生成的内容

print("云端模型回答:")

print(response["result"])每个方式都要到对应的平台去申请api-key,基本都会有一定量的测试token。

七、选型建议

看到这里,相信大家已经对两种部署方式有了全面的了解。最后我们给出简单明了的选型建议,帮大家快速做出决策。

1. 选本地部署:

- 如果是企业用户,需要处理金融、医疗、政务等敏感数据;

- 对大模型的调用频次很高,每天达到上万次,长期使用成本高;

- 需要在无网络或者网络不稳定的环境下使用大模型;

- 或者对模型的自主控制权要求高,需要根据自己的需求定制模型。

2. 选云端调用:

- 如果是个人开发者或者小型企业,预算有限,不想承担硬件成本;

- 如果只是做小项目测试,调用频次低,每月不超过 1 万次;

- 我们追求快速上线,不想花时间维护硬件和模型;

- 或者我们需要使用超大参数的大模型,比如 175B 参数的 GPT-3,本地部署无法实现。

3. 选混合模式:

- 如果需要处理部分敏感数据和部分非敏感数据;

- 希望用本地模型处理核心业务,用云端模型进行功能扩展;

- 或者想平衡成本、隐私和效率,实现最优的使用体验。

八、总结

其实说到底,本地部署和云端调用没有绝对的好坏,只有适合不适合。本地部署就像是自己买房住,前期需要花一大笔钱,但住进去之后,想怎么装修就怎么装修,想怎么用就怎么用,不用看别人脸色,而且长期下来很划算;云端调用就像是租房住,前期不用花钱,拎包入住,灵活方便,但是每月都要交房租,而且不能随意改造房子,长期下来成本不低。

成本、隐私、效率这三个因素,就像是一个三角架,缺了任何一个都不行。刚开始接触在选择的时候,不用纠结,先想清楚自己的核心需求,是更看重数据安全,还是更在意成本和效率?想明白这一点,答案就一目了然了。

随着大模型技术的发展,本地模型会越来越轻量化,普通电脑也能轻松运行;云端服务会越来越便宜,调用成本会不断降低。未来两者的界限会越来越模糊,混合模式会成为主流。但不管怎么变,按需选择永远是王道!