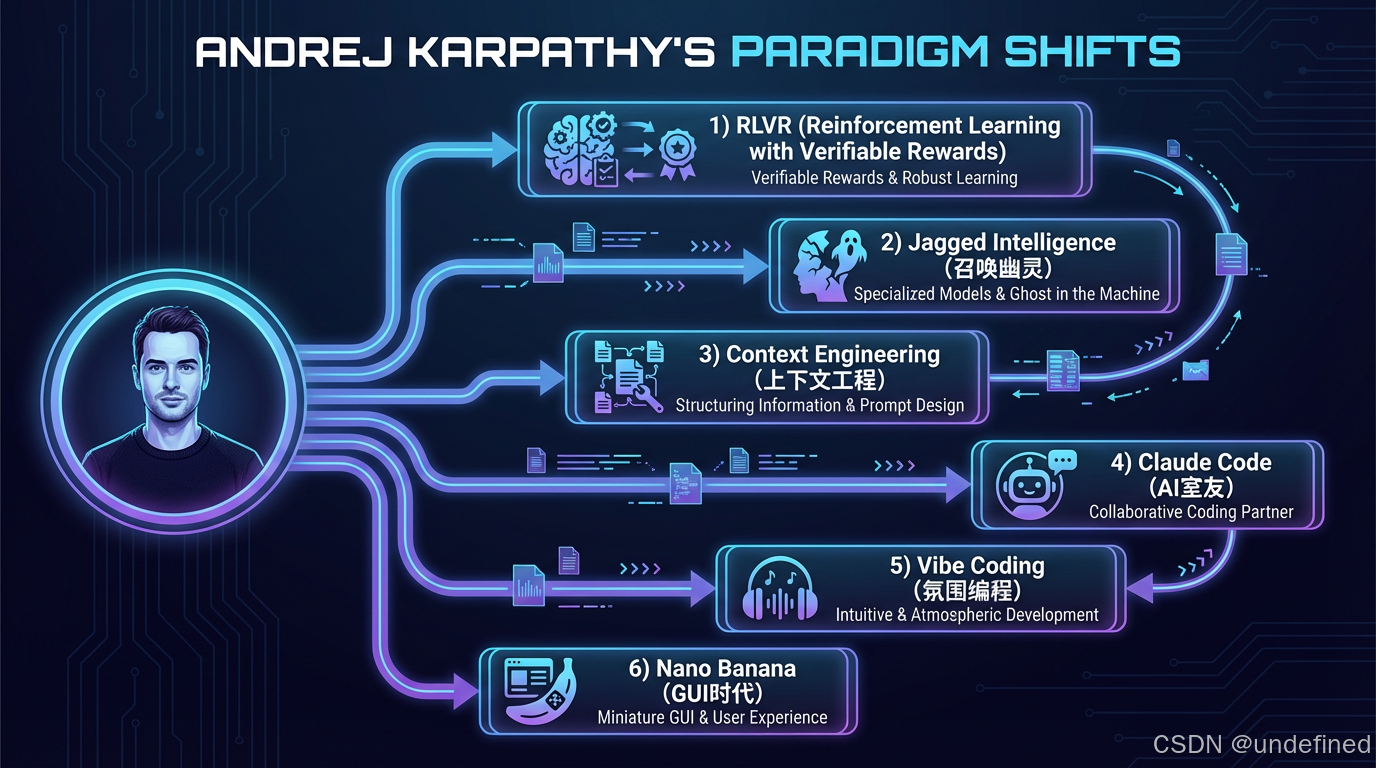

Andrej Karpathy:过去一年大模型的六个关键转折

本文共 2836 字,阅读预计需要 4 分钟。

一边是模型光靠"多想一会儿"就能解出奥数题,另一边是刷爆排行榜的选手被用户吐槽"中看不中用"。

2025年的AI圈,弥漫着一股诡异的气息:

参数规模不再是唯一的军备竞赛指标,但模型能力却在某些维度上狂飙突进。

这到底发生了什么?

Andrej Karpathy------前OpenAI研究总监、曾掌舵特斯拉AI团队的技术大牛------在年终复盘中抛出了一个判断:

2025年LLM的真正突破,不在于模型变大,而在于我们"驯养"它的方式、理解它的视角、以及使用它的姿势,都发生了根本性的变化。

这篇文章,我会带你拆解Karpathy眼中的六个范式转变,聊聊它们对普通人意味着什么,以及有哪些坑是你现在就该绕开的。

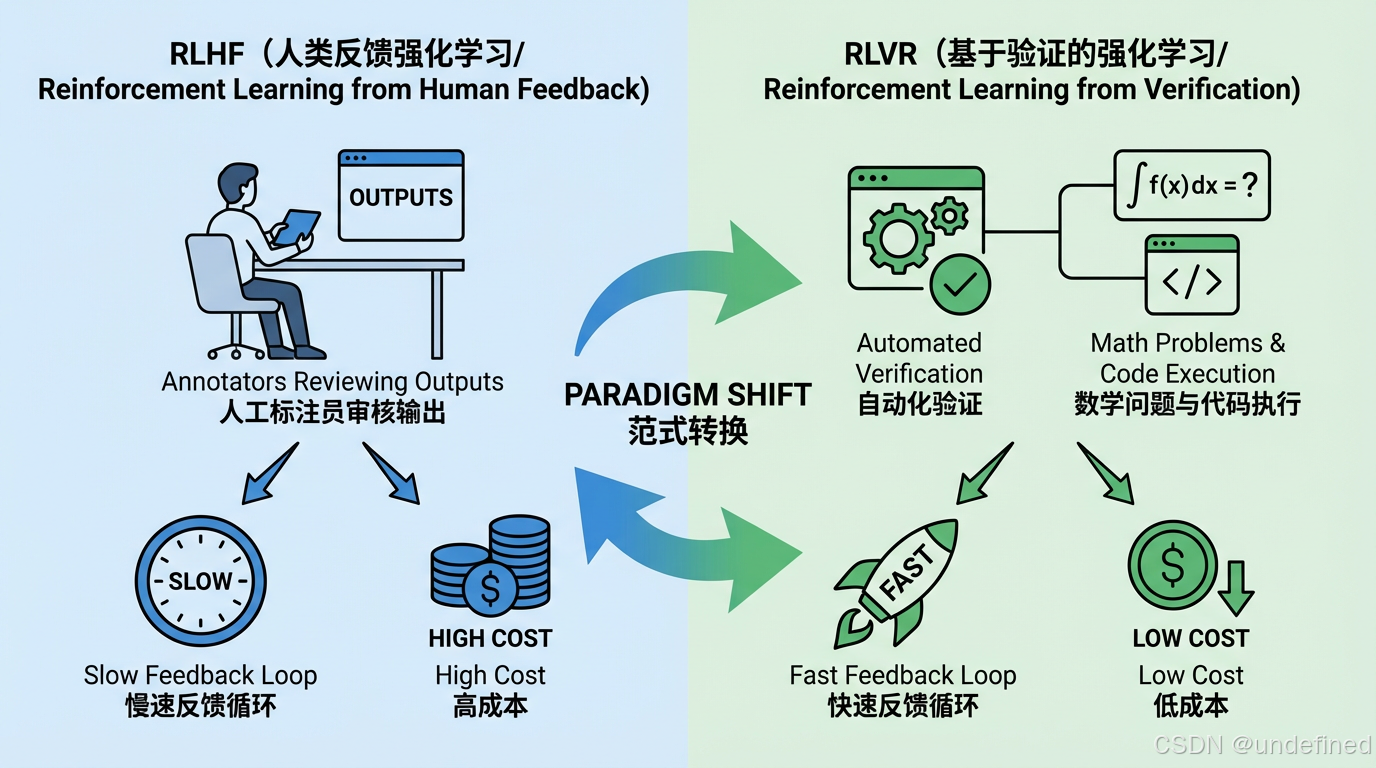

一、RLVR:训练范式的静默换代

2024年之前,大模型训练三板斧:预训练、监督微调、RLHF。但RLHF的瓶颈很明显------依赖人工标注,成本高、速度慢。

2025年,RLVR(基于可验证奖励的强化学习)开始上位。核心逻辑很简单:用有标准答案的任务来训练。数学题对不对?代码能不能跑?机器自己就能验证。

打个比方:RLHF像请老师批改作文,标准不一;RLVR像做数学卷子,对就是对、错就是错。

RLVR还解锁了一个调节旋钮:让模型"多想一会儿"

生成更长的推理链,就能换来更强能力。OpenAI的o1到o3,DeepSeek的R1,都是这条路线的产物。

以前比谁模型参数多,现在比谁的强化学习跑得久。

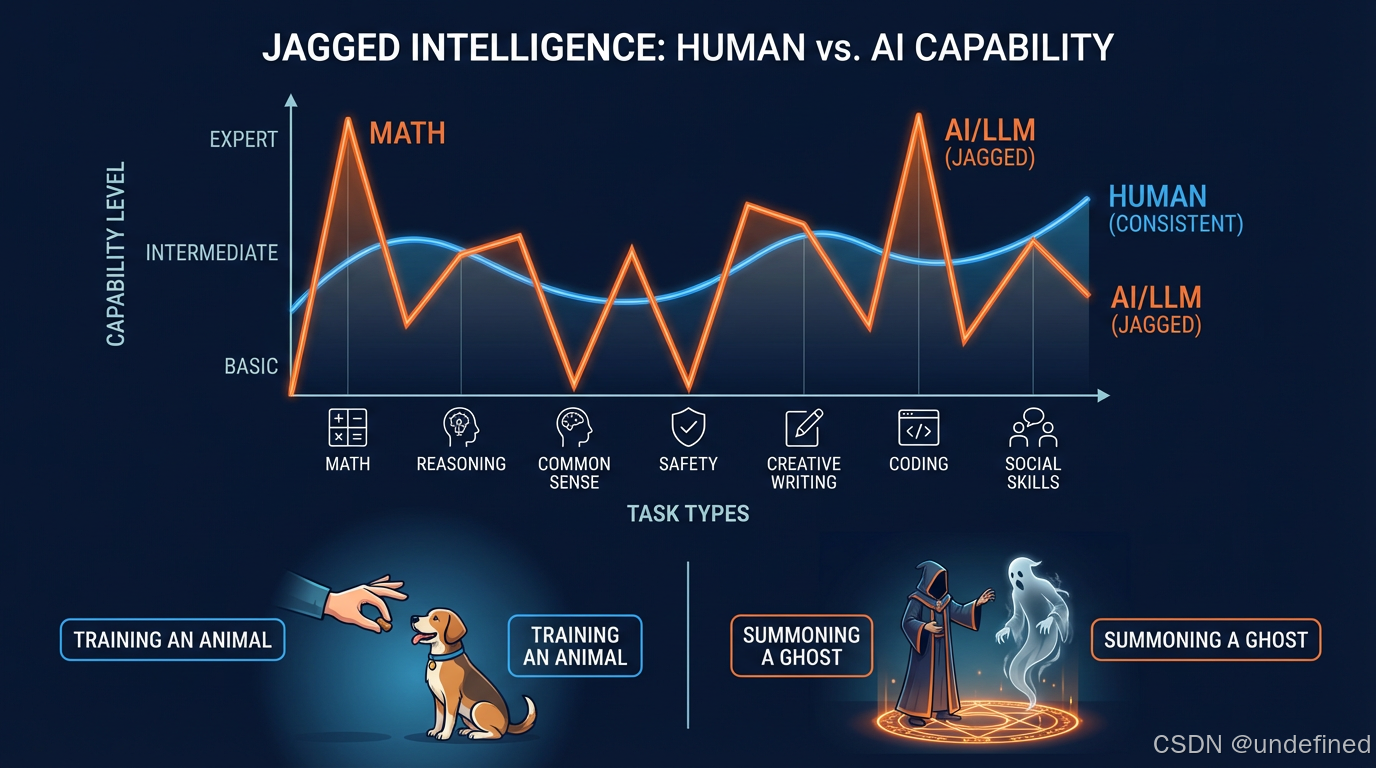

二、召唤幽灵,而非驯养动物

Karpathy用了一个隐喻:我们不是在"培育动物",而是在"召唤幽灵"。

动物智能是进化塑造的,能力配合天衣无缝。

但LLM的"大脑"是为了预测下一个词、在数学题里拿分------这些目标和生存没关系。

结果就是"锯齿状智能":某些任务碾压专家,另一些任务犯低级错误。

它能写出逻辑严密的报告,但是转头就被越狱提示词骗了。

实际后果是:别迷信基准测试。 LLM团队为了刷榜,围绕测试题大量生成训练数据,榜单漂亮,实际用起来翻车。

幽灵的能力是尖刺的、不可预测的。用的时候,得时刻警惕。

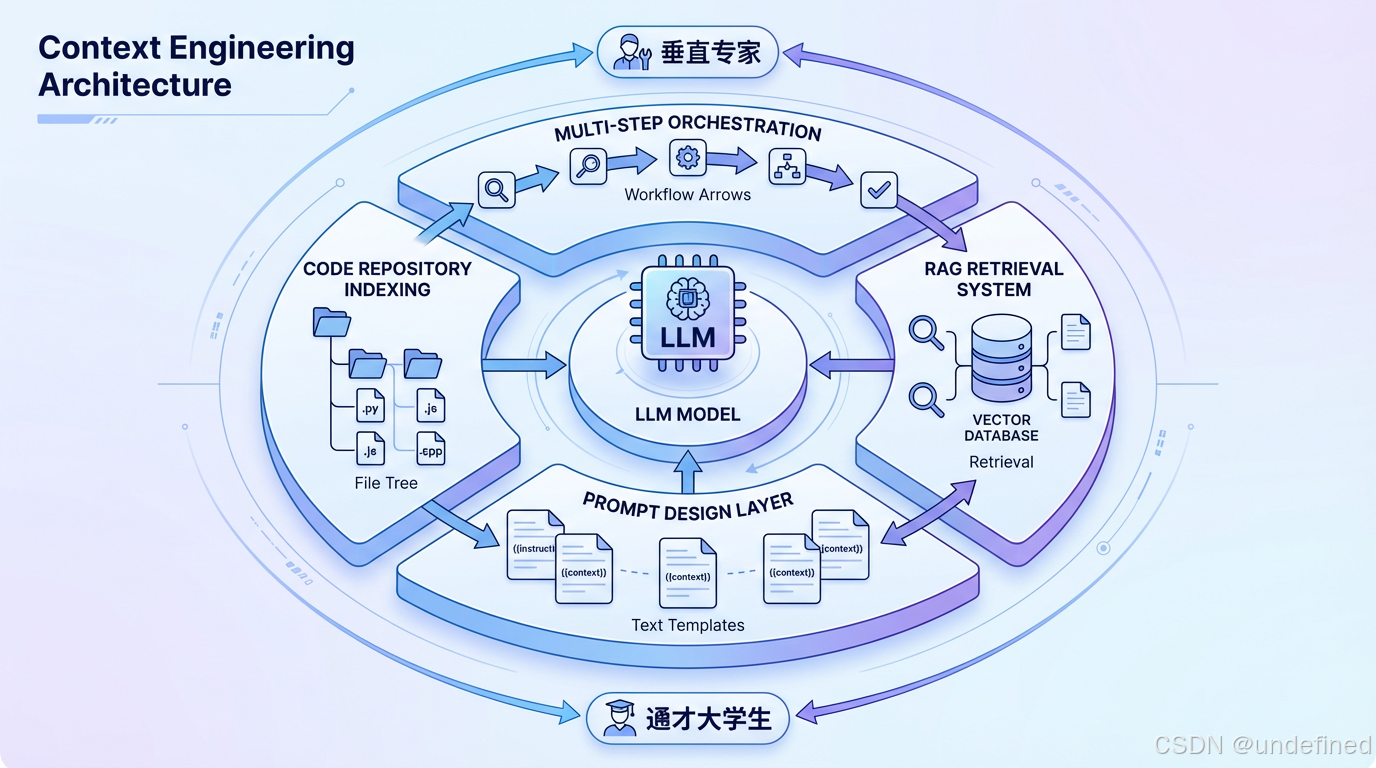

三、Cursor与新应用层:上下文工程的价值爆发

2025年,Cursor没有自己训练模型,但估值从4亿飙到99亿美元。它做对了什么?

答案是上下文工程------在调用大模型时,精心设计给它的信息环境:提示词怎么写、代码库怎么索引、多次调用怎么编排。

Karpathy的观点是:LLM实验室培养"通才大学生",应用层把他们培养成"垂直专家"。桥梁就是上下文工程。

直接问ChatGPT和用Cursor写代码,体验天差地别。Cursor自动索引代码仓库,理解文件依赖,提问时自动塞入相关上下文。这不是模型能力差距,是信息组织方式的差距。

启示很清晰:模型会迭代,但上下文工程能力可以沉淀,能无缝迁移到下一代模型。

这也是我一直以来坚持上下文工程优先的原因。

四、Claude Code:AI从"网站"变成"室友"

Claude Code是Anthropic推出的命令行工具,特别之处在于:直接运行在本地电脑上,访问你的文件、配置、密钥。后续Copilot等工具也相继推出了这样的开发模式。

Karpathy说:它不再是需要打开浏览器的网站,而是"寄居"在电脑里的小精灵。

本地运行的好处:AI直接读取电脑上的上下文------装了哪些软件、项目代码长什么样,不需要手动复制粘贴。

更重要的是延迟和隐私------云端来回几百毫秒,敏感数据发到第三方合规部门不同意。

当然也有隐患:一个能操作本地文件的AI,权限边界怎么划定?

五、Vibe Coding:代码正在变得廉价

Karpathy造了个词叫"Vibe Coding"------氛围编程。

用自然语言描述需求,AI帮你写代码,你甚至不需要"懂"代码。

2025年这事跨过了临界点。之前AI写代码问题多,需要人debug。现在很多简单项目,从想法到可运行程序,一气呵成。

Karpathy自己用它写了Rust版tokenizer(不需要学Rust)、做了好几个小应用原型、甚至写过临时应用定位bug------用完就扔。

他的原话是:代码变得廉价、短暂、可塑、用完即弃。

对普通人意味着什么?"我有想法但不会代码"这个门槛,正在消失。

六、Nano Banana:LLM的GUI时代前奏

Google的Gemini Nano Banana让Karpathy特别兴奋。

核心不是图像生成能力,而是文本、图像与世界知识在模型权重中的深度融合。

现在"跟LLM对话"像1980年代敲命令。文本是机器原生语言,但人更喜欢视觉化呈现------这正是GUI被发明的原因。

LLM也需要自己的GUI------用图片、信息图、动画跟我们沟通。Nano Banana就是这个方向的早期预演。

写在最后:可立即落地的三个建议

拉回来说说,这六个范式转变对你意味着什么。

如果你是创业者,最重要的启示是:模型能力会继续涨,但涨的方式变了。与其追着模型跑,不如在上下文工程上建立壁垒。Cursor的成功已经证明了这条路。

如果你是开发者,Vibe Coding值得你认真对待。不是说它会取代你,而是说它能让你的生产力翻倍。把重复性的代码工作交给AI,把精力放在架构设计和业务逻辑上。

如果你是普通用户,最重要的是调整预期。AI既不是全能的神,也不是彻底的废物------它是一个能力极度不均匀的"幽灵"。用好它的尖刺能力,同时对它的盲区保持警惕。

三个行动建议,作为结束:

投资上下文工程能力。学会设计提示词、组织RAG检索、编排多步调用,这是当下性价比最高的AI技能。

用Vibe Coding降低创意落地门槛。你脑子里的想法,别再等"等我学会编程再说",现在就可以试着让AI帮你实现。

理解锯齿状智能,设置人工校验。在享受AI效率提升的同时,别忘了在关键环节保留人工把关。

2025年是LLM的分水岭。规则变了,玩法也得跟着变。

2026年,又会有什么新的成果出现呢?评论区聊聊你的看法

既然看到这了,如果觉得不错,随手点个赞、收藏、转发三连吧~

我是Carl,大厂研发裸辞的AI创业者,只讲能落地的AI干货。

关注我,更多AI趋势与实战,我们下期再见!

数据来源

Karpathy 2025年终复盘原文 [数据|2025|https://karpathy.bearblog.dev/year-in-review-2025/\]

RLVR训练范式说明:基于可验证奖励的强化学习 [数据|2025|Karpathy原文]

DeepSeek R1推理能力展示 [数据|2025|DeepSeek R1论文]

Cursor估值变化:400M(2024.8) → 9.9B(2025.6) [数据|2024-2025|https://techcrunch.com/tag/cursor/\]

OpenAI o1/o3推理模型发布 [数据|2024-2025|OpenAI官方]

Claude Code产品发布与功能说明 [数据|2025|Anthropic官方]

Vibe Coding概念由Karpathy在Twitter提出 [数据|2025|https://x.com/karpathy/status/1886192184808149383\]

Google Gemini Nano Banana多模态融合能力 [数据|2025|Google官方]