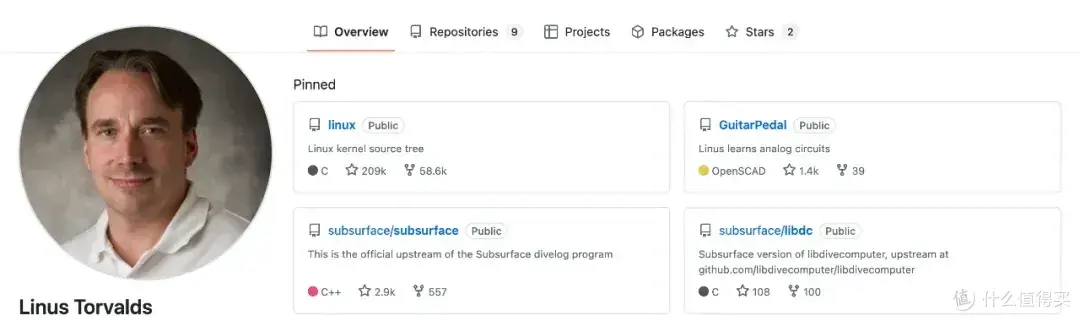

容器为什么能隔离进程?Kubernetes 怎么限制 Pod 资源?eBPF 监控的原理是什么? 这些问题的答案,都指向同一个开源项目------Linux Kernel。它是 Linus Torvalds 在 1991 年创建的操作系统内核,如今已成为云计算基础设施的技术基石。

什么是 Linux Kernel

Linux Kernel 是 Linux 操作系统的核心组件,负责管理硬件资源、调度进程、分配内存、处理网络数据包。所有运行在 Linux 系统上的应用程序,都需要通过内核才能使用 CPU、内存、磁盘、网卡等硬件资源。

对于运维工程师来说,理解内核工作原理意味着:

- 排查故障时能直达问题根源

- 性能调优时知道瓶颈在哪

- 容器化部署时明白底层机制

五大核心子系统

1. 进程调度器

采用 CFS(完全公平调度器)算法,决定哪个进程获得 CPU 时间、运行多久。这是容器 CPU 配额管理的底层实现。

实际应用 :通过 nice 命令调整数据库进程优先级,保证核心业务响应速度。Kubernetes 的 CPU Limit 最终也是由调度器执行。

2. 内存管理

提供虚拟内存机制,让每个进程拥有独立的地址空间,互不干扰。当内存不足时,OOM Killer 会选择终止部分进程释放资源。

运维要点:

- 监控

/proc/meminfo查看内存使用情况 - 调整

vm.swappiness参数控制 Swap 使用 - 配合 Kubernetes Memory QoS 避免容器 OOM

云栈社区在实践中发现,合理配置内存参数能显著降低容器被驱逐的概率。

3. 网络协议栈

从应用层的 Socket 到网络设备驱动的完整实现,支持 TCP/IP、UDP、Netfilter(iptables 和 nftables)、eBPF 等技术。

DevOps 场景:

- 使用

tc命令进行流量整形 - 部署 Cilium 实现基于 eBPF 的容器网络

- 调优

net.core.somaxconn支持高并发连接

bash

# 高并发服务器网络优化

net.core.somaxconn = 65535

net.ipv4.tcp_max_syn_backlog = 8192

net.ipv4.tcp_tw_reuse = 14. 虚拟文件系统

提供统一的文件操作接口,屏蔽底层文件系统差异(ext4、xfs、btrfs)。Docker 的存储驱动 overlay2、devicemapper 都基于 VFS 实现。

关键指标:

- 用

df -i监控 inode 使用率 - 调整

fs.file-max支持大规模连接 - 选择合适的容器存储驱动

想深入了解存储技术,可以访问云原生 / IaaS 学习路径获取系统化资料。

5. 设备驱动

提供硬件抽象层,支持 GPU(NVIDIA、AMD)、RDMA 网络、NVMe 存储等高性能设备的统一管理。

三个典型运维场景

场景一:内核参数调优

bash

# /etc/sysctl.conf 配置示例

net.core.somaxconn = 65535

net.ipv4.tcp_max_syn_backlog = 8192

fs.file-max = 2097152

vm.swappiness = 10

vm.dirty_ratio = 15这些参数直接影响 Web 服务器、数据库、消息队列的性能上限。执行 sysctl -p 使配置生效。

场景二:容器隔离机制

Docker 的底层实现就是 Namespace(隔离进程、网络、文件系统)加 Cgroups(限制 CPU、内存、I/O)。

bash

# 手动创建容器隔离环境

unshare --pid --net --mount --uts --ipc /bin/bash

# 使用 Cgroups 限制资源

cgcreate -g cpu,memory:myapp

cgset -r cpu.shares=512 myapp

cgset -r memory.limit_in_bytes=1G myapp理解这些机制,才能深度排查容器网络故障、资源争抢问题。

场景三:eBPF 性能监控

通过内核的 eBPF 技术,可以零侵入监控生产环境的系统调用、网络流量、安全事件。Falco、Cilium、Pixie 等工具都基于此实现。

bash

# 使用 bpftrace 追踪 TCP 连接

bpftrace -e 'kprobe:tcp_v4_connect {

printf("PID %d connecting\n", pid);

}'性能分析工具

bash

# CPU 调度延迟分析

perf sched latency

# 追踪系统调用

strace -c -p <pid>

# 网络连接统计

ss -s && nstat -az

# I/O 性能监控

iostat -x 1 && iotop -o这些工具直接读取内核暴露的性能指标,是故障排查的第一手资料。更多运维实战技巧可以查看运维 / DevOps / SRE 学习路径。

版本选择建议

生产环境推荐使用 LTS(长期支持)版本:

- 6.6.x:最新 LTS,支持到 2026 年

- 6.1.x:稳定 LTS,支持到 2026 年

- 5.15.x:经典 LTS,支持到 2027 年

LTS 版本提供至少 2 年的安全补丁支持,API 接口稳定,经过社区充分验证。对于追求极致性能的场景(如高频交易、实时音视频),可评估使用 Mainline 版本的新特性(如 io_uring、MPTCP)。

学习路径

初级阶段:

- 掌握

sysctl参数调优 - 使用

dmesg分析内核日志 - 理解进程、内存、网络基本概念

中级阶段:

- 使用

perf、ftrace定位性能瓶颈 - 掌握 iptables 和 tc 流量控制

- 编写简单的内核模块

高级阶段:

- 编写 eBPF 程序实现自定义监控

- 使用 kgdb 和 crash 调试内核

- 参与上游社区贡献代码

云栈社区( https://yunpan.plus )整理了完整的计算机基础学习资料,涵盖操作系统、网络、编译原理等核心知识。

为什么运维必须懂内核

云原生时代,容器、微服务、Service Mesh 层出不穷,但它们都运行在 Linux Kernel 之上。当你理解了进程调度、内存管理、网络协议栈的工作原理,就能:

- 快速定位故障:知道问题出在应用层还是内核层

- 精准性能调优:找到真正的瓶颈而不是盲目调参

- 深度理解容器:明白 Docker 和 Kubernetes 的底层机制

- 掌握新技术:eBPF、io_uring 等新特性的原理和应用

掌握内核,就是掌握云原生基础设施的底层逻辑。

关注《云栈运维云原生》,获取更多运维、SRE、DevOps 技术干货!

📌 项目地址 :github.com/torvalds/linux

📖 官方文档 :kernel.org/doc

🛠️ 性能工具 :github.com/iovisor/bcc

📖 Linux内核开发课 :https://yunpan.plus/t/574

标签: #LinuxKernel #Github #云原生 #DevOps #容器技术 #eBPF #运维

作者:https://yunpan.plus/t/1349-1-1 版权所有