本文档为完全分布式大数据环境(3台虚拟机:hadoop01~hadoop03)中Flink组件(Standalone模式)的独立测试教程,基于视频操作流程,结合完全分布式测试文档的规范要求,详细说明从环境准备、远程连接到服务启停、核心功能验证(Web页面验证、批处理任务验证)的全流程,适用于验证Flink集群的独立可用性。

一、前期准备:环境基础信息与测试前提

测试前需确认环境配置及依赖组件状态符合要求,避免因环境问题导致测试失败:

1.1 基础环境信息

- 虚拟机配置:3台虚拟机(命名为hadoop01、hadoop02、hadoop03),硬盘总配置100GB~200GB,已完成基础环境部署

- 系统账号:优先使用hertz账号(密码:hertz);特殊操作需使用root账号(密码:1)

- 工具准备:Mobaxterm远程连接工具(已安装并可正常使用)、本地浏览器

- 网络要求:虚拟机之间网络互通,本地主机与虚拟机网络连通;已关闭所有虚拟机防火墙(root账号执行命令:systemctl stop firewalld)

- 安装目录:所有组件统一安装于 /opt/module 目录下,Flink相关环境变量已配置完成

- 端口要求:确保Flink默认端口8081(Web管理页面)无占用

- 依赖组件:Flink需依赖Hadoop(HDFS)存储数据、ZooKeeper管理集群状态,需提前确认两者环境配置正确

1.2 测试前提

- 3台虚拟机(hadoop01~hadoop03)均正常启动,已到达登录页面

- 以hertz账号登录hadoop01节点(分布式脚本统一在hadoop01执行)

- 依赖组件已正常启动:ZooKeeper服务(执行命令:zk start,状态为1台Leader、2台Follower)、Hadoop(HDFS+YARN)服务(执行命令:start-all.sh),且Hadoop已退出安全模式(执行命令:hdfs dfsadmin -safemode get 验证显示"OFF")

- HDFS上已有复用的测试文件(即Hadoop测试中创建的/test_hdfs/test.txt)

二、Flink测试详细步骤

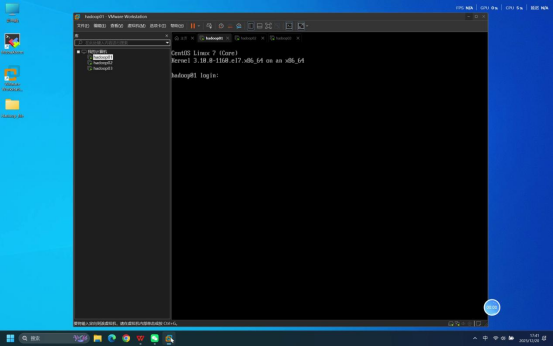

步骤1:确认虚拟机启动状态

操作说明:分别检查3台虚拟机(hadoop01、hadoop02、hadoop03)的启动状态,确保每台虚拟机系统加载完成,均已到达登录页面。

预期结果:3台虚拟机均正常启动,无启动报错,各自显示系统登录界面。

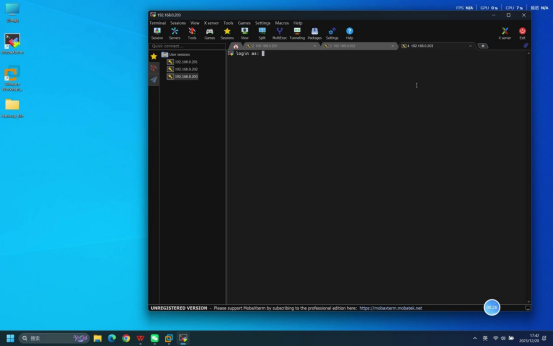

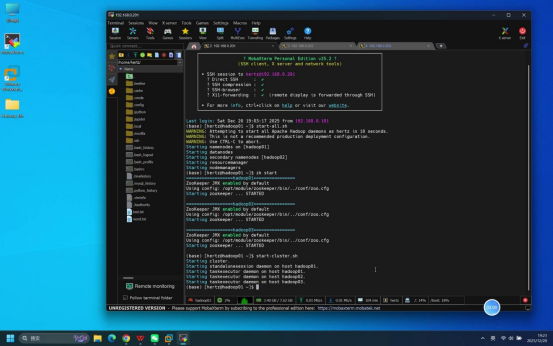

步骤2:使用Mobaxterm连接虚拟机

操作说明:打开本地Mobaxterm工具,分别建立与3台虚拟机(hadoop01、hadoop02、hadoop03)的SSH远程连接。

核心操作要点:

- 新建远程连接,选择SSH连接类型

- 分别输入3台虚拟机对应的正确IP地址

- 默认选择普通用户登录类型,无需额外修改

预期结果:3台虚拟机的Mobaxterm连接均成功建立,各自进入等待登录状态。

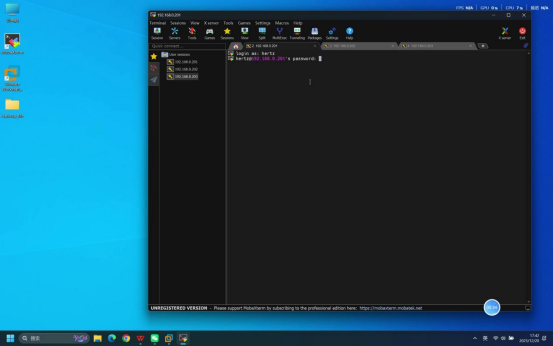

步骤3:输入账号密码完成登录

操作说明:在3台虚拟机对应的Mobaxterm连接终端中,依次完成账号和密码的输入操作。

具体操作:

- 终端提示输入账号时,输入:hertz

- 回车后,终端提示输入密码,输入:hertz(密码输入时无明文显示,直接输入后回车即可)

预期结果:3台虚拟机均登录成功,终端界面分别显示当前登录用户及主机标识,如[hertz@hadoop01 ~]、\[hertz@hadoop02 \~\]、[hertz@hadoop03 ~]$。

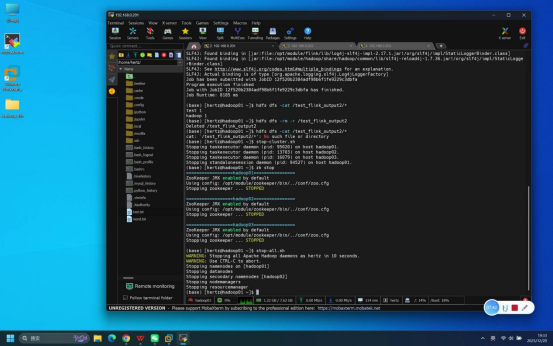

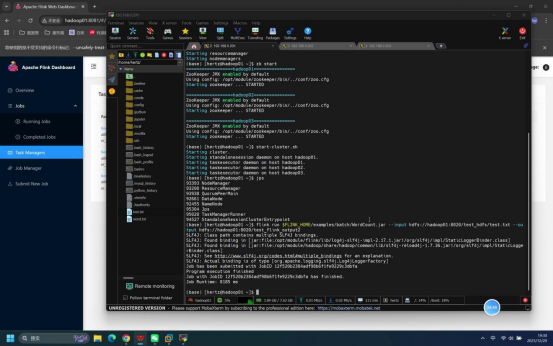

步骤4:启动Flink相关服务

操作说明:在登录成功的hadoop01节点终端中,先确认依赖的ZooKeeper、Hadoop服务已正常运行,再执行Flink集群(Standalone模式)启动命令。

具体操作:

- 确认依赖服务状态(可选):通过jps命令验证Hadoop、ZooKeeper进程正常;ZooKeeper状态可执行zkServer.sh status验证

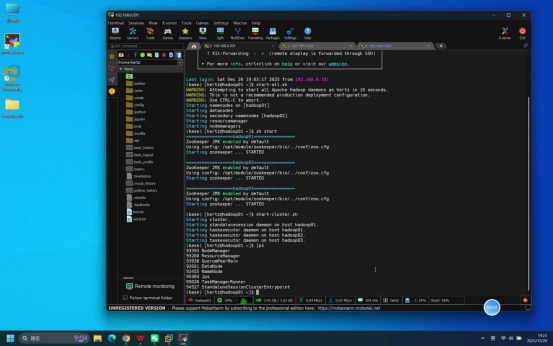

- 启动Flink集群:执行命令:start-cluster.sh

说明:start-cluster.sh为Flink Standalone模式内置集群启动脚本,执行后可一键启动hadoop01的JobManager节点和3台节点的TaskManager节点,两者均启动后Flink集群方可正常提供服务。

预期结果:终端逐步输出各节点Flink服务的启动日志,无报错提示。

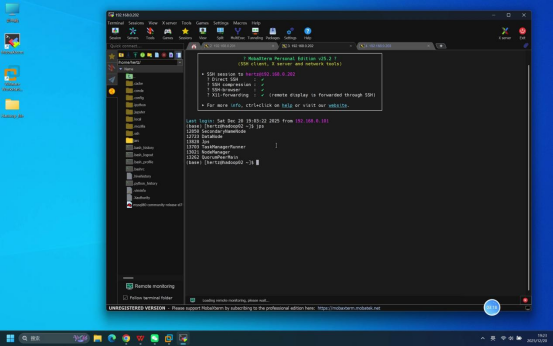

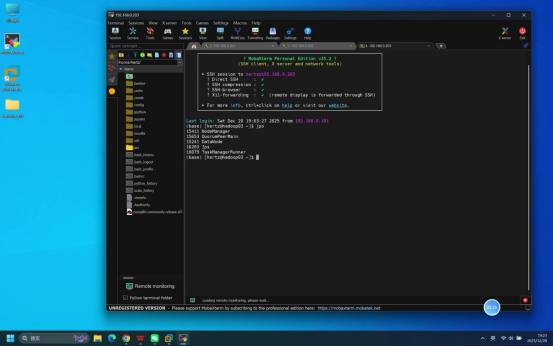

步骤5:执行jps命令验证进程状态

操作说明:启动命令执行完成后,分别在hadoop01、hadoop02、hadoop03节点的终端中输入jps命令,查看各节点Java进程运行情况。

具体命令:jps

预期结果:各节点进程符合以下要求,说明Flink服务启动正常:

- hadoop01节点:包含StandaloneSessionClusterEntrypoint(即JobManager进程)

- hadoop01~hadoop03节点:均包含TaskManagerRunner(即TaskManager进程)

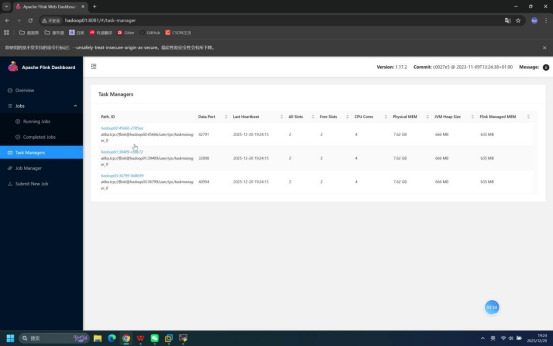

步骤6:浏览器访问Flink Web页面验证节点状态

操作说明:在本地打开浏览器,访问Flink JobManager节点的Web管理页面,查看"Task Managers"栏目验证节点状态。

具体操作:

- 打开本地浏览器,在地址栏输入:hadoop01:8081(注:"hadoop"需替换为hadoop01节点的IP或主机名,确保本地可正常解析)

- 进入Web页面后,找到"Task Managers"栏目,查看当前Flink集群中的TaskManager节点信息

预期结果:

- 浏览器可正常打开Flink Web页面,无访问失败提示

- "Task Managers"栏目显示3台节点信息,状态均正常

步骤7:执行完全分布式测试文档中的Flink测试命令

操作说明:在hadoop01节点终端中,执行与完全分布式测试文档一致的Flink批处理任务测试命令,验证Flink核心计算功能。

具体操作:

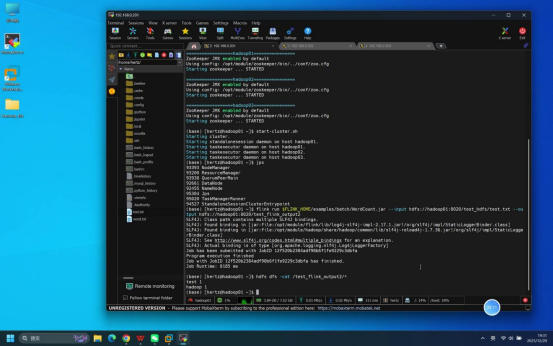

- 提交批处理任务:执行命令:flink run $FLINK_HOME/examples/batch/WordCount.jar --input hdfs://hadoop01:8020/test_hdfs/test.txt --output hdfs://hadoop01:8020/test_flink_output2

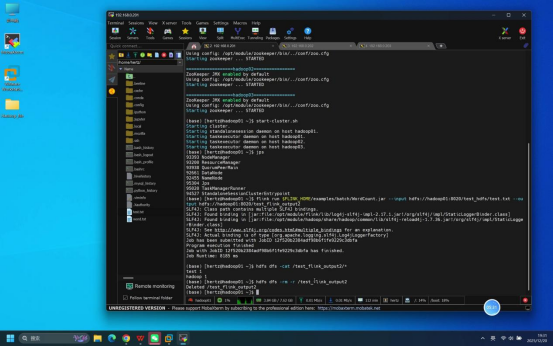

- 查看任务执行结果:执行命令:hdfs dfs -cat /test_flink_output2/*

- (可选)删除输出目录:执行命令:hdfs dfs -rm -r /test_flink_output2

说明:$FLINK_HOME为Flink安装目录的环境变量,命令中使用Hadoop测试时已创建的/test_hdfs/test.txt作为输入文件,输出目录指定为/test_flink_output2。

预期结果:所有测试命令执行无报错,任务执行成功;查看结果时终端输出词频统计信息:hadoop 1、test 1,与输入文件内容匹配。

步骤8:关闭Flink相关服务

操作说明:功能验证完成后,在hadoop01节点执行Flink集群停止命令,最后根据需求停止依赖服务。

具体操作:

- 停止Flink集群:在hadoop01节点终端执行命令:stop-cluster.sh(一键停止所有节点的Flink服务)

- 停止依赖服务(可选):若后续无需使用其他组件,依次执行zk stop(停止ZooKeeper)、stop-all.sh(停止Hadoop)

预期结果:

- Flink集群停止命令执行无报错,终端输出各节点JobManager、TaskManager服务停止日志。