Linux内核之文件系统:从VFS到实际存储的运作机制

在Linux的世界里,"一切皆文件"是贯穿始终的设计哲学。无论是普通文本、硬件设备、网络套接字,还是进程信息,都能通过统一的文件接口进行操作。这种强大的抽象能力,背后离不开Linux内核文件系统的精妙设计。本文将从核心架构出发,拆解虚拟文件系统(VFS)的核心组件、运作流程,以及常见文件系统的特性。

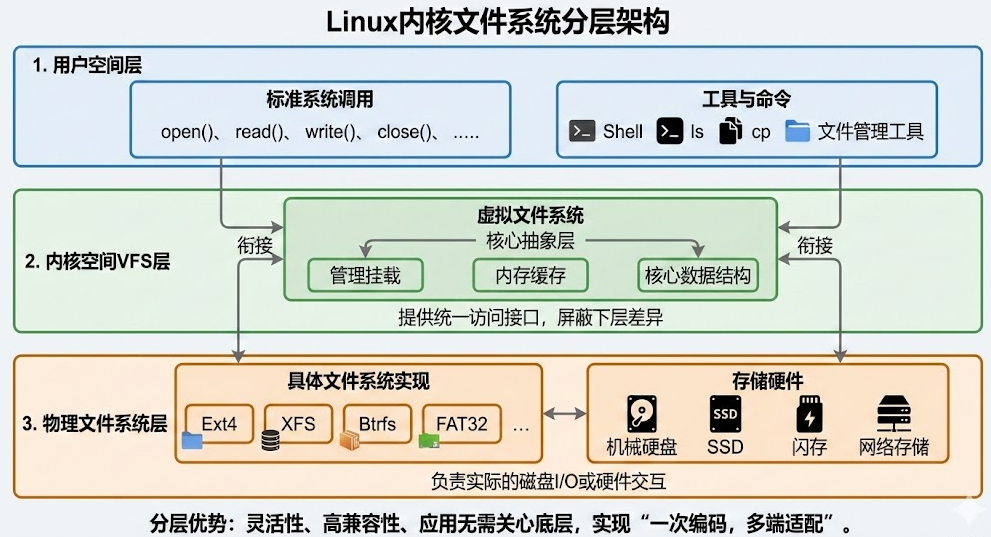

一、Linux文件系统的核心架构

Linux内核文件系统采用分层架构,核心目标是屏蔽不同物理存储介质和文件系统的差异,为上层应用提供统一的访问接口。整个架构从顶层到底层可分为三层,各层职责清晰、协同运作:

-

用户空间层:提供

open()、read()、write()、close()等标准系统调用,以及Shell命令、文件管理工具(如ls、cp),是用户与文件系统交互的入口。 -

内核空间VFS层:虚拟文件系统(VFS)是整个架构的核心抽象层,位于系统调用与物理文件系统之间,通过标准化接口衔接上下层,管理文件系统挂载、内存缓存及核心数据结构。

-

物理文件系统层:对应具体的文件系统实现(如Ext4、XFS)和存储硬件(机械硬盘、SSD、闪存),负责将VFS的抽象操作转化为实际的磁盘I/O或硬件交互。

这种分层设计的优势在于灵活性------新增或替换物理文件系统时,无需修改上层应用代码;应用程序也无需关心底层存储介质,只需调用统一接口,实现了"一次编码,多端适配"的高效开发模式,这也是Linux能兼容数十种文件系统的核心原因。

二、VFS虚拟文件系统:内核文件系统的"万能适配器"

VFS作为内核空间的核心抽象层,不直接操作硬件,而是通过定义统一的数据结构和操作接口,将上层系统调用转化为底层物理文件系统的具体操作。其核心价值在于"屏蔽差异、统一管理",让不同文件系统在Linux内核中无缝协同。

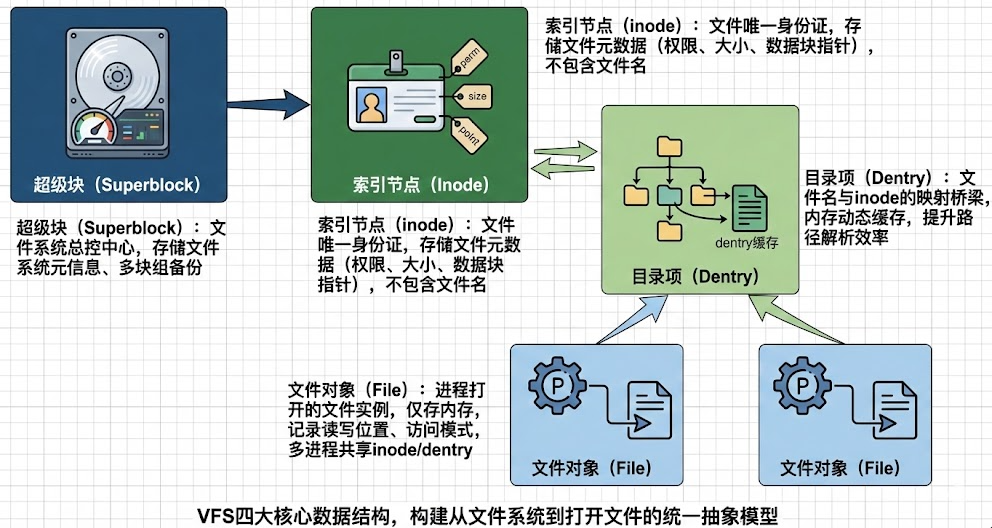

2.1 VFS四大核心数据结构

VFS通过四个相互关联的数据结构,构建了统一的文件模型,覆盖从整个文件系统到单个打开文件的全维度描述:

-

超级块(Superblock):文件系统的"总控中心",存储整个文件系统的元信息,包括文件系统类型、分区大小、块大小、空闲空间数量、inode总数及备份位置等。超级块默认存储在磁盘特定位置,且会在多个块组中备份,避免单点损坏导致整个文件系统失效,内核挂载文件系统时会将超级块加载到内存。

-

索引节点(Inode):文件的"唯一身份证",记录单个文件的元数据,包括文件权限(rwx)、所有者(用户/组ID)、文件大小、时间戳(创建/修改/访问时间)、数据块指针及文件类型等。需注意,inode不存储文件名,仅通过编号唯一标识文件,文件名与inode的映射关系由目录项维护。每个文件对应唯一inode,多个文件名可指向同一个inode(即硬链接)。

-

目录项(Dentry):构建文件系统目录树的核心,负责维护文件名与inode编号的映射关系,同时记录目录层级结构(父目录、子目录关联)。VFS会将常用的目录项缓存到内存的dentry缓存中,减少磁盘寻道和路径解析耗时,大幅提升文件访问效率。目录项本身不存储在磁盘,仅在内存中动态构建和缓存。

-

文件对象(File):表示进程打开的文件实例,仅存在于内存中,记录文件当前读写位置(offset)、访问模式(只读/读写)、引用计数及关联的dentry对象等信息。同一个文件被多个进程同时打开时,会生成多个独立的File对象,但共享同一个inode和dentry,确保进程间文件操作的一致性。

Linux 通过 VFS 作为中间层,把系统调用和具体文件系统解耦。VFS 用 superblock 描述文件系统,用 inode 描述文件本身,

用 dentry 管理路径关系,用 file 表示进程打开文件的实例,实际文件数据通过 page cache 缓存,未命中才访问磁盘。

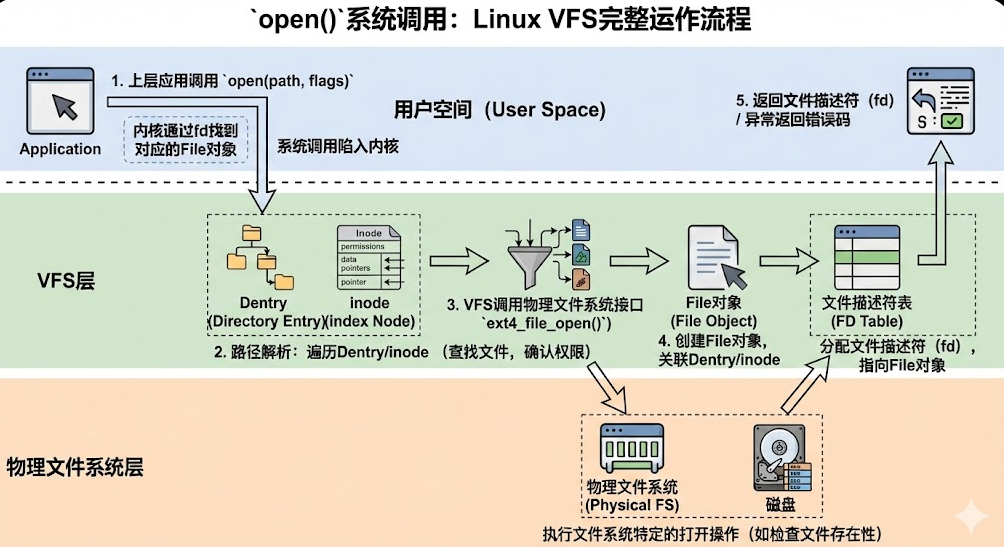

2.2 VFS核心运作流程:从系统调用到物理I/O

open()系统调用:

- 上层应用调用

open(path, flags)系统调用,传入文件路径和打开模式,系统调用陷入内核后,内核准备为本次操作分配资源。 - VFS通过解析传入的文件路径,遍历目录项(Dentry)缓存找到对应的Dentry对象,再通过Dentry获取inode编号,进而找到inode对象,确认文件存在性与进程访问权限。

- VFS调用inode关联的物理文件系统操作接口(如Ext4的

ext4_file_open()),触发底层文件系统执行特定检查与初始化操作。 - VFS创建File对象(代表进程打开的文件实例),将其与Dentry、inode关联,并在进程的文件描述符表(FD Table)中分配一个未使用的文件描述符(fd),指向该File对象。

- 操作完成后返回文件描述符(fd)给上层应用,若遇异常(如文件不存在、权限不足)则返回错误码。

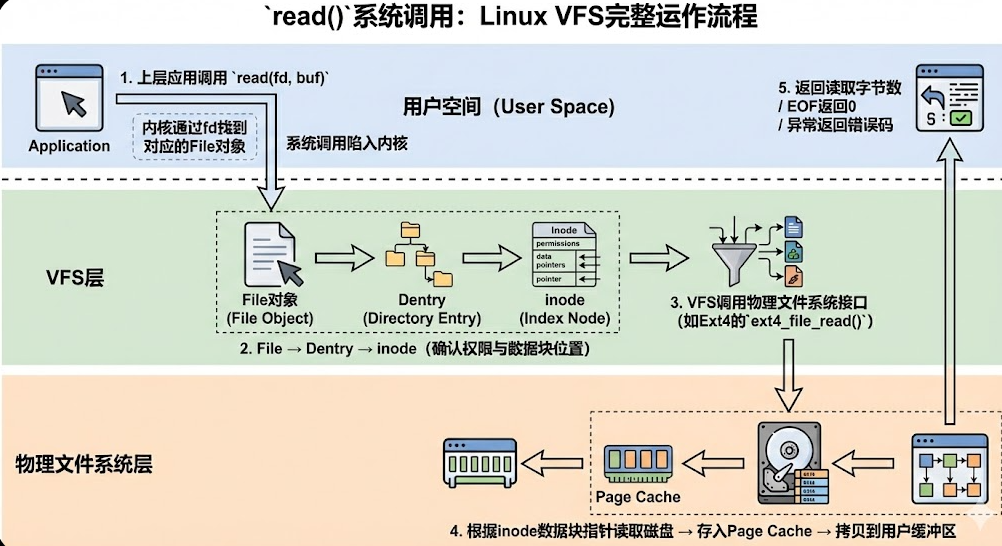

read()系统调用:

- 上层应用调用

read()系统调用,传入文件描述符(fd)和缓冲区地址,内核通过fd找到对应的File对象; - File对象关联对应的dentry,通过dentry获取inode编号,进而找到inode对象,确认文件权限和数据存储位置;

- VFS调用inode关联的物理文件系统操作接口(由具体文件系统实现,如Ext4的

ext4_file_read()); - 物理文件系统根据inode中的数据块指针,读取磁盘对应数据块,存入内核缓存(page cache),再拷贝到用户空间缓冲区;

- 操作完成后返回读取字节数,若遇EOF(文件结束)则返回0,异常则返回错误码。

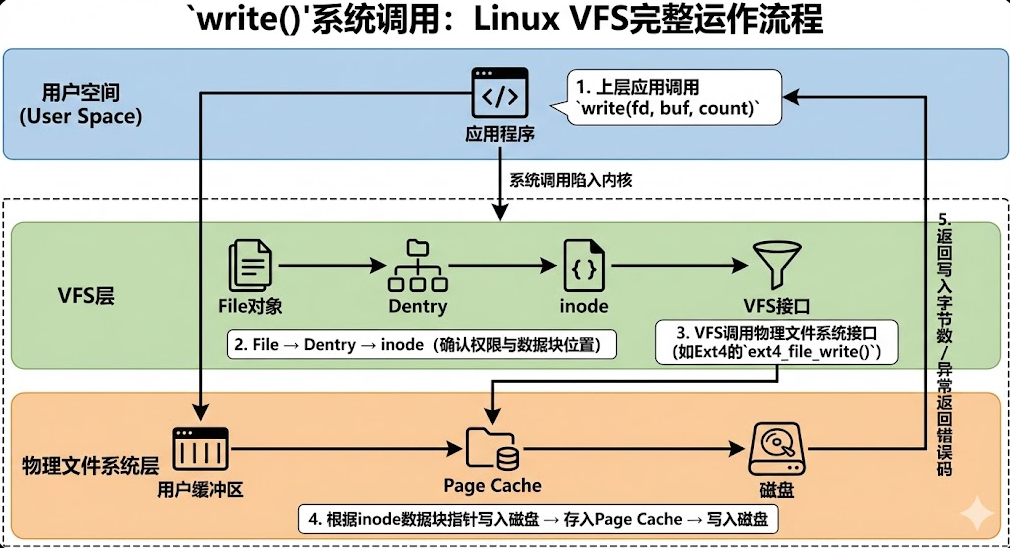

write()系统调用:

- 上层应用调用

write(fd, buf, count)系统调用,传入文件描述符、用户缓冲区地址和写入字节数,系统调用陷入内核。 - 内核通过文件描述符(fd)找到对应的File对象,再通过File对象关联的Dentry找到inode对象,确认进程对文件的写入权限,并获取数据块的存储位置。

- VFS调用inode关联的物理文件系统操作接口(如Ext4的

ext4_file_write())。 - 物理文件系统将用户缓冲区的数据拷贝到内核Page Cache,根据inode中的数据块指针完成延迟分配,再由内核后台线程异步将Page Cache中的数据刷入磁盘。

- 操作完成后返回实际写入的字节数,若遇异常(如磁盘满、权限不足)则返回错误码。

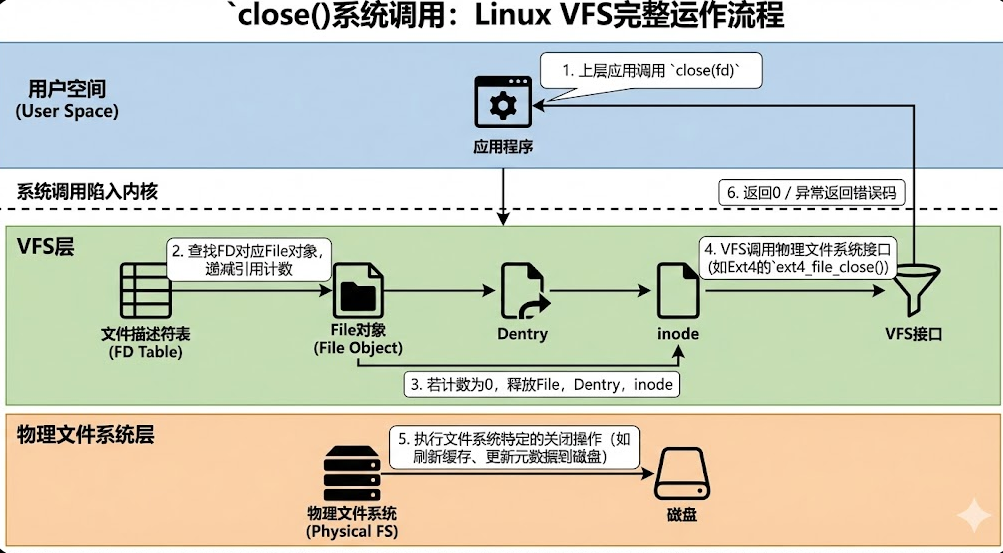

close()系统调用:

- 上层应用调用

close(fd)系统调用,传入文件描述符,系统调用陷入内核。 - 内核通过文件描述符(fd)在文件描述符表(FD Table)中找到对应的File对象,将其引用计数减1。

- 若File对象的引用计数减至0,则释放该File对象,并同步释放关联的Dentry和inode缓存(若其引用计数也为0)。

- VFS调用inode关联的物理文件系统操作接口(如Ext4的

ext4_file_close())。 - 物理文件系统执行特定的关闭操作,包括刷新Page Cache中未写入磁盘的数据、更新文件元数据到磁盘。

- 操作完成后返回0表示成功,若遇异常(如文件已损坏)则返回错误码。

三、主流物理文件系统特性对比

Linux支持数十种物理文件系统,不同文件系统针对不同场景做了优化设计,核心特性和适用场景差异显著,以下为最常用的四类文件系统对比:

-

Ext4:Linux主流默认文件系统,基于Ext3升级而来,兼容Ext2/Ext3,支持Extent块管理、延迟分配、元数据校验和等特性,稳定性高、兼容性强,适合桌面端、服务器本地存储等通用场景,支持1EB文件系统和16EB单个文件。

-

XFS:高性能日志文件系统,擅长处理大文件和高并发I/O,元数据操作效率优于Ext4,支持动态扩展分区大小,适合大数据、数据库、视频编辑等对吞吐量要求高的场景,是CentOS 7+、RHEL 7+的默认文件系统。

-

Btrfs:新一代Copy-on-Write(写时复制)文件系统,支持快照、RAID、动态卷管理、数据校验等企业级特性,容错性强,但稳定性略逊于Ext4/XFS,适合需要快照备份、灵活存储管理的企业级场景。

-

嵌入式专用文件系统:YAFFS2、JFFS2适配闪存设备,支持擦除均衡和坏块管理;SquashFS为只读文件系统,压缩比高,适合嵌入式固件、路由器等只读存储场景。

四、Linux文件系统核心知识点速查表

4.1 核心概念与数据结构

| 核心概念 | 核心作用 | 关键特性 |

|---|---|---|

| 超级块(Superblock) | 管理整个文件系统元信息 | 磁盘存储+多块组备份,避免单点故障 |

| 索引节点(Inode) | 描述单个文件元数据 | 无文件名,唯一编号,支持硬链接 |

| 目录项(Dentry) | 映射文件名与inode | 内存缓存,提升路径解析效率 |

| 文件对象(File) | 描述进程打开的文件实例 | 仅存内存,多进程共享inode |

| Page Cache | 文件数据内核缓存 | 减少磁盘I/O,提升读写性能 |

Linux VFS 中,superblock 描述整个文件系统,inode 描述文件本身的元数据,dentry 负责路径和文件名到 inode 的映射,file 表示进程打开文件后的运行时状态。

4.2 常用操作命令

| 命令 | 功能描述 | 示例 |

|---|---|---|

| mount | 挂载文件系统 | mount /dev/sda1 /mnt/data(挂载分区到/mnt/data) |

| umount | 卸载文件系统 | umount /mnt/data(需确保无进程占用) |

| df | 查看文件系统磁盘使用情况 | df -h(以人类可读格式显示) |

| du | 查看目录/文件占用空间 | du -sh /home(显示/home目录总大小) |

| fsck | 文件系统检查与修复 | fsck /dev/sda1(卸载后执行,修复Ext系列文件系统) |

| stat | 查看文件inode信息 | stat test.txt(显示文件权限、时间戳、inode编号等) |

4.3 完整文件生命周期流程

| 系统调用 | 核心步骤 |

|---|---|

open(path, flags) |

1. 上层应用调用open(path, flags),系统调用陷入内核 2. VFS解析文件路径,遍历Dentry缓存找到对应的Dentry和inode,校验访问权限 3. VFS调用物理文件系统接口(如ext4_file_open())执行底层检查 4. 创建File对象并关联Dentry/inode,分配文件描述符(fd) 5. 返回fd给应用,异常则返回错误码 |

read(fd, buf, count) |

1. 上层应用调用read(fd, buf, count),系统调用陷入内核 2. 内核通过fd找到File对象,通过Dentry定位inode,确认读取权限 3. VFS调用物理文件系统接口(如ext4_file_read()) 4. 物理文件系统根据inode数据块指针读取磁盘数据到Page Cache,再拷贝到用户缓冲区 5. 返回读取字节数,EOF返回0,异常返回错误码 |

write(fd, buf, count) |

1. 上层应用调用write(fd, buf, count),系统调用陷入内核 2. 内核通过fd找到File对象,通过Dentry定位inode,确认写入权限 3. VFS调用物理文件系统接口(如ext4_file_write()) 4. 将用户缓冲区数据拷贝到Page Cache,延迟分配物理块,内核后台异步刷盘 5. 返回写入字节数,异常返回错误码 |

close(fd) |

1. 上层应用调用close(fd),系统调用陷入内核 2. 内核通过fd找到File对象,将其引用计数减1 3. 若引用计数为0,释放File、Dentry、inode缓存 4. VFS调用物理文件系统接口(如ext4_file_close()) 5. 物理文件系统刷新Page Cache、更新元数据到磁盘 6. 返回0表示成功,异常返回错误码 |

4.4 核心总表

| 模块 | 核心点 | 核心概念 |

|---|---|---|

| 整体架构 | 分层设计 | 应用 → 系统调用 → VFS → 具体文件系统 → 存储设备 |

| VFS 作用 | 解耦 | VFS 屏蔽不同文件系统差异 |

| superblock | 文件系统级 | 描述整个文件系统的全局信息 |

| inode | 文件级 | 描述文件本身的元数据,不含文件名 |

| dentry | 路径级 | 文件名到 inode 的映射,主要在内存 |

| file | 进程级 | 进程打开文件的运行时状态 |

| fd | 用户态 | fd 只是进程里的索引 |

| 多进程 open | 共享关系 | 多个 file,共享同一个 inode |

| open() | 打开 | 路径解析 → dentry → inode → 创建 file → 分配 fd |

| read() | 读 | 先 Page Cache,未命中才访问磁盘 / Flash |

| write() | 写 | 默认写 Page Cache,不等于立刻落盘 |

| fsync/sync | 数据安全 | 强制把 Page Cache 刷到磁盘 |

| close() | 资源释放 | file 引用计数归零才真正释放 |

| Page Cache | 性能核心 | 内核文件数据缓存,减少 I/O |

| rm / unlink | 删除 | 删除的是 dentry,不是 inode |

| inode 释放条件 | 引用计数 | link=0 且无 file 引用 |

| mount | 挂载 | 把文件系统 superblock 挂到 dentry |

| ext4 | 通用 | 块设备,稳定,默认 |

4.5 性能优化关键点

-

Ext4优化:开启延迟分配(默认开启)、调整块大小(4KB适合通用场景,8KB适合大文件)、启用元数据校验和提升可靠性;

-

缓存优化:合理调整Page Cache大小,通过

sync命令手动刷新缓存,避免数据丢失; -

文件系统选型:小文件多场景优先Ext4,大文件高并发优先XFS,企业级快照需求选Btrfs;

-

磁盘调度算法:机械硬盘选CFQ(公平调度),SSD选mq-deadline(适合闪存的调度算法)。

五、总结

Linux内核文件系统的精髓,在于以VFS为核心的分层抽象设计------既通过"一切皆文件"的哲学简化了资源访问,又通过灵活的架构适配了多样化的存储场景。从VFS四大核心数据结构的协同运作,到Ext4、XFS等物理文件系统的场景化优化,每一处设计都围绕"可靠性、性能、兼容性"三大目标展开。