摘要

本文以 Spring Cloud Gateway 架构全景为视角,从 Route、Predicate、Filter 核心组件切入,拆解其四层分层架构与协同逻辑,重点剖析基于 Netty 的 WorkerEventLoop 线程模型核心机制,结合源码解析过滤器链响应式执行原理。同时融入线程复用验证、Sentinel 限流落地、性能调优等实战内容,打通底层原理 - 线程机制 - 实战优化知识链路,为 Spring Cloud Gateway 网关治理的设计、排查与调优提供实操参考。

一、网关治理核心价值与底层架构基石

1.1 网关的核心定位

Spring Cloud Gateway 作为微服务架构的 "流量入口",基于 Spring Framework 5、Project Reactor 和 Netty 构建,彻底摒弃 Zuul 1.x 的同步阻塞模型,采用非阻塞响应式架构;而 Sentinel 则为其提供轻量级、高可用的流量治理能力,二者结合可实现网关层的全维度流量管控,支撑数万级并发连接。

1.2 分层架构设计

|--------|------------------|-----------------------------------------------------|

| 分层 | 核心职责 | 关键组件 / 技术 |

| 接入层 | TCP 连接建立、IO 事件监听 | Netty Boss/Worker EventLoop、epoll IO 多路复用 |

| 路由过滤层 | 请求解析、限流鉴权、路由匹配 | Gateway Filter、SentinelGatewayFilter、RoutePredicate |

| 转发层 | 异步请求转发、响应回调 | WebClient、Reactor Netty、Mono/Flux 响应式流 |

| 响应层 | 响应处理、结果返回 | Post-Filter、响应编码、线程复用 |

1.3 底层架构核心拆解:三大组件 + 响应式流转链路

1.3.1 三大核心组件

(1)Route(路由):网关的基础单元

- 底层结构(源码核心) :

java

// 核心源码:org.springframework.cloud.gateway.route.Route

public interface Route {

String getId(); // 路由唯一标识

URI getUri(); // 目标服务地址(如lb://order-service)

Predicate<ServerWebExchange> getPredicate(); // 路由断言

List<GatewayFilter> getFilters(); // 路由级过滤器

int getOrder(); // 路由执行顺序

}本质是 "条件路由规则容器",由 id、uri、predicates、filters 四部分组成,其中 uri 支持 lb:// 前缀(对接负载均衡)、http:///https:// 前缀(直接转发)。

- 存储机制:

路由信息默认存储在内存中(InMemoryRouteDefinitionRepository),通过 RouteDefinitionRepository 接口抽象,可扩展为 Apollo/Nacos 持久化(满足动态路由需求):

java

public interface RouteDefinitionRepository extends RouteDefinitionLocator, RouteDefinitionWriter {

}- 关键设计:

路由匹配采用 "先匹配先执行" 策略,底层通过 Predicate 函数式接口实现灵活条件判断,匹配失败则触发 NotFoundRoutingPredicate 返回 404。

(2)Predicate(断言):路由匹配的核心逻辑

- 底层实现(源码核心) :基于 Java 8 Function<Predicate>,输入为 ServerWebExchange(请求上下文),输出 boolean 值:

java

// 核心源码:org.springframework.cloud.gateway.handler.predicate.RoutePredicateFactory

public abstract class AbstractRoutePredicateFactory<C> implements RoutePredicateFactory<C> {

// 断言核心执行方法

public Predicate<ServerWebExchange> apply(C config) {

return exchange -> {

// 子类实现具体断言逻辑(如路径、请求头匹配)

return match(exchange, config);

};

}

}- 内置断言类型 :PathPredicate(路径匹配)、HeaderPredicate(请求头匹配)、BetweenPredicate(时间匹配)等,均继承自 AbstractRoutePredicateFactory,支持自定义扩展(如按 IP 段匹配)。

- 性能优化 :断言执行采用链式调用,基于 Netty 事件驱动模型,无额外线程开销,匹配耗时控制在微秒级。

(3)Filter(过滤器):请求处理的核心链路

- 分类与执行顺序(源码核心) :生命周期:PreFilter(请求转发前)、PostFilter(响应返回前);

- 作用范围:GlobalFilter(全局生效)、GatewayFilter(路由级生效);

- 执行顺序:由 Ordered 接口的 getOrder() 决定,数值越小优先级越高(如 Sentinel 限流过滤器通常设为 -100)。

- 底层原理:过滤器链的响应式链式执行

过滤器链基于响应式编程模型实现异步非阻塞链式调用 ,核心通过 GatewayFilterChain 接口 + 递归索引实现链路流转,全程以 Mono<Void> 保证非阻塞特性。

过滤器链核心接口(定义链路传递规则)

java

// 核心接口:单个过滤器执行后,通过此方法传递到下一个过滤器

public interface GatewayFilterChain {

Mono<Void> filter(ServerWebExchange exchange);

}默认过滤器链实现(链式执行核心)

java

// 核心逻辑:通过索引递归,实现过滤器有序执行

public class DefaultGatewayFilterChain implements GatewayFilterChain {

private final List<GatewayFilter> filters; // 排序后的过滤器列表

private final int index; // 当前执行的过滤器索引

// 核心方法:递归执行过滤器链

@Override

public Mono<Void> filter(ServerWebExchange exchange) {

return Mono.defer(() -> {

// 终止条件:所有过滤器执行完毕

if (index >= filters.size()) {

return Mono.empty();

}

// 执行当前过滤器,并创建「下一个链路节点」(索引+1)

GatewayFilter currentFilter = filters.get(index);

GatewayFilterChain nextChain = new DefaultGatewayFilterChain(filters, index + 1);

// 执行当前过滤器,同时传递下一个链路

return currentFilter.filter(exchange, nextChain);

});

}

}核心过滤器执行链路:RouteToRequestUrlFilter(解析目标 URL)→ LoadBalanceClientFilter(负载均衡)→ WebClientHttpRoutingFilter(发起 HTTP 请求)。

1.3.2 底层流转链路(响应式非阻塞模型)

- 请求接入(接入层):客户端请求通过 Netty NIO 通道接入,由 EventLoopGroup(boss 线程组)接收连接,分发至 worker 线程组处理 IO 事件;

- 请求解码(路由过滤层):Netty 解码器将 HTTP 报文解析为 ServerHttpRequest,封装为 ServerWebExchange 上下文对象;

- 路由匹配(路由过滤层):RoutePredicateHandlerMapping 遍历路由列表,通过 Predicate 链式调用匹配目标路由;

- 过滤器链执行:PreFilter 链:完成权限校验、路径重写、Sentinel 限流等操作;

- 负载均衡:LoadBalanceClientFilter 从 Nacos/Eureka 拉取服务实例,选择目标实例;

- 请求转发(转发层):WebClient 向目标服务发起非阻塞请求,底层基于 Netty 通道复用;

- 响应处理(响应层):服务响应通过 Mono/Flux 异步返回,执行 PostFilter 链,最终编码为 HTTP 响应返回客户端。

1.3.3 核心技术亮点:非阻塞与高性能的底层支撑

- Reactor 响应式编程 :基于 Reactor 3 的 Mono(0-1 个元素)和 Flux(0-N 个元素)实现异步流处理,支持背压机制,防止内存溢出。

- Netty 通道复用 :采用长连接池管理与后端服务的连接,默认开启 keep-alive,减少 TCP 握手 / 挥手开销;单个 EventLoop 线程可处理数千级并发连接。

- 无锁化设计 :整个流转链路无明显锁竞争,通过响应式编程和 Netty 线程模型实现并发安全,避免锁开销导致的性能瓶颈。

二、客户端请求全流程

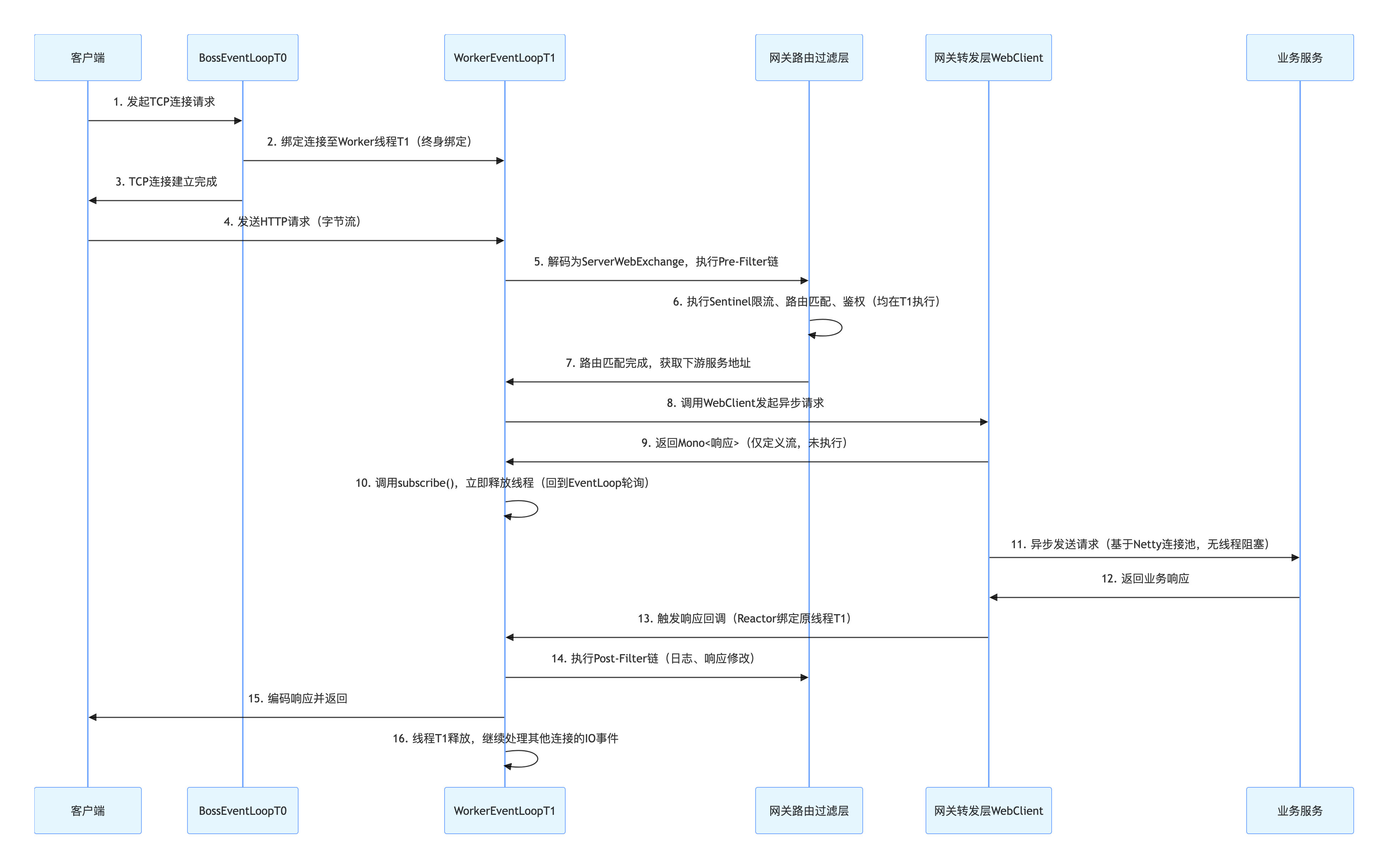

2.1 全流程时序图

2.2 核心阶段拆解

阶段 1:TCP 连接建立(接入层,Netty 核心)

- 分层对应 :完全匹配接入层 "TCP 连接建立、IO 事件监听" 的核心职责;

- 线程行为(源码级) :

java

// 核心源码:org.springframework.cloud.gateway.netty.NettyAutoConfiguration

@Bean

public NettyReactiveWebServerFactory nettyReactiveWebServerFactory() {

NettyReactiveWebServerFactory factory = new NettyReactiveWebServerFactory();

// Boss线程组配置(默认1个线程)

factory.setBossEventLoopGroup(new NioEventLoopGroup(1));

// Worker线程组配置(默认CPU核心数×2)

factory.setWorkerEventLoopGroup(new NioEventLoopGroup(Runtime.getRuntime().availableProcessors() * 2));

return factory;

}- BossEventLoopT0(1 个线程)通过 NioServerSocketChannel 监听端口,接收 TCP 连接请求;

- 将连接终身绑定到 WorkerEventLoopT1,避免后续线程切换;

- BossEventLoopT0 处理完绑定后立即回到 select() 状态,监听新请求。

阶段 2:HTTP 请求处理(路由过滤层,核心链路)

- 分层对应 :匹配路由过滤层 "请求解析、限流鉴权、路由匹配" 的核心职责;

- 触发条件 :WorkerEventLoopT1 监听到 OP_READ 读事件;

- 线程行为 + 源码解析 :

- 请求解码 :HttpServerCodec 将字节流解析为 FullHttpRequest,封装为 ServerWebExchange;

- Pre-Filter 链执行 :

java

// 核心源码:org.springframework.cloud.gateway.handler.FilteringWebHandler

public Mono<Void> handle(ServerWebExchange exchange) {

Route route = exchange.getRequiredAttribute(GATEWAY_ROUTE_ATTR);

List<GatewayFilter> combined = new ArrayList<>(route.getFilters());

combined.addAll(globalFilters);

combined.sort(AnnotationAwareOrderComparator.INSTANCE);

return new DefaultGatewayFilterChain(combined).filter(exchange);

}- SentinelGatewayFilter:在此阶段执行限流规则校验(内存原子操作,微秒级);

- RoutePredicate:链式匹配路由规则,定位下游服务地址;

3. 全程在 WorkerEventLoopT1 执行,无线程切换。

阶段 3:异步转发 + 线程释放(转发层,高并发核心)

- 分层对应 :匹配转发层 "异步请求转发、响应回调" 的核心职责;

- 核心逻辑 + 源码解析 :

java

// 核心源码:org.springframework.cloud.gateway.filter.WebClientHttpRoutingFilter

public Mono<Void> filter(ServerWebExchange exchange, GatewayFilterChain chain) {

URI uri = exchange.getRequiredAttribute(GATEWAY_REQUEST_URL_ATTR);

WebClient.RequestBodySpec requestSpec = webClient.method(exchange.getRequest().getMethod())

.uri(uri).headers(headers -> headers.putAll(exchange.getRequest().getHeaders()));

Mono<ClientResponse> responseMono = requestSpec.body(BodyInserters.fromDataBuffers(exchange.getRequest().getBody()))

.retrieve().onStatus(HttpStatus::isError, clientResponse -> handleError(clientResponse));

// 异步订阅,立即释放线程

return responseMono.flatMap(clientResponse -> writeResponse(clientResponse, exchange));

}- 线程行为 :WorkerEventLoopT1 调用 subscribe() 后立即释放,回到 EventLoop 轮询其他 IO 事件,实现 "1 线程处理 N 个连接"。

阶段 4:业务响应 + 线程复用(响应层,回调机制)

- 分层对应 :匹配响应层 "响应处理、结果返回" 的核心职责;

- 线程行为 + 源码解析 :

- 业务响应触发 OP_WRITE 写事件,Reactor 通过 Context 精准唤醒绑定的 WorkerEventLoopT1;

- 执行 Post-Filter 链(日志、响应头修改),HttpResponseEncoder 编码响应并返回客户端;

- 处理完成后 WorkerEventLoopT1 释放,继续轮询新事件。

三、核心问题解答:线程模型与高并发

3.1 线程是等待还是释放?

核心结论 :转发下游服务后,WorkerEventLoopT1 立即释放,而非阻塞等待。

- 源码佐证:WebClientHttpRoutingFilter 中 responseMono.flatMap() 是异步操作,无 block() 阻塞方法,线程不会等待响应;

- 性能对比:8 核 CPU(16 个 Worker 线程)释放后可支撑 5 万 + 并发连接,阻塞模式仅能处理 16 个并发请求。

3.2 释放线程为何不丢失请求?

核心是「连接 - 线程终身绑定 + 上下文精准追踪」,即使一个 Worker 线程处理多个连接,也能精准匹配:

- 连接有 "专属身份证" :每个 TCP 连接(Channel)创建时,会永久绑定到一个 WorkerEventLoop 线程(如 T1),Channel.eventLoop() 只读返回该线程,无论线程是否释放,"身份证" 不变;

- 线程释放是 "待命" 不是 "失联" :Worker 线程释放后仅回到 EventLoop 轮询新事件,响应返回时,Netty 通过连接的 "身份证"(eventLoop())直接找到绑定的线程;

- 上下文随连接绑定 :请求上下文(ServerWebExchange)会和连接 ID 绑定,存入 Reactor 异步流的 Context 中,线程找到后,可通过连接 ID 精准取出对应上下文,不会与同线程下的其他连接混淆。

3.3 Sentinel 限流的源码级执行逻辑

Sentinel 网关限流在路由过滤层的 Pre-Filter 阶段执行,核心源码:

java

// 核心源码:com.alibaba.csp.sentinel.adapter.gateway.sc.SentinelGatewayFilter

public Mono<Void> filter(ServerWebExchange exchange, GatewayFilterChain chain) {

String resourceName = exchange.getRequiredAttribute(GATEWAY_ROUTE_ATTR).getId();

Entry entry = SphU.entry(resourceName, EntryType.IN);

if (entry != null) entry.exit();

return chain.filter(exchange);

}- 限流规则存储在 GatewayRuleManager 中,校验耗时 < 1μs,不影响网关高并发能力。

四、实战验证:线程复用与限流效果

4.1 线程复用验证

java

@Component

public class ThreadMonitorFilter implements GlobalFilter, Ordered {

private static final Logger log = LoggerFactory.getLogger(ThreadMonitorFilter.class);

@Override

public Mono<Void> filter(ServerWebExchange exchange, GatewayFilterChain chain) {

String requestId = UUID.randomUUID().toString();

exchange.getRequest().mutate().header("X-Request-ID", requestId).build();

Thread currentThread = Thread.currentThread();

log.info("[{}] Pre阶段 - Worker线程ID: {}, 线程名称: {}",

requestId, currentThread.getId(), currentThread.getName());

return chain.filter(exchange)

.doOnSuccess(aVoid -> {

long postThreadId = Thread.currentThread().getId();

log.info("[{}] Post阶段 - Worker线程ID: {}(复用验证:{})",

requestId, postThreadId, currentThread.getId() == postThreadId);

});

}

@Override

public int getOrder() {

return -100;

}

}日志输出 :

xxx-xxx-xxx\] Pre阶段 - Worker线程ID: 16, 线程名称: reactor-http-nio-2 \[xxx-xxx-xxx\] Post阶段 - Worker线程ID: 16(复用验证:true)

4.2 Sentinel 限流验证(配置 + 效果)

java

spring:

cloud:

sentinel:

gateway:

enabled: true

rules:

- resource: order-service-route

grade: QPS

count: 1000

strategy: ROUTE_ID

controlBehavior: FAST_FAIL

intervalSec: 1验证效果 :QPS>1000 时快速返回 429 响应,无线程阻塞,网关 TPS 稳定在 1000 QPS。

五、性能优化实战(源码级调优)

5.1 线程数调优(接入层优化)

java

spring:

cloud:

gateway:

netty:

connection-timeout: 2000

worker-count: 24 # 8核CPU建议设为24(CPU核心数×3)5.2 连接池优化(转发层优化)

java

spring:

cloud:

gateway:

httpclient:

pool:

max-connections: 10000

max-idle-time: 300000

max-pending-connections: 50005.3 过滤器链优化(路由过滤层优化)

- 移除无用默认过滤器:

java

@Bean

public FilteringWebHandler filteringWebHandler(List<GlobalFilter> globalFilters) {

List<GlobalFilter> filtered = globalFilters.stream()

.filter(f -> !(f instanceof MetricsWebFilter))

.collect(Collectors.toList());

return new FilteringWebHandler(filtered);

}- 自定义过滤器异步化:避免阻塞操作,封装为 Mono 执行。

六、总结

6.1 核心知识点回顾

- 分层架构核心 :接入层(连接 / IO)→ 路由过滤层(解析 / 限流 / 路由)→ 转发层(异步转发)→ 响应层(响应 / 返回),四层职责清晰,支撑网关全流程处理;

- 线程模型核心 :WorkerEventLoop 线程 "短占用、快释放",通过 EventLoop 事件循环和 Reactor 响应式流实现高并发;

- 高性能关键 :连接 - 线程终身绑定、异步转发释放线程、响应回调复用线程、Netty 通道复用。

6.2 落地建议

- 线程数调优:IO 密集型场景设为 CPU 核心数 ×3~4,CPU 密集型场景设为 CPU 核心数 ×2;

- 限流规则:优先基于路由 ID/IP 维度配置 Sentinel 规则,减少规则匹配耗时;

- 过滤器优化:所有阻塞操作异步化,过滤器 Order 值按 "轻量级优先" 排序;

- 监控重点:关注接入层线程数、路由过滤层执行耗时、转发层连接池状态、响应层线程复用率。