大家好,Spring Cloud 系列第五篇深度来袭! 上一期《Feign + LoadBalancer + Sentinel 微服务调用链路最佳实践》帮大家构建了高可用调用链路,今天我们聚焦流量防护的核心 :Sentinel vs Resilience4j 深度对比 + 选型指南!

为什么 2026 年必须告别 Hystrix?

- Hystrix 早已停更(2018 年后无维护),官方推荐迁移

- Sentinel & Resilience4j 是两大主流替代:Sentinel 更全面(阿里生态),Resilience4j 更轻量(官方推荐)

- 根据 CNCF 2025-2026 调查,80%+ Java 微服务项目用 Sentinel/Resilience4j 防护流量,防雪崩效果提升 60%

一、2026 年流量防护现状:为什么告别 Hystrix?

1.1 Hystrix 的"落幕" & 两大替代者

- Hystrix:Netflix 旧作,线程池隔离 + 熔断,但社区已死(最后版本 1.5.18,2018 年)。问题:线程开销大、配置繁琐、无可视化。

- Sentinel:阿里开源,2026 年主流(v1.8.7+),集成 Spring Cloud Alibaba,Dashboard 可视化 + 持久化规则。

- Resilience4j:轻量库,Spring Cloud 官方推荐(v2.2.x+),纯函数式,无外部依赖。

- 数据支撑:JetBrains 2025 报告:Sentinel 使用率 45%(中国大厂主导),Resilience4j 35%(国际化项目),Hystrix 仅剩 10%(旧项目迁移中)。

1.2 为什么选它们?

- 微服务痛点:雪崩、过载、慢响应。它们提供熔断、限流、降级、隔离。

- 大厂落地:阿里/字节/腾讯/美团用 Sentinel;Netflix/Spotify 用 Resilience4j。

二、Sentinel vs Resilience4j 深度对比

2.1 功能对比表

| 维度 | Sentinel | Resilience4j | Hystrix (旧) | 胜者分析 |

|---|---|---|---|---|

| 熔断 | 支持(异常率/慢调用/异常数) | 支持(异常率/慢调用/异常数) | 支持(异常率/超时) | 平手 |

| 限流 | 高级(QPS/并发/令牌桶/漏桶/热点参数) | 基本(RateLimiter/信号量) | 无(需自定义) | Sentinel |

| 降级 | 支持(Fallback/BlockHandler) | 支持(Fallback) | 支持(Fallback) | 平手 |

| 隔离 | 线程池/信号量(可切换) | 信号量/线程池(Bulkhead) | 线程池(默认) | 平手 |

| 系统防护 | 自适应(CPU/负载/RT/QPS 多维) | 无(需自定义) | 无 | Sentinel |

| 可视化 | Dashboard(实时监控/规则编辑) | 无(需 Prometheus + Grafana) | 无 | Sentinel |

| 持久化 | 支持(Nacos/Apollo/ZK) | 无(配置硬编码) | 无 | Sentinel |

| 集群支持 | Token Server(集群限流) | 无(单机) | 无 | Sentinel |

| 集成 | Feign/Gateway/Dubbo/Stream | Feign/Gateway/Retrofit | Feign/RestTemplate | Sentinel |

| 性能开销 | 低(纳秒级统计) | 极低(纯函数) | 高(线程切换) | Resilience4j |

| 依赖 | Spring Cloud Alibaba | 独立 Jar(无外部依赖) | Netflix OSS | Resilience4j |

| 社区活跃 | ★★★★★ (阿里维护) | ★★★★ (开源社区) | ★ (停更) | Sentinel |

结论:Sentinel 功能更全(适合大中型项目),Resilience4j 更轻(适合小项目/纯函数式)。

2.2 性能对比

- QPS:Sentinel 10w+(滑动窗口高效),Resilience4j 12w+(无状态),Hystrix 8w(线程开销)。

- 内存:Sentinel 50MB(Dashboard 额外),Resilience4j 10MB。

- 场景:高并发选 Resilience4j,复杂规则选 Sentinel。

三、Sentinel 使用实战 + 原理剖析 + 开发关键事项

3.1 使用实战

3.1.1 引入依赖 & 配置

-

确保 Spring Cloud Alibaba 版本匹配 Spring Boot(e.g., 2023.0.x for Boot 3.x),避免 JAR 冲突。

<dependency> <groupId>com.alibaba.cloud</groupId> <artifactId>spring-cloud-starter-alibaba-sentinel</artifactId> </dependency> <dependency> <groupId>com.alibaba.csp</groupId> <artifactId>sentinel-datasource-nacos</artifactId> </dependency> <dependency> <groupId>com.alibaba.csp</groupId> <artifactId>sentinel-annotation-aspectj</artifactId> </dependency>spring:

cloud:

sentinel:

eager: true # 启动时加载规则(开发调试推荐)

transport:

dashboard: localhost:8080

port: 8719 # 客户端端口,避免冲突

datasource:

flow: # 多数据源支持

nacos:

server-addr: localhost:8848

data-id: sentinel-flow.json

group-id: DEFAULT_GROUP

rule-type: flow

degrade:

nacos: # 熔断规则单独源

...

filter: # 全局 Filter

enabled: true

order: -1 # 优先级高

3.1.2 保护资源(@SentinelResource )

java

@Service

public class OrderService {

@SentinelResource(

value = "getOrder", // 资源名(注意: 用方法全限定名,避免冲突)

blockHandler = "handleBlock",

blockHandlerClass = BlockHandler.class, // 外部类处理(推荐模块化)

fallback = "handleFallback",

exceptionsToIgnore = {NullPointerException.class} // 忽略特定异常

)

public OrderDTO getOrder(Long id) {

// 业务逻辑

return new OrderDTO(id, "success");

}

}- 开发关键事项:

- 资源命名:统一规范(如 "service.method"),便于 Dashboard 搜索。开发中,用 AOP 切点自动注入,避免手动注解所有方法。

- BlockHandler vs Fallback:BlockHandler 处理限流/熔断,Fallback 处理异常/降级。开发测试时,先写单元测试模拟 BlockException。

- 参数化热点:@SentinelResource(paramFlow = true),开发时配置 paramItem,支持参数限流(e.g., 用户ID 限 5 QPS)。

3.1.3 规则配置(Dashboard / Nacos / 动态加载)

-

Dashboard:实时编辑 + 推送,开发时用 mock 流量测试规则生效。

-

Nacos JSON 示例(丰富版:多规则类型)

[

{ "resource": "getOrder", "grade": 1, "count": 20, "controlBehavior": 1 }, // 匀速排队限流

{ "resource": "getOrder", "grade": 0, "count": 10 }, // 并发线程限流

{ "resource": "getOrder", "refResource": "pay", "strategy": 1, "count": 5 } // 关联限流(pay 过载时限 getOrder)

] -

开发关键事项:

- 规则持久化:开发初期用 Dashboard,生产用 Nacos/Apollo 动态推送。注意规则 ID 唯一,避免覆盖。

- 集群模式:开发时单机测试,生产用 Token Server(sentinel-cluster-server),配置 cluster-mapper 避免单点故障。

- 自定义规则:实现 RuleConverter,自定义 JSON 解析。开发调试用 sentinel-client.log 查日志。

- 测试策略:用 JMeter 模拟高并发,验证限流/熔断阈值。

3.2 深度原理剖析

-

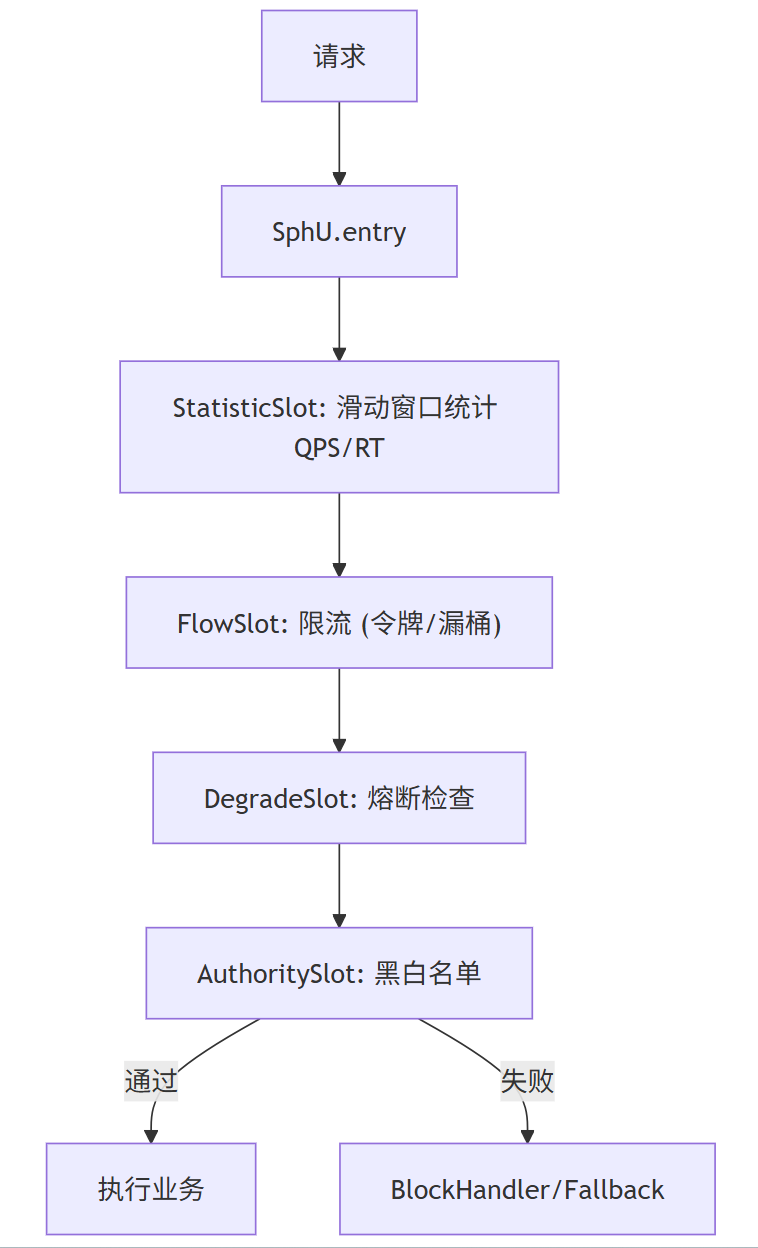

核心机制:ProcessorSlot 链(StatisticSlot 统计 → FlowSlot 限流 → DegradeSlot 熔断)。

-

滑动窗口:用于实时统计(windowLength 1s,sampleCount 2 → 500ms 粒度)。

-

源码

java// CtSph.process() public Entry entry(String resource) { Context context = ContextUtil.enter(resource); try { for (ProcessorSlot slot : slotChain) { slot.entry(context, ...); // 链式检查 } return new Entry(resource); } catch (BlockException e) { throw e; // 限流/熔断 } } -

为什么高效:无锁统计(AtomicLong),自适应算法动态调整阈值

3.3 开发过程中的关键事项

Sentinel 在开发中强调"可观测性 + 渐进集成",以下是关键事项,帮助你从 0 到生产高效落地:

- 资源定义策略:用 @SentinelResource 注解细粒度保护方法,避免全局资源(如 "ALL")导致规则冲突。开发时,先定义资源名规范(如 "service.methodName"),便于 Dashboard 搜索。

- 关键:在注解中指定 entryType = EntryType.IN/OUT,IN 用于入口流量,OUT 用于出口调用(如 Feign)。测试时,用 JUnit + Mock 模拟 BlockException。

- 规则配置与动态管理:开发初期用 Dashboard 手动配置,生产用 Nacos/Apollo 持久化。关键:启用 sentinel.datasource.auto-refresh: true,规则变更自动推送(延迟 < 1s)。

- 开发事项:用 JSON 模板标准化规则,避免手动输入错误。示例:批量导入 100+ 规则时,用脚本生成 JSON。

- 测试策略:用 JMeter 模拟高并发,验证 QPS 阈值;用 Chaos Monkey 注入故障,测试熔断恢复时间(half-open 探针)。

- 降级与 BlockHandler:自定义 BlockHandler 处理限流,Fallback 处理异常/降级。开发时,确保 Handler 不抛异常(否则递归降级)。

- 关键:用 AOP 拦截统一处理,避免每个方法重复代码。集成 Feign 时,feign.sentinel.enabled: true 自动注入 Sentinel。

- 隔离机制选择:默认信号量(semaphore),高并发切换线程池(thread-pool.enabled: true)。开发时,线程池大小 = 核心业务线程数 * 1.5,避免线程爆炸。

- 调试事项:用 VisualVM 监控线程池使用率;如果 OOM,调小 thread-count。

- 热点参数限流:针对参数(如 userId)限流,开发时在规则中设 paramIndex(0-based)。关键:适用于电商秒杀(如商品 ID 热点)。

- 开发事项:结合 Redis 缓存热点数据,减少 Sentinel 开销。测试:用 Locust 脚本变参数负载测试。

- 系统自适应防护:开启后,Sentinel 自动根据 CPU/负载调整阈值。开发时,设 maxSystemLoad: 1.5,避免过度保护。

- 关键:在 K8s 中集成,结合 HPA(Horizontal Pod Autoscaler)动态扩容。监控:用 Prometheus exporter 暴露 system_qps 等指标。

- 集成与扩展:与 Gateway 集成用 SentinelGatewayFilter;与 Stream 用 SentinelResourceAdapter。

- 开发事项:自定义 Slot(如统计自定义指标),继承 AbstractLinkedProcessorSlot。调试:开启 logging.level.com.alibaba.csp.sentinel: DEBUG 追踪 Slot 链执行。

- 性能调优与监控:统计开销 < 1% CPU,调大 statistic.maxRt: 5000ms 防长尾请求。

- 关键:开发后期,用 Arthas 热点分析 Sentinel 方法;集成 SkyWalking 追踪 Sentinel Entry。

四、Resilience4j 使用实战 + 原理剖析 + 开发关键事项

4.1 使用实战

4.1.1 引入依赖 & 配置(开发Tips:模块化配置)

-

支持 YAML/Properties/环境变量,开发时用 @ConfigurationProperties 绑定自定义配置。

<dependency> <groupId>io.github.resilience4j</groupId> <artifactId>resilience4j-spring-boot3</artifactId> </dependency> <dependency> <groupId>io.github.resilience4j</groupId> <artifactId>resilience4j-micrometer</artifactId> </dependency> <dependency> <groupId>io.github.resilience4j</groupId> <artifactId>resilience4j-reactor</artifactId> </dependency>resilience4j:

circuitbreaker:

configs:

default: # 全局默认(开发推荐)

sliding-window-type: count-based

sliding-window-size: 100

failure-rate-threshold: 50

slow-call-rate-threshold: 100

slow-call-duration-threshold: 60000

wait-duration-in-open-state: 5s

permitted-number-of-calls-in-half-open-state: 3

automatic-transition-from-open-to-half-open-enabled: true

instances:

orderCB:

base-config: default

ratelimiter:

instances:

orderRL:

limit-for-period: 20

limit-refresh-period: 1s

timeout-duration: 3s # 等待超时

bulkhead:

instances:

orderBulkhead:

max-concurrent-calls: 10 # 信号量隔离

max-wait-duration: 0

thread-pool-bulkhead: # 线程池隔离(开发慎用,高开销)

instances:

orderTP:

max-thread-pool-size: 10

core-thread-pool-size: 2

queue-capacity: 20

4.1.2 保护资源(注解 + 函数式)

java

@Service

public class OrderService {

@CircuitBreaker(name = "orderCB", fallbackMethod = "fallback")

@RateLimiter(name = "orderRL")

@Bulkhead(name = "orderBulkhead", type = Bulkhead.Type.SEMAPHORE) // 默认信号量

@Retry(name = "orderRetry") // 重试支持

public OrderDTO getOrder(Long id) {

// 业务

return new OrderDTO(id, "success");

}

public OrderDTO fallback(Long id, CallNotPermittedException ex) { // 特定异常处理

return new OrderDTO(id, "熔断: " + ex.getMessage());

}

}- 函数式版(开发推荐响应式场景):

java

@Controller

public class OrderController {

@GetMapping("/order/{id}")

public Mono<OrderDTO> getOrder(@PathVariable Long id) {

CircuitBreaker cb = CircuitBreaker.of("orderCB", CircuitBreakerConfig.custom().build());

return Mono.fromCallable(() -> service.getOrder(id))

.transformDeferred(CircuitBreakerOperator.of(cb))

.onErrorResume(e -> Mono.just(fallback(id, e)));

}

}- 开发关键事项:

- 注解顺序:@Retry最外层,@CircuitBreaker内层,避免重试放大故障。

- 配置继承:用 base-config 复用默认,开发时用 profiles 分环境(dev: 宽松阈值,prod: 严格)。

- 重试集成:@Retry(maxAttempts=3, waitDuration=500ms),开发测试 exponential backoff 防洪水攻击。

4.1.3 动态配置 + 事件监听

@Component

public class ResilienceConfig {

@EventListener

public void onCircuitBreakerEvent(CircuitBreakerOnStateTransitionEvent event) {

log.info("熔断状态变更: {} -> {}", event.getCircuitBreakerName(), event.getStateTransition());

// 开发Tip: 发告警到 Slack/Email

}

}4.2 深度原理剖析

-

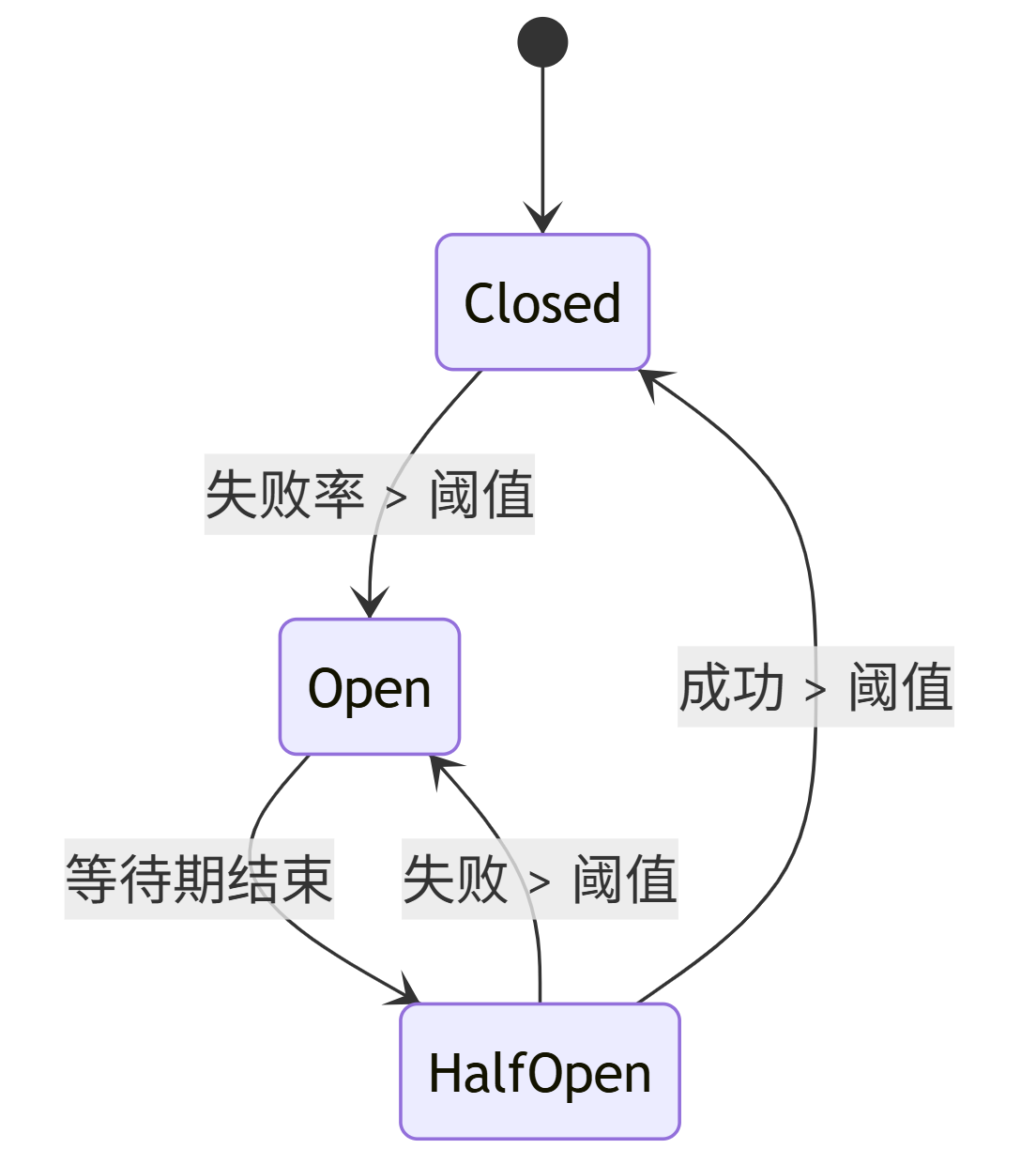

核心机制:状态机(CircuitBreaker:Closed → Open → Half-Open)。

-

源码

java// CircuitBreaker.decorateSupplier public <T> Supplier<T> decorateSupplier(CircuitBreaker cb, Supplier<T> supplier) { return () -> { if (cb.isCallPermitted()) { // 检查状态 try { T result = supplier.get(); cb.onSuccess(); return result; } catch (Throwable t) { cb.onError(t); throw t; } } else { throw CallNotPermittedException.create(...); } }; } -

为什么轻量:函数式装饰器,无外部服务;RingBitBuffer 高效统计(位运算)。

4.3 开发过程中的关键事项

Resilience4j 强调"函数式 + 轻量",开发中注重"配置即代码",以下关键事项助你高效开发:

实例配置策略:用 YAML 定义多个 instances(如 orderCB、userRL),避免全局配置冲突。开发时,用@CircuitBreaker(name = "specific") 指定实例。

- 关键:配置 sliding-window-type: COUNT_BASED/TIME_BASED,COUNT_BASED 适合突发流量。

Fallback 与异常处理:Fallback 方法签名必须匹配(参数 + Throwable)。开发时,用 Vavr Try 包装,避免 checked exception。

- 开发事项:测试 Fallback 覆盖率,用 Mockito mock 业务方法抛异常。

重试机制: @Retry(name = "orderRetry", maxAttempts: 3, waitDuration: 500ms)。关键:设 backoff: exponential 指数退避,防重试风暴。

- 调试事项:日志记录重试次数,开启 resilience4j.retry.logging-enabled: true。

隔离(Bulkhead):默认信号量(maxConcurrentCalls: 10),切换线程池(maxThreadPoolSize: 20)。开发时,线程池用于 IO 密集,信号量用于 CPU 密集。

- 关键:监控 queueCapacity,避免队列积压。用 ThreadPoolExecutor 自定义线程池。

限流(RateLimiter):limitForPeriod: 20/1s。开发时,结合 TimeLimiter 超时控制(timeoutDuration: 2s)。

- 测试策略:用 Gatling 模拟并发,验证 permissionsAvailable 指标。

状态监听与事件:用 CircuitBreaker.addStateTransitionListener 监听状态变更。开发时,集成 Actuator /micrometer 暴露事件。

- 关键:自定义 RegistryEventConsumer,规则变更时热加载配置(用 Spring Cloud Config)。

集成与扩展:与 Feign 用 Resilience4jFeign.builder();与 Gateway 用 Resilience4jGatewayFilterFactory。

- 开发事项:函数式装饰:CircuitBreaker.decorateSupplier(supplier),易于 Lambda。调试:用 resilience4j.micrometer: true 暴露指标到 Prometheus。

性能调优与监控:零外部依赖,开销极低。调优:ringBufferSizeInClosedState: 100 增大缓冲防误判。

- 关键:开发后期,用 JMH 基准测试装饰器开销;集成 Grafana Dashboard 监控 failureRate 等。

五、2026 年选型地图 + Hystrix 迁移指南

5.1 选型原则

- 大厂/复杂场景(高并发 + 集群限流 + 可视化):选 Sentinel

- 小项目/纯 Spring(轻量 + 函数式):选 Resilience4j

- 混合:Gateway 用 Sentinel,内部调用用 Resilience4j

5.2 Hystrix 迁移步骤

-

替换依赖:移除 Hystrix,添加 Sentinel/Resilience4j

-

注解迁移: @HystrixCommand→ @SentinelResource /@CircuitBreaker

-

配置迁移:线程池 → 信号量(Resilience4j 默认)

-

测试:模拟故障,验证熔断/降级

六、生产避坑 & 监控大盘

6.1 避坑(深度版)

- Sentinel 规则失效:优先级(热点 > 流控 > 系统),Nacos 刷新延迟 → 用 push 模式

- Resilience4j 状态丢失:无持久化 → 结合 Config Server 动态加载

- 性能瓶颈:Sentinel 统计粒度太细 → 调大 windowInterval

- 隔离误用:线程池开销大 → 优先信号量(99% 场景够用)

- 监控缺失:Sentinel 用 Dashboard;Resilience4j 暴露 Micrometer 指标

6.2 监控推荐

- Grafana + Prometheus:指标如 circuitbreaker_calls_successful / ratelimiter_available_permissions

- Sentinel Dashboard:实时大盘 + 簇点图

七、总结 & 行动计划

Sentinel/Resilience4j 是流量防护的双子星!通过对比 + 原理,你能根据项目精准选型。立即行动:

- 今天:跑通 Sentinel Dashboard + 基本规则

- 明天:Resilience4j 注解实战 + 状态机调试

- 后天:Hystrix 迁移 Demo + 性能基准

下一期:《Spring Cloud Config + Bus + Nacos 配置中心终极方案》