note

- 论文证明了 DeepSeek-OCR 的强性能很大程度上来自语言模型的"语言先验",而非真正的深度视觉理解,并指出这种依赖使得它在语义扰动或超长上下文下表现脆弱。

文章目录

一、Visual Merit or Linguistic Crutch?

《Visual Merit or Linguistic Crutch? A Close Look at DeepSeek-OCR》,https://arxiv.org/pdf/2601.03714,相关实验数据在https://anonymous.4open.science/r/ACL26-84B5/Readme.md

"依赖语言先验"并非DeepSeek-OCR独有的问题,而是"视觉编码+LLM解码"这类VL/OCR模型的架构共性,Qwen2.5-VL、HunyuanOCR、Nougat等所有端到端模型的通病,核心根源就是"视觉对齐LLM做解码"的设计逻辑。这类模型的核心设计是"视觉提取特征→LLM负责文本生成",而LLM的本质是基于语言统计规律建模,这就注定了LLM的解码逻辑优先依赖已知语言模式(词汇、句法、语义),而非纯粹的视觉信号,视觉特征只是"触发信号",当视觉信息模糊(高压缩、字符紊乱)时,LLM会自然调用自身的语言先验"补全",形成所谓的"幻觉"。

从另一个角度上看,这种工作价值其实不在于否定单个模型,而在于量化了这种依赖的严重程度(无先验时精度暴跌60%-80%),并点出了架构层面的trade-off:追求token压缩效率,必然以牺牲视觉鲁棒性为代价,现有OCR/VLM评估多聚焦自然文本准确率,通过"语义破坏""零语言先验""长文本压力测试"等方法,是一种"模型真实视觉能力"的评估方式。

二、实验

论文聚焦在一个核心评估问题:DeepSeek-OCR 的高性能是来自真实的视觉理解能力,还是模型强大的语言先验在"脑补"文本?

RQ1:句子级语义破坏如何影响DeepSeek-OCR?

实验设计上,基准数据采用Fox基准(112页英文文档,token长度600-2500),将真实文本渲染为图像(text2png)作为干净基准。

进行语义破坏:替换关键名词、动词和短语为"视觉相似但语义荒谬"的表达(如"butterfly"→"breadflutter"),保留字符形状和布局,仅消除语义连贯性,渲染为扭曲图像(distort)。

在DeepSeek-OCR的Tiny(高压缩)、Small、Base(低压缩)三种模式下,以OCR精度为指标对比text2png与distort的性能。结论是句子级语言先验是高压缩模式下的"语言拐杖"------视觉token稀缺时,模型依赖全局语义上下文重构文本;视觉token充足时(Base模式),对语言先验的依赖显著降低。

RQ2:单词级语义破坏如何影响DeepSeek-OCR?

实验设计上,基准数据延续Fox基准,设计3类单词级扰动策略:Swap:5%/10%单词随机交换2个字母(轻微拼写错误,语言先验可修复);Shuffle:5%/10%单词完全打乱字母顺序(破坏单词结构,保留字符分布);Zero-Prior:生成无词汇/句法结构的随机字符序列(完全无语言先验)。

评估同样在三种模式下测试OCR精度,结果是轻微扰动已导致性能下降,无语言先验时性能崩溃模型严重依赖词汇级语言先验,所谓"高压缩精度"本质是语言幻觉(基于先验猜测),而非真实视觉识别能力。

RQ3:语言先验依赖在不同VLM(视觉语言模型)和OCR架构中如何体现?

实验设计上,对比13种不同架构的VLM/OCR模型(参数125M-72B),包括DeepSeek-OCR(Tiny/Small)、端到端模型(HunyuanOCR、Nougat、Qwen2.5-VL等)、传统流水线模型(PaddleOCR-v5、MinerU),测试场景包括自然文本(有语言先验)与Zero-Prior随机文本(无语言先验),对比精度变化。

结果是端到端模型普遍依赖语言先验,传统流水线模型鲁棒性强,语言先验依赖是端到端架构的共性问题,传统流水线模型在无语言先验场景下更可靠。

RQ4:DeepSeek-OCR在QA(文本问答)和VQA(视觉问答)任务中的表现如何?

实验设计上,扩展Fox基准,为每页文档标注3个事实性问答对。对比模型包括VLM基线:Qwen2.5VL-3B/7B、Qwen3VL-4B/8B等;QA基线:Qwen2.5-3B、Llama3.2-3B等(与DeepSeek-OCR参数规模相当)。测试DeepSeek-OCR(VQA模式)、直接输入文本的LLM(QA模式)的问答准确率。

结果是VQA性能接近随机水平,标准LLM直接处理文本时,QA准确率超90%。光学压缩破坏了语义结构,模型仅能重构表面文本,无法保留下游推理所需的深层语义关系,且自身推理能力因过度优化文本重构而受损。

RQ5:光学压缩的上下文长度限制是什么?

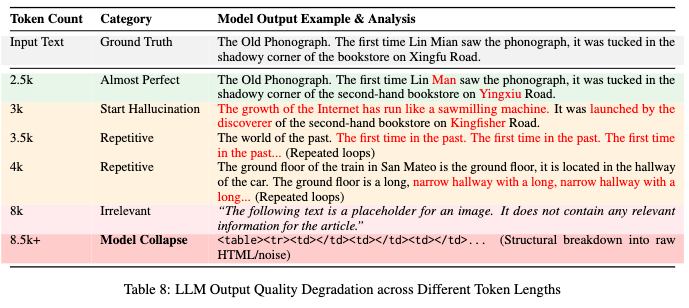

实验设计上,长文本数据集使用GPT-5.1生成5个5k词故事,重复至20,000token,按500token步长分割为40个片段(500-20,000token),渲染为文档图像,在DeepSeek-OCR的Tiny/Small/Base/Large四种模式下,测试不同token长度的OCR精度。

结果是光学压缩存在信息论瓶颈,固定网格视觉编码器的信息承载能力有限,超过8.5ktoken后信噪比低于解码阈值,反而加剧长上下文瓶颈(与设计目标相悖)。

在 DeepSeek-OCR 中,随着需要还原的输入文本(Input Text)变长、对应的解码 token 序列变长,模型的输出质量会系统性退化,说明其高性能并非来自稳定的视觉识别,而是越来越依赖语言模型的语言先验。

Reference

1\] Visual Merit or Linguistic Crutch? A Close Look at DeepSeek-OCR