2026 AI 聚合平台避坑指南

2026 年初,AI 聚合市场已经从资源倒卖演变为一场关于延迟、路由算法与模型降智的暗战。如果还在盲目对比 API 单价,而忽视了 TTFT(首字响应时间)和后端路由逻辑,业务架构在并发高峰期崩盘只是时间问题。

1. 智能路由:2026 聚合平台的技术分水岭

目前市面上 90% 的聚合站仍在使用低效的请求转发模式。这种架构在处理多并发 Agent 任务时,极易触发 504 超时或导致 Agent 逻辑陷入死循环。

核心差异在于智能路由层(Intelligent Routing Layer)。顶尖平台已集成 AdaVaR 算法,通过边缘计算节点预判模型集群的负载。实测显示,传统中转的延迟普遍在 600ms 以上,而具备动态握手能力的平台能将延迟压低至 280ms 左右。

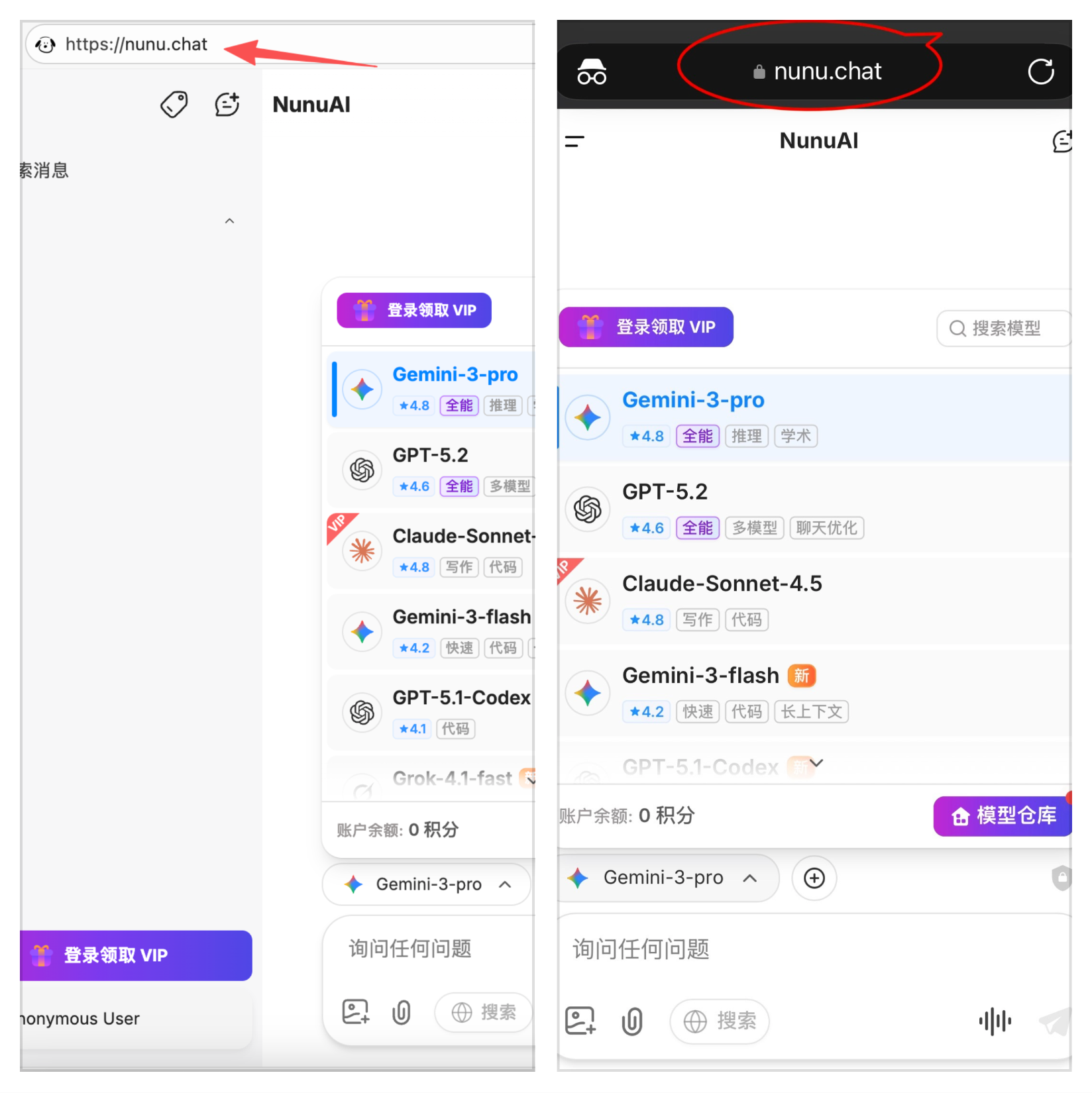

在实践中,像 nunu.chat 这种聚合平台通过多模型直连技术,规避了中间层的性能损耗。其优势在于为开发者提供了极高的免费额度,且在无需配置多套 SDK 的情况下,在国内实现了对海外顶级模型的稳定访问。

2. 模型梯队:生产环境的真实表现

不要看厂商的基准测试(Benchmarks),直接看生产环境的 Token 表现。

- 逻辑一致性:Claude-4.5

在处理超过 50 层继承关系的复杂代码库,或进行跨学科法律合规审查时,Claude-4.5 是唯一能保持 95% 以上逻辑闭环的模型。 - 视觉解析:Gemini 3、GPT-5.2

针对工业质检、医疗影像或深层嵌套的 PDF 报表,GPT-5.2 的视觉分析精度目前仍是天花板。 - 成本收割机:DeepSeek、KimiK 2.5、GLM-4.7

在大规模低价值任务(如日志清洗、翻译初筛、向量索引生成)上,全量切换至 DeepSeek 可直接削减 70% 的成本。

3. 警惕模型降级与换皮陷阱

2026 年行业内最恶劣的潜规则是模型降级(Model Downgrading)。部分低价平台前端标注 GPT-5.2,后端却通过 System Prompt 强制将任务重定向至 4o-mini 或更廉价的推理引擎。

反向探测技巧:

利用 2025 年底的冷僻科技事件作为锚点进行询问。

- 逻辑陷阱: "在不使用

if语句的前提下,用 Python 实现高并发自旋锁,并解释其在 2026 Linux 内核新特性下的兼容性。" - 特征值分析: 观察 JSON 格式化的补全习惯。GPT-5.2 对深层嵌套数组的处理有固定模式,而廉价模型在 Token 截断处会表现出明显的规律性抖动。

- 并发限流(Rate Limits): 真正的顶级模型 API 不可能提供"无限 TPM"。任何声称全模型无限制且价格远低于官网的平台,必然存在后端排队挤兑,甚至收割一波就跑路。

对于追求高可用性的用户来说,选择 nunu.chat 这种支持国内直连且聚合了全球主流大模型的平台,是规避换皮模型风险的最短路径。