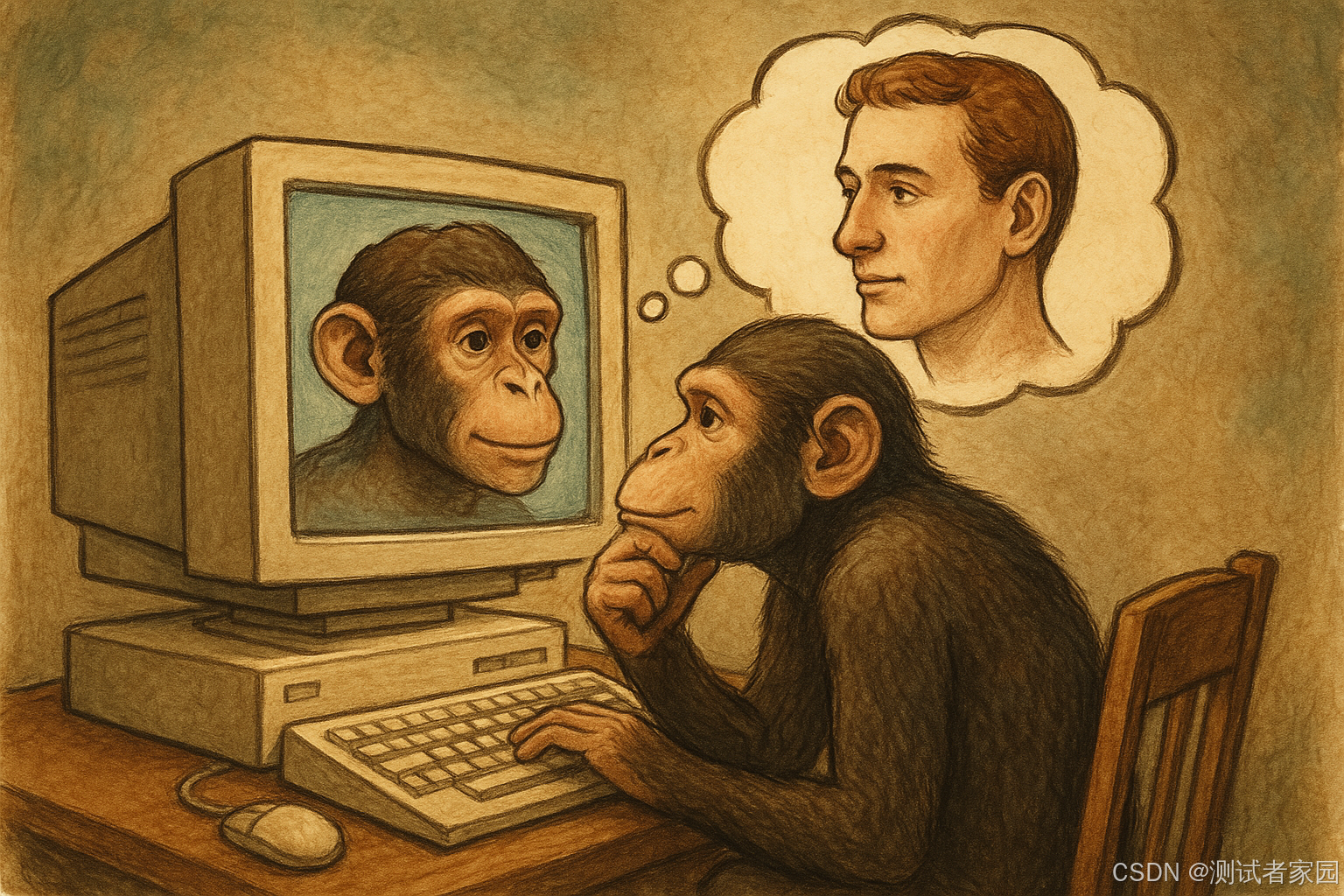

当大模型开始批量生成测试用例时,很多团队产生了一种近乎本能的兴奋:

需求文档一输入,数百条测试用例瞬间产出;边界场景自动补齐;异常路径自动展开;甚至还能生成自动化脚本。

这看起来像是一场效率革命。

但冷静下来,我们必须面对一个更本质的问题:

测试用例智能生成,究竟是在提升测试能力,还是在放大输入质量问题,把"垃圾进,垃圾出"推向规模化?

本文将从工程实践、认知模型与组织能力三个维度,系统拆解这一命题。

一、测试用例生成的本质:认知映射,而非文本扩写

在讨论"智能生成"之前,我们必须先厘清一个常被忽略的事实:

测试用例不是文本产物,而是认知结构的外显形式。

一个高质量测试用例背后,包含三层认知:

-

需求结构理解(功能边界、隐含约束)

-

风险识别能力(异常路径、状态转换、极端条件)

-

系统行为预测能力(接口协作、依赖链传播)

如果输入模型的仅仅是一份表述模糊的需求文档,那么模型生成的内容本质上是对模糊结构的再表达,而不是风险洞察。

这正是"垃圾进,垃圾出"的根源。

二、为什么智能生成看起来效果很好?

许多团队在初期实践中都会得到不错的效果,原因主要有三个:

1. 大模型擅长结构化展开

例如:

-

自动识别边界值

-

自动生成等价类划分

-

自动补充异常输入

-

自动扩展状态流转路径

在语义明确的场景下,模型的覆盖率往往高于人工初稿。

2. 大模型具备模式迁移能力

训练数据中包含大量:

-

表单验证逻辑

-

登录鉴权逻辑

-

电商订单流程

-

权限控制场景

当业务与通用模式相似时,模型可以快速迁移已有"测试模板"。

3. 规模优势带来错觉

人工写 30 条用例,模型生成 300 条。

数量上的"压倒性优势"容易掩盖质量结构上的问题。

但真正的风险隐藏在细节里。

三、"垃圾进,垃圾出"的三种典型表现

1. 需求不完整 → 风险被合理化

如果需求文档缺少:

-

错误处理策略

-

超时机制说明

-

并发处理规则

-

数据一致性定义

模型不会主动质疑,而会默认一种"合理假设"。

这会导致测试用例逻辑自洽,但与真实系统行为脱节。

本质上,模型在填补需求空白,而不是发现需求漏洞。

2. 架构不可见 → 关键风险缺失

测试用例质量高度依赖对系统架构的理解:

-

是否存在缓存

-

是否异步处理

-

是否多副本写入

-

是否存在最终一致性延迟

如果模型无法获取架构信息,那么生成结果往往停留在功能层面,而忽略:

-

竞态条件

-

分布式一致性风险

-

降级链路

-

熔断策略验证

这类风险恰恰是高价值测试。

3. 数据质量低 → 自动化脚本失真

当智能生成直接输出自动化脚本时,如果:

-

测试数据模型不规范

-

接口定义不完整

-

返回码约定混乱

模型会基于错误结构生成"可运行但错误"的脚本。

这类问题更隐蔽,因为脚本可以运行,却验证了错误的逻辑。

四、真正的效率革命来自哪里?

智能生成的价值,并不在于替代测试思考,而在于:

把测试工程师从"机械展开"中解放出来,转向"风险建模"。

真正的效率革命体现在三点。

1. 从"文本驱动"转向"结构驱动"

如果输入的不只是需求文档,而是:

-

需求结构图

-

业务状态机

-

接口契约定义

-

架构依赖图

-

历史缺陷数据库

那么生成过程将不再是语言扩写,而是基于多维结构的风险推演。

此时,模型角色发生改变:

从"写作助手"变为"测试分析引擎"。

2. 引入RAG机制降低"垃圾进"风险

通过知识增强机制(RAG):

-

注入历史线上事故

-

注入典型缺陷模式

-

注入架构设计说明

-

注入非功能指标要求

模型将基于组织真实风险进行生成,而非通用模式推测。

这能显著提升用例价值密度。

3. 人机协作闭环

高成熟度团队不会直接接受生成结果,而是采用:

-

模型生成初稿

-

人工做风险裁剪

-

模型做补充优化

-

自动去重与优先级排序

-

人工做关键场景确认

智能生成成为"认知加速器",而非替代者。

五、质量评估:如何避免规模化错误?

如果要让智能生成真正落地,必须建立质量评估体系。

可以从四个维度进行度量:

1. 风险覆盖率

-

是否覆盖关键依赖链?

-

是否包含异常路径?

-

是否触达历史高频缺陷模块?

2. 逻辑独立性

-

是否存在语义重复?

-

是否只是边界值换数字?

3. 可执行性

-

是否具备可验证断言?

-

是否具备明确前置条件?

4. 缺陷捕获能力

- 是否能够捕获已知真实缺陷?

如果没有评估机制,智能生成只会成为"高产低质"的流水线。

六、组织层面的深层影响

智能生成的真正挑战不在技术,而在组织能力。

1. 测试工程师能力模型将改变

未来测试工程师需要具备:

-

需求结构建模能力

-

风险抽象能力

-

Prompt工程能力

-

数据治理能力

-

架构理解能力

单纯"写用例能力"将不再构成核心竞争力。

2. 需求质量将被放大检验

如果需求本身存在结构缺陷,智能生成会将问题规模化放大。

因此,需求规范化成为前置条件。

3. 质量左移程度进一步加深

智能生成可以在需求评审阶段就生成风险列表。

这意味着测试更早介入设计。

测试角色将更接近架构与产品决策层。

七、智能生成的未来方向

从当前趋势看,未来将演进为:

1. 多模态输入

-

原型图识别

-

时序图解析

-

架构图理解

2. 风险预测驱动生成

-

基于变更diff自动生成回归用例

-

基于历史缺陷预测高风险区域

3. 自学习系统

-

每次线上缺陷自动反向强化生成模型

-

形成组织专属测试知识库

这将真正实现:

测试能力的"数据资产化"。

结语

测试用例智能生成,不是简单的效率工具。

它像一面放大镜:

-

优秀的输入,会被放大为高质量风险模型;

-

模糊的输入,会被规模化复制为低价值内容。

因此,问题不在于"模型能否生成",而在于:

-

我们是否具备结构化需求能力?

-

是否具备系统风险建模能力?

-

是否建立了质量评估机制?

智能生成既可能是效率革命,也可能是规模化幻觉。

最终的分水岭,不在模型能力,而在组织的认知成熟度。

当测试不再只是写用例,而是构建风险认知体系时,智能生成才真正成为推动质量跃迁的工具,而不是新的技术泡沫。