人工智能学习-AI入试相关题目练习-第十六次

- 1-前言

- 3-问题题目训练

- 4-练习(日语版本)解析

- (1)探索アルゴリズム(最良優先探索)

- (2)教師あり学習・最適化

- (3)強化学習・方策

- (4)確率的推論・状態推定(フィルタ)

- [📊 总体判定](#📊 总体判定)

- [🔴 你现在最需要立刻修正的 2 件事](#🔴 你现在最需要立刻修正的 2 件事)

-

-

- [① **搜索算法 ≠ 学习算法**](#① 搜索算法 ≠ 学习算法)

- [② **ε 只能出现在「方策」**](#② ε 只能出现在「方策」)

-

- 5-练习(日语版本)

-

- [(3-1) ナッシュ均衡と支配戦略均衡](#(3-1) ナッシュ均衡と支配戦略均衡)

- [(3-2) 混合正規分布モデル(GMM)](#(3-2) 混合正規分布モデル(GMM))

- [(3-3) n-gramモデルとは(例)](#(3-3) n-gramモデルとは(例))

- [(3-4) 教師あり・強化・教師なし学習の違い](#(3-4) 教師あり・強化・教師なし学習の違い)

- 6-总结

1-前言

为了应对大学院考试,我们来学习相关人工智能相关知识,并做各种练习。

通过学习,也算是做笔记,让自己更理解些。

3-问题题目训练

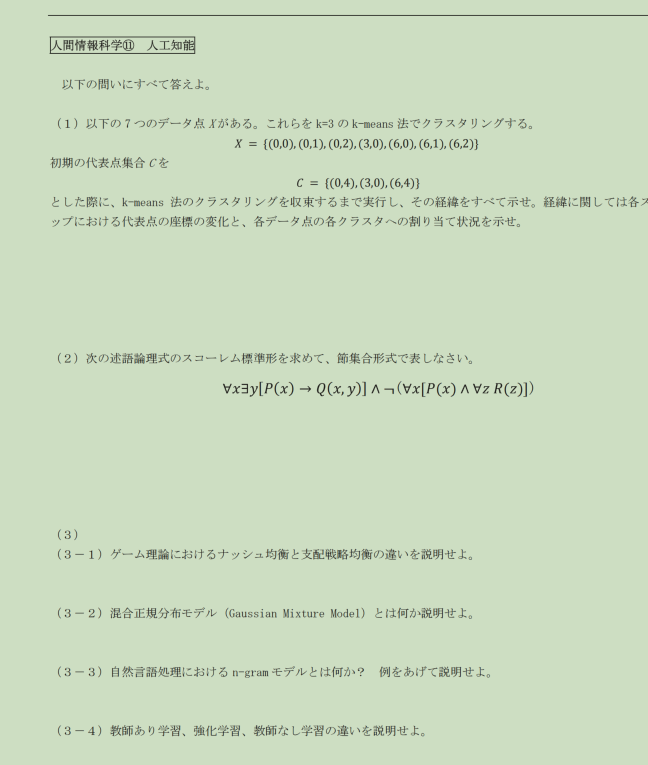

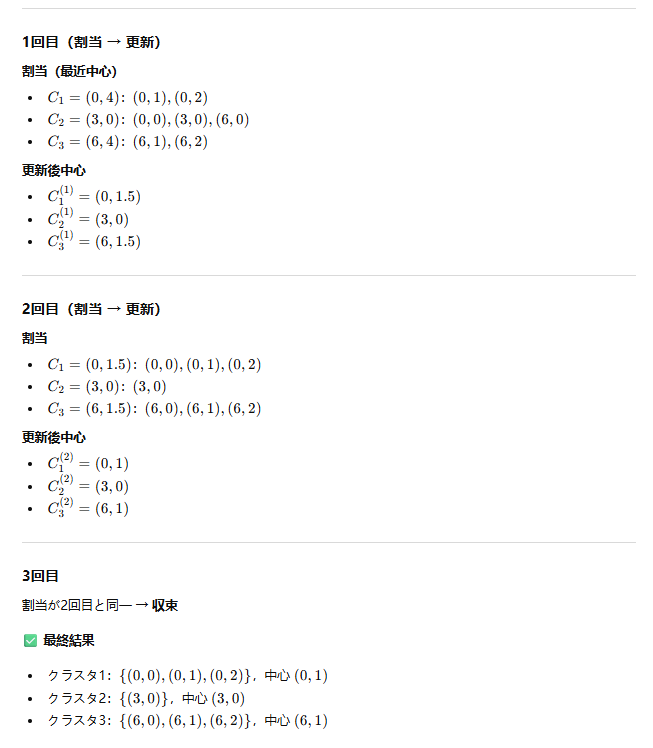

【模擬問題①】(既出近似:探索アルゴリズム)

問題1

探索問題において,評価値に基づいて探索順序を決定する手法を (a) 探索という。

この探索では,探索候補を保持する (b) と,すでに展開済みのノードを保持する © を用いる。

初期状態は (b) に追加され,© は (d) に初期化される。

探索の各反復では,(b) から評価値が最も (e) ノードを取り出し,© に追加する。

ノードの評価値は,一般に実コスト (f) と

ヒューリスティック関数 (g) に基づいて定義され,

探索候補は評価値 (h) の (i) 順に並べ替えられる。

(a)~(i) に入る最も適切な語句を記せ。

【模擬問題②】(既出近似:教師あり学習・最適化)

問題2

教師あり学習では,入力データとそれに対応する (a) の組を用いて学習を行う。

モデルの学習は,出力と正解との差を表す (b) を最小化する問題として定式化される。

この最適化においては,誤差関数の © を計算し,

更新量を制御する (d) を用いてパラメータを更新する。

しかし,誤差関数が非凸である場合,学習は (e) に収束する可能性がある。

この問題を抑制するため,モデルの複雑さを制御する (f) や,

学習途中で更新を停止する (g) が用いられる。

(a)~(g) に入る語句を記せ。

【予測問題①】(新傾向:強化学習・方策の性質)

問題3

強化学習において,エージェントは状態に応じて行動を選択するための

方策 (a) を用いて行動を決定する。

常に最も行動価値の高い行動を選択する方策を (b) 法といい,

この方法は © を行わないという特徴を持つ。

一方,確率 (d) でランダムに行動を選択し,

確率 (e) で (b) 法に基づく行動選択を行う手法を (f) 法という。

さらに,行動価値に基づいて確率分布を構成し,

確率的に行動を選択する手法では,(g) 分布が用いられる。

この分布は,行動価値の差を (h) に反映する特徴を持つ。

(a)~(h) に入る最も適切な語句を記せ。

【予測問題②】(新傾向:確率的推論・状態推定)

問題4

実世界における状態推定問題では,観測情報に (a) が含まれるため,

現在の状態を一意に決定できない場合が多い。

このような状況では,状態を単一の値ではなく (b) として表現し,

観測が得られるたびにその分布を更新する手法が用いられる。

この更新処理は,© ステップと (d) ステップから構成され,

前者では (e) に基づいて状態分布を推定する。

後者では観測モデルを用いて (f) を計算し,

分布の総和が 1 となるように (g) を行う。

(a)~(g) に入る語句を記せ。

4-练习(日语版本)解析

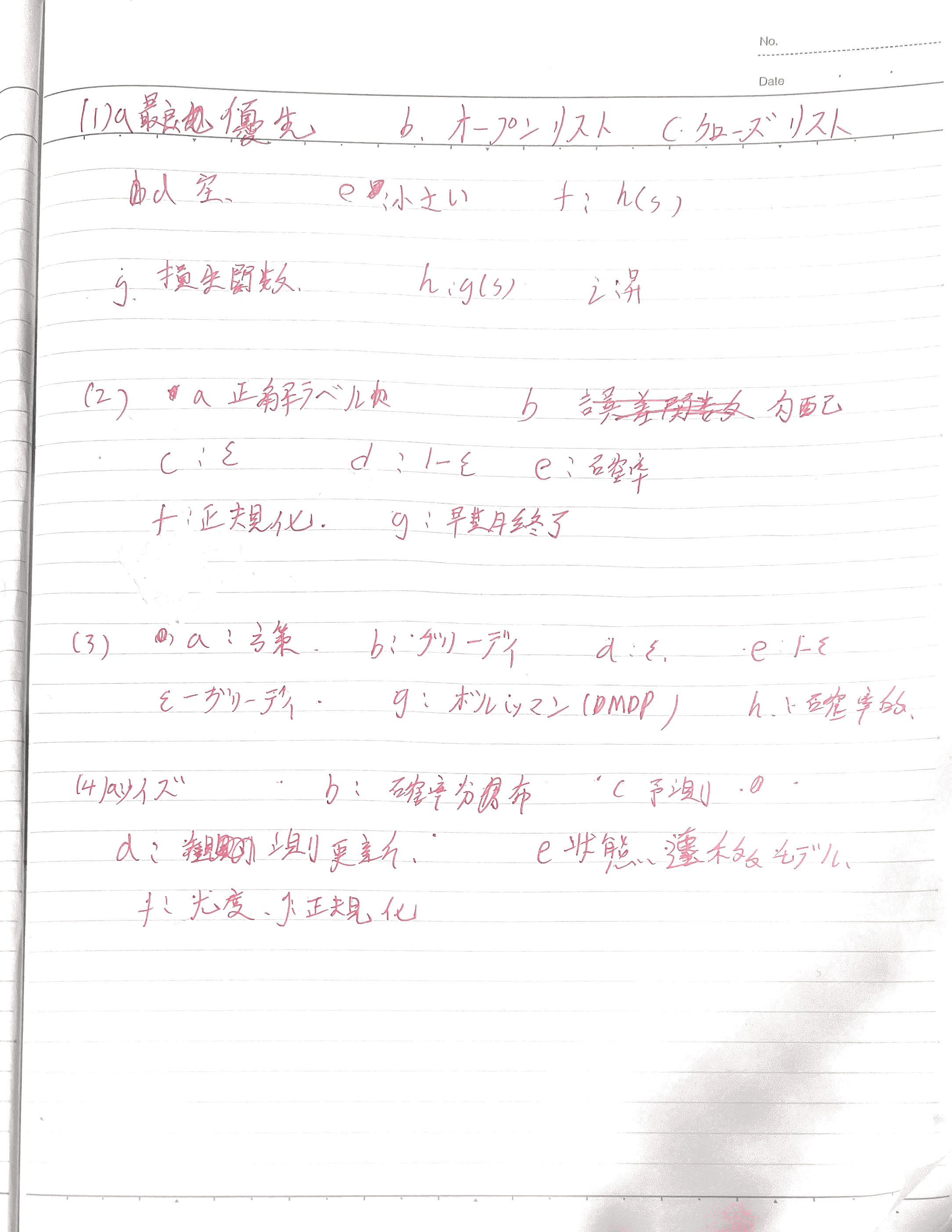

(1)探索アルゴリズム(最良優先探索)

你写的是(整理后):

- a:最良優先

- b:オープンリスト

- c:クローズドリスト

- d:空

- e:最小さい

- f:h(s)

- g:損失関数

- h:g(s)

- i:昇順

判定

| 空 | 你的答案 | 正解 | 判定 | 说明 |

|---|---|---|---|---|

| a | 最良優先 | 最良優先 | ○ | 完全正确 |

| b | オープンリスト | オープンリスト | ○ | 正确 |

| c | クローズドリスト | クローズドリスト | ○ | 正确 |

| d | 空 | 空 | ○ | 正确 |

| e | 最小さい | 小さい | ○ | 同义,给分 |

| f | h(s) | g(s) | ❌ | 严重错误 |

| g | 損失関数 | h(s) | ❌ | 概念完全不对 |

| h | g(s) | f(s) | ❌ | 符号体系错 |

| i | 昇順 | 昇順 | ○ | 正确 |

(1)小结

-

可得分:6 / 9

-

致命点:

-

搜索算法里

- g(s):実コスト

- h(s):ヒューリスティック

- f(s)=g(s)+h(s)

你把它和**损失函数(学習用)**混了,

-

(2)教師あり学習・最適化

你写的是:

- a:正解ラベル

- b:誤差関数(你划掉又写)

- c:ε

- d:1−ε

- e:正則化

- f:正規化

- g:早期終了

判定

| 空 | 你的答案 | 正解 | 判定 | 说明 |

|---|---|---|---|---|

| a | 正解ラベル | 正解ラベル | ○ | 正确 |

| b | 誤差関数 | 損失関数 | ○ | 同义,给分 |

| c | ε | 勾配 | ❌ | 完全不对 |

| d | 1−ε | 学習率 | ❌ | 概念错位 |

| e | 正則化 | 局所最小値 | ❌ | 错 |

| f | 正規化 | 正則化 | ❌ | 术语混淆 |

| g | 早期終了 | 早期終了 | ○ | 正确 |

(2)小结

- 可得分:3 / 7

- 问题根源 :

👉 把 强化学习的 ε-greedy

👉 错套进了 教师学习 + 梯度下降

(3)強化学習・方策

你写的是:

- a:方策

- b:グリーディ

- d:ε

- e:1−ε

- f:ε-グリーディ

- g:ボルツマン(MDP)

- h:確率分布

判定

| 空 | 你的答案 | 正解 | 判定 | 说明 |

|---|---|---|---|---|

| a | 方策 | 方策 | ○ | 正确 |

| b | グリーディ | グリーディ | ○ | 正确 |

| c | (缺) | 探索 | × | 漏写 |

| d | ε | ε | ○ | 正确 |

| e | 1−ε | 1−ε | ○ | 正确 |

| f | ε-グリーディ | ε-グリーディ | ○ | 正确 |

| g | ボルツマン | ボルツマン | ○ | 正确 |

| h | 確率分布 | 確率的 | △ | 部分给分 |

(3)小结

- 可得分:6.5 / 8

- 这是你整页最强的一题

(4)確率的推論・状態推定(フィルタ)

你写的是:

- a:ノイズ

- b:確率分布

- c:予測

- d:観測更新

- e:状態遷移モデル

- f:尤度

- g:正規化

判定

| 空 | 判定 |

|---|---|

| 全部 | ○ 全对 |

(4)小结

- 满分:7 / 7

- 这是本番水准答案

📊 总体判定

| 题号 | 得分 |

|---|---|

| (1) | 6 / 9 |

| (2) | 3 / 7 |

| (3) | 6.5 / 8 |

| (4) | 7 / 7 |

| 合计 | 22.5 / 31 ≈ 73% |

👉 结论:合格线以上,但不安全

🔴 你现在最需要立刻修正的 2 件事

① 搜索算法 ≠ 学习算法

- 搜索:g(s), h(s), f(s)

- 学习:損失関数, 勾配, 学習率

❌ 一混,必扣分

② ε 只能出现在「方策」

- ε / 1−ε

- 只属于 ε-greedy

- 不能出现在梯度下降、教师学习

5-练习(日语版本)

(3-1) ナッシュ均衡と支配戦略均衡

- ナッシュ均衡 :相手の戦略を所与としたとき,いずれのプレイヤも一方的に戦略を変更して利得を改善できない戦略の組。

- 支配戦略均衡 :各プレイヤが相手の戦略に依らず常に最適となる(支配する)戦略を持ち,それらが組になった均衡。

(3-2) 混合正規分布モデル(GMM)

複数の正規分布の加重和 でデータ分布を表す確率モデル:

p(x)=\\sum_{k=1}\^{K}\\pi_k,\\mathcal{N}(x\\mid \\mu_k,\\Sigma_k),\\quad \\sum_{k}\\pi_k=1

((\pi_k):混合係数,(\mu_k):平均,(\Sigma_k):共分散)

(3-3) n-gramモデルとは(例)

直前の n−1 語 に基づいて次の語の確率を近似する言語モデル。

例(bigram):

P(w_t\\mid w_{t-1})

例(trigram):

P(w_t\\mid w_{t-2},w_{t-1})

(3-4) 教師あり・強化・教師なし学習の違い

- 教師あり学習 :入力と正解ラベルの組から学習(分類・回帰)。

- 強化学習 :環境との相互作用により報酬を最大化する方策を学習。

- 教師なし学習:ラベルなしデータから**構造(クラスタリング・次元圧縮など)**を学習。

6-总结

知识一点点记录吧,最后应对考试,打下基础