作者:卢建晖 - 微软高级云技术布道师

排版:Alan Wang

引言

在当今快速发展的 AI 环境中,开发者常常面临一个关键选择:我们应该使用需要互联网连接、功能强大的云端大语言模型(LLM),还是使用可在本地运行但能力有限的小语言模型(SLM)?答案并不是非此即彼------而是混合模型,通过结合两者的优势,构建既安全、高效,又强大的 AI 解决方案。

本文将通过 GenGitHubRepoPPT 的视角,探讨混合模型架构,展示如何将 Microsoft Foundry Local、GitHub Copilot SDK 以及其他技术优雅地结合起来,从 GitHub README 文件中自动生成专业的 PowerPoint 演示文稿。

混合模型的应用场景与价值

什么是混合模型?

混合 AI 模型是在同一个应用中,有策略地将本地运行的小语言模型(SLM)与基于云的大语言模型(LLM)结合起来,并根据任务的不同特性,为每个任务选择最合适的模型。

核心原则:

-

敏感数据的本地处理:隐私敏感内容的分析在本地设备上完成

-

云端用于价值创造:复杂推理和创造性生成依赖云端能力

-

成本与性能的平衡:高频、简单任务在本地运行,以减少 API 成本

典型混合模型使用场景

为什么选择混合模型?

三大核心优势:

-

隐私与安全

-

敏感数据不会离开本地设备

-

符合 GDPR、HIPAA 等法规

-

适用于企业内部文档和个人信息

-

-

成本优化

-

减少云端 API 调用频率

-

本地模型无使用费用

-

运维成本可预测

-

-

性能与可靠性

-

本地处理消除网络延迟

-

离线环境下可提供部分功能

-

云端模型确保高质量输出

-

核心技术解析

大语言模型(LLM):云端智能的代表

什么是 LLM?

大语言模型是基于深度学习的自然语言处理模型,通常具有数十亿到数万亿参数。通过在海量文本数据上的训练,它们获得了强大的语言理解和生成能力。

代表模型:

-

Claude Sonnet 4.5:Anthropic 的旗舰模型,擅长长上下文处理和复杂推理

-

GPT-5.2 系列:OpenAI 的通用语言模型

-

Gemini:Google 的多模态大模型

LLM 的优势:

-

✅ 出色的文本生成质量

-

✅ 强大的上下文理解能力

-

✅ 支持复杂推理任务

-

✅ 持续的模型更新与优化

典型应用:

-

专业文档写作(技术报告、商业计划)

-

代码生成与重构

-

多语言翻译

-

创意内容生成

小语言模型(SLM)与 Microsoft Foundry Local

SLM 的特性

小语言模型通常拥有 10 亿到 70 亿参数,专为资源受限环境设计。

主流 SLM 模型家族:

-

Microsoft Phi 系列:推理优化的高效模型

-

阿里 Qwen 系列:优秀的中文能力

-

Mistral 系列:小参数规模下的出色性能

SLM 的优势:

-

⚡ 低延迟响应(毫秒级)

-

💰 零 API 成本

-

🔒 完全本地运行,数据留在设备上

-

📱 适合边缘设备部署

Microsoft Foundry Local:本地 AI 的基础

Foundry Local 是微软的本地 AI 运行时工具,使开发者能够在 Windows 或 macOS 设备上轻松运行 SLM。

核心特性:

兼容 OpenAI 的 API

bash

# Using Foundry Local is like using OpenAI API

from openai import OpenAI

from foundry_local import FoundryLocalManager

manager = FoundryLocalManager("qwen2.5-7b-instruct")

client = OpenAI(

base_url=manager.endpoint,

api_key=manager.api_key

)-

硬件加速支持

-

CPU:通用计算支持

-

GPU:NVIDIA、AMD、Intel 显卡加速

-

NPU:高通、Intel AI 专用芯片

-

Apple Silicon:Neural Engine 优化

-

-

基于 ONNX Runtime

-

跨平台兼容

-

高度优化的推理性能

-

支持模型量化(INT4、INT8)

-

便捷的模型管理

-

bash

# View available models

foundry model list

# Run a model

foundry model run qwen2.5-7b-instruct-generic-cpu:4

# Check running status

foundry service psFoundry Local 的应用价值:

-

🎓 教育场景:无需云订阅即可学习 AI 开发

-

🏢 企业环境:在合规前提下处理敏感数据

-

🧪 研发测试:无 API 成本顾虑的快速原型

-

✈️ 离线环境:可在飞机、地铁等无网络场景使用

GitHub Copilot SDK:从 Agent 到业务价值的快速通道

什么是 GitHub Copilot SDK?

GitHub Copilot SDK 于 2026 年 1 月 22 日 以技术预览形式发布,是 AI Agent 开发领域的一次重大变革。与其他 AI SDK 不同,Copilot SDK 不仅提供 API 调用接口,还提供了一个完整的、可用于生产环境的 Agent 执行引擎。

传统 AI 应用开发通常需要自行构建:

-

❌ 上下文管理系统(多轮对话状态)

-

❌ 工具编排逻辑(决定何时调用哪个工具)

-

❌ 模型路由机制(在不同 LLM 之间切换)

-

❌ MCP 服务器集成

-

❌ 权限与安全边界

-

❌ 错误处理与重试机制

Copilot SDK 开箱即用地提供了上述所有能力,使开发者能够专注于业务逻辑,而非底层基础设施。

核心优势:从概念到代码的超短路径

生产级 Agent 引擎:经实战验证的可靠性

Copilot SDK 使用与 GitHub Copilot CLI 相同的 Agent 核心,这意味着:

-

✅ 已在数百万真实开发者场景中验证

-

✅ 能够处理复杂的多步骤任务编排

-

✅ 自动进行任务规划与执行

-

✅ 内置错误恢复机制

真实示例:

在 GenGitHubRepoPPT 项目中,我们无需手动编写"如何将提纲转换为 PPT"的逻辑,只需向 Copilot SDK 描述目标,它便会自动完成:

-

分析提纲结构

-

规划幻灯片布局

-

调用文件创建工具

-

应用格式化逻辑

-

处理多语言适配

bash

# Traditional approach: requires hundreds of lines of code for logic

def create_ppt_traditional(outline):

slides

= parse_outline(outline)

for slide in slides:

layout = determine_layout(slide)

content = format_content(slide)

apply_styling(content, layout)

# ... more manual logic

return ppt_file

# Copilot SDK approach: focus on business intent

session = await client.create_session({

"model": "claude-sonnet-4.5",

"streaming": True,

"skill_directories": [skills_dir]

})

session.send_and_wait({"prompt": prompt}, timeout=600)自定义 Skills:可复用的业务知识封装

这是 Copilot SDK 最强大的特性之一。在传统 AI 开发中,每次调用都需要提供完整的 Prompt 和上下文。通过 Skills,你可以:

一次定义,永久复用:

bash

# .copilot_skills/ppt/SKILL.md

# PowerPoint Generation Expert Skill

## Expertise

You are an expert in business presentation design, skilled at transforming

technical content into easy-to-understand visual presentations.

## Workflow

1. **Structure Analysis**

- Identify outline hierarchy (titles, subtitles, bullet points)

- Determine topic and content density for each slide

2. **Layout Selection**

- Title slide: Use large title + subtitle layout

- Content slides: Choose single/dual column based on bullet count

- Technical details: Use code block or table layouts

3. **Visual Optimization**

- Apply professional color scheme (corporate blue + accent colors)

- Ensure each slide has a visual focal point

- Keep bullets to 5-7 items per page

4. **Multilingual Adaptation**

- Choose appropriate fonts based on language (Chinese: Microsoft YaHei, English: Calibri)

- Adapt text direction and layout conventions

## Output Requirements

Generate .pptx files meeting these standards:

- 16:9 widescreen ratio

- Consistent visual style

- Editable content (not images)

- File size < 5MB业务代码生成能力

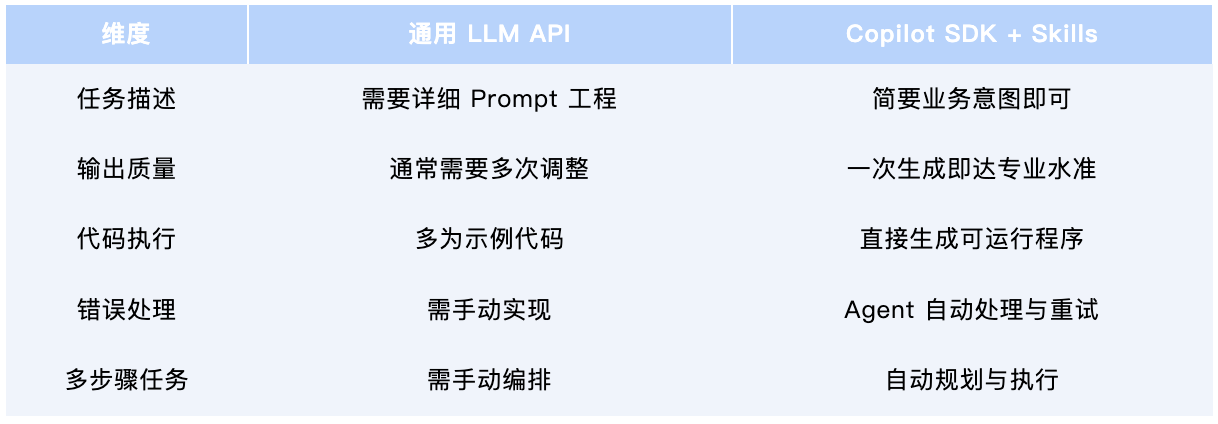

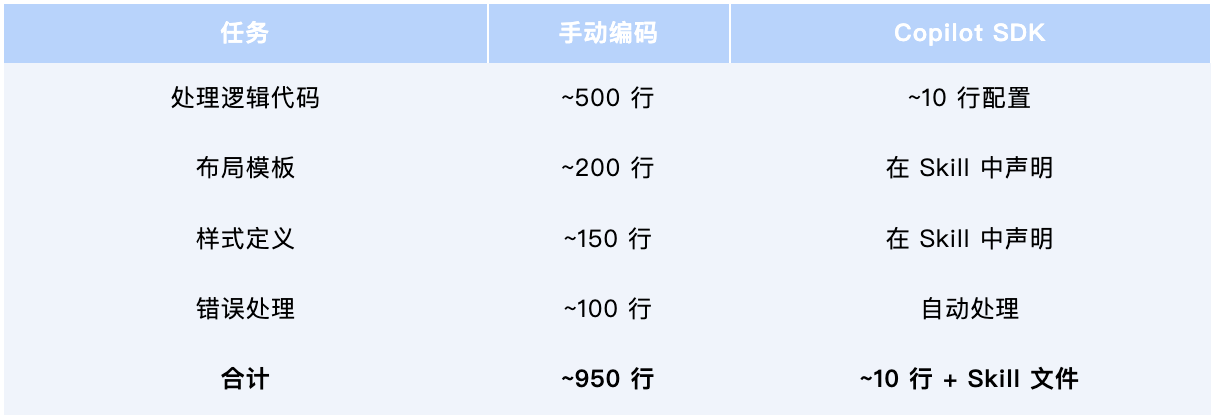

这是该项目的核心价值。与通用 LLM API 不同,结合 Skills 的 Copilot SDK 能够生成真正可执行的业务代码。

对比示例:

手动编码工作量对比:

GenGitHubRepoPPT 案例研究

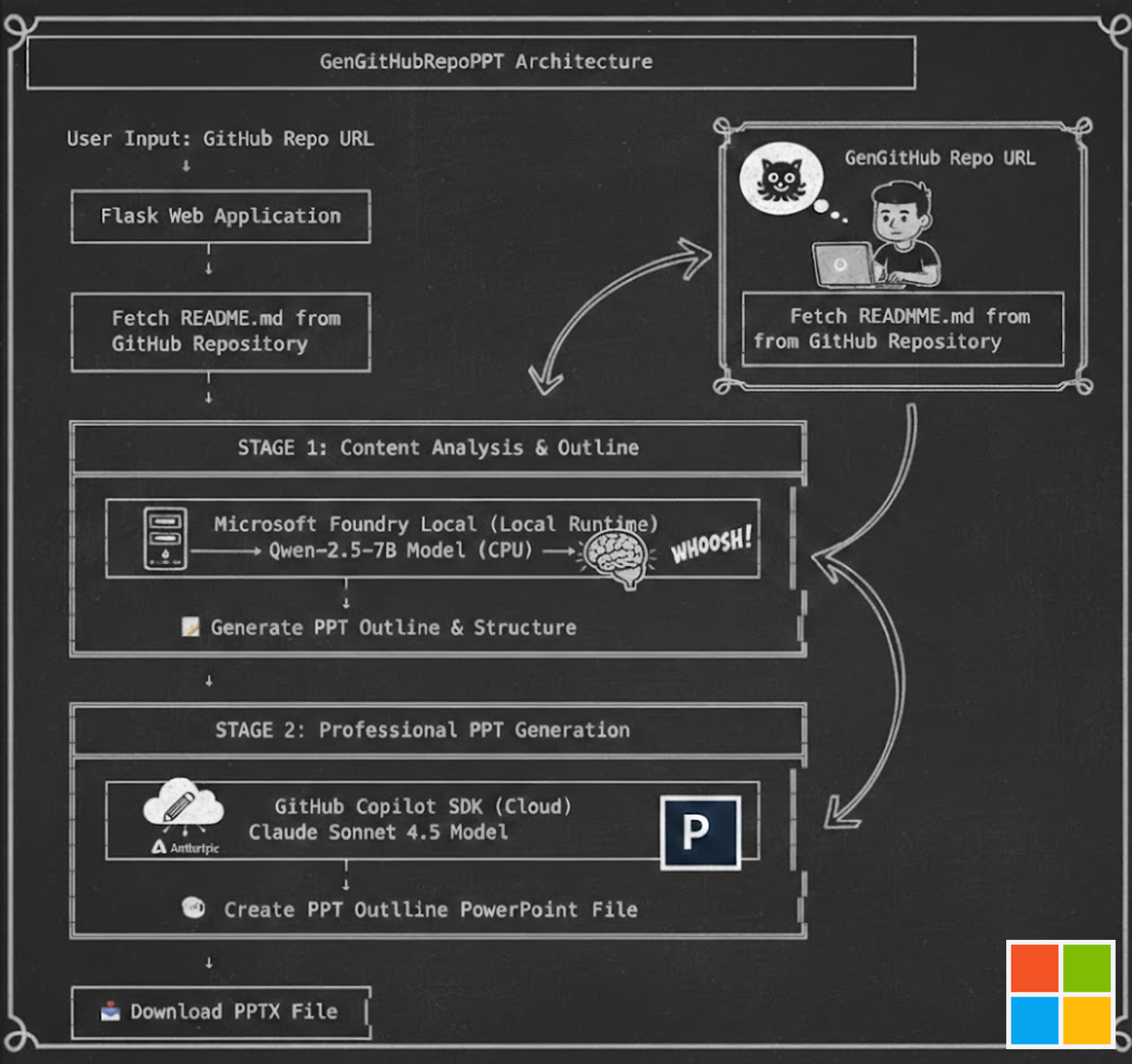

项目概述

GenGitHubRepoPPT 是一个创新的混合 AI 解决方案,通过结合本地 AI 模型与云端 AI Agent,在 5 分钟内 从 GitHub 仓库 README 文件自动生成专业 PowerPoint 演示文稿。

技术架构:

为什么采用混合模型?

阶段 1:本地 SLM 处理敏感数据

任务:

分析 GitHub README,提取关键信息,生成结构化提纲。

选择 Qwen-2.5-7B + Foundry Local 的原因:

-

隐私保护

-

README 可能包含内部项目信息

-

本地处理确保数据不离开设备

-

符合数据合规要求

-

-

成本效益

-

每次分析涉及数千 token

-

高频场景下云端 API 成本较高

-

本地模型无额外费用

-

性能

-

Qwen-2.5-7B 擅长文本分析任务

-

优秀的中文支持

-

可接受的 CPU 推理延迟(通常 2--3 秒)

-

阶段 2:云端 LLM + Copilot SDK 创造业务价值

任务:

基于提纲生成格式良好的 PowerPoint 文件。

选择 Claude Sonnet 4.5 + Copilot SDK 的原因:

- 自动化业务代码生成

- 传统方式的痛点:

需要手写 500+ 行 PPT 布局逻辑

需要深入理解 python-pptx API

样式和格式代码容易出错

多语言支持需要额外条件逻辑

- Copilot SDK 方案:

通过 Skills 声明业务规则与最佳实践

Agent 自动生成并执行所需代码

复杂布局逻辑实现零手写

开发时间从 2--3 天缩短至 2--3 小时

-

从意图到执行的超短路径对比:实现"生成专业 PPT"的不同方式

-

生产级可靠性与质量保障

-

经实战验证的 Agent 引擎:

-

使用与 GitHub Copilot CLI 相同的核心

-

在数百万真实场景中验证

-

自动处理边界情况与错误

-

-

一致的输出质量:

-

通过 Skills 确保专业标准

-

自动验证生成文件

-

内置重试与错误恢复机制

-

- 快速迭代与优化能力

场景:客户端请求调整 PPT 样式

总结

混合模型 + Copilot SDK 的核心价值

GenGitHubRepoPPT 项目展示了混合模型与 Copilot SDK 结合所带来的 AI 应用开发新范式。

隐私与成本的平衡

混合方案使敏感 README 分析能够在本地通过 Qwen-2.5-7B 完成,确保数据不离开设备且零 API 成本。同时,真正创造价值的工作------生成专业 PowerPoint------则通过 Copilot SDK 使用 Claude Sonnet 4.5 完成,输出质量与成本相匹配。

从代码到意图

传统 AI 开发需要编写数百行代码来处理 PPT 生成逻辑、布局选择、样式应用和错误处理。借助 Copilot SDK 和 Skills,开发者只需用自然语言描述需求,Agent 即可自动生成并执行所需代码。原本需要 3--5 天的工作,现在只需 3--4 小时,代码维护量减少约 95%。

自动化业务代码生成

Copilot SDK 不只是提供代码示例,而是生成完整、可执行的业务逻辑。当你请求生成多语言 PPT 时,Agent 能理解需求、选择合适字体、生成实现代码、执行并处理错误、验证输出,并返回可直接使用的文件。开发者只需关注业务意图,而无需关心实现细节。

技术趋势

向意图驱动开发的转变

开发者正在经历一种根本性的工作方式变化:不再需要精通每一种语言细节和框架 API,而是通过声明式 Skills 定义想要的结果。Copilot SDK 代表了这一未来:你用自然语言描述能力,AI Agent 自动完成代码生成与执行。

边缘 AI 与云 AI 的融合

从纯云端 LLM(强大但存在隐私顾虑)到纯本地 SLM(私密但能力有限)的演进,催生了当下的混合架构。GenGitHubRepoPPT 正是这一趋势的体现:本地模型负责数据分析和结构化,云端模型负责复杂推理和专业内容生成,从而实现快速、安全、专业的结果。

Agent 开发的民主化

Copilot SDK 极大降低了 AI 应用开发门槛。资深工程师可获得 10--20 倍效率提升,中级工程师能够构建过去难以实现的复杂 Agent,甚至初级工程师和业务专家,也可以通过编写 Skills 参与其中,而无需深厚的技术背景。

未来不再是"能否构建 AI 应用"的问题,而是------我们能多快把想法变成现实。

参考资料

项目与代码

-

GenGitHubRepoPPT GitHub 仓库 ------ 案例项目

-

Microsoft Foundry Local ------ 本地 AI 运行时

-

GitHub Copilot SDK ------ Agent 开发 SDK

-

Copilot SDK 入门教程 ------ 官方快速上手

深入资料

-

Build an Agent into Any App with GitHub Copilot SDK ------ 官方发布

-

GitHub Copilot SDK Cookbook ------ 实践示例

学习资源

-

Edge AI for Beginners ------ 边缘 AI 入门课程