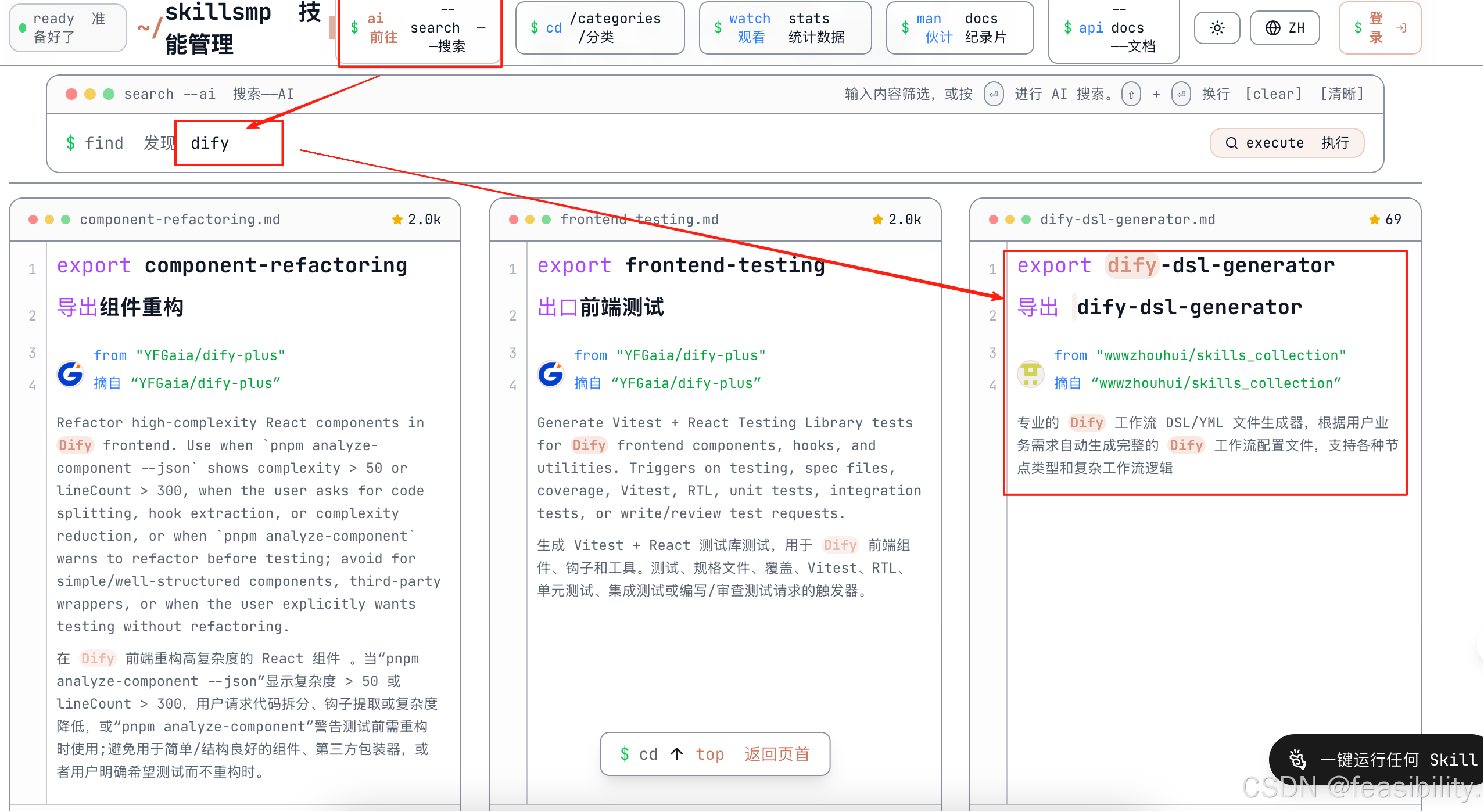

到https://skillsmp.com/zh下载skills,点击搜索跳转skills搜索页面,在输入框输入你感兴趣的技能,比如dify等,选择相关的skills

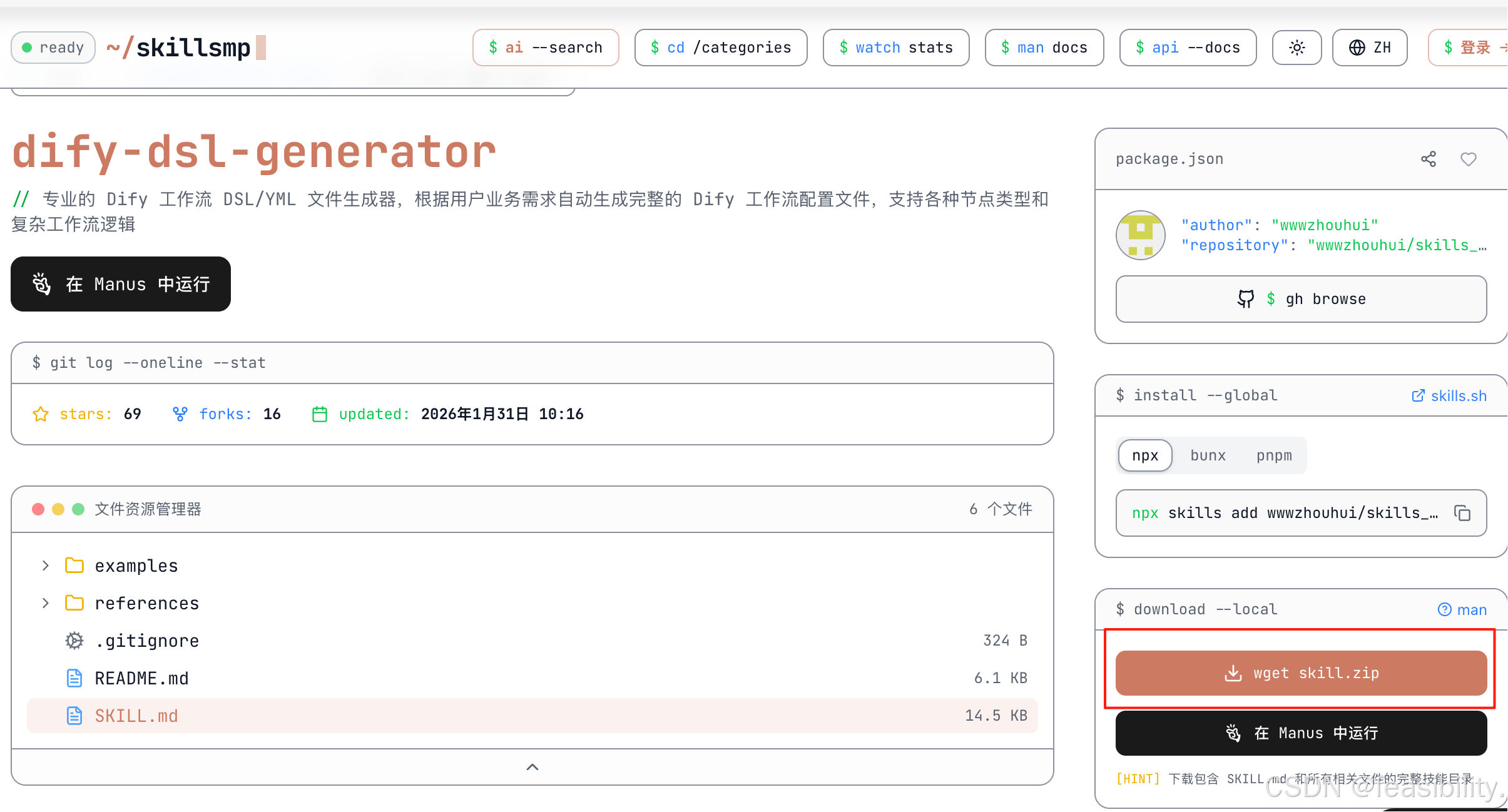

进入页面,点击下载skills包

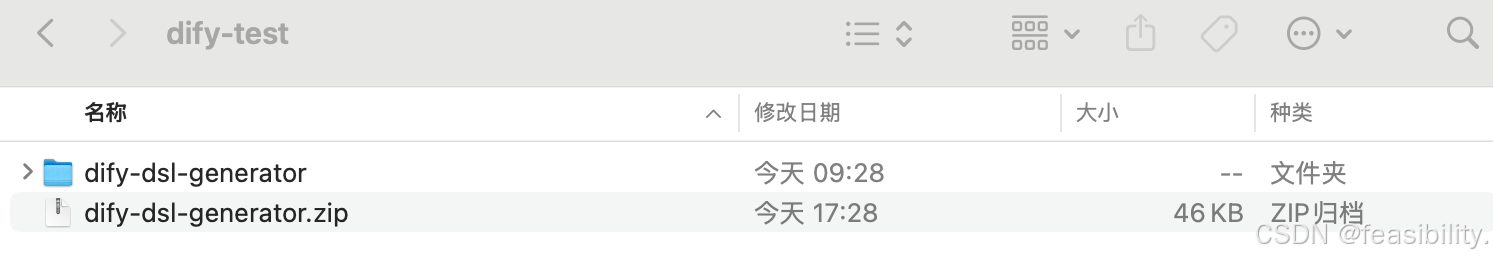

创建dify-test目录测试,你可以随便起名,然后把刚下载的skills压缩包放入其中解压

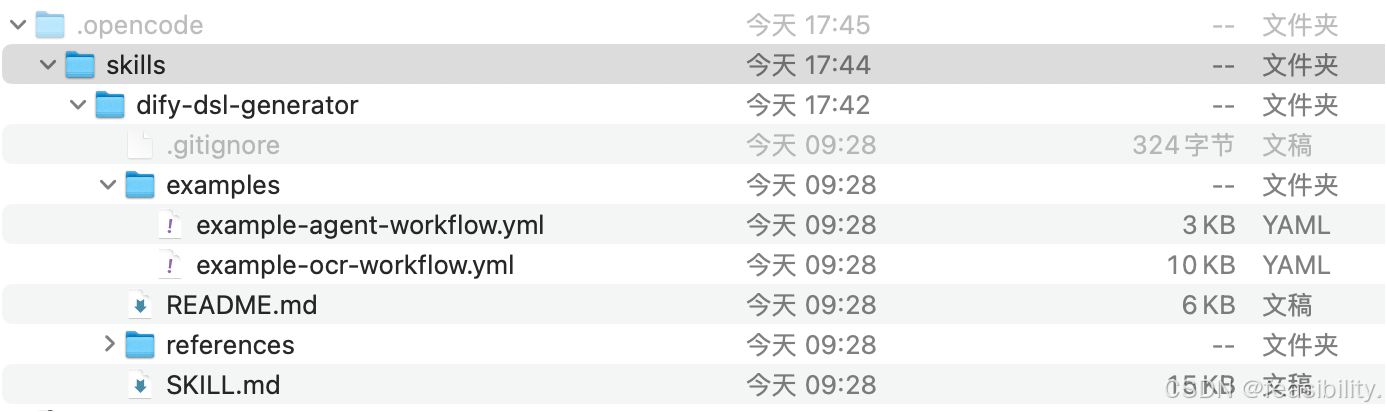

创建.opencode/skills目录,移动解压的skills包放入/Users/Zhuanz/Desktop/study/OpenCode/dify-test/.opencode/skills

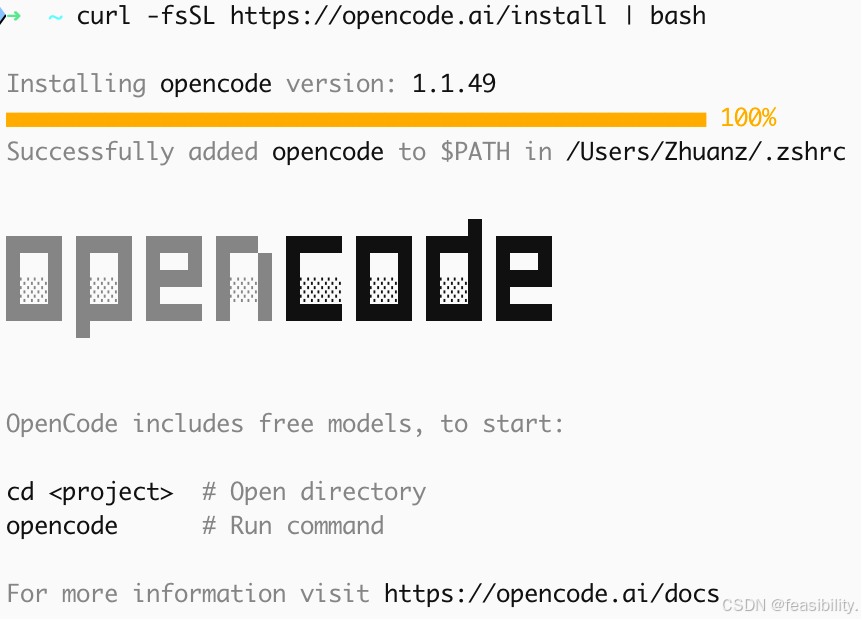

执行curl -fsSL https://opencode.ai/install | bash安装opencode

执行cd Desktop/study/OpenCode/dify-test进入刚刚的目录

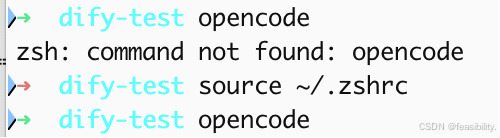

然后执行opencode,第一次执行zsh终端shell还没加载新添加的 PATH 配置,需要先用source加载,注意对没有zsh终端shell一般是用source ~/.bashrc

输入你的提示词

生成一个Dify工作流,用于文章摘要生成,包含开始节点、LLM节点和结束节点,注意需要支持ollama和API的接口接入模型opencode使用当前默认模型Zen作为agent的大脑

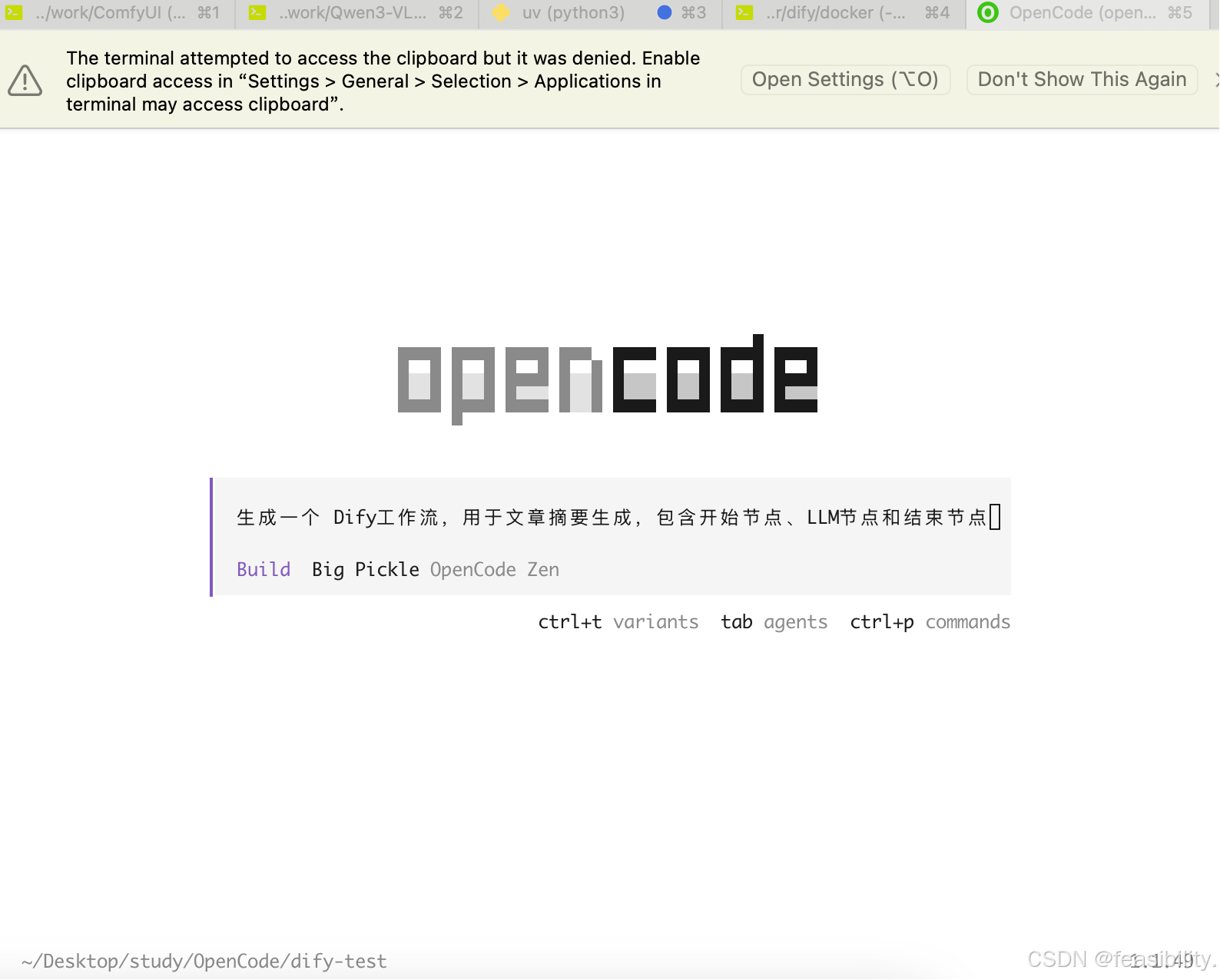

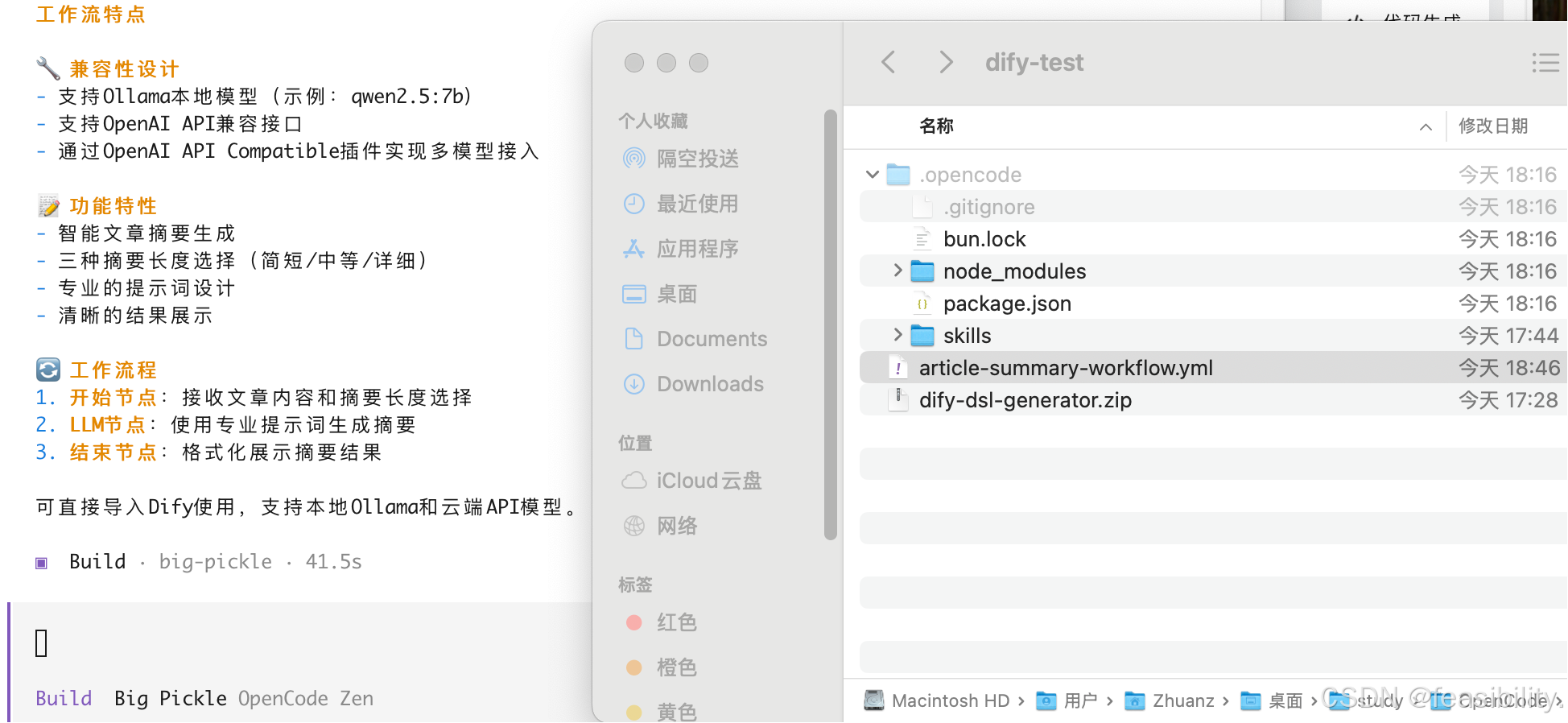

按下回车,智能体开始按提示词的要求执行任务

可以看出生成了yml工作流文件,当然最好检查一下,另外小心语法和dify版本不一致

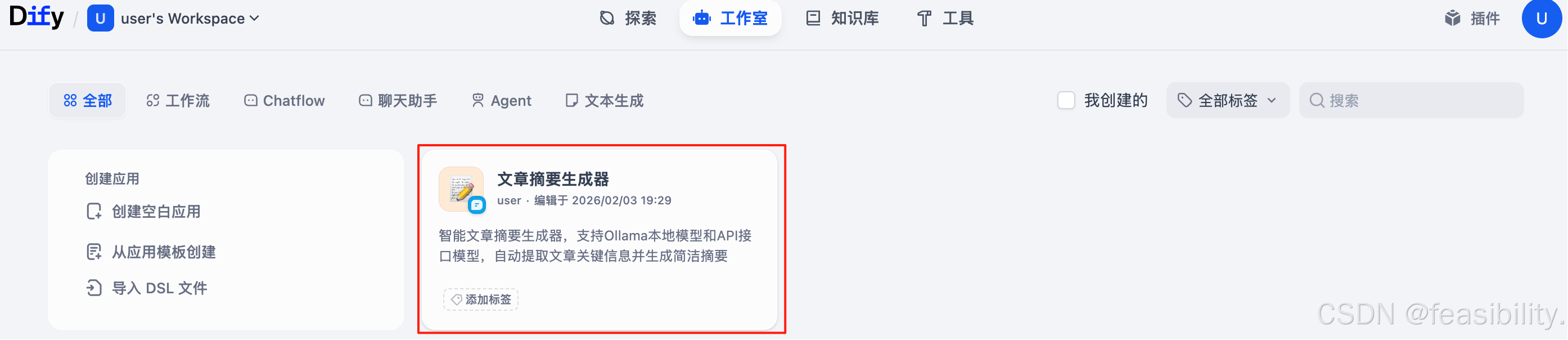

启动dify,打开http://localhost/apps,点击导入DSL文件,并放入刚才的dsl文件

点击创建

点击进入

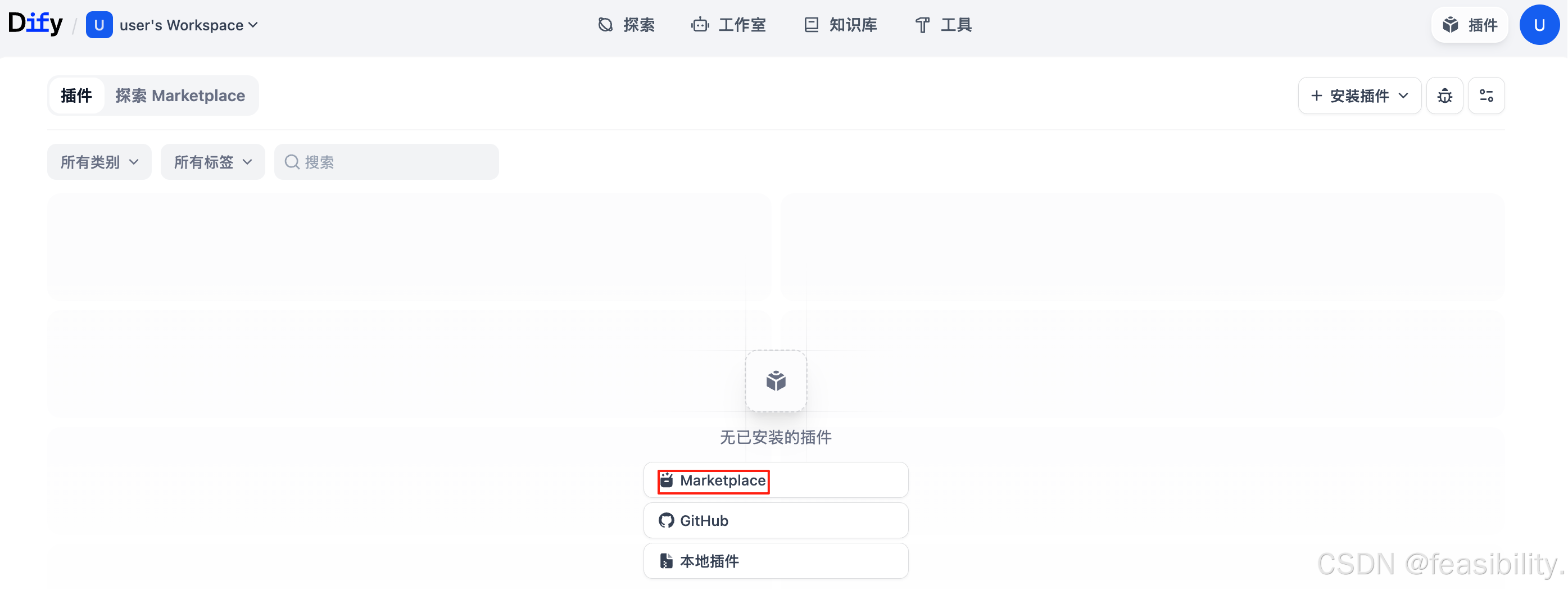

点击插件,跳转页面,并点击Marketplace

点击ollama插件

点击安装

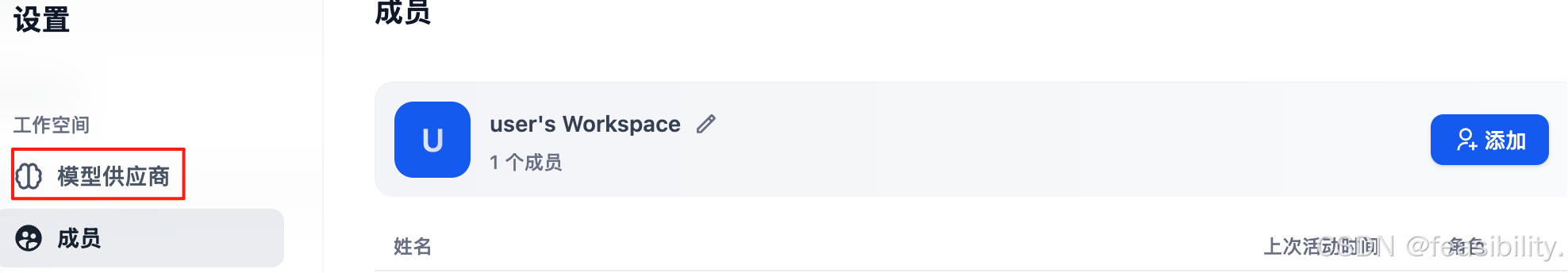

点击设置

点击模型供应商

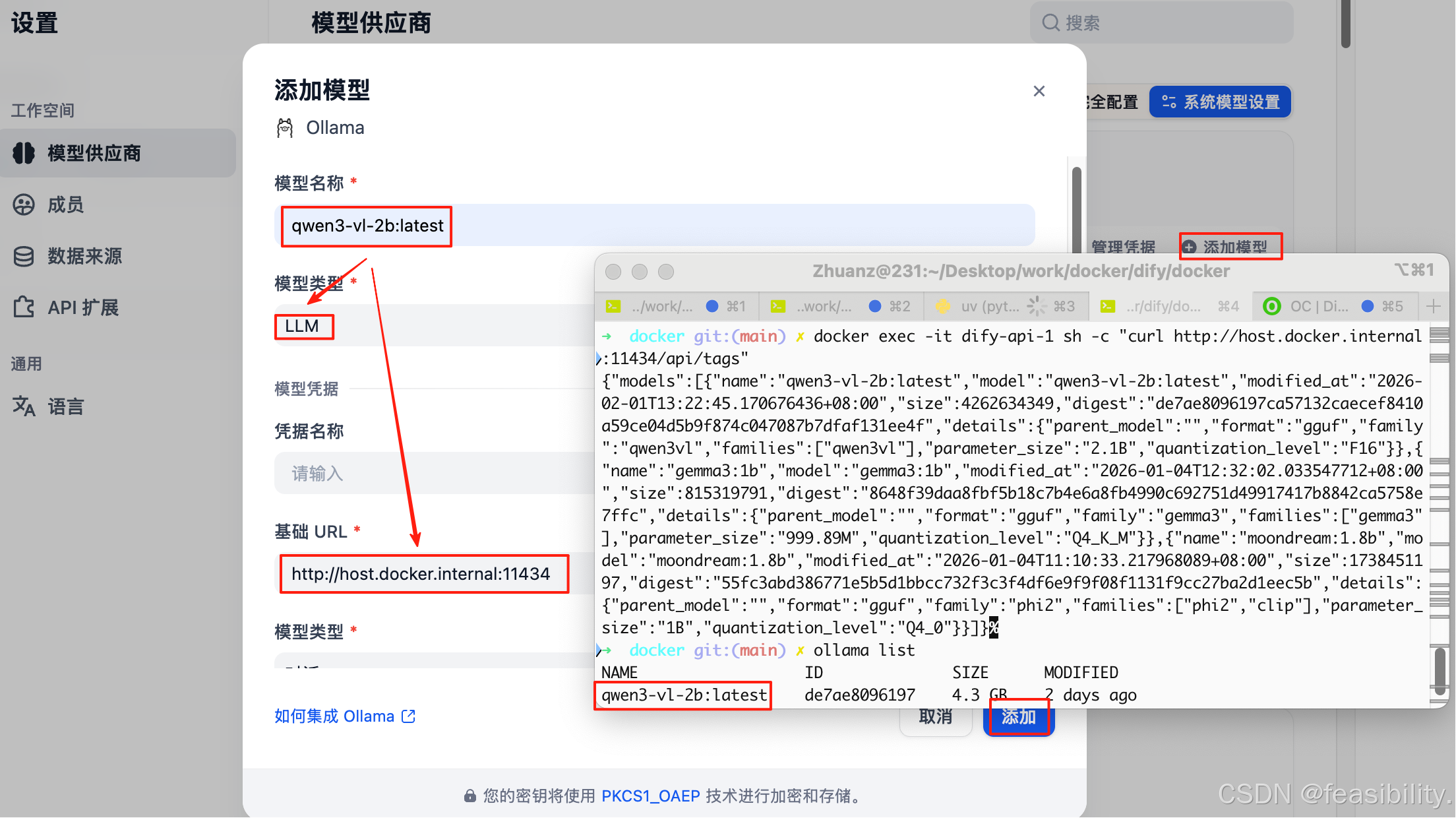

添加模型

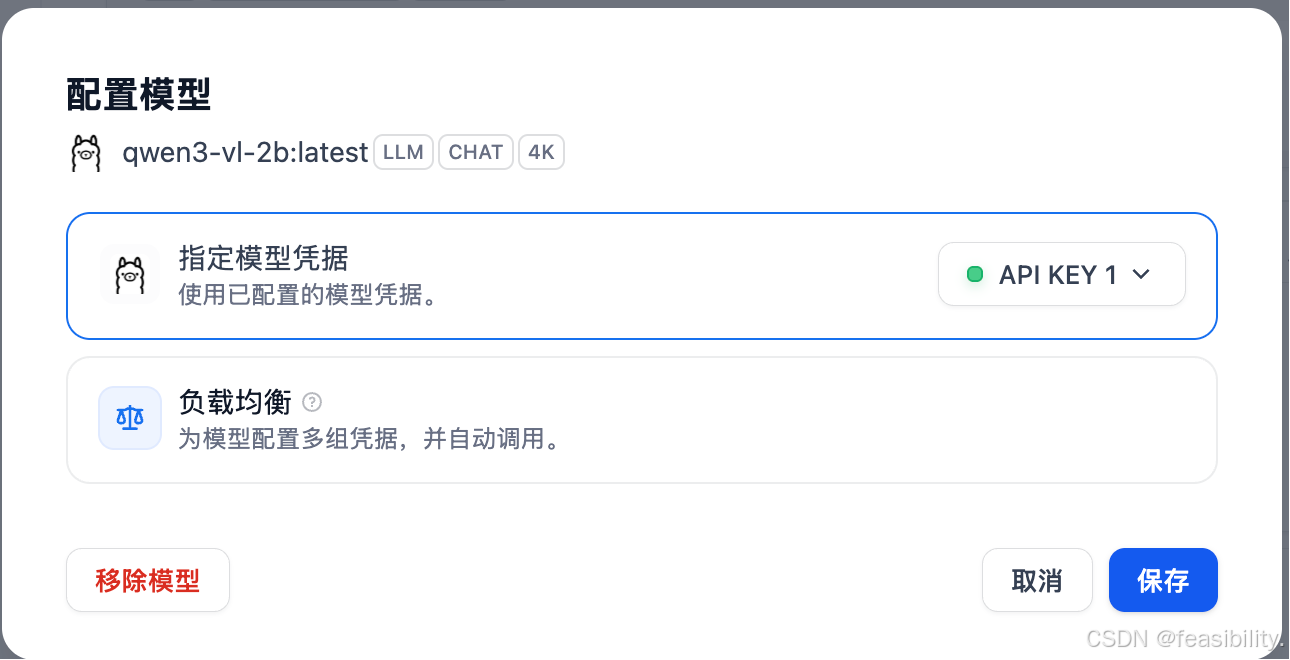

启动ollama,填写ollama模型空间有的模型,如果dify是在容器,那么基础URL一般是http://host.docker.internal:11434,即使ollama不是在docker中,配置仅供参考,以你的ollama情况为准,配置完点击添加

启动ollama,填写ollama模型空间有的模型,如果dify是在容器,那么基础URL一般是http://host.docker.internal:11434,即使ollama不是在docker中,配置仅供参考,以你的ollama情况为准,配置完点击添加

点击右上角关闭设置

如果不行可以尝试dify的docker中的.env文件加入下面配置,然后重启 Dify

# 启用自定义模型

CUSTOM_MODEL_ENABLED=true

# Ollama 地址(容器内部视角)

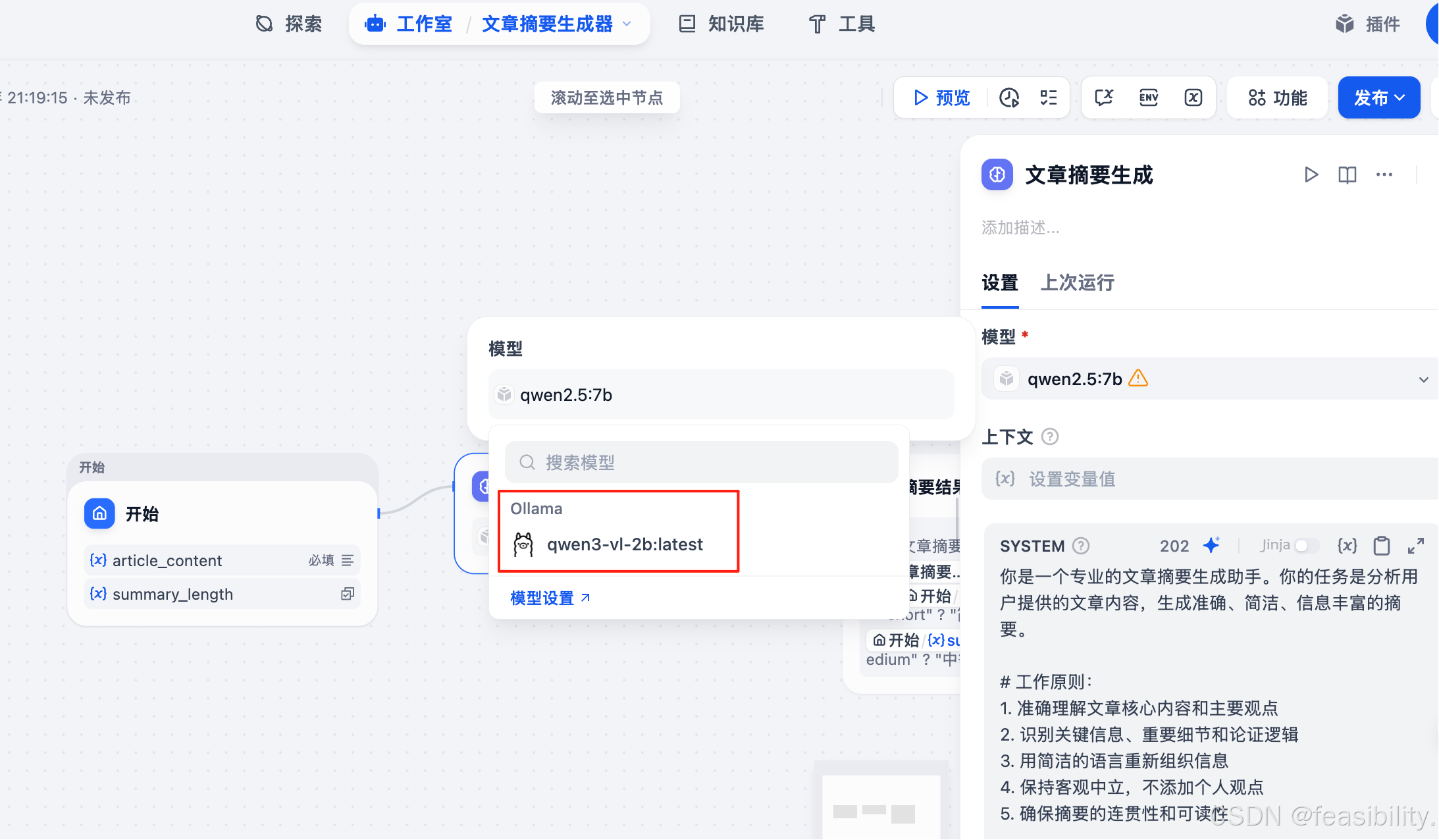

OLLAMA_API_BASE_URL=http://host.docker.internal:11434回到工作室,点击模型选择ollama

点击预览,填写文章内容,并在聊天框输入用户提示词,点击运行

查看结果

创作不易,禁止抄袭,转载请附上原文链接及标题