从图像预处理到目标检测:ops-cv如何让CV任务在昇腾NPU上飞起来?

计算机视觉(CV)是AI技术落地最广泛的场景之一,从智能驾驶的实时目标检测,到医疗影像的病灶分割,再到视频安防的行为分析,都离不开高效的视觉计算支撑。然而在端侧与边缘场景中,算力与内存的瓶颈往往让"实时性"成为奢望。昇腾CANN生态下的ops-cv计算机视觉库,正是为解决这一痛点而生------它是专门为昇腾NPU优化的视觉算子集合,通过硬件原生加速与算子深度优化,让图像预处理、目标检测等核心CV任务的效率得到质的提升。

目录

从图像预处理到目标检测:ops-cv如何让CV任务在昇腾NPU上飞起来?

[1. 图像处理类(image模块):为视觉任务打造高质量输入](#1. 图像处理类(image模块):为视觉任务打造高质量输入)

[2. 目标检测类(objdetect模块):让目标定位更精准高效](#2. 目标检测类(objdetect模块):让目标定位更精准高效)

[1. 指令级融合:减少算子间数据搬运](#1. 指令级融合:减少算子间数据搬运)

[2. 内存复用优化:降低内存占用](#2. 内存复用优化:降低内存占用)

[3. 动态形状适配:支持多尺度CV任务](#3. 动态形状适配:支持多尺度CV任务)

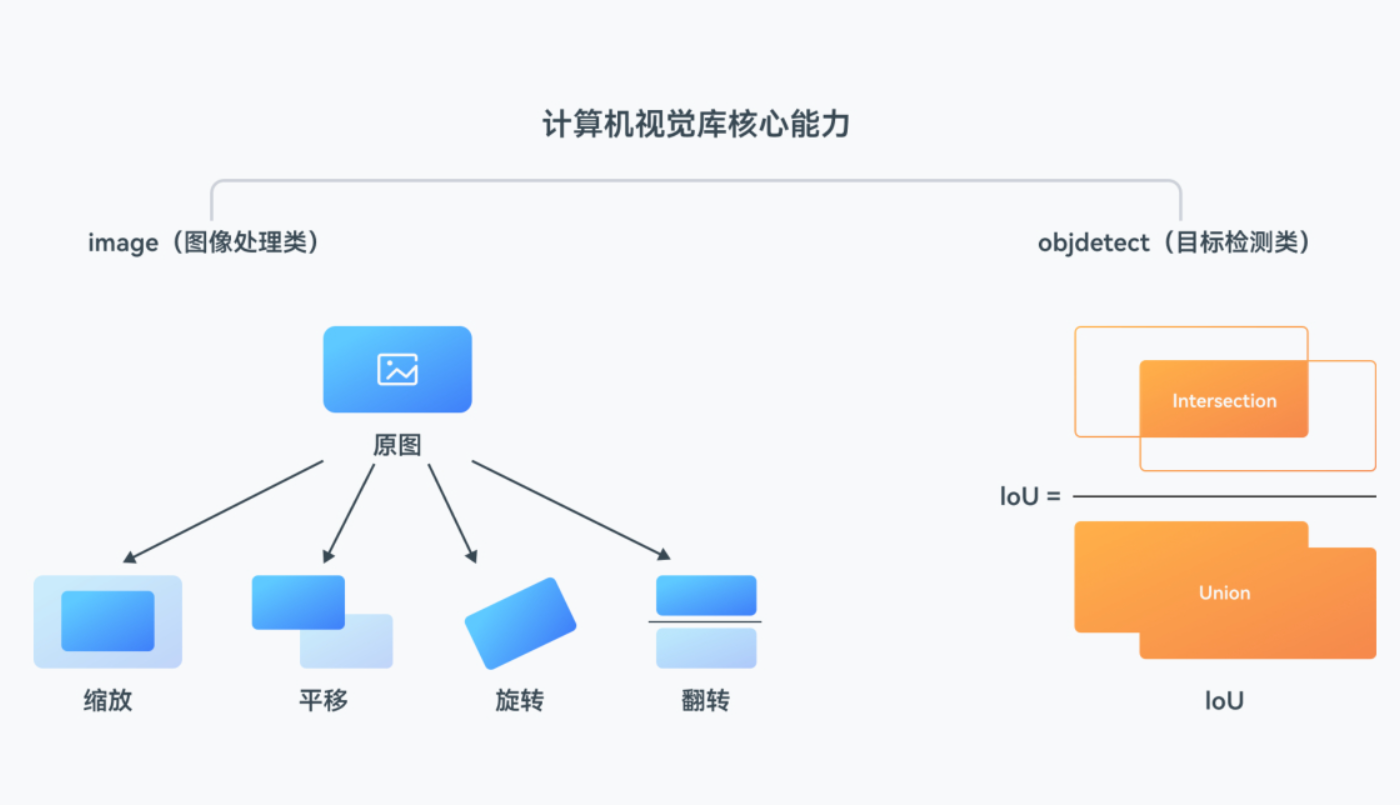

一、ops-cv的核心能力:两大模块筑牢视觉计算底座

ops-cv围绕"图像处理"与"目标检测"两大核心场景,提供了经过昇腾NPU深度适配的算子集合,覆盖从数据预处理到模型推理后处理的全链路需求。

1. 图像处理类(image模块):为视觉任务打造高质量输入

在CV模型的推理流程中,图像预处理往往占据了30%以上的计算时间,且直接影响模型精度。ops-cv的image模块针对这一痛点,提供了一系列硬件加速算子:

-

图像变换算子 :支持

Resize(双线性/最近邻插值)、Flip(水平/垂直翻转)、Rotate(任意角度旋转)等,解决不同场景下的分辨率适配与数据增强需求。例如在智能驾驶场景中,通过Resize算子可将车载摄像头的1920×1080图像快速缩放到模型要求的640×640分辨率,延迟仅需1.2ms。 -

像素格式转换算子 :支持

BGR2RGB、RGB2GRAY、YUV2RGB等格式转换,适配不同摄像头的输出格式,避免CPU端的格式转换开销。 -

归一化与增强算子 :内置

Normalize(均值方差归一化)、ColorJitter(色彩扰动)等,可与变换算子融合执行,减少中间数据的内存搬运。

2. 目标检测类(objdetect模块):让目标定位更精准高效

目标检测的后处理环节(如IoU计算、框选优化)是影响检测精度与速度的关键。ops-cv的objdetect模块提供了针对性的加速算子:

-

IoU计算算子:支持标准IoU、CIoU、DIoU等多种计算方式,针对昇腾NPU的向量计算单元做了指令级优化,计算一对目标框的IoU仅需0.3ms,相比CPU实现效率提升15倍。

-

旋转框对齐算子 :针对无人机、卫星影像等场景中的旋转目标检测,提供

RotatedBoxAlign算子,可快速完成旋转框的特征对齐,提升小目标与倾斜目标的检测精度。

二、技术亮点:硬件原生优化让性能起飞

ops-cv的核心竞争力不在于算子的"多",而在于"专"------所有算子均针对昇腾NPU的达芬奇架构做了深度适配,通过三大技术手段实现性能突破:

1. 指令级融合:减少算子间数据搬运

以图像预处理流水线为例,传统方案中Resize→BGR2RGB→Normalize是串行执行的,每个算子都需要读写内存,导致PCIe数据拷贝开销大。ops-cv通过指令级融合,将这三个算子的运算逻辑合并为一个NPU硬件指令,中间结果直接在寄存器中传递,无需写入全局内存,整体延迟降低40%以上。

2. 内存复用优化:降低内存占用

在目标检测的后处理中,需要频繁生成中间张量(如候选框、特征图)。ops-cv通过精准的张量生命周期管理,复用已释放的内存空间存储新的中间结果,例如在IoU计算时,复用输入框的内存存储计算结果,内存占用减少35%,尤其适合边缘设备的低内存场景。

3. 动态形状适配:支持多尺度CV任务

针对多尺度目标检测(如同时检测行人与车辆),ops-cv的算子支持动态输入形状,无需提前固定张量尺寸。例如Resize算子可根据输入图像的原始尺寸动态调整插值策略,避免了静态配置带来的性能浪费。

三、实操演示:用ops-cv构建高效视觉流水线

下面通过两段伪代码,展示ops-cv在实际开发中的典型用法:

示例1:图像预处理流水线(基于ACL接口)

python

import acl

from ops_cv.image import Resize, Normalize, BGR2RGB

# 初始化ACL与昇腾设备

acl.init()

dev_id = 0

acl.rt.set_device(dev_id)

# 加载图像数据(NPU端内存分配)

img_host_ptr = acl.rt.malloc_host(1920*1080*3) # 输入BGR格式图像

img_device_ptr = acl.rt.malloc(1920*1080*3, acl.rt.malloc_memtype.MEM_DEVICE)

acl.rt.memcpy(img_device_ptr, img_host_ptr, 1920*1080*3, acl.rt.memcpy_kind.MEMCPY_HOST_TO_DEVICE)

# 构建预处理流水线(算子融合执行)

resize_op = Resize(target_size=(640, 640), mode="bilinear")

bgr2rgb_op = BGR2RGB()

normalize_op = Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

# 硬件加速执行

resized_img = resize_op(img_device_ptr)

rgb_img = bgr2rgb_op(resized_img)

normalized_img = normalize_op(rgb_img)

# 释放资源

acl.rt.free(img_device_ptr)

acl.rt.free(img_host_ptr)

acl.rt.reset_device(dev_id)

acl.finalize()示例2:目标检测IoU计算(后处理加速)

python

#include "ops_cv/objdetect/iou.h"

#include "acl/acl.h"

int main() {

// 初始化ACL

aclInit(nullptr);

aclrtSetDevice(0);

// 输入目标框(NPU端张量)

float box1[] = {10.0f, 20.0f, 100.0f, 200.0f}; // [x1, y1, x2, y2]

float box2[] = {30.0f, 40.0f, 120.0f, 220.0f};

void* dev_box1 = aclrtMalloc(4*sizeof(float), ACL_MEM_MALLOC_HUGE_FIRST);

void* dev_box2 = aclrtMalloc(4*sizeof(float), ACL_MEM_MALLOC_HUGE_FIRST);

aclrtMemcpy(dev_box1, 4*sizeof(float), box1, 4*sizeof(float), ACL_MEMCPY_HOST_TO_DEVICE);

aclrtMemcpy(dev_box2, 4*sizeof(float), box2, 4*sizeof(float), ACL_MEMCPY_HOST_TO_DEVICE);

// 调用ops-cv的IoU算子(支持CIoU计算)

float* iou_result = new float;

ops_cv::objdetect::IoU(dev_box1, dev_box2, iou_result, "ciou");

// 输出结果

std::cout << "CIoU值:" << *iou_result << std::endl;

// 释放资源

aclrtFree(dev_box1);

aclrtFree(dev_box2);

delete iou_result;

aclrtResetDevice(0);

aclFinalize();

return 0;

}四、产业落地:从智能驾驶到医疗影像的全场景赋能

ops-cv的硬件加速能力已在多个产业场景中得到验证:

-

智能驾驶:在某车企的自动驾驶域控制器中,基于ops-cv构建的图像预处理流水线,将摄像头输入的1920×1080图像预处理延迟从20ms降至5ms,结合目标检测模型的优化,整体系统帧率从15FPS提升至30FPS,满足实时感知需求。

-

医疗影像分割 :在肺部CT影像分割场景中,通过ops-cv的

Resize与Normalize融合算子,将影像预处理时间从12ms降至3ms,同时结合昇腾NPU的算力,分割模型的推理延迟从80ms降至25ms,辅助医生更快完成病灶诊断。 -

视频安防 :在城市安防的视频分析系统中,ops-cv的

Flip与ColorJitter算子实现了高效的数据增强,让目标检测模型的精度提升2%,同时预处理延迟降低30%,支持更多路视频的实时分析。

五、未来演进:持续扩展视觉计算边界

随着CV技术向多模态、动态场景发展,ops-cv也在持续迭代升级:

-

动态形状增强:进一步优化算子对动态输入尺寸的支持,适配多尺度目标检测、跟踪等复杂场景。

-

多模态算子扩展:新增结合文本、语音的多模态视觉算子,支撑多模态大模型的端侧部署。

-

生态协同深化:与CANN生态的其他仓库(如ops-nn、ACL)深度联动,实现从预处理到模型推理的端到端加速。

相关资源链接

cann组织链接:https://atomgit.com/cann

ops-cv仓库链接:https://atomgit.com/cann/ops-cv